首发:AIWalker

作者:HappyAIWalker

大家好,我是Happy。

最近,Transformer在CV领域搅翻了天,在各个CV领域打出了半片天。比如,Detection、Segmentation、Classification等等均出现了Transformer这个“搅局者”;甚至Low-level领域也被Transformer占领多个高峰,比如超分、降噪、去雨等等。一直以为视频超分可能还会再等一段时间,哪成想,视频超分领域也成了Transformer的附属地。

标题&作者团队

Abstract

视频超分旨在由低分辨率视频进行高分辨率视频重建,是一种空-时序列预测问题。近来,Transformer由于其对序列到序列问题的并行计算能力获得了极大关注。乍一看,好像可以将Transformer直接应用到视频超分中。然而,Transformer的经典设计方式(全连接自注意力层与词级前馈层)并不适用于视频超分问题,主要由以下两个原因:

- 因其依赖于线性层计算注意力图,全连接自注意力层难以探索数据局部特性;

- 词级前馈层缺乏特征对齐能力,而这对于视频超分非常重要。

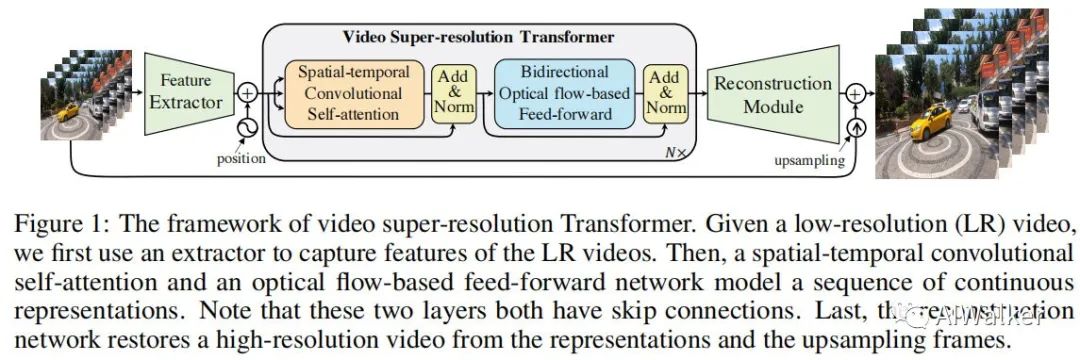

本文首次采用Transformer对视频超分任务进行了适配。具体来说,为解决第一个问题,我们提出一种空时卷积自注意力层以探索局部信息;为解决第二个问题,我们设计了一种双向光流前馈层以挖掘近邻视频帧相关性并进行对齐。最后,我们在几个基准数据集上验证了所提方案的有效性。

Method

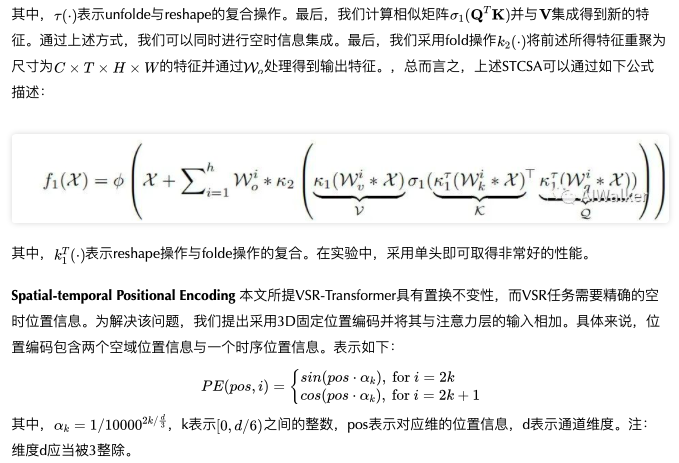

上图给出了本文所提VSR-Transformer架构示意图,它包含特征提取、Transformer编码器以及重建网络。具体来说,给定视频序列,我们首先采用堆叠残差模块从视频中提取特征;然后VSR-Transformer将特征编码为连续表达序列;最后重建网络从上述表达中进行高分辨率视频重建。

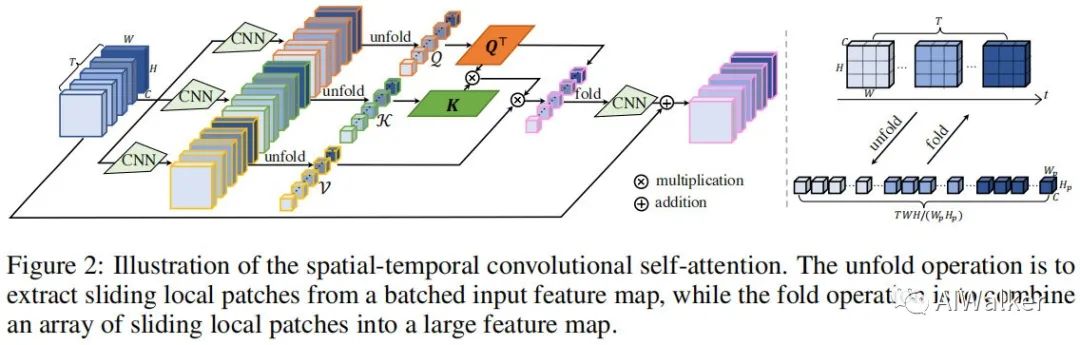

Spatial-Temporal Convolutional Self-Attention

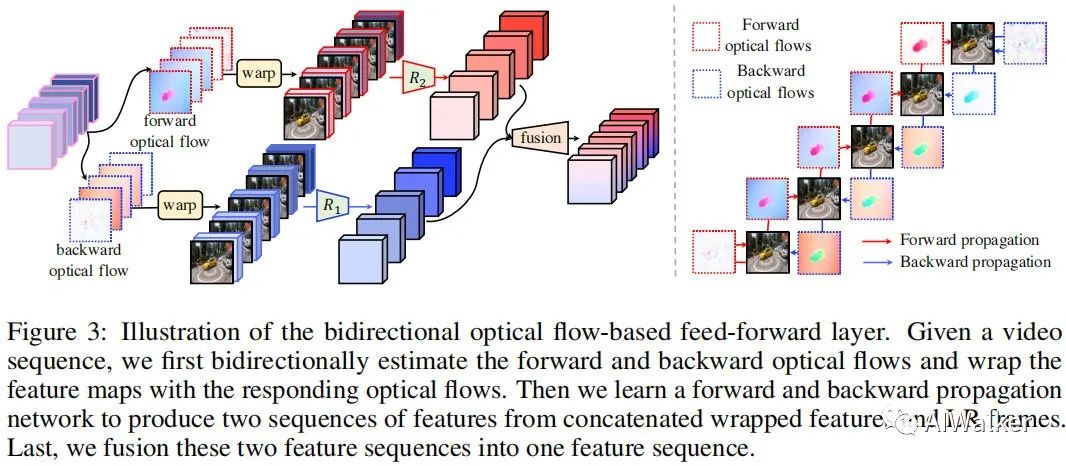

Bidirectional Optical Flow-based Feed-forward

传统Transformer的全连接前馈层包含两个线性层外加GeLU激活,而这种方式在视频超分任务中无法有效探索不同帧间的相关性,进而导致较差的性能。

Experiments

训练数据:REDS与Vimeo90K;度量准则:PSNR与SSIM。

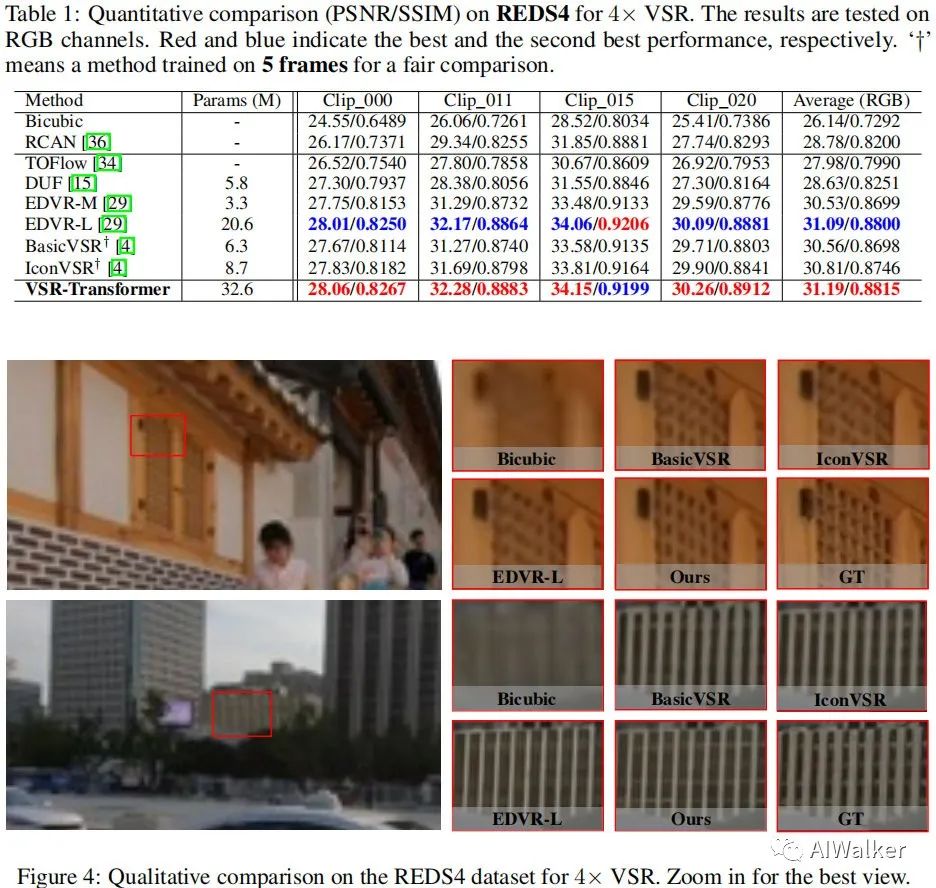

Results on REDS

上图给出了REDS数据集上不同方案的性能对比,从中可以看到:

- 相比其他方案,所提方案具有更高的PSNR指标;

- 当仅采用5帧进行训练时,BasicVSR与IconVSR比EDVR性能还要差,这意味着两者严重依赖于序列信息集成;

- 所提方法仅需64个通道即可取得比128通道的EDVR-L更好的性能;

- 所提方法可以重建更多的细节、更锐利的边缘。

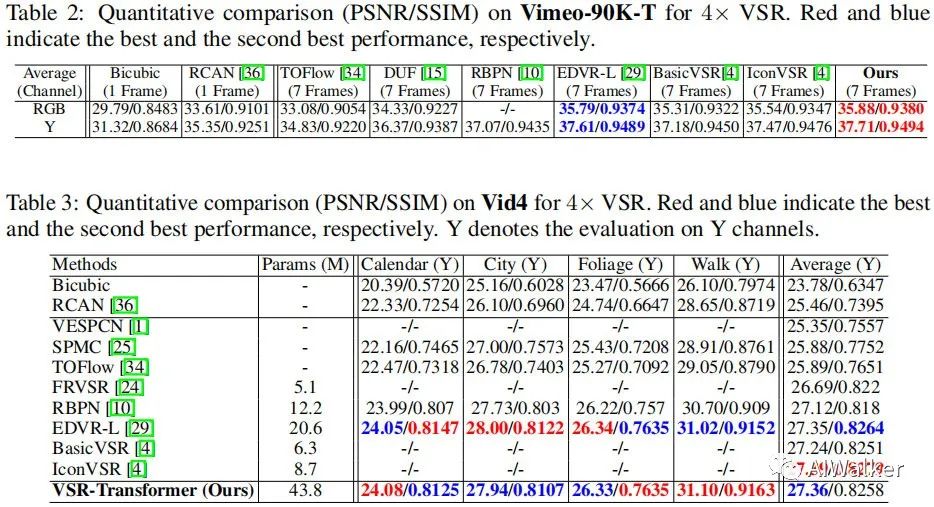

Results on Vimeo90K

上图给出了Vimeo90K-T与Vid4数据集上的性能对比,从中可以看到:

- 相比其他方案,所提方案取得了最佳的PSNR指标;

- 在Vid4测试集上,所提方案的泛化性能要优于EDVR与BasicVSR,但弱于IconVSR。一个可能的原因:IconVSR采用全部测试帧,而所提方案仅采用了7帧。更重要的是:Vimeo90K-T与Vid4之间存在分布偏差。

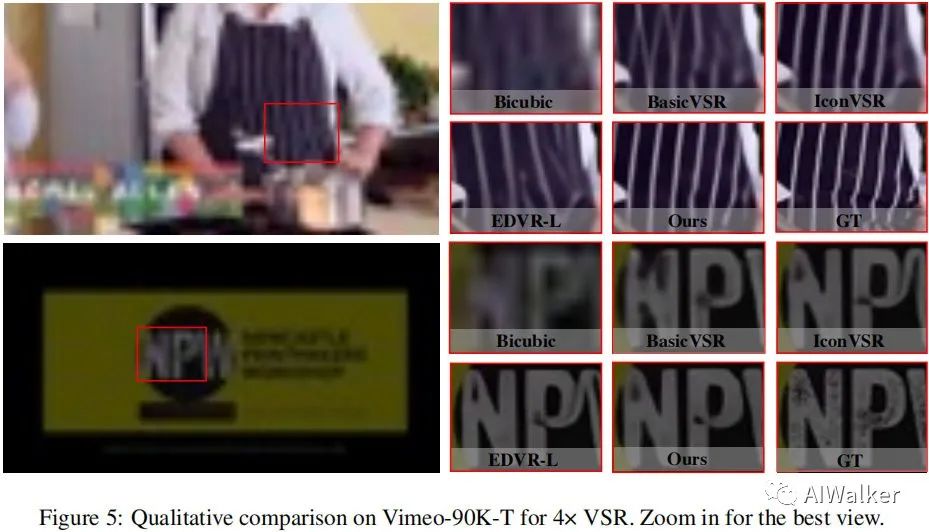

- 视觉效果见下图,可以看到:所提方案具有更锐利而逼真的HR结果。

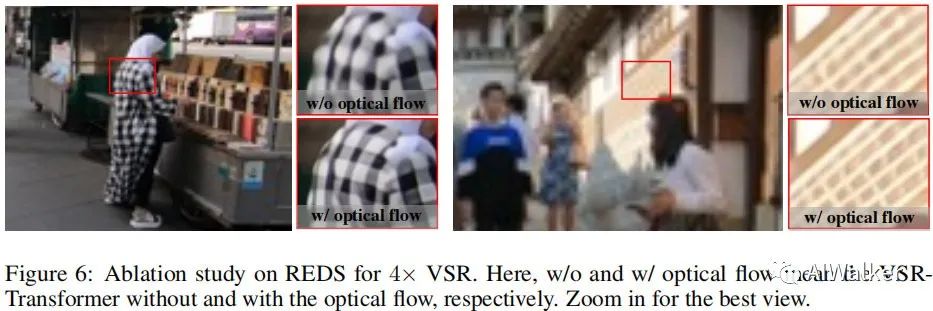

Ablation Study

为验证所提方案中光流的有效性,我们进行了消融实验对比,结果见上图。可以看到:当移除光流后,生成的HR图像就变得模糊,细节不再锐利。这意味着:光流对于信息传播与特征对齐非常重要。

附录

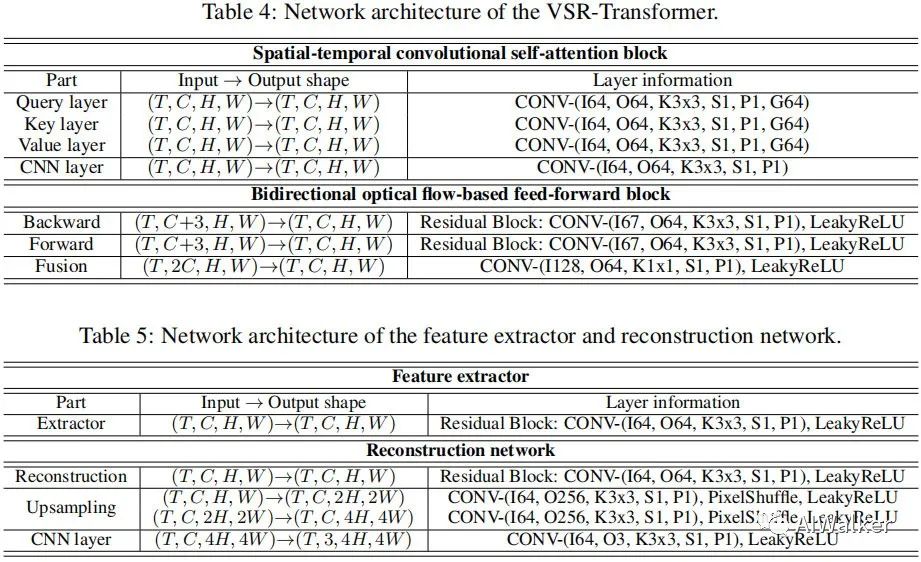

作者在文末的补充材料中提供了关于VSR-Transformer网络的结构信息配置,见下表。

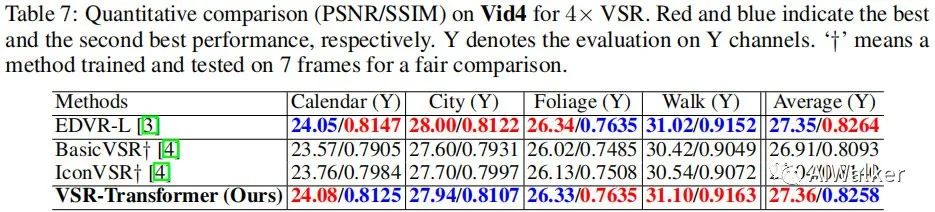

此外,为更公平对比,还提供了关于Vid4上相同帧数测试结果,见下表。所提方案取得了更佳的PSNR指标。

全文到此结束,更多消融实验与分析建议查看原文。

推荐阅读

- 89.77%!谷歌大脑Quoc V.Le团队提出CoAtNet:将卷积与自注意力纳入同一模块

- 只需两行code即将置换思想与Transformer巧妙衔接

- “新卷王”X-volution | 将卷积与自注意力进行高效集成

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏深度学习从入门到精通。