结构重参数(Structural Re-parameterization)已在多领域证实了其优秀的"涨点"优势,相关研究有如下几篇:

- CVPR2021|“无痛涨点”的ACNet再进化,清华大学&旷视科技提出Inception类型的DBB

- RepVGG|让你的ConVNet一卷到底,plain网络首次超过80%top1精度

- 重参数思想再续新篇章RepNAS=Re-parameterization+NAS

- “重参数宇宙”再添新成员:RepMLP,清华大学&旷视科技提出将重参数卷积嵌入到全连接层

- 神操作!RM让ResNet等价转换为Plain架构

- CVPR2022 | RepLKNet: 大核卷积+结构重参数让CNN再次伟大

- 从RepVGG系列谈起,结构重参数化如何暴力提升性能

- DO-Conv无痛涨点:使用over-parameterized卷积层提高CNN性能

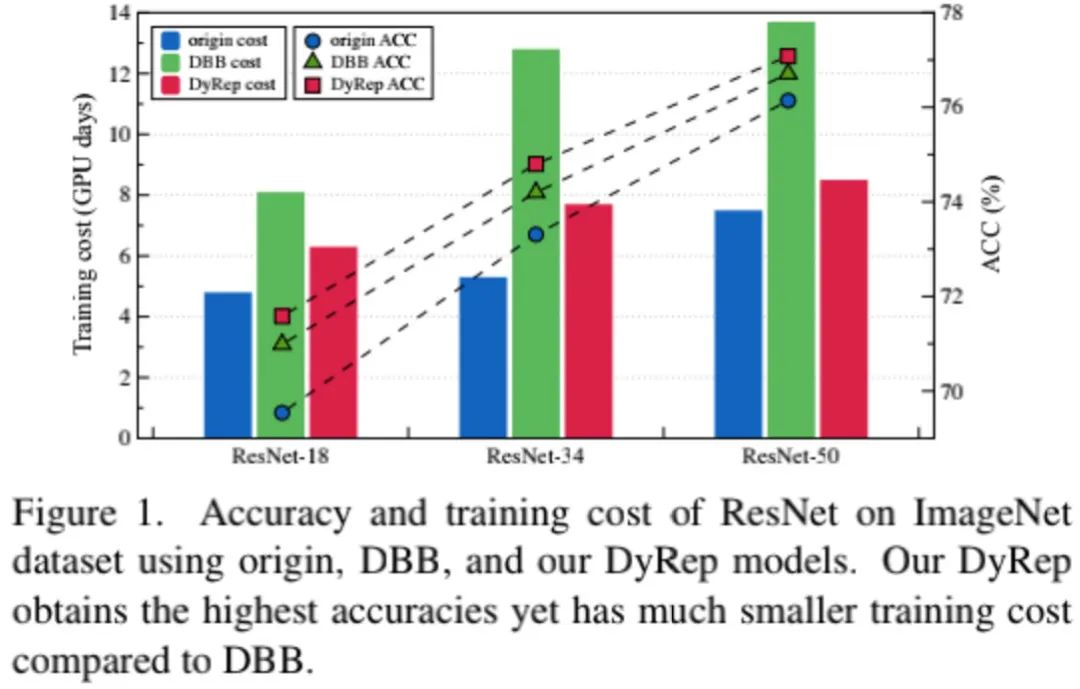

已有的方案均是对所有操作通过重参数机制进行结构增广,这种“静态”处理机制会导致了昂贵的训练代价。为解决该问题,本文设计了一种DyRep(Dynamic Re-parameterization)方案以最小代价引导训练,DyRep将重参数技术编码到训练过程中对网络结构进行动态进化。

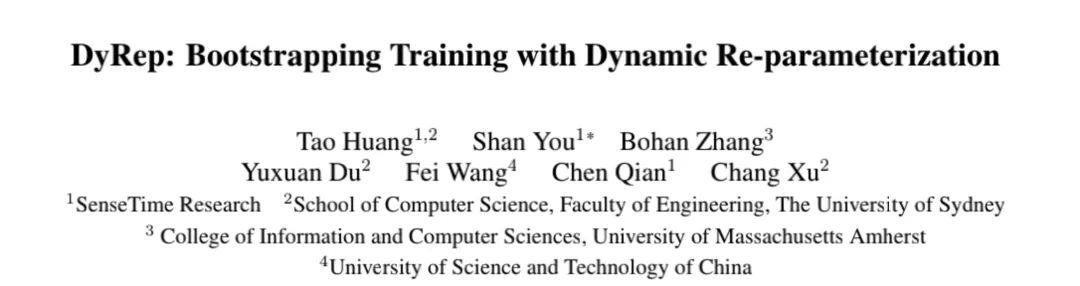

相比“静态”重参数机制,本文所提DyRep效率更高:它可以对给定网络平滑进化而非构建一个过参数化网络。DyRep可以提升ResNet18的性能达2.04%,同时训练耗时降低22%。

1Method

关于结构重参数可行的指导准则可参考DBB一文中的描述,这里不再赘述,我们仅对DyRep的核心思想进行简单介绍。

CVPR2021|“无痛涨点”的ACNet再进化,清华大学&旷视科技提出Inception类型的DBB

上述给出了本文所提DyRep方案示意图,它聚焦于在训练阶段对网络贡献最大的分支进行自适应增广,而非常规的训练前“静态”增广方式。

Minimizing Loss with Dynamic Structures

在DyRep中,不同分支的贡献通过其梯度信息评估,也就是说:小梯度对应低贡献,进而代表分支冗余。DyRep的评估方案是在synflow基础上扩展而来,表示如下:

注:表示分支的参数。通过上述公式,我们逐渐对贡献最大的分支进行重参数扩展,这意味着:该方案可以进行递归重参数化以达成更丰富的表示形式。

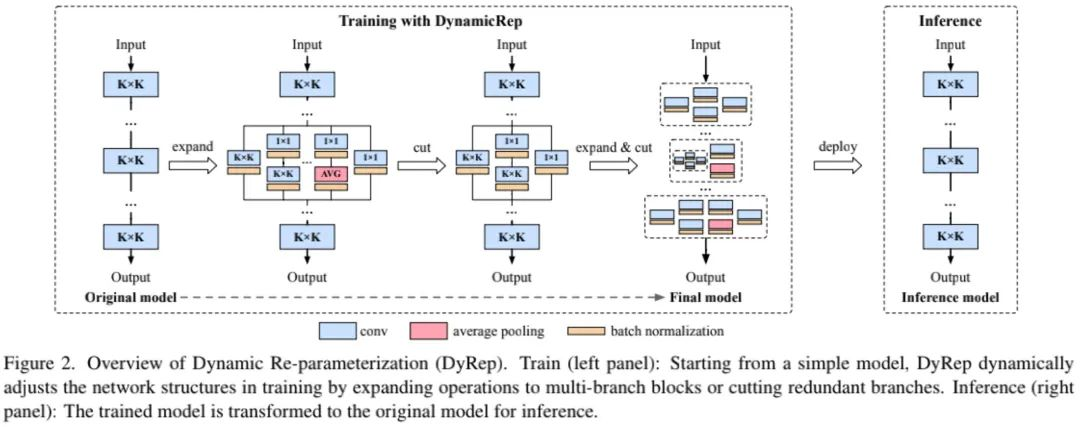

上图给出了本文所用到的重参数流程:在定位到最重要的分支后,我们采用重参数技术将其从单一卷积扩展为DyRep模块,扩展分支的参数随机初始化。为确保扩展前后的等价性,对其参数进行如下处理:

注:表示增广分支的随机初始化参数。此外,为稳定训练,我们对所添加的BN层参数进行如下设置:。对于均值与标准差两个统计信息,我们进行20个batch的统计校正。

De-parameterizing for Better Efficiency

除了对最重要的分支进行重参数扩展外,我们还需要不重要的分支进行去冗余,称之为de-parameterization(Dep)。此时,我们将要移除的分支参数折叠到最重要分支中:

Progressive Training with Rep and Dep

上图给出了DyRep训练流程说明,通过组合Rep与Dep,网络结构可以进行更高效的增广。具体来说,DyRep每t个epoch重复一次Rep与Dep操作:

- Rep:它包含最重要分支的选择、扩展以及参数修正;

- Dep:它包含冗余分支定位、移除以及参数修正。

2Experiments

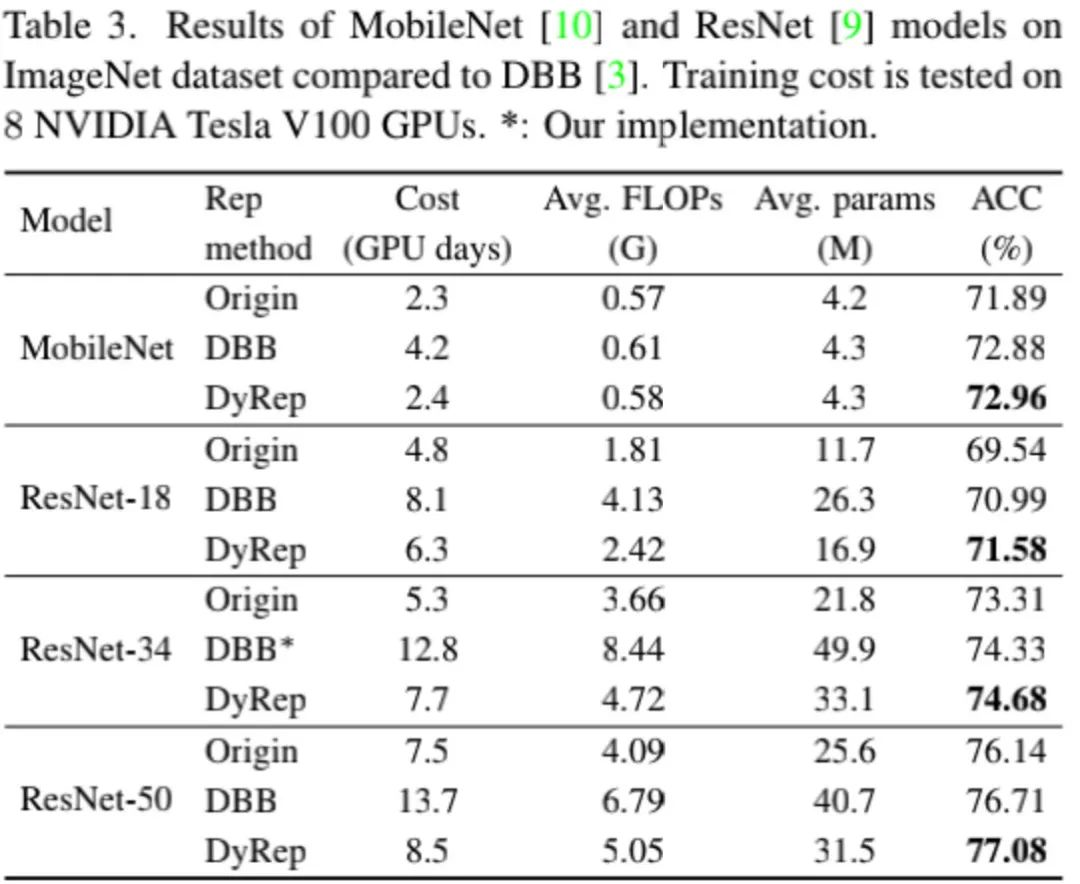

上表给出了ImageNet+ResNet基线上DBB与DyRep的性能对比,从中可以看到:相比DBB,所提方案可以取得显著性能提升,同时需要训练耗时更短。

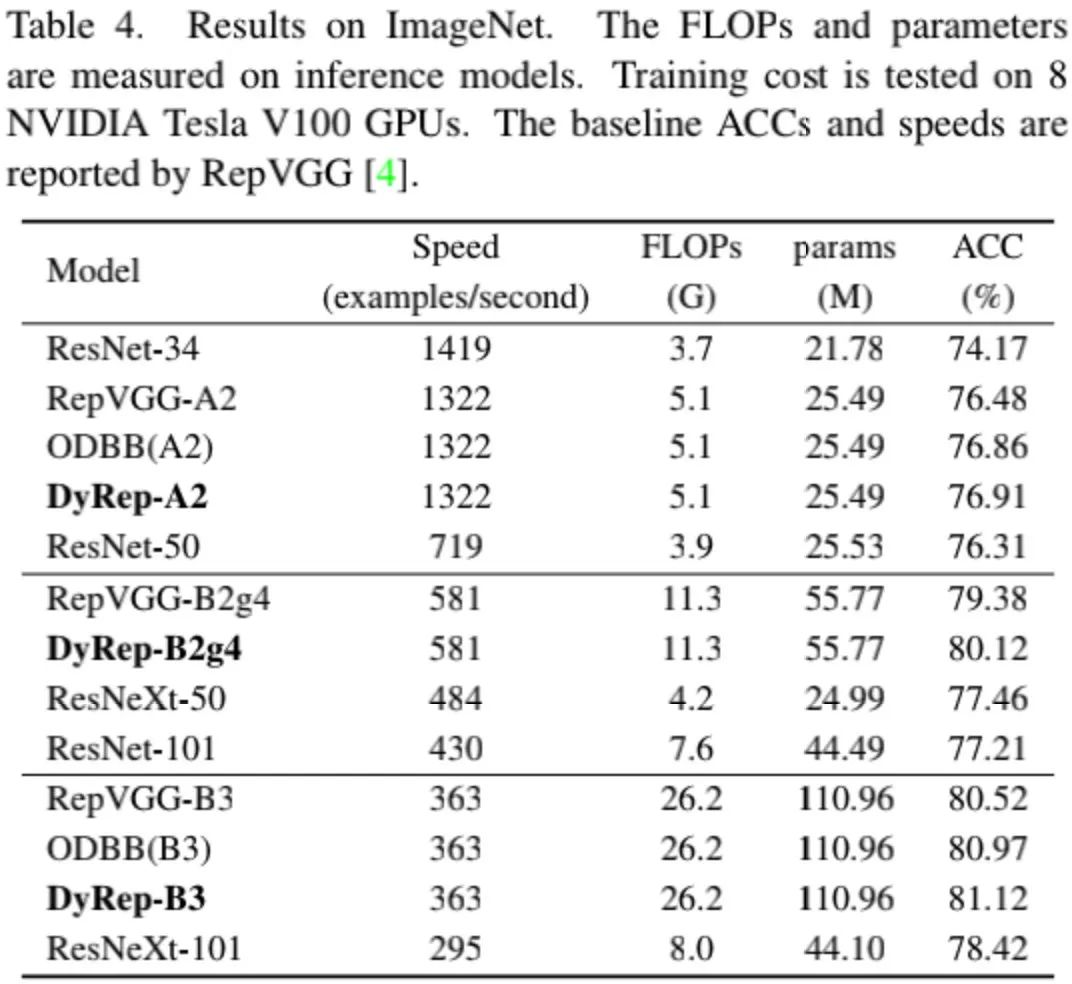

上表给出了所提方案与RepVGG以及RepNAS的性能对比,从中可以看到:相比RepVGG与RepNAS,DyRep取得了更高的精度。比如DyRep-B3取得了81.12%,比RepVGG-B3高0.6%,比RepNAS高0.15%。

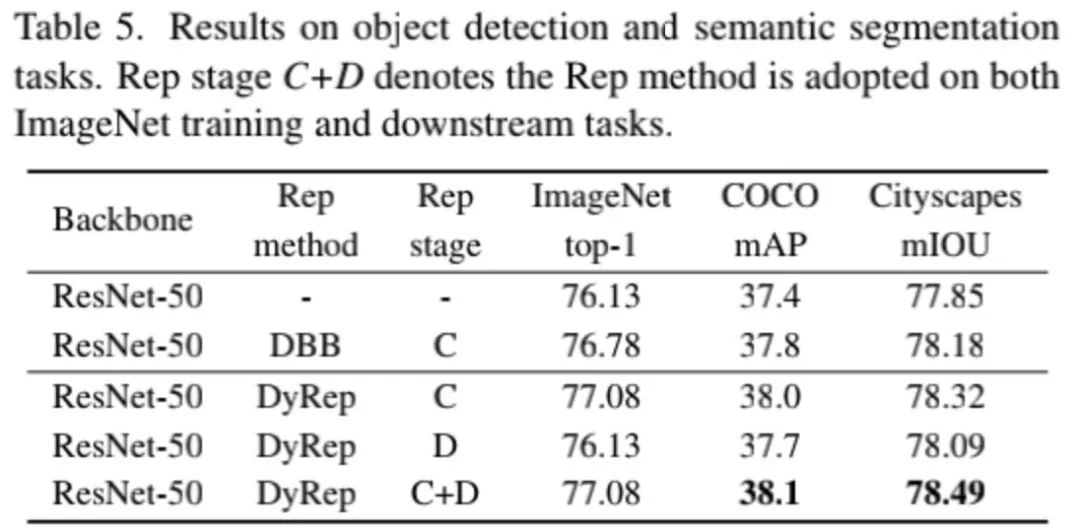

上表给出了下游任务上的性能对比,从中可以看到:相比DBB方案,所提方案可以取得更高的性能提升。

来源:AIWalker

作者:HappyAIWalker

推荐阅读

- ARM | 内容&硬件感知超分方案,让图像超分自适应适配不用算力平台

- CNN与Transformer相互促进,助力ACT进一步提升超分性能

- CVPR2022 | RepLKNet: 大核卷积+结构重参数让CNN再次伟大

- CVPR2022 | Restormer: 刷新多个low-level任务指标

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏AIWalker。