InfiniBand 技术正在不断创造更高的数据吞吐量记录,目前 200Gbps 网络已经普及,400Gbps 紧随其后。同时,通过 multi-path 技术将多网卡带宽性能聚合。原生支持 RDMA 技术,在保证高带宽输出的基础上,大大降低数据访问延迟,为高性能计算、人工智能、云计算、存储等众多数据密集型应用提供了强大的网络性能支撑。

焱融科技基于高性能分布式并发文件存储系统 YRCloudFile,并结合 NVIDIA Quantum InfiniBand 高速网络平台、NVMe SSD,推出追光 F8000X 全闪分布式文件存储产品,在充分释放性能的同时,实现系统随着业务需求动态增加节点数量,使得存储容量和存储性能都以线性方式增长,并有效平衡数据存储成本和空间扩展能力。

传统存储架构面临性能和低效传输带来的挑战

随着 AI、数据分析和 HPC 等新兴数据密集场景的深入融合,越来越多的企业不仅需要超高性能底层算力 ,更需要保证高带宽、高 IOPS、低延迟和稳定数据访问性能的存储系统,但是传统存储方案普遍存在以下几个问题:

1、由于存储介质、网络传输和文件系统本身的限制,存储系统很难同时兼顾高性能、高 IOPS 和低延迟的性能要求;

2、存储软件层面只能对于不同的数据存取模式采取相应设计和优化,很难全面兼顾产品性能表现。

因此,当前大规模计算平台对高性能数据存储产生迫切需求,并面临现有传统存储技术低效传输所带来的挑战。

焱融全闪 X NVIDIA InfiniBand:打造 AI 时代 GPU 计算的高性能存储技术

针对传统存储方案面临问题,焱融追光 F8000X 通过 NVIDIA Quantum InfiniBand 在 GPU 计算服务器和存储设备之间构建的高带宽和低延迟数据传输网络,以满足数据密集型应用系统的网络性能要求。对于存储网络,采用双 HDR 200Gbps InfiniBand 网卡,通过 multi-path 实现网卡聚合,理论可提供高达 400Gbps 的带宽性能,并支持 RDMA 技术,保证高带宽输出的同时,大幅度降低了数据访问延迟。

NVIDIA Quantum InfiniBand 作为业内领先、性能卓越的网络平台,为 AI、数据分析和高性能计算(HPC)应用提供高性能、高可靠,以及超低时延的网络连接能力。

目前,焱融追光 F8000X 所采用的分布式架构,可实现系统随着业务需求动态增加节点数量,使得存储容量和存储性能都以线性方式增长。为了能够获得卓越的性能表现,满足 AI 时代 GPU 计算对于存储系统的需求,焱融追光 F8000X 还进行了全方位的系统优化设计:

在分布式并行文件系统层面:首先,针对海量小文件场景,焱融科技提出用横向水平扩展的方式,把单点的 MDS 集群化,采用静态子树+目录 Hash 两者结合的方式,实现了元数据的分布存储,从而通过扩展元数据节点即可支持百亿级别的文件数量,极大提升了元数据的检索性能。

其次,焱融科技优先保证大文件 IO 的吞吐性能,将控制流和数据流(即元数据和存储数据 )分离,有效减少对 MDS 更新频率的同时,大幅提高 IO 性能。同时,为了保证小文件 IO 访问性能,焱融科技采用小文件内联、元数据缓存、文件信息 KV 化等技术手段,满足了企业对小文件有苛刻性能要求的场景需求。

最后关于目录热点的问题,焱融科技通过增加虚拟子目录的方式把热点分摊到集群中所有的元数据节点,不仅解决了元数据热点问题,同时也解决了单目录下文件数量问题。通过增加虚拟子目录使单目录可以支撑 20 亿左右的文件数量,并且可以根据虚拟子目录的数量灵活调整。

在数据传输层面:焱融科技在高性能分布式存储里实现了 RDMA 传输的功能,可以在几乎不消耗 CPU 资源的前提下达到极高的存储带宽、IOPS 和扩展性,支持通过 InfiniBand RDMA,以太网 RoCE 或 TCP 来实现客户端到存储服务端的数据交互,以及存储集群服务器之间的数据传输。

在物理存储层面:焱融追光 F8000X 采用 NVMe SSD 构建物理存储空间,并基于 NVMe 存储架构做出了深度优化,充分释放了 SSD 性能。不仅降低了延迟,提高了 IOPS 和吞吐量,还提升了服务器处理并发请求的能力。

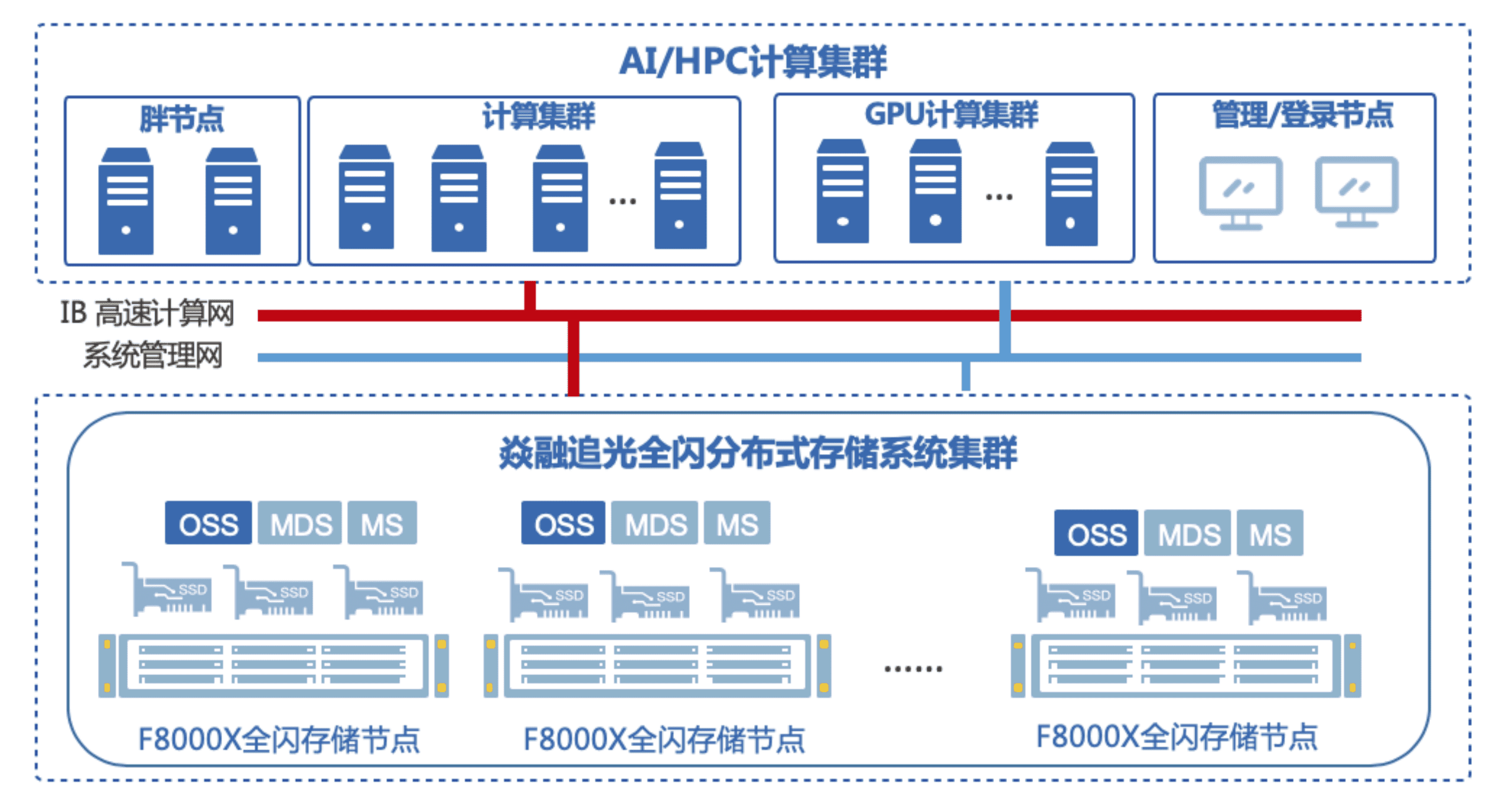

追光 F8000X 高性能存储解决方案架构

在追光 F8000X 高性能存储解决方案架构基础上,焱融科技服务了某家高科技企业,针对客户面临的海量小文件处理性能和存储并行访问等问题,提出了性能与成本兼顾的解决方案——通过追光 F8000X 所具备的海量小文件、高并发访问等特点,以及智能分层功能将冷数据自动下沉到本地对象存储,有效解决平衡数据存储成本和空间扩展的问题。

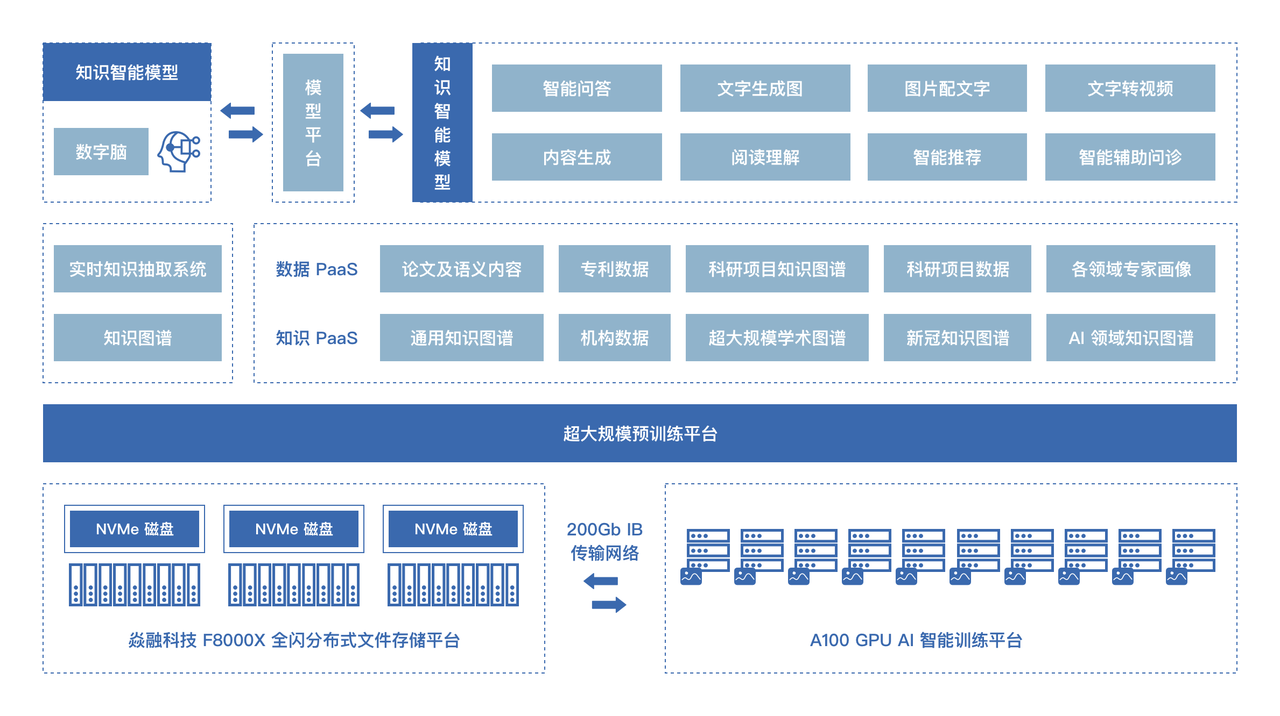

AI 训练平台存储解决方案架构图

在落地实施追光 F8000X 后,用户有效解决了在数十亿文件场景下,元数据操作性能和小文件访问性能衰减的问题,极大地提升了 AI 业务的计算分析能力,并有效降低了整体 TCO。

高负载、低延迟,追光 F8000X 让性能无懈可击

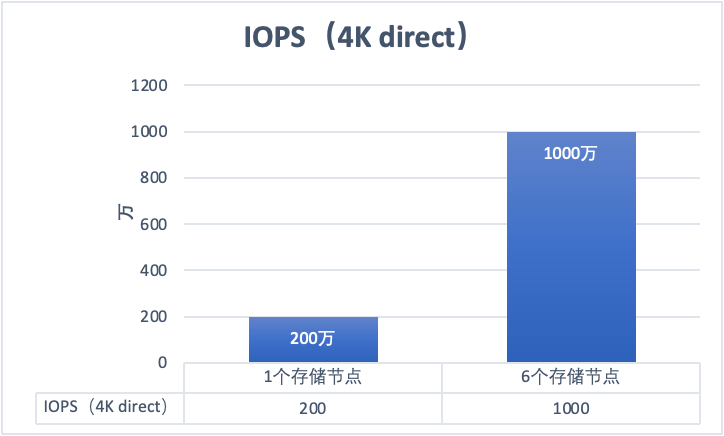

在实际测试中,焱融追光 F8000X 每节点配置为 AMD EPYC 64 核心处理器,256GB 内存,2 块 200Gbps HDR InfiniBand 网卡,测试数值如下:

带宽性能

IOPS 性能

结合 NVIDIA Quantum InfiniBand 强大的网络传输性能,追光 F8000X 优异的性能测试,实现单个存储节点达到 40GB/s 带宽、200 万以上 IOPS。同时, 由于存储采用的是分布式架构,性能可以实现线性提升,在 6 存储节点时,性能可达 1000万 IOPS,210GB/s 带宽, 并在高负载情况下,依然可保持 130μs 以内的延迟。