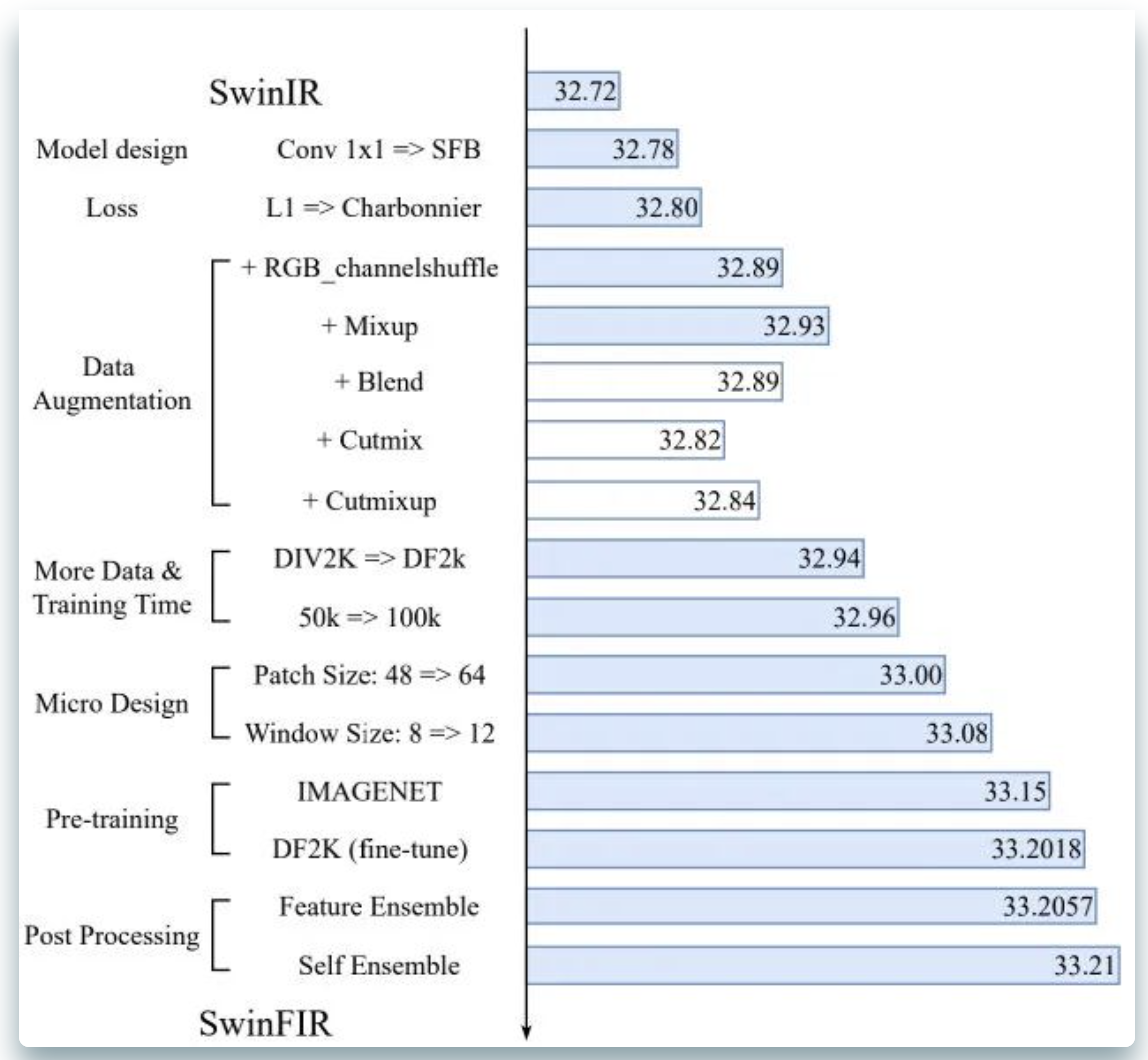

看上图,有没有觉得好熟悉?好像是ConvNeXt?对,也不对。它就是超分领域的那个"X":依托SwinIR而衍生出来的SwinFIR。很明显,上图就给出了本文的研究脉络:

- 模块层面的设计,引入SFB模块,后面会进行介绍;

- 损失函数的调整,从L1调整为Charbonnier(好像视频超分中用这个更多)

- 数据增强的引入:打破"常识",ChannelShuffle与Mixup竟然可以涨点0.13dB

- 更多数据、更长训练周期:已被多次验证可行性;

- 针对Transformer的微观改进:SwinTransformer的块尺寸调大

- 预训练技巧引入:已在IPT、EDT中得到验证;

- 后处理涨点技巧:受启发于自集成,提出了特征集成涨点技巧(有些类似于EMA,但又不一样)

总而言之,通过上述不同维度的探索与尝试,所提SwinFIR取得了显著的性能提升。从笔者角度来看,值得称道的主要是以下两点:(1) 数据增广技巧的探索与分析;(2)自集成涨点技巧的提出。

本文方案

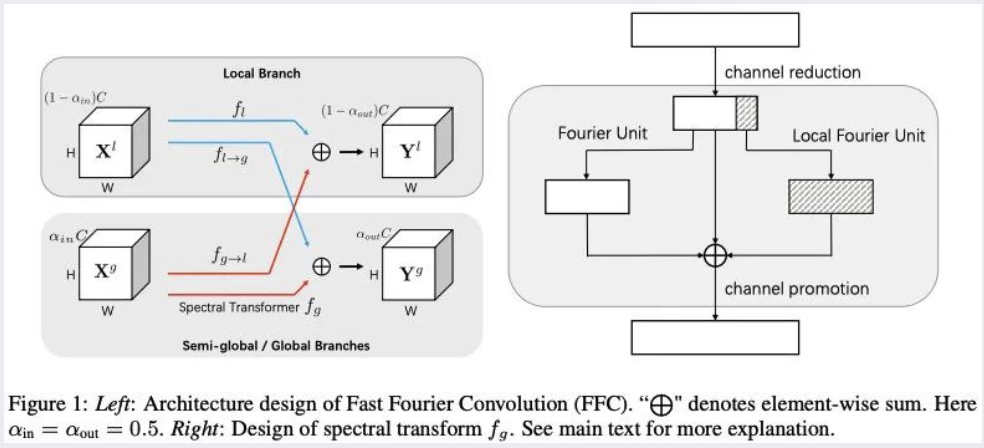

上图给出了所提SwinFIR架构示意图,在SwinIR基础上将RSTB与body部分的Conv替换为SFB即可,这个没什么好介绍。这就只是对SFB进行一下介绍好了。

SFB引入了FFC模块,即快速傅里叶卷积。FFC可以用一句话来概括:为捕捉全局特征正而提出的一种新的卷积模块。它首先将空间特征采用傅里叶变换到频域,然后在频域做卷积处理,最后再通过傅里叶逆变换回去。关于FFC的架构可参考下图,源自《Fast Fourier Convolution》

# 实现伪代码

def FFC(x):

y_r, y_i = FFT(x)

y = Concatenate([y_r, y_i], dim=1)

y = ReLU(Conv(y))

y_r, y_i = Split(y, dim=1)

z = iFFT(y_r, y_i)

return z

此外,针对经典图像超分与轻量型图像超分,作者设计了两个版本的SFB模块,见上图。区别只是左侧的残差分支,这个没什么好介绍的,直接略过。

Data Augmentation

Radu Timofte等人于CVPR2016提出的"超分七把刀"表明:基于空域变换的旋转、镜像空域有效提升超分性能。相关方案已被广泛应用low-level任务中。尽管像素域的数据增广在high-level任务中得到了广泛应用并取得了显著成果,但是在low-level任务中却鲜少进行探索。

本文则对其他像素域数据增广方法(如RGB空间的通道置换、Mixup、Blend、CutMix、Cut-Mixup)的有效性进行了回顾。如前面图示所看到:除了CutMix与Cut-Mixup这种会破坏视觉连续性的方案外,其他方案均取得了性能上的提升。

更多训练数据、调大Transformer模块的窗口尺寸、模型预训练已在IPT、EDT研究中得到了证实,所以本文作者就没有进行深入分析,故略过。

Feature Ensemble

一般来讲,模型训练完成后,只会保留在验证集上指标的那个,其他临时模型则会被删除。多模型击沉关于自集成两种有效的提升超分性能的方案,但两者往往会导致更长的推理耗时。

- 多模型集成:它将多个模型的处理结果进行组合;

- 自集成:它对输入图像的不同变换进行处理,然后将多个结果进行平均。

本文提出一种不会影响训练或测试周期的新的集成策略:特征集成。该集成策略可以有效提升模型的性能并可以用于任意任务,包含high-level与low-level。

其中,n表示用于特征集成的模型数量,表示每个模型的加权值,默认。

实验部分

关于训练数据与模型配置相关信息可参考下表,基本上参考EDT一文进行的。此外,作者还在Stere ISR任务上进行了训练验证。

| Pre-Train | Train | Aug | PatchSize | block | stl | channel | head | win | |

|---|---|---|---|---|---|---|---|---|---|

| Classifical | ImageNet2012 | DF2K | chanel shuffle, mixup etc | 60x60 | 6 | 6 | 180 | 6 | 12 |

| Lightweight | ImageNet2012 | DF2K | chanel shuffle, mixup etc | 60x60 | 4 | 5 | 60 | 6 | 12 |

关于训练超参数信息如下:

- 优化器:Adam常规配置;

- 学习率(预训练阶段):初始2e-4总结训练1M次迭代,分别在500k、800k、900k以及950k时折半;

- 学习率(微调阶段):学习率设为1e-5。

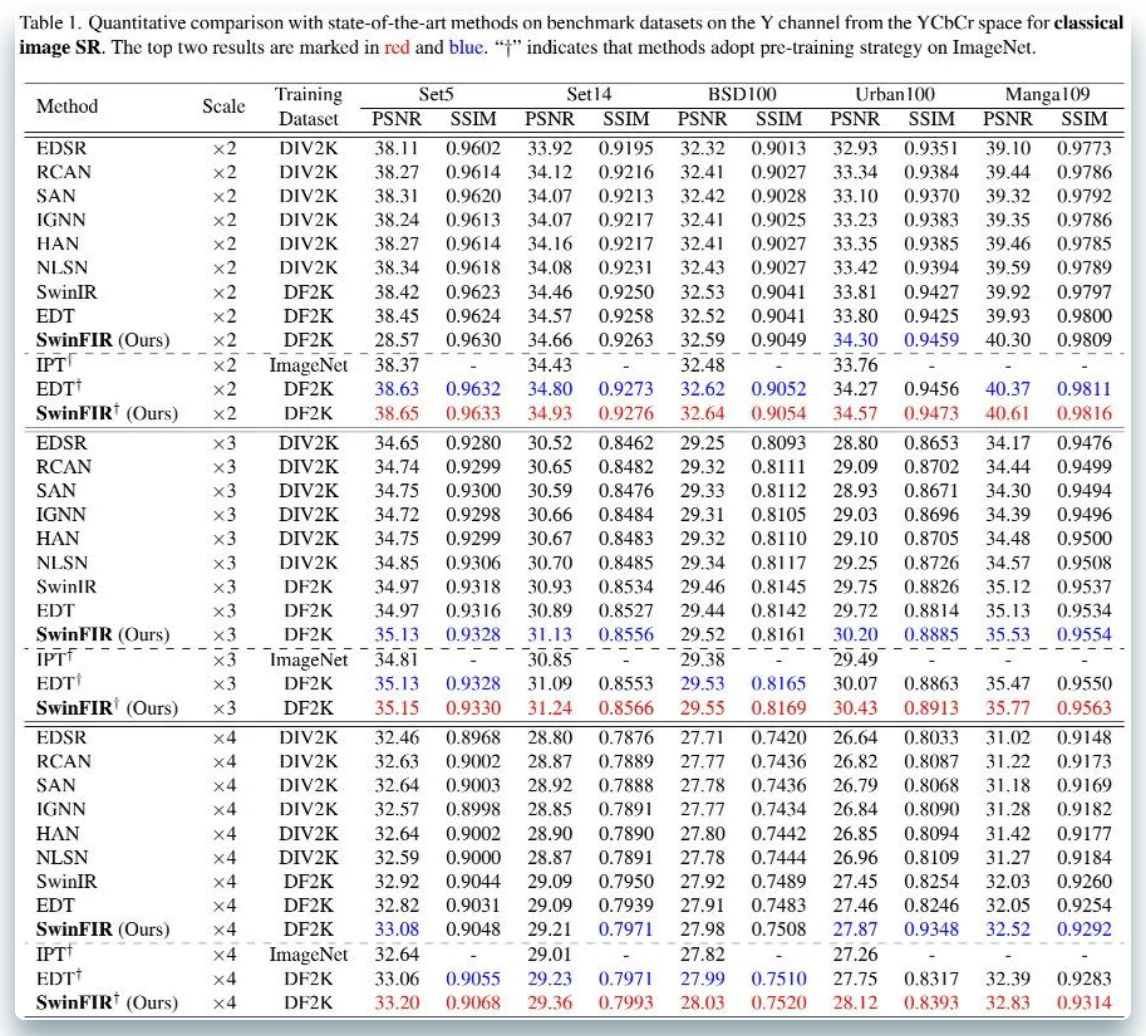

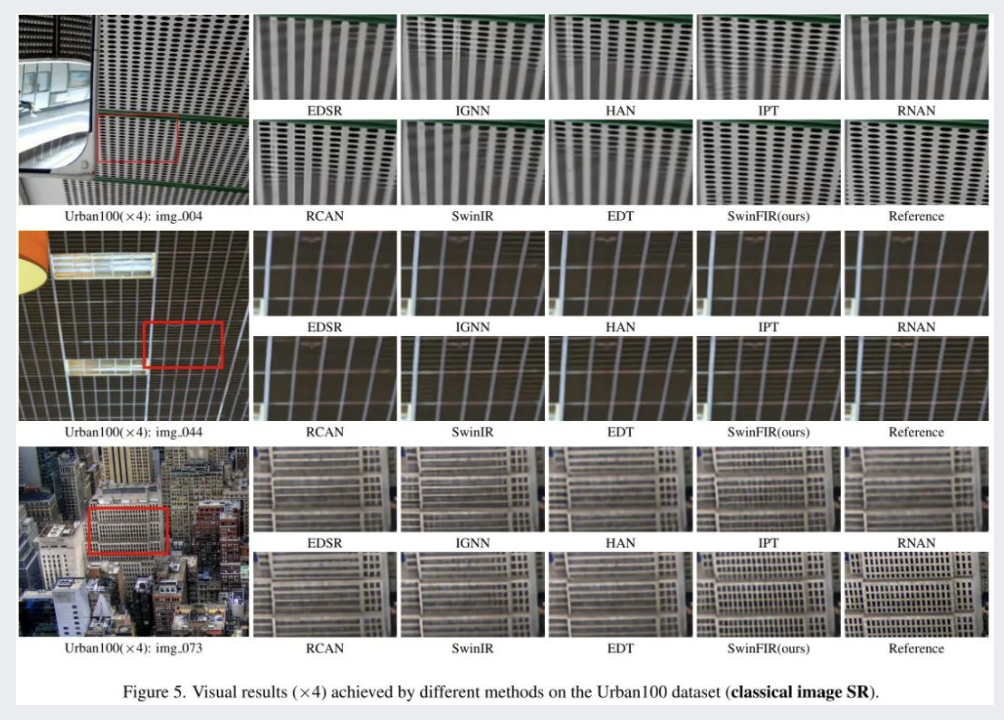

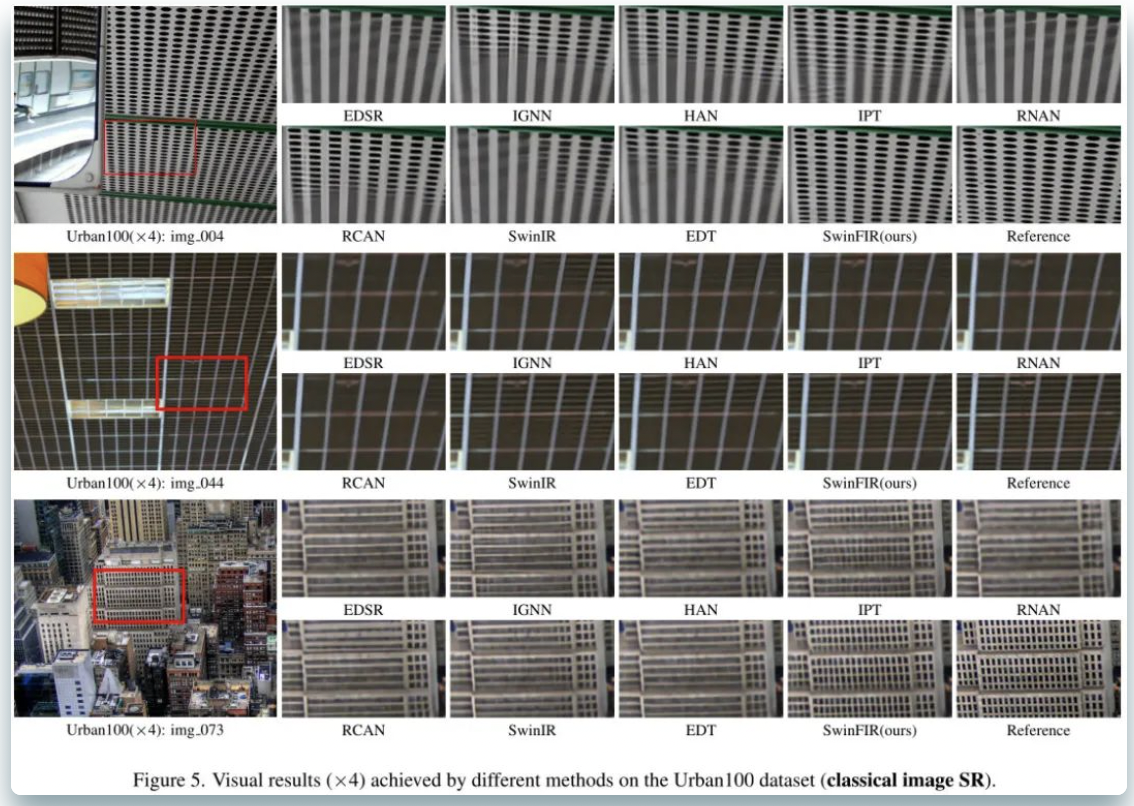

Classical Image Super-Resolution

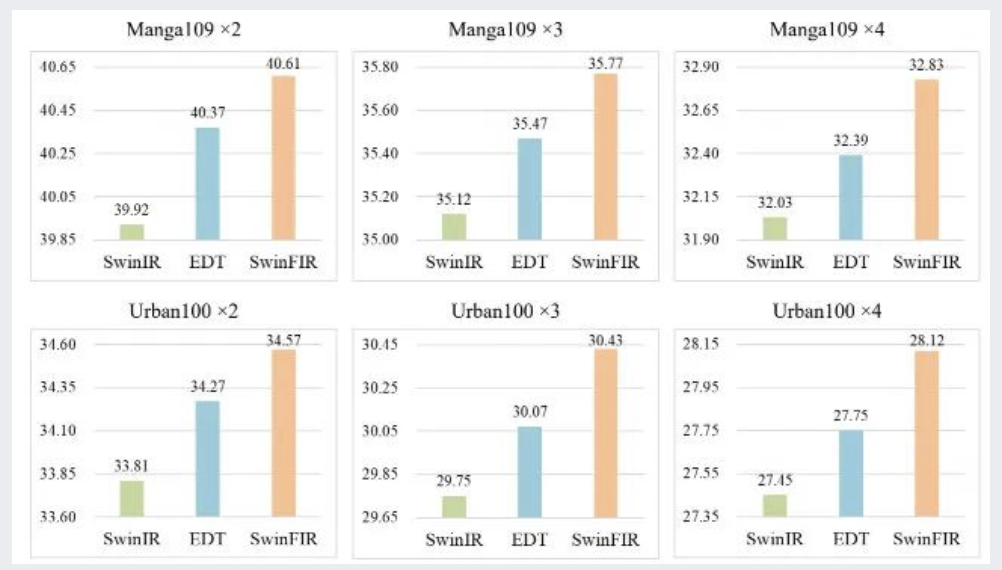

上表与图给出了常规图像超分指标与直觉效果对比,从中可以看到:

- SwinFIR在X2、X3以及X4任务上均取得了最佳指标。值得一提的是,相比SwinIR,Urban100@X4与Manga109@X4的指标分别从27.45dB、32.03提升到了28.12dB、32.83dB,提升达0.77dB与0.80dB。

- 从视觉效果可以看到:SwinFIR重建效果更为清晰。受益于FFC,该方案尤其擅长于重建周期性纹理。

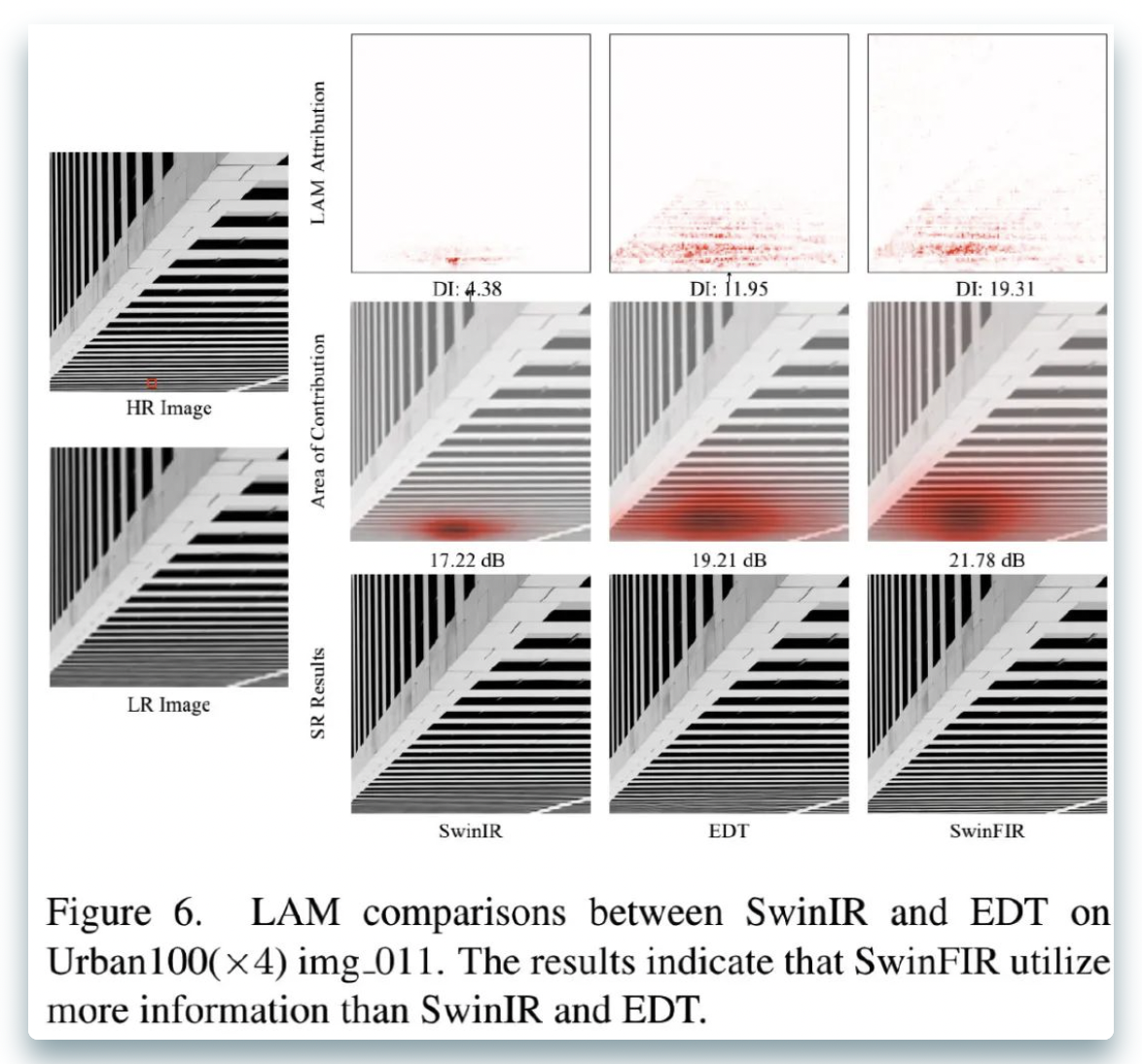

上图从LAM角度对SwinIR、EDT以及SwinFIR进行了分析,可以看到:

- 从DI角度来看,SwinFIR方案可以利用更多相关的像素进行重建;

- 从Area-of-contribution角度来看,几乎全部的像素均参与了SR图像的重建,而SwinIR的感受野则比较有限。

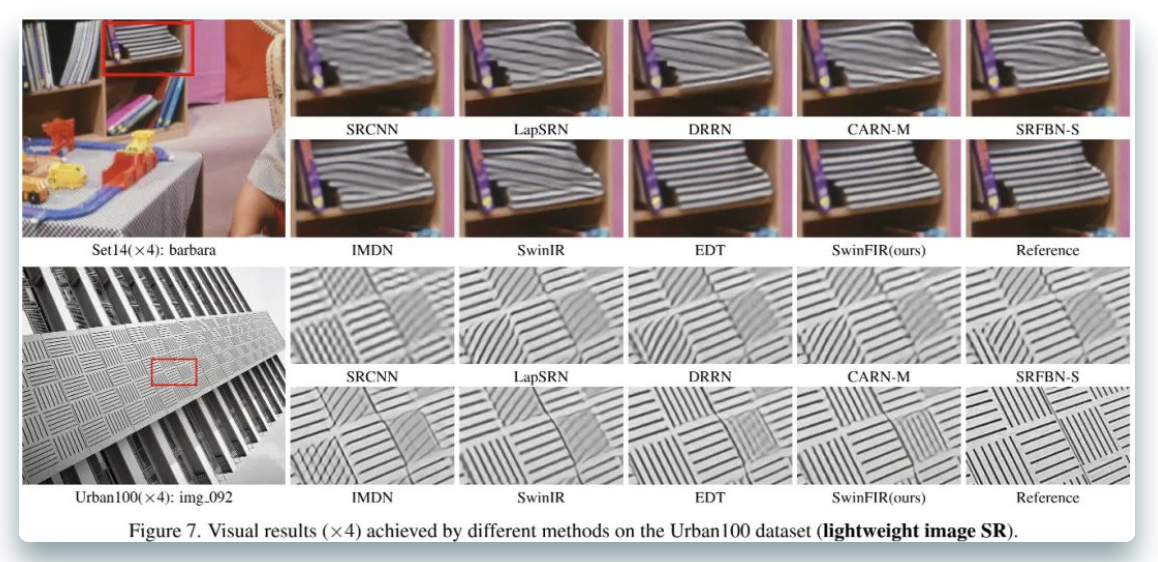

Lightweight Image Super-Resolution

上图与表对轻量型超分模型性能进行对比,可以看到:

- 所提方案取得了最佳的指标,值得一提是:同等参数前提下,SwinFIR比EDT和SwinIR高出0.15dB与0.58dB(Manga109@X4)。

- 从视觉角度来看,SwinFIR重建结果更为锐利,包含更多的高频细节信息。

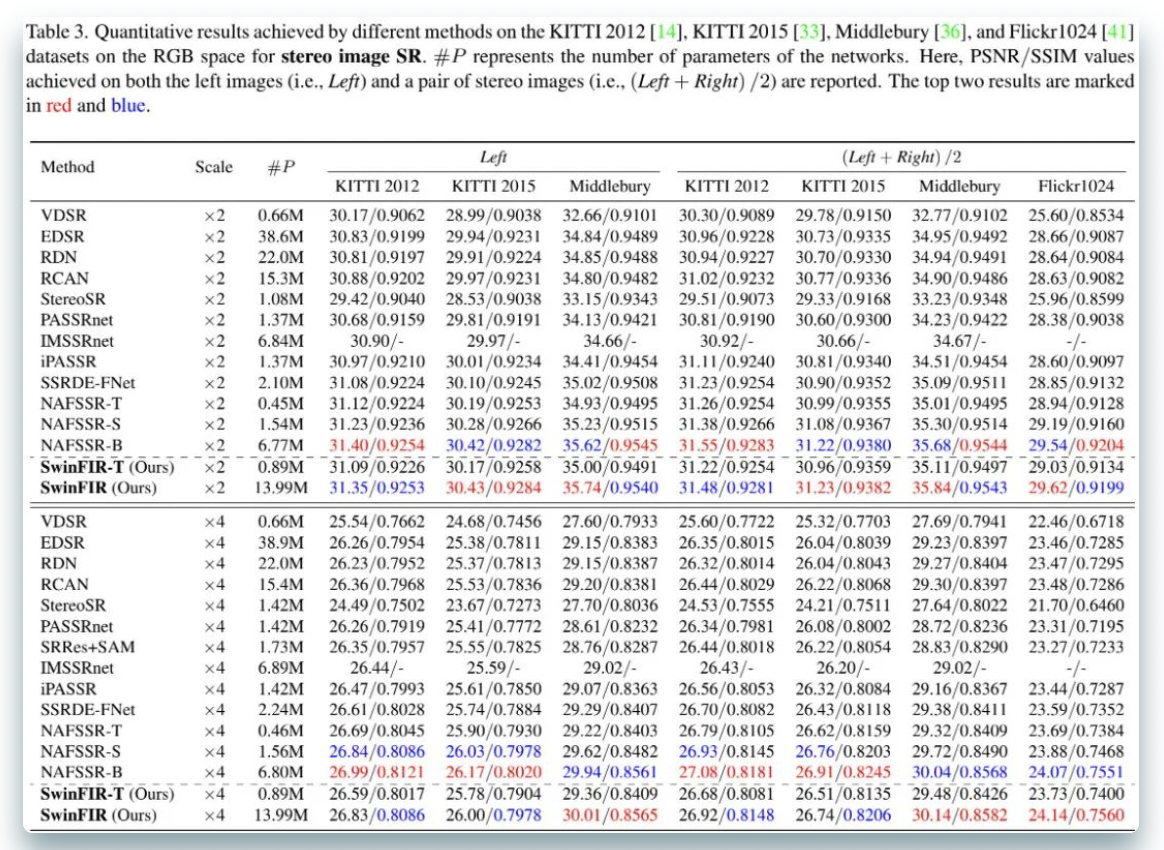

Stereo Image Super-Resolution

Ablation Study

上图对不同的数据增强的有效性进行了实验,从中可以看到:

- 相比镜像与旋转,通道置换与Mixup可以将PSNR指标从32.78dB提升到32.93dB;

- 但是,并不是所有增广均能涨点。尽管CutMix与Cutmixup能提升high-level任务性能,但会导致low-level任务性能下降。源自在于:这两种方案破坏了图像中的视觉连续性。

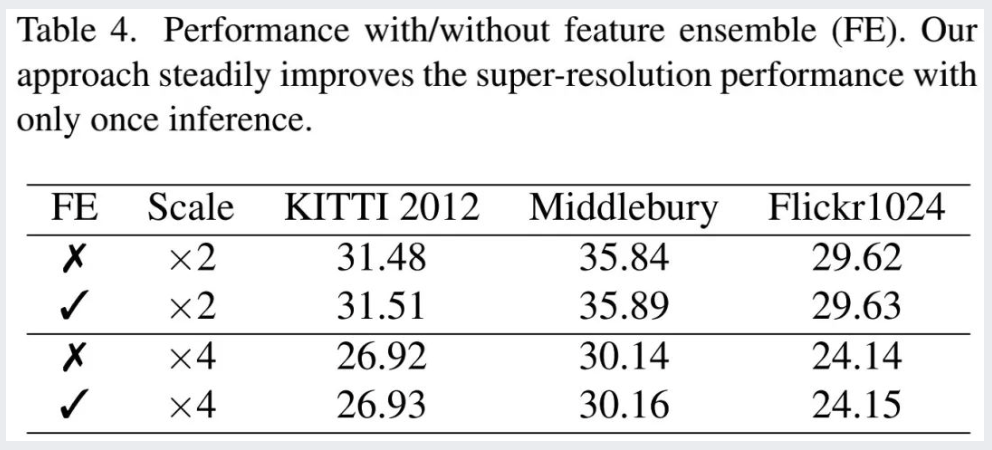

已有研究表明:自集成可以提升超分性能指标,但会导致更长的推理耗时。受启发于自集成,本文提出了特征集成策略。相比自集成,新的策略不会导致任何额外训练与推理耗时。性能提升情况可以参考上表,还是比较稳定的涨点方式。

来源:AIWalker

作者:Happy

推荐阅读

- 全新范式 | 沈春华老师团队提出无需解码器的目标检测器DFFT

- MobileOne: 移动端仅需1ms的高性能骨干,你值得拥有!

- 近距离接触盲图像超分:退化模型、基线以及性能上限

- 恺明团队新作:MAE"入局"视频表达学习

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏AIWalker。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。