本文提出了一种Hybrid Vision Transformer架构FastViT,它取得了更优的延时-精度均衡。具体来说,

- 提出了一种新的Token Mixing操作RepMixer作为FastViT的基础部件,它采用结构重参数机制移除跳过连接以降低访存占用

- 引入重参数机制与大核卷积进一步提升模型性能;

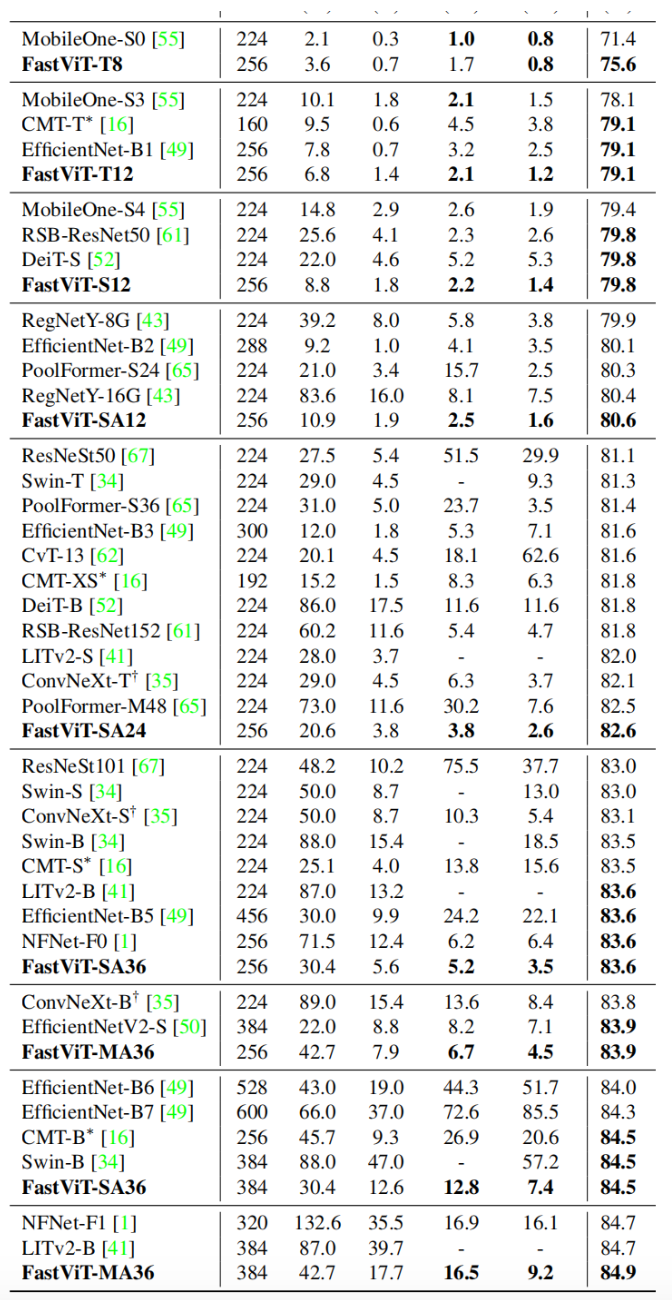

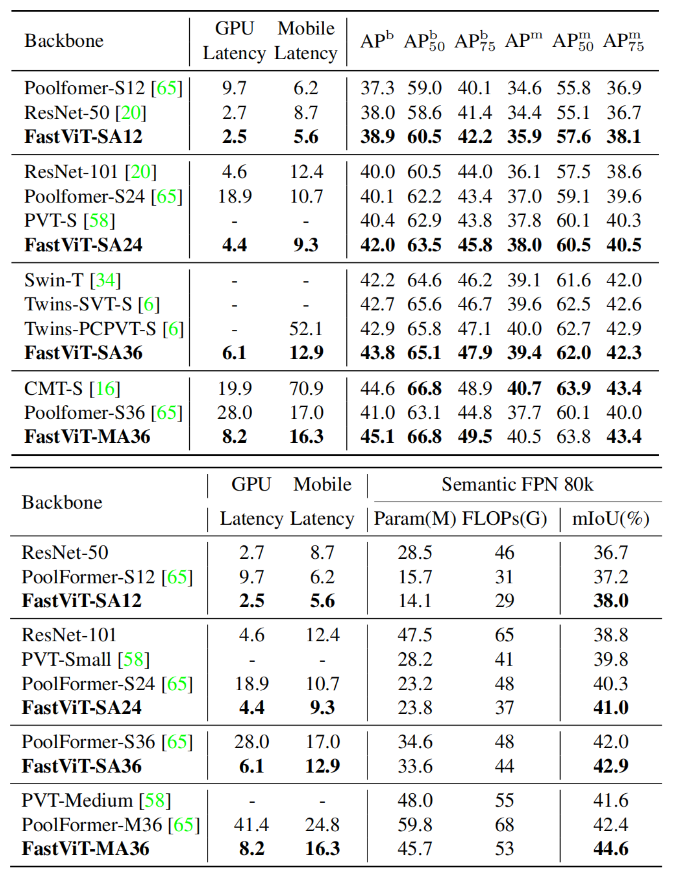

- 在同等延迟下,相比MobileOne,FastViT精度高出4.2%;在同等精度下,FastViT比EfficientNet快4.9倍,比ConvNeXt快1.9倍。

本文方案

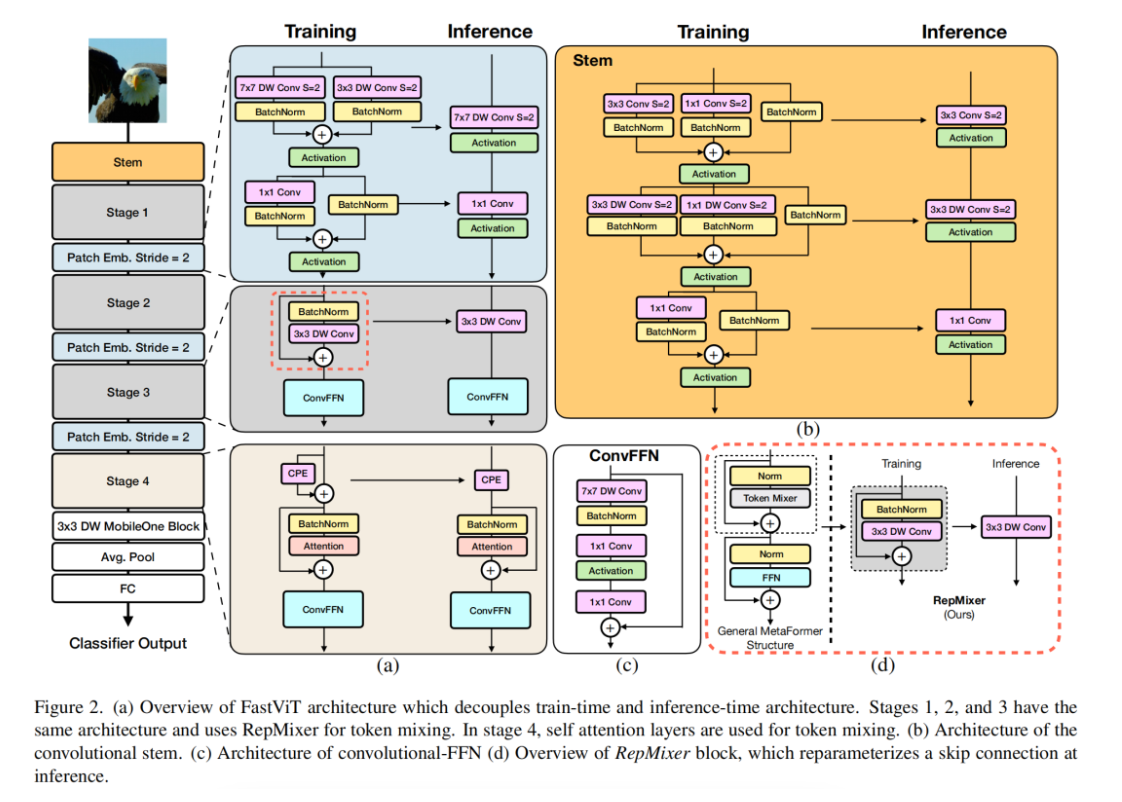

上图给出了本文方案架构示意图,非常经典的4-stage架构。

- 它采用RepMixer作为基础部件,RepMixer采用结构重参数机制移除跳过连接,进而缓解了访问占用消耗(见上图d)。

- 为进一步改善效率与性能,作者将stem与下采样模块的稠密卷积进行拆解并引入重参数机制。

- 自注意力机制在高分辨率阶段计算度过高,作者采用大核卷积作为替代,仅在第4阶段使用自注意力。

RepMixer

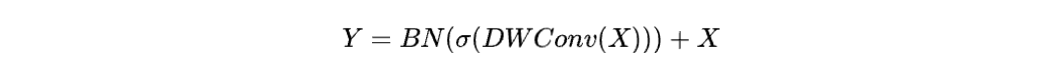

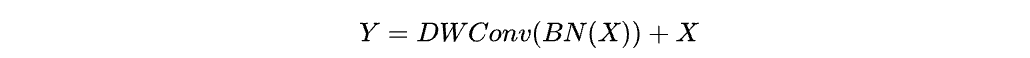

ConvMixer采用如下方式进行Token Mixing处理

作者再次基础上进行了简单的重排并移除非线性激活函数

很明显,上述操作在推理阶段可以折叠为简单的DWConv操作。

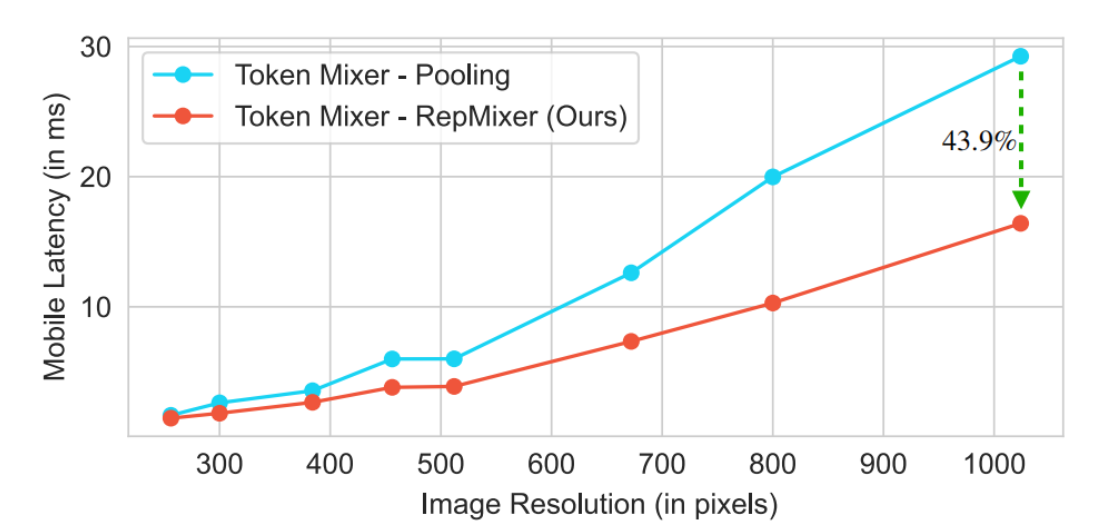

Empirical Analysis

上图对Poolformer与RepMixer进行对比分析,可以看到:相比Pool操作,RepMixer可以大幅改善推理效率。

本文实验

来源:AIWalker

作者: Happy

推荐阅读

- ARM | 内容&硬件感知超分方案,让图像超分自适应适配不用算力平台* CVPR2023 InternImage已开源

- GFSNet | 高低频分离超分方案

- 南京大学&港中文提出首个支持超高分辨率(10000x10000)图像风格迁移方案

- 深入分析MobileAI图像超分最佳方案:ABPN

- HDRUNet | 深圳先进院董超团队提出带降噪与反量化功能的单帧HDR重建算法

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏AIWalker。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。