AI Codec自2016年首次提出以来,众多海内外高校、企业研究院等机构对此展开了广泛研究。6年时间里,AI Codec 的SOTA方案的压缩性能已经超越了H.266(最新的传统Codec标准),展现了强大的技术潜力。但受限于计算复杂度、非标等原因,AI Codec在应用落地方面的案例却屈指可数。LiveVideoStackCon2022北京站邀请了来自双深科技的田康为大家分享基于双深科技的AI Image Codec技术落地探索经验。

文/田康

编辑/LiveVideoStack

大家好,本次分享的主题为:AI Image Codec技术落地实践,主要将分三部分介绍我们在移动端方面取得的技术成果。第一部分介绍图像视频行业发展趋势和我们的理解;第二部分简单总结AI Codec发展;第三部分为重点,即AI Image Codec移动端落地实践。

-01-

图像视频行业发展趋势

首先介绍图像视频行业发展趋势,“我们身处图像数据大爆发的时代”可能已成为了一项行业共识。据我们从相关机构取得的调研数据显示,全球图片视频数据总量至2025年预计将超过140ZB,每年的数据复合增长率达到27%,这是一个很恐怖的数量级。随着近年来ChatGPT等技术的火爆,相信增长率还会进一步提升。

简单分析数据量迅速增长的原因:首先是在医疗、安防等应用场景下,影像数据按照国家政策要求需要长期或永久存储,导致数据积累量越来越大。第二是随着大众对高画质、高帧率等高质量视频需求的增长,导致数据密度提升。第三是随着视频数据在互联网、安防、无人机、云游戏(不同于传统游戏,过程中伴随着超大量视频传输)等等多种应用场景的拓展带来了数据量的巨量增长。

那么要高效运用这些数据必定伴随着压缩、传输和存储等底层技术的发展优化,我们认为压缩技术的提升是其中的关键,主要原因有三个:首先是带宽和存储的提升是有瓶颈的。其次针对野外巡检等特殊应用场景,增加带宽并不适用。第三是存储和带宽的提升并没有从根本解决传输数据量庞大这个问题。

上图为我们设计的视觉AI应用链路图,首先通过摄像头或计算机生产影像内容,然后进行修复、剪辑或AI审核等处理,并将数据呈递给用户进行数据查看,过程中可能伴随着AI动作识别交互或超分,随后传递至存储设备进行数据存储。在应用前通过文本、图片、跨模态等检索方式查找所需的数据,最终可以对其进行结构化解析和隐私/分布式计算等应用。

可以看到整个流程都由编解码来进行衔接。同时在每个环节都可能存在AI的应用,这也是数据处理后续的发展趋势。

和传统编解码相比,AI端到端编解码在天然上更适应这种趋势。从算法层面来看,AI编解码以提取的图像特征直接进行下游应用,从而节约了下游特征提取计算量。从硬件层面来看,AI的大量应用使当下硬件都或多或少地带有AI算力,这同时为AI编解码的应用创造了条件。

-02-

AI Codec发展

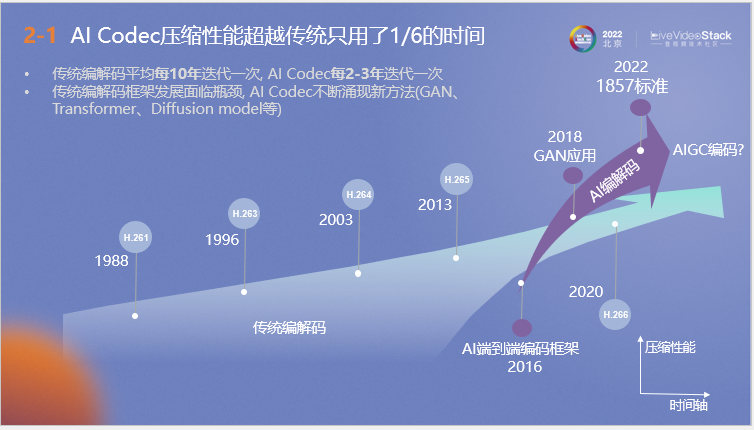

接下来介绍AI Codec的发展,上图为传统和AI编解码发展历程的对比。可以看到,AI Codec压缩性能超越传统的H.264、H.265仅使用了传统方法1/6的发展时间。从1988年的H.261到2020年的H.266,相较于传统编解码器平均十年一次的迭代频率,AI编解码实现了飞速发展,从2016年端到端编码框架的提出到后续GAN、1857标准的应用,甚至是后续AIGC编码发展方向的出现,它在短时间内不断涌现可落地应用的各种新方法。

另一方面是AI芯片行业的发展同时为AI编解码提供了落地土壤。近年来GPT-4、AIGC的大规模使用在侧面推动了AI芯片业整体的快速发展,随着行业利好,高通等著名边缘芯片企业也在逐步启动对AI芯片的开发研究。其次是存算一体、类脑芯片、量子计算等未来技术为芯片算力发展带来了更好前景。

-03-

AI Image Codec移动端落地实践

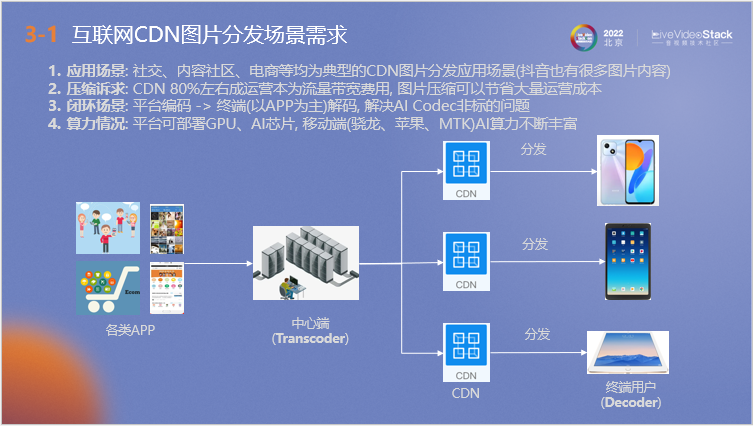

接下来介绍我们关于AI Image Codec在移动端的落地实践,以互联网移动端CDN图片分发场景为应用场景,首先解释采用该场景的原因。

第一,当下大量社交、内容社区、电商APP均涉及该场景,中心端以一对多方式进行图片的分发,即使是抖音这种小视频平台也会涉及很多图片内容。同时由于CDN 80%左右的运营成本为流量带宽费用,因此它有很大的图片压缩诉求,优化图片压缩技术可以有效节约成本。第三是该场景为闭环场景,可以解决目前AI Codec非标的问题。最后是移动端的AI算力相对于其他物联网设备较强,可以实现更好的编解码效果。

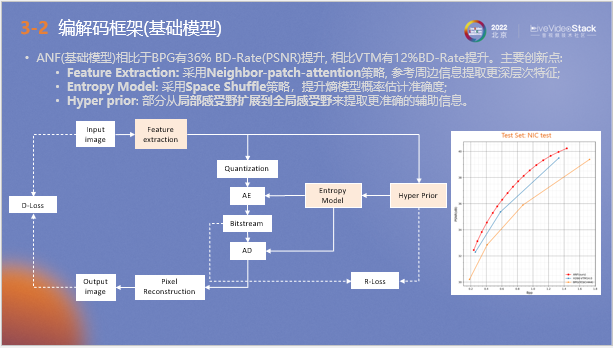

以上为我们自研的AI图像编解码模型框架,它被称为ANF。不同于传统编解码器通过分块预测处理来进行数据压缩,ANF编解码器在接收图片后,通过神经网络提取高层像素规律作为数据量化和辅助熵模型概率预估的依据。数据最终传递至传输端进行熵解码和像素重建,向用户呈现图片。

我们在整个流程中针对AI训练设置了两个约束,第一是R-Loss,它代表比特流和超先验的存储信息量;第二是D-Loss,它用于衡量输入和输出图片之间的质量差,以上两个指标都需要保持尽量小。

针对该模型我们也提出了一些优化策略,如在特征提取阶段采用Neighbor-patch-attention策略来参考周边信息,提取更深层次特征。其次是在熵模型概率预估阶段: 采用Space Shuffle策略,提升概率估计准确度。第三是在超先验阶段,将局部感受野扩展到全局感受野来提取更准确的辅助信息。

右图为测试结果,其中红线代表ANF模型数据,可以看到相比于VVC等传统编码器,它的测试结果要超出0.5~0.7dB左右。

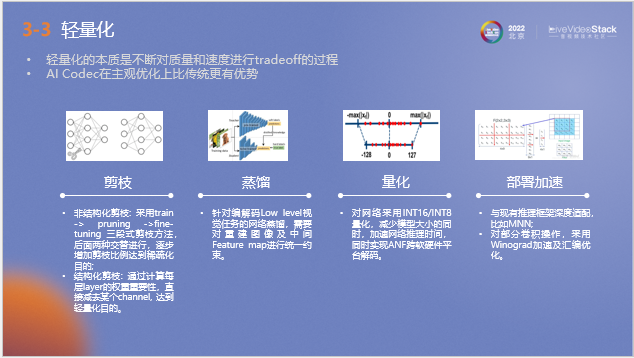

由于ANF模型的架构比较复杂,为了更好的在移动端上进行应用,我们对它进行了轻量化处理,在量化和部署加速方面做了相当多的工作。在画质损失尽量小的前提下尽量获取加速收益。

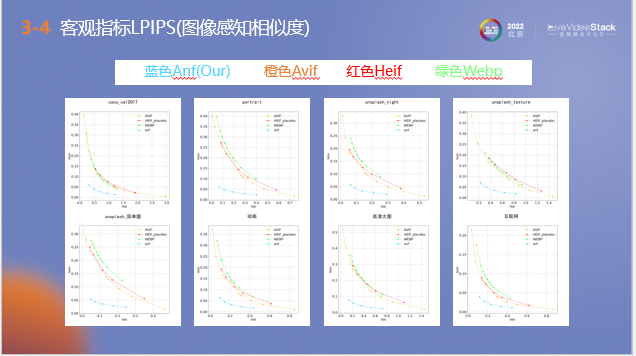

以上是轻量化后的ANF模型和其他编解码器使用LPIPS指标测试的对比结果,用于衡量ANF和其他编解码器之间的差距,该指标越小代表压缩后的图像和原图主观质量越接近。通过在多种场景下测试可以看到,ANF压缩的图片质量要明显优于其他编解码器。

在客观指标结果较好的基础上,我们组织对压缩图像进行了主观评测,选择了数十种不同场景,约两万张涵盖不同分辨率的图片作为数据集进行测试。以avif的压缩图像作为基准进行对比,按照三种不同比例将原始图片用ANF和avif编解码器进行压缩,将压缩后的图片从相同位置裁取100*100左右大小的块,与原图对应小块对比压缩画质,最后征集志愿者进行测评。

下表为评测结果,可以看到同体积下,主观选择ANF的比例(49.4%)明显高于AVIF(18.6%),说明ANF主观质量明显比AVIF好; 体积比为1:1.4时,结果与1:1时相同;体积比为1:2时,选择ANF和AVIF的次数相当,且有较大比例“不选择”,说明两者主观画质相当。

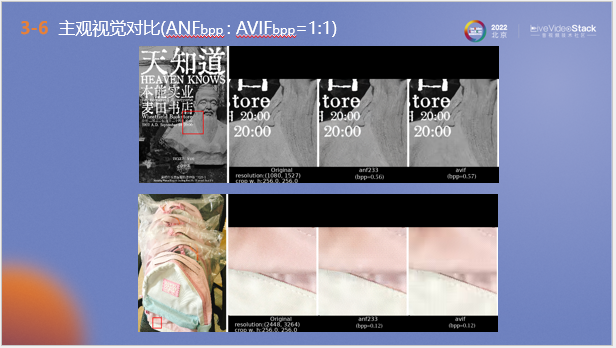

以上为同体积比下,两种编码器的测试效果图,可以看到ANF压缩图片的质量和原图更加接近。

以上为体积比为1:1.5时,两种编码器的测试效果图。可以看到ANF的图像细节效果仍然不错。

接下来介绍ANF的解码速度,我们在骁龙8gen1平台上对解码速度进行了测试,使用自封SDK测试从图片载入到最终在移动端显示所需的时间。可以看到在1080P分辨率下,ANF的平均延迟可以达到29.4毫秒,这个量级是人眼感受不到的,可以满足应用需求。

以上为编码吞吐对比结果,在同样的硬件条件下和传统编码器相比,ANF可获得10-30倍的编码加速。

以上为压缩对二次识别检测影响的测试结果,选取了精确率和召回率两个指标进行衡量。可以看到在低压缩比下,ANF压缩图片的检测精度略高于avif, 两项指标与原图相当;在高压缩比下,ANF压缩图片的检测精度明显高于avif, 与原图的差距保持在2-5%范围。

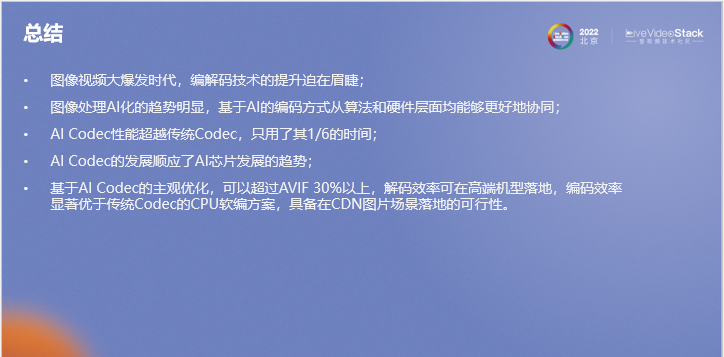

接下来进行总结,首先在当前的图像视频大爆发时代,我们认为编解码技术的提升迫在眉睫和势在必行的。第二是图像处理AI化的趋势明显,基于AI的编码方式从算法和硬件层面均能够更好地协同。第三是AI Codec的发展速度很快,未来发展前景光明;同时AI Codec的发展也顺应了AI芯片发展的趋势。最终我们基于AI Codec的主观优化,可以超过AVIF 30%以上,解码效率可在高端机型落地,编码效率显著优于传统Codec的CPU软编方案,具备在CDN图片场景落地的可行性。我的分享到此结束,谢谢大家!

__▲扫描图中_二维码_或点击“_阅读原文_” ▲

查看更多LiveVideoStackCon 2023上海站精彩话题