//

编者按:随着流媒体技术、虚拟化技术和云技术的发展,也伴随着疫情等客观因素,远程制作的应用越来越广泛,虚拟化及云端制作也逐渐开始起步,一种全新的转播模式也在被世界各大重要赛事所接受,所认可。远程制作和虚拟化云端制作到底能给客户带来什么,是制作质量的提升,类似于HDR,4K,8K,三维声给我们带来的全新的视听体验,还是制作成本的大幅减少,这是值得讨论的。

本次分享分三个部分,第一部分介绍SMT的几个重要的远程制作案例,第二部分介绍虚拟化及云端制作的一个初步尝试案例,最后是对未来融合制作模式的一些思考。

文/翟爽

整理/LiveVideoStack

大家好,过去几年,我所在的SMT在远程制作和虚拟化云端制作方面进行了一些探索,今天借此机会和大家分享我们在该领域的一些经验与思考。

首先简单介绍下SMT,如图所示。

再看下我们的一些合作伙伴。SMT在2018年参与平昌冬奥会,也参与了东京奥运会和北京冬奥会等。

再回到我自己所在的团队——SMT天鹰转播是专注于转播的团队,具有二十余年的国际合作和国际转播经验。

接下来介绍下我自己,我从2007年进入电视转播行业,一直专注于LIVE BROADCASTING,经历了各项重大赛事的转播活动。

我今天的分享主要从以下几个方面展开:首先是介绍一下SMT对远程制作的理解,以及远程制作目前需要解决的问题;接下来会分享SMT在远程制作领域的实践案例,和大家一起来感受技术的发展如何应用于远程制作的模式迭代;然后会简要分享一下国外的远程制作案例和他们的模式。最后,我会分享SMT在转播系统虚拟化和云端化技术上的一些探索。

-01-

远程制作

说到远程制作,在世界范围的任何地方、任何角落,要采用远程制作的方式,除了解决信号传输、控制、处理, 还需要解决远距离控制延时,信号质量,信号延时等问题,目前的跨城区、跨国家的远程模式或多或少会存在一 些技术点没有解决,要在制作上进行一定的妥协。随着技术的发展,远程制作模式也随时在进行着技术上的革新。

对于整个的转播节目制作,大概可以分为三个模块,一个是信号的采集阶段包括摄像机等画面采集设备和音频的收声设备;一个是操作人员的操作界面,包括切换台面板,调音台面板等等;另外一个就是最为核心的信号处理模块,包括切换台的信号处理核心和调音台的声音信号处理核心。

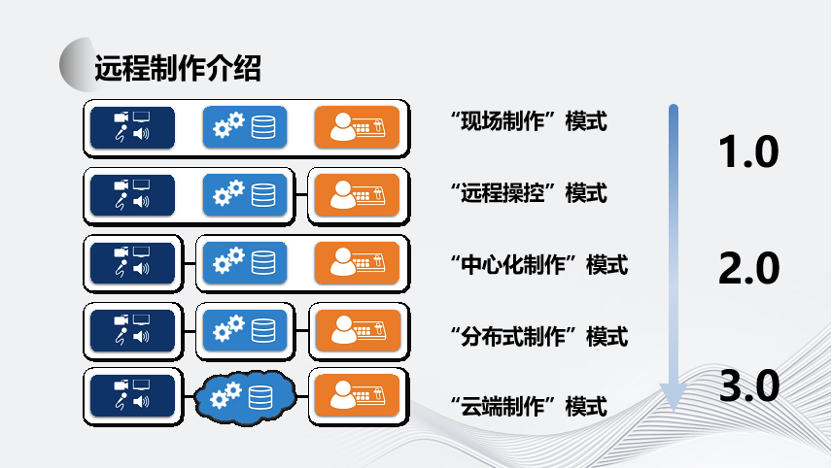

根据这些模块的不同的分布,可以将远程制作划分成以下几种模式。

(1)现场制作模式:这是目前最为常见的现场转播车的这种模式,它集信号采集信号处理和制作人员的操作界面于一体,都集成于一个转播车上,同时存在于一个现场。

(2)远程操控模式:是将操作人员的操作界面单独独立出来,并且处于远端,而信号采集和信号处理处于同一个地方,这样也不涉及到海量的数据传输;

(3)中心化制作模式:信号处理和制作人员的操作在一个制作中心当中完成,而信号采集分布于不同的转播现场。

(4)分布式制作模式:信号采集、制作人员的操作、和信号处理分别处于多个不同的地方,根据模块分工和岗位分工,协同完成制作。

(5)云端制作模式:将信号处理部分放在了公有云或者私有云的云端来进行完成,而信号采集和操作人员可以更加灵活的分布式部署。

对于广播电视行业的远程制作需求,虽然都是采用了IP传输技术实现,但与互联网音视频的技术需求有着根本性的不同。

远程制作为了能够达到现场制作的体验度,存在几个关键的要点:

(1)超低的交互延迟以及恒定的延迟量

在远程制作时,整个信号的延时要尽可能小,因为延时会带来制作的困难,试想如果导播一个 指令过去,相应的反应镜头要慢10帧,那么会极大影响制作效果。 所以信号的超低延时传输是节目转播的技术保障。

(2)信号源的高质量要求

信号的技术质量是关键,保证信号的高质量传输是转播制作的基本要求,所以在远程转播中采用浅压缩或者无压缩的方式是首选,这样能够保证信号的高质量,但是也给网络带宽带来了压力。

(3)技术功能的完整性

在远程制作中的技术功能完整性也是个关键因素,是否能解决在现场制作需要具备的所有功能,包括摄像机、音频、控制、 通话、数据等,任何一个功能的缺失都会给制作效果带来负面影响。

支撑这些远程制作技术的是不断发展的信号传输技术、网络传输协议、以及视音频的编解码技术。

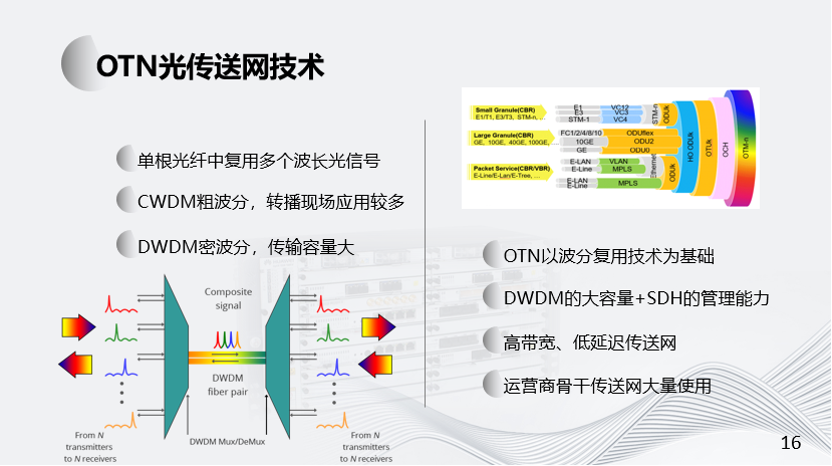

对于信号传输技术,我们经历了从裸光纤到OTN的传送网络、再到数据专线以及现在的公网和SD Wan网络。

对于网络传输协议而言,SRT、RIST、NDI、WebRTC协议逐渐被广泛使用,这些都是针对实时音视频而专门开发的协议。这些协议为远程制作的实现提供了非常重要的基础保障。

在视频和音频的压缩技术方面,主要分为浅压缩编码和深度压缩编码。浅压缩主要针对于帧内编码的压缩形式,例如TICO压缩、JPEG-2000压缩,以及最近两年提出的JPEG XS压缩,而JPEG XS目前已经被写入到了SMPTE ST2110-22标准当中。

对于公共互联网传输的深度压缩标准,我们经历了从H264、H265以及到目前刚刚发展起来的H266的发展过程。而国内自有的压缩标准也经历了从AVS到AVS2到目前最新的AVS3的发展。这些编解码技术的发展为在有限带宽的网络上进行信号的传输提供了重要的保障。

-02-

SMT的实践探索之路

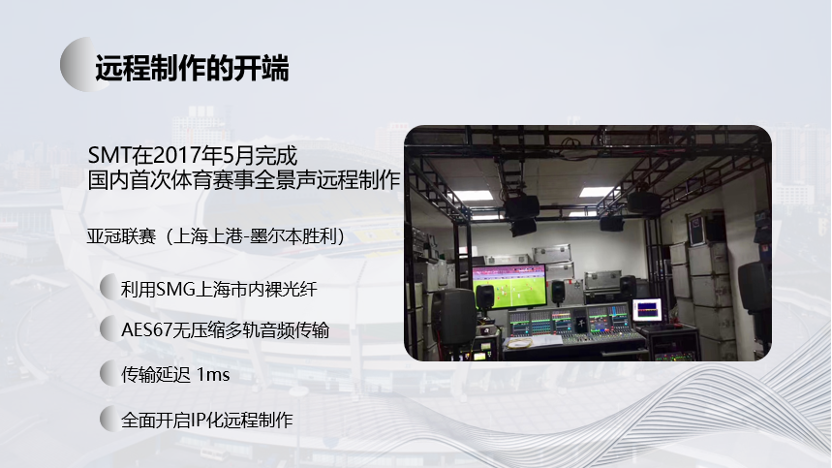

SMT在国内较早的进行远程制作的研究和实践,最早的远程制作是2017年的亚洲足球冠军联赛上海上港队主场迎战墨尔本队的比赛,这场赛事也是国内首次杜比全景声的体育赛事现场直播。当时为了进行杜比全景声的现场制作,需要搭建一个5.1.4的监听环境,但是在上海八万人体育场现场并没有条件去搭建这样的混音环境,而我们最终在SMT转播部的制作中心来进行搭建,采用了远程制作的方式在SMT制作中心来完成这场比赛的直播声音信号的制作。结合当时在广电领域刚刚发展起来的AES67音频AOIP传输技术,我们将64轨无压缩的音频信号从上海八万人体育场通过IP网络的形式传输到了SMT制作基地。在SMT的制作基地完成了全景声的制作,传输延迟低至1ms。

而这一次的远程制作是利用了SMT自有的裸光纤资源,完成了一次同城远程制作。借助当时最先进的无压缩IP音频信号传输技术,前后方声音传输的延时被控制在了两毫秒以内。对于SMT来说,这是第一次真正意义上的远程制作,并且被应用在亚冠这样级别的赛事直播中,这也为之后更大型、更广地域的远程制作打好了基础。

基于裸光钎的远程制作模式,我们在之后还完成了LPL八周年盛典,第七届世界军人运动会军事五项比赛的远程制作。在这些远程制作当中,我们借助了裸光纤的高带宽、和低延时的优势,采用无压缩或者浅压缩视音频IP信号进行信号制作,对于声音和画面信号而言,传输的延时被控制在了帧级别。

例如2019年的LPL夏季总决赛,这是国内第一次实现远程制作的商用化。利用SMT自有的在上海市内的光纤资源,将信号从梅赛德斯奔驰文化中心,传输至位于40公里外的腾竞体育播出制作中心完成信号的制作与分发。这次的远程制作充分利用了光纤网络高带宽和低延迟的优势,全面采用无压缩和部分TICO(基于帧内4:1固定压缩比和固定压缩编解码时间的方式)浅压缩形式进行前后方的信号交互,实现了前后方100G网络的级连,以及前后方PTP精准时钟的同步。

这场转播随后作为成熟技术案例,陆续应用到英雄联盟S10全球总决赛小组赛、2020 LPL总决赛;并作为LPL常规赛标准配置,连续五年沿用至今。我们在静安区的腾竞制作中心和位于虹桥的虹桥天地LPL常规赛的比赛场地搭建了这样一个基于裸光纤的制作场景。

裸光纤讲完了,接下来讲一讲OTN。

随着传输技术的进步以及运营商传输网络的发展,我们迎来了基于OTN的远程制作时代,采用OTN的传输技术能够实现更广地域和更大规模以及更高容量的远程信号传输。

对于远程制作来说,我们所采用的OTN光传送网技术是以波分复用技术为基础在光层组织网络的传送网。它是综合了DWDM大容量的优势和SDH的组网灵活、保护完善、管理功能强大的这些特性把两者的优势结合起来。OTN目前来说是在高带宽、低延迟需求的传送网当中都有非常重要的应用。

2020年在中国上海举行的英雄联盟S10全球总决赛的转播,我们就采用了OTN的远程制作模式,这是2020年疫情爆发后全球范围内最大的电竞赛事。

S10全球总决赛在上海的浦东足球场进行,但它的制作是在腾竞体育播出制作中心,两者之间相距大概六十公里。由于这是一个世界性的电竞赛事,其信号传输规模非常的庞大。

两者之间采用 IP 链路进行级联,转播中 30台摄像机、1 台遥控摄像机、双向传输 100 路基带视频、双向 256 路音频信号、40 路 AES67 远程通话、86 个现场通话点位(通话面板、双工背包机)、 10 块矩阵的前方控制面板等大量的信号传输及制作。如此大的转播规模即使采用转播车现场制作方式也有一定难度,而采用远程制作更面临极大的挑战。

通过OTN的高带宽、低延时的传输网络,结合视频的TICO浅压缩格式,整个前后方制作的信号链路延时被控制在了30毫秒以内。

在OTN网络传输方面,我们采用了100G传输线路来传输无压缩的音频信号以及经过TICO浅压缩的3G视频信号,并使用多个10G传输链路,实现了赛事数据信号通话信号,以及其他控制信号的互联互通。

但是无压缩和浅压缩质量的远程制作,所依赖的是大规模高带宽无阻塞组播网络的组网技术,对传输环境和设备的要求较高。外加高昂的成本,大规模普及以及广泛适用性的制作模式较难实现。

在此基础上,SMT开始探索更加敏捷部署的远程制作模式,为了实现更大范围的远程制作,我们开始攻克基于公共互联网的远程传输技术。

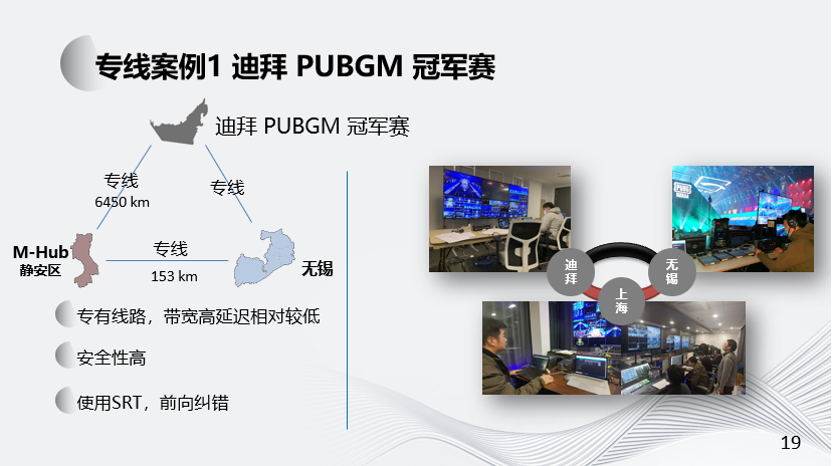

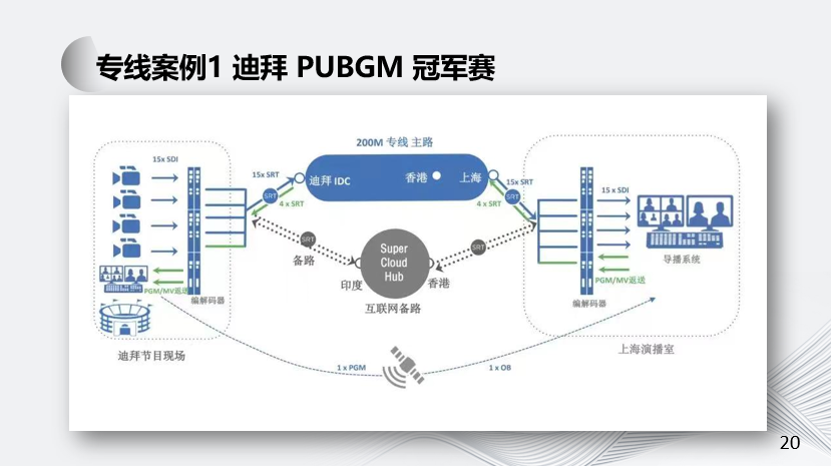

上图是2020和平精英全球总决赛的案例。比赛是在2021年1月21日正式开启直播,由于目前国外疫情大环境的影响,战队队员们只能齐聚迪拜展开角逐,而开幕式等环节在无锡举行。

本次电竞活动采用跨城跨国远程制作的方式,将迪拜、无锡两地的信号利用互联网专线远程传送回到位于上海M-hub静安的制作中心,并进行信号的制作与分发。

通过互联网专线与Haivision Hub节点的主备双路由,达成庞大视频信号量的远程稳定交互,实现三地转播过程中所需信号的低延时交互需求,即便在不同的城市甚至不同的国家,也能带给观众身临其境的体验。

在三地的前期筹备工作和直播过程中,通话也是必不可缺的一环。本次远程通话使用了较为成熟的基于VoIP的公网远程通话技术,将迪拜、无锡的通话与上海打通,完成三地低延迟的对话要求,并开辟制作与技术独立通道。无论是前期技术对接工作或是彩排与直播时三地的流程对应,远程通话都能够为其带来巨大的便利,大大提升了节目制作的效率。

当时我们已经按照技术方案实现了三地的互联网专线组网系统搭建,并顺利完成了第一天的直播。但第二天比赛,由于当地疫情原因,选手无法到达比赛现场参加比赛,因此,比赛临时改为线上赛,选手在各自酒店完成比赛。相对应的,我们的转播系统方案需要按照线上赛的需求重新进行配置。此时,采用公共互联网为基础平台的远程制作模式就体现出了其敏捷性,仅仅使用了一天的时间,我们的远程转播系统就按照线上赛的配置重新搭建完成,实现了所有线上选手的信号互联互通,并保证了传输延迟量在1秒以内,VoIP通话延迟在200ms以内。

公共互联网平台带来的便利性和敏捷性,是传统远程传输系统所无法比拟的,但同时,由于受到弱网环境的限制,视音频的信号质量相对较低、传输延迟都相对较高。

接下来是基于公网专线的第二个案例,也是我们改进过的案例——UFC终极格斗。

2023年5月27日和28日UFC精英之路第2季在上海UFC精英训练中心(UFC PI)举行,作为首次在UFC上海精英训练中心进行的赛事直播,今年全部比赛在现场观众面前进行,并通过位于美国拉斯维加斯UFC Apex制作中心最先进的远程制作集成模型——REMI制作和分发并通过SMT M-HUB与拉斯维加斯UFC Apex之间的信号交互实现,涵盖了视频信号、音频信号、各类控制信号以及上海与拉斯维加斯之间的IP通话传输。

UFC的远程制作,在SMT的制作中心与拉斯维加斯之间,我们共使用了六条150兆速率的专线,并使用ASI信道编码模式,在视频信号的传输方面使用了JPEG2000浅压缩编码。音频和通话信号的传输,使用AAC编码。整个传输链路的信号传输单向延时低至400ms,双向延时做到850ms以内,而传统的跨洲际信号传输和制作通常需要两秒以上的传输延时。

随着云计算技术的发展,云服务商的业务开始逐渐扩展到广电传输领域,由于云服务商拥有优质的计算资源和传输资源,充分利用这些资源,对于优化改善远程信号传输而言,非常重要。

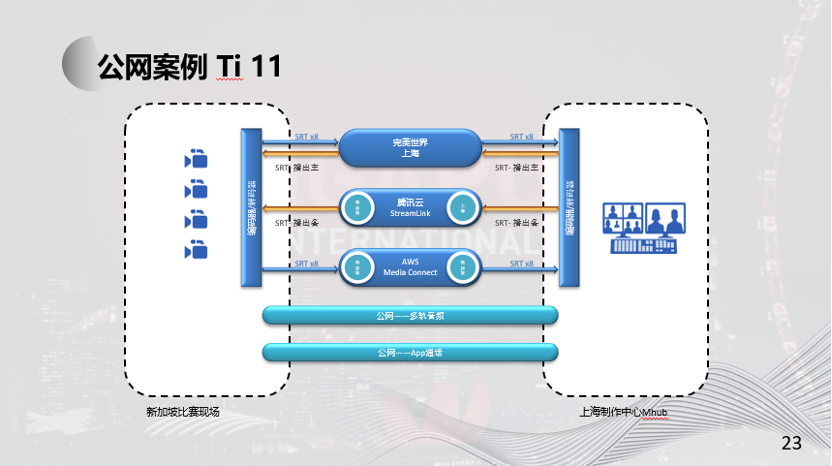

著名的电竞游戏 DOTA2 TI-11国际邀请赛于2022年10月15日-30日在新加坡举行,信号分发在新加坡统一进行,不同内容的视频信号和音频信号,通过主、备各12路采用24Mbps 264·视频编码的SRT流,经公网传输至上海M-hub进行中文包装制作,主、备中文PGM信号经24Mbps编码后使用SRT送回新加坡总控进行全球分发。

在视频信号传输方面,总共有24路24Mbps码率的SRT下行流并发,加上SRT的协议本身的网络带宽开销,以及SRT协议所采用的ACK和NACK混合的丢包重传机制,对网络带宽的冗余量有着更高的要求。

另外,由于这是制作端的信号传输,对信号的稳定性、抖动以及延迟、画面质量等都有较高要求。而且这是跨境流媒体信号传输,因此对传输链路和制作网络提出了极大的挑战。

在综合了传输稳定性和成本方面的考虑之后,我们采用了腾讯和AWS等云服务商的SRT信号传输服务实现稳定和高带宽的跨境传输。但由于流媒体转发节点较多,传输延迟超过了1秒,这在后续还有继续优化的空间。

在音频传输方面,前后方的通话信号采用多轨音频传输系统经公网进行交互,为了实现制作团队良好的沟通交流体验,音频信号传输延迟被控制在了300ms以内。

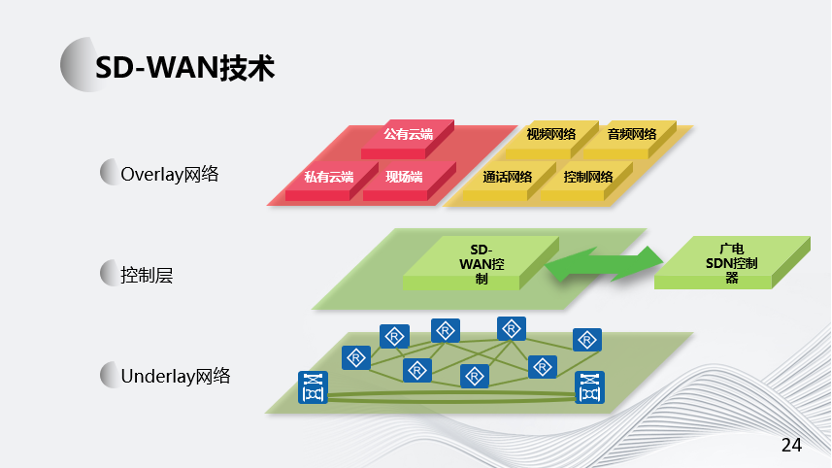

为了在公网中实现更为广泛的远程制作功能,实现更为复杂的组网和信号传输,特别是实现结合云计算平台的远程制作,我们开始探索在远程制作中引入SD-WAN组网技术。

我们希望将传统广电中已经成熟的SDN技术应用到广域互联网的场景中。在远程制作中,SD Wan网络与传统的广播电视IP网络深度融合。传统的广电集中控制系统,能够为SD Wan网络和远程制作提供必要的集中控制功能,如Tally、UMD、信号路由切换等等。同时SD Wan网络的SDN控制器也能够同时为传统广电IP网络和SD Wan网络的网络路由提供路由规划和集中控制管理。

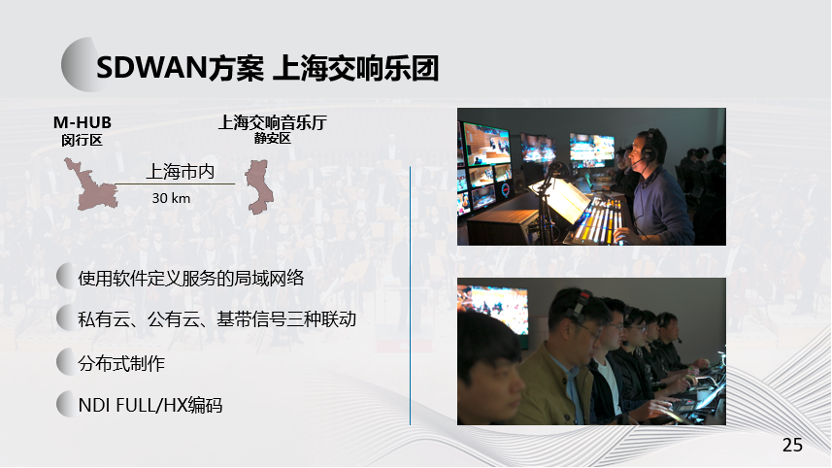

在上海交响乐团远程制作的实例中,我们构建了一张结合了上海交响乐团转播现场、SMT远程制作中心、以及公有云云端所形成的三方网络的融合,形成了一张逻辑上的大型overlay网络,在逻辑上按照视频音频和控制数据彼此分离。

在远程制作当中,对SD Wan网络的延迟非常重要。我们所构建的这张SD Wan网络,具备了低延迟、和高可靠性的特点。摄像师在制作中心远程操控现场的摄像机的推拉摇移等等摄像机运动、以及在制作中心控制摄像机的光圈颜色,这些操作都是具有实时的画面反馈,这对网络以及信号传输延迟提出了非常高的要求。结合NDI-Full的本地格式、和NDI-HX的远程传输格式,我们的方案能够做到摄像师的操作和感受到的反馈延时在五百毫秒以内。而在传统的高压缩的公网远程制作当中,此延时通常要在一到两秒以上。

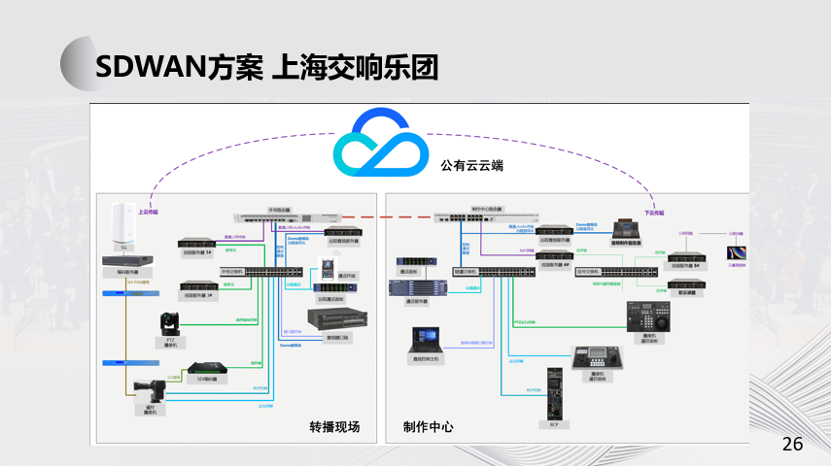

这是上海交响乐团音乐会混合云制作的系统架构图,这个系统分为了现场端、制作中心端、和公有云端三个部分。

在现场端,部署了遥控摄像机和遥控云台、以及音频设备等,并使用VoIP的云端app通话实现与后方的沟通。

在制作中心端,是一套全IP化和软件化的制作系统,同时采用传统基带系统进行应急备份,并能够无缝倒换。

在公有云端,我们部署了云端切换台、调音台、图文包装、多画面监看服务等,并实现了本地系统与云端系统的实时镜像工作。

下面给大家分享一下在上海交响乐团音乐会制作中所采用的NDI技术。NDI是Network Device Interface的简称,即网络设备接口协议。

NDI是个音视频的编解码和网络传输协议,它有两重属性,第一是对视频进行编码压缩和解码,第二是在此基础上进行低延时的传输,以UDP协议为主。除了音视频流之外,它还支持广电特有的一些信令,比如导播常用的TALLY和双向通话、支持PTZ摄像机控制、支持Alpha透明通道等常用到的重要功能。

NDI分为两种类别,一种是FULL NDI,一种是NDI HX。FULL NDI采用了基于帧内压缩算法的SpeedHQ编码,是一种DCT变换浅压缩编码,和我们前面讨论的浅压缩编码原理基本一致,只是压缩比更高一些,这个编码目前已经迭代到NDI 5.5版本,高清带宽90-180M,4K带宽在200-300M。NDI HX是基于H264和H265的深压缩编码,主要是服务于公网NDI信号传输,目前已经迭代到NDI HX3。

目前,NDI技术已经在流媒体制作领域有了非常广泛的应用,但在专业广电制作领域的应用还存在一些有待改进的地方,比如说大规模系统部署的可控制性不足,对精准同步的需求难以实现(虽然有API,但是无法实现)等。

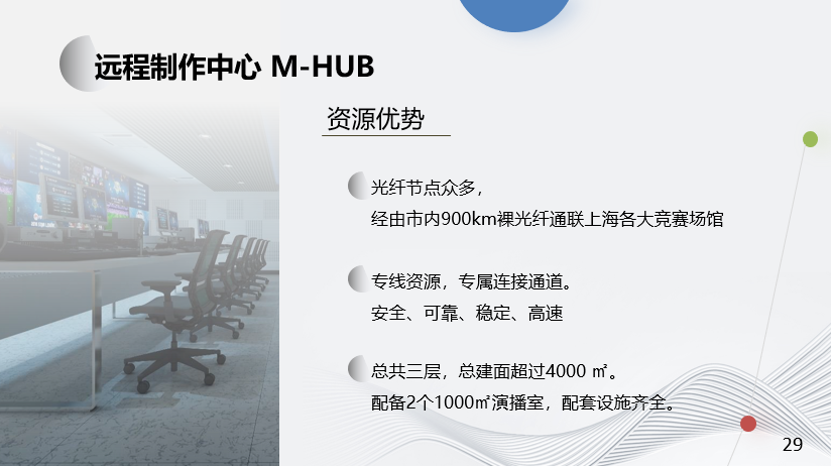

综合SMT过去多年在远程制作领域的探索,目前我们正在打造属于自己的远程制作中心——M-HUB。SMT的远程制作中心目前是由两个制作节点组成,分别是位于上海市静安区的M-HUB静安、和位于闵行区的M-HUB闵行,未来还有M-HUB浦东。

支撑SMT远程制作中心的是一个庞大的自有光纤网络,在全上海有超过900公里的裸光纤资源,可以直连上海多个竞技场馆。

除此之外,还有安全、可靠、稳定、高速的专线资源供信号传输使用。同时两个1000平的演播室也为制作中心提供了节目的制作保障。

-03-

境外重点案例

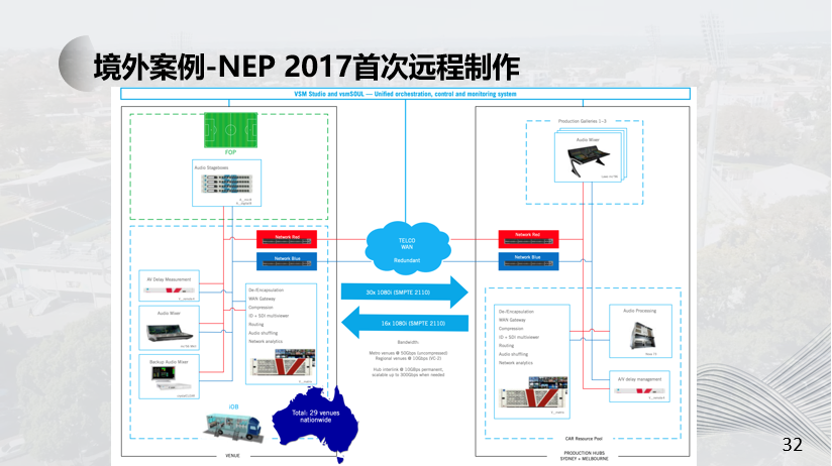

在2017年,NEP澳大利亚引领了现场体育广播的新时代,当时他们的全新基于IP的远程制作设备开始投入使用。NEP的两个制作中心,称之为“Hub”——一个位于悉尼,另一个位于墨尔本。尽管它们在地理上相隔一定距离(约880公里),但这些中心实际上形成了一个单一的单位,因为所有资源都是共享的。这种共享的方法延伸到与NEP网络连接的所有场馆和地点。通过IP技术实现了多个同时进行的转播节目制作。

澳大利亚的面积与美国相当,大多数人居住在东海岸和西海岸。在综合评估了各类成本和便捷性后,NEP提出了 “任何人,任何地方”这样一个新的理念,虽然传统的转播工作流程,包括评论员、摄像师和观众在现场看到的一切仍然在现场进行,但制作团队却在距离场馆数百甚至数千公里的制作中心中工作。

这也是世界范围内大规模远程制作以及中心化制作的开端之作。而今天的NEP,无论在澳大利亚还是欧洲,其网络资源体量都抵得上一个中型的电信运营商。

Telstra广播服务为NEP澳大利亚选择的29个场馆提供了光纤网络连接。其中一些场馆以50Gbps(每秒十亿位)的速度连接,并且无需压缩进行操作,而其他场馆则依靠10Gbps和VC1压缩进行操作。

在2022北京冬奥会的转播中,美国全国广播公司NBC、联合NEP,在速度滑冰项目中,为了拍摄荷兰选手的特写镜头,在速滑馆冰丝带中,单独架设了4台IP摄像机,通过远程传输的方式,直接接入了位于阿姆斯特丹的制作中心的系统中。采用了JPEG-XS压缩格式进行传输,传输延迟控制在了20ms。这在跨国甚至是跨洲际的浅压缩远程传输中,不论是信号质量还是信号的稳定性方面,都是一个质的飞跃。

EMG diPloy是一个完全模块化的IP制作系统,内置在不同尺寸的机架中,放置在专用的40英尺集装箱中,这使得EMG可以根据每个任务的需求组合所需的特定功能。通过在机箱级别创建模块,EMG可以将它们Deploy(部署)在需要的位置。

该系统被设计成完全弹性的,适用于任何规模的制作,包括从一个四台高清摄像机的任务到一个拥有近100台超高清摄像机的超大规模世界级体育赛事。

diPloy的设计是遵循“Everything in IP”的理念。这是一个集成的网络,将视频、音频、监控、通话和数据结合在一起,将所有不同的外场部件打包到不同的模块中,每个模块具有不同的功能。

这套系统服务于东京奥运会开闭幕式、北京冬奥会开闭幕式转播,以及北京冬奥会张家口颁奖广场的远程制作,同时还被用于卡塔尔世界杯全部比赛场地的直播信号制作。

diPloy的Everything in IP的理念也是下一代转播系统架构的基础。

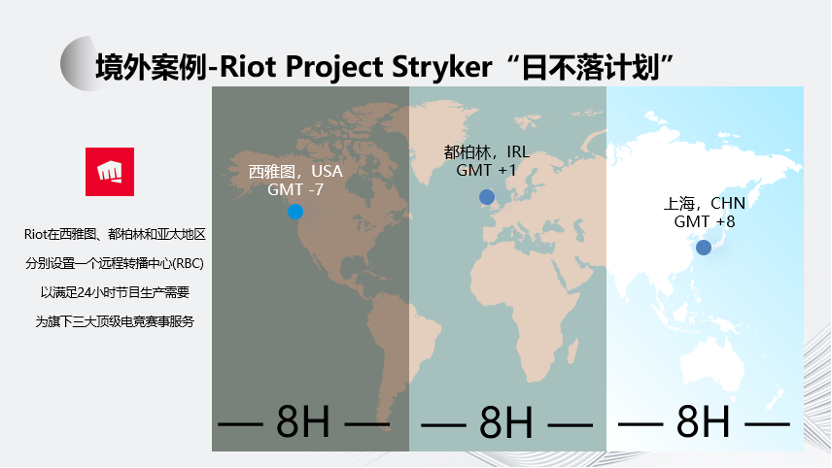

ProjectStryker是拳头游戏和亚马逊AWS合作建设的一个基于云技术的远程电竞赛事制播中心项目。在全球一共建立3处制播中心,一处在爱尔兰都柏林,一处在美国西雅图,还有一处在亚太地区。这3处制播中心遵循着一个原则,彼此之间时差均为8小时,通过3 x 8的全球时间覆盖来实现拳头游戏旗下电竞内容365 x 24地不间断生产,这也是它被称作“日不落”计划的原因。

这些远程制播中心都将通过拳头构建的名为“Riot Direct”的全球高性能光纤网络进行信息传输,以达到对全球所有官方赛事内容实时传输与“加工”的目的。

在英雄联盟 MSI 2023转播中,Riot在爱尔兰都柏林的RBC完成远程信号制作,在比赛现场和制作中心之间,使用了10G专线,信号通过JPEG XS浅压缩编码传输,将每路3G视频信号压缩至300-400M,完成了都柏林RBC-伦敦之间的远程制作。

-04-

虚拟化与行业趋势

面对现在IT行业的技术发展以及云服务模式的成熟,广播电视制作领域也在尽可能的利用IT行业的技术发展成果。过去几年,广播电视制作系统进入了一个全面IP化的阶段,而现在面对云端制作的需求,电视转播系统的核心开始逐渐向通用计算平台迁移,在一个基于CPU和GPU的通用计算平台上完成传统转播系统的所有功能,我们把这种技术称之为转播系统的虚拟化技术。

将超大型转播制作系统进行虚拟化部署,使用部署在通用服务器上的软件来提供专业传统转播制作所需要的各类特定功能,实现SaaS(软件及服务),并且可以根据节目实际情况任意调整,以实现灵活的可扩展性。

SMT从两年前开始相关的技术探索——虚拟转播车项目

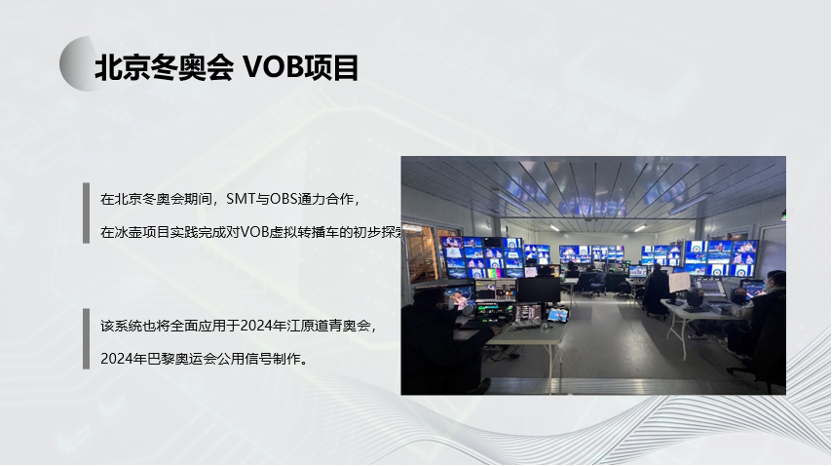

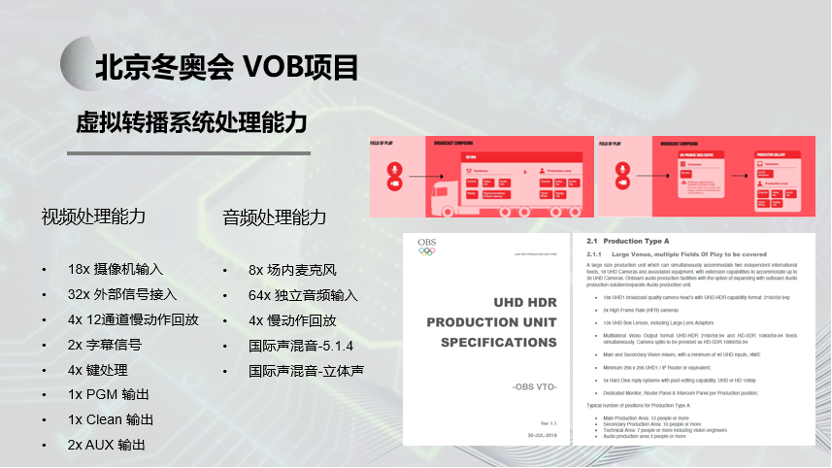

虚拟转播车首次应用在了2022年北京冬奥会冰壶比赛的第四赛道的公共信号制作当中。这个系统总共使用了八台X86架构的服务器完成了传统转播系统各项功能,包括切换台、调音台、慢动作回放、多画面分割监看等等。

本次项目改变了专业转播系统问世半个世纪以来一直使用大型传统转播系统(箱载系统或转播车)才能完成转播工作的历史,利用一个云端数字底座,软件支持的架构,完全镜像复制一个传统转播系统的功能,以实现更加灵活、模块化的制作环境,这是一个历史性的升级和改变。

在未来,这将是一个基于混合云架构的、多地协同的远程混合制作模式。计算技术和传输技术将成为未来电视转播行业的奠基石,也就是现在常说的算力和传输力,让传统广电行业从ICT行业特别的分支再次回归ICT行业,再次享受ICT行业的技术发展给我们带来的宏利,这也是我分享的目的之一:传统广电行业并没有完全被时代所抛弃,我们还在努力跟上时代的步伐。

最后用一个视频结束我今天的分享,谢谢大家。