https://arxiv.org/abs/2312.07100

在高分辨率场景下,现有的显著目标检测方法难以同时满足快速推理和准确结果的要求。它们受到用于高分辨率图像的公共数据集和高效网络模块的质量的限制。

为了缓解这些问题,我们构建一个显著对象匹配数据集HRSON和一个轻量级网络PSUNet。考虑到移动部署框架的高效推理,我们设计了对称像素置乱模块和轻量级模块TRSU。

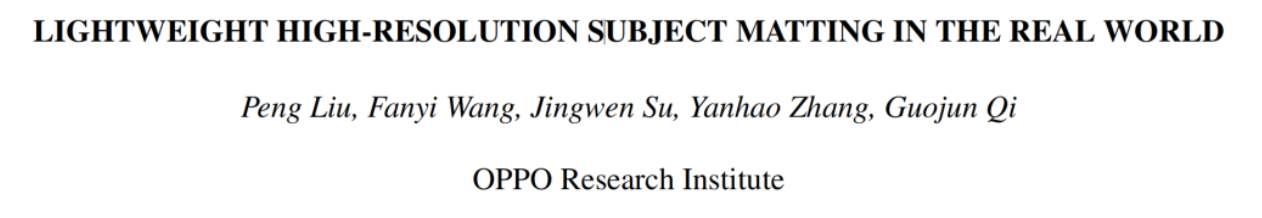

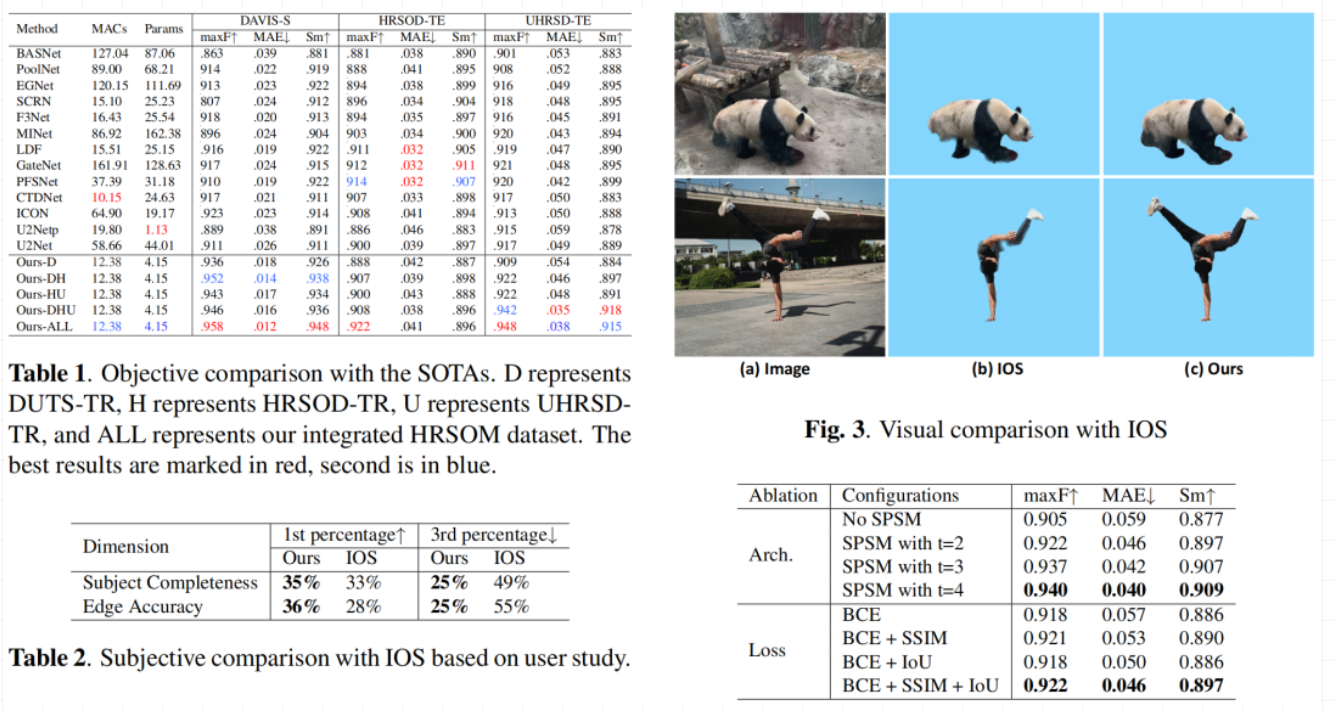

在高分辨率基准数据集上,与13种SOD法相比,PSUNet具有最好的客观性能。客观评价结果优于U2Net,后者的参数值是我们网络的10倍。在骁龙8第二代移动平台上,推断一张640x640图像仅需113ms。在主观评价上,评价结果优于行业基准IOS16。

本文方案

编解码器的整体结构类似于U2Net,由所提轻量级TRSU模块组成。所提TRSU单元也具有UNet结构。在3x3卷积的一层之后,通过深度可分离卷积和最大合并的多个组合的堆叠将特征地图采样到较小的大小。然后在经过几层深度可分离卷积后,通过相同数量的上采样和深度可分离卷积的组合来恢复分辨率。最终输出是经过一层3x3卷积后得到的。TRSU通过跳过连接控制网络宽度。MIDLBlock(图1(C))堆叠纯深度可分离的卷积结构,以提取更深层次的特征。对于解码器中的TRSU模块,图1(D)中的所有卷积都被深度可分离的卷积所取代。最后,特征图经过单层卷积后送入SPSM。编码器和解码器之间的跳过连接也是加法的形式。

我们集成了RGB SOD低分辨率数据集DUTS-TR、HKU-IS、RGB SOD高分辨率数据集UHRSD、HRSSOD、DIS5K、RGB-D SOD数据集COME15K[5],以及匹配数据集AM、P3M。

为了构建集成的数据集,我们与数据标签专家合作,为实际应用建立了显著标准。我们手动排除了不适合标记的图像,特别是在多个数据集行为不一致的情况下。超分辨率算法Real-ESRGAN被用来将分辨率提高到720多个短边像素。上采样的双线性内插被用来以相同的速率提高标签分辨率。利用预先训练好的大模板模型对所有SOD数据集的标签进行细化。

本文实验

在三个高分辨率的数据集上,我们以更小的计算量和参数数量超越了大多数轻量级方法。提出的PSUNet包含415M参数,当输入图像大小为640x640时,需要12.38G MAC计算。它比大多数的SOOD方法都要轻得多。实验结果表明,这些客观指标表明所提方案甚至可以与U2Net相媲美。

在浮点16量化后,它们被部署到移动设备上。在高性能骁龙8 Gen 2移动平台上,模型推理仅需113毫秒;在中级芯片平台联发科Dimensity 8100-Max上运行234毫秒。

作者:AIWalker

来源:AIWalker

推荐阅读

- 38.7fps!EdgeSAM = RepViT + SAM,移动端超强变种,已开源!

- FAIR十年之路:以开放研究促进人工智能前沿SOTA

- 将卷积与自注意力进行高效集成,上交与华为海思提出了Xvolution

- 超分画质大模型!华为和清华联合提出CoSeR:基于认知的万物超分大模型

- TPSeNCE开源,让CV图像变换到雨天/雪天/夜晚都不是大问题

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏AIWalker。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。