DCNN在图像去噪领域取得了极大的关注,然而仍存在两个缺陷:(1)训练困难;(2)性能饱和。

为解决上述问题,作者设计了一种称之为BRDNet的网络架构,它包含两个网络用于提升网络的宽度,同时获取更多特征。BRN的应用缓解了internal covariate shift与小批次问题;采用残差学习方式加速训练;采用扩张卷积提升感受野获取更多信息。作者通过充分实验验证了所提方法的优异性能。

来源: https://zhuanlan.zhihu.com/p/107080082

文章作者: Happy

Image Denoising using Deep CNN with Batch ReNormalization (论文文末可下载)

code

Method

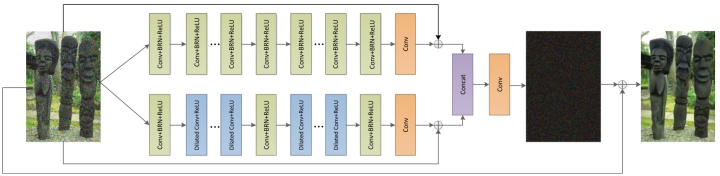

Framework

上图给出了所提方法的网络架构示意图,它包含上下两个分支。上分支仅仅包含残差学习与BRN;下分支包含BRN、残差学习以及扩张卷积。一般而言:网络感受野越大,计算量越大。作者采用扩张卷积提升感受野而不增加计算量。

上分支网络包含两种不同类型的层:Conv+BRN+ReLU与Conv。它的深度为17,前16个层为Conv+BRN+ReLU,最后一层为Conv。特征图通道数为64,卷积核尺寸为3.

上分支网络同样包含17层,但其1,9,16层为Conv+BRN+ReLU,2-8,10-15为扩张卷积,最后一层为Conv。卷积核尺寸为3,通道数为64.

两个分支结果经由Concat组合并经Conv得到噪声,最后采用原始输入减去该噪声即可得到清晰无噪图像。

整个BRDNet合计包含18层,相对比较浅,不会导致梯度消失与梯度爆炸问题。该网络的设计思想源自以下几个方面的思考:

- 通过两个自网络提升宽度而非深度达到改善去噪性能的目的;

- 采用BRN解决小批次与internal covariate shift问题;

- 采用残差学习防止梯度消失与梯度爆炸;

- 采用扩张卷积节省计算量。

Loss

受DnCNN影响,作者选用MSE作为损失函数对网络参数进行优化,优化器选择Adam。

BRN,DilateConv,RL

BRDNet的设计有以下几个方面的考虑:

(1)更深的网络存在梯度消失与爆炸问题,通过提升宽度降低深度进而缓解梯度消失与梯度爆炸问题;

(2)卷积可能导致数据分布发生变化,BN是一种有效的方法,但其存在小批次时性能下降问题,作者采用BRN替代BN改进收敛效率;

(3)更深的网络可以提取更精确的特征,但是同时具有更高的计算量,作者采用扩展卷积提升感受野,降低计算量。

Experiments

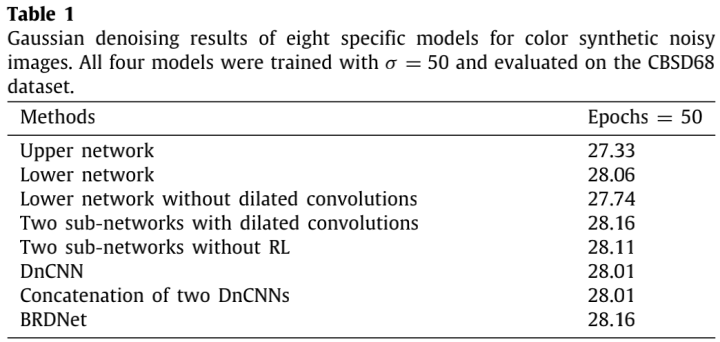

消融实验分析见下表。

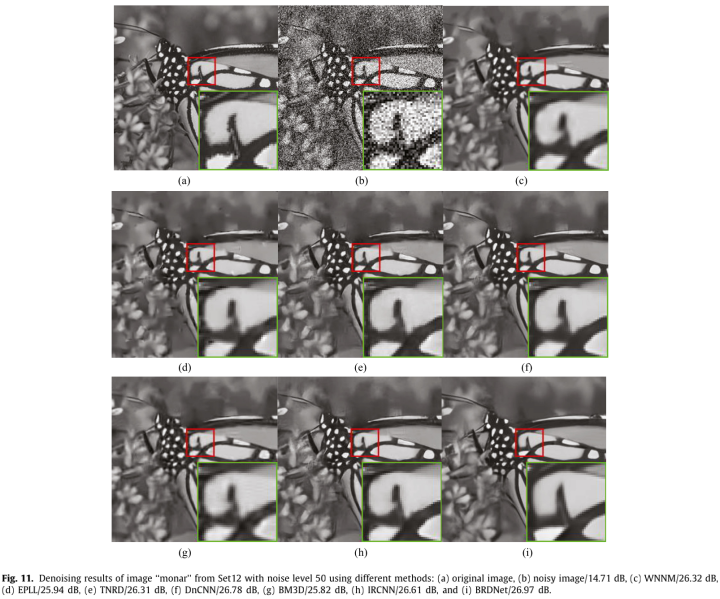

合成数据测试效果对比图

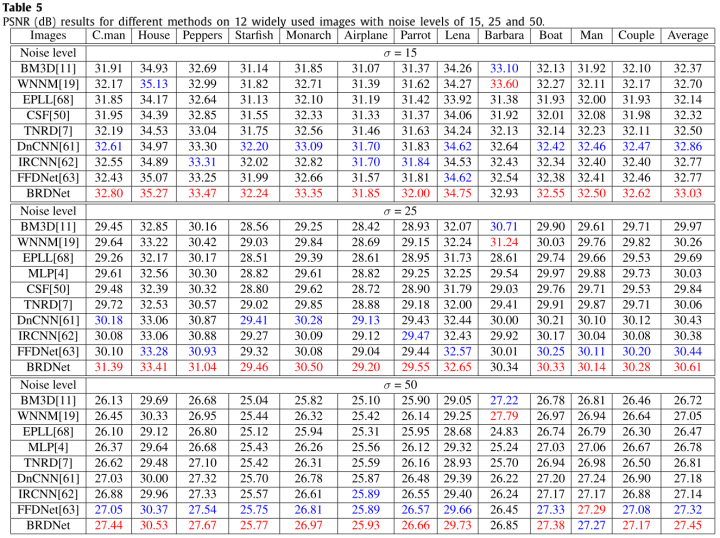

在测试数据集上的性能对比分析

在真实场景图像上的去噪性能对比

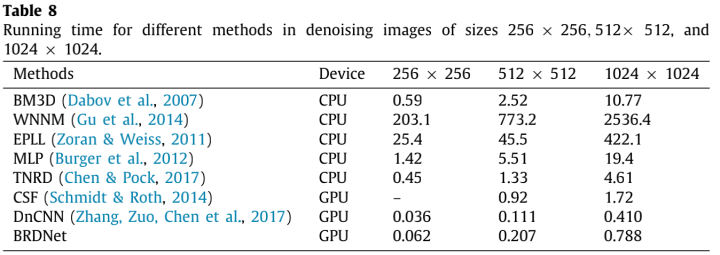

算法耗时对比分析

Concolusion

作者从实际训练与应用场景出发,提出了一种新颖的去噪网络BRDNet。它采用双分支结构降低网络深度,采用扩张卷积提升感受野,采用残差学习降低训练难度。最后通过实验验证了所提方法的优异性能:速度快效果还好,你说气人不气人。

推荐阅读

- ICCV2019|非对称卷积网络ACNet,有效增强CNN的核骨架,提升不同模型在CIFAR及ImageNet中的性能

- 动态滤波器卷积在CV中的应用

- 视频去模糊:STFAN, 达到速度,精度和模型大小同步考虑的SOTA性能

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏深度学习从入门到精通。

| 文件名 | 大小 | 下载次数 | 操作 |

|---|---|---|---|

| Image Denoising using Deep CNN with Batch ReNormalization.pdf | 4.04MB | 1 | 下载 |