原文最初发表于 2015年5月29日,题为《规模,决定制生态:定制新常态》,分五部分连载至2015年6月9日

IDC在2013年第四季度的一个拥有超大规模(hyperscale)数据中心的公司统计中,将10万台服务器以上的划为Tier 1,名单里包括Google、Microsoft、Amazon、Facebook、Yahoo、Baidu、Tencent、Alibaba、Akamai、Savvis、Rackspace、Softlayer/IBM。据美国数据中心专业网站Data Center Knowledge的文章估算,法国的互联网服务提供商(ISP)OVH在2013年7月时拥有15万台服务器(IDC将其划在5~10万台区间的Tier 2),而Intel公司在2011年8月即拥有7.5万台服务器。

现在,基本可以确认Google、微软和亚马逊是仅有的三家超巨“百万俱乐部”成员,Facebook可能是最接近的, 但服务器总量何时超过50万台还不好说。

Google位于美国俄勒冈(Oregon)州Dalles的数据中心内景,在无人经过的区域,动作感应器自动关掉主要的灯以节能。其结果是,来自全球的数据通过五颜六色的LED发出耀眼的光芒,就像全年的假日灯。(来源:Google官网)

100万台服务器意味着什么?美国科技网站ExtremeTech有一个简单的估算:

- 假设服务器的平均成本为1000美元(现在要界定怎么算“1台”服务器不那么容易,实际价格很可能更高,此处从简,下同),100万台服务器的购置成本就是10亿美元;

- 每台服务器的功率大约200W,假设冷却、配电损耗、路由器等消耗50W,总功率就是250MW(兆瓦),年耗电量为2.19TWh,也即20多亿度电,相当于近20万美国家庭的平均用电量(按11280kWh每年计算)——仅以人口而论,大于中等规模的城市。

有不同来源的数据表明:2011年数据中心能源消耗占到了美国电网总量的2%;目前数据中心的能耗已经超过了全球能源使用量的1.3%。

我们前一章介绍数据中心规模时,列出的都是面积,这样看起来比较直观。但在美国市场上,数据中心的价格很早就按照供电能力(MW)来计算,因为仅仅能够放下服务器的是仓库,有足够的电力供应才能让服务器发挥作用。现代数据中心每兆瓦建设成本大约1000万美元,250MW就是25亿美元。

35亿美元,Google一个季度在基础设施上的投资而已,对Facebook也“只”需要两年(见上一篇数字)。

一个大型数据中心能容纳5~10万台服务器(相应地,供电能力可达25MW或更高),这意味着至少需要10~20个数据中心设施(单体),全球分布是必须的。譬如,2013年6月初,风力发电开发商O2(已更名为OX2)获得在瑞典北部Maevaara建设72MW风力发电厂的规划许可,使用高效能3MW风力发电机,Google立即承诺购买该风力发电厂未来10年的全部产能,以满足其芬兰数据中心使用再生能源的需求。

Google在欧洲的三个数据中心之一,位于芬兰南部海岸之滨Hamina,源自其2009年收购的一个退役的造纸厂,照片中的水罐以前就用于造纸流程。为什么要把这个建于1950年代的造纸厂改造成现代化的数据中心?因为这个造纸厂不仅有巨大的建筑(有点像北京的酒仙桥,仅此而已),还有完备的海水隧道,可以用天然的冷海水解决数据中心的散热需求,与风力发电相得益彰(图片来源:Google官网)

据推测,Google一个季度要采购17~20万台服务器(基础设施投资不仅是建设数据中心和购买服务器),亚马逊和Facebook在6~8万台的级别。也就是说,每年都在建设数据中心,属于常态。

建设数据中心,已经成为互联网巨头们的日常:

- 有规模,有资金,有持续性,这是在内部设立数据中心专业团队的充分条件;

- 节约成本、自主可控,还有保密的需求,这是在内部设立数据中心专业团队的必要条件。

Google芬兰Hamina数据中心的团队在芬兰湾享受冰上垂钓的乐趣 (图片来源:Google官网)

数据中心(包括服务器,此处不区分)团队掌控设计、采购、供应链的关键环节,数据中心建设施工、服务器生产制造都可以交给合作伙伴(如ODM)。这里面很重要的一个工作,就是定制。

规模,即有足够大的量,是定制的充分必要条件。

对这百十万台服务器的拥有者来说,必须考虑如何省钱,也就是降低TCO(Total Cost of Ownership,总体拥有成本)。TCO包括CapEx(Capital Expenditure,资本支出)和OpEx(Operational Expenditure,运营支出),可以简要的理解为购置成本和运维成本。

数据中心建设和服务器购置成本,属于CapEx;用电和维护成本,属于OpEx。

从服务器的购置成本来看,有足够的量当然可以享受大客户价,要再压低价格,就得采取“偷工减料”、“化零为整”或“化整为零”等手段。

一、偷工减料,杜绝浪费

“偷工减料”是指去掉自己不需要的功能。戴尔(Dell)、惠普(HP)和以前的IBM(System x)这些传统意义上的服务器OEM(Original Equipment Manufacturer,原始设备制造商),面对的是数以万计的客户,每个客户采购的量不大(与10万台的规模相比),需求却千差万别。所以,IBM、HP、Dell等大厂的服务器(特别是机架式)要兼顾多种应用场景,虽然不同系列各有侧重(譬如1U计算密集型,2U有存储型),但设计上仍然相对均衡,以通用性为优先考量,难以满足特定用户的需求,因为要有量来分摊成本。

偏偏互联网巨头既有特定需求,又有量来支撑,可以要求供应商去掉自己用不到的功能,增加自己需要的功能。当然,从简化供应链和库存管理的角度,他们也需要考虑(在自家环境中的)通用性,以减少需要维护的SKU(下一篇会看到,Facebook的服务器配置就那么六七种),但这个范围已经窄了很多。

在北卡罗来纳州Lenoir的数据中心,Rachel Mitchell准备了一辆小车去修理Google的服务器(来源:Google官网)

如果是与应用无关的部件,那便能省则省。因为在他们的环境中用不着的部件,哪怕只有1美元,乘以万就是不小的数字。不要说土豪们一年花在数据中心上好几十个亿,就不在乎几十万了。回想之前介绍的Google早期案例(注意1999年Google采购“软木板”服务器合同的前两页上手写的注释),公司的CEO和副总裁在1000多台服务器的订单上都特别注明不要网线插头的保护套,现在把VGA、USB等大规模运维环境下用不到的功能和接口都去掉,实属正常。

更明显的是服务器的上盖和前面板。传统的(机架式)服务器,拥有完整的外壳,自然也包括顶盖(Top Cover),因为要考虑到服务器不在机架上,或者上方没有其他设备(传统数据中心机架放不满是常态,特别在中国)的使用场景,这样顶盖就必不可少,发挥形成密闭风道、防止外物侵入等作用。

超大规模互联网数据中心则不然,机架配满是常态(数据中心寸土寸金啊),这时上面的服务器就部分充当了“顶盖”的作用,顶盖可有可无。取消顶盖的话,既省钱,又便于维护,可谓一举两得。

Google在俄勒冈州达勒斯(Dalles, Oregon)的数据中心里,Denise Harwood正诊断一个过热的CPU,可以看到这些服务器都没有传统机架式服务器的顶盖和前面板,机柜也没有门,既降低硬件成本,又方便通风和维护(图片来源:Google官网)

前面板则起着支撑接口、驱动器等作用,某些品牌(如Dell)还会有选配的保护罩,放置Logo,兼具上锁功能。不过这些在大规模互联网数据中心都派不上用场,徒具其表而已,偏偏美观、卖相基本不在他们的考虑范围之内,讲的是功能性为先。不设面板,正面基本处于敞开状态,便于前端维护,通风效果也更好。用Facebook常说的话,叫“vanity free”(无浪费,或者,“告别虚荣”?)。

戴尔PowerEdge R730服务器的前面板护罩(bezel),新增iDRAC Quick Sync功能,用手机上安装的Open Manage Mobile软件,通过NFC配置iDRAC的IP地址、访问故障记录、改变网络设置,便于传统企业用户维护。而对前面板都不要的互联网数据中心来说,反而是虚掷金钱(来源:张广彬拍摄)

如果说1999年Urs等人设计的那批“服务器”还透着浓浓的山寨感,不设前面板(顶盖看情况)早已是Google和Facebook的标准做法:省钱、利于通风、便于维护,一举三得。

二、化零为整,裁撤冗源

“化零为整”则是将供电单元(Power Supply Unit,PSU)与服务器节点解耦,以机架为单位重新组织,对降低CapEx和OpEx都有显著的效果。

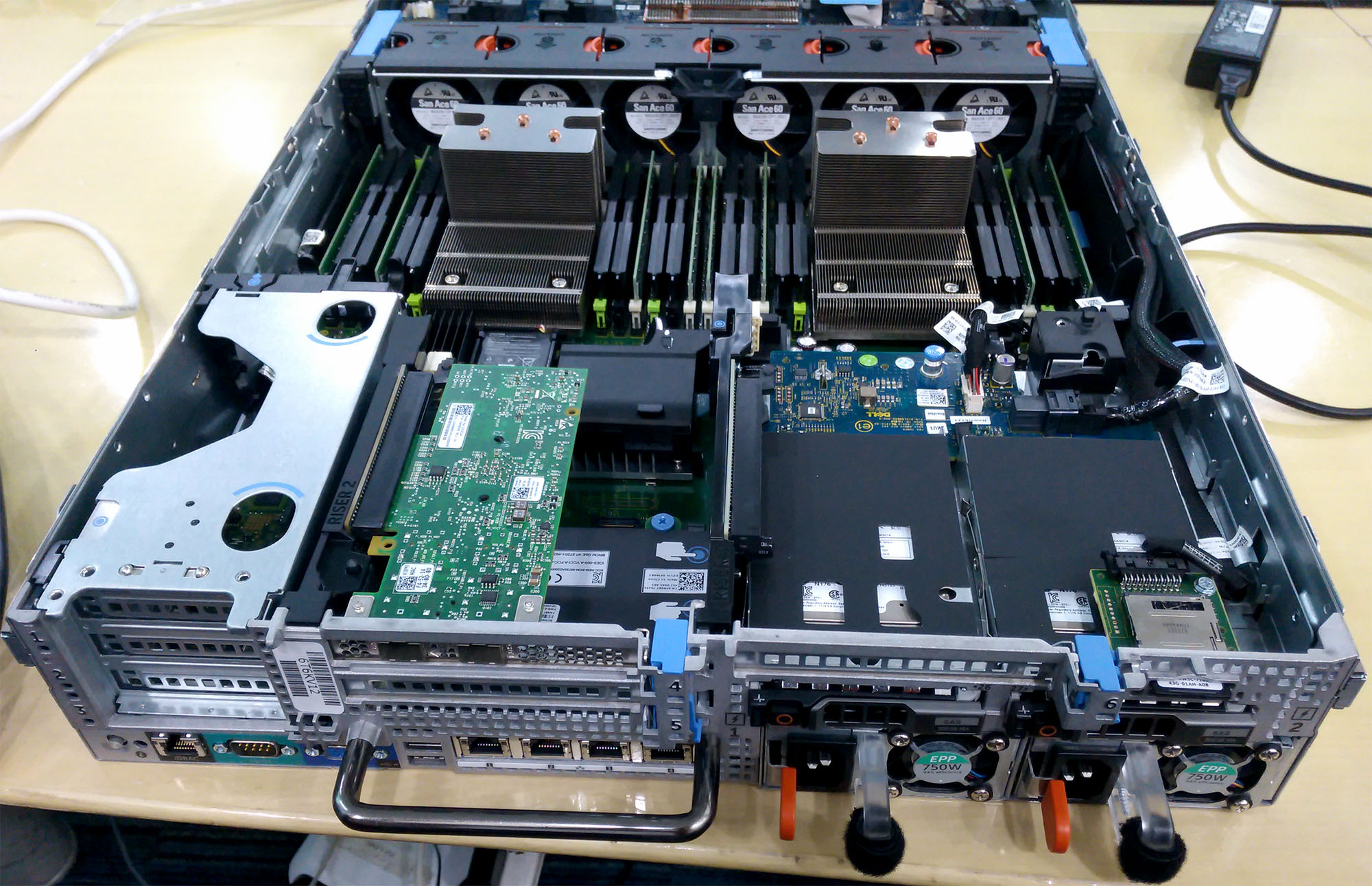

传统的机架式服务器——1U或2U,为保证冗余,会采用双供电单元设计,1+1配置。仍以2U的戴尔PowerEdge R730为例,PSU可选750W、1100W、1600W,还有不太常见的495W。按照750W来计算,20台服务器就是40个PSU,总功率30kW(以495W计也要19.8kW)。不论每台服务器上的两个PSU工作模式如何,都有20个是纯为冗余考虑的,浪费惊人。

2U机架式服务器后下方的2个750W电源模块,还有中前部的6组60mm风扇(来源:张广彬拍摄)

若将PSU从服务器中取出,汇聚成池,统一给20台服务器供电,那么,只需10个1600W的PSU即可,总功率16kW,N+1或N+2的配置足够保证冗余度。10个1600W的PSU显然比40个750W的PSU便宜(CapEx),功率只有一半左右但已够用,服务器内部的空间也变得更规整,可以容纳更多的部件(如硬盘)。

浪潮SmartRack 4.0整机柜服务器中部集中放置的10个PSU(来源:张广彬拍摄)

另外,前一种(分散布置有冗余的)情况下每个PSU的负载情况只有20%~30%,后一种(集中布置共享的)情况则可以在50%左右,是电源效率最高的区间,也意味着更省电(OpEx)。

电费是OpEx的重头。继续本文开始的估算,5台服务器不停的运转,就相当于美国一个家庭的平均用电量;以每千瓦时0.097美元(Dell在2012年的数据)计,100万台服务器每年的电费就超过2.1亿美元。尽管以服务器生命周期为三年来计算,全生命期内服务器所消耗的电费仍不及购置成本(何况每台1000美元的估价偏低),但是,只要把整体功耗降低10%,100万台服务器每年即可节省2100多万美元,三年累计的效果堪比取消两侧的机架导轨(Rack Rails)。

必须指出的是,这有一个适用场景的问题:配备冗余供电单元的服务器可以独立使用,对外界环境依赖很小;集中PSU之后,每个服务器节点不能独立使用,只能配合特定的机柜——换言之,在小的尺度上解耦(decoupling,或disaggregation),又在更大的尺度上重新耦合,适用的也是大规模应用环境。

三、化整为零,行业巨变

2006年,成立于1999年的Dell OEM Solutions曾为Google定制生产一批面向企业的服务器,名为Google Search Appliance(非Google自用)。

Google Search Appliance (GSA)是Google提供给企业客户的设备,硬件由Dell等服务器厂商提供,将Google的搜索技术与企业的应用软件集成,目前最新的版本是7.2,2014年2月中旬发布(来源:Google官网)

2012年10月底,戴尔公司庆祝其始于2007年的互联网客户定制业务DCS(Data Center Solutions,数据中心解决方案)出货达到100万台服务器,宣称这100万台“云服务器”可以节省62MW的能耗(假设每台节省41W,数据中心PUE为1.5),足够美国亚利桑那州Tempe的每一个家庭使用(2006年约17万人);四年可减少电费开支2.1亿美元($0.097/kWh),节省的数据中心面积达33.84万平方英尺(约3.1万平方米),大于等于9个泰姬陵……

2013年,戴尔宣称其支持着5个最大搜索引擎中的4个、4个顶级社交网站中的3个、5个最大云服务中的4个、15个最常访问网站中的12个……的正常运转。

出色的成绩。不过,显而易见,最大的那几家不在其中,因为早已转向ODM(Original Design Manfucturer,原始设计制造商);以后也很难保持,因为会有越来越多够规模的互联网公司考虑ODM,或者——中国的OEM们。

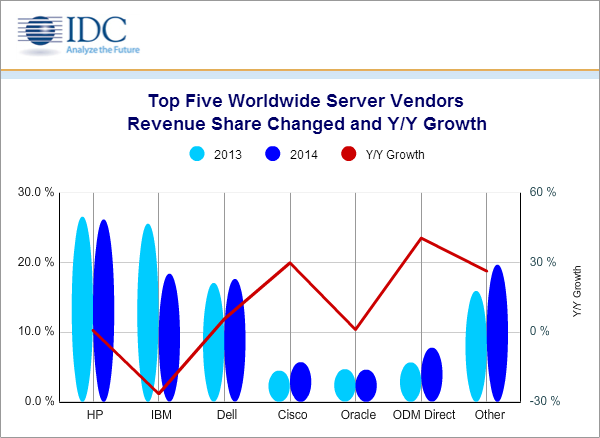

从2013年第三季度开始,IDC的全球服务器市场报告中将原来列入“其他”(Others),由广达(Quanta)、纬创(Wistron Group)/纬颖(Wiwynn)、英业达(Inventec)、仁宝(Compal)等ODM直接销售的完整系统,和最终在渠道中由集成商完成组装的部分子系统,合并成一个新的厂商类别——ODM直销(ODM Direct)。在:

- 全球服务器市场收入同比增长4.8%,出货量同比增长5.7%、达到238万台;

- x86服务器收入同比增长11.6%,出货量220万台保持平稳

的大背景下,ODM服务器取得了45.2%的收入同比增长,达到7.83亿美元,占总体服务器市场的6.5%,接近IBM大机(运行z/OS的System z)所占的6.8%;出货量增长30.7%,达到325685台,占全部服务器出货量的14.4%。该季度79.6%的ODM直销服务器收入来自美国,包括Google、亚马逊、Facebook和Rackspace(微软与戴尔的合作历史比较久)。

从那以后,ODM直销保持40%以上的收入同比增长,不仅把身后的思科(Cisco)和甲骨文(Oracle)越甩越远,仅次于前三大,还超越了IBM大机。2014年第四季度,ODM直销收入的同比增长终于降至31.4%,但全年的同比增长仍有40.5%,接近40亿美元,占有7.8%的市场份额。

IDC统计的2014年全球服务器厂商收入份额,及相对于2013年的变动情况,可以看到ODM直销的市场份额已超过思科和Oracle,相当于第四大服务器厂商(来源:IDC,2015年3月)

直接找ODM的原因有很多,主要是觉得给OEM这个中间环节的钱不划算,而大OEM们也不想赔本赚吆喝了,必须改变对策。

“化整为零”说的就是服务器采购模式的改变。广达、纬创、富士康(Foxconn)等ODM主要为OEM开发硬件平台,戴尔、惠普、IBM等OEM加入硬件IP(知识产权)、底层软件(如固件)、服务、管理工具、物流、融资、集成、分销、支持等能力,作为一个完整的解决方案提供给最终用户,价格肯定要比各部分组件成本之和高不少。

除了电源、机箱,服务器还有CPU、主板、内存、硬盘等关键组件,要么单价高(如CPU),要么用量大(如硬盘)。大部分普通用户不会分开采购,一则设计、集成、测试等工作还是颇有技术含量,二则戴尔等OEM因采购量大,有议价权,很可能加价后还是便宜。

互联网巨头则不然。技术上,随着定制的普及和深化,他们越来越深入的参与到设计环节,服务器OEM的价值逐渐受到削弱。规模上,去年x86服务器的出货量不到1000万台,Google一家可能就有8%,接近戴尔(2014年占全球服务器市场收入份额的17.6%,非出货量)的一半,不低于ODM直销的份额,可以争夺服务器市场第四的排名——也有说Google相当于全球第三大服务器厂商,自产自用而已;2013年据Bloomberg供应链分析,Google是英特尔(Intel)第五大客户,贡献了后者约4.3%的营收。部件供应商如硬盘厂商也看到了局势的变化,乐于直接卖到互联网公司等大客户,而不受制于OEM,这一点后面还会展开讨论。

有了议价权,分开采购就成为可能。需求细化之后,设计、兼容性测试、组装等工作可以交给ODM和渠道集成商——譬如,著名渠道商Synnex公司2012年成立了Hyve Solutions分部,专门为Facebook等客户服务。

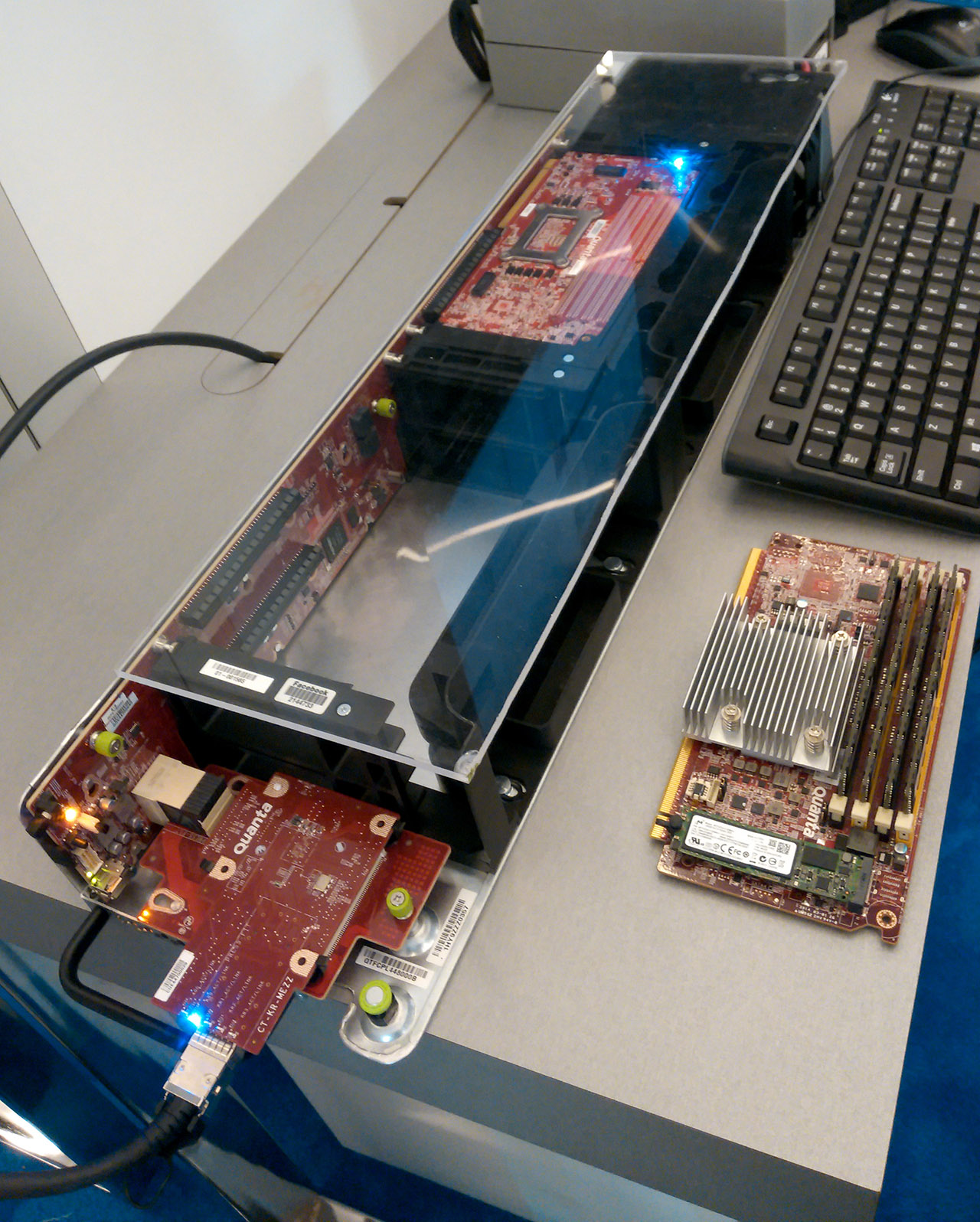

Hyve Solutions在AWS re:Invent 2014上展出的服务器和对象存储硬件(来源:张广彬拍摄)

渠道厂商化,厂商渠道化。原本就被人说是搬箱子,现在有彻底变成走量的趋势。要么放弃血拼,把重心放到另外那百分之七八十以传统企业客户为主的市场上,更依赖ODM的IBM干脆直接变卖走人;要么薄利多销或赔本赚吆喝,走量冲排名,如中国的OEM们。

Dell DCS的第五代(G5)服务器,从前面板即可看出风格明显与PowerEdge家族不同:21英寸机箱、集中PSU(10个1600W)和散热风扇(3个一排)、整合RMC、节点高度1U的整机柜设计,相当符合天蝎2.0规范。腾讯是戴尔DCS在国内的主要客户(来源:张广彬拍摄)

不过,惠普和戴尔没那么容易放弃,毕竟量在那里摆着,而且持续高速增长。以前解决方案拼不过IBM,被视为只会做低附加值的硬件,如今这块阵地又被ODM们“釜底抽薪”,高不成低不就,情何以堪?

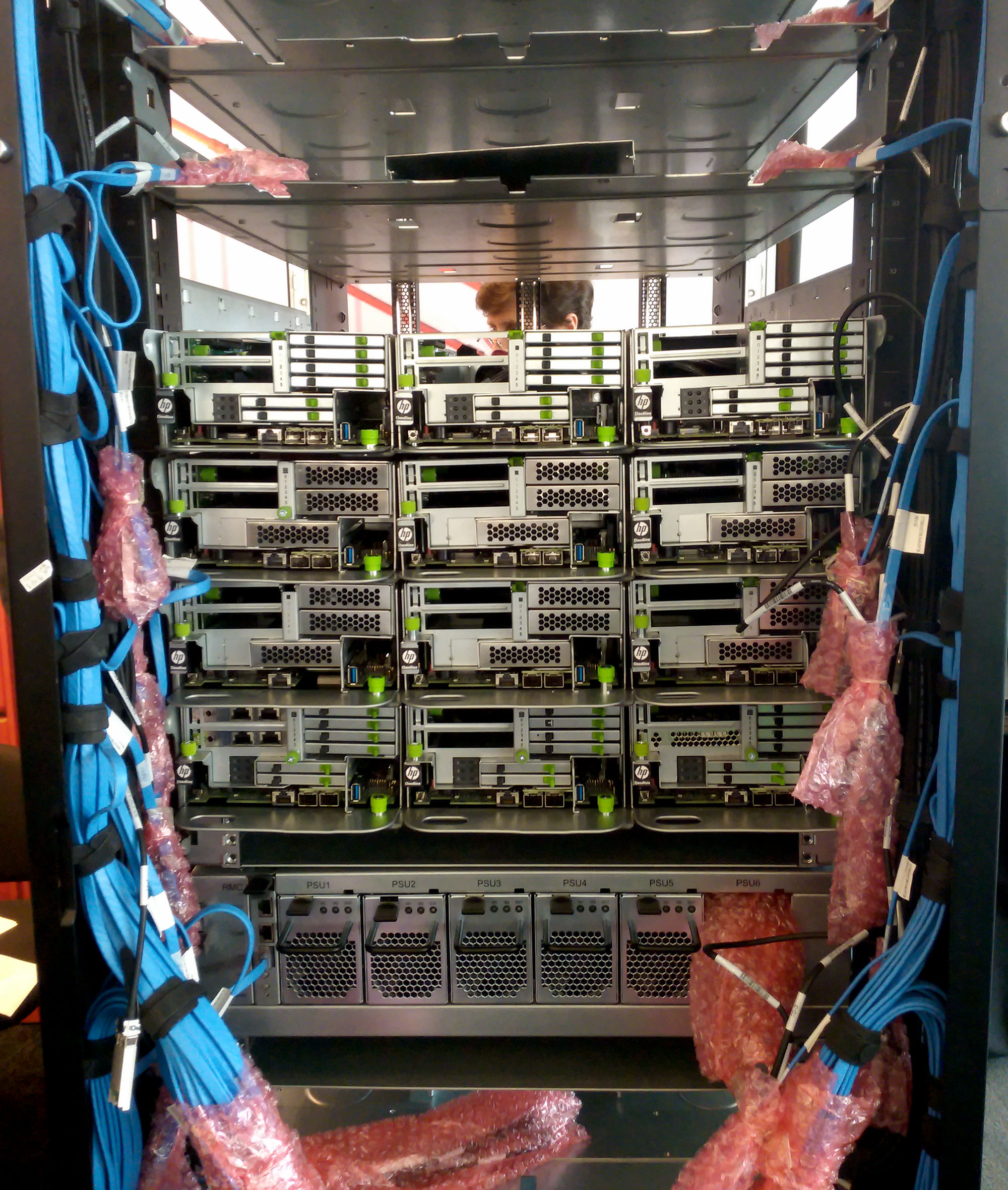

显然,戴尔的战略是对的,不能以PowerEdge这样面向传统企业市场的标准化产品去争夺互联网客户,必须设立单独的业务或品牌,削减成本拼定制,如DCS仍有微软这么重要的客户。同理,惠普只靠ProLiant也是不行的,于是在2014年4月底宣布与(服务器ODM中知名度略逊的)富士康合资,意在超大规模服务器(Hyper-Scale Servers)市场上展开竞争,并推出了为服务提供商(Service Provider,SP)定制的Cloudline服务器产品线,作为ProLiant家族的补充,一个拼附加值,一个打价格战。

符合OCP设计规范的HP Cloudline CL7100服务器,也是与ProLiant截然不同的风格。图中靠下位置是Open Rack集中的PSU(来源:张广彬拍摄)

ODM直接与大型互联网客户接头,戴尔(DCS)与惠普(Cloudline)分兵抵挡,加上浪潮(Inspur)、联想(Lenovo)、中兴(ZTE)、华为(Huawei)等中国服务器OEM的类似策略,服务器市场上,OEM与ODM的界限愈发模糊起来,抢夺客户才是硬道理。

四、宠物与牲口

定制的好处是针对特定环境优化,代价是丧失了通用性。譬如,“偷工减料”和“化零为整”固然可以降低设备的购置成本,却也提高了对使用环境的依赖程度。通用服务器为顶盖、前面板和冗余电源付出了成本,但在普通的办公场所即可部署;而去掉顶盖、前面板并使用集中PSU池的定制服务器,机柜也得是配套的定制产品(还要尽可能放满)。不仅如此,由于正面基本处于敞开状态,随便放在托管的数据中心怕是不合适,即数据中心亦要相匹配。换言之,从数据中心到机架,再到服务器,要作为一个整体来考虑;不能如传统数据中心般不同的层之间保持“透明”——因注重每一层的通用性,而处于割裂状态。

大型互联网公司内部的数据中心团队和服务器团队在一起工作,了解彼此的状况,也更容易掌握业务的需求,毕竟是一家嘛;而在传统企业市场,数据中心建设、服务器(存储)提供商和用户,三方是分开的,沟通合作是大问题,很难做出准确的决策,更遑论快速高效了。

挑战在于,为了省钱,“特定的环境”,不等于“特别好的环境”——恰恰相反,往往是更严苛的环境。

这就要谈到数据中心的宠物模式与牲口模式。前微软杰出工程师、SQL Server BI总经理Bill Baker有一个关于(虚拟)服务器的绝妙比喻:

- 传统的纵向扩展(Scale-Up)设备就像家养的宠物(pets),每个都是独一无二的,甚至起上名字,病了精心照料,直到恢复健康;

- 基于通用硬件的横向扩展(Scale-Out)设备就像牧场的牲口(cattle,这个词本身就用作复数),为数众多而相互间几乎没有区别(homogeneous,同类的),通过编号区分,病了随时可以“杀死”(替换)——是不是也意味着容易传染“瘟疫”?

Google在1999年订购的“软木板服务器”已经践行了“牲口模式”——注意每个主板贴在扩展槽上白色标签的编号(来源:张广彬拍摄)

这个比喻被CloudScaling的共同创始人兼CTO Randy Bias和CERN(欧洲核子研究组织)的Gavin McCance引申到数据中心及OpenStack领域而广为人知。想想确实如此:传统的纵向扩展模式追求单一设备的高可靠性和高可用性,需要用户的精心照料,数据中心要像家一样舒适宜人;横向扩展靠分布式的软件架构保证整体的可靠性和可用性,在大规模使用的场景下硬件故障是不可避免的,直接换掉就是,数据中心就像牧场一样…?

Mike Barham正在俄勒冈达勒斯的Google数据中心里更换主板。当服务器有部分损坏,Google首先尝试修理好;如果不能,就彻底破坏为钢、塑料、铜等原材料并回收(图片来源:Google官网)

像“家”并不意味着规模就一定小,有些以传统企业为主要客户群(至少是之一)的主机托管(Colocation)数据中心从规模到技术水平上,并不逊色于互联网巨头们的超大规模数据中心。譬如Switch通信公司旗下的SuperNAP 8数据中心,虽地处炎热的拉斯维加斯南部,仍能达到1.18的年均PUE,并且是五个获得Uptime Institute颁发Tier Ⅳ Gold运营认证的数据中心之一(2014年,号称是惟一的运营商中立托管数据中心)。紧邻的SuperNAP 7数据中心因为时间的关系,没有获得这一认证,但是面积更大(51.5万平方英尺,约4.8万平方米),具有两倍的容量——100MVA的供电能力可以满足Palazzo和Venetian(威尼斯人)赌场&酒店的需求。

eBay是SuperNAP的客户之一,后面的文章还会提到,感觉其在IT设备的选择上相对接近传统企业,不是很“互联网”。我在SuperNAP 7数据中心里见到了装满一个机柜的Oracle服务器(功率密度不逊色于互联网数据中心)、NetApp的(FAS系列)全闪存阵列等设备,不全是纵向扩展风,但一看品牌(价格/定位)便知是需要精心呵护的“宠物”类。送风温度68华氏度(20摄氏度),而传统数据中心冷通道的温度通常正是在20~25摄氏度,避免局部过热影响IT设备使用寿命,或影响应用的正常运行。

SuperNAP数据中心里的EMC Symmetrix高端存储设备,可谓“托管数据中心寻常客,Google、Facebook见不着”(图片来源:Switch通信公司官网)

相比之下,Facebook数据中心的送风温度可达80华氏度(26.7摄氏度)乃至85华氏度(29.4摄氏度),且具有更高的湿度。高温高湿,意味着什么?服务器的体魄需要像“牲口”一样强健——或者,一定比例的损耗是可以接受的。

图什么呢?当然是节能。有数据表明,数据中心的运行温度每提高5摄氏度,整体能耗即可降低8至10个百分点。

在运行温度低至少5摄氏度的不利条件下,SuperNAP 8数据中心能取得接近Google(约为1.12)和Facebook(约为1.07)的PUE水平,确实不易。没办法,作为一个多租户的托管机房,必须迁就客户的应用模式。

反过来说,自建数据中心就自由得多,(在合理的范围内)想建哪儿就建哪儿,想让设备怎样就怎样——或者,根据IT设备的需要设计建设。

前一种情况,可以找电费便宜、气候条件适宜的地点建设数据中心。当然,与租用数据中心比起来,自建数据中心存在位置固定和建设周期等问题,并需要与供应商谈判,签订长期能源供应协议(如本文开头Google与OX2的例子),以及更广泛的定制。据James Hamilton介绍,在有些区域,AWS会定制高压变电站以降低能源成本,加快建设速度;还要让供应商接受AWS在其电气开关设备里运行定制的固件,以避免因开关设备故障而导致的数据中心宕机(这种情况非常罕见,但Hamilton说他的职业生涯中已经遇到过3次)。

自建数据中心适合规模较大、长期稳定的使用情况,如果需要尽可能靠近用户或强调灵活性,租用数据中心是不可避免的。这方面的典型例子是CDN(Content Delivery Network,内容分发网络)——最大的CDN服务商Akamai的服务器数量超过15万台,分布在全球的上千个数据中心里。

Yahoo!设于纽约州北部Lockport的清洁能源数据中心,在2010年初获得美国能源部(DoE)近千万美元($9,921,887)大奖。这个最早公布于2007年的设计,充分利用了周围的空气温度和自然的气流来进行冷却,被称为“鸡舍”(chicken coop,YCC)——与“牲口模式”一脉相承?(图片来源:NBC Bay Area)

后一种情况,在Facebook采用定制服务器的初期有体现。2011年11月初,Facebook负责IT运营的Tom Furlong在接受ZDNet英国专访时透露,还有不到一半的OEM(非定制)服务器在运行特定任务。由于两类服务器的散热和气流特性不同,在数据中心中随便混置会影响散热效率。Facebook的解决方案是让高压的头部接近定制(OCP)服务器,允许其风扇低速运行以节能;低压的尾部接近OEM服务器,其高速转动的风扇可以保证散热效果(同样的流速条件下,气压高的区域空气密度高,单位体积带走的热量多,不需要风扇运转太快 )。

另外当时的交换机也不是定制的,这些现货(off-the-shelf)交换机和路由器不能把气流吹向后方,会影响热通道与冷通道的隔离,降低散热效果。Facebook想了一些解决方案,但最彻底的就是逐渐过渡到全部采用定制设备。

举个更具体的例子。有些核心网络设备采用侧面送风(左右进风排风)的冷却方式,还有传统机房从地板下送风的设计,都不适合互联网巨头们采用的整机柜。Google、Open Rack和天蝎整机柜普遍采用前后送风方式,为提高通风效率不设置前面板和机柜门,为提高密度而不断增加机架的承重能力,所以Google和Facebook的数据中心均为厂房式大开间(见本文前面的图),整体作为冷通道,封闭热通道(冷通道空间明显大得多,在不使用列间空调的情况下可以提供更大的冷量),没有垫高地板(可能降低承重能力,又无必要)。如果换成采用垫高地板下送风的传统托管数据中心,反而不匹配了。

作为一个现代化的托管数据中心,SuperNAP数据中心的总体设计未必逊于Google,根本区别在于里面放置的主要是客户的传统非定制机柜。在这种情况下,机柜门有其存在的价值,也不能过多考虑设备的散热设计会不会影响总体PUE等问题,满足客户需求是第一位的(图片来源:Switch通信公司官网)

从上面的分析不难看出,传统以设备为中心的思维,重个体轻整体,重CapEx轻OpEx。虽然,随着虚拟化等技术的应用,传统企业市场在2008年前后就开始加强对OpEx的宣传,但关注更多的还是设备本身的利用率,仍把应用的可用性寄托于硬件,所以要在很好的环境里伺候起来(如20度的空调)。为保护硬件投资(CapEx)而不惜提高运营成本(OpEx)的局面,没有得到根本改观。

诚然,即便是以买廉价硬件为标记的互联网巨头,服务器生命周期内的总电费(只是OpEx的一部分),通常也赶不上购置成本,何况还要分摊到每一年,没有CapEx的数额那么大且直观,(特别在中国)传统企业用户重视不够也是可以理解的。互联网公司比较可取的一点是,有意愿更有能力摆脱以设备为中心的思维,将CapEx和OpEx作为一个整体来考虑(这才是真正重视TCO),必要时可以在CapEx和OpEx之间转换,只要总的TCO下降了就行。

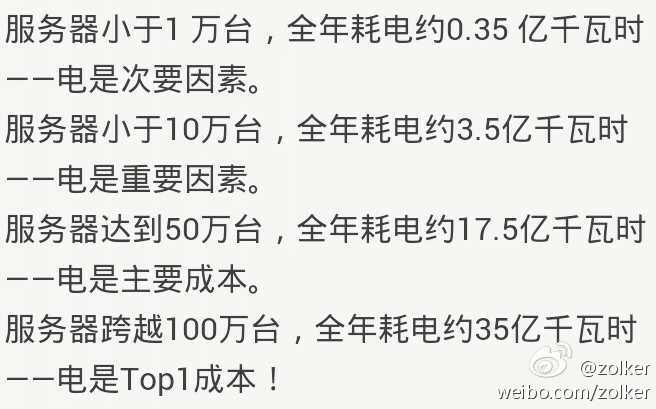

腾讯华南数据中心高级经理郁智华指出,随着服务器数量的增长, 电费在数据中心运营成本(OpEx)中所占比例不断上升,100万台规模时已是最大部分。因为人员维护成本等可以通过软件和自动化去控制,不一定随着规模线性增长,电费则不然(图片来源:前新浪DBA杨尚刚的微博)

在“宠物模式”下,出于保护设备投资(CapEx)的考虑,设备的生命周期长一些会比较好。但是,对于CPU等技术更新换代较快的组件来说,这样未必划算。英特尔2012年的分析数据指出:在整个IT基础设施中,使用4年以上的服务器占32%,计算能力只占4%,能耗却占65%!

当然,上述言论可以理解为英特尔希望大家加速产品(特别是CPU)换代,不妨看看Facebook的观点。Facebook认为,由于摩尔定律的存在,x86 CPU不到两年性能可提升50%以上,TDP基本保持不变,如果能够及时更换,可以大幅提高单位密度的计算能力,或显著降低单位计算能力的耗电。不过,更换周期过短的话(如不到两年),能耗的节省仍然不及新CPU的支出,如何利用二手CPU回收部分成本也值得研究。

但有一点是可以验证的,即适当牺牲服务器的设计使用寿命(譬如从五年减至三年),能够降低硬件的购买成本和运营成本,并更快的淘汰低性能、高能耗的设备(在多出来的两年时间里尤为明显),CapEx和OpEx双管齐下,而不是用CapEx换OpEx(不得已而为之)。

采用廉价、设计使用寿命较短的硬件意味着相对较高的更换率,要保证整个体系的RAS(Reliability, Availability and Serviceability,可靠性、可用性和可维护性) 需要软硬两个方面的配合:一方面,要由分布式的软件架构负责可靠性、可用性,而不是依赖于硬件的设计(反正硬件总是要坏的);另一方面,不同种类的硬件之间要解耦,便于更换发展较快的部件如CPU、内存。一言以蔽之,通过软件定义驱动硬件重构。

从数据中心基础设施(风火水电)到IT设备的整体化定制和一体化管理,使互联网巨头们可以进一步优化数据中心的运营效率。Google在2014年5月公布了利用机器学习及神经网络算法“榨取”数据中心PUE潜能的成果。一个典型的Google数据中心在投产初期的PUE约为1.25,Google通过持续的运营优化将PUE降低到1.12,但要想进一步降低就很困难了。因为到了某一阶段,制冷和电气系统之间的相互作用和各种复杂反馈回路,使用传统的工程公式难以准确推导数据中心的效率。譬如冷通道温度的较小提升都会导致制冷系统的很多变化,如冷机、冷却塔、换热器、水泵等设备的功耗都将增减不定,且非线性变化,其结果很可能是冷通道温度提升而总功耗增加(而不是降低)。

机器学习方法利用现有的大量传感器数据来建立一个数学模型,理解操作参数之间的关系从而提升整体学习效率;神经网络是一类机器学习算法,它模拟神经元之间相互作用的认知行为。Google的BMS(建筑管理系统)、PMS(可编程管理系统)及控制系统每天产生数以亿计的原始运行数据,人类难以理解,却适合机器挖掘。

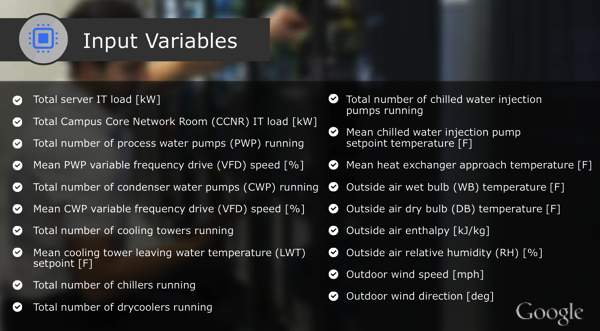

Google神经网络算法使用的19个输入变量,可谓用大数据支持云计算的范例(来源:Google)

Google利用传感器部署了几万个数据点来收集服务器总负载、水泵、冷却塔、冷水机组、干式冷却器、湿球温度、户外湿度、风速、风向等基础设施运行数据和电能使用信息,多达19个变量作为神经网络研究的要素,而只用一台服务器就能运行整个神经网络系统。通过与历史数据的结合进行PUE仿真,Google的数据中心团队选定了一套新的运营参数,能将PUE降低到1.1以下,其预测的数据中心PUE精度为0.4%~0.5%之间。考虑到Google上百万台的服务器数量,将PUE再降低0.02也有可观的节能效果,关键是投入产出比很好。随着实际运行数据的不断积累,PUE模型的精度预计会随时间进一步增加。

Google的实践验证了机器学习方法可以利用现有的传感器数据来模拟数据中心能源效率优化,并可实现10%~15%的节能。机器学习会告诉运营团队如何优化数据中心的能效,包括模拟数据中心的参数配置评估、能效评估,并确定优化方案。

据说百度也在研究预测实际工作负载的变化情况,调节数据中心运行参数,以达到进一步降低PUE的目标,而不是一味依靠硬件本身能效的改善。

五、自主与生态

站在业务应用的角度,数据中心基础设施与IT设备都属于基础设施层面,这种底层的定制与优化如何改善上层应用的效能呢?需要深入到IT设备的组件级,包括计算、存储与网络的核心部件,最明显的就是SSD(Solid State Drive,固态盘)和CPU的定制。

定制SSD

SSD近年来发展迅猛,但在传统企业市场的接受度还有待提高。主要原因是SSD相对硬盘驱动器(Hard Disk Drive,HDD)而言是一种颠覆性的产品,一则用户要从单位容量成本($/GB)的传统思维转向单位性能成本($/IOPS),市场需要教育;二则成本因素还是需要考虑,并不是所有的数据都能存到SSD上,关乎SSD拥有和使用成本的技术手段如缓存、分层,以及重复数据删除(Data de-duplication,dedup)、实时压缩等(Real-time Compression,RTC),在企业级存储系统中普及也需要一段时间。

有足够软硬件开发实力的互联网巨头不用等市场成熟起来。Fusion-io(FIO)在2011年IPO之前,最大的两家客户Facebook和Apple贡献了近70%的收入。Google则棋高一着,早就自己定制SSD了,动因还是“量大”。

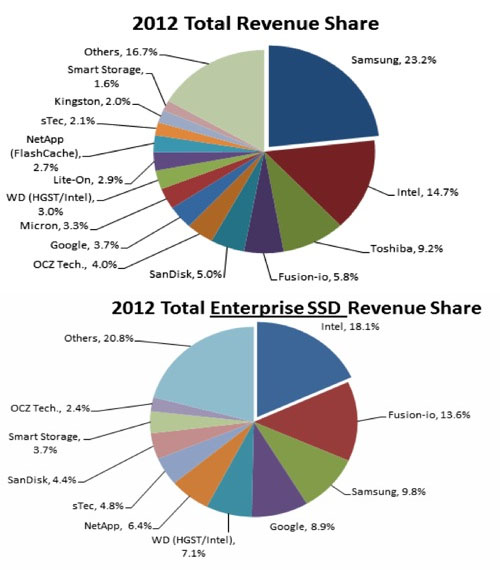

Gartner在2013年中公布了2012年全球SSD的出货量数字,Google身居其中,而且排名不低:总体收入份额3.7%,排名第7,前面的6家依次为三星、英特尔、东芝、Fusion-io、SanDisk和OCZ;总体企业级SSD收入份额8.9%,名列第四,前三位依次为英特尔、Fusion-io和三星。

Gartner的2012年全球SSD市场份额统计,Google的排名领先于NetApp、sTec等企业级厂商,包括PC SSD在内的总体市场份额也超过Micron、Lite-On、Kingston等大众品牌(来源:The Register网站,Stifel Nicolaus分析师Aaron Rakers协助制图)

Fusion-io的收入份额数字分别是5.8%和13.6%,在IPO之前Facebook贡献的收入接近50%,到2013年第二季度这一数字仍高达36%。如果将2012年来自Facebook的收入占比以三分之一计,折合的市场份额也有约1.9%和4.5%。Google与Facebook消费的SSD(不考虑其他厂商)相加,整体收入份额约5.6%,企业级SSD收入份额能超过13%,均略低于Fusion-io,分列第五和第三。

在2013年的统计中,Google占总体收入份额为2.8%,排名降至第9;企业级SSD收入份额7.0%,排名降至第6。Google在SSD上的开支(即收入,因自产自用,不对外供应)仍在增长,幅度达15.2%,只是跟不上高达50%左右的市场增幅而已。换个角度来看,可以理解为Google对SSD的应用先于市场,等市场开始爆发时,Google已经进入稳定期——想一想每30元SSD销售额,就有1元产生在Google,是一种怎样的体验?

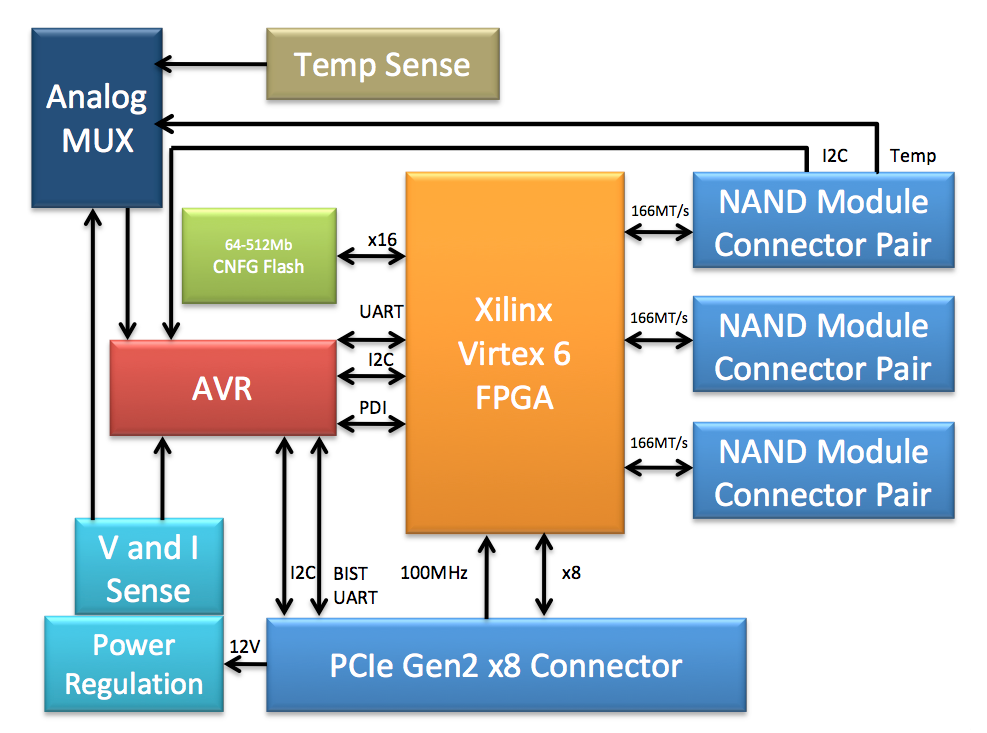

由于最大的客户Facebook发起了开放计算项目(Open Compute Project,OCP),Fusion-io在2013年1月中旬召开的第四届OCP峰会上贡献了3.2TB ioScale PCIe闪存卡的设计(主要是硬件实现,核心的软件IP还是要保护)。Google非但不存在“看客户脸色”的问题,反而可以要求零部件供应商(如闪存控制芯片)和硬件生产商等合作伙伴严守秘密,所以很少有人了解Google SSD产品的具体情况。

Fusion-io贡献的3.2TB I/O加速硬件框图,单凭这个设计规范是生产不出有“灵魂”的产品的(来源:OCP存储规范)

不受市场普及程度约束的不仅仅是互联网巨头,具备“既是厂商,又是用户”特质,同时掌握底层硬件与上层应用的公司都可以这样做。Oracle集成系统(Engineered Systems,工程系统)家族中的Exadata数据库一体机可称典型代表。2009年收购Sun之后不久正式推出的Exadata(2008年还有一代,具体看后面融合系统的文章),就集成了Sun F20 PCIe闪存加速卡。与Fusion-io的产品相比,Sun F20的方案很“挫”,但放到当时来看,Fusion-io尚处草创时期,企业级存储仍在追捧SAS SSD(NetApp是个例外),Exadata在理念和实践上已经很先进了。

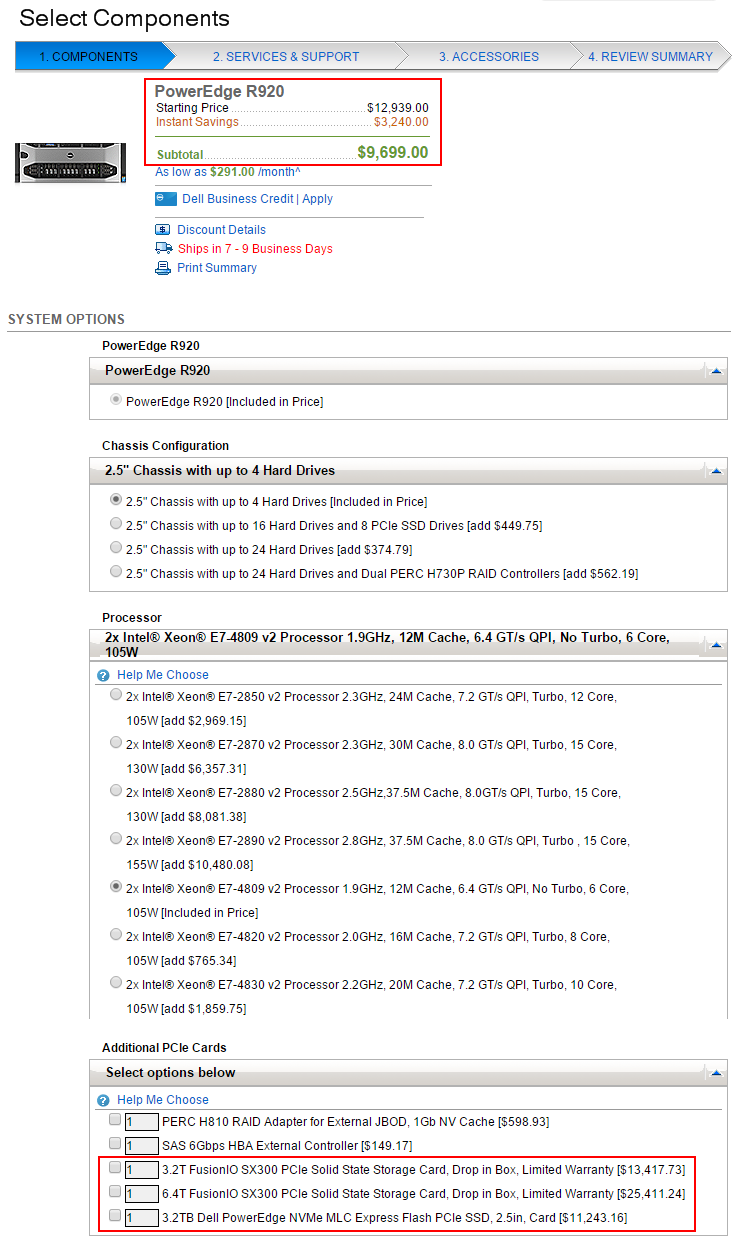

出于可以解释的原因,Exadata一直不买Fusion-io的账,其使用的PCIe闪存卡(SSD),到了Exadata X4还是架构上相对落后的SAS IOC + SATA闪存模块的桥接方案。然而,只要Oracle觉得有必要,用起新技术来可谓毫不犹豫。2015年1月21日,Oracle发布的第六代Oracle Exadata Database Machine X5,集成了正式推出才7个月的Intel P3600系列NVMe PCIe SSD,而且是定制版本P3605。虽然三星已于2014年3月下旬宣布,其“业界第一款”NVMe PCIe SSD随Dell PowerEdge R920服务器(从这个组合上看,也是主打数据库应用)全球出货,但是市场垂范效果难以评估,毕竟只是服务器选件(option)。

2015年5月17日,Dell官网上PowerEdge R920服务器及PCIe SSD(包括NVMe)选件的报价对比

服务器选件的市场接受度很大程度上取决于用户。且不说大容量PCIe SSD的报价比服务器的起价还要高(上图为配备2个至强E7 v2处理器的四路平台,双路至强E5服务器更便宜 ),还要考虑用户会不会用,服务器厂商的销售教育用户的能力和动力几何?实践已经证明,“选件”策略看似可以第一时间将新技术新产品推向市场,普及进度反而相对缓慢。

数据库一体机(集成系统或工程系统)则不然,决定如何选择与集成SSD的是数据库厂商的工程师,他们显然比绝大多数用户更了解闪存对数据库应用的价值,基本不需要教育,与SSD供应商的沟通更顺畅而明确。SSD作为一个完整解决方案的组成部分与服务器一起提供给用户,用户买了最新的Exadata(X5),里面自然会有NVMe PCIe SSD,关注整个系统运行数据库的效能即可, 不用单独操心硬件,让它在幕后默默奉献……当然,用户愿意了解,也没问题。

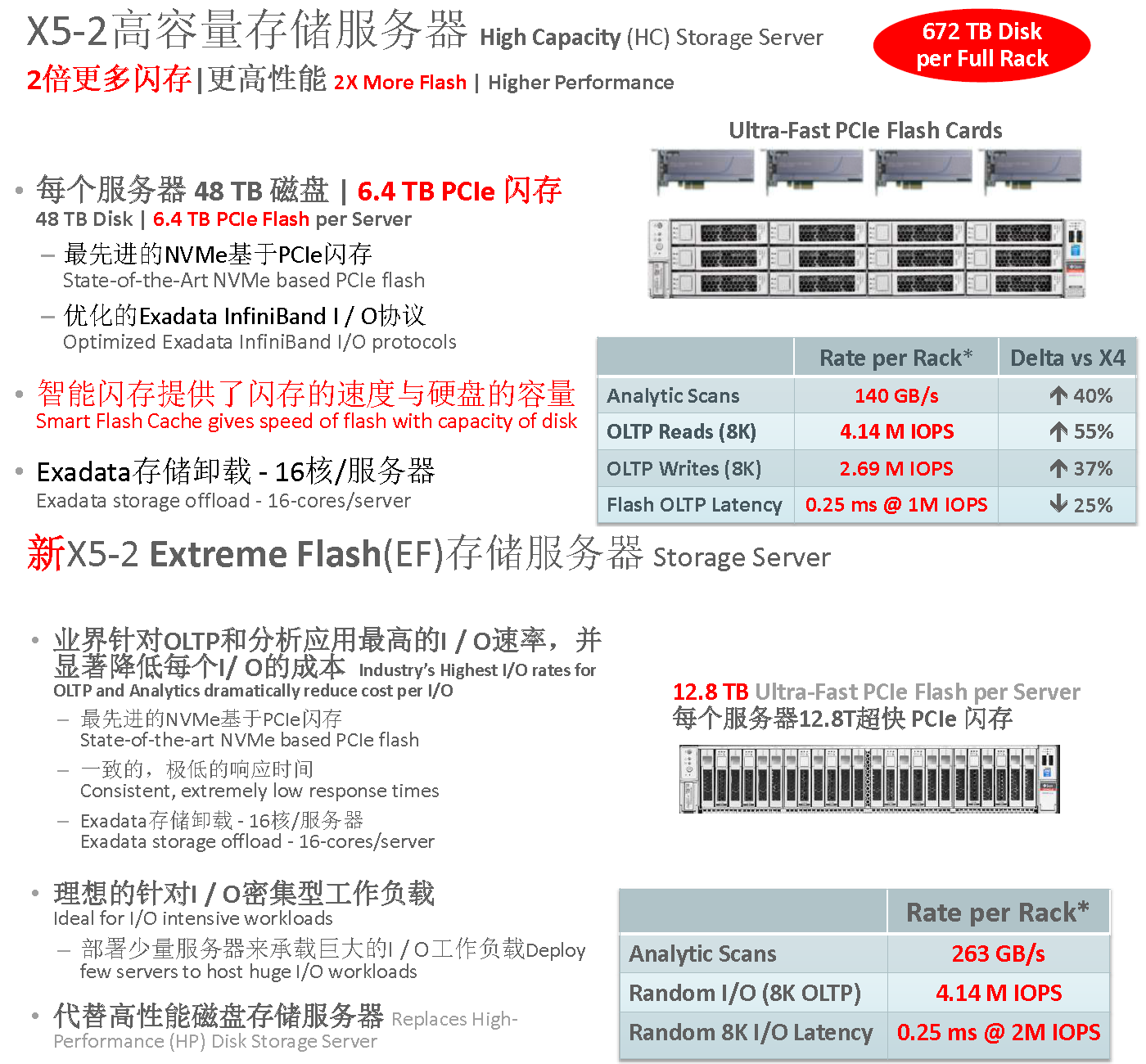

NVMe让Exadata X5-2高容量存储服务器(上)中用作智能缓存的插卡式PCIe SSD与新增EF存储服务器(下)中用作数据存储的SFF-8639规格PCIe SSD可以使用同样的驱动程序,简化管理和维护,应该是Oracle(在Intel推出产品后)几乎第一时间采纳的主要动因

从目前了解的情况来看,Exadata接纳NVMe PCIe SSD的速度,不逊于惯吃螃蟹的互联网巨头们。

Oracle的舵手Larry Ellison与Steve Jobs是好友,Oracle工程系统也以iPhone为努力目标(至少是这么标榜的)。有一点倒是很相似,即苹果的目标用户自然会去购买新一代的iPhone,关注的是屏幕尺寸及分辨率、存储容量等容易外化的指标,知道采用什么样的处理器属于加分项,存储如果不出问题也绝少有人去关心闪存是否TLC及供货商为谁(从业者除外)。作为对比,热衷于讨论手机处理器八核是否有必要、跑分高低等问题的,往往是Android(安卓)用户。

当然,我不是反对开放及开源——Windows Phone的用户基本也不讨论上述问题。iPhone率先采用64位处理器(A7),因为苹果自己设计CPU,再次体现了软硬件都由一家提供的好处。

定制CPU

有消息称,早在2008年,Google已经从英特尔定制CPU了。鉴于Google对其数据中心(特别是IT设备)采用的技术高度保密,很难看到公开资料。反而是连数据中心照片都不愿公布的亚马逊(Amazon),旗下的AWS(Amazon Web Services,亚马逊云服务)出于宣传需要,在2014年11月中旬召开的AWS re:Invent 2014大会上,透露Amazon EC2(Elastic Compute Cloud,弹性计算云)服务新增的C4类型实例,基于定制的Intel Xeon E5-2666 v3 (Haswell)处理器。

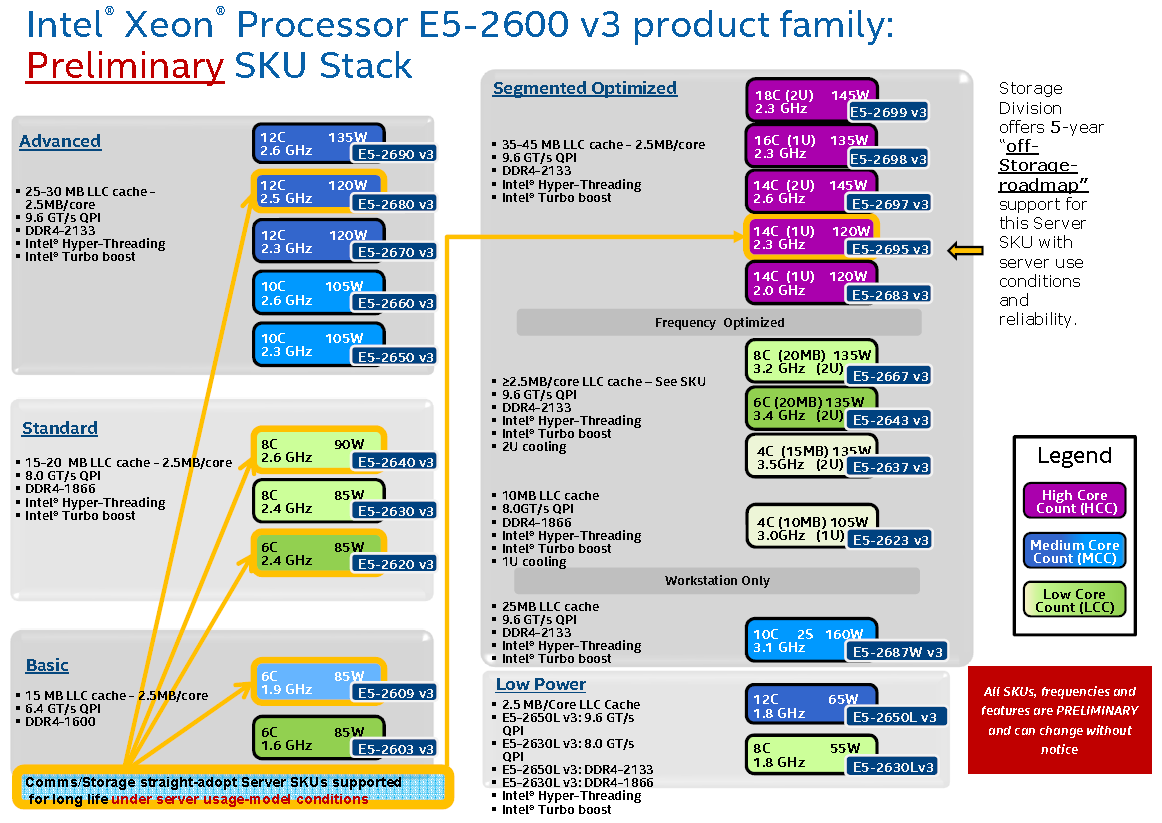

C4是AWS的最新一代计算优化型(Compute Optimized)EC2实例,前一代的C3实例采用高频率的Intel Xeon E5-2680 v2 (Ivy Bridge)处理器,从型号等信息来看,不是定制版本。作为定制型号,很难找到E5-2666 v3的详细信息,从AWS的文档来看,其与C3实例的E5-2680 v2及同代的E5-2660 v3一样,拥有25MB LLC(Last-Level Cache,末级缓存)、10核/20线程(推测),但主频更高(基频2.9GHz,所有核的Turbo频率3.2GHz,1或2核的Turbo频率可达 3.5GHz)。PCPS(Per Core P-States,每核功耗状态)是Haswell架构的特性,定制E5-2666 v3,是在通用的E5-2660 v3(10核/20线程,2.6/3.3GHz)与分段优化的E5-2667 v3(8核/16线程,3.2/3.6GHz)之间,增加了一个核数与频率兼顾、更符合AWS需求的SKU(Stock Keeping Unit,库存单位)。

至强E5-2667 v3所在的频率优化分段(右侧中间),允许每个核的LLC大于2.5MB,如6核20MB(每核3.33MB)的E5-2643 v3及4核15MB(每核3.75MB,比标准配置大一半)的E5-2637 v3。E5-2666 v3应该也属于此分段,推测其为10核,依据除了LLC为25MB,还包括采用E5-2666 v3的C4虚拟机最多可以提供36 vCPU(C4.8xlarge),意味着单CPU的物理核数至少不小于9(一台双路服务器才能提供36个线程),而我们又没见E5 v3家族有奇数核的配置(来源:Intel Xeon E5-2600 v3产品家族SKU堆栈)

C4.8xlarge 是EC2有史以来CPU性能最高的类型,为了与其处理能力相匹配,辅以60GiB的内存、支持SR-IOV的10GbE(万兆以太网),存储则默认为基于 SSD的EBS(Elastic Block Store,弹性块存储)。2008年8月中旬推出的EBS,在2012年8月初增加了基于SSD的Provisioned IOPS(PIOPS,预分配的I/O性能),2014年6月中旬又更进一步,推出基于SSD的General Purpose (SSD),因为是第二代通用( General Purpose)EBS,亦称GP2,作为默认的EBS卷类型;而原来基于磁盘的Standard volume(标准卷),更名为Magnetic volume(磁盘卷),用于存放不常访问的数据。将SSD作为块存储的默认类型,也是遥遥领先于企业级市场普及程度的,可见亚马逊在SSD应用上的实力。

2015年5月可用的EBS卷类型,价格以美东区(北弗吉尼亚)为参照(来源:AWS官网)

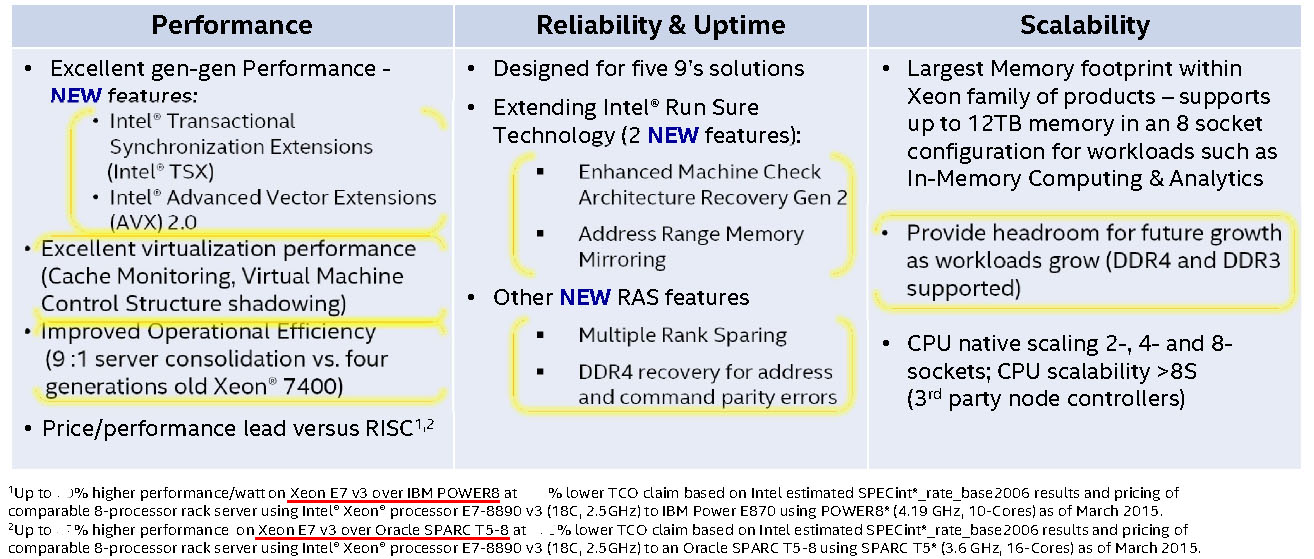

微软显然不愿让AWS专美,2015年1月上旬,Microsoft Azure云服务新增了G系列虚拟机,其中顶级的G5号称公有云里最大的虚机(the largest VM in the public cloud),也基于至强E5-2600 v3,提供32个VCPU、448GiB内存,还有6.59TB的本地SSD存储空间。这么大的内存容量主要面向数据库应用,包括关系型的SQL Server和MySQL,以及大型NoSQL和大数据解决方案如MongoDB、Cassandra、Cloudera、xTremeData和DataStax。

正如中国移动研究院高级研究员唐华斌所言:领先IaaS服务商的产品规格的提升,预示着云服务也开始越来越多地用于对处理能力要求很高的高性能计算(HPC)、大型数据库等关键应用。

英特尔在定制CPU及大型互联网客户应用上的集中展现,可以视为一年多来努力的成果。2013年6月,Intel宣称在当年定制了15款CPU,提到的用户包括Facebook和eBay。Facebook与Intel在定制CPU方面的主要合作是最大化CPU在单位功耗和成本下的处理能力,尤其是优化单位功耗的CPU处理能力,包括根据工作负载提出在CPU的核数、主频、关键状态(如P-State)管理方面的增强设置等方面的要求。

一年以后的2014年6月上旬,英特尔公司数据中心事业部总经理Diane Bryant表示,预计2014年定制解决方案的数量将超过前一年的两倍。 有消息称,2014年秋天,英特尔的云客户共有35个定制的SKU,到2015年5月已上升至50个。

人们更感兴趣的是,英特尔宣称在标准至强E5处理器的封装里集成FPGA(Field Programmable Gate Array,现场可编程门阵列),这至少有两个用途:一是与x86 CPU构成异构计算;二是方便客户在批量定制之前先行测试不同的配置,有助于推动英特尔在SoC(System-on-Chip,片上系统)方面的进展。Altera与英特尔从2013年开始就使用Intel 14nm Tri-Gate制程生产FPGA展开合作,2015年6月1日,双方宣布达成协议,英特尔将以约167亿美元现金收购Altera。

公布至强定制成果的范围迅速从中端的E5家族扩展到高端的E7家族——2014年7月中旬,Oracle推出Exadata数据库机(又是Exadata! 不过这是八路型号)的新一代X4-8(字母后面的数字表示“代”数,减号后面的数字表示单个计算节点的CPU个数),采用了定制的至强E7-8895 v2处理器,可以弹性的扩展频率和活动的核数以提高工作负载的峰值性能,而不需要重启。

这个案例再次证明了软硬件一体与定制SKU的关联。作为至强E7的另一杀手级应用,搭载SAP HANA的系统出货量也不算少了(就E7而言,起码应该和Exadata是一个级别),但是站在SAP的角度,HANA更像是一个参考架构 (reference architecture),硬件来自多个合作伙伴,不会锁定在一两种CPU型号上。在这种情况下,CPU对HANA的优化显然是个覆盖范围更广的系统工程,针对性没有定制那么强。

2015年5月初正式发布的至强E7 v3处理器的主要特性,性能方面选择IBM POWER8和Oracle SPARC T5-8两款RISC处理器作为参照,这里引用是为了突出竞争关系,故将可能引发争议的性能数字抹去(图片来源:Intel官方资料)

有趣的是,Oracle自己有与至强E7定位在同一区间的SPARC处理器,特别是在主要对应SAP HANA的Oracle Exalytics In-Memory Machine(内存分析一体机)中,同时有两个版本:基于至强E7 v2的X4-4和基于SPARC T5的T5-8。Exalytics X4-4用的也是至强E7-8895 v2,但限于四路配置(Exadata X4-8为八路配置),八路配置留给Exalytics T5-8。

SPARC的搭档是Solaris,在收购Sun以后,2011年8月,Oracle宣布Exadata X2-2和X2-8(的数据库节点)可以订购Solaris 11 Express,作为Linux的补充。在x86平台上,就是没有Express,Solaris也不是Linux的对手。实践证明这个定位确实尴尬,加之Oracle的支持力度不足,很少有用户使用,测试没有Linux平台充分,软件发布的速度没有Linux快,反过来就更没有用户使用,如此恶性循环……结果,Exadata数据库节点对Solaris的支持,八路从X3-8即已取消,双路坚持到X4-2,最新的X5-2和X4-8一样仅支持Linux。

SPARC和Solaris在Oracle的遭遇,与2011年流传过一阵的“Oracle即将收购AMD”被时间证伪一样,本质上有共通之处。Oracle毕竟是货真价实的软件(及服务)公司,只要市面上有可以满足要求的硬件供应商,自家的CPU可以留着侃价用,没必要为了全部掌控,在明显弱势的生态系统和产品上付出太多。

摩尔定律未失效,英特尔至强不跳票,工艺先进产能高,定制态度这么好……生活在理想世界里,大家当然不用操心。可是,没有人愿意看到英特尔一统天下,后者2013年开始加大定制(包括宣传)力度,与2012年ARM的一系列动作不无关系:开始支持64位,AMD投靠ARM阵营,等不及64位的百度还公然上 了一批ARM服务器(其实是存储)……RISC始终是x86甩不开的话题。

ARM在消费端(准确的说是移动设备)占优,英特尔当年就据此在服务器市场逆袭了RISC阵营,太清楚这一路线的杀伤力,此为其一。其二在于,英特尔是个执行力很强的整体,而当年的RISC阵营自相残杀给了它机会。不过,英特尔的警觉无法消除大家对其一家独大的担忧,又逢互联网巨头们有规模且动手能力强,只要硬件(性能、成本)基本过关,软件生态可以迅速建立起来。一旦从互联网市场打开了缺口,倒逼企业级市场并非难事。

2015年3月10日在硅谷召开的第六届OCP峰会上,展出的四至强D节点OCP服务器(Yosemite,左)及单个至强D-1500服务器(Mono Lake,右)。至强D为单核的SoC,核数比E5系列少(当时最多8个Broadwell内核,14nm制程),但集成了6个6Gb/s SATA、2个10GbE和4个USB(来源:张广彬拍摄)

这是信奉“惶者生存”的英特尔非常担心的事情。所以,百度的ARM服务器浅尝辄止,换来了很大的战略利益(包括议价能力),对Atom走进数据中心也起了一定的促进作用;Facebook倒是认真的 (虽然英特尔数据中心事业部高密度计算业务总经理Jason Waxman是OCP基金会的几位董事之一),可惜ARM服务器芯片初创公司Calxeda没熬到黎明就破产了。加之第一批64位ARM服务器芯片在功耗和成本上都没有达到预期,英特尔又吸取了移动市场的教训,迅速以Atom及SoC“灭火”,2015年3月初发布的至强D(Xeon D-1500)系列SoC兼具性能与集成度,提前封堵ARM的去路。只要英特尔不犯重大错误,ARM短时间内难以在服务器市场上构成真正的威胁。

当然,理论上,只要能坚持下来,领先者总会犯错误的。如果英特尔不能收复消费端的失地,ARM还等得起。

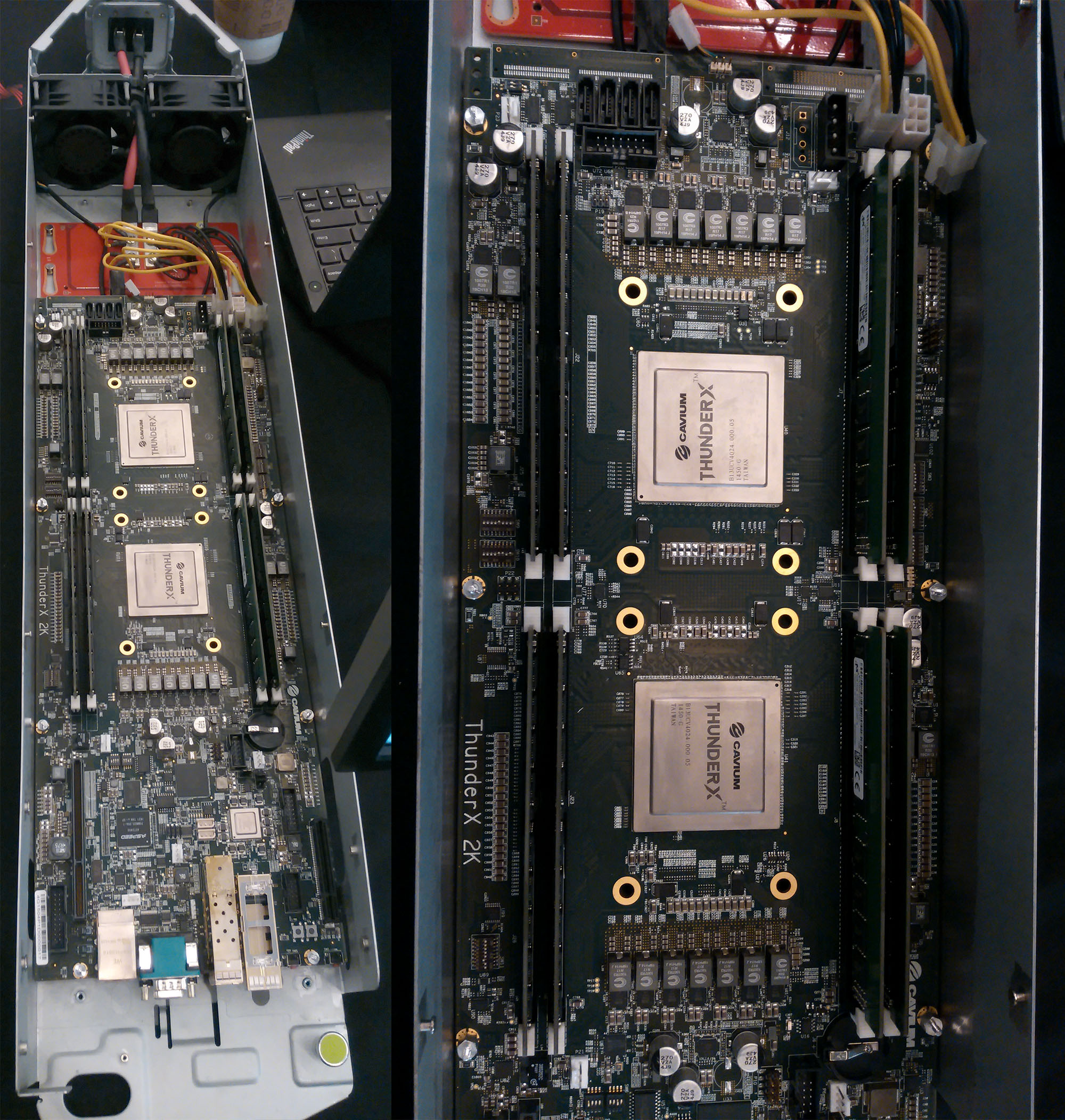

第六届OCP峰会上展示基于Cavium ThunderX 2K参考平台的OCP服务器,采用双路64位ARMv8服务器SoC(来源:张广彬拍摄)

站在互联网巨头的角度,既然有选择,都想去试试。2013年8月初,Google与IBM、Mellanox(迈络思)、NVIDIA(英伟达)、 Tyan(泰安)等公司发起了OpenPOWER联盟,Google硬件平台团队高级总监Gordon MacKean作为OpenPOWER基金会创始人并担任董事会主席。FPGA巨头Xilinx和Altera也加入了OpenPOWER基金会,有消息称IBM亦尝试与Altera合作,将FPGA集成到POWER处理器的封装中,但在英特尔收购Altera之后,恐怕只能看Xilinx的态度了。

2013年底,彭博资讯(Bloomberg)透露,Google在考虑打造自己的ARM服务器。一年多时间过去,无法证实Google在ARM上的动作。早在2009年,Google 负责工程的高级副总裁Urs Hölzle已于《The Datacenter as a Computer: An Introduction to the Design of Warehouse-Scale Machines》一书中指出,即便是分布式系统,也是单个CPU(核)的能力越强越好 ——Scale-out(横向扩展)不代表单点的Scale不需要up(纵向扩展)。他甚至还把这一小节单独摘出来,以“Brawny cores still beat wimpy cores, most of the time”(绝大多数时候,强核就是比弱核好)为标题在2010年的IEEE Micro杂志上发表了一页半的文章。

按照上述观点,如果ARM还是能耗导向,就不太适合计算(而不是I/O)为主的数据中心工作负载——存储倒是挺有前景。所以,在64位ARM可以与至强正面拼性能之前,仍然要考虑应用类型,譬如目前Oracle与ARM阵营的合作,主要集中在64位ARM对Java平台的支持上。

结合“传说中”的Google应用类型来看, 与至强(Xeon)同属强核(brawny core)的POWER显然比公认为弱核(wimpy core)的ARM(即使64位,包括Atom)更对其胃口,可以多一个选择(AMD太不争气了也)。Google一向注重保密,通常只在使用新的技术之后,才公开几年前的技术,这次出来与POWER一起Open,不禁令人看好OpenPOWER的前景,尽管有POWER8测试的结果未如Google预期等传言。

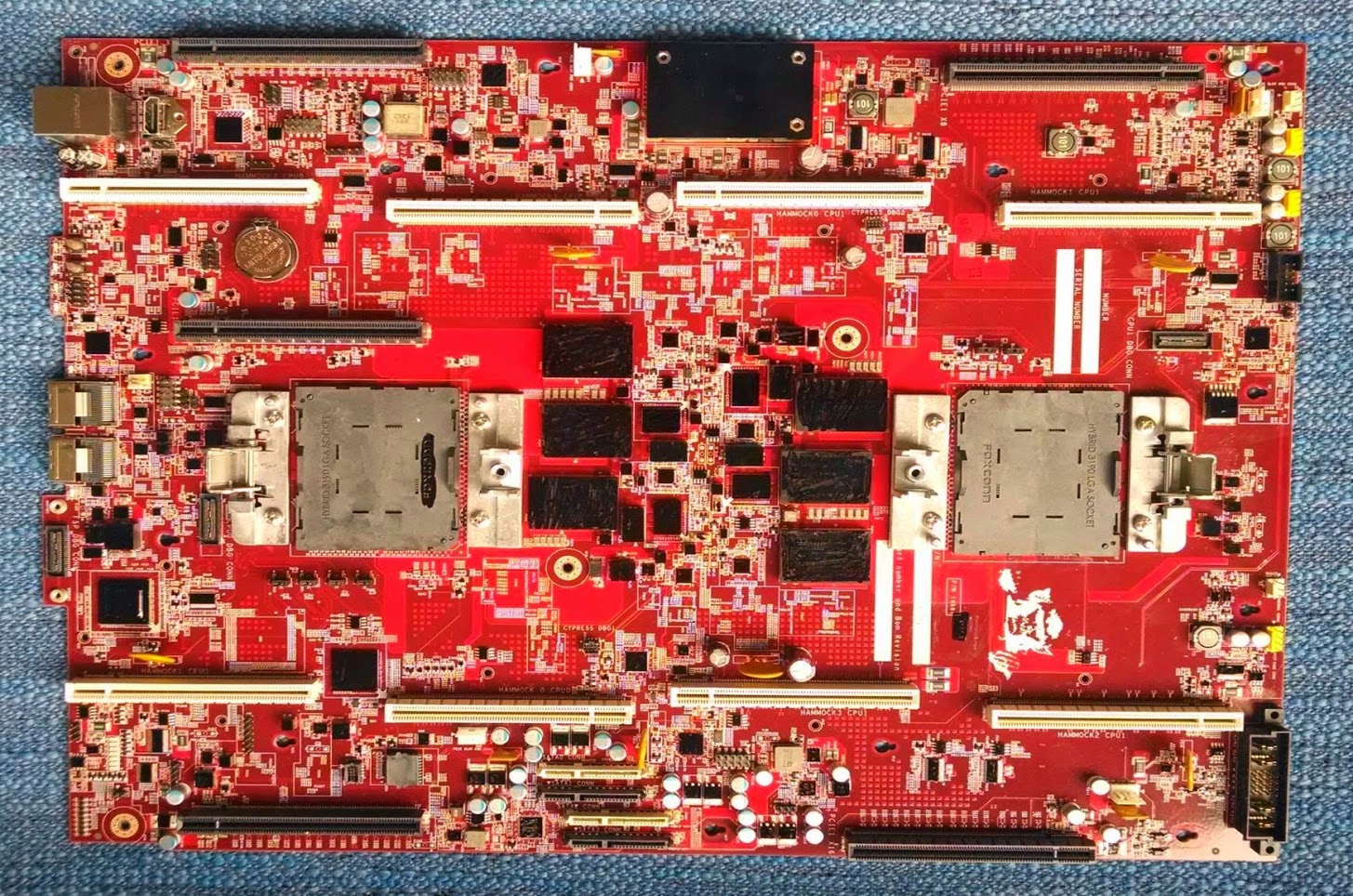

2014年4月底展出的Google POWER8服务器主板(来源:Gordon MacKean的Google+)

不过,虽然我们一直强调Google有多么重视基础设施,但基础设施毕竟只是它的业务支撑,而不是业务本身。以苹果为例,iPhone和iPad是它对外销售的产品,不仅要掌控供应链,自行设计处理器也是符合逻辑的(苹果和高通一样,拥有ARM架构授权);Google并不真正生产Android手机,ARM对Android的优化显然是另一个层面的问题——有点像前面讲的,Exadata与SAP HANA之间的区别。

且不说Google涉足基础设施技术只是满足自己使用的需要,就是苹果在ARM的生态环境中,也没重要到可以替代ARM (Holdings)作为核心的地步。

一个CPU的生态环境,核心厂商可以做的事情包括(但不限于)以下三项:

- 架构研发

- 设计制造

- 系统方案

CPU架构研发是核心厂商的责任,属于技术含量高、直接回报少的“脏活”。从MIPS到ARM,只做架构开发和授权的收入都不算多——可以对比下ARM (Holdings)和高通的营业额。

设计制造芯片,乃至做成整机(系统)销售,可以显著扩大收入规模,理论上更容易回收架构研发的成本。英特尔做前两项(这才能保证著名的Tick-Tock),第三项让给系统厂商(如Dell、HP等),包括提供参考设计帮助降低门槛,形成一个开放的生态系统。

英特尔提供参考设计、建设生态系统等行为最终目的还是利己,不过,青云(QingCloud)负责研发的副总裁甘泉对生态系统建设者的要求值得深思:可以自利,不能自私。不愿只干“脏活”,也是人之常情,无可指摘。

如果三项都自己来,通常意味着封闭的生态,因为争利之心太过明显。这方面的典型是2000年前后的RISC阵营,拉帮结伙,貌合神离,各有各的CPU,各有各的Unix,互不兼容,互相算计,更有甚者,还有个(后来)被英特尔摆了一道的卧底(HP)。于是乎,在自相残杀到只留下一个胜者(IBM)的时候,已经不是英特尔的对手了。

提起IBM开放POWER,有不止一个人说过“Sun被收购之前几年也开放了SPARC”。言下之意,SPARC开放只是让SPARC存活了下来,并没能挽救Sun。这么说只是强调历史的相似性,Sun在Java上所做的工作对行业影响深远,IBM早年对PowerPC(PPC)的贡献亦令人尊敬,可惜没坚持到OpenPOWER出现。

市场竞争很复杂,只做第一项(架构研发)也未必能保证成功,MIPS(经历和中间形态过于丰富,不展开)当年瞄准的市场强敌环伺,在RISC阵营的乱战中难以自保,后来连英特尔都结盟ARM(客观上)参与围剿。ARM则抓住移动市场的机会一举冲上潮头,英特尔惊觉之时已根深叶茂。

相对而言,生态系统的核心厂商是否拥有第三项(系统方案)业务,比第二项(设计制造)更容易影响开放程度,因为意味着同时掌握上下游。生态系统的其他参与者如果不做系统,除了芯片的设计制造,还有周边的组件(为简化问题,不考虑纯软件),更像是去补缺的;如果做系统,最好处于核心厂商难以涉足的市场(如互联网和一些特定行业),否则要面对既当裁判又当运动员的不对等竞争——算盘可是打得很精的。

自然,开放(开源)并不代表高尚,封闭也不代表邪恶,无关乎道德。不过,既然OpenPOWER的卖点就是“开放”,那就无法回避这个话题。OpenPOWER的成败不在于规格的开放,而在于IBM经营生态系统的诚意和能力。

小结

无论如何,开放(硬件)和开源(软件)是互联网巨头们采用技术时的基本诉求。这里面不乏Google般独特的视角(喜欢开源软件还因为它的私密性——“如果我们购买了软件许可或代码许可,只要对号入座,就可以猜出谷歌的IT基础架构。”),Amazon的保密甚至有过之而无不及。主要动机仍然是一体化的控制,出发点是用量太大,能够成真也是因为用量太大。正所谓:不是店大欺客,就是客大欺店。

客大到一定程度,不仅自己开店(服务器,对于部件供应商来说还是客)供自己用,为了吸引更多客人加入分摊成本,有的大客已经发起品牌加盟店了——下面两章我们就来讲讲OC劳和天蝎基。