全球计算机视觉顶会 CVPR 2020上,百度共计有22篇论文被接收。针对长视频上不同动作的时空巨大差异性,百度在这篇论文中提出了基于自监督的局部和全局混合时间域迁移新方法来解决这一挑战。自监督任务能有效实现域预测和顺序预测,从而更好地将嵌入局部和全局时间动态的跨域特征空间联合对齐,进而实现更好的动作分割性能。在三个非常具有挑战性的公开数据集上,本文提出的新方法都实现了大幅度的性能提升。

欢迎转载,转载请注明来源出处。

论文名称:https://arxiv.org/abs/2003.02824

论文代码:https://github.com/cmhungsteve/SSTDA

1. 研究背景

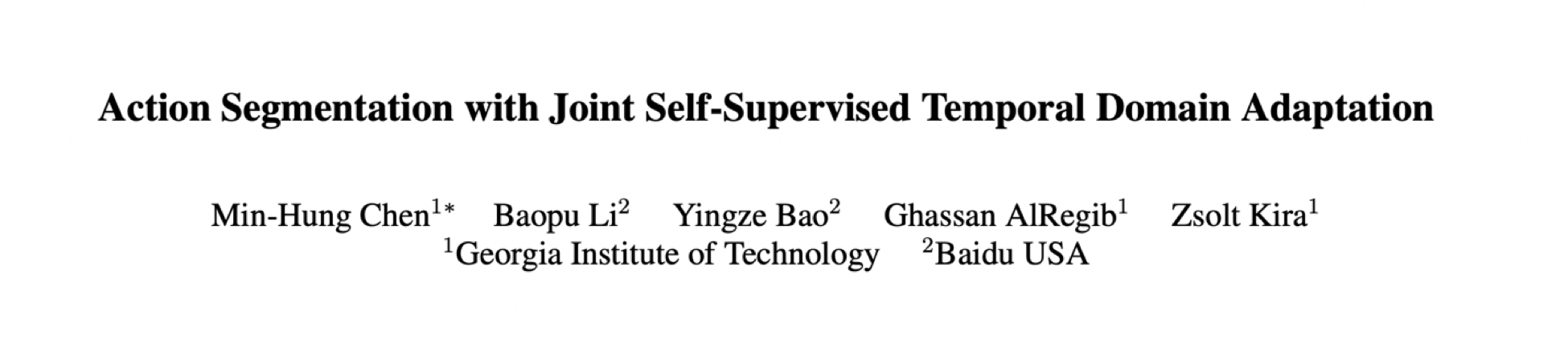

动作分割的目标是按时间同时分割视频并预测每个分割的动作类别,其中一个主要的挑战是整个视频中人类行为的时空变化问题。一种提高性能的方法是利用更大规模的标记数据。但是,手动注释精确的逐帧动作既耗时又困难。另一种方法是设计更复杂的模型结构,但是要增加模型复杂性的成本。因此,本文目标是利用相对容易获得的未标记数据来解决时空变化问题。为了实现此目标,本文提出通过使用辅助贴标的视频(具有不同人执行的相同类型的人类动作)来减少由时空变化引起的分布差异。具体地说,为了扩展用于利用辅助数据的主要视频任务的框架,本文将主要任务(即动作分割)重新设计为无监督域自适应(DA)问题,旨在无目标标签的条件下,减少源域和目标域之间的差异,如图1所示。

图1:利用 SSTDA做动作分割的流程图

2. 技术方法

2.1. 基准模型

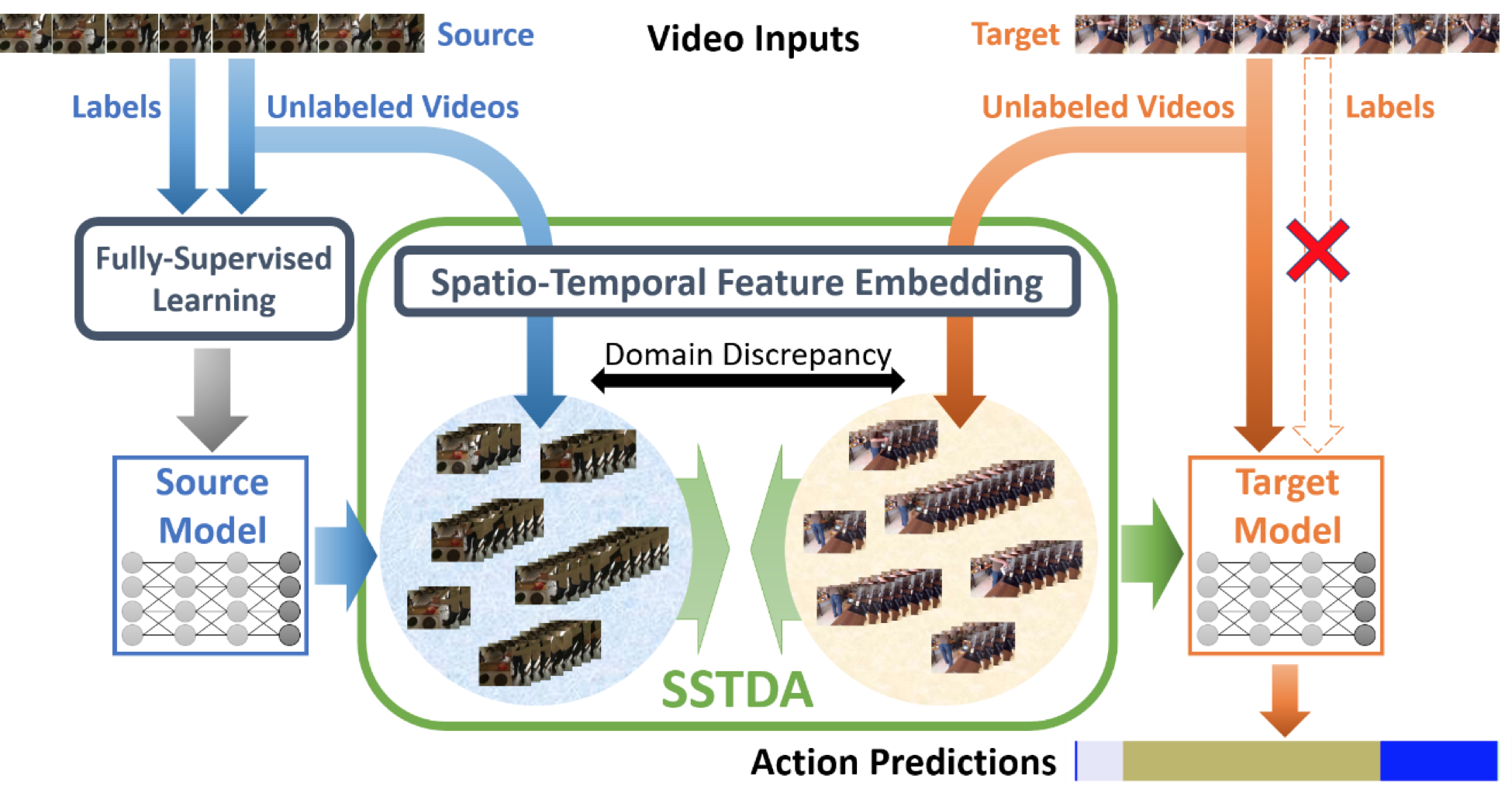

本文工作建立在当前最新的动作分割模型“多阶段时间卷积网络(MS-TCN)”的基础上。对于每个阶段,单阶段TCN(SS-TCN)应用多层TCN得出帧级特征,并使用全连接层做出相应的预测,如图2的左半部分所示。最后,堆叠多个SS-TCN以增强时间感受野,从而构建最终的基线模型MS-TCN,其中每个阶段取来自上一阶段的预测作为输入,并为下一阶段做出预测。

图2:基准模型以及与本文提出的SSTDA

2.2. 自我监督的时域适应(SSTDA)

MS-TCN在动作分割方面取得了不错的性能,但仍有很大的改进空间。一个主要的挑战是人类行为的时空变化问题,导致跨域的分布差异。例如,由于个性化的时空风格,不同的对象可能会完全不同地执行相同的动作。此外,收集带标签的数据以进行动作细分既具有挑战性又耗时。

受自我监督学习的最新进展启发,该过程学习可以无需外部监督(例如人工标签)就可以转移到主要目标任务的信息功能,本文提出了自我监督的时域适应(SSTDA),通过使用未标记的视频设计自我监督的辅助任务以减少跨域差异。

近来,基于对抗的域自适应(DA)方法显示了在使用具有对抗训练能力的域鉴别器解决跨域图像问题方面的进展,其中域识别可被视为自我监督的辅助任务,因为域标签是自标注的。然而,由于时间信息被忽略,直接将基于图像的DA用于视频任务不会产生好的效果。因此,问题就变成:「本文应该如何设计自我监督的辅助任务来帮助跨域操作细分?」更具体地说,答案应同时解决跨域和动作分割问题。

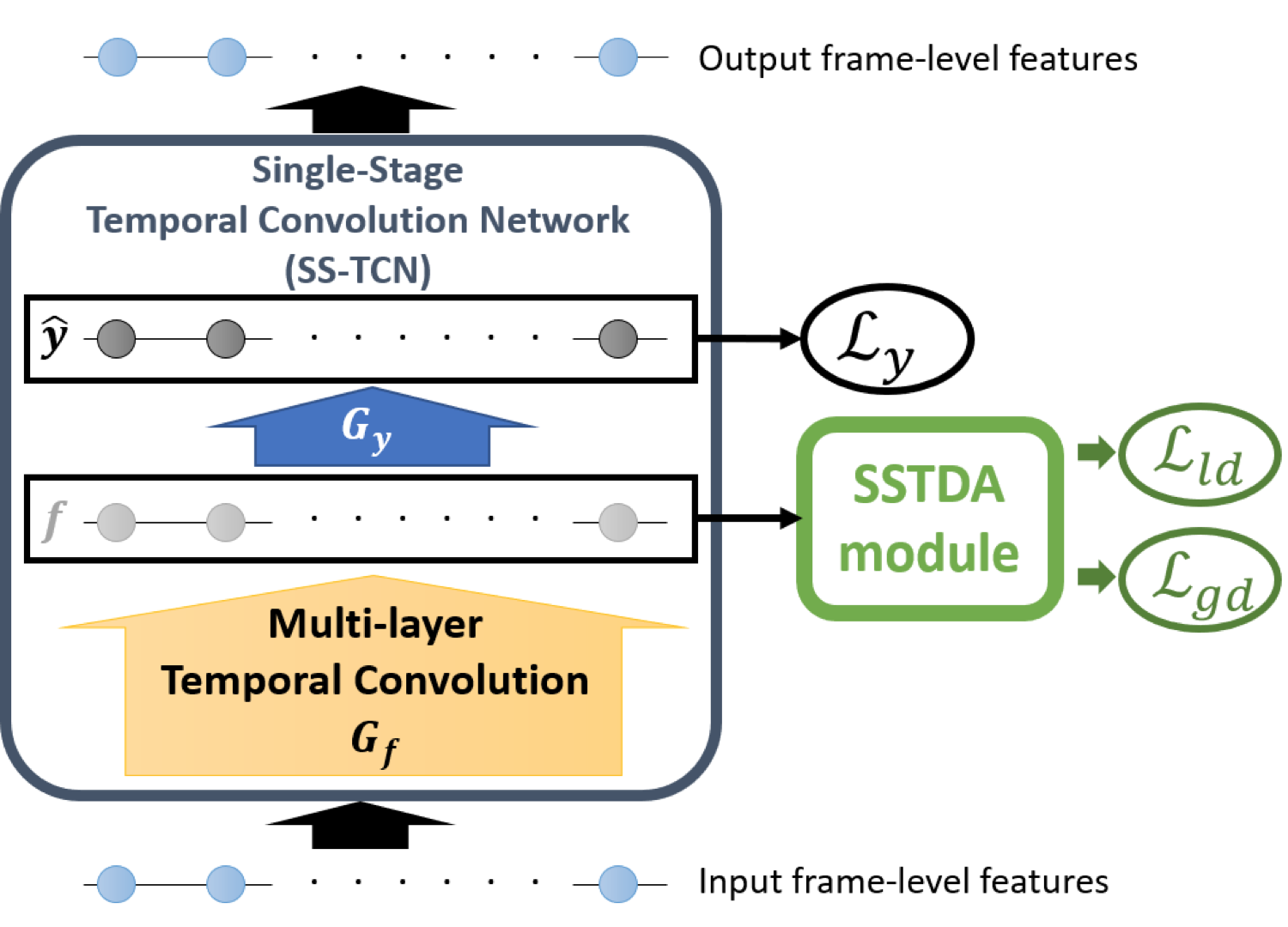

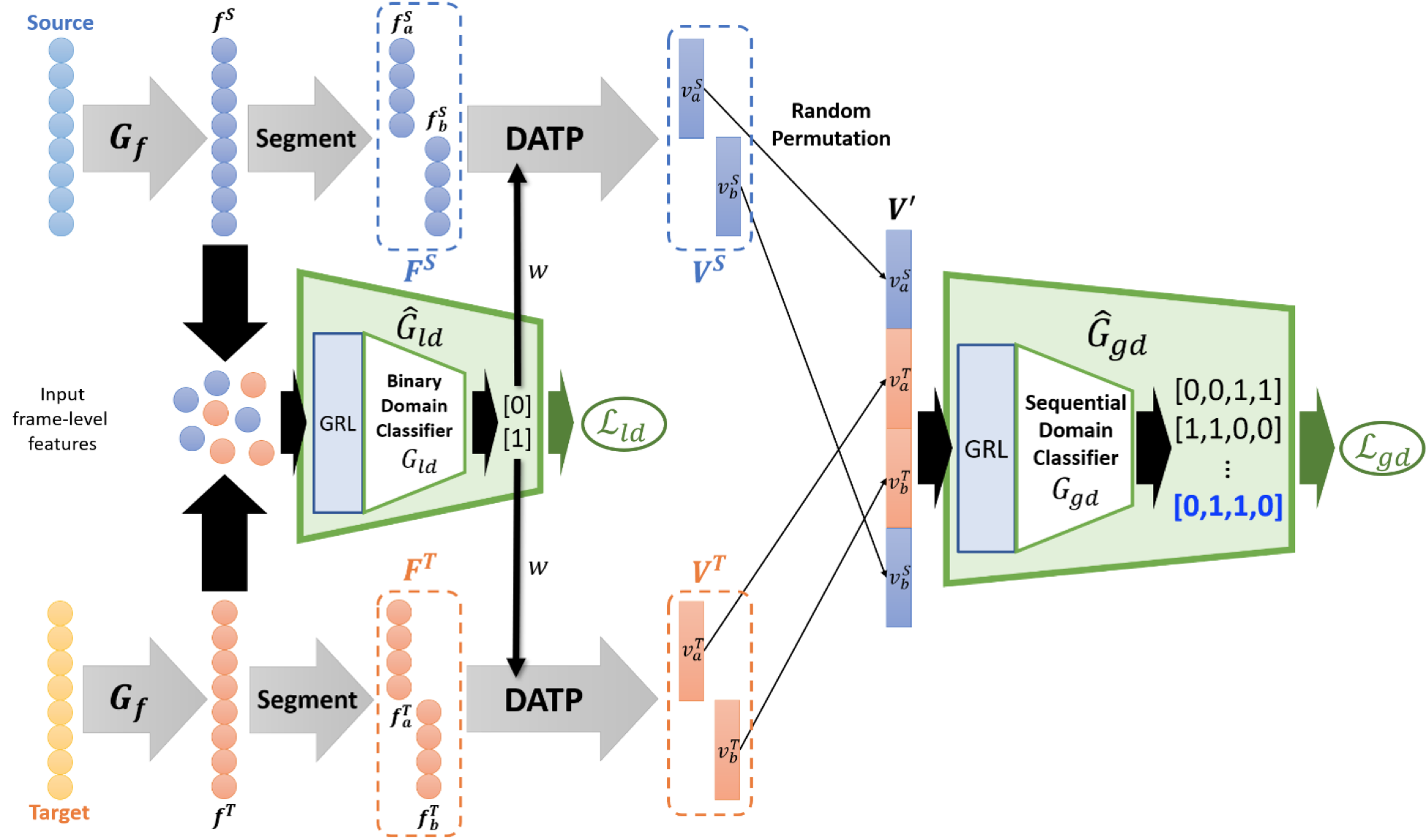

为了解决这个问题,本文首先应用辅助任务二进制域预测(Binary Domain Prediction)来预测每帧的域,在这些帧中嵌入了帧特征并具有局部时间动态特性,旨在解决局部尺度视频的跨域问题。然后,提出一种新颖的辅助任务顺序域预测(Sequential Domain Prediction),以对未修剪视频的域进行时间分割,其中视频级特征嵌入了全局时间动态,旨在全面解决上述问题。最后,通过联合应用这两个辅助任务在局部和全局范围内实现SSTDA,如图3所示。

在实现上,由于有效视频DA的关键是同时对齐和学习时间动态,而不是分开两个过程,因此本文将SSTDA模块集成(Integration)到多个阶段,而不仅仅是最后一个阶段,其中单阶段集成如图2所示。

图3:SSTDA中的两个自我监督的辅助任务:1)二进制域预测:区分单帧,2)顺序域预测:预测视频的域序列。这两个任务分别对局部和全局SSTDA有所贡献

2.2.1. 局部SSTDA

动作分割基于对时空信息进行编码的帧级特征表示,然后利用多帧中的信息来预测每帧的动作。因此,本文首先通过辅助任务二进制域预测(图3左)学习域不变的帧特征。对于单个阶段,本文分别将源域和目标域的帧特征提供给其他浅层二进制域分类器,以区分特征来自哪个域。来自先前层的时间卷积将信息从多个相邻帧编码到帧级特征,因此这些特征有助于每帧的二进制域预测。通过使用梯度反转层(Gradient Reversal Layer)进行对抗训练,可以在反向传播过程中反转梯度符号,从而逐渐对齐两个域之间的特征分布。

2.2.2全局SSTDA

尽管使用上下文和相邻帧的关系来学习帧级特征,但时间感受野仍然有限,无法表示完整的视频,且不能完全解决未修剪的长视频的时空变化。因此,除了针对帧级特征的二进制域预测外,本文还提出了针对视频级特征的另一项自监督辅助任务:顺序域预测,以预测视频片段的域序列,如图3右侧所示。此任务是一个时间域分割问题,旨在为包含来自源域和目标域的混洗(shuffle)视频剪辑的长视频预测域的正确排列。由于此目标与跨域和动作分割问题均相关,因此顺序域预测可以有效地使本文的主要任务受益。

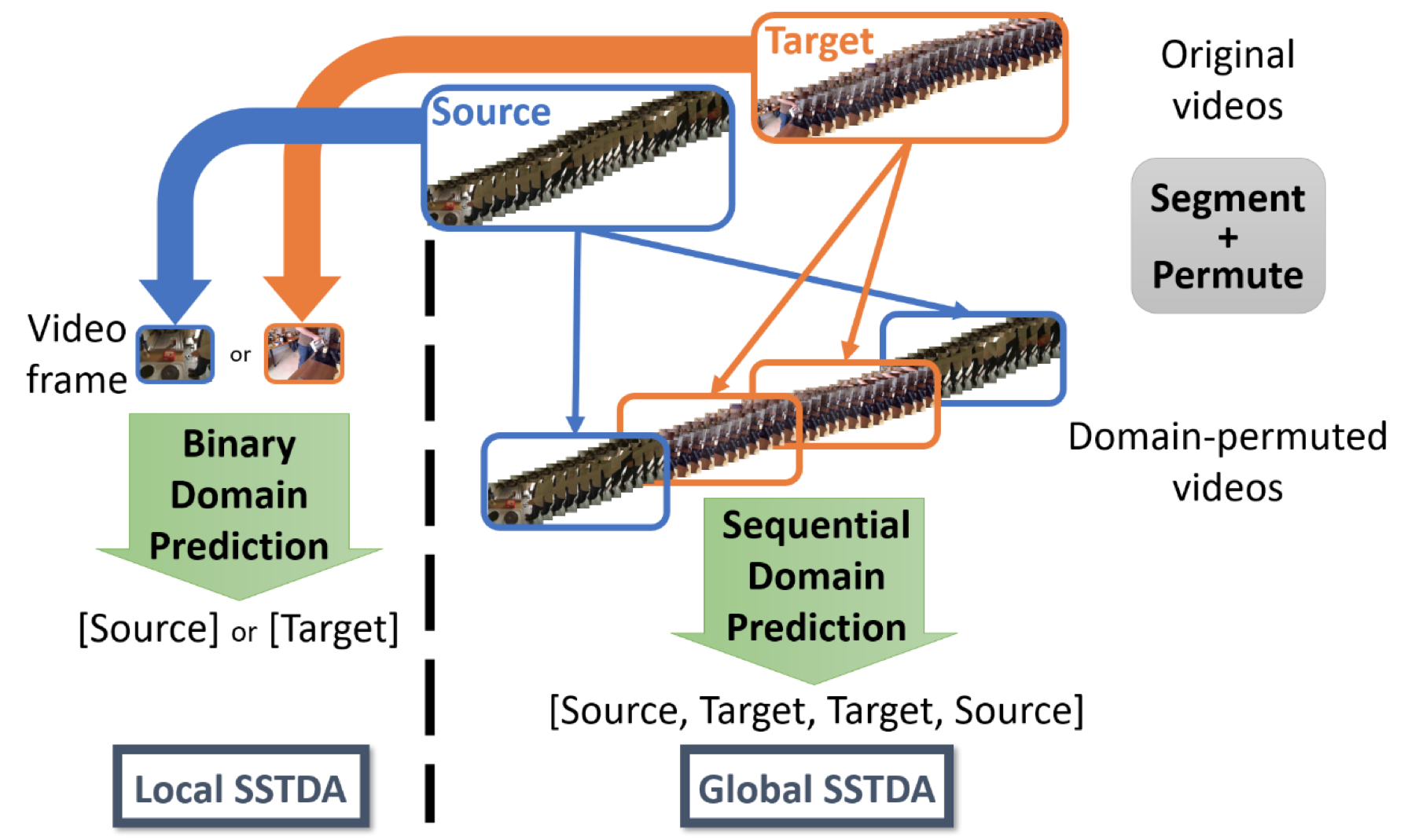

获得视频级功能的最直接方法是使用时间池化(pooling)聚合帧级特征。但是,并非所有帧级功能都对整个域差异做出了相同的贡献,因此本文将较大的注意力权重分配给具有较大域差异的特征,以便本文可以将更多精力放在对齐这些特征上。

最后,将所参与的帧级特征与时间池聚合在一起以生成视频级特征。本文称此方法为域注意时间池化(DATP)。通过分别将DATP分别应用于源段和目标段,可以得到一组段级(segment-level)特征。然后,将所有特征混洗(shuffling),组合为一个特征,以表示一个长且未修剪的视频,该视频包含来自两个域的视频片段,并且顺序随机。最后用顺序域分类器以预测视频片段的域排列。通过GRL的对抗训练,顺序域预测还有助于对齐两个域之间的特征分布。本文方法可以预测跨域视频的时间排列,如图4中的双分支流程图所示,并与二进制域预测相集成,以有效解决跨域和动作分割问题。

图4:本文提出的自我监督的时域适应(SSTDA)的流程图

3. 实验结果

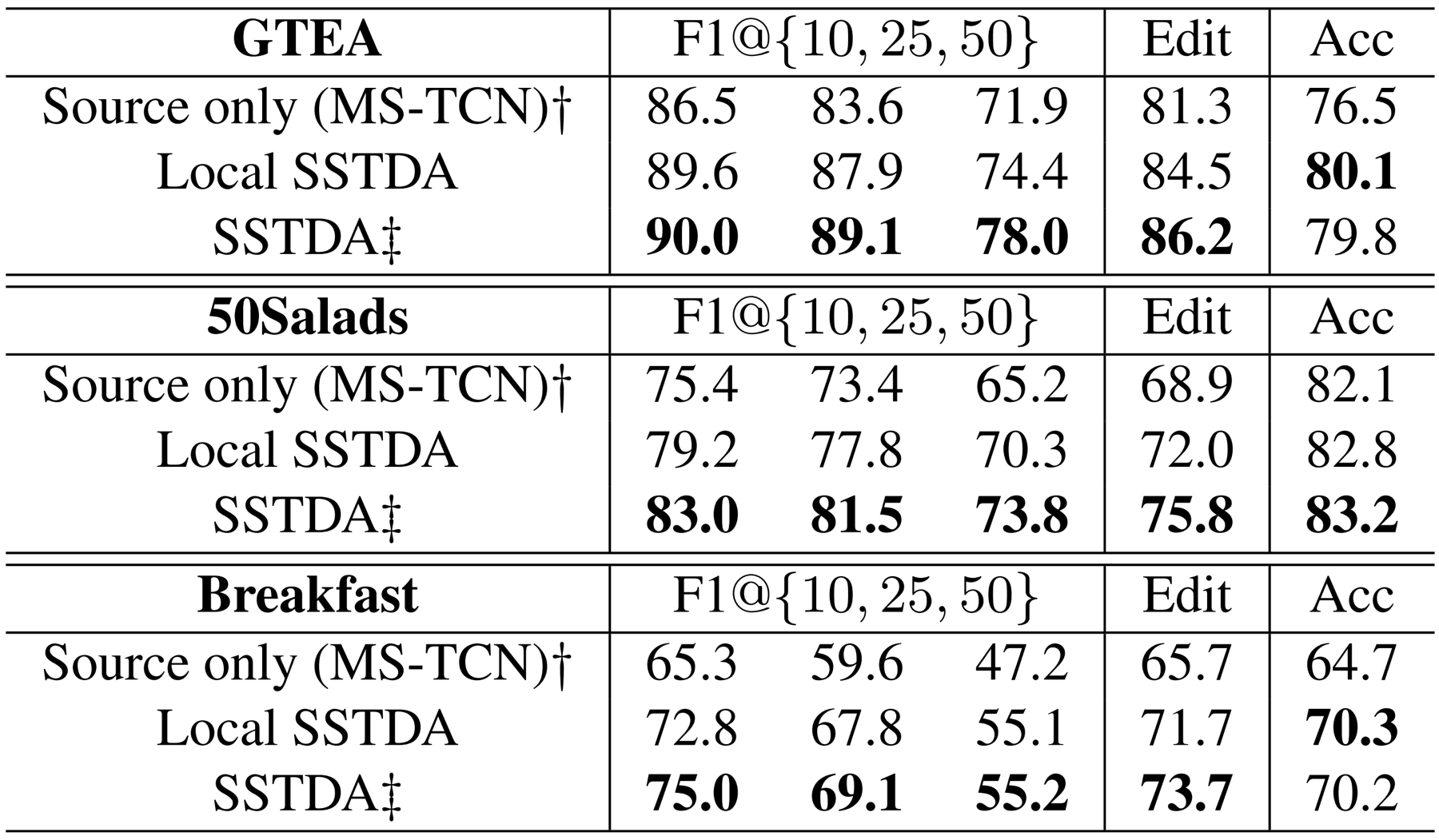

为了验证所提出的方法在减少动作分割时空差异方面的有效性,本文选择了三个具有挑战性的数据集:GTEA、50Salads和Breakfast。它们将训练集和验证集按不同的人分开以作交叉验证的评估,由于时空变化,导致出现大的域移位问题。因此,本文将训练集视为源域,将验证集视为目标域,采用标准的无监督DA设定。

本文首先研究了该方法在利用未标记的目标视频进行动作分割方面的有效性。本文选择MS-TCN作为骨干模型。 “Source only”是指仅使用带有来源标签的视频来训练模型。然后将本文方法与具有相同设定的其他方法进行比较。最后,将本文方法与所有三个数据集上的最新动作细分方法进行了比较。

首先,通过将辅助任务二进制域预测与基线模型集成来研究局部SSTDA的性能。如表1所示,所有数据集的结果均得到了显著改善。尽管局部SSTDA主要在帧级功能上起作用,但仍使用邻居帧中的上下文对时间信息进行编码,从而有助于解决跨域视频的变化问题。尽管局部SSTDA有所改进,但将DA集成到帧级功能中仍不能完全解决长视频时空变化的问题。因此,本文针对长视频集成了本文提出的顺序域预测。通过与两个辅助任务联合训练,SSTDA可以将嵌入局部和全局时间动态的跨域特征空间联合对齐,并以显著的优势进一步改进局部SSTDA。详情可参照表1。

表1:本文的方法在三个标准数据集上的实验结果。

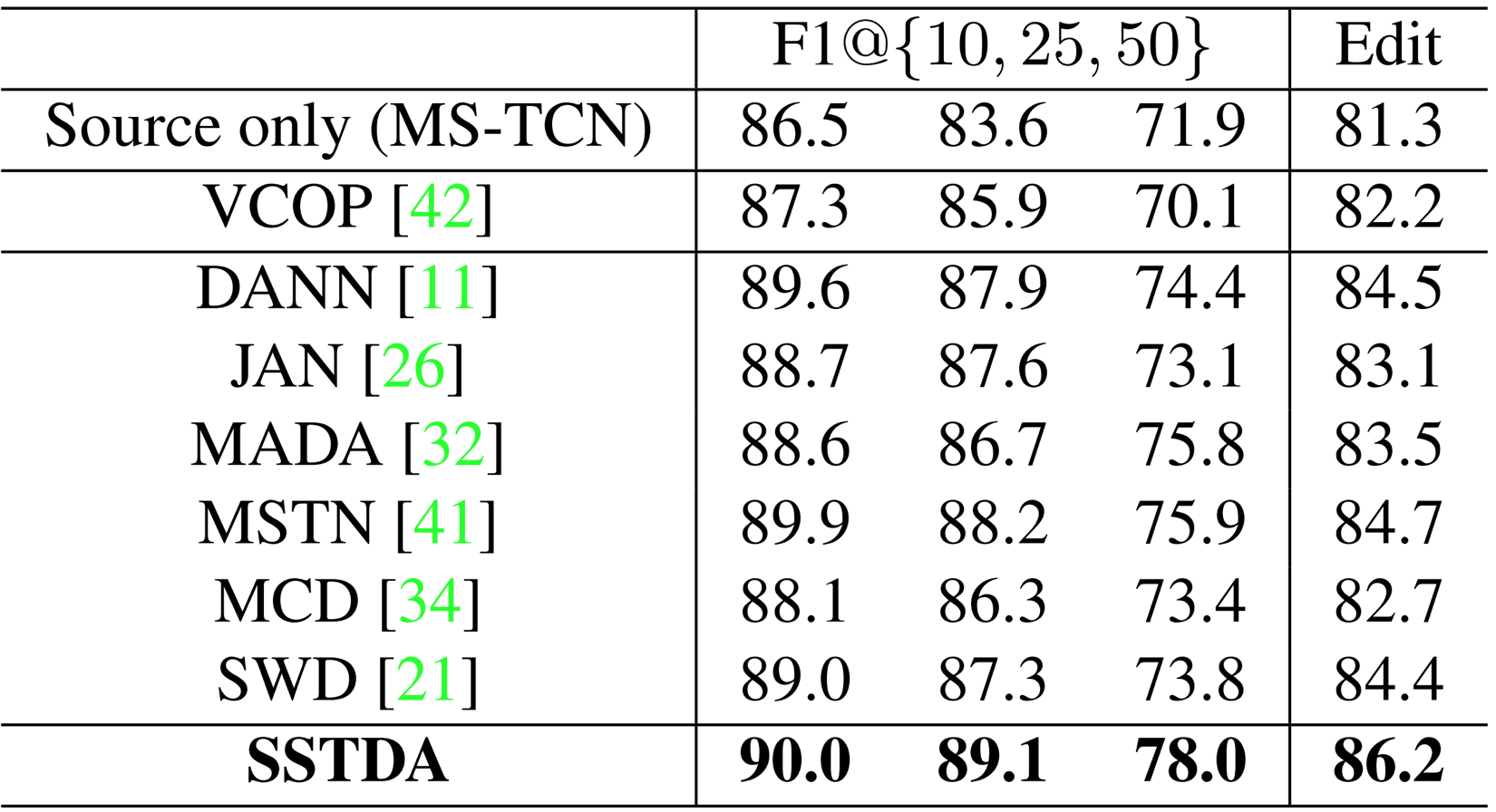

本文还将SSTDA与其他DA方法进行比较。为了公平比较,本文将所有这些方法与相同的基线模型MS-TCN集成在一起。表2显示,在考虑时间关系的两个指标方面,SSTDA优于所有其他DA方法。本文推测主要原因是所有这些DA方法都是针对跨域图像问题而设计的。尽管它们与对局部时域动态进行编码的帧级功能集成在一起,但有限的时域感受野阻止了它们完全解决时域差异。

相反,将SSTDA中的顺序域预测直接应用于整个视频,有助于全局对齐嵌入较长时间动态的跨域特征空间,从而可以更有效地减少时空变化。本文还与最新的基于视频的自我监督学习方法进行了比较,该方法也可以从未标记的目标视频中学习时间动态机制。但是,该性能比其他DA方法还要差,这意味着单个域内时间上混洗不能改善跨域动作分割。

表2:与其他DA方法的比较(在GTEA上), 所有方法都与同一基线模型MS-TCN集成在一起

4. 结论

为了解决跨域视频时空变化的问题,百度提出了自我监督的时域自适应(SSTDA),通过两个自我监督的辅助任务,域和顺序域预测,将嵌入局部和全局时间动态的跨域特征空间联合对齐以更好地实现视频动作分割实验结果表明,SSTDA通过更有效地对齐时间动态,优于其他DA方法。在三个公开数据集上的实验表明了本文方法的有效性。

主要参考文献:

[1] Yazan Abu Farha and Jurgen Gall. Ms-tcn: Multi-stage temporal convolutional network for action segmentation. In

IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2019.

[2] Dejing Xu, Jun Xiao, Zhou Zhao, Jian Shao, Di Xie, and Yueting Zhuang. Self-supervised spatiotemporal learning via video clip order prediction. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2019.

[3] Mingsheng Long, Han Zhu, Jianmin Wang, and Michael I Jordan. Deep transfer learning with joint adaptation networks. In International Conference on Machine Learning (ICML), 2017.

推荐专栏文章

- 百度Apollo智能交通底座技术再升级,4项世界冠军霸榜CVPR2020顶级赛事!

- 百度轻量深度学习推理引擎Paddle Lite,极致的 ARM CPU 性能优化

- PaddleLite底层在backend上的kernel选择策略

更多嵌入式AI算法部署等请关注极术嵌入式AI专栏。