本文最初发表于 2015年9月9日

2013年10月,我在杭州参加阿里云开发者大会(AWDC)时参观了阿里与华通云数据(华数)合作的转塘数据中心,当时双方合作的千岛湖数据中心已开始建设。

2015年9月8日,也就是昨天,阿里巴巴千岛湖数据中心启用仪式在千岛湖畔的珍珠半岛举行。仪式归仪式,千岛湖数据中心已投产三个月以上(数据中心一层大堂显示屏上的安全生产时间超过3100小时,算来应为四个月有余),有些运营商合作伙伴在大阅兵之前就参观过了。

远眺阿里巴巴千岛湖数据中心,华数的标志仍很醒目(拍摄:张广彬)

但是我和参加仪式的很多“外地人”一样,还没有来过啊!况且,阿里数据中心团队的精英尽出,曲海峰、陈炎昌、韩玉、刘水旺等新老朋友也不同程度的参与着阿里张北数据中心的建设,小叙一番,获益匪浅。

阿里巴巴为此次启用仪式发布了官方新闻,“阿里技术保障”公众号也第一时间放出了一组数据中心的美图。但是,对于希望了解所谓“细节”的人来说,官方新闻通常是引发疑问,而非答疑解惑的。以下,将顺着官方材料的脉络,通过我在现场的见闻加以解读,当然也少不了随兴的发挥和一些“小道消息”,仅供大家参考,本人和文中提到及未提到的任何人均不对此负责……

注:引号内的段落系从官方新闻稿中引用,加粗的部分为强调重点。根据技术表达的需要,引用时对原文的部分段落进行了重组,有些为表达完整而不便删去的宣传用语,不代表本人观点,请大家自动忽略。

“深挖”数据中心

“9月8日,阿里云位于浙江千岛湖的数据中心正式启用,因地制宜采用湖水制冷。得益于千岛湖地区年平均气温17度,其常年恒定的深层湖水水温,足以让数据中心90%的时间都不依赖湖水之外的制冷能源,制冷能耗节省超过8成。”

没错,“湖水制冷”是千岛湖数据中心的核心卖点。“深层湖水”有多深呢?作为千岛湖数据中心的建设方,华数投入的资源主要是管道建设权,原定管道深度为25米左右,阿里出资下移至35米以下。据称,每深挖一米,成本要增加百万元,所以阿里在这上面的投资就达千万元。

下移10米的收益是水温下降2度,按照华数官网上的说法,“千岛湖数据中心利用水源热泵空调系统实现制冷,采用千岛湖35米以下恒温(10.82℃)的冷水进行机房制冷,”而参观数据中心时,解说人员的说法是进水13~17℃,回水约17~20℃,视气候与环温而定。

为了确定合适的管道深度,阿里方面聘请了浙江省的潜水专家,从2013年三四月份开始,进行了约8个月的水下勘测,到10月份数据中心土建开始时还在同步进行。

我们知道,千岛湖实际上是新安江水库,最深处达百余米,水温可以低至4度左右。但是,取冷却水不是越低越好,除了前面所说的挖掘成本,湖底的杂质也会比较多,将大大加重过滤环节的负担。

“千岛湖数据中心……设计年平均PUE(能源效率指标)低于1.3,最低时PUE1.17,比普通数据中心全年节电约数千万度,减少碳排放量一万多吨标煤,也是目前国内亚热带最节能的数据中心之一。除了节能,千岛湖数据中心的另一大特色是节水,设计年平均WUE(水分利用率)可达到0.197,打破了此前由Facebook俄勒冈州数据中心创下的WUE0.28的最低纪录(据公开报道)。

深层湖水通过完全密闭的管道流经数据中心,帮助服务器降温,再流经2.5公里的青溪新城中轴溪,作为城市景观呈现,自然冷却后最终洁净地回到千岛湖。”

昨天中午参观时,大堂显示屏上的PUE指标为1.27x,略低于1.28。我们知道,百度在北京、腾讯在天津的数据中心,PUE指标也不逊色,但北京和天津地处北方,自然(空气)冷却时间要长得多。千岛湖数据中心“深挖”水的潜力,使得自然(水)冷却时间可占全年的90%,红果果的开了“外挂”,只有在少数气温很高的天气里,才需要切换到蓄冷罐。

Google很早就在数据中心里尝试了海水冷却,但是要经过换热器,以避免海水的腐蚀作用。千岛湖数据中心如果增加换热器这个中间环节,冷却水温会上升两度,等于抵消了深挖的效果。为了将PUE从1.33压低至1.28,阿里采用了直接引入湖水冷却的方法,以过滤和沉降对抗水中的杂质。以防万一,冷却水系统采用全备的方式,并能承受数据中心生命周期内更换一次的潜在开销。

数据中心楼前,2台相邻的湖水处理器之1(拍摄:张广彬)

同时,WUE的运行指标显示为0,即没有水分的消耗。这不难理解,在完全采用自然水冷却的时候,湖水在数据中心的封闭管道内流动,理论上不会有蒸发的损失。至于流经中轴溪时,暴露在外且温度略高的回水,肯定会有蒸发,但不计入数据中心的WUE。一定程度上,采用自然风冷的数据中心,向外界排放的空气温度也会略高,对环境的影响是不可避免的。

不过,千岛湖毕竟不是Oregon州Prineville的沙漠(前面官方新闻稿中拿来对比WUE的Facebook第一个数据中心所在地),其自然景观和生态环境需要保护(谈到环保,似乎怎么说都容易政治不正确),水温的上升多少会带来不利影响。另外,朋友圈中有人质疑,每月的柴油发电机组演习,也会对环境造成污染。

千岛湖数据中心能容纳的服务器超过5万台(下文会有分析),总供电能力可达30MW(兆瓦)。一路市电、一路高压直流,外部电力供应中断时,可以用柴油发电机供电,两个30吨的油罐可以维持数据中心运行8小时。千岛湖数据中心采用卡特彼勒(Caterpillar,CAT)的柴油发电机(不是挖掘机:P),符合欧Ⅳ标准,也会采用尿素等手段处理尾气,满足排放要求。据称,发电机组演习虽然每月都有,但柴油机带油演练的频率相对较低,可能会以三个月或半年为周期,以控制排放。

“该数据中心将满足阿里巴巴云计算和大数据的应用需求,由浙江华通云建设的千岛湖数据中心设计和建设等级接近最高Tier4等级,是目前浙江省内单体建设规模最大的数据中心。”

据公众号“阿里技术保障”的文章描述,千岛湖数据中心“占地面积3173.75㎡”,有朋友特意问我是不是写错了(虽然不是我写的)。在现场一看就清楚了——这是一栋11层的建筑,以占地面积3000多平米来算,华数官网上写的“机房面积26000平米”并不难达到。

在大型数据中心建筑里,11层还是蛮高的(拍摄:张广彬)

印象中,地处杭州市郊的转塘数据中心,也不过是六层的建筑,外观上还是偏“横向扩展”,不像千岛湖数据中心这般“纵向扩展”。主要原因还是容积率的要求,因为千岛湖是水库围出来的,所以对土地利用的要求较高。

“千岛湖数据中心还广泛采用了光伏太阳能、水力发电等可再生能源,服务器余热也被回收用作办公区采暖。”

楼顶的光伏太阳能板有照片(为何平置?),我没能上去观摩。服务器余热回收,在需要暖气的季节无疑很有诱惑力,但平时呢?看来还是偏概念一些。

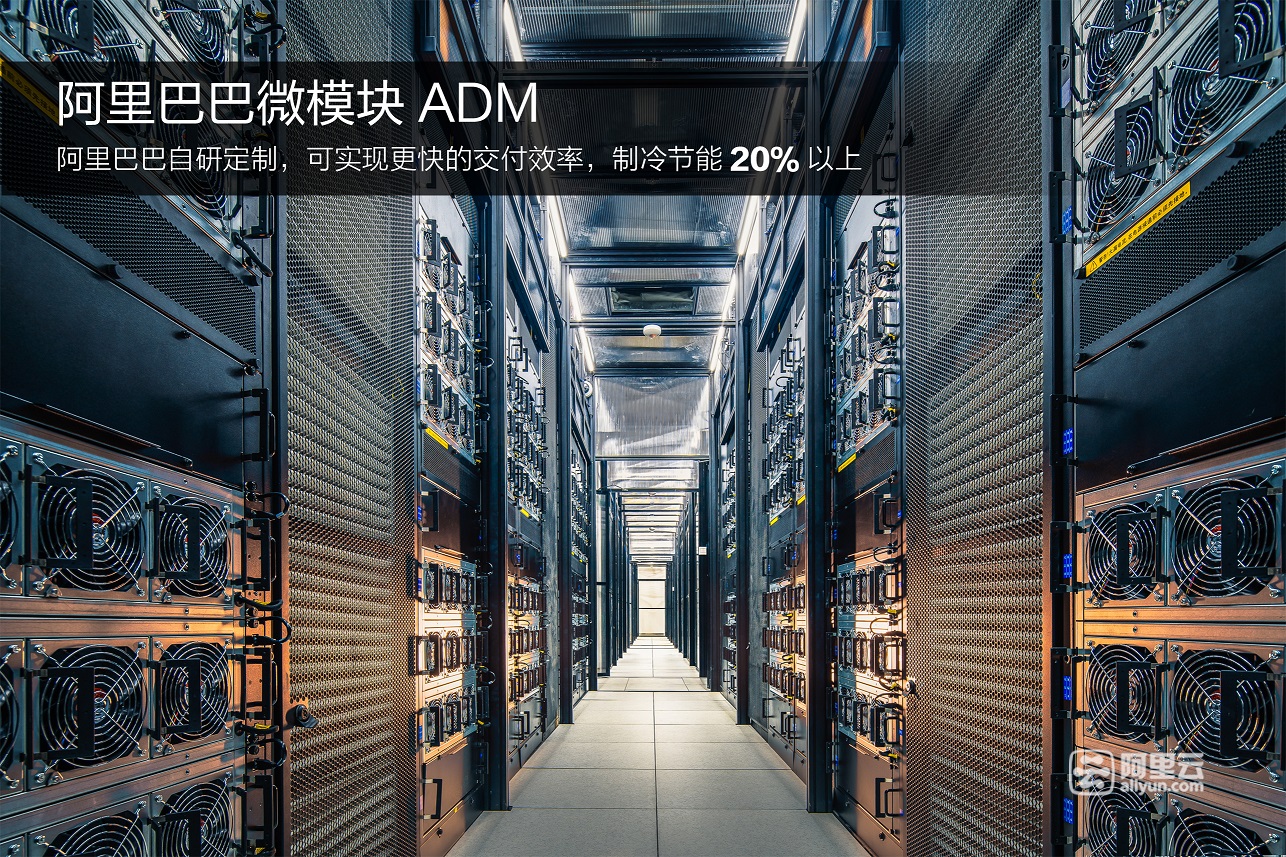

整机柜与微模块

“千岛湖数据中心采用了一系列阿里巴巴自主研发的技术和产品,如数据中心微模块、整机柜服务器、PCIe固态硬盘等。”

微模块和整机柜,我亲眼所见的部分相对较多,就不对照着新闻稿解读了,尽可能的用图说话——进数据中心之前,手机的前后摄像头和闪光灯都被工作人员贴住,只能以官方供图为主,辅以我平时搜集的存货。

数据中心微模块采用阿里的整机柜服务器(AliRack),新闻稿中说“千岛湖数据中心采用了最新的2.0版本”,根据我在7月底召开的2015年可信云服务大会上的观察,在具体节点设计等方面比一年前的AliRack 2.0有所改进,总体上还都是符合天蝎2.0标准的产品。

数据中心微模块热通道内的照片,官方提供,美得有点儿不太真实,但却符合实际情况——每个整机柜有6行风扇,天蝎2.0规格每行风扇(3个140×38mm并排)对应4U高度,也就是最多可以放置24个1U(全宽)节点

目光所及的整机柜,服务器节点被中间的供电框分为上下两部分,上面11个(天蝎的节点目前都是1U高度),下面我看着也是11个,但后来阿里的同学纠正说是12个。也就是说,每机柜23个1U的计算与存储均衡型节点,这应该是受每机柜8KW(千瓦)供电能力的限制。如果再增加服务器,会对地板承重、供电容量、散热能力等构成全面的挑战,这个突破要看在建中的张北数据中心啦。

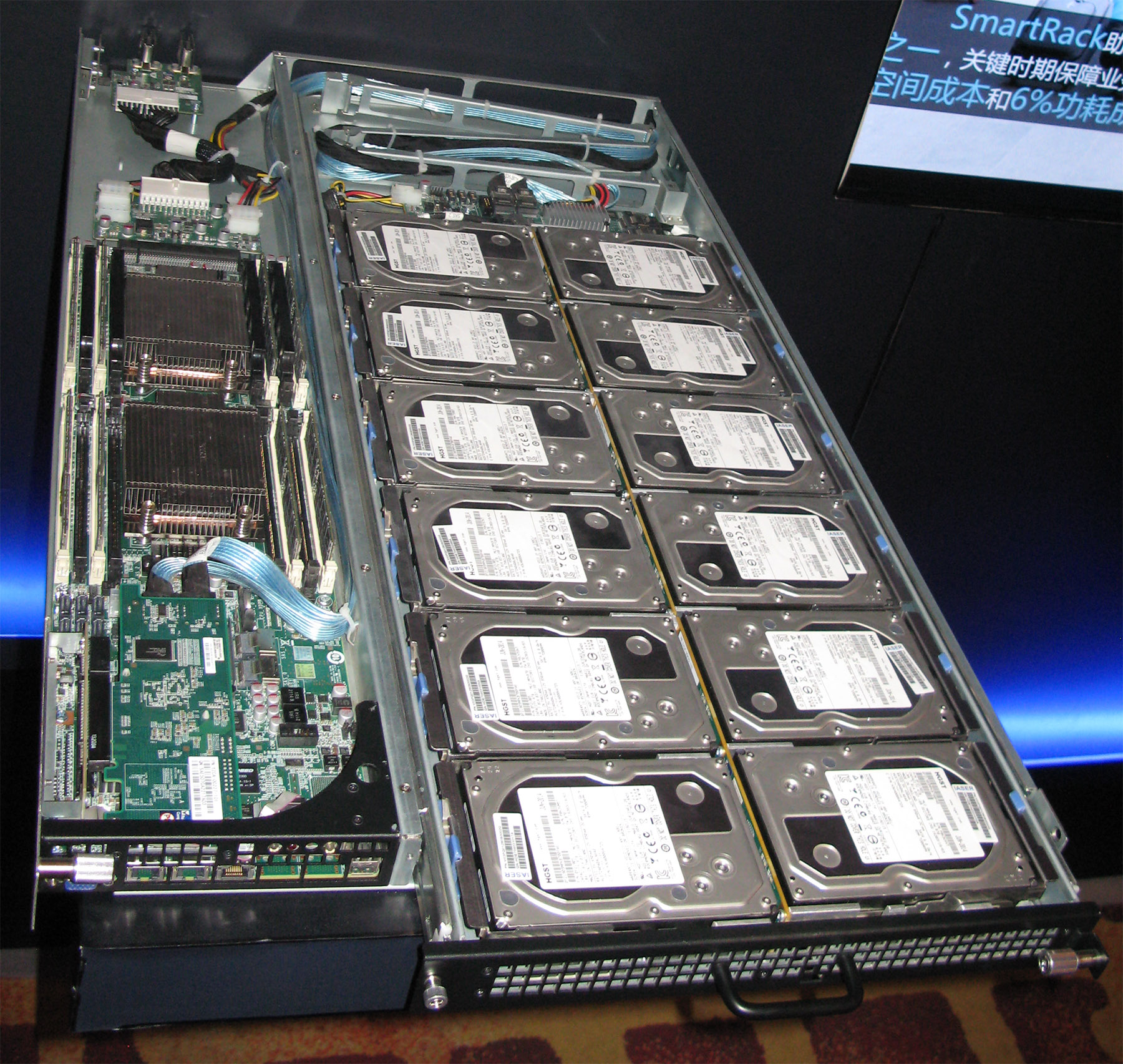

2015年展出的AliRack(局部),下面是集中PSU的供电框(实际位于机柜中部),上面4个一样的1U节点为计算存储均衡型,右侧的硬盘可单独抽出维护。当时缺乏远见,没有整体拉出来,拍个合影(拍摄:张广彬)

与常见的天蝎整机柜不同,交换机没有安装于机柜内部(严格说来,不算ToR),而是安装于机柜上方(离地)接近3米的高度。这样做的好处是交换机的配置相对独立于机柜(毕竟机柜没有装满),加入一个机柜不一定会引发网络变更,可以简化运维。但从长远来说,以整机柜为单位增减,还是发展方向。(关于天蝎整机柜的详细介绍,可参见我之前的文章)

AliRack用的计算存储均衡型节点,1U高度,左侧为双路至强E5系列CPU及内存,右侧三分之二宽度内塞满等同2U服务器前面板容量的12个3.5英寸硬盘,并可单独拉出维护,体现了天蝎2.0整机柜21英寸内宽和深度挖潜的效果(拍摄:张广彬)

服务器普遍采用万兆接入,使用连接距离更长、线缆更细而软(便于布线,重量轻)且保留了DAC(Direct Attach Cable,铜芯直连线)低成本优点的AOC(Active Optical Cable,有源光纤)。有小道消息称,阿里近几个季度招标采购AOC线缆数以十万计,不知有多少是为张北数据中心准备的。

AliRack前端网络接入特写,右侧较粗的红缆是千兆铜线接管理口,左侧较细的橙缆是万兆AOC(数据线)

每个数据中心微模块包括16个整机柜,每两个整机柜之间装有行间空调。与腾讯微模块数据中心不同,阿里的数据中心微模块采用热通道封闭的设计,这也是Google、Facebook、百度等国内外互联网公司普遍采用的方式——如果不局限于“微模块”概念的话。具体优劣,容后再议。

整机柜在千岛湖数据中心所占比例不高,基本只在11层的部分包间。其他楼层仍大量采用2U规格的传统机架式服务器,每个机柜约2.5米高(52U),安装22台(2U)服务器——惊鸿一瞥间,看到的型号有联想ThinkServer RD640和惠普ProLiant DL380e,都是前面板配满12个3.5英寸硬盘的2U机型,从硬盘和CPU数量来看,与1U的计算存储均衡型天蝎2.0服务器节点相当,也可看出天蝎整机柜在密度上的优势(放不满的话,实际效果还是要打折扣)。换言之,单台1U天蝎2.0服务器节点与2U传统机架式服务器,功耗上也是差不多的,所以,不论是否整机柜服务器,每个机柜的服务器数量都在22~23台,显然是受限于每机柜8KW的供电能力(可能还有承重)。

(非整机柜的)IT单元模块采用相对传统的冷通道封闭、地板下送风设计,服务器数量也可见其写实性。晚上睡不着的时候可以数数看,是不是22个2U……如果发现我“又”数错了,请告诉我

华数官网上宣称千岛湖数据中心“规划机柜3500个”,从我了解到的情况看,有2500个8KW的机柜,其他一些不到5KW的机柜留给存储等应用。因此,整个数据中心的容量不少于5.5万台(2500×22),考虑到PUE的因素,需要的供电容量约30MW,与宣传资料基本一致。

至于传说中的AliFlash,我没有见到实物,不知道是与哪家PCIe SSD供应商合作的产品。有知情者不妨大声说出来,我不能保证你的人身安全……