来源:腾讯技术工程微信号

作者:思颖

犀牛鸟中学创新科研营作为犀牛鸟中学科学人才培养计划的重要环节于近期开营,开营仪式邀请了哈佛大学、清华大学丘成桐教授、腾讯AI Lab及腾讯Robotics X实验室主任张正友博士以及来自清华大学、中国科学院大学、北京邮电大学的四位优秀学长,从对话大师、行业洞察、聚焦成长等方面做了信息学科的知识分享。

张正友博士分享的话题为《计算机视觉的三生三世》,计算机视觉可能是这次人工智能高潮中最成功的一个领域。张正友博士参与这个领域已近35年,见证了这个领域从一个小众的研究方向发展成已有多个独角兽公司并在很多实际场景落地开花的过程。在这个报告里,张正友博士将回顾计算机视觉的发展历程,同时也对今后的发展进行展望。

以下为张正友博士的演讲实录:

大家好!很高兴能和丘院士一起参加 犀牛鸟 中学创新科研营 的开营仪式。

我非常敬佩丘院士。丘院士不但是世界著名的数学家,他的文学和历史功底也是非常了得。我人文方面的修养就差一些。一方面是历史原因,一方面是个人原因。历史原因是我的少年是在文化大革命时代度过的,没有什么书可读。个人原因是,文革后百废待兴,觉得数理化很重要,那时候我们开玩笑说:学好数理化,走遍天下都不怕。对人文方面就有所疏忽。你们正处在非常好的时代,希望你们向丘院士学习,做到数理和人文并重,像丘院士那样为学与做人。

下面我简单介绍一下我的经历。我还是比较幸运的。文革后我基本上还是有个比较完整的初中和高中。1981年进入浙江大学,刚开始用的计算机是大型机,占一个房间,和计算机交互是用打孔的卡片。大学毕业后学了7个月的法语,就去法国留学了。参与研发了世界上第一个基于三维立体视觉的移动机器人。10年后去日本学术休假,研发了世界上第一个基于人工神经网络的人脸表情识别系统。然后去了美国西雅图,加入微软研究院,工作了整整20年。发明了被称为“张氏标定法”的摄像机平板标定法,在全世界,无论是在计算机视觉,还是机器人,还是自动驾驶,都被广泛采用。我还领导研发了远程呈现机器人,三维数字人等项目。

2018年初,我回到深圳,加入腾讯,创建了腾讯机器人实验室,同时领导腾讯AI Lab。

刚才我说了我是1986年去法国的。1986年也是我第一次参加国际会议,是在巴黎开的ICPR,世界模式识别大会。也在这次大会上,我碰到了复旦大学吴立德带队的中国代表团。吴老师做了一个大会报告,介绍了中国在模式识别方面的研究。他们准备申请1988年的ICPR在中国召开。

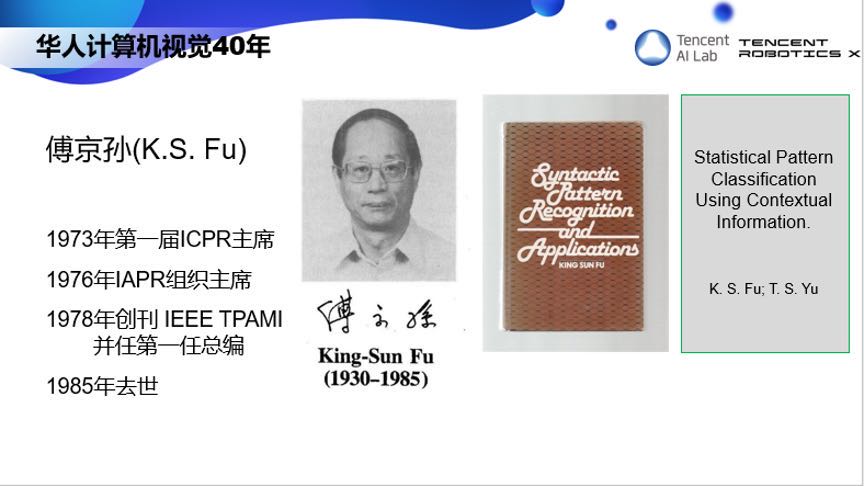

这里需要提到一个关键性的人物,那就是普渡大学的傅京孙教授,他是模式识别领域的鼻祖。他是1973年第一届ICPR的主席,1976年创建了IAPR,1978年创刊了IEEE TPAMI,并担任第一届主编。本来他是支持1988年ICPR在中国召开的,但不幸的是1985年他去世了,所以1988年的申请没有成功。如果1988年ICPR能在中国召开,也许中国在模式识别和计算机视觉的发展会更提前。当然历史没有如果。ICPR在中国召开需要等三十年,2018年在谭铁牛院士的领导下,ICPR才第一次在中国召开。

1986年还有个重要事件,我在法国的师兄马颂德回国了,创办了NLPR,国家模式识别重点实验室,吸引了一些国外回来的学者,邀请了很多国外的访问学者,国内计算机视觉的研究开始和国际接轨。当然马颂德是中国科技界重要人物,后来担任科技部副部长。1997年更是成立了中法联合实验室,有一半的研究人员都是法国过来的。

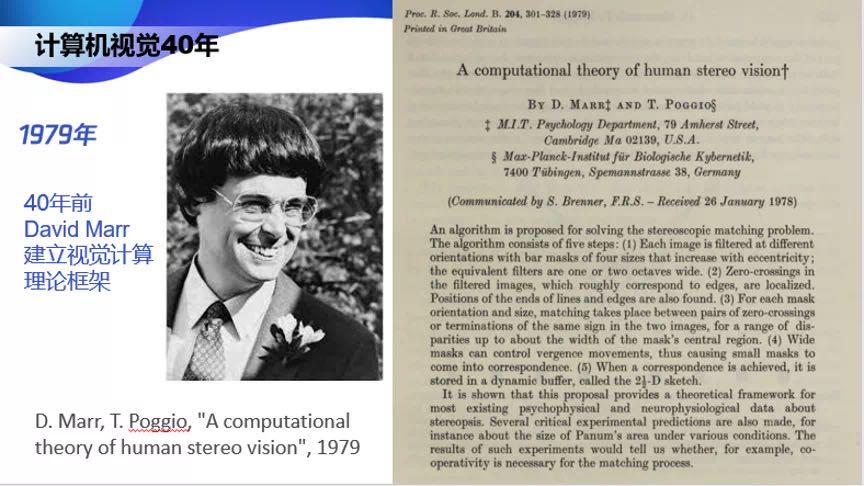

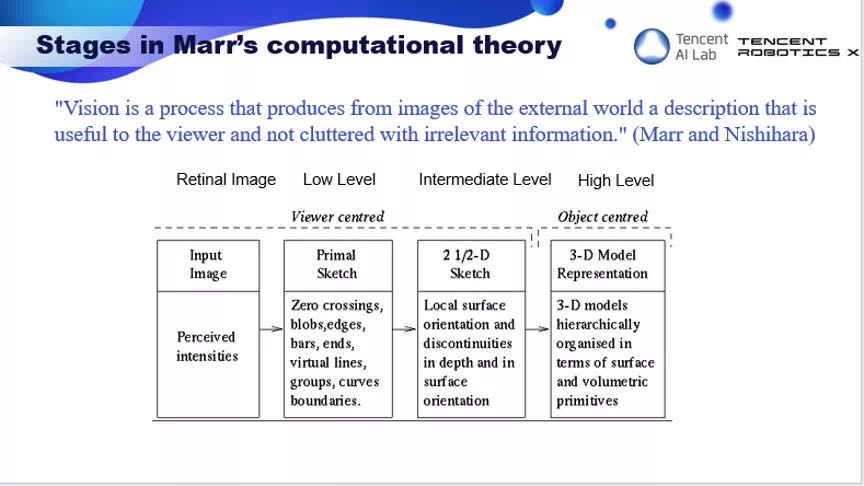

提到计算机视觉,离不开一个标志性人物,MIT 的教授 David Marr。1979 年,40年前,他从人类的立体视觉角度考虑,提出了视觉计算的理论框架。Marr 的理论框架有三个层次,从计算什么,到如何表达和计算,到硬件的实施。

具体到三维重建,Marr认为从图像要经过几个步骤,第一个步骤叫primal sketch,也就是图像处理,比如边缘提取。所以到八十年代中叶,计算机视觉的主要工作是图像处理。

最有名的工作可能是 1986 年 MIT 一个硕士生发表的 Canny 边缘检测算子,基本上解决了边缘提取的问题。如下图所示,左边是原始图像,右边是检测出的边缘。那时候还有一个比较有名的工作是华人科学家沈俊做的。他那时在法国波尔多大学。他比较了不同的算子。在有些图像方面他的算子要比Canny 检测器要好。所以到了八十年代中叶,当我留学法国的时候,图像处理已经做的差不多了。

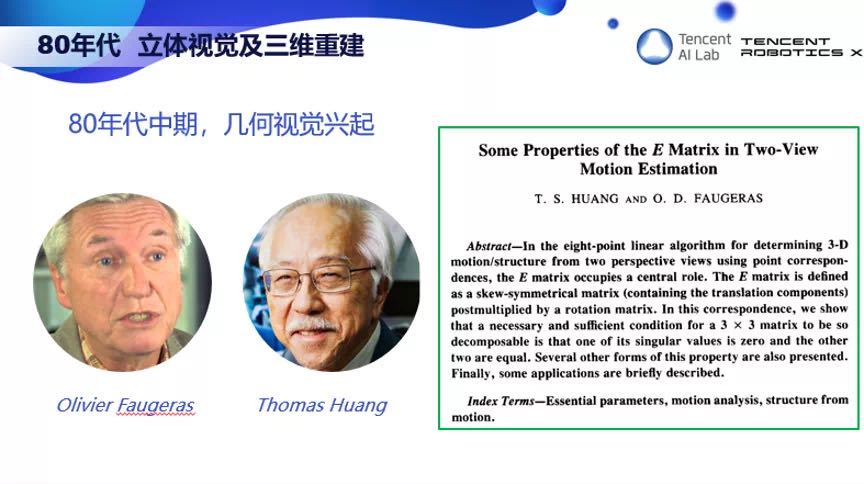

幸运的是,几何视觉刚开始兴起。有两位代表人物,一位是法国的 Olivier Faugeras,他是我的博士导师,另一位是美国的 Thomas Huang,我们叫他 Tom。他们是好朋友,还一起写过文章。我 1988 年就认识 Tom,他对我有非常大的帮助。他培养了 100 多位博士,包括不少活跃在中国学术界和工业界的计算机视觉专家,他对中国计算机视觉的贡献是非常巨大的。很遗憾,他今年4月份去世了。上周在全球人工智能和机器人峰会(GAIR)上,我们Tom的几个朋友和学生一起组织了一个专场,纪念Tom对计算机视觉的贡献。

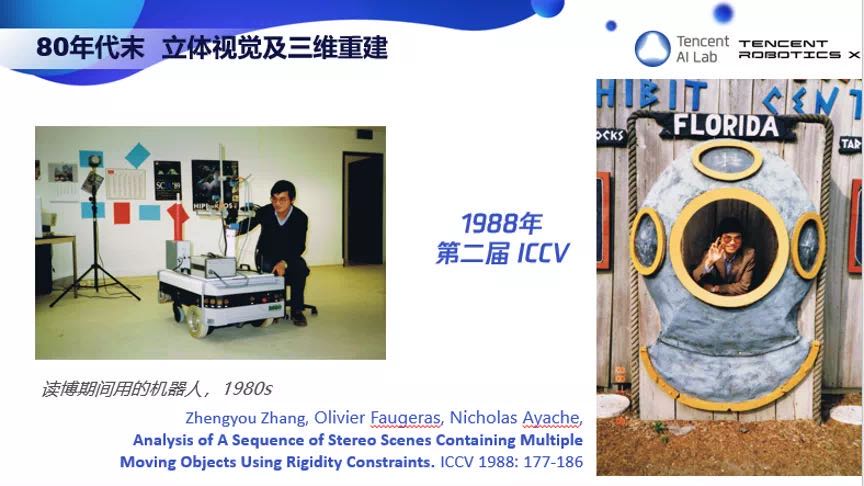

我很荣幸师从Olivier Faugeras,参与开发了世界上第一台用立体视觉导航的移动机器人。1988年我的第一个研究成果发表在第二届ICCV上。右边是在美国Florida开会的一张照片。那时候计算机视觉还没有红火,那届ICCV大概只有200个参会者,华人就更少了,大概只有我,权龙,还有Tom的学生翁巨扬。

博士期间围绕着三维动态场景分析做了不少工作,包括运动估计,数据不定性,鲁棒估计算法,运动分割,短序列匹配,长序列跟踪等。1992年我把这些工作整合成我的第一本书发表。

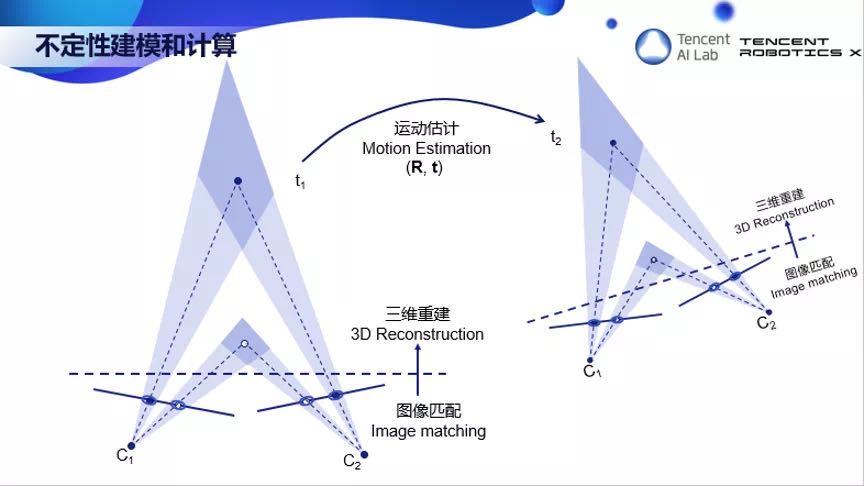

我想举一个例子,不定性的建模和计算。这个需要用到概率与统计,非常重要,但现在做视觉的人往往忽略了。这里下面两条线代表了两个图像平面。左边图像上一个白点对应右边图像上一个白点。每个图像点对应空间一条直线,两条直线相交就得到一个三维点,这就是三维重建。同样,左边图像的黑点对应右边图像的黑点,两线相交得到一个三维点。但是图像的点是检测出来的,是有噪声的。我们用椭圆来代表不定性,那么图像的一个点就不对应一条线了,而是一个椎体。两个椎体相交,就代表了三维重建的点的不定性。这里可以看到,近的点要比远的点精确。当我们用这些三维重建点的时候就需要考虑这些不定性。比如当机器人从一个地方移动到另一个地方,需要估计它的运动时就必须考虑数据的不定性。

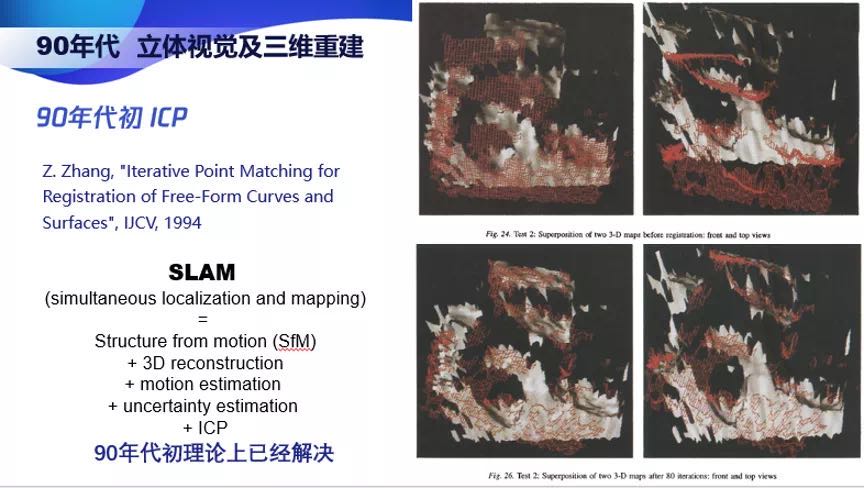

1992年我提出了ICP算法,通过迭代点的匹配来对齐曲线或曲面。这个算法也用在很多地方。我们现在经常听到的SLAM,它其实就是我们以前做的从运动中估计结构,三维重建,不定性估计,ICP。事实上,SLAM 在 90 年代初理论上已经解决了。

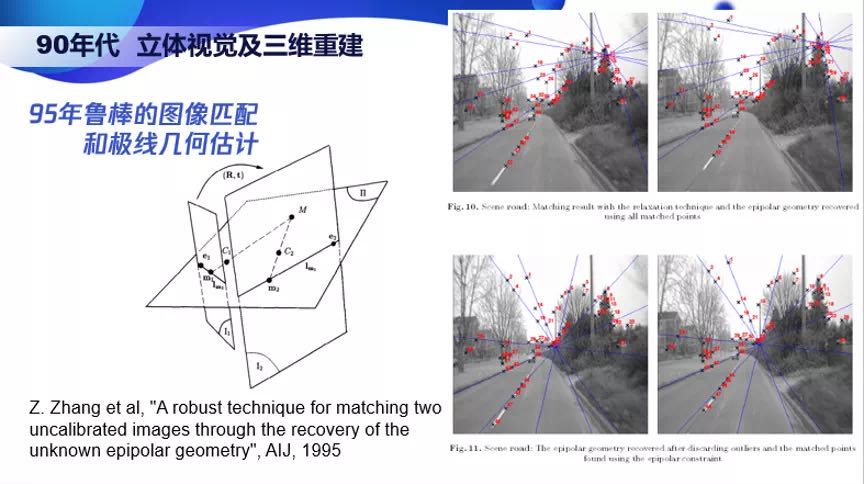

1995 年我提出了鲁棒的图像匹配和极线几何估计方法,同时把程序放到网上,大家都以此作为参照。这可能是世界上第一个,至少是之一,把计算机视觉的程序放到网上让别人用真实图像来测试的。所以这个算法那时候就成为计算机视觉的通用方法。不像现在有很多开源的代码,那时候根本就没有开源,所以所有的代码都是自己写的。

1998 年我提出了一个新的摄像机标定法,后来大家都称它为「张氏方法」,现在它已经在全世界的三维视觉、机器人、自动驾驶上普遍应用,也获得了IEEE Helmholtz 时间考验奖。

1998年我和马颂德对日益成熟的几何视觉做了总结,作为研究生教材由科学出版社出版。

1998年还发生了很多事情。一个是MSRA微软亚洲研究院的成立,一个是腾讯公司的成立。这两家看似无关的机构其实对中国的计算机视觉的发展,对整个人工智能的发展,起了不可估量的作用。MSRA给中国带来了国际先进的研究方法和思路,腾讯促进了中国互联网的发展。因为互联网,中国研究人员能够几乎实时的接触到国际最顶尖的研究成果。

中国计算机视觉界一个重要的标志性事件是2005年ICCV在北京召开,马颂德和Harry Shum担任大会主席,标志着中国计算机视觉的研究水平已经得到国际的认同。我也很荣幸的从Tom Huang前辈手中接过IEEE Fellow的证书。

可能几何视觉的理论已经比较成熟了,90年代末,计算机视觉的研究开始进入物体和场景的检测和识别。用的方法是传统特征加上机器学习。

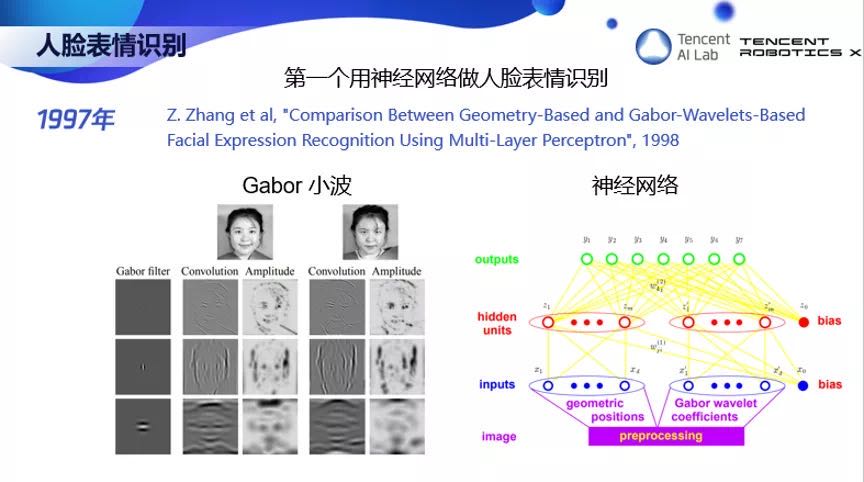

那时候我做几何视觉做了很长时间,1997 年,我也开始尝试,开发了世界上第一个用神经网络来识别人脸表情的系统,用的特征是 Gabor 小波。虽然 20 多年前就开始人脸表情识别,但那时数据太少,一直到 2016 年我们才在微软把人脸表情识别技术商业化,在微软的认知服务上,大家都可以调用。

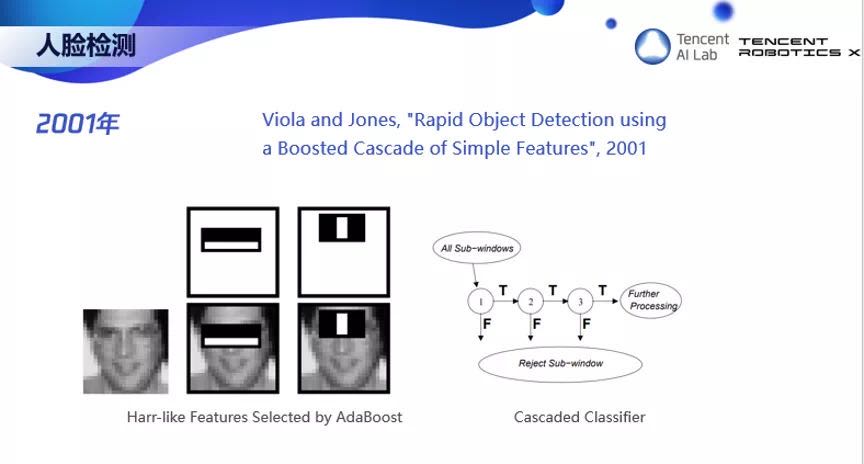

在传统的特征加机器学习的年代,需要提一下一个里程碑的工作,那就是2001年Viola-Jones Detector。通过Harr特征加级联分类器,人脸的检测能够做得非常快。在20年前的机器上就能做到实时。此后的循环是一波一波的新数据集推出,加一波一波的算法刷榜。

2009 年一个叫 ImageNet 的数据集出现了,这是斯坦福大学李飞飞团队推出的,这个数据集非常重要,它的意义不在于这个数据集很大,而在于几年后催生了深度学习时代。

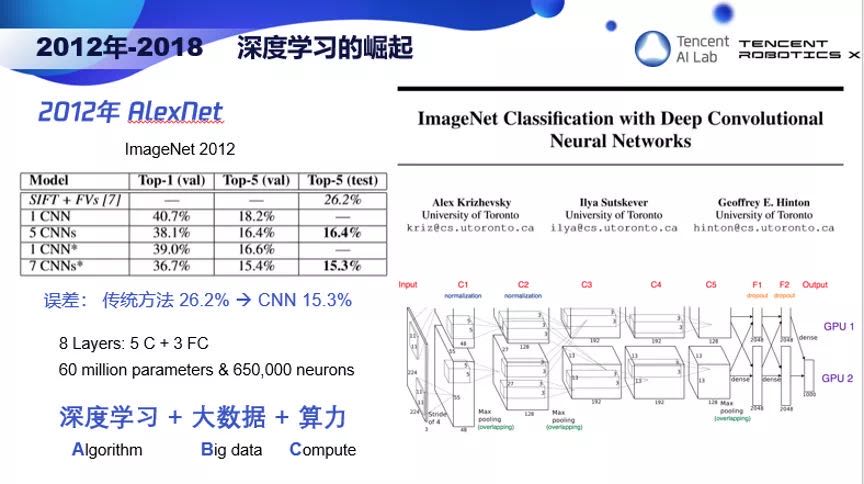

2012 年,Geoffrey Hinton 的两个学生开发了 AlexNet,用了 8 层神经网络,6 千万参数,误差比传统方法降了十几个百分点,从 26% 降到 15%,从此开启了计算机视觉的深度学习时代。这个 AlexNet 结构其实和 1989 年 Yann LeCun 用于手写数字识别的神经网络没有很大区别,只是更深更大。

由于 Geoffrey Hinton, Yoshua Bengio, Yann LeCun 对深度学习的贡献,他们共同获得了 2018 年的图灵奖。这个奖他们当之无愧。要知道 Geoffrey Hinton 1986 年就提出了 backpropagation,坐了 25 年的冷板凳。

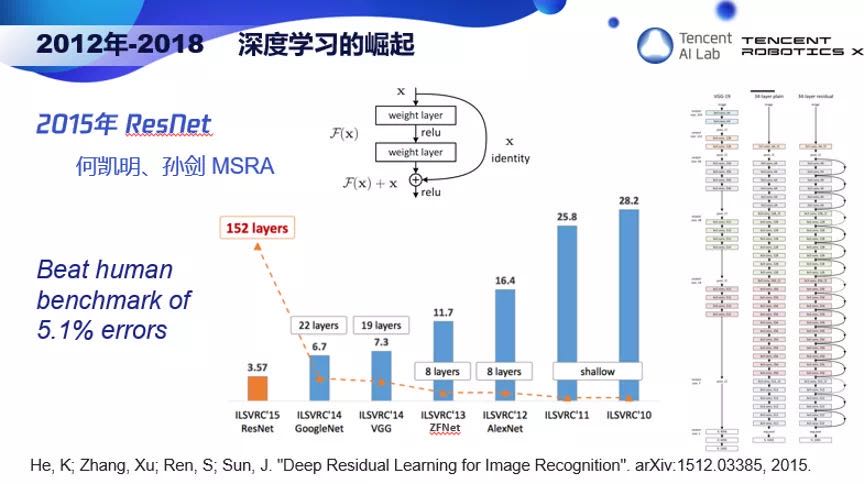

在深度学习时代还有一个里程碑的工作,2015 年,微软亚洲研究院的何恺明和孙剑提出 ResNet,用了 152 层神经网络,在 ImageNet 测试集上的误差比人还低,降到了 4% 以下。

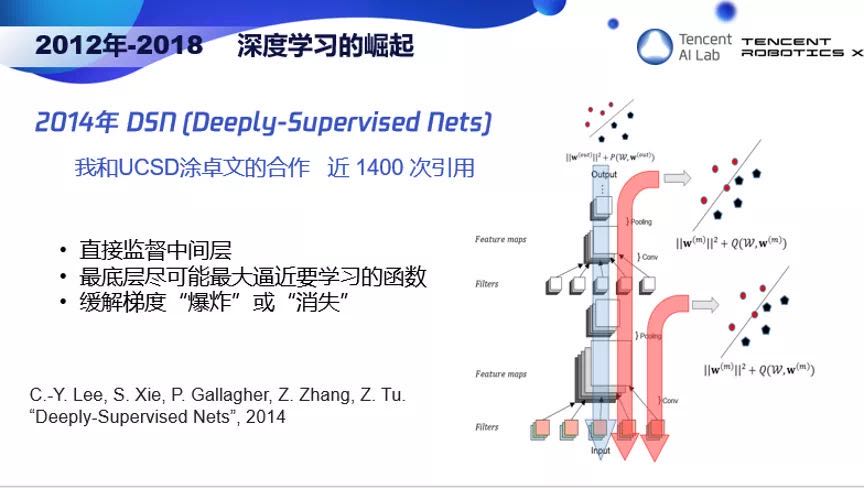

我在深度学习领域也有一点贡献。2014年和UCSD的涂卓文合作,提出了Deeply Supervised Nets, DSN, 深度监督网。虽然影响没有ResNet大,但也有近一千四百次引用。想法是直接让输出监督中间层,使得最底层尽可能最大逼近要学习的函数,同时也缓解梯度“爆炸”或“消失“。

经过三十多年的发展,华人在计算机视觉领域的力量从寥寥可数的几个人发展到现在的几千人。去年CVPR2019 可以被称为是华人的盛典,在组织者里面有很多华人面孔,包括大会主席朱松纯、程序委员会主席华刚和涂卓文。在五千多篇投稿中,40% 来自大陆,最佳论文奖和最佳学生论文奖的第一作者也都是华人。所以中国的计算机视觉能力还是很强的,这一点值得骄傲。

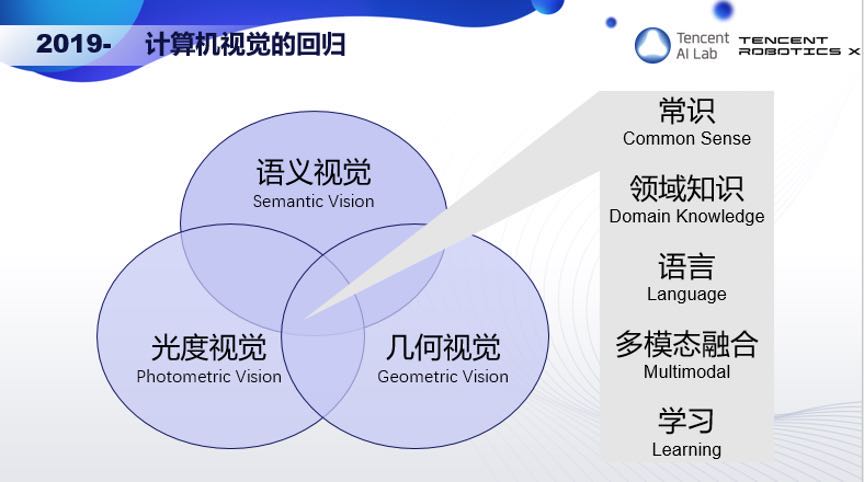

现在让我们回顾一下计算机视觉研究的演变,从最初的图像处理、立体视觉与三维重建、物体检测和识别,到光度视觉、几何视觉和语义视觉,到现在的深度学习打遍天下。这是让我担忧的。深度学习有很多局限性。比如深度学习本质上是一个监督学习,需要标签,才能学会一个从数据到标签的mapping。它缺乏常识,无法推理,也很难结合领域知识。

所以我们应该回归初心,让光度视觉,几何视觉,和语义视觉紧密结合起来,同时注入常识和领域知识,和语言进行多模态融合,通过学习不断演变。

我们腾讯 AI Lab 在这方面也开始做了一点点工作。比如我们的看图说话项目能够用语言描述一张照片的内容,2018 年 1 月,我们上线 QQ 空间 app 让视障用户「看到」图片。我们还整合了计算机视觉,语音识别,和自然语言处理技术,开发了虚拟人产品,探索多模态人机交互,赋能其他场景,助力社交。

那么现在的人工智能真的智能吗?看看左边的视频,摄像头能一直跟踪住人,好像是智能的。但看看右边的视频,你觉得它智能吗?让一个安防系统看一个iPad就不知道怎么做了。想象一下,如果一个人想要盖住你的眼睛,你会怎么做?我是会躲开的。但这个系统显然没有这样的举止。现在的人工智能只是机器学习:从大量的标注数据去学习一个映射,尽管这个映射可能很复杂。

那什么是真正的智能?我想目前还没有定论,而且我们对我们自己的智能还没有足够的了解。不过我很认同瑞士认知科学家 Jean Piaget 说的,智能是当你不知道如何做的时候你用的东西。我认为这个定义是非常有道理的。当你无法用你学到的东西或天赋去面对时,你动用的东西就是智能。如何去实现有智能的系统呢?可能有很多条路,但我认为一条很重要的路是需要把载体考虑进去,做有载体的智能,也就是机器人。

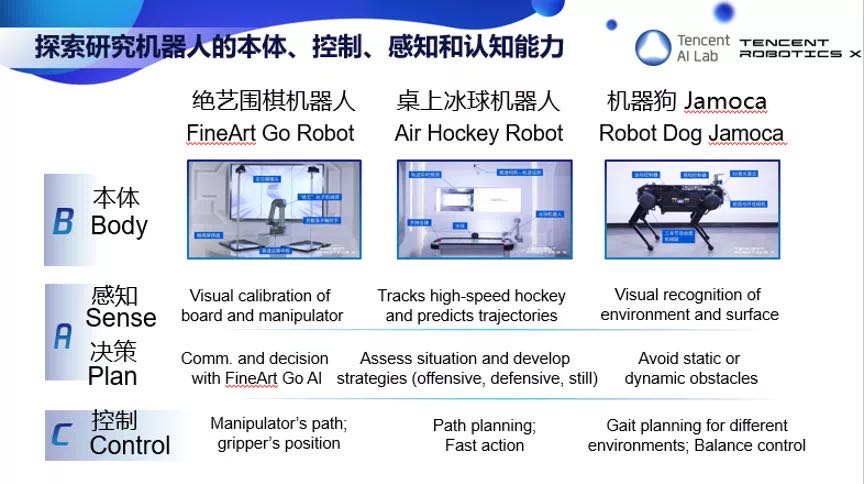

在机器人领域,我提出了A2G理论,A是AI, 机器人必须能看能听能说, B是Body本体,不同的本体形态具备不同的能力,C是Control控制,要对机器人本体能精准控制,ABC组成了机器人的基础能力。D是Developmental Learning,发育学习,机器人要能通过和外界的交互不断学习,提高自己的智能,E是EQ,情感理解、拟人化,机器人才能理解人,和人类共生,F是Flexible Manipulation,灵活操控,要有灵敏的触觉能力,执行物理任务。最后要达到G,是Guardian Angel,守护天使,服务人类,保护人类。因为时间关系,就不一一展开了。

腾讯做了三款机器人:绝艺围棋机器人、桌上冰球机器人,还有机器狗。可以为大家展示机器狗的视频,机器狗具备感知系统,能够绕开障碍物,看到悬空的障碍物能匍匐前进,看到前面一个人能蹲下来看着人。

我的报告就到这里。最后我想说我们腾讯的 AI 使命是 Make AI Everywhere,我们一定会善用人工智能,让人工智能造福人类,因为科技向善。谢谢大家。

推荐阅读:

更多腾讯AI相关技术干货,请关注专栏腾讯技术工程