来源:AI人工智能初学者

作者:ChaucerG

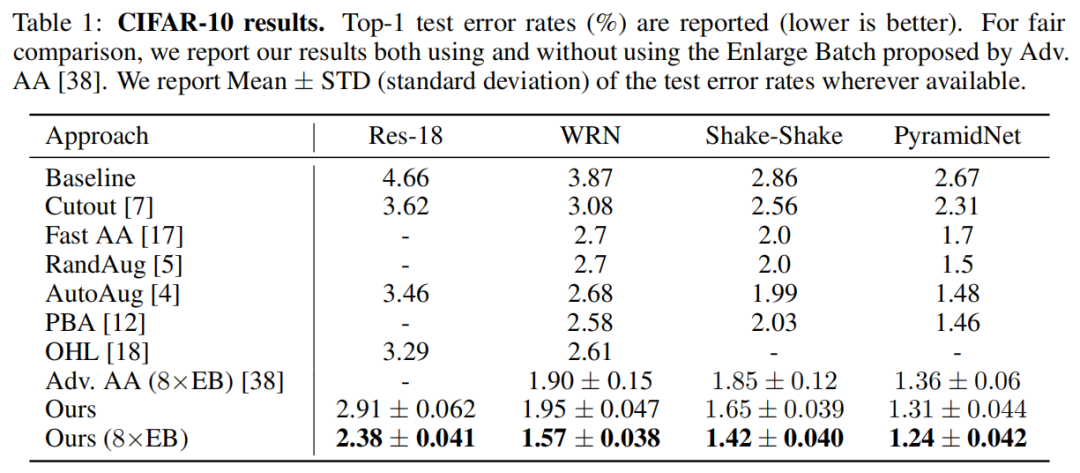

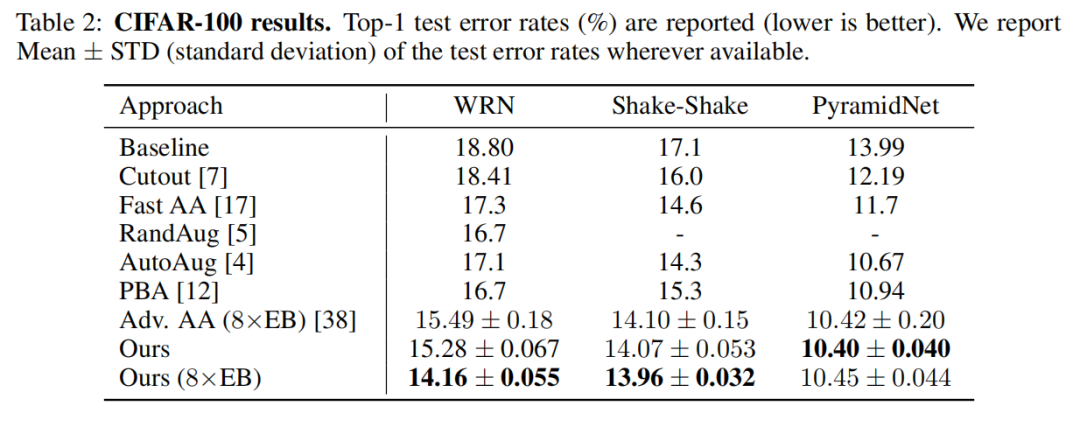

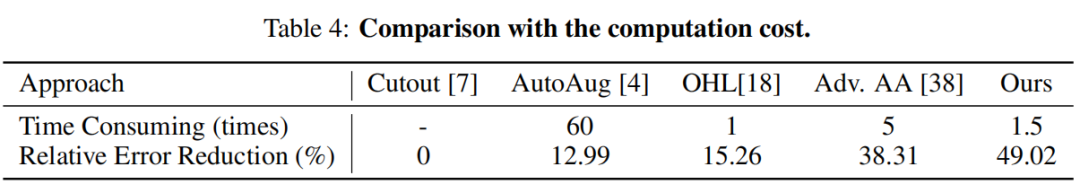

近两年自动搜索得到的图像数据增广策略大大提高了各种视觉任务的性能。自动搜索的关键组成部分是对特定增强策略的评估过程,该过程用于返回奖励并进一步得到更好的策略。评估过程将非常耗时。为了获得效率,很多研究者选择牺牲评估可靠性来提高速度。而在本文中将深入研究模型的增强训练的动力学。启发设计了基于增强权重共享的机制,以一种优雅的方式形成快速而准确的评估过程。本文方法在CIFAR-10上,Top-1错误率为1.24%,这是目前性能最佳的单一模型!性能优于Adv AA、PBA、AutoAug等数据增广方法。

1 Introduction

深度学习技术在计算机视觉领域得到了大量应用,在图像分类、目标检测、图像分割、图像描述、人体姿态估计等许多任务中都取得了显著地进展。而过拟合是深度学习中一个广泛存在而又很难回避的问题。很多学者针对不同的任务也提出了不同的正则化方法来缓解过拟合的问题。

数据增强是将具有语义不变性的图像变换方法应用于训练数据中以增加数据的数量和多样性,该方法简单有效,同时也是最常用的正则化方法。对于图像数据,有各种常用的增强操作,包括传统的图像转换,如调整大小、裁剪、剪切、水平翻转、平移和旋转。最近,一些特殊的操作被提出,如Cutout和Sample Pairing。

但是,选择适当的数据增强策略非常耗时,并且需要经验丰富的专家大量努力。因此,自动增强技术被用来根据特定的数据集和模型进行搜索性能增强策略。

2 本文方法

2.1 Motivations

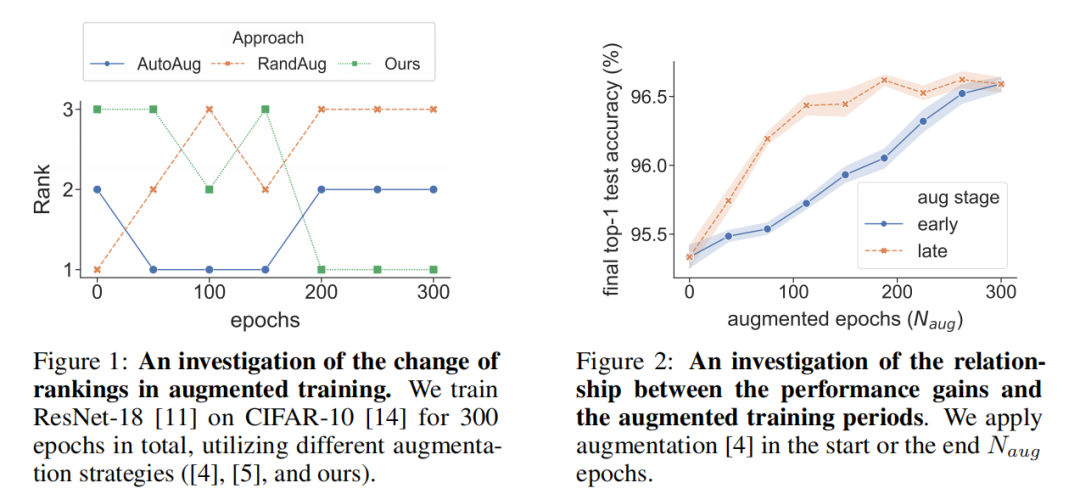

为了验证Data Augmentation可以缓解过拟合的问题,作者探究了性能增加和周期增加之间的关系。在Cifar-10上使用ResNet-18总共训练了300个Epoch,其中一些被AutoAug的搜索策略扩充数据。具体来说增加的开始或结束 Epoch,表示数量扩张的时代。

主要证明了两点:

- 1)、在增大Epoch 数相同的情况下,在后期进行数据增强可以不断获得较好的模型性能,虚线曲线总是在实线曲线之上。

- 2)、为了将模型训练到相同的性能水平,在后期进行数据增强比在早期进行数据增强需要的Epoch更少,因为虚线总是在实线的左边。

综上所述,实证结果表明,在训练的后期,数据增强的作用更大,可以利用它对不同的增强策略产生有效和可靠的奖励估计。

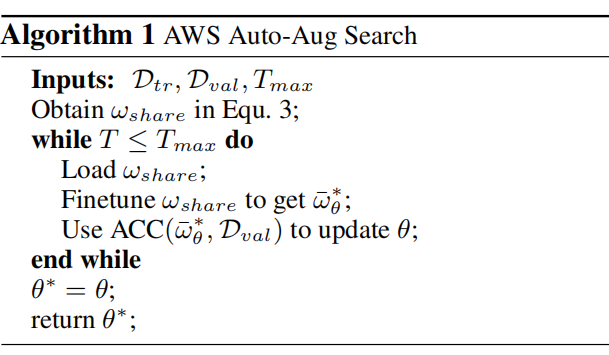

2.2、Augmentation-Wise Weight Sharing

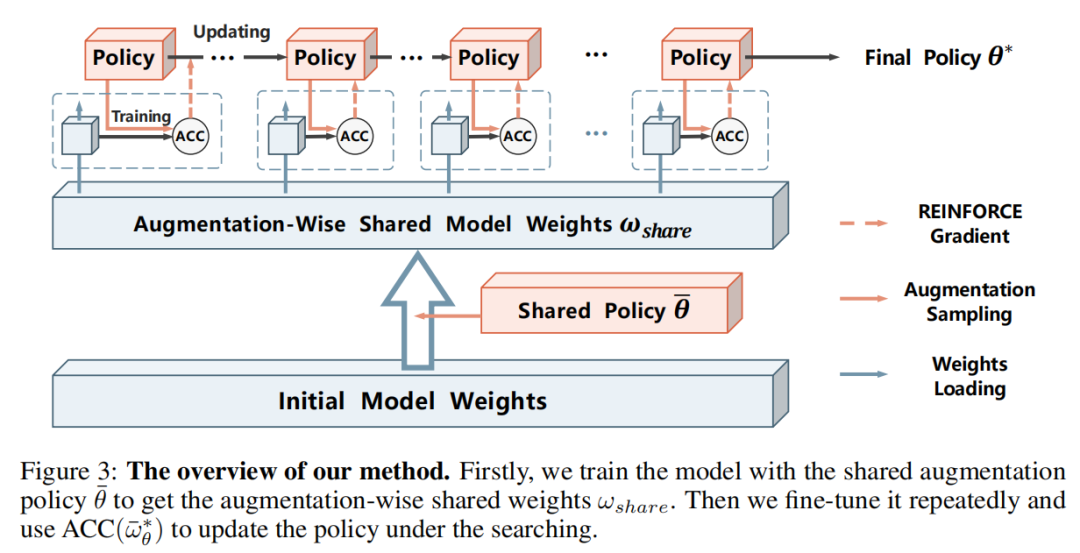

本文提出了一种新的用于自动增强方法。它包括两个阶段:

- 第一阶段,选择一个共享的增强策略来训练共享的权值,即基于增强的共享模型权值。借鉴了NAS中的权重共享方法,在不同的网络架构中共享权重,以加快搜索速度。

- 第二阶段,进行有效的策略搜索。可靠性在后期更多地作为增强操作功能。

2.3、 Auto-Aug Formulation

本文的搜索数据扩充策略为一个特定的模型表示ω,参数化的ω。这里将增强策略看作是对候选图像变换的一个分布函数,它是由线性变换控制的。最优增强策略可以描述为一个优化问题。通过求解最优ω来固定以得到最优的权重优化模型,进而得到最优的增强策略。

式中L为损失函数,即交叉熵损失。

外部层是增强策略优化,即对策略参数进行优化给出了内部层次问题的结果。值得注意的是,的优化的目的是验证准确性ACC

表示参数的最优值和ω表示验证准确性。于是该问题便是一个典型的优化问题。

2.4、Proxy Task

在观察到后期的增强操作比早期的增强操作影响更大的情况下,本文提出了一种新的Proxy任务,该Proxy任务用计算效率评估过程代替了内部层优化的求解过程。

Proxy任务是通过2个part来训练增强的参数ω:

- 第一个part:采用共享增强策略对网络进行训练,而不考虑外部优化给出的当前策略;

- 第二个part:通过给定策略的加权,对网络模型的扩展共享权值进行微调,以评估该策略的性能。

由于第一个part中共享的增强训练独立于给定的策略冗余,对于所有候选的增强策略只需训练一次就可以进行搜索,大大加快了优化速度。

3 消融实验

3.1、Cifar10实验

3.2、Cifar100实验

3.3、ImageNet实验

更为详细内容可以参见论文中的描述。

References

[1] Improving Auto-Augment via Augmentation-WiseWeight Sharing

声明:转载请说明出处

推荐专栏文章

更多嵌入式AI算法部署等请关注极术嵌入式AI专栏。