在国内,谈到智能语音技术,肯定绕不开一个人,那就是现任百度语音首席架构师贾磊,他是智能语音界举足轻重的 AI 大牛,于 2010 年加入百度,组建了百度语音团队,主导研发了百度语音识别和语音合成等一系列百度自有知识产权的语音核心技术。2016 年短暂创业后又回归百度,主持研发了小度智能音箱的远场语音交互系统、小度车载语音交互、百度鸿鹄语音芯片、百度智能语音呼叫中心系统等一系列百度语音类产品并将相关技术推向中国社会,他还于 2015 年获得了全国劳模称号(互联网业首位全国劳动模范)。作为 AI 落地的一个关键组成部分,智能语音交互技术这一路是如何发展起来并日趋成熟的?在 2020 魔幻的一年,智能语音技术的最新发展是什么?伴随着 5G、AI 算力等技术的快速发展,未来智能语音技术又将在哪些方向进行突破和创新?本文将分为上下两部分,结合贾磊的从业经历,从个人侧和技术侧详谈智能语音技术的过去、现在和未来,肯定能让你收获颇多。另外,贾磊老师也将于 2021 年 1 月 8-9 日 QCon 北京站上带来智能语音的更多精彩分享,欢迎大家现场面基,共同探讨、交流。

(上)

作为最早关注智能语音的业界大咖之一,贾磊是在什么契机下选择走上智能语音之路的?他对语音交互认知的本源是如何理解的?短暂创业经历又给他带来了哪些收获?接下来,本文上篇将你深入认识一下贾磊,全面了解下大牛成长记。

兴趣驱动,开启近 20 年的智能语音技术追求之旅

贾磊选择语音是兴趣驱动的。贾磊硕士毕业后,考入中科院自动化所攻读博士学学位。他最初的研发方向是图像处理,广泛涉猎了模式识别各学科方方面面的知识,也综合比较了图像、语音和 NLP 等学科的学科差异等。这时候逐渐开始对语音技术产生了浓厚的兴趣,很好奇人是怎么发出声音、感知声音、并且理解声音内容的。当时 IBM 的 ViaVoice 软件也是风靡世界,人们依靠声音来实现人机交互的梦想的实现就摆在眼前,语音产业化应用的明天一片大好。这时候正巧贾磊中科院自动化所的第一任导师因为工作调动问题,允许他们调换专业,最终他根据个人兴趣发展,申请从图像处理方向转到语音识别的技术方向上。从那时候开始,贾磊就开始了他近 20 年的语音技术追求之旅。

短暂创业让贾磊明白了伙伴间的“可依赖”关系

贾磊曾在 2016 年有过一段短暂的创业经历,谈及创业带给他的最大收获,贾磊坦言,创业使他懂得了创业伙伴之间需要的是“可依赖”,而不是简单的“可信赖”。大家因为信赖走到一起,“信赖”只是彼此结缘的开始。创业伙伴们之间需要维护的是一种可依赖关系,这种关系需要长期存在,是一个过程。创业过程中,经常舍死忘生,人力物力财力都有限,大家各自需要 120% 的投入解决眼前的问题。大家需要把后背交给对方,无条件的信任对方。大家背靠背的去战斗,背靠背的一起拼。每个人都拼死守住自己前方的战场,把自己的后背托付给一起创业的伙伴和兄弟。一个人败了,其实也是大家都败了,再说谁的责任已经毫无意义。创业会让人更加认识到团队协作的价值和团队的作用。除了对创业伙伴之间的关系理解外,创业带给贾磊最大的冲击是对资本的敬畏。之前一直在大公司打工做技术,从来没有意识到资本对于技术发展的可持续是如此的重要。经过创业之后,他深刻的理解到,技术要想有进步,不单单是技术人员的个人努力,更重要的是技术人员所属平台的持续长期投入。这些投入不单单是技术人员的工资、实验以及各种研发要件的投入,更为具体的是技术应用场景的投入,后者的投入更为巨大。因此创业之后再回到百度,贾磊更加感恩,百度的长期不计回报的投入,才让语音技术这个小草,在百度内能够长成参天大树。贾磊个人也从语音技术的普通专业技术人才,变成语音行业的技术领军人物。

如何理解语音交互认知本源

创业回到百度后,贾磊从之前侧重语音算法技术创新,变成算法创新和产业拓展兼顾。也许是认识到了资本对于技术的推动作用,贾磊要求团队成员都要有成本意识和营收意识(当然技术团队的营收都是概念上的,而不都是绝对实际的营业流水),都要具备业务整体推进能力,而不是单体算法创新。这也是他们投入做百度鸿鹄芯片的一个背景。讲这些乍一听,好像和人类认知没有关系,但是真正的把技术应用到实际的应用过程,贾磊越来越发现,人类的认知过程,不是一个简单的学科划分过程。不是说学语音的就只解决语音的认知,很多时候认知是视觉、听觉、理解一体化的一个过程,比如任何人交流中的肢体语言,就对人的意图理解起到举足轻重的作用,再比如语义理解过程和语音识别过程,在具体的产业应用中,是密不可分的。学科划分有边界,但是人的认知本源可能是一体的。解决语音交互的问题,不能单单从语音技术出发,要放在产业应用中,语音、图像和 NLP 一体化的规划和解决问题。

时间就像海绵里的水,努力挤才能平衡工作和家庭

贾磊曾在 2015 年荣获全国劳模称号(互联网业首位全国劳动模范),可以想见工作强度非常大,关于怎样平衡工作和家庭,他认为互联网的工作强度都很大,互联网工作的朋友们都牺牲了很多自己的生活休息时间。“我个人而言和从事互联网行业的伙伴们一样,都是全身心的投入工作,家庭生活感觉确实参与的少一些。陪孩子的时间也比较少,有时候工作忙了,早晨一大早出来,晚上很晚回去,回去后孩子也早就睡了。早晚两头都见不到孩子,非常想她。每次见到孩子冲着我笑的小脸,我都觉得很自责。如果不是很忙的话,我都尽量早晨早一点起来。陪她吃早饭,送她上学。上学路上,我会教她看红绿灯、走斑马线以及避让绿灯时候右转的车辆。之后,我赶紧开车奔向公司,正好能赶上大清早开始工作。我觉得时间就像海绵里面的水,只要你使劲挤,总是能挤出来的。不要错过陪伴孩子长大的时间,他们长大的很快,一晃就不再需要我们的陪伴了。”

(下)

上篇我们聊到了贾磊老师与智能语音技术的情结,下篇我们将着重从技术侧和你聊聊智能语音的过去、现在和未来,干货满满。

智能语音行业发展历程解析

IBM ViaVoice 时代的语音技术

语音行业在 2000 年左右,迎来了第一个产业高潮,也就是 IBM 的 ViaVoice 语音录入软件。当时人们把这个软件安装到 PC 机器上,就可以在计算机前面朗读报纸或者新闻内容,或者录入一些简单的日常用语,识别率也还不错。于是工业界有了一次大规模连续语音识别的产业化应用的热潮。当时,ViaVoice 时代的语音技术还是以 HMM 建模和混合高斯系统 (GMM) 为声学建模核心的建模技术,语言模型采用的是基于 Ngram 的统计语言模型。因为 PC 上的内存限制,语言模型体积也只有几十 M。另外,当时可以获得的文本语料也是有限的,所以语言模型能覆盖的内容范围很小,当时主要集中在新闻报纸和日常用语领域。因为 HMM 系统和混合高斯系统建模能力有限,这时的连续语音声学训练语料库也就只有数百小时。这个时候的语音识别系统对说话方式和口音的要求也很严格,说话方式必须是朗读方式,口音也要求必须是标准普通话,否则,识别率迅速下降。很快的,人们发现 ViaVoice 难以满足人们在 PC 上把声音转成文字的产业需要。慢慢地,ViaVoice 的产业热情就逐渐降温了。

图 1:早期 Windows 上的 ViaVoice 软件

在 2003 年贾磊毕业的时候,基本上人们对于语音输入的产业期望已经很低了,各大公司都降低了语音技术的投入和预期。贾磊刚毕业就立刻迎来了语音技术的第一个低潮期,当时很多做语音专业的学生都转换方向,不少人做语音也是选择留校,而不是工业届。当时国内各大公司比较多见的语音需求是手机上的数字和人名拨号系统、以及车载语音导航等嵌入式产品研发,技术也大都集中在设备端侧的单通道语音识别或者是语音合成。技术上讲,这些应用都是嵌入式孤立词语音识别系统,其特点是只能识别特定的指令词和句式。之后的几年,除了零星的嵌入式设备应用外,语音技术在工业界的拓展乏陈可新,语音产业持续低迷。

语音技术的产业应用迎来第二波高潮

痛苦的日子总算没有太长。在 2007 年,微软公司收购语音识别技术企业 Tellme Networks,并开始组建自己的语音团队,语音技术的产业应用又重新回到大公司的关注热点中。很快,谷歌于 2008 年在美国发布了英文语音搜索服务 Voice Search, 并应用于 Android、诺基亚 S60、黑莓、iPhone 等多个系列的手机。之后,谷歌又在 2009 年发布了中文语音搜索,语音的产业应用迎来了新一波高潮。这一波热潮的核心特点是以互联网需求和实现为基础,此时模型处在云端,所以体积可以更大。例如语言模型,由于位于云端,语言模型体积可以达到上 G , 这是之前 2000 年左右的 ViaVoice 语音系统所不可能达到的(2000 年的比较好的 PC 计算机内存才 256M,那是语言模型位于终端,也只有几十 M)。语言模型位于云端后,热词新词的信息更新也更加及时,同时大的模型体积意味着对支持的语言领域更加广泛。同时,技术上虽然声学模型仍然是以 HMM 框架 GMM 建模为主体,但是可以采用更多更大的训练语料。数千小时乃至上万小时的声学训练语料库已经开始进入工业界。因此从 2000 年到 2010 年左右的十年期间,虽然语音识别的核心算法技术仍然是 HMM、GMM 和 Ngram 统计语言模型,但是因为互联网技术的引入,可以采用云端体积更大的声学模型和语言模型,训练这些模型的语料库也显著增加,最终导致语音交互的用户体验得到很大提升,语音技术的云端应用逐渐开始流行。

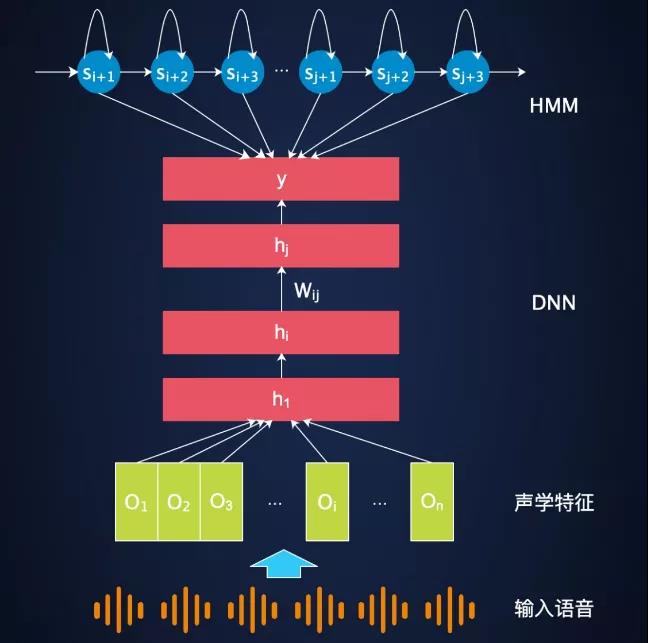

图二 深度学习首次应用语音识别的系统框图

2011 年, 微软的邓力和俞栋两位学者通力合作, 把深度学习技术应用于工业级的大词汇量连续语音识别实验, 获得相对于传统基线系统 23% 的显著提升,这标志着语音识别技术最先迎来深度学习革命。深度学习应用于语音识别,最初的整体建模框架仍然是 HMM,但是声学输出分布 GMM 模型被替换成了深度学习 DNN 模型。这时候的语音识别系统是一种 HMM 和 DNN 混合 (hybrid) 的语音识别系统。随着深度学习技术在语音技术中越来越深入的应用,从 DNN 到 CNN,再到 CNN+LSTM,语音识别系统的字错误率以每年 10%- 15% 的相对错误率降低。再后来伴随着 CTC 技术的引入,更大粒度的建模单元(WordPiece 模型,音节和字)开始逐渐越来越多的被采用,应用于语音识别几十年的 HMM 框架逐渐被淘汰。

语音识别技术进入端到端时代

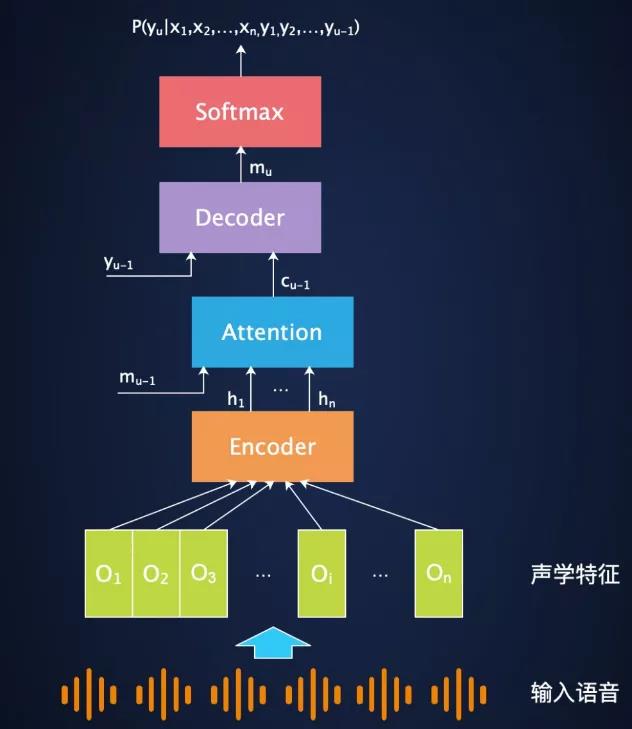

从 2015 年开始到 2020 年这段时间,注意力建模技术的研究,又让语音识别技术开始进入端到端的时代。2019 年之前,Attention(注意力) 技术早已经广泛应用于 NLP、图像等商业产品领域。但是语音识别领域,从 2015 年开始,实验室内就广泛进行了基于 Attention 的声学建模技术,也获得了广泛的成功。国际上通常用于语音识别的注意力模型有两种,一种是谷歌的以 LSTM 为基础的 LAS(listening attention and spelling) 模型。另外一种是基于 self attention 的 transformer 模型。这两种注意力模型在实验室的各种实验中,都能够显著提升语音识别系统的识别率,同时实现了一套深度学习模型,语音语言一体化的端到端建模。虽然注意力模型在实验室范围内获得巨大成功,但是应用于工业界的实际在线语音交互产品,还存在一系列的技术障碍。核心难题就是在线需要识别系统需要流式解码,而注意力模型需要拿到整段语音才能进行解码,会造成用户无法接受的识别延迟问题。所以注意力模型直到 2019 年初,都没有在工业在线语音交互中使用注意力模型做语音识别的成功案例。2019 年 1 月,百度发布率先发布了基于流式置信度建模技术的语音输入法产品,首次提出流式多级截断的注意力模型 (SMLTA),这是国际上注意力模型在在线语音识别领域的大规模工业应用的首个成功案例。之后,流式注意力模型在学术界也开始进入广泛的研究。最近,语音识别应用中的逐渐集中到流式的 self-attention 建模,包括流式的 transformer 等。人类对于语音识别的核心技术提升的脚步从来没有停止过。

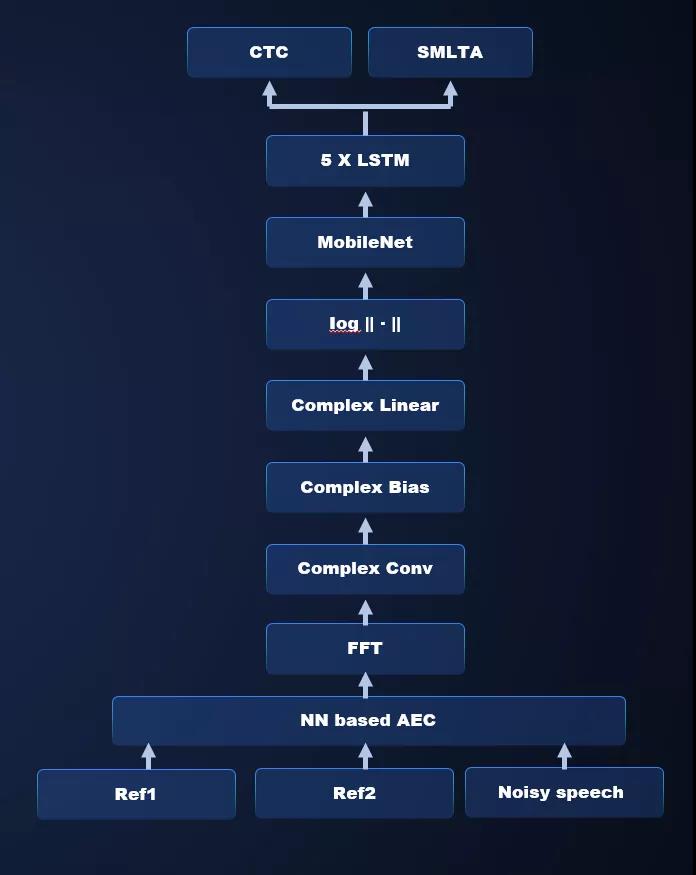

图三 基于注意力机制的语音识别端到端建模的通用框架

2015-2020 年期间,智能音箱产业在中国乃至世界范围内,都得到巨大的发展和普及。在智能音箱使用场景下,目标声源距离拾音器较远,致使目标信号衰减严重,加之环境嘈杂干扰信号众多,最终导致信噪比较低,语音识别性能较差。为了提升远场语音识别准确率,一般会使用麦克风阵列作为拾音器,然后利用数字信号处理领域的多通道语音信号处理技术,增强目标信号,最终产生一路清晰信号,送给后面的语音识别系统进行语音识别。这时候数字处理信号系统和语音识别系统相互级联是主流的远场语音识别技术,这种级联技术也成为第一代智能音箱远场语音交互技术的主流技术。随后,语音学术界开始进行一系列的技术创新,从数字信号处理到语音识别一体化的端到端建模成为热点。这是一种创新的远场语音交互技术,一套深度学习模型打穿数字信号处理和语音识别两个领域。国际上,Google 最先试图解决这个问题。谷歌的解决方案采用的深度学习模型结构,来自于类似于 filtering and sum 的数字信号处理思想,模型底部的结构设计,模拟了数字信号处理的多路麦克处理过程。在此之上,模型仍然是采用传统的近场语音识别的深度学习模型。该模型直接建立了从远场语音多路信号到识别文字之间的端到端的进行。百度团队针对远场语音识别的特殊需求,也提出了自己的基于复数 CNN 的远场端到端建模方案,并大规模应用于工业产品。

语音技术从之前的云端竞争开始逐渐向端侧芯片延伸

2020 年左右的 AI 芯片的发展,也对语音交互行业产生了巨大的推动作用。在 AI 技术快速普及的今天,算力已经成为推动 AI 行业发展的根本核心力量。2011 年微软的科学家能够把深度学习应用于语音识别工业界,除了科学家的勤奋工作之外,更重要的背后的推手是 GPU。没有 GPU 的算力支持,就不可能一个月完成数千小时的 DNN 模型训练。从 2011 年至今,英伟达的股价已经从十几美金,暴涨了几十倍。这一点充分证明了 AI 算力的价值,在语音识别行业,远场识别的兴起催生了 AI 语音芯片的发展。一颗芯片完成端侧信号处理和唤醒成为一个明显的市场需求。在智能音箱领域,这种 AI 语音芯片能够显著降低音箱的成本,并且提供更高精度的唤醒和识别能力。在汽车车载导航领域,AI 语音芯片可以保证主芯片的负载安全,提升驾驶安全。各大语音公司都开始推出自己的语音芯片,语音技术从之前的云端竞争又开始逐渐的向端侧芯片延伸。

2020 年百度语音技术成果盘点

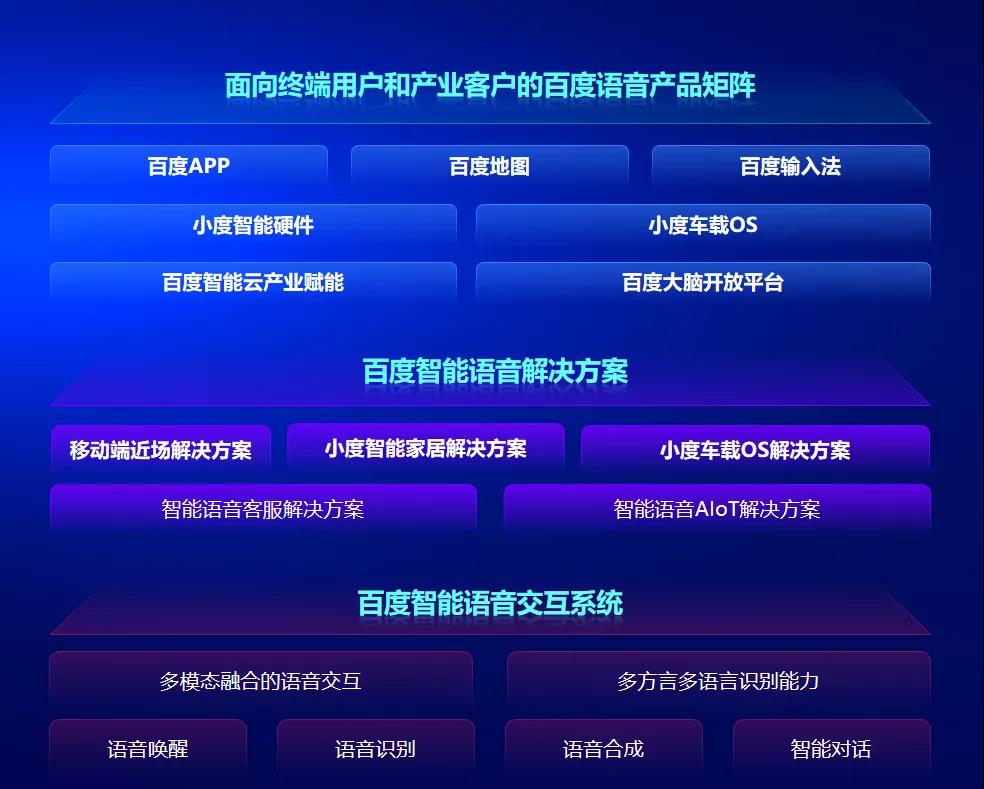

智能语音交互系统是人工智能产业链的关键环节,面对未来智能语音产业链的新需求,百度研发了新一代适合大规模工业化部署的全新端到端语音交互系统,实现了语音交互全链路协同处理,软硬件一体优化,信号语音一体化建模,语音语言一体建模,语音语义一体交互,语音图像多模态融合,全深度学习的语音识别、语音唤醒以及千人千面个性化语音合成等,其中重大技术创新如下。

1.Attention(注意力) 技术早已经广泛应用于 NLP、图像等商业产品领域,但是语音识别领域,从 2015 年开始,实验室内就广泛进行了基于 Attention 的声学建模技术,也获得了广泛的成功,但是在语音识别最广泛使用的语音交互领域,Attention 机制一直没办法应用于工业产品。核心原因是语音识别的流式服务要求:语音必须分片传输到服务器上,解码过程也必须是分片解码,用户话音刚落,语音识别结果就要完成,这时候人的说话过程、语音分片上传过程和语音识别的解码过程三者都是并行的。这样用户话音一落,就可以拿到识别结果,用户的绝对等待时间最短,用户体验最佳。传统注意力建模技术必须拿到全局语音之后,才开始做注意力特征抽取,然后再解码,这样一来解码器过程的耗时就不能和语音识别的解码过程同步起来,用户等待时间就会很长,不满足语音交互的实时性要求。

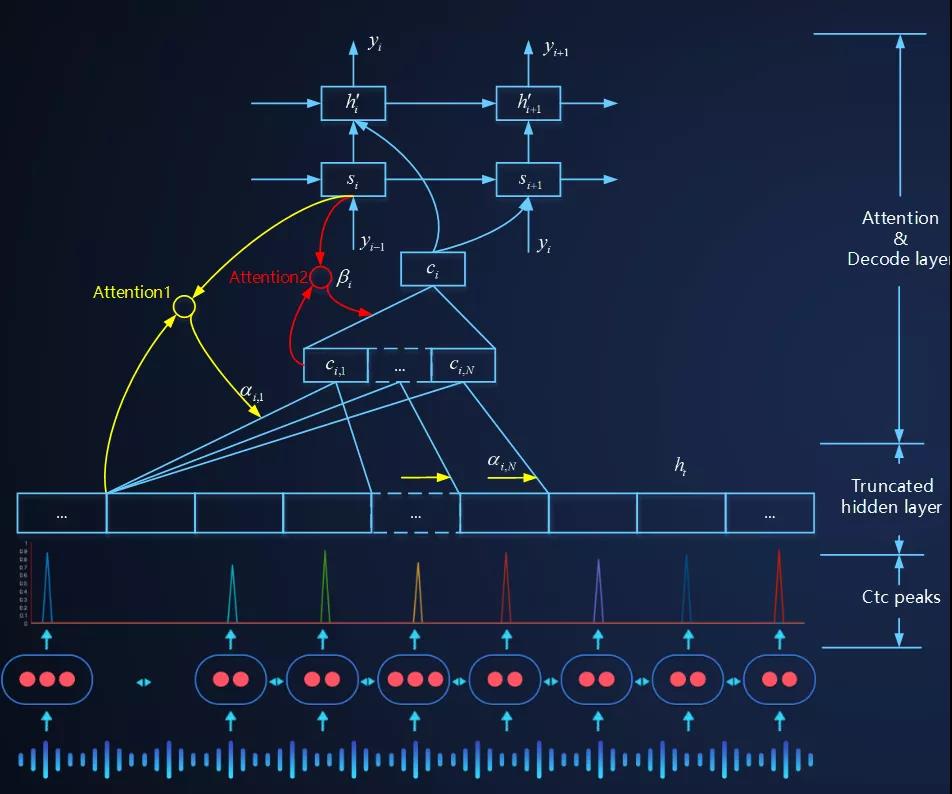

图四 SMLTA: 百度流式多级截断注意力模型(2019 年 1 月发布)

2019 年 1 月,百度语音团队提出了流式多级的截断注意力模型 SMLTA。该方案采用 CTC 模型和 SMLTA 模型相结合的办法,利用 CTC 的 peak 对连续语音流进行截断,然后在截断的语音流上做截断的注意力模型。这是全世界范围内,第一次基于 Attention(注意力技术) 的在线语音识别服务的大规模上线。该技术显著提升了线上语音交互的语音识别的准确率,同时实现了语音语言的一体化建模,为云端语音识别技术的全面端侧芯片化打下了基础。2020 年,SMLTA 技术全面应用于百度语音识别全线产品:语音输入法、语音搜索、地图语音交互、智能音箱、汽车导航、智能呼叫中心、会议在线翻译等产品上,都能看到 SMLTA 技术对语音交互性能的持续提升。

2.近些年随着 5G 的万物互联概念的普及,中国社会对智能设备的远场语音交互需求日益增加。在远场环境下,目标声源距离拾音器较远,致使目标信号衰减严重,加之环境嘈杂干扰信号众多,最终导致信噪比较低,语音识别性能较差。为了提升远场语音识别准确率,一般会使用麦克风阵列作为拾音器,然后利用数字信号处理领域的多通道语音信号处理技术,增强目标信号,最终产生一路清晰信号,送给后面的语音识别系统进行语音识别。这时候数字处理信号系统和语音识别系统是级联方式,数字信号处理系统是以信号的清晰度为优化目标,语音识别声学建模是以云识别率为建模目标,两个系统优化目标不统一,错误也会级联放大,最终的交互体验相比于近场识别差很多。国际上,Google 试图采用端到端建模技术解决这个问题,一套模型解决远场麦克阵列信号处理和语音识别声学建模问题。谷歌的解决方案采用的深度学习模型结构,借鉴了数字信号处理领域的类似于 filtering and sum 的数字信号处理思想,模型结构设计模拟经典数字信号处理过程。这种借鉴使得深度学习进行端到端建模更容易收敛,但是后期我们通过实验证明,这种借鉴严重影响了深度学习技术在该方向上的发挥和延伸,限制了深度学习模型的模型结构的演变,制约了技术的创新和发展。

图五 基于复数 CNN 的语音增强和语音识别一体化的端到端建模

百度语音团队研发出完全不依赖于任何先验假设的信号、语音一体化的适合远场语音交互的深度学习建模技术。该深度学习模型以复数 CNN 为核心,利用复数 CNN 网络挖掘生理信号本质特征的特点,采用复数 CNN、复数全连接层以及 CNN 等多层网络,直接对原始的多通道语音信号进行多尺度多层次的信息抽取,期间充分挖掘频带之间的关联耦合信息。在保留原始特征相位信息的前提下,同时实现了前端声源定位、波束形成和增强特征提取。该模型底部 CNN 抽象出来的特征,直接送入百度独有的端到端的流式多级的截断注意力模型中,从而实现了从原始多路麦克信号到识别目标文字的端到端一体化建模。整个网络的优化准则完全依赖于语音识别网络的优化准则来做,完全以识别率提升为目标来做模型参数调优。目前该方法已经被集成到百度最新发布的百度鸿鹄芯片中。

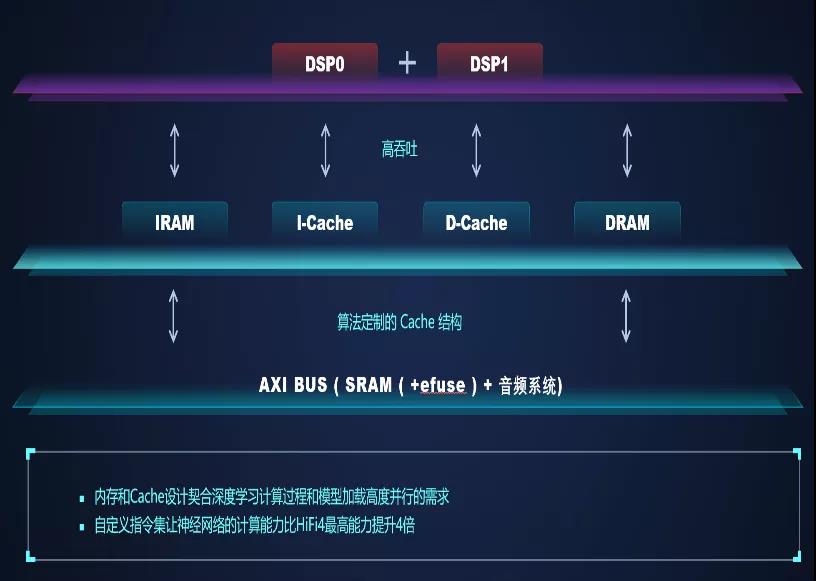

图六 百度鸿鹄芯片结构图

2020 年,百度在智能音箱、车载导航和智能电视控制方面,落地了百度鸿鹄语音芯片。研发了以远场语音交互为核心的鸿鹄芯片解决方案,一颗芯片解决远场阵列信号处理和语音唤醒的问题,打造了云端芯一体化的语音交互解决方案。百度鸿鹄语音芯片设计,变革传统芯片设计方法,推出 AI 算法即软件定义芯片的全新设计思路。百度鸿鹄芯片采用双核 Hifi4 架构自定义指令集,2M 以上超大内存,台积电 40nm 工艺,在此硬件规格上,100mw 左右平均工作功耗,即可同时支持远场语音交互核心的阵列信号处理和语音唤醒能力,满足车规可靠性标准。同时,百度鸿鹄芯片为远场语音交互算法量身定制了芯片架构,完全契合 AI 算法需求的核内内存结构设计、分级的内存加载策略、依据 AI 算法调教的 Cache 设计和灵活的双核通信机制,最终实现了深度学习计算过程和数据加载的高度并行。百度鸿鹄芯片是中国行业内唯一一颗能够承载全部远场阵列信号处理和智能音箱唤醒技术的语音芯片,也已经完成了业内首个支持电视熄屏唤醒的 AI 芯片解决方案并实现工业产品落地。

百度鸿鹄芯片之后,贾磊团队又将整个语音交互的复杂算法、逻辑和数据模型耦合的语音交互技术,利用百度全新研发的端到端语音建模技术,抽象成多个单纯的深度学习计算过程,从而可以几乎在性能无损的情况下将整个语音识别过程从云端搬到客户端。基于以上思路的百度鸿鹄芯片二代也正在紧锣密鼓的研发中,一颗芯片解决远场语音识别和合成问题将不再遥远。5G 时代的云端定义语音交互功能,端侧执行语音交互功能,云端一体的语音交互,很快会成为现实。

图七 百度智能语音全景图

在语音技术的产业化过程中,贾磊认为核心关键的要素是技术创新要把握产业需求,而不是闭门造车。比如百度的语音语言一体化的流式多级截断的注意力建模技术 (SMLTA),核心就是针对性的解决注意力(Attention)建模技术不能进行流式识别的问题,后者是在线语音识别技术必须的关键要求。再比如百度研发鸿鹄芯片,核心就是解决一颗芯片集成远场信号处理和远场唤醒,从而提升智能音箱的远场交互体验,降低智能音箱的成本。“文以载道”,技术提升的首要目标是产品体验提升,而非纯粹的学术创新。管理上要集中优势兵力优先解决技术工业应用时的痛点问题,要基于用户感知体验提升去迭代技术,而非单纯的技术指标提升。

端到端语音交互的技术挑战和难点

贾磊 认为最大的挑战是对跨学科端到端的模拟数据的生成和大规模工业训练的深度学习训练平台的把握。端到端建模,目前越来越倾向于跨学科的端到端建模,这时候首先需要解决跨学科的数据模拟问题。每一个学科,都有一个学科假设的学科边界。之前几十年的研究成果,都是在学科边界的假设范围内进行的,所积累的各种训练数据,也是基于学科边界假设的。一旦学科边界被打破,每个学科的假设都不成立了,训练数据往往需要重新积累。所以,通常需要用模拟的方法产生跨学科的端到端的训练数据。如何模拟跨学科的场景数据,是端到端建模的第一个难题。端到端建模的第二个难题,是如何应对数据倍增时候的深度学习训练,这些问题,对通常的语音团队,会成为一个很大的挑战。比如在做信号和声学一体化建模的时候,要在近场语音识别建模的训练数据量上,叠加一个远场信号的声场模拟。这样的话,模拟的数据量会有一个成倍的增加。考虑到大规模工业训练的要求,上面提到的模拟数据的生成,还通常需要在 GPU 上进行。同时,数据成倍增加后,还要在 GPU 上进行高速有效的训练。这里面对深度学习训练平台的把握是至关重要的,否则跨学科端到端建模时候的训练数据模拟和训练速度优化中任何一个问题,都会是压垮端到端建模的最后一根稻草。

解决上述问题的核心是要有对深度学习算法技术和工程技术都要有深刻的理解,对深度框架有全面的把握。有能力修改深度学习框架的内核,解决 GPU 上的训练加速、内存优化问题和算法调优的问题。如果只是泛泛的理解国外开源框架的算法技术,只是跑脚本训练模型,那么再遇到上述训练数据模拟和训练速度优化的时候,就无从下手,最终难以解决跨学科的端到端建模问题。

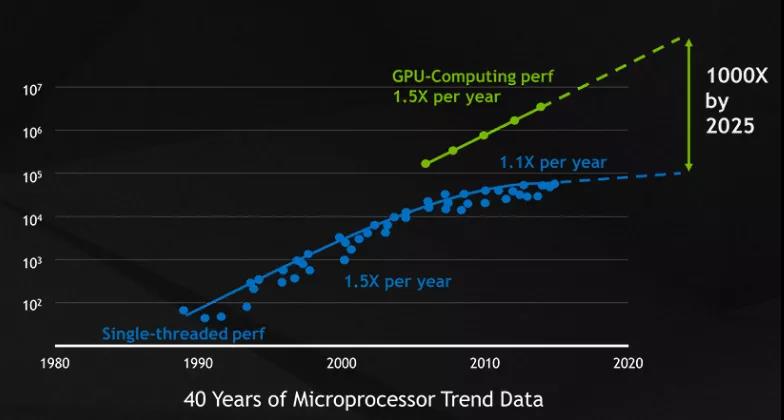

AI 发展是否进入瓶颈期?如何破局 AI 落地难?

贾磊认为,人工智能近 10 年的发展是伴随着 GPU 算力、数据增加和深度学习算法创新的发展而发展的。目前训练数据的增加和深度学习算法的创新速度确实是变慢了,但是 AI 算力这个维度,还有很大的增长潜力。无论是云端的 GPU 服务器,还是端侧的 AI 芯片,都有很大的增长空间。2018 年,OpenAI 的研究人员发布了一份分析报告显示,从 2012 年到 2018 年,在最大规模的人工智能训练中使用的算力增长了 30 多万倍,3.5 个月的时间就翻一番,远远超过了摩尔定律的速度。未来 5 年,GPU 的算力将达到 CPU 算力的 1000 倍。这些都将对语音交互产生巨大的推动作用。比如端侧 AI 芯片的发展,很快将使得端侧芯片具备完成和现在云端服务一样的语音交互能力,在一些场合比如汽车智能座舱等领域,语音交互的主体都将是由端上芯片在不需要联网情况下独立完成,大大提升了汽车行驶过程中的语音交互的可靠性和流畅性。

图八 GPU 算力增长趋势图

贾磊认为智能语音交互技术落地作为 AI 落地的一个关键组成部分,破局的关键点是从简单的识别和合成的能力提升,到更加场景化聚焦发展、更加综合性发展。之前我们提到的 AI 能力提升,都是单体的 AI 技术,比如语音识别技术、语音合成技术等单体技术的学科发展。但是综合语音、视觉、NLP 和知识图谱等 AI 综合能力,在特定场景下的 AI 体验打磨,将使得 AI 技术从“旧时王谢堂前燕,飞入寻常百姓家”,这是以语音交互为代表 AI 能力破局的关键。语音交互的发展也不单单是单一的从语音这个维度进行发展,而是在具体场景下,综合视觉、语义、对话、通讯等技术在内的综合性技术。在这一发展过程中,场景化数据的积累和用户反馈的收集将成为成败的关键。贾磊认为语音交互的算法能力,针对特定的个人和特定的场景,做充分的打磨,应该是能够满足特定需要的。“打磨”的过程,需要我们更清楚的理解用户的场景,同时反馈个性化场景化数据。未来语音交互的成熟,一定是伴随着个性化和场景化的聚焦而实现的。

谈谈新冠疫情给 AI 行业带来的影响

贾磊认为,类似新冠疫情这样的事件,确实是对人类社会的生产和生活产生了巨大的影响。新冠疫情将使得非接触生产和生活成为社会生活的必要组织部分。为非接触生产和生活服务的一些语音交互技术,也会得到持续的发展。比如音视频通讯技术,在疫情时代就得到了很大的发展,伴随音视频通讯的在线翻译需求就会继续增加。在线会议内容的实时识别和翻译系统、音视频通讯的内容分析和挖掘等也都会蓬勃发展。这些都对语音技术的发展提出了更高的需求。全社会应对疫情,很多也是靠科技手段,语音技术在这个过程中,也起到了很大的作用,比如语音自动外呼业务,对于落实人员状态,沟通紧急信息,都起到了不可缺少的作用。

智能语音未来发展趋势展望

在谈及智能语音未来发展时,贾磊认为,基于 AI 语音芯片的端侧语音交互、多模态语音交互以及个性化语音交互是他个人比较看中的语音交互的发展方向。以上 3 个领域是他觉得很有希望的语音技术发展方向。百度语音团队会发展端侧 AI 语音芯片,端侧执行语音交互,云端定义语音交互,沿着视觉语音一体化和语音语义一体化的发展方向发展多模态交互技术。针对语音交互的环境噪音和个体口音差异,发展个性化语音识别、个性化语音合成和情感语音合成等个性化相关的语音交互技术,让语音技术不但可靠流畅还同时具备亲情和温暖。

讲师简介

贾磊,男,1975 年生人,2003 年中科院自动化所获得博士学位,现任百度语音首席架构师。2010 年加入百度,组建了百度语音团队,主导研发了百度语音识别和语音合成等一系列百度自有知识产权的语音核心技术。2012 年,贾磊在百度内部首次推动深度学习技术落地在语音搜索产品。之后又研发了百度语音输入法、百度地图语音交互等一系列近场语音识别产品。2016 年短暂创业后回归百度,又主持研发了小度智能音箱的远场语音交互系统、小度车载语音交互、百度鸿鹄语音芯片、百度智能语音呼叫中心系统、百度信息流的语音合成播报系统、百度如流的音视频通讯系统等一系列百度语音类产品并将相关技术推向中国社会。截至 2020 年第二季度,小度语音助手累计激活设备数超过 4 亿台,百度大脑 AI 开放平台的语音日均调用次数超 150 亿次。

贾磊 2014 年获得北京市科技进步二等奖、2015 年获得全国劳模称号、2018 年获得中国专利银奖、2018 年和 2019 年贾磊两次获得电子学会一等奖。

本文转自 公众号:AI前线 ,作者孟夕,点击阅读原文