作者注:原文最初发表于2017年11月22日,以《gui扯:阿里云专有云、超融合、AWS以及张北二期》为题,回顾了云栖大会和夏天探营张北二期工程的感悟。

十一过后,十九大之前,到杭州的云栖大会上学习了几天。信息量有点大,不如随意八卦一下以大会现场演示断电而引发关注的阿里云专有云。

这回八卦的主题是“规模”,从几个关于规模的段子开始哈。

本世纪初,招商银行已经颇具规模,但在存储市场老大EMC那里,却还要屈身于“中小企业”的行列。据说EMC的逻辑很简单——买了他家高端的Symmetrix,才算大型企业。以此标准衡量,当时够格的用户,无非四大行加三大运营商罢。

规模够大的用户必然是少数,由此引发了另一个段子:据曾经负责高端存储市场工作的前EMC员工忆往昔,当年的客户活动上,礼品可是全套高尔夫球具的哦。单个客户对应的采购价值很高,you deserve IT。

上面两个例子,或年代久远,或道听途说,不一定足信,进入呆鹅的恶魔城兄弟们不要来砍我。

不过,多即是少,少即是多,确是规模相对论。

昔日拥有#企事录#公众号时撰写的“基建之美”系列文章,其中有一篇连载详解互联网数据中心规模效应

接着讲两个云栖大会上耳闻目睹,还算新鲜的段子。

与一位在阿里的朋友闲聊,ta感慨:我们小部门,哪比得了阿里云。

so问:你们部门多少人?答曰:才一千多。

这让从未在千人级别规模的公司工作过的我等吃瓜群众,情何以堪!

在上万人大公司工作过的朋友们肯定不以为然,那就听听这样的段子是否够劲:乃们服务器数量在10万、20万台以下的小企业……

遗憾(唯恐天下不乱),没人被恶魔(城)附体,这真的只是个段子,是我短暂“幻听”的结果——当时,差点儿就起来high了。

真相是,为了进一步了解本届云栖大会上发布的明星产品——“欲说还休”的神龙(X-Dragon)云服务器——我去弹性计算企业线峰会一探究竟。

原话是这么说的:今天的标准服务器效率很高,插在标准的机架、插上网线就可以工作,但这是对小企业,对10万台、20万台以下级别的企业,才会有用。但是未来我们整个数据中心,可能是百万台、甚至上千万台服务器在一个数据中心,如果还使用这个标准,意义就不是很大。因为机房都是你的,里面所有的基础设施都可以自定义了,为什么还要跟随一个二三十年前定的标准呢?

这段话的中心思想,特别是互联网巨头定制化服务器与大规模数据中心的关系,我是举双手赞成的,也从《数据中心2013:硬件重构&软件定义》开始,陆陆续续写过不少文章(可在本公众号之前发表的文章中查看),为此大势鼓与呼。

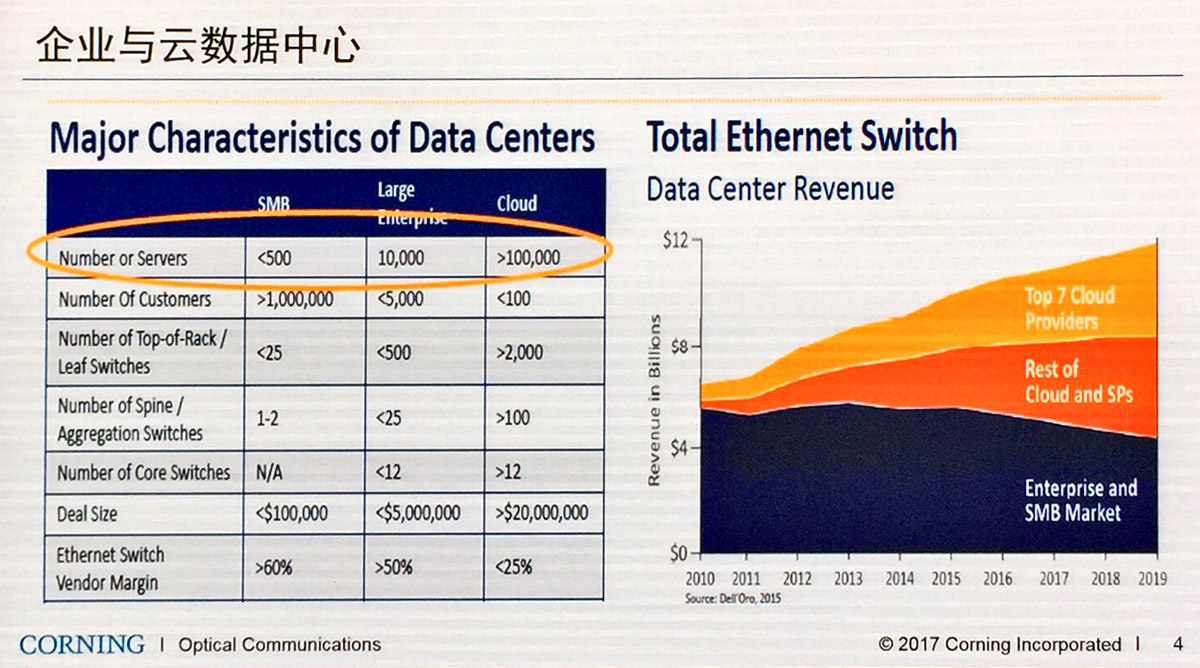

康宁对大型企业和中小型企业的划分比较符合日常认知,服务器数量超过10万台的云计算企业已经是全球前几十大客户之一啦。当然,做这些客户的生意,供应商的单位利润也会比较低

值得探究的是数字背后的含义,即使不那么精确。

数据中心与服务器

服务器保有量在10万、20万台级别的企业,全球范围内都到不了三位数,在国内肯定是Tier 2互联网公司中的翘楚了,可以说仅次于BAT(譬如京东、360)。就是整个阿里,目前的服务器保有量“也才”五六十万台,还不至于鼻孔朝天。

因为,眼睛正要向前看呢。

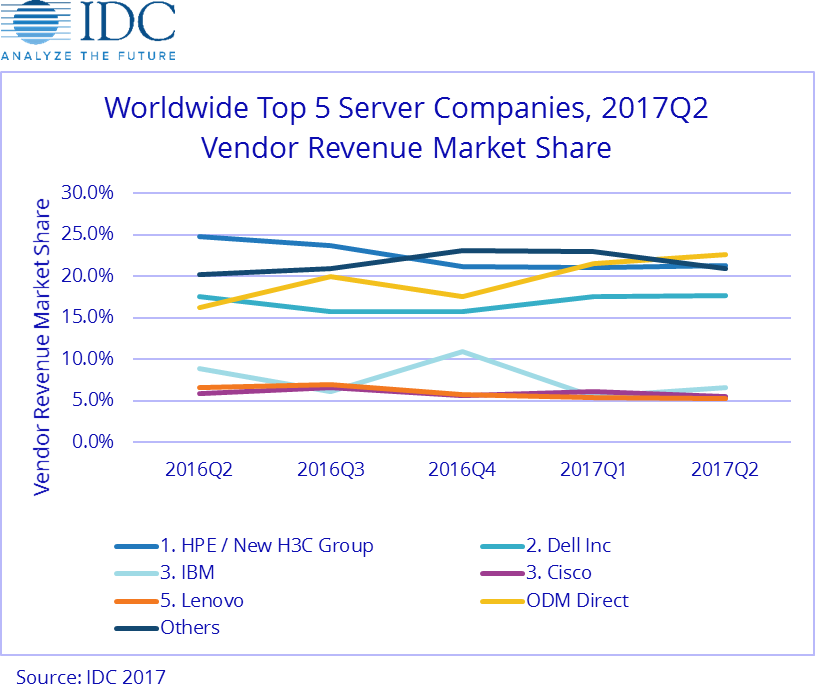

就在云栖大会召开前一个月,IDC公布了2017年第二季度全球服务器市场追踪报告,有两项数据值得拎出来说道说道:

首先,仅AWS一家就贡献了超过10%的服务器出货量——也就是说,当季总的服务器出货量为245万台,而AWS的采购量即达25万台。大约两年前,AWS每季度的采购量还“只有”15万台左右。

其次,在以AWS为首的超大型云计算/互联网公司(Hyperscaler)的带动下,多家ODM直销(ODM Direct)的总和首次超过市场份额第一的厂商,达到22.6%,领先HPE/新华三达1.3个百分点。

原本在IDC的2016年第二季度统计中,ODM直销(ODM Direct)总的市场份额只有7.9%,但是今年IDC完成了对2013年的ODM直销收入数据的历史修正——结果是ODM们平均每个季度的收入平均增加超过10亿美金,导致2016年第二季度的占比跃升为16.2%,而2017年第二季度的增长率又接近50%,于是市场份额历史性的蹿升至第一位

ODM厂商直接向AWS(Amazon Web Services,亚马逊网络服务)等超大型客户提供定制的服务器产品,而我们常说的白牌(white-box)服务器仍以传统标准化的通用产品为主,不可简单的混为一谈。

依靠着如此疯狂“买买买”的节奏,亚马逊的服务器保有量飞速增长,保守的估计也得有三百万台了罢。据说,AWS在(美东区)弗吉尼亚州Ashburn的数据中心园区,就有50万台服务器之多。

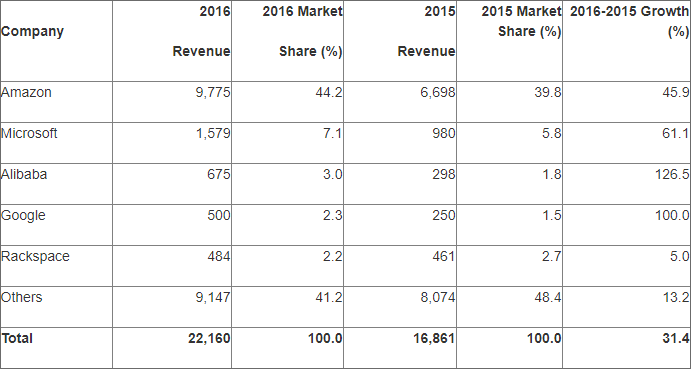

AWS显然是阿里云追赶的目标——根据Gartner在9月底公布的数据,阿里云在2016年的IaaS(Infrastructure as a Service,基础设施即服务)公有云服务市场的份额排名第三,相对于2015年的增长率达126.5%,是前五名中唯一年增长率超过100%的,两倍于第二名微软还多一点儿。阿里云希望在高增长率的支撑下,于未来一两年内超越微软,坐二望一。

要达成上述目标,必然伴随着数据中心的大幅扩张。阿里巴巴在张北的云计算数据中心项目众所周知,去年投产的一期工程覆盖小二台和庙滩两个点,共投资约40亿元、占地120亩,可容纳8万台服务器。今年紧接着开工的二期工程补上了中都草原,三点齐出。7月中旬,我专程去张北遥望了建设中的工地,看起来每个点的二期都比一期大很多,哪怕说二期每个点都有10万台(1号园区和2号园区,张北地区总的规划目标为30万台)服务器,也是有可能的。

以小二台镇、庙滩、中都草原的三点式布局开篇,这个宣传材料的文字概括了整个阿里巴巴张北云计算数据中心项目的关键指标,其中的几幅效果图揭示了二期工程的布局,在适宜的时机我会专门撰文详细解读

当然,从规划来看,30万台服务器应该是一二期工程相加的结果。即便如此,在国内也是非常大的数据中心集群了。毕竟,不同于那些按照机房面积和机柜数量来列出能容纳服务器数量理论值的“超大型数据中心园区”,张北这三个点建成后是真的可以容纳30万台服务器一同工作的。

分离与(超)融合

服务器和数据中心之间的关系简单直接,那么,云服务的技术架构又会对数据中心产生怎样的影响呢?不妨看看阿里云的分布式块存储技术。

云栖大会最后一天下午举行的块存储技术解析专场,据说是云栖大会有史以来第一次讲块存储技术,所以简要回顾了一番发展史。

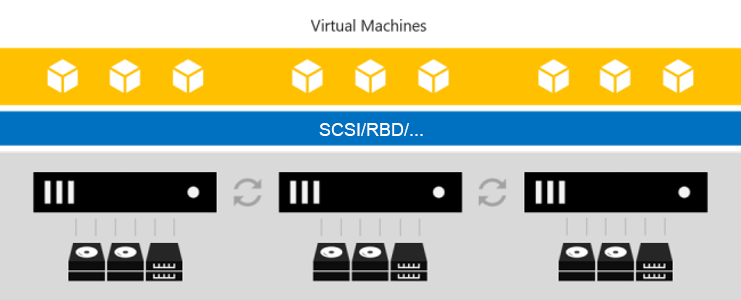

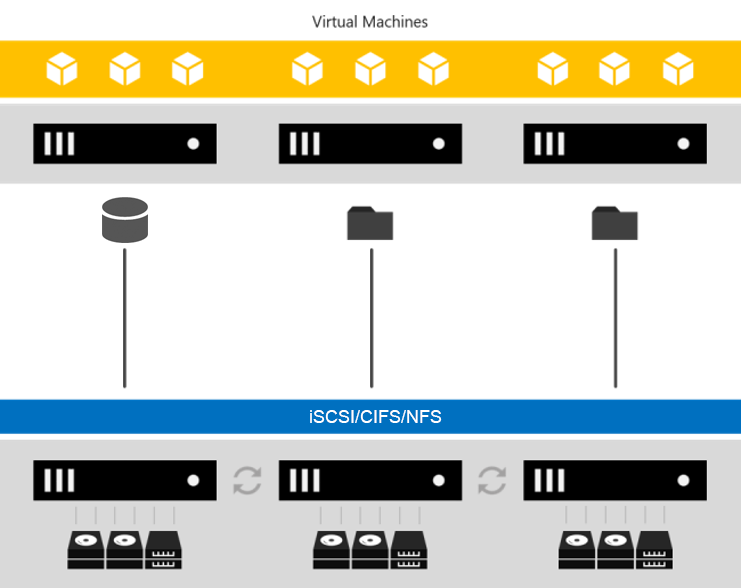

阿里云的分布式块存储始于2010年,第一代产品主要基于SATA硬盘和千兆以太网(GbE)。由于网络不行,数据需要本地化,于是采用了计算与存储一体的融合架构——在企业级市场,这叫超融合架构(Hyper-Converged Infrastructure,HCI)。计算与存储融合的好处是不用区分机型、机柜和物理POD,把机器塞到机柜功耗上限就行了,网络流量模型和IDC机房建设都相对简单。

超融合能简化IT基础架构的部署和运维,这点在传统企业级市场和大型互联网公司是一样的。问题在于规模,特别是在大规模云服务的场景下,超融合架构面临很多挑战,最典型的问题是——用户把计算资源买光了怎么办?存储资源可能还有大量剩余。计算和存储资源需求严重不匹配,而且计算和存储耦合在一起也会相互制约,限制规模的进一步扩大,同时不利于各自的硬件专精发展——类似观点,可参考《超融合架构的“逆流”?(存储峰会演讲实录)》一文。

2012年,随着SATA SSD(Solid State Drive,固态盘)和万兆以太网(10GbE)的普及,阿里云的分布式块存储产品升级为第二代,从硬件到软件,都实现了计算与存储的分离部署。在随后的几年中,第二代分布式块存储产品支撑了ECS和容器等服务的发展。

第二代分布式块存储采用Master/Cluster/Server三层架构,前端VM磁盘和后端Server一一对应,有性能上限,被称为分离架构1.0。随着NVMe和3D XPoint等新型存储介质、100GbE/InfiniBand/RDMA等网络技术、SPDK/用户态文件系统等软件方法逐渐涌现及扩散,阿里云在2015年启动了向第三代分布式块存储产品的演进,采用分离架构2.0,据说在12月的云栖大会·北京峰会上将有新的发布。

计算集群与存储集群分离的架构对神龙云服务器尤为重要,因为从目前已知的神龙云服务器架构来看,每个节点上只有CPU和内存等计算资源,需要通过(虚拟)网络访问(外部)存储资源。

别忘了,还有阿里云专有云。

专有云的玄机

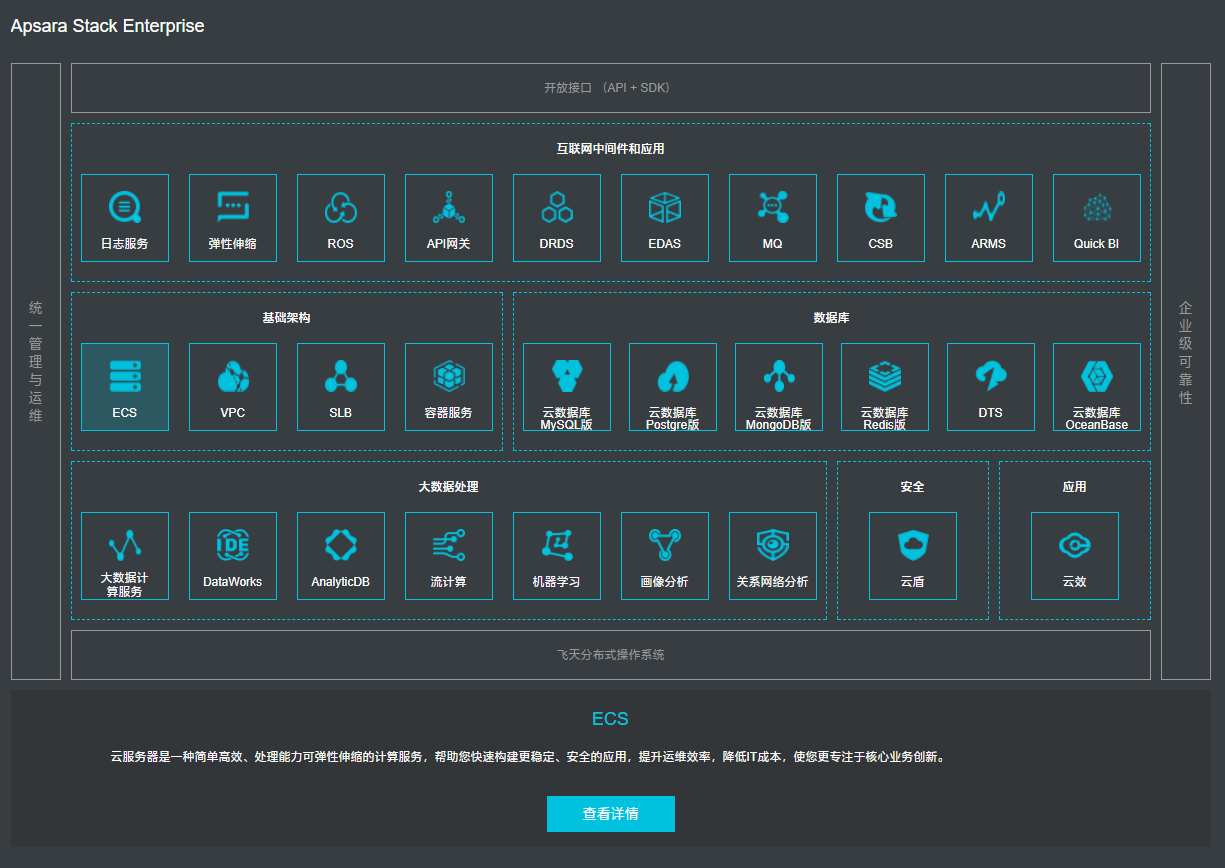

基于阿里云飞天架构的阿里云专有云(Apsara Stack)并非新生事物,却因为本届杭州云栖大会第二天主题演讲上的断电演示而收割大片关注,会议期间还让大家体验了好几次。

由于整日流窜在偌大的展区赶场,我错过了亲自体验给专有云拔电(其实主要是满足破坏欲)的机会,倒不觉得特别遗憾。因为现场演示的系统分布在8个机柜上,只要规划得当,随便断掉其中任何一个机柜的供电,服务并不会因此而中断,对云计算的这点信心我还是有的。

我关注的是Apsara Stack Enterprise的最小规模,部分原因是有江湖传言说这个“基于阿里云飞天架构的全量云平台”集群规模不能小于60个(物理)节点,更详细的说法是其中有10个作为管理节点,其他50个节点提供计算和存储等服务。具体数字有待进一步考证,总体上我倾向于赞同公众号“飞总聊IT”的观点:类似“飞天”这样的系统,本来就是为了大规模数据中心应用设计的。一个数据中心有成千上万台机器,为了能更好更自动化的运行,先弄出几十台机器专门做部署、监控、调度等管理工作,其实性价比很高。但如果服务器总共就几十台,“管理层”们还是要吃掉很多,部署完可能就没剩多少机器(可用资源)用于对外的服务了。也就是说,专为大规模部署而设计的系统,在规模很小的情况下利用率不高,甚至根本无法满足部署要求,有点和前面提到的超融合架构各擅胜场的意思。

这套系统看起来要用的机器就不会少

云栖大会现场演示的阿里云专有云系统由2个集装箱数据中心组成,每个集装箱里有4个服务器机柜,8个机柜共有62台服务器。

服务器是一水儿的新华三(H3C)R4900 G2(激凸?),很主流的2U双路至强E5-2600 v4服务器。我们知道2U机架式服务器各方面相对均衡,可计算可存储,譬如前面板插满盘就可以视为存储型服务器或计算存储兼顾的超融合节点。不妨按照这种“以貌取机”的方法,把那62台服务器分为两类:前面4个(少数有8个)2.5英寸10K(小容量)SAS盘的是计算型节点,前面12个3.5英寸7200转6TB SATA硬盘的是存储型节点——对演示系统而言性能也够了,再说机器内部很可能有SSD作为缓存。

粗略统计(因为不能保证完全没看错),共35个计算型节点,27个存储型节点,相对均匀的混部于8个机柜上。管理节点应该出自计算型节点,所以:

10×管理节点 + 25×计算节点 + 27×存储节点

看起来是个比较合理的搭配,每个机柜上的服务器数量不超过8台,整组掉电可以接受。

捕风捉影的胡乱分析一番,主要目的是抛砖引玉,激发更多思考。不过,有一点是基本可以确定的,即IaaS公有云市场上的前三名都有意愿用自家的软件堆栈去占领私有云市场,但要么很难搬得下来,要么下来还是嫌大,只好通过合作或变通的手段:

AWS选择了与VMware合作,推出VMware Cloud on AWS;

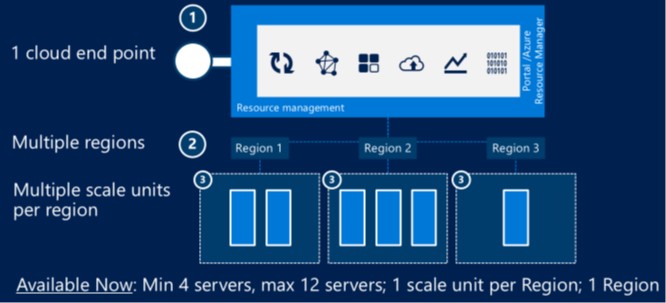

微软专门开发了一套采用(超融合)一体机方式部署的软件堆栈,实现与其Azure公有云兼容的功能,叫做Azure Stack(可以视为Azure的功能精简版),一个区域(Region)最少4台服务器,最多12台服务器(下一阶段扩展至16台)——这很超融合;

阿里云专有云(指Apsara Stack Enterprise)60台级别的起点对多数企业还是太高了,自行精简尚需时日,所以先选择基于ZStack的轻量级云平台ZStack for Alibaba Cloud作为在私有云一端的补充,双方围绕神龙云服务器也有紧密的合作。

严格来讲,阿里云专有云由一系列不同定位(和来源)的产品构成

哎,没想到越扯越远……八卦了一大圈,总算回归主题,可以告一段落啦。