记得大约是5年前,SSD的(单体)最大容量首次超过硬盘。我突然萌生了一个幼稚的想法,要查一查全球NAND Flash(闪存)的产能有多少……这个“幼稚”当然是全方位的,核心驱动力还是想了解:如果机械硬盘(HDD)真如某些个人消费者所愿的凭空消失了,光靠(基于闪存的)SSD,容量缺口会有多大?

现如今,在售硬盘的最大容量为20TB,而固态盘(SSD)的最大容量已经在30TB以上,超出一半还多。然而,到了需要为信仰充值的市场上,容量的主要贡献者仍然是硬盘。

2020年的硬盘和SSD市场(来源:Trendfocus)

| 出货量(百万计) | 同比增长 | 容量(EB) | 同比增长 | |

|---|---|---|---|---|

| SSD | 333.120 | +20.8% | 207.39 | +50.4% |

| HDD | 259.810 | -18% | 1.018.32 | +13% |

2021年2月,Trendfocus公布了2020年NAND/SSD出货统计,有两个“首次”:

- SSD的出货量首次超过硬盘,达3.33亿,硬盘非常接近2.6亿;

- 硬盘总容量首次突破1ZB(1018EB),SSD仅为207EB——几乎5倍的差距。

单体容量大不算大,单位容量大才叫大。根据Trendfocus的数据统计出单位平均容量,SSD不到630GB,硬盘接近4TB,是前者的6倍以上。结合其他数据也不难得出结论:SSD对硬盘的替代主要发生在客户端,数据中心和云一侧的容量需求还是要靠硬盘来满足。

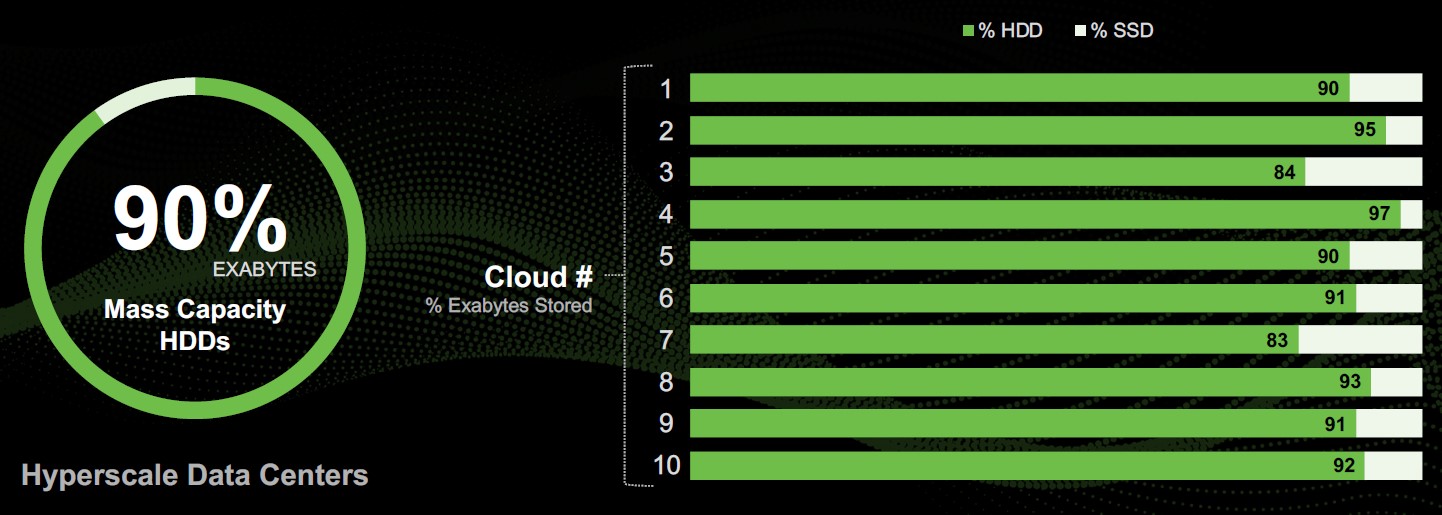

IDC对全球8个超大规模用户(美国FAMGA+中国BAT)2019年存储使用情况的统计表明,硬盘总容量在SSD的9倍以上。调查范围扩大到10家,硬盘存储数据的占比仍然超过90%。

全球领先的云数据中心,约90%的数据存储在大容量硬盘上

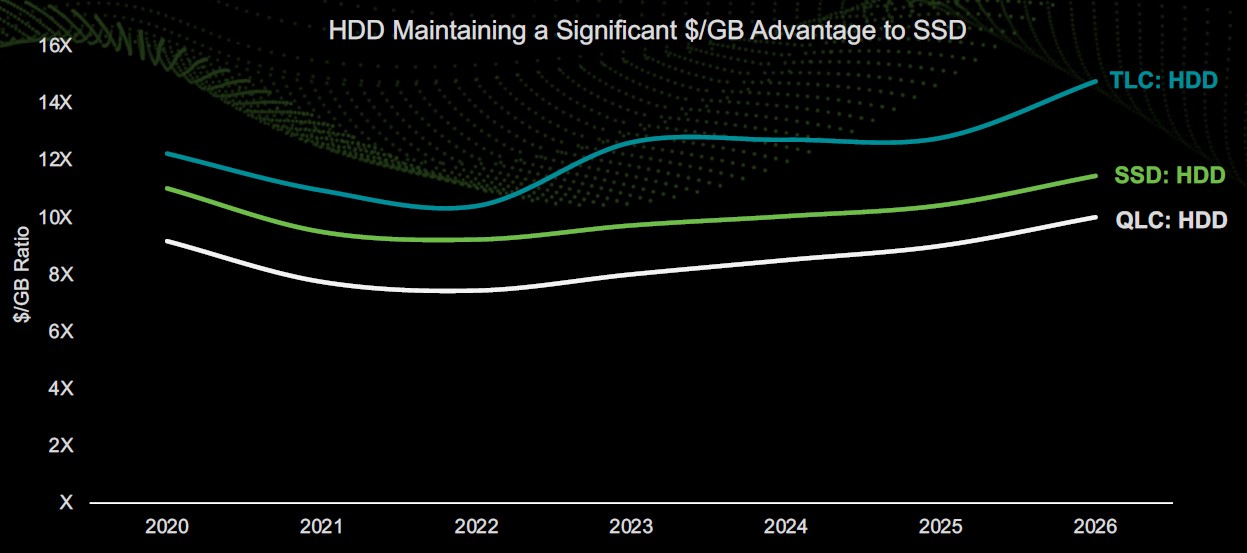

原因很简单,在大容量区间,硬盘的成本比SSD有明显的优势。SSD的单位容量价格是硬盘的10倍左右,需要存储的数据越多,越不可能无视这么大的价差,毕竟地主家也没有余粮呀……譬如Facebook就曾表示,当SSD的价格(下降)到硬盘的2~3倍时,才会考虑完全转用SSD。

不过,我们要用发展的眼光看问题。如果在最大单体容量上,SSD能持续拉开与硬盘的差距,那么总有一天,“中小容量”的SSD就可以与大容量硬盘PK价格了,届时硬盘还有什么优势呢?数据保存时间吗?

以单位容量成本而言,机械硬盘仍低至SSD的十分之一左右

“(从历史数据来看)NAND价格下降稳定在每年不超过20%,这样SSD也要10年才能达到今天硬盘的价格水平。”可是,假设硬盘的容量提升从现在起突然停滞,那么,只需要6年左右的时间,SSD的价格就可以下降到2~3倍于硬盘的区间……岌岌乎殆哉。

不管你是乌龟还是兔子,躺下睡觉,或是原地踏步,被追上的时间都会提前到来。

世纪之交,昙花一现

核心技术的重大突破,是高科技产品走向黄金时代的开路先锋。

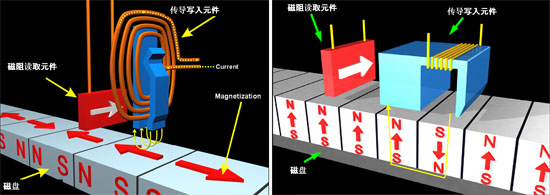

1988年,巨磁阻(Giant Magneto-Resistance,GMR)效应被发现。几年之后,IBM率先研制成功基于巨磁阻效应的读出磁头,并于1997年率先应用在其硬盘驱动器(Hard Disk Drive,HDD)产品中。

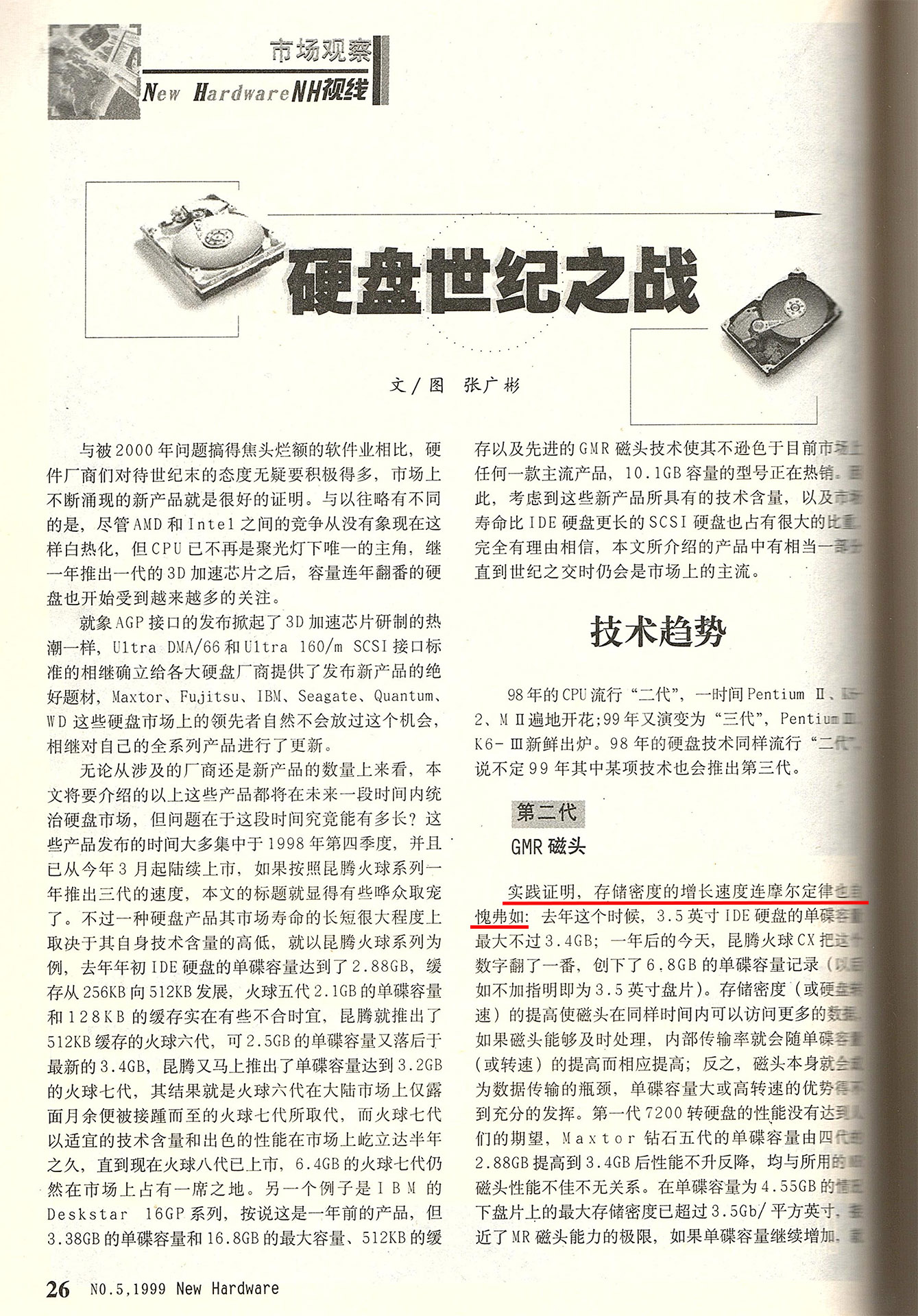

随着各种MR磁头乃至GMR磁头的广泛应用,硬盘的容量在世纪之交迎来高速增长。1999年初,我在为《微型计算机》撰稿的过程中,发现市售硬盘的磁录密度(面密度,areal density),在一年间翻了一番,不由得感慨“存储密度的增长速度连摩尔定律也自愧弗如”——在类似表述的克莱德定律(Kryder's law)被提出的2005年,硬盘存储密度的增速已经明显回落了。

那段时间的硬盘行业有多“膨胀”呢?说个零零后可能不会相信(或者说并不关心)的事实:当时机械硬盘在微型化上颇有建树,甚至打入了以iPod mini为代表的MP3播放器市场。

不难想象,以手机、平板电脑为代表的移动设备,对存储部件在形状/尺寸适应性、健壮性(如抗冲击)、访问特性等各方面的诉求来看,固态存储原本就比机械硬盘更合适。但是,硬盘仅仅凭借那几年存储密度的狂飙突进,就可以容量优势“越界”抢固态存储的饭吃;那么,待到增长之势逆转,招致全面反击也就是意料中事了。

在这点上,和经济一样,保增长是关键。

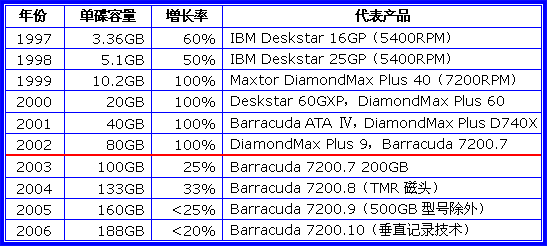

水平极限,垂直急转

根据我个人对市售硬盘的统计,3.5英寸硬盘的单碟容量(单张盘片的容量,在盘片尺寸不变的情况下,可以大致对应磁录密度)年增长率达100%的高光时刻,只维持了4年(1999~2002)。从2003年开始,单碟容量的年增长率就暴跌至三分之一以下了。

虽然来自NAND Flash(闪存)的威胁尚未显现,硬盘行业已经着手从纵向磁记录过渡到垂直磁记录。

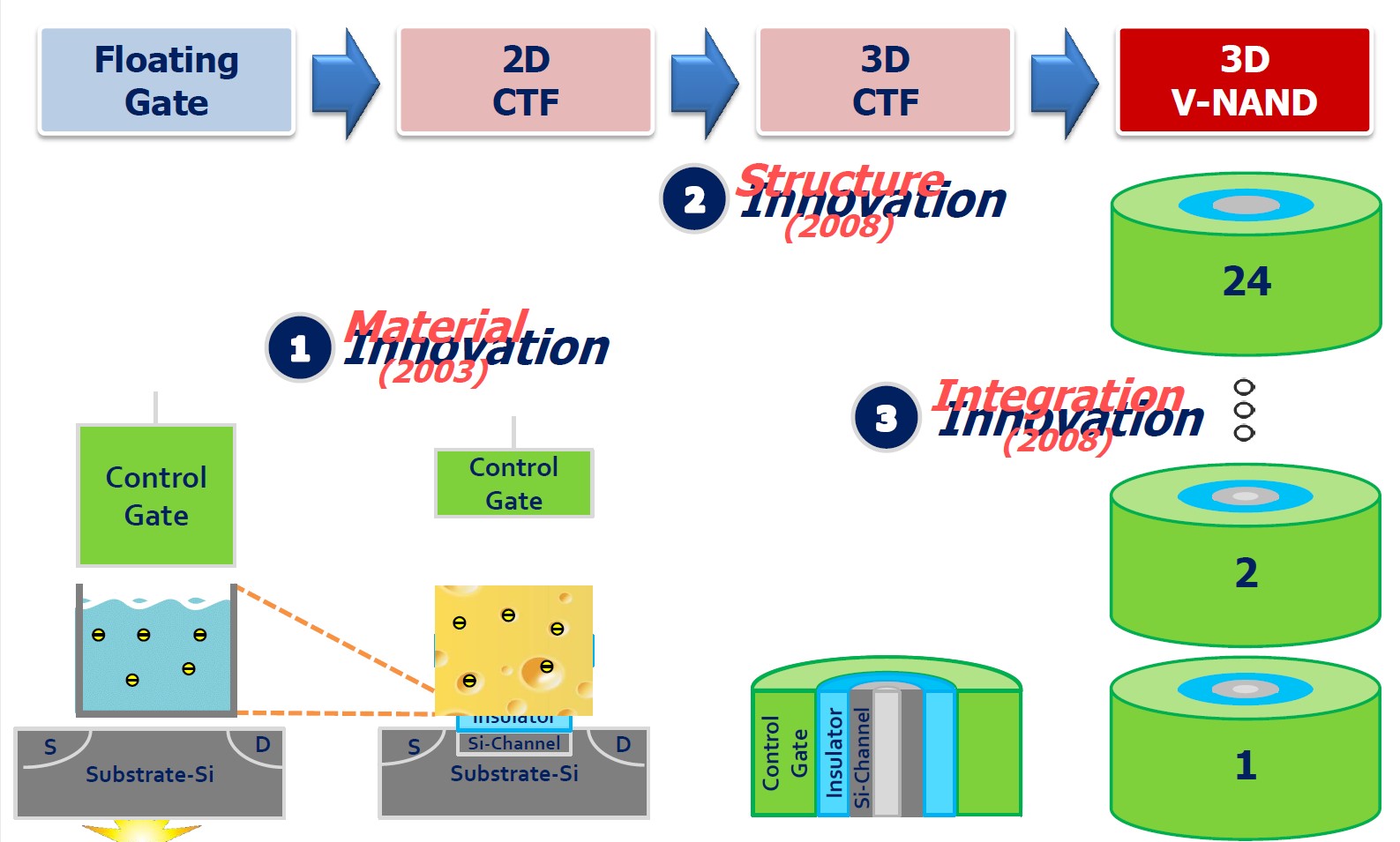

一些宏观的想法往往具备跨不同细分领域的适用性,哪怕是并无“血缘关系”的NAND闪存和磁记录技术。

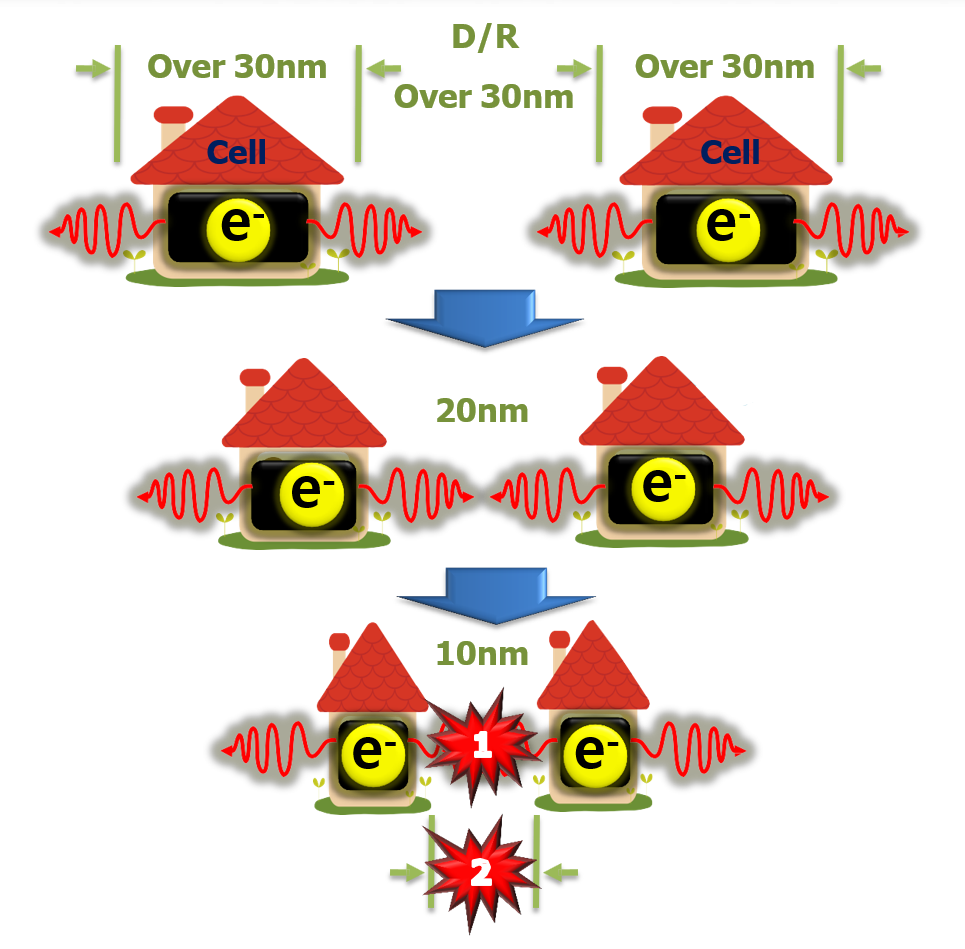

不太严谨的说,磁盘的盘片也好,闪存的芯片也好,都是通过在单位面积上增加存储单元的数量来达成更高的密度。在存储单元只分布在介质表面的二维状态下,存储密度的提升通常对应着存储单元体积的缩小。

闪存单元缩小、靠近后的互相干扰

在存储介质使用的材料没有改变的情况下,存储单元体积的缩小,意味着其可用的原子或电子总数的减少,所具有的总能量降低,更容易受到环境(如温度)或相邻存储单元的干扰而改变状态,影响数据存储的稳定性。当这种情况严重到一定程度,存储密度就不能继续提升了。

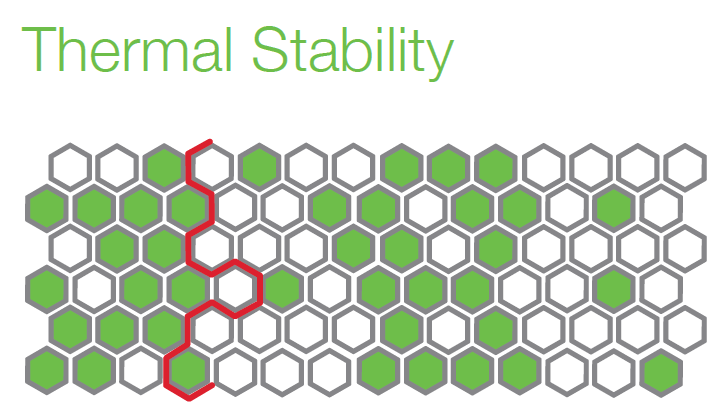

磁记录的1个数据位(本文所称的“磁位单元”)由多个磁粒组成,当超过一定比例的磁粒翻转(如图中红线圈住的白色六边形),导致信噪比(SNR)过低,数据位便无法正确读出

具体到硬盘,有个对应的术语叫“超顺磁”效应(superparamagnetic effect),即是说当磁粒的体积缩小到一定程度,只需要很小的能量(譬如室温下的热能)就可以使其磁化方向翻转,导致磁位单元保存的数据位(bit)被破坏,无法再正确地读出。

不能无休止的减小存储单元(尺寸),又想继续提升存储密度?那就改变存储单元的排列方式,以延缓其体积的下降。

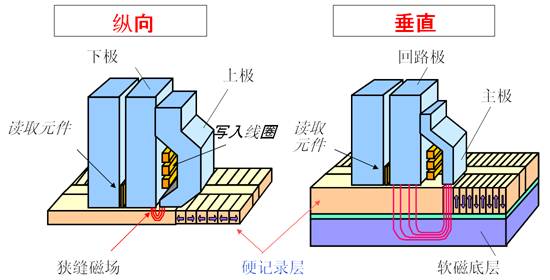

纵向(水平)磁记录与垂直磁记录

上个世纪的硬盘基本上都采用纵向磁记录(Longitudinal Magnetic Recording,LMR)技术,磁位单元的磁化方向与盘片表面平行,沿着盘片旋转的方向(圆周)排列构成磁道,磁极相邻,首尾相接,即所谓的“纵向”(longitudinal也有“水平”之意)。不过,垂直磁记录的历史也不算短,(开山祖师IBM的)第二代硬盘就试图采用之,1976年已有完善的理论支撑。

垂直磁记录(Perpendicular Magnetic Recording,PMR)的“垂直”是指,磁位单元/磁粒的磁化方向与盘片表面相垂直,由原来两个磁极和整个磁体都位于盘片表面,转为只有一个磁极位于盘片表面,而磁体和另一个磁极都埋入磁层中的结构。如此一来,可以通过增加磁层厚度,抵消磁粒占据盘片表面积的缩小。

这种将存储(基本)单元翻转90°排列的方式,是不是让你想起了后来的3D NAND?这个“起手式”看起来确实很相似,但是机械硬盘读写头与存储介质相分离、通过磁场去改写或读取数据的特性,决定了磁位单元不能多层堆叠,也就是依然停留在2D,并没有继续发展为3D的“后手”。少了一个维度,增长潜力自然不可同日而语——就像平房很难和楼房比总的建筑面积一样。

2D变3D的关键一步,就是闪存单元结构方向的改变(步骤2)

3D的威力着实了得,一投入量产就是24层,到了第三代的48层,就帮助固态盘(Solid State Drive,SSD)实现了单体容量对硬盘的超越。不到八年的时间,3D NAND已经奔着200层去了。

作为对比,我们可以看一下机械硬盘在盘片层面的堆叠。通过填充密度低、阻力小的稀有气体氦(Helium)并密封盘体的手段,所谓的“氦气密封硬盘”能够把标准构型(1英寸厚)3.5英寸硬盘所容纳的盘片数量,从4~5个提升到8~9个——也不过就是一倍而已,何况NAND闪存在芯片层面的堆叠更凶残,还是拼不过。

到头来,终归要靠磁记录技术的进步谋求可持续发展,而垂直磁记录从2006年走向普及以来,硬撑了十多年,潜力已消耗殆尽,却还没等来援军。

尽管,援军的身影甚至更早浮现。

HAMR,“无间道”

垂直磁记录的“援军”中,有一个帮手,一个接班的。

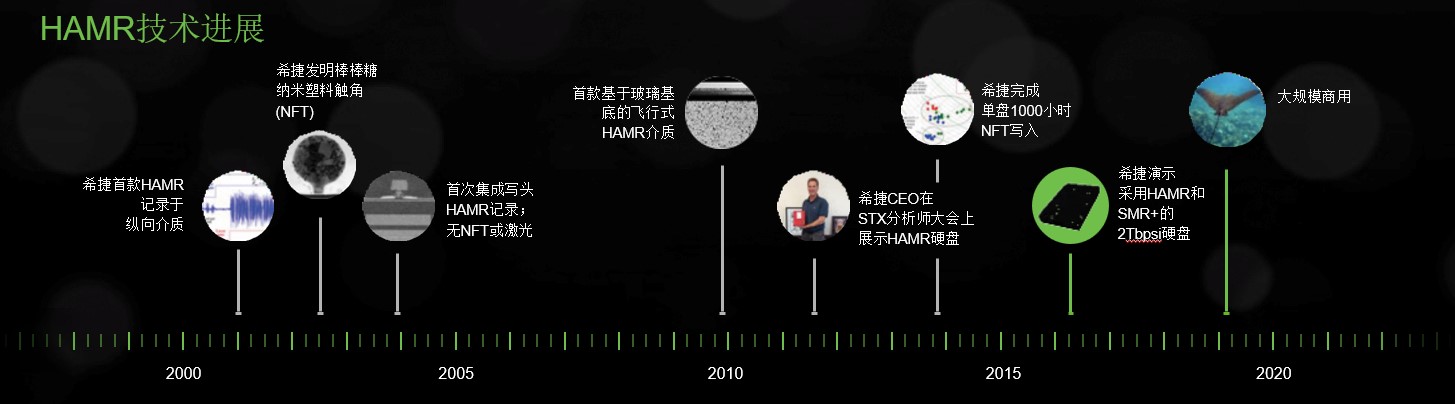

大约在2001年底,希捷(Seagate)公司在纵向记录介质上首次实验了热辅助磁记录(Heat-Assisted Magnetic Recording,HAMR)技术。2002年8月,在位于宾夕法尼亚州匹兹堡的研发中心开幕庆典上,希捷演示了HAMR技术。

我本有机会参加庆典现场观摩,但最终没有去成。据说,按照当时的技术路线图,HAMR被引入市场还需要五六年的时间。

这一年的晚些时候,电影《无间道》在香港上映。在短短一年的时间里,《无间道》三部曲全部面市。

仅从字面意义来说,“无间道”三个字非常适合代称另一项硬盘技术。

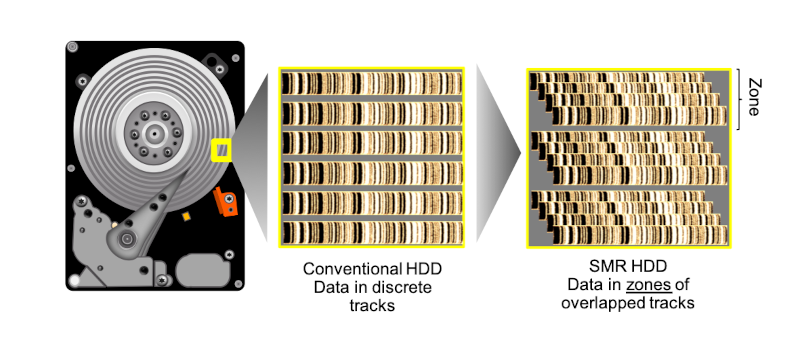

我们知道,硬盘盘片上的磁道是一个个的同心圆,彼此间有一定的(径向)距离。随着磁头和介质技术的进步,磁道逐渐变窄,间隙也在变小,但终究还是存在。

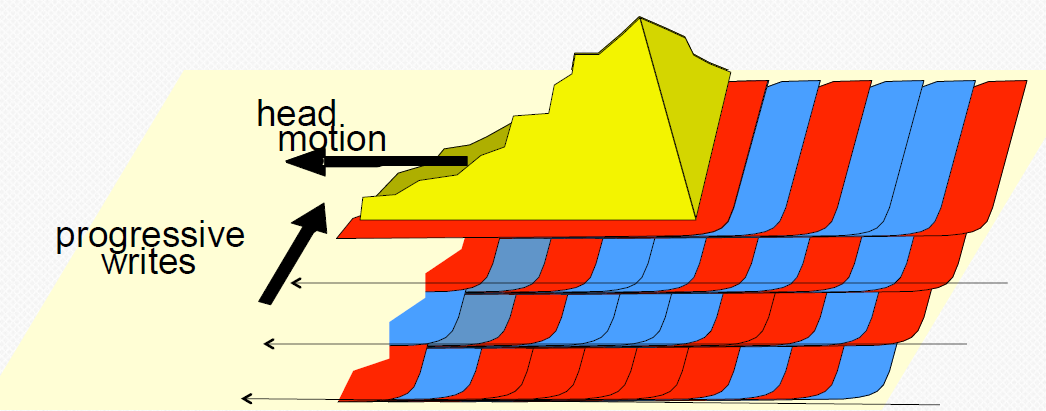

“无间道”的主旨就是消灭这些磁道间的空白区域,充分利用盘片的表面积。更确切的说,相邻的磁道之间不仅没有空隙(无间道),而且有一定的重叠,这样一圈压一圈的下来,很像屋顶上层层叠叠的瓦片,所以得名为叠瓦式磁记录(Shingled Magnetic Recording,SMR)。

SMR得以成立的基础是磁头上的读取元件小于写入元件,所有数据仍然可以从宽度变窄的磁道上读取,而不影响数据的完整性或可靠性。再者,SMR涉及的更多是软件层面的变化,并不需要更改磁头和盘片,也不用大幅增加生产投资,或许还真可以跟电影一年出三部类比一下。

既然这么好,为什么没有广泛应用呢?

因为写数据的代价有点大。

问题在于,SMR在原本相互独立的磁道之间建立起了关联性,这种磁道结构只适合顺序写入,或者说是按顺序在后面追加(append)数据。一旦你试图在前面的磁道上重新写入(修改)数据,就会摧毁相邻的一到多个磁道的数据——活在“无间道”上的数据,也是很危险的。

解决之道是把磁道“分区”(zoned),控制写入操作的作用范围。连续的磁道中间需要改写数据,那就是“牵一发而动全身”(起码也要动个半身)——先连同后面磁道上的数据都读入缓存,更改对应的数据后再整体重写。显然,随机写的性能必然会下降。

另一类做法是干脆把SMR定位在顺序写入场景,把分区设置为只能顺序写,或者顺序写优先。

SMR给随机写入数据带来的附加操作,不由得让人想起NAND闪存……但是,SSD能够消化NAND写入的复杂性,不会波及到应用;而SMR的写入要么可能导致性能不可预测,要么需要主机端(上层软件)介入管理,带来额外的开发工作量或兼容性问题。

总之,SMR技术不仅潜力较为有限(容量提升零点几到几倍),更有其适用范围和场景(如归档和冷存储应用),主要还是用来打辅助,没到山穷水尽,不宜全面推广。

尽管SMR本质上是一种磁道组织方式,必须与具体的磁记录技术如PMR配合使用,但在SMR出现之后,单纯的PMR就改称CMR(Conventional Magnetic Recording,常规磁记录),以与暗含PMR的SMR相区分。但是,随着“基石”PMR接近极限,加上SMR这个“放大器”也走不了多远了。

光热转换,排除万难

回到2002年的技术路线图,PMR的定位应该是给HAMR打前站,差不多三年后(2002+6 ≈ 2006+3)就可以交班了。

可谁承想“三年之后又三年,三年之后又三年……”等我拿到20TB的HAMR硬盘,已经19年过去了。

19年什么概念?2007年,巨磁阻效应的发现者们都拿到诺贝尔物理学奖了。

在技术研发期,希捷共制造约1万块HAMR硬盘

当然,这19年中并不都是“三年又三年”式的delay。譬如,在2018年底,希捷就利用HAMR技术达成了当时业界最高的16TB容量,略胜PMR+SMR组合一筹。

想当初,在大致了解HAMR的概念和规划之后,我有两个直觉上略存冲突的感受,对错放一边,可以作为梳理HAMR技术难点的辅线。

首先,感觉6年商用有点过于乐观了,但是也没想到要15年那么久(才接近商用)。

主要的顾虑在于,HAMR上的难度有点大——不仅盘片和磁头全要换,硬盘的复杂度也变得更多维:在原本的机械(力学)、电、磁之外,加入了光学和随之而来的热力学,可以说常见的物理学分支都用上了。

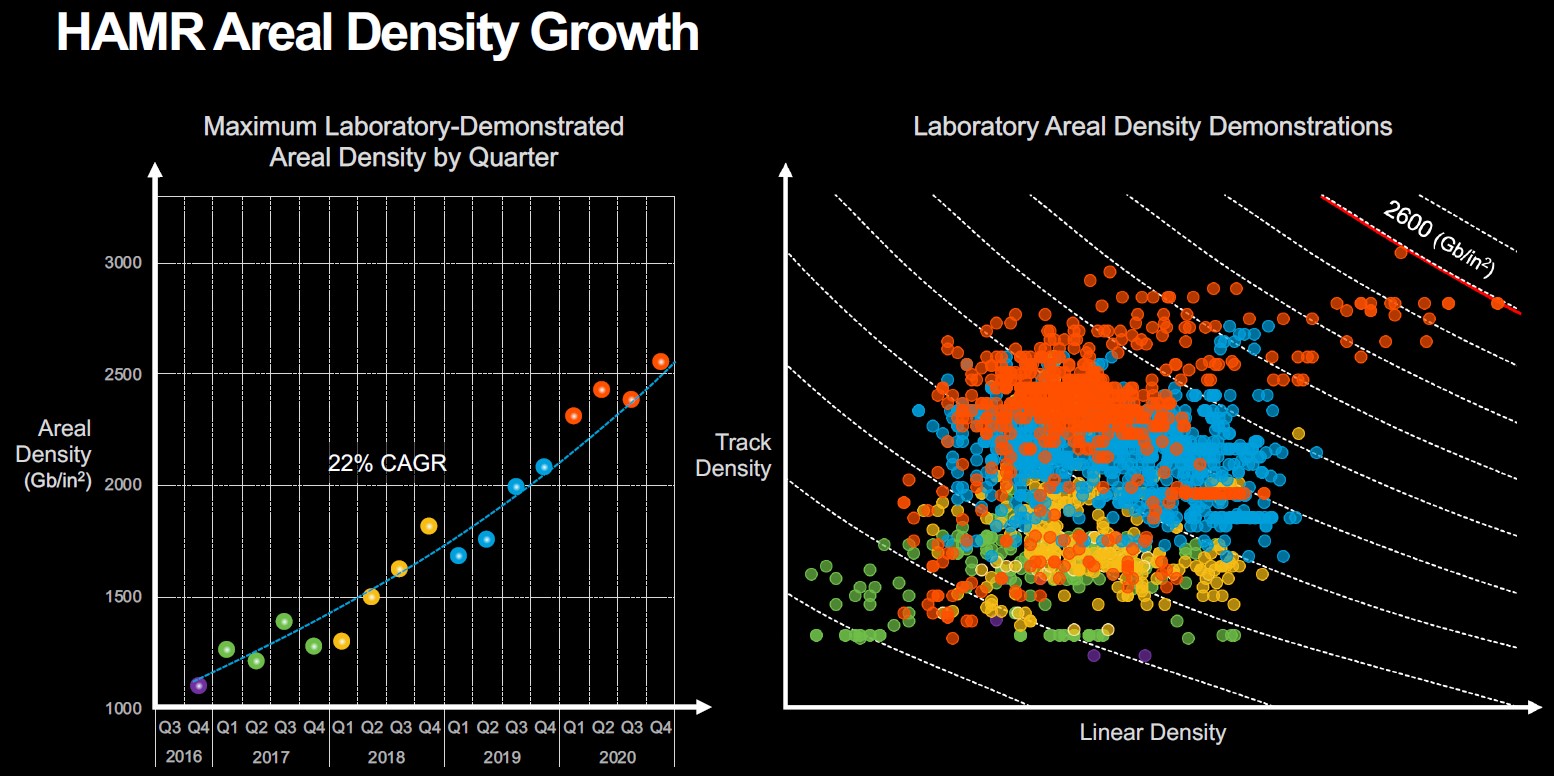

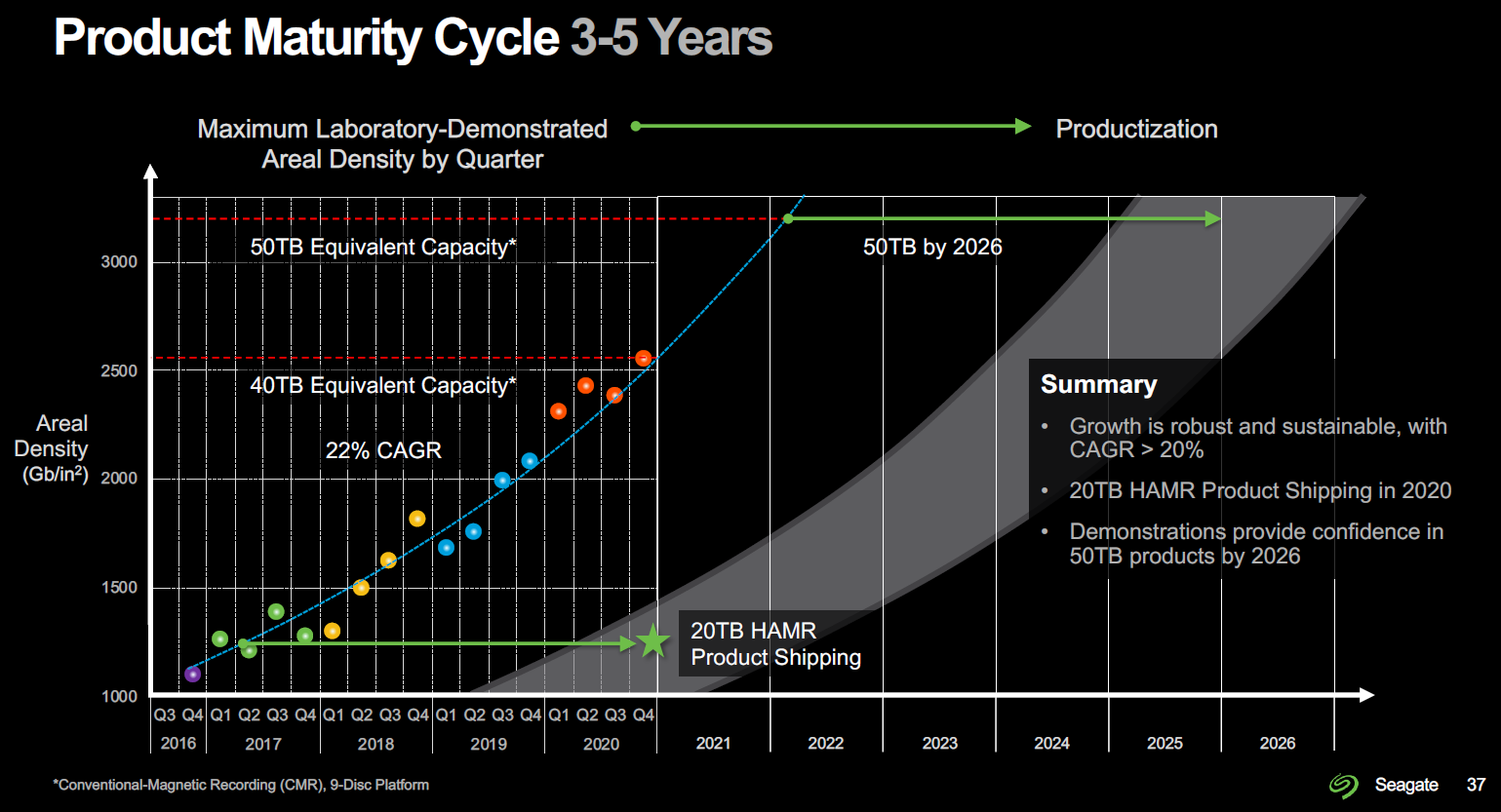

2017~2020年间,HAMR磁录密度的增长情况。注意看左边图:左下角紫色圆点代表2016年得出18TB等效容量对应的磁录密度,右上角橙色圆点代表2020年最大实验室演示磁录密度(2600 Gb/in²)

这一系列变化的开端属于化学(材料),即改变(磁记录)介质的“受”性,归根结底还是物理(磁学)需求驱动的。

如前所述,磁记录层无法3D堆叠,SMR又是“杀敌一千自损八百”的神经刀,继续减小磁位单元的尺寸和磁道的宽度(而不是强求“无间”)才是正途。

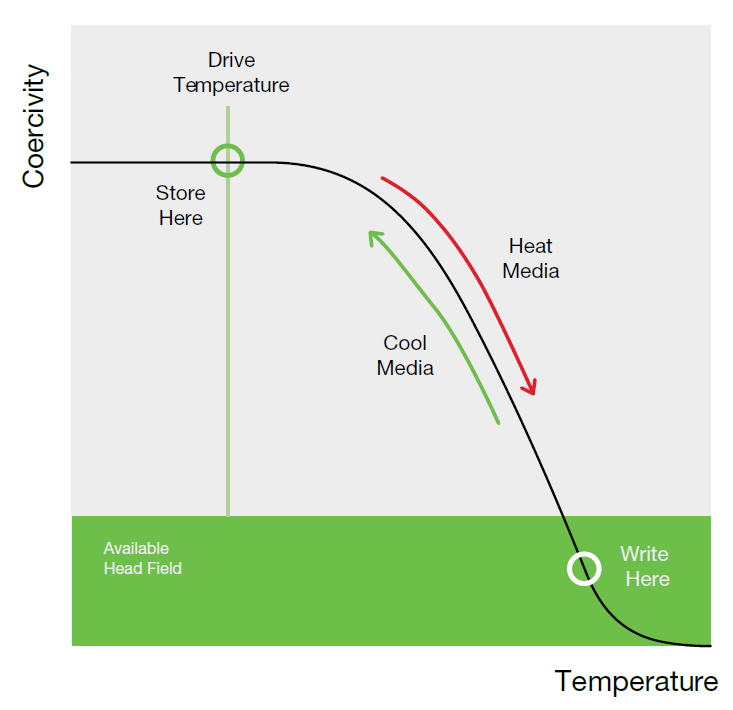

但是,如何避免超顺磁效应的出现,(起码)在室温下能保持磁化方向的稳定性呢?改用矫顽力(coercivity)更高的材料,譬如高各向异性的铁铂合金(FePt)介质。

是不是一看到“铂”这个字,一股浓浓的“稳定”气息就扑面而来?没错,铂君这“金设”真是稳稳的。

除了高矫顽力和很好的单轴磁晶各向异性,FePt还有很低的超顺磁临界尺寸(纳米级),拓展了继续做小的空间。

通俗的说,矫顽力就是磁性材料保持磁化方向的能力。矫顽力高,别说室温了,温度再上升一些,依然保持稳定。

然而,读写矛盾再次显现:读出来的数据是没问题了,磁头想要(在常温下)写入数据,得要多强的磁场?小小磁头上渺小的写入元件,没有那个能力呀……

HAMR用名字给出了方案:去它的常威……哦不,常温!用(加)热辅助记录(写入)。

利用矫顽力随温度升高而下降的特性,在高温下以正常的磁场强度写入

既然不能加强磁场来“硬的”,先升高温度来“软的”,让磁粒无力抵抗,没有那么直接,确实是辅助性的。

不论强磁还是高温,都要精确控制能量场的作用范围,以防误删了临近的数据。

HAMR使用在人们印象中以“精细”著称的激光作为加热盘片特定区域的外部能量,然而真相远没有看起来这么简单。

这就说到第二个感觉了:“激光束照射到磁记录层上,当被照射记录层的温度达到一定值时,通过外加磁场的作用改变记录层的磁化方向,从而在盘片上写入数据”——不就是磁光(Magneto-Optical,MO)盘么?上世纪80年代中期就有了……(已经无惧暴露年龄)

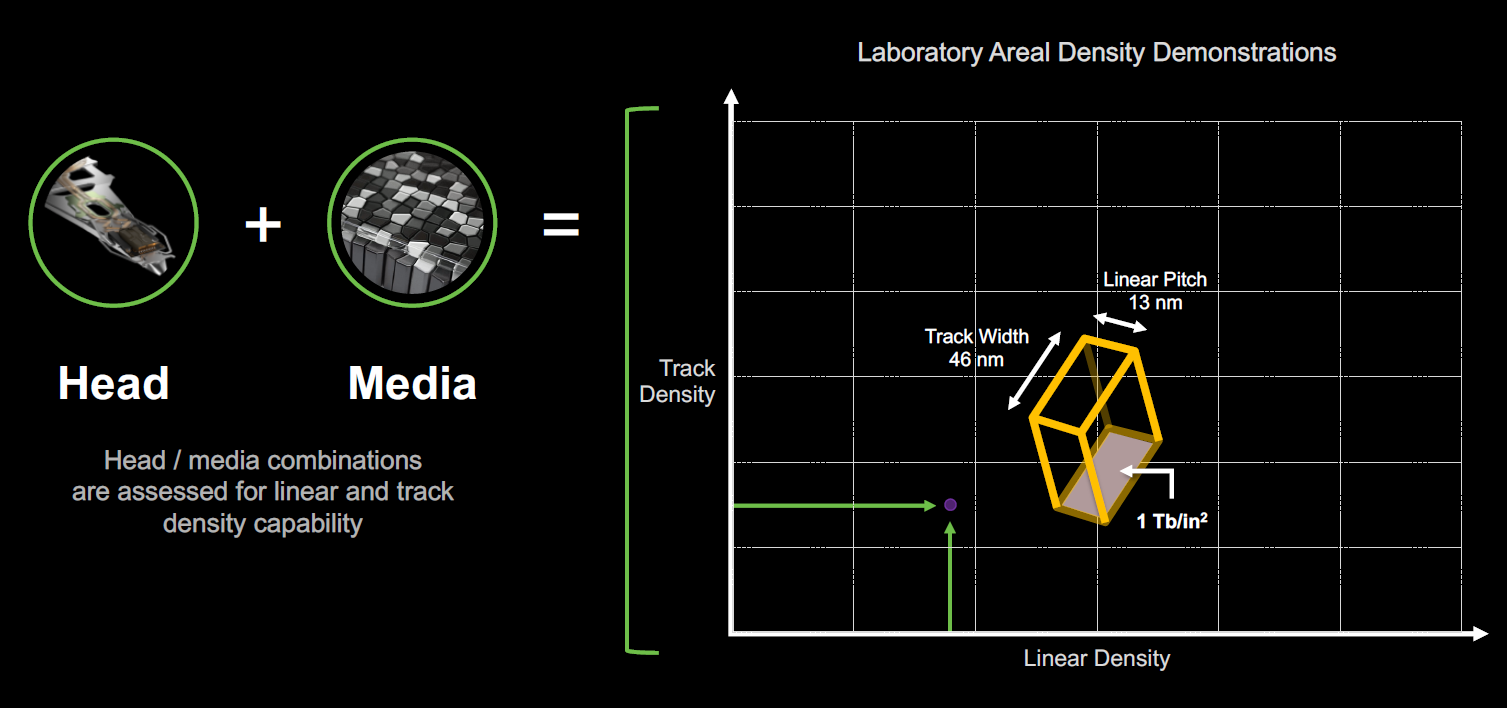

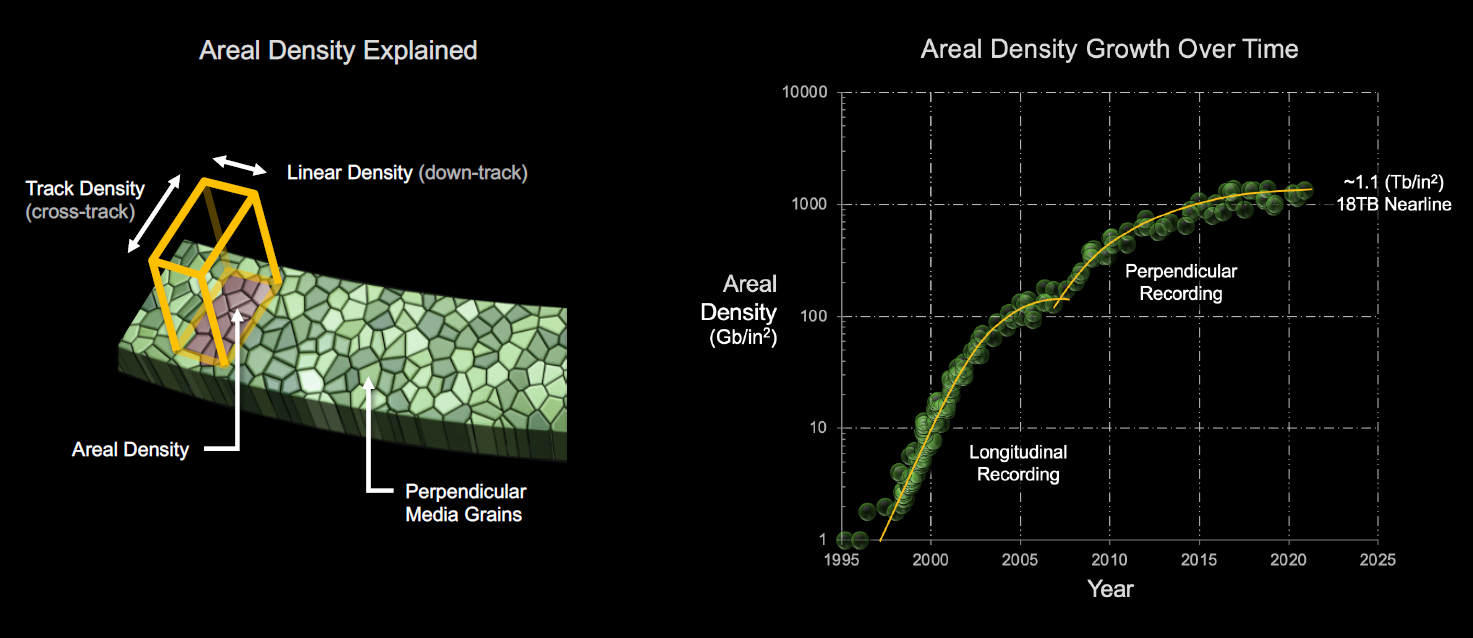

磁头和介质(盘片上)共同决定磁录密度(areal density),或者说“面密度”,又可以分解为平面内相互垂直的线密度(linear density)和道密度(track density)

难度岂可同日而语?磁光盘最后只发展到GB级别的容量,硬盘(单盘片)的千分之一。这么大的差距,足以完成从量变到质变的过程,不是一个物种了——况且本来也不是。

不要说最高几个GB的MO盘,就是几十GB的蓝光(Blu-ray,与MO原理不同)光盘,其光点尺寸也“高达”238nm(纳米),对超顺磁临界尺寸低两个数量级(2.8~3.3nm)的FePt来说,还是太高了。

经过尝试,希捷发现,即使运用光学技巧和近场记录技术,仍然无法把光束聚焦到100纳米以内。

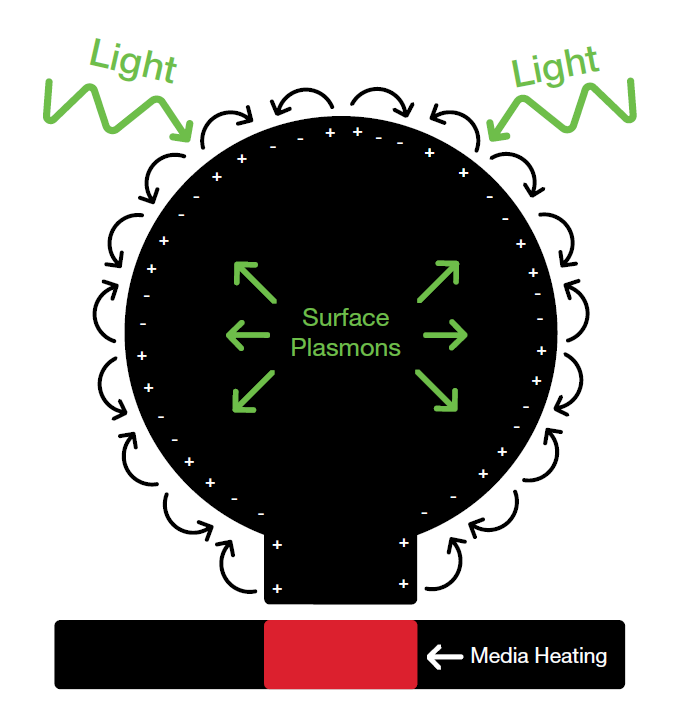

最后,希捷将古老的表面等离子体激元(surface plasmons)原理——翻译过来挺拗口,但是人类使用它的历史可以追溯到公元七世纪——应用到近场换能器(near-field transducer,NFT)上,称为等离激元(plasmonic)NFT。希捷在2017年底的一份介绍材料中宣称,在HAMR开发过程中,共制造了超过2500万个等离激元NFT。

等离激元NFT由侧面带一个凸起的圆盘构成,光被这个圆盘散射转化为表面等离子体激元,通过圆盘外边缘由凸起向下加热介质的特定点,凸起的宽度就是介质上热点的宽度,远远小于衍射极限

当光在特殊情况下照射到某些金属时,就会变成表面电流。这种表面电流和相关的电磁场称为表面等离子体激元。表面等离子体激元沿金属表面传播,通过控制NFT器件的形状就可以控制(投射在盘片上的)加热点的大小,也就间接控制了磁道宽度——这个加热点的尺寸已被证明可以达到每英寸100万个磁道,是垂直记录磁道密度的3~4倍。

HAMR磁头看起来很像PMR磁头,但是增加了3个主要元件:贴装的激光二极管发出激光,通过集成光波导(光纤是大家相对熟悉的另一类光波导)引向集成在写入元件前侧的NFT,转化为精确定向的热能,预先加热要写入的区域,临时降低其矫顽力,以便于磁头写入数据。

所以,磁头上的写入部分(记录头)是完全为HAMR重新设计了,而盘片也是重新设计的。

因为,解决了加热的问题,还有散热的问题:太快过于耗能,太慢会造成热量扩散并删除临近的数据,找到平衡点是HAMR成功的关键。

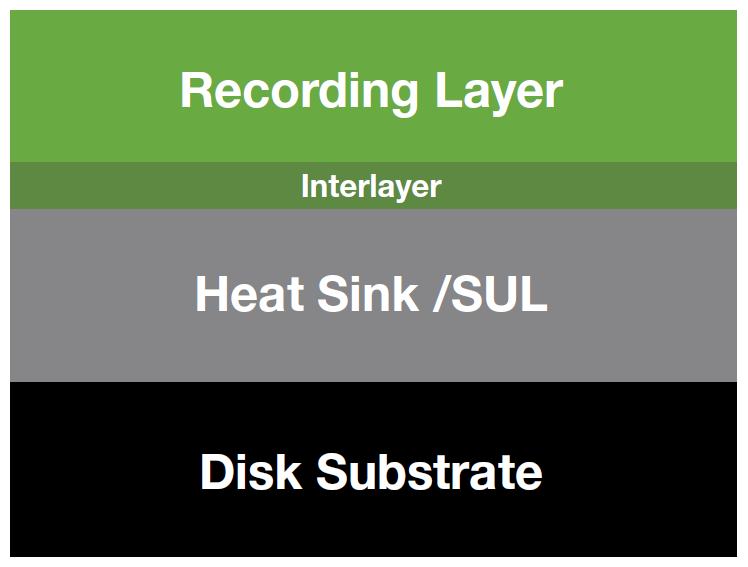

从下到上,或者说从里到外,依次是:

- 由特殊HAMR玻璃材质制造的基板,允许在高温下沉积记录层;

- 加入的中间层和散热层控制从记录层扩散的热流量;

- 记录层…使用希捷称为Iron-Platinum(铁-铂)的介质…不用再展开啦;

- 改变涂层,以在被加热到超过400℃时依旧保持稳定。

按照希捷的介绍,加热、写入、冷却的整个流程耗时约1~2纳秒(ns)——简直可以媲美CPU Cache的访问时延?

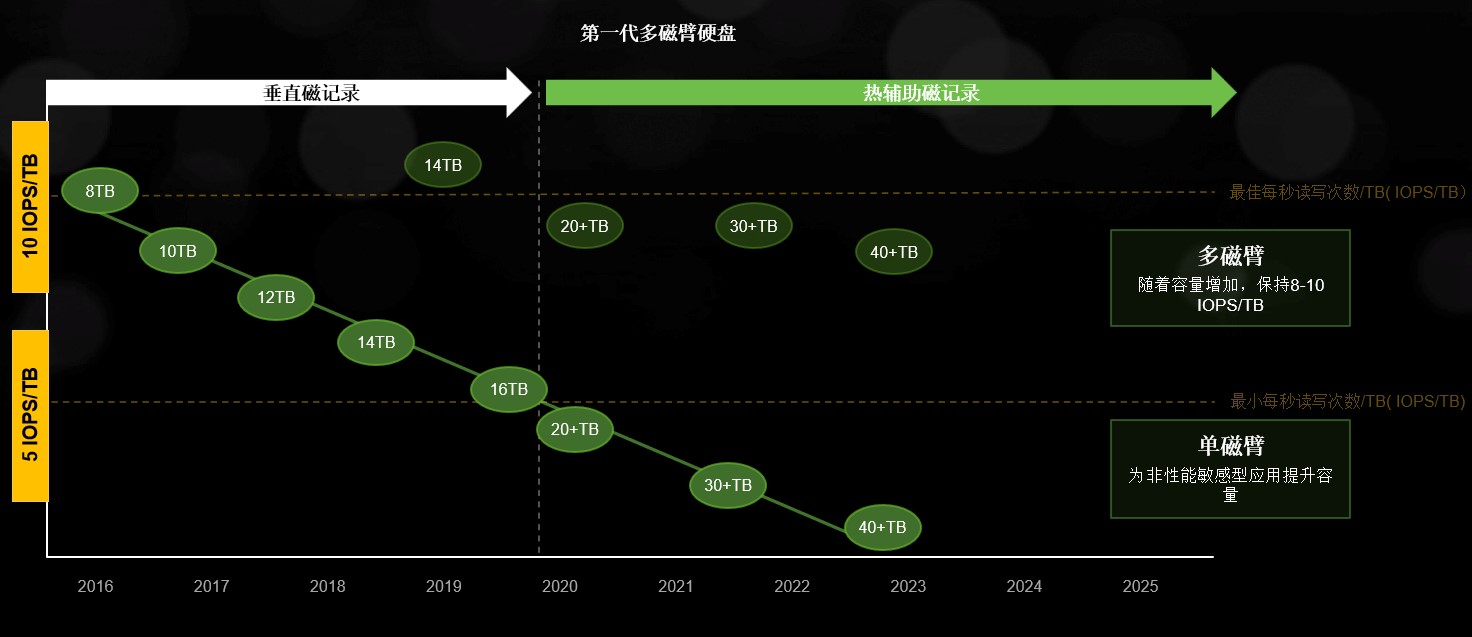

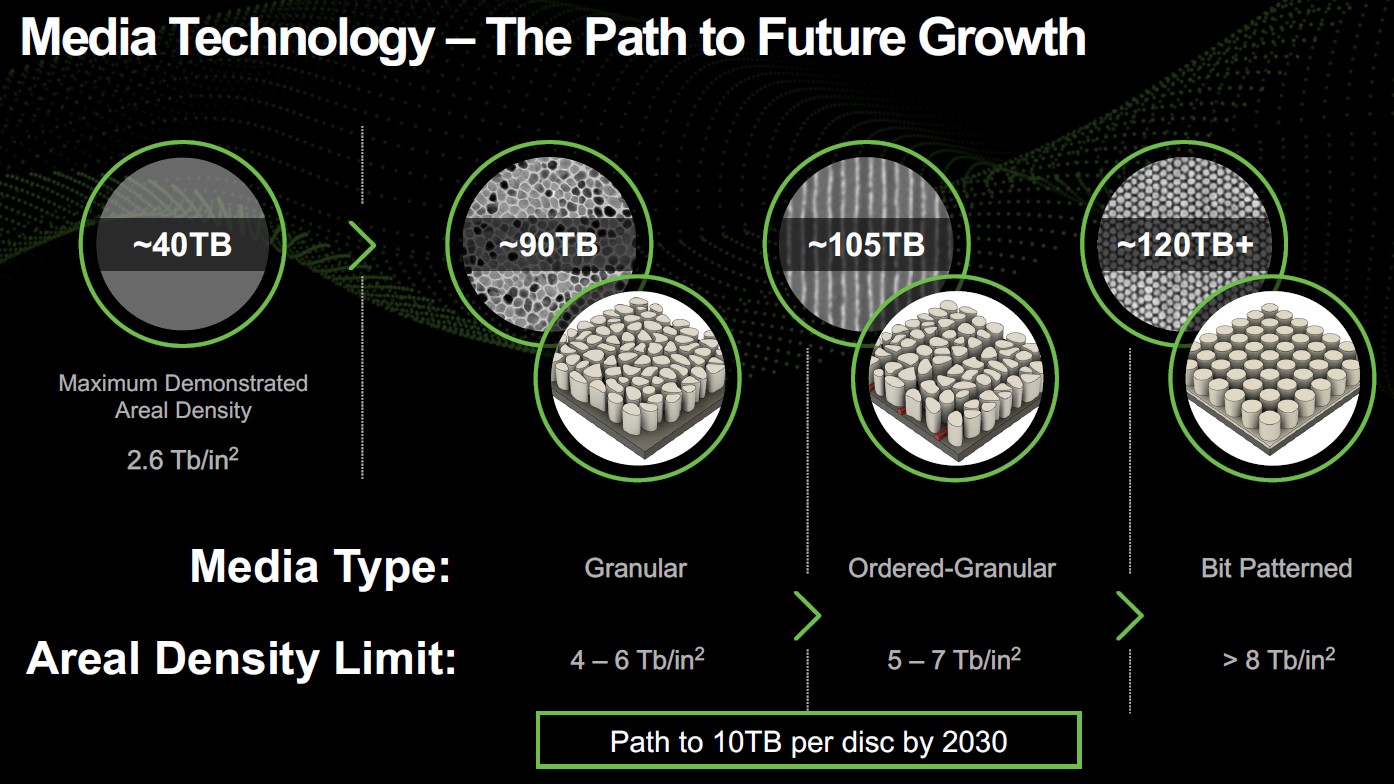

业界认为,PMR的磁录密度极限是每平方英寸1Tbit(1 Tbpsi),而基于HAMR可以达到5~10 Tbpsi,也就是起码5倍的提升。从希捷的路线图来看,2026年HAMR硬盘的容量可以达到50TB。

HAMR产品的成熟周期在3~5年

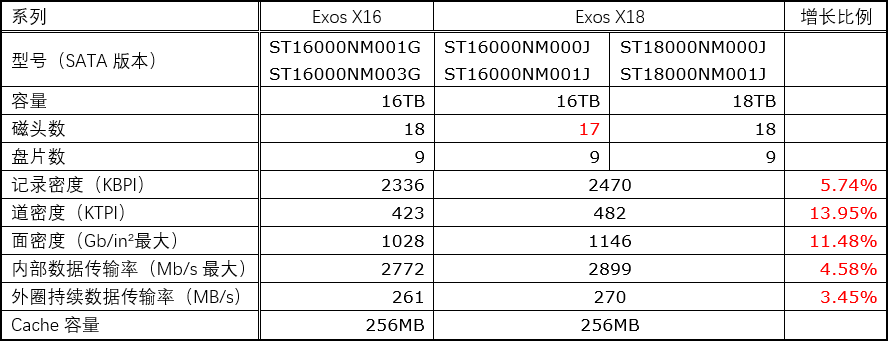

希捷在2019年推出最大容量16TB的Exos X16系列企业级氦气硬盘,平均磁录密度刚刚超过1 Tbpsi(1028 Gb/in²);随后最大容量18TB的Exos X18系列,平均磁录密度继续挺进到了1.1 Tbpsi之上。

现在,市场终于等来了首款公开发售的HAMR硬盘——希捷Exos X20H,容量达到20TB,磁录密度基本吻合1.2 Tbpsi的预估。接下来请跟随我们的脚步,一同经历HAMR初体验。

右边的Exos X20H是2020年12月中旬生产的,左边的Exos X18要早3个月

牛刀小试,再战十年

作为参照,一同到手的还有18TB的Exos X18——之所以强调18TB,是因为同系列还有16TB的型号。新的16TB与前辈Exos X16同为9碟封装(9张盘片),但有数据显示其少用了半张盘片(只用盘片的一面和1个磁头),因而单碟容量略大一些。

Exos X18的磁录密度比Exos X16高了11%,所以性能也要好上那么一点点,主要体现在最大持续数据传输率。

温习一下面密度、线密度、道密度;水平(纵向)磁记录向垂直磁记录(PMR)的转换,以及PMR的极限

磁录密度是一个平面(面密度)或者说是二维的量,可以分解为径向的磁道密度(道密度)和切向的记录密度(线密度),决定(持续)数据传输率的是后者——换言之,持续传输率的提高速度必然追不上磁录密度的增长幅度(除非道密度是降低的)。

在盘片直径、转速等因素不变的情况下,更高的记录密度通常对应着更高的持续数据传输率。根据希捷产品手册中列出的数据来分析,Exos X18比Exos X16的磁道密度高出近14%,记录密度高出不到6%,最大(外圈)持续数据传输率高出近3.5%,也不难看出持续传输率与磁道密度的关联更为密切。

Exos X20H沿用了Exos X16/18的外观设计,也是氦气密封、9碟封装,外观上的辨识主要靠标签上“X20”后面小号字体的大写“H”,代表HAMR(而不是Helium)。

可能因为这是一款采用全新磁记录技术的产品,我暂时还没看到Exos X20H的数据表。用单碟容量粗略对应磁录密度,那么在盘片数相同的情况下,18TB到20TB的提升比例,略低于16TB到18TB,结合上面的分析,我对最大(外圈)持续数据传输率会不会有肉眼可见的增长,基本上不抱期望。

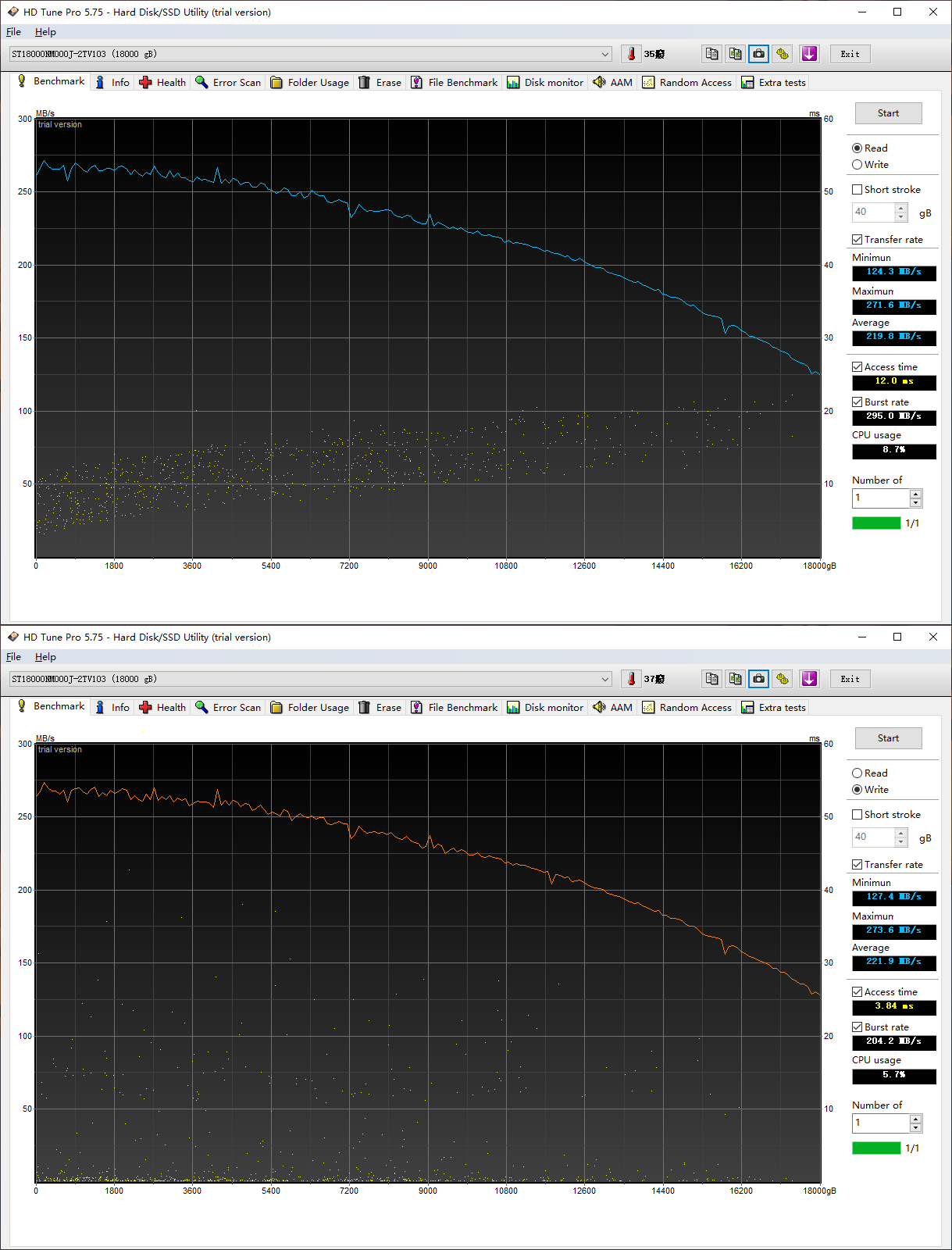

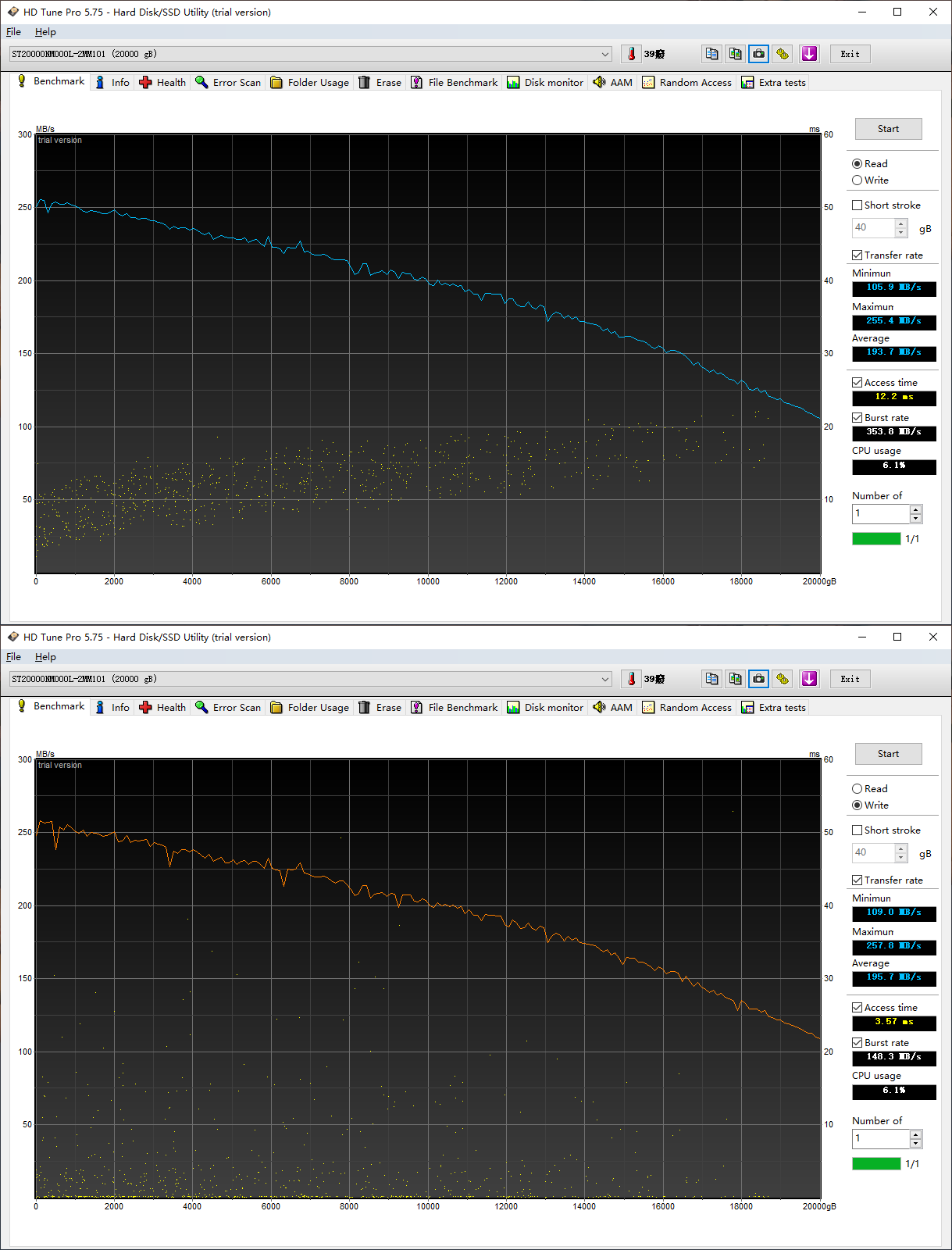

Exos X18的顺序读写性能与数据表相当吻合

测试结果是:Exos X20H的最大持续数据传输率略低于Exos X18,大约有后者的95%,(持续数据传输率的)最小值和平均值还要低一些。通常而言,这表明磁录密度的增长主要来自磁道密度,倒是可以证明等离激元NFT在加热点尺寸控制上的能力——如此说来,冷却时间的匹配精确度可能是制约记录密度提高的一个重要因素。

Exos X20H的顺序读写性能也很一致

不过,目前拿到的Exos X20H还是工程样品,期待正式量产版本的性能会有进一步提升。

无论如何,(其他条件不变的情况下)硬盘的最大持续传输率必然跟不上容量增长的速度,所以大容量硬盘完整读/写一遍所需的时间,越来越长。以我们测得的持续数据传输率平均值来推算,全盘顺序读或写一遍,Exos X18要用接近一天的时间,Exos X20H则已经超过一天。

在同一条技术路线上,随着硬盘容量的增长,单位容量的I/O性能下降,全盘读写一遍的时间变长

要想更快的读写数据,又不能提高转速,增加磁臂的数量是一个方向,如希捷的MACH.2双磁臂技术,理想状况下可以把硬盘的读写性能提高一倍,将来可能还会有更多的磁臂出现。

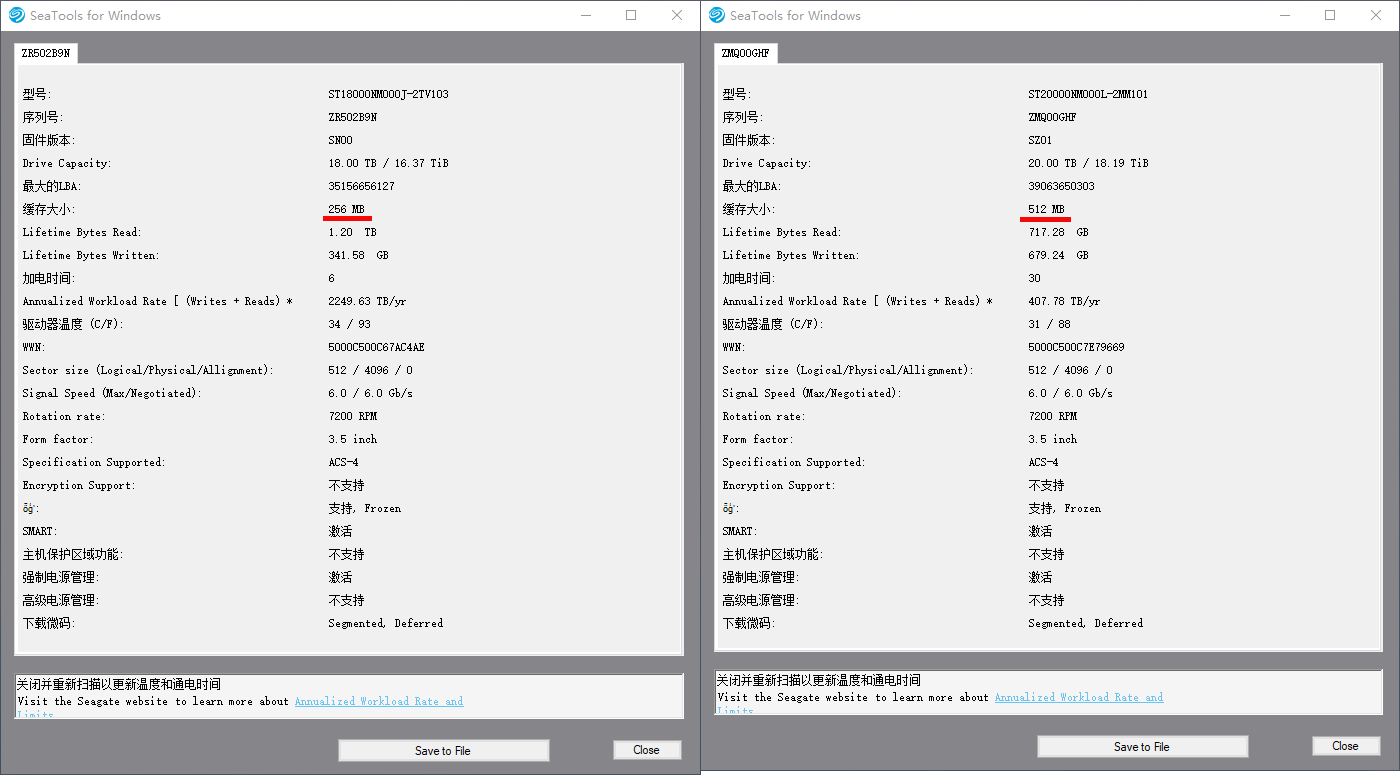

翻过来看,近年来硬盘的PCBA(安装于盘体外的电路板组件)布局已经非常紧凑,譬如Exos X18/20H的PCBA,面积不到硬盘(投影)的四分之一。PCBA上的主要芯片,还是硬盘控制器、SDRAM、马达控制器这“老三样”,Exos X20H沿用了Exos X18的硬盘控制器,但SDRAM的容量从256MB翻倍为512MB。

总体上,作为硬盘Cache的SDRAM,容量基本上随着硬盘容量(尽可能地)同步增长。像Exos X16和Exos X18都是256MB的Cache,Exos X20H的容量增幅相同,按理说没必要把Cache容量翻倍,所以我更倾向于认为是出于供应链方面的考虑,未来(量产版本)有可能还是256MB。

随着容量继续增长,为了保持单位容量的性能(如IOPS/TB),HAMR势必会与多磁臂技术合体。多磁臂能直接提高硬盘的性能,包括随机访问性能(IOPS),增大Cache容量并不能取得这样的效果。

更具体的说,在随机读的时候,以不到GB级别的Cache,服务10TB以上的存储容量,命中率可以忽略不计;在随机写的时候,把写入数据先保存在内存里(Write Back),积累到一定容量再尽可能的按顺序写入磁道,肯定可以提高性能,代价是突然掉电时未落盘的数据会丢失。在企业级环境后者显然是不能允许的,所以要求的还是关闭写缓存(Write Cache Disable,WCD)的“裸”性能。

上有政策,下有对策。希捷的高级写缓存技术干脆跳过内存环节,把随机写入的数据直接顺序写入盘片上的特定区域,等到相对有利的时机再将数据取出并写入到真正的目的地。这种类似log的做法在数据库等软件领域久经考验,E企研究院在2019年测试的Exos X16就支持高级写缓存功能。我在Exos X18上体验了一把:当软件停止随机写入操作时,硬盘继续忙个不停(频繁寻道的声音),哪怕立即关机或重启系统的过程中,仍然在咔咔的送数据“归位”。

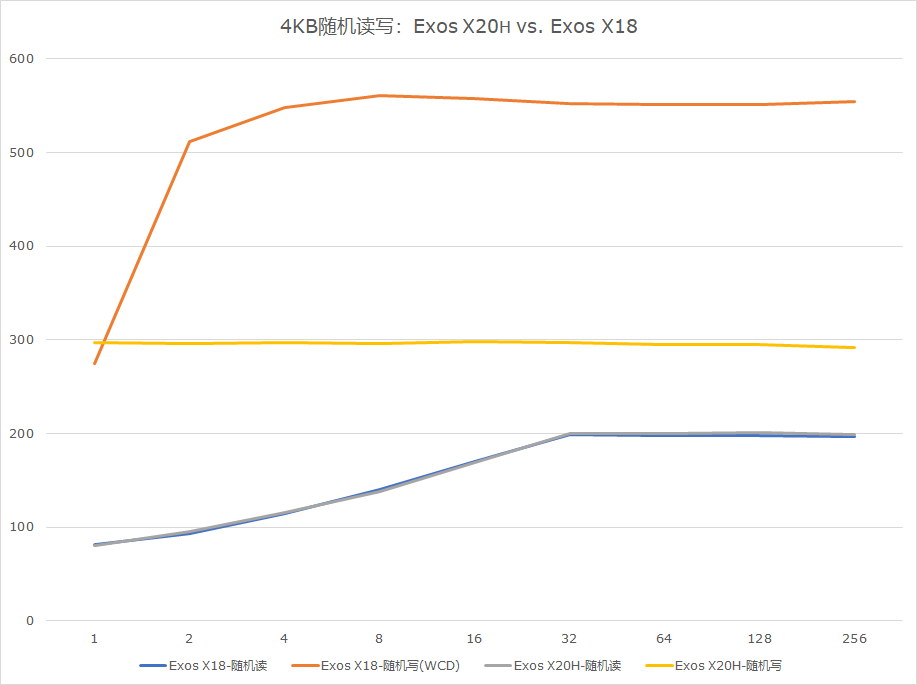

在4KB对齐的情况下,Exos X20H的4KB随机写入性能,达到Exos X18的一半以上

从4KB随机写入的测试来看,在Exos X18的高级写缓存功能的加持下,队列深度为16(QD16)时,IOPS可以稳定在560左右,是随机读取性能的3倍以上。出于保险起见,Exos X20H还未配备高级写缓存功能,但是随机写入性能最差也可以与随机读取性能相当,体现了不用SMR的价值。

总体而言,Exos X20H可以视为Exos X18的加大容量保守版,让用户先体验到纯粹的容量增长……相比性能上的提升,我更希望这真是新的一个10年的开始。