本文对百度NLP入选AAAI 2020的对话生成领域入选论文《Knowledge Graph Grounded Goal Planning for Open-Domain Conversation Generation》进行详细解读,该论文针对如何让机器生成有内容并且主题连贯的多轮开放域对话进行了讨论。

一、研究动机

让机器生成有内容并且主题连贯的多轮开放域对话,是人工智能公认的关键任务之一。针对这一任务,研究人员尝试了一些基于端到端的生成模型,但模型生成的回复内容丰富性较低。

为解决这一问题,研究人员一方面尝试引入外部知识或文本主题信息,以提升对话回复内容的丰富性;另一方面,尝试借助强化学习技术生成有内容的可持续的对话。

虽然上述工作取得了一些进展,但可能因为缺少有效的对话管理机制去管理多轮对话中的聊天话题,这些模型仍旧倾向于生成主题不连贯的对话。

一些对话语料分析工作表明,在人人对话中,存在一些常见的对话管理策略,包括聊天话题的切换、某个话题的持续深入等。因此,有效的聊天话题管理技术是达成对话主题自洽的关键。

二、技术方案

有效聊天话题管理技术的实现,目前面临两个挑战。其一,如何进行高层级对话目标(Gonversational Goal,此处指聊天话题)序列的规划。其困难在于,对话系统既要保持对话主题的连贯性,也要兼顾用户的兴趣,以免机器单方面的自说自话;其二,如何基于一个对话目标生成内容丰富的深入对话。此技术可以支持许多实际的对话应用场景,例如多个知识点的持续推荐、某个物品的推荐等。

为了解决以上两个问题,论文中提出了一个基于知识图谱的层次化强化学习框架(KnowHRL),进行多粒度回复指导信息的选择。

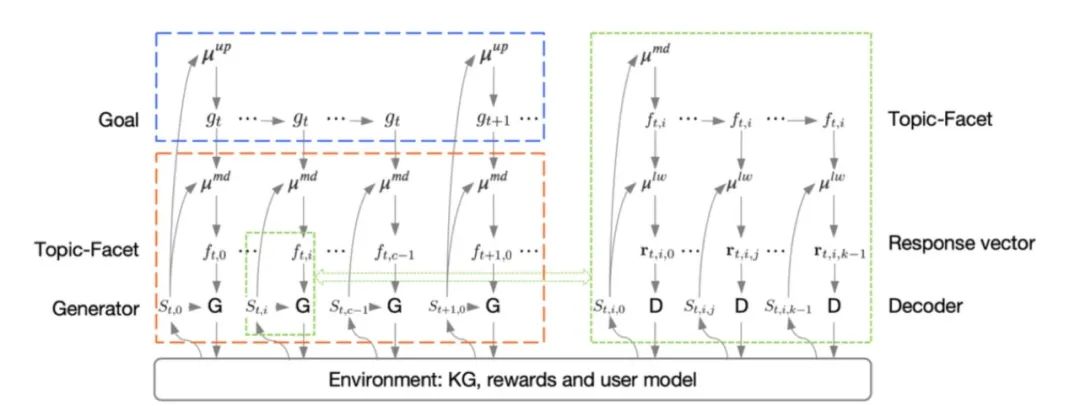

如图1所示,强化学习框架中的决策模块(Policy)部分包含三层:

1、上层Policy是第一个多层感知网络,负责通过在知识图谱中选取实体类节点,以规划一个主题连贯、多样、可持续的聊天话题序列(即图谱中的实体节点)。考虑到用户兴趣的建模,研究人员在 RL Reward中添加了回复句与用户话题一致性的度量因素。

2、中层Policy是第二个多层感知网络,负责从实体节点的邻居中选取一个节点(通常为实体属性),作为细粒度子话题。由于将对话目标是否完成形式化为SMDP中的Option,我们设计了另外一个模型,可以在中层Policy的每一步决策之后,都去判断当前对话目标(即上层Policy选择的实体)是否完成。如果完成,则将控制权交给上层Policy。

3、下层Policy是第三个多层感知网络,负责选取一个回复向量(来自基于多映射机制对话生成模型中的一个隐映射函数,具体细节请参考论文)。

RL Reward设计:

1、针对上层Policy,论文中提出了五个因子,包括对话目标序列的主题连贯性、对话目标与用户话题的一致性、围绕当前对话目标的对话轮数、当前对话目标的可持续性(实体节点的Pagerank)以及来自中层Policy的Reward打分。

2、针对中层Policy,论文中设计了两个因子,一个是话题内的连贯性,另一个是来自下层Policy的Reward打分。

3、针对下层Policy,论文中提出了三个因子,包括回复句的相关性、回复句的信息丰富度以及回复句中是否提及了中层Policy选择的细粒度话题(即实体属性名)。

最后我们使用另外一个基于多映射机制对话生成模型,以当前给定上下文,Policy选择的细粒度子话题/回复向量,作为输入,然后输出适合的回复句。

三、实验结果

数据集:论文在百度公司之前发布的DuConv数据集上进行了实验。该数据集包含30k对话Session,其中对话轮数为120k。我们将数据切分为训练集(100k轮对话)、开发集(10k 轮对话)以及测试集(10k轮对话)。

该数据还提供了电影、明星领域的知识图谱,由人工进行标注,每个对话Session最终需要引导到一个预先给定的实体,并且对话需要围绕知识图谱中的相应知识进行。

基线:论文选取了2个基线模型。

① CCM:基于图注意力机制的知识对话模型;

② CCM+LaRL:我们对一个基于隐变量以及RL的对话模型(LaRL)进行了改进,使用了CCM中的两个图注意力机制使得LaRL可以充分利用知识图谱。

多轮评估指标:这里没有采用BLEU等指标,而是设计了多个人工指标。主要原因在于文中工作目标不是选取概率最高的句子做为回复,而是建模回复序列的长期特性,例如对话可持续性、主题的连贯性等。

论文中提出了主题间连贯性(Inter-topic Coherence)、主题内连贯性(Intra-topic Coherence)、用户兴趣一致性(User Interest Consistency)、知识准确率等四个人工指标,同时沿用前人的Distinct指标评估回复多样性。

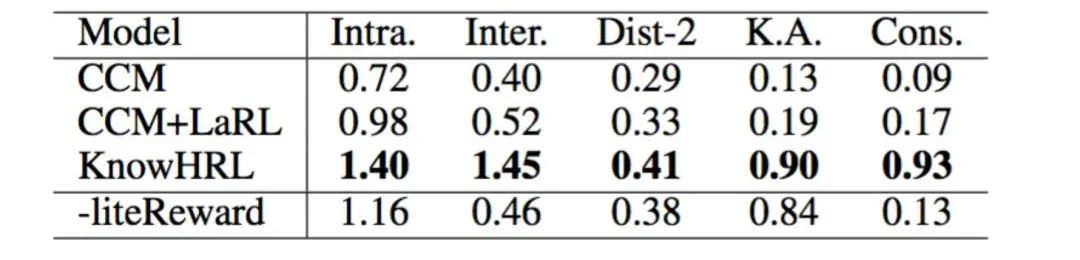

实验结果:表1展示了文中模型(KnowHRL)与基线模型的实验结果,在所有评估结果下的统计显著性检验p值均小于0.01。

可以看到,KnowHRL模型在主题间连贯性、主题内连贯性、用户兴趣一致性、知识准确率等指标下,KnowHRL有非常显著的优势。实验结果表明KnowHRL可以生成主题连贯的多轮对话,并且让回复中的知识更加准确。

Ablation Study:为了探究模型中对话目标相关Reward因子对模型整体效果的影响,论文还做了模型简化测试(Ablation Study),简化后的模型(即KnowHRL-liteReward)结果如表1所示。

KnowHRL-liteReward:为了确认对话目标相关Reward的贡献,论文中实现了一个KnowHRL模型的变体,即将对话目标相关的Reward去掉。

不使用对话目标相关的Reward因子后, 模型在主题间连贯性以及用户兴趣一致性等指标下效果显著下降。可以看到,对话目标相关的Reward引入,对模型整体效果的提升比较显著。

四、创新点总结

1、该工作首次将多轮开放域对话拆解为两个子任务,即对话目标序列的规划及给定对话目标的深入对话。基于该思想,文中提出了KnowHRL模型。

2、借助于知识图谱,该工作为对话策略(Dialog Policy)学习引入了显示的、可解释的对话状态与动作,不仅便于设计对话目标相关的Reward因子,还可使用对话目标以及细粒度话题指导回复生成。

3、实验结果验证了KnowHRL模型在多个指标下的有效性,包括话题连贯性、用户兴趣一致性、知识准确率等。

五、结束语

论文中提出了一个基于知识图谱的层次化强化学习框架,该框架展示了如何基于知识图谱进行层次化的话题内容规划,从而进一步辅助聊天话题管理以及回复生成。

在公开数据集上的实验表明,文中提出的方案在主题连贯性、用户兴趣一致性、知识准确率等指标上大幅超越基线。未来可能的改进工作是提升知识图谱的内容覆盖,例如可以在图谱中引入开放域对话的内容。

至此,《Knowledge Graph Grounded Goal Planning for Open-Domain Conversation Generation》论文的分享结束。敬请期待更多百度NLP前沿进展分享!