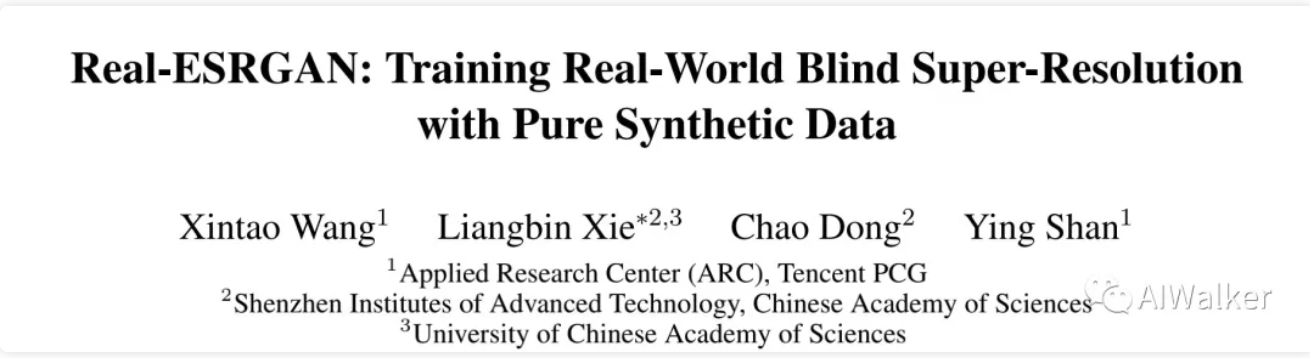

标题&作者团队

paper: https://arxiv.org/abs/2107.10833

Code: https://github.com/xinntao/Re...

本文是ESRGAN、EDVR等超分领域里程碑论文的作者在超分领域的又一力作,他们对ESRGAN进行扩展,将其应用场景从合成数据向真实场景数据走了一大步。针对现有图像超分、盲图像超分退化模型设计的不足,提出了一种高阶退化建模方案;针对高阶退化空间下原始判别不稳定问题,提出了UNet+SN的超强判别器。最终所得Real-ESRGAN在真实场景数据下取得了非常优秀的、视觉效果绝佳的超分效果。

Abstract

尽管盲图像超分领域已有诸多研究,但距离解决真实世界退化图像超分仍有很长的路要走。

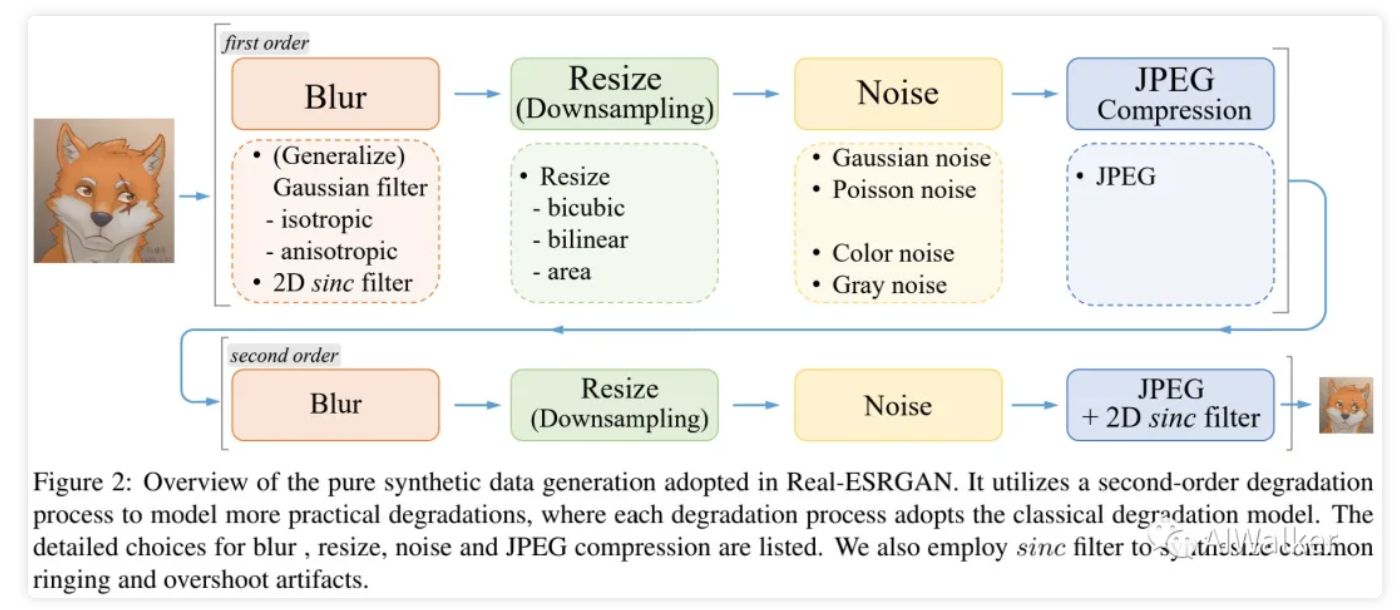

本文采用纯合成数据对ESRGAN朝着真实复原应用进行扩展,得到了本文所提的Real-ESRGAN。具体来说,我们构建了一个高阶退化建模过程以更好的模拟复杂的真实退化。在合成过程中,我们同时还考虑的重建的ringing, overshoot伪影等问题。此外,我们采用了带谱归一化的UNet判别器以提升判别能力、稳化模型训练。

实验结果表明:相比不同数据集上的先验性工作,所提方法具有非常好的视觉效果。我们同时还提供了在线训练数据合成的高效实现。

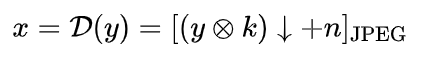

Classical Degradation Model

盲图像超分旨在对未知的、复杂的低分辨率退化图像进行高分辨率重建。经典的退化通常采用合成方式制作低分辨率输入,该过程可以描述如下:

接下来,我们将对常见的退化过程进行简要回顾。

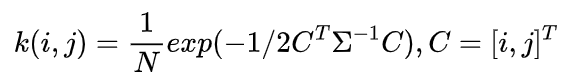

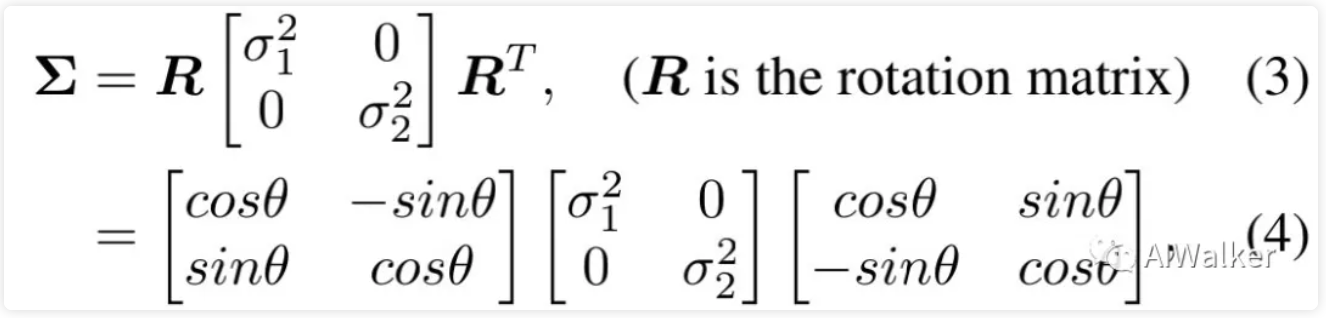

Blur

在模糊退化方面,高斯模糊是最常见的选择,高斯模糊核定义如下:

其中表示协方差矩阵,C表示空域坐标,N表示归一化常数。协方差矩阵可以进一步表示成如下形式:

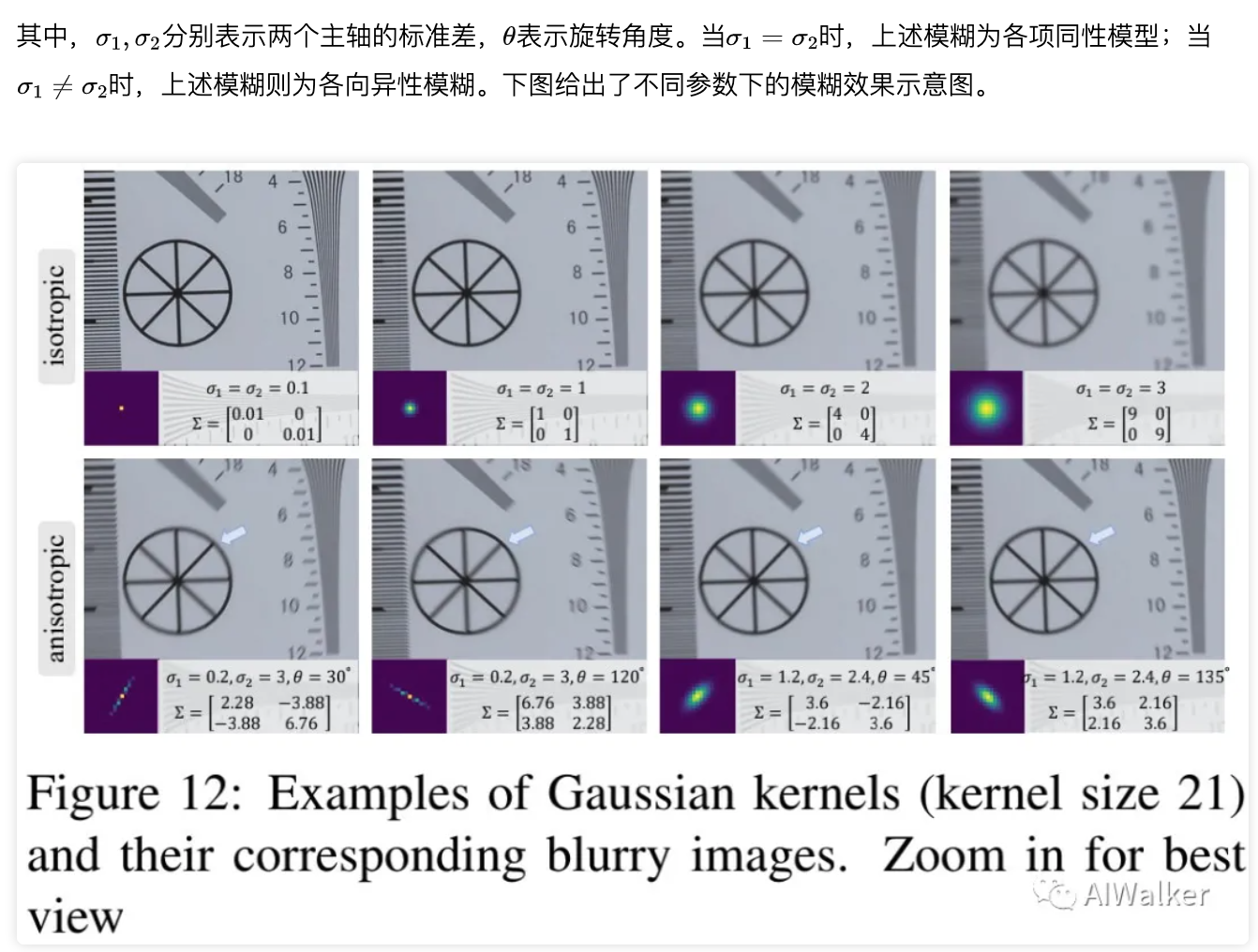

尽管上述高斯模糊常用来模拟模糊退化,但它们往往难以很好的近似真实相机模糊。为包含更多样的核形状,我们进一步引入了广义高斯模糊核与高原形状分布(plateau-shaped distribution),可参见下图。

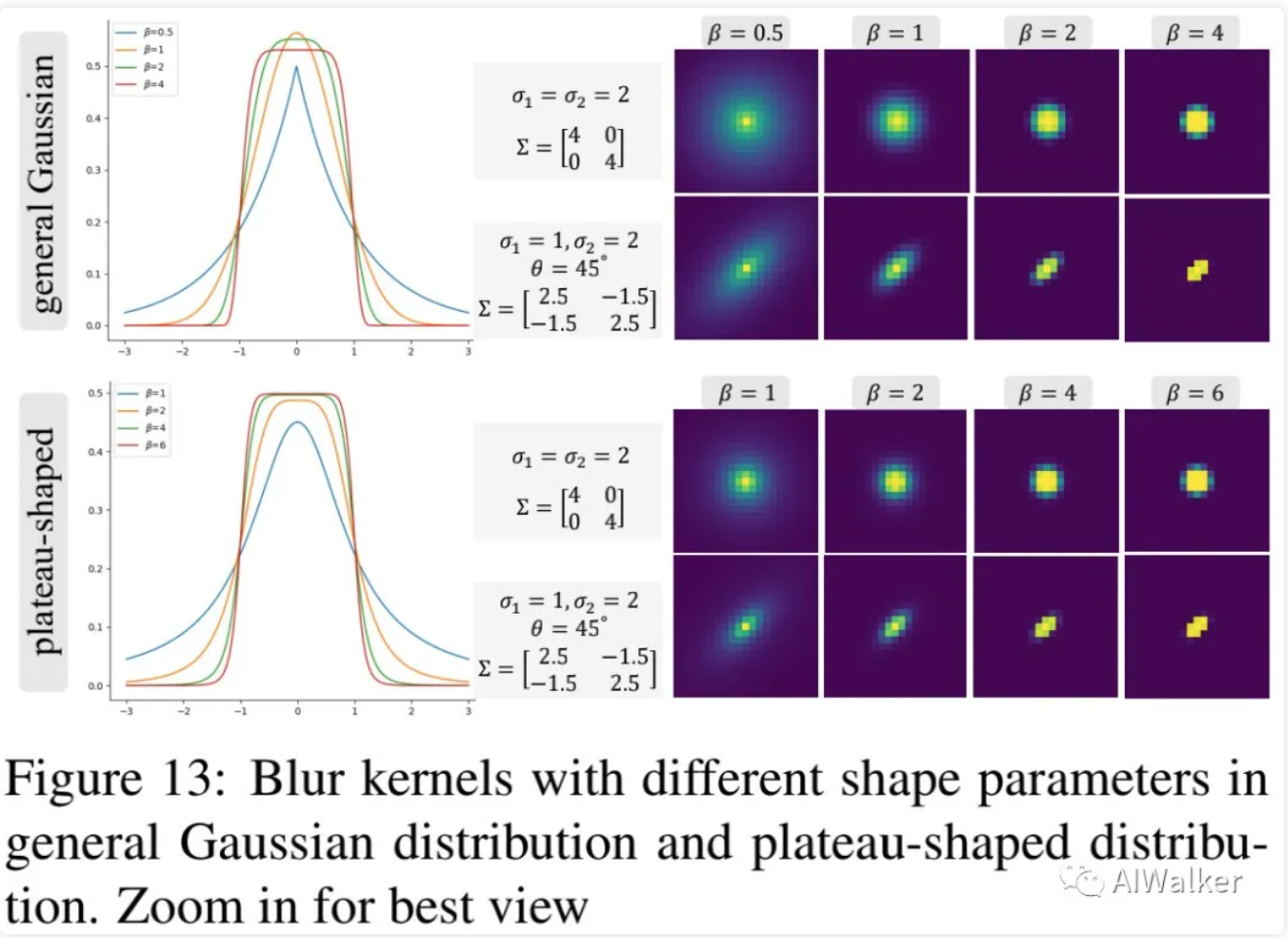

Noise

在噪声方面,我们考虑了两种常见噪声:

- 加性高斯噪声:其噪声强度受高斯分布标准差控制;

- 泊松噪声:它服从泊松分布,可以用于模拟传感器噪声,其噪声强度与图像信息成正比。

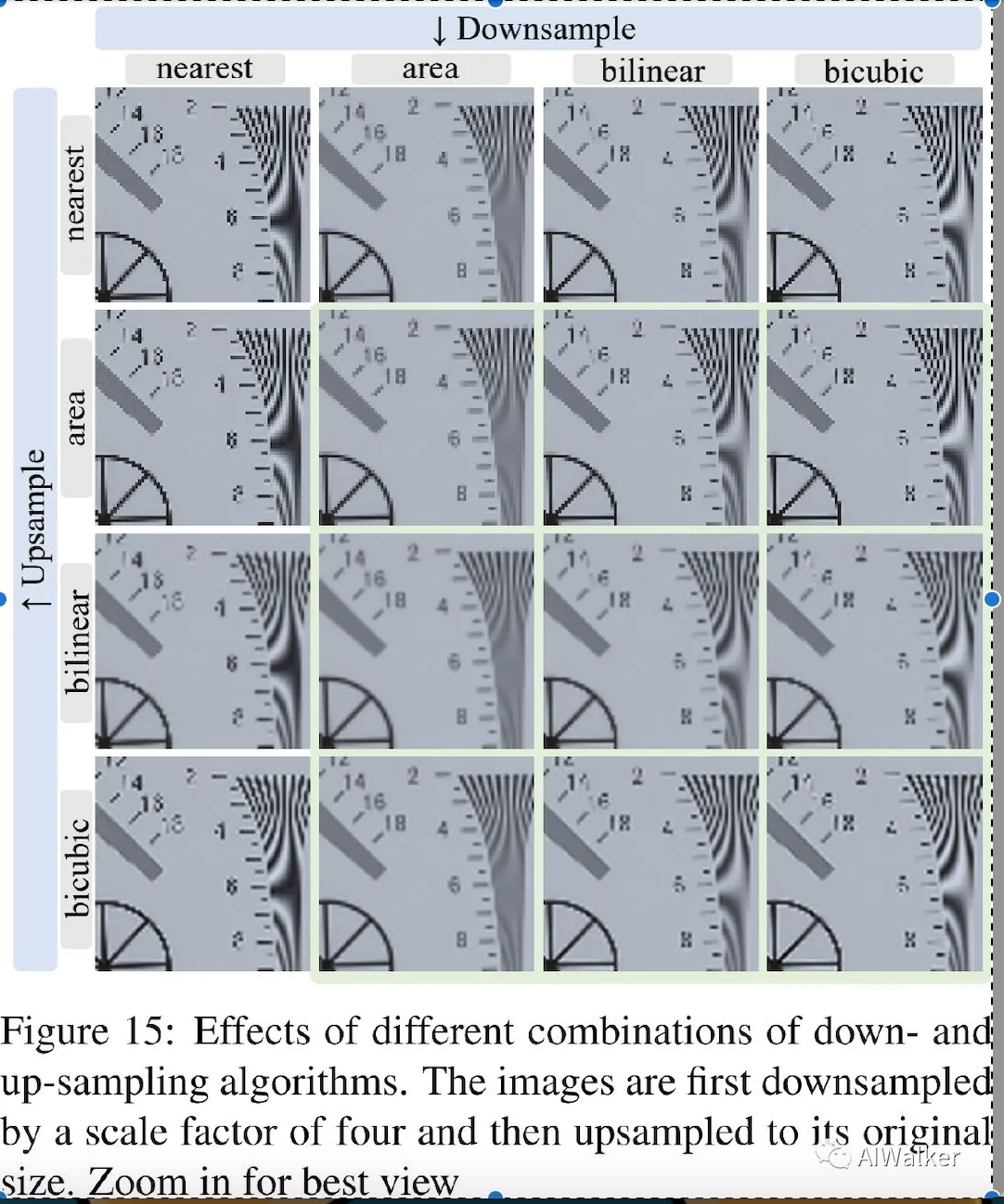

Resize(Downsampling)

下采样是超分领域合成低分辨率图像的一种基本操作。该操作一般有这样几种实现:最近邻插值、面积插值、双线性插值、双三次插值等。不同的插值操作会带来不同的效果,有的会产生模糊结果,有的会产生过度锐化结果。下图对比了不同插值方法下采样+上采样组合的效果对比。

image-20210723210742445

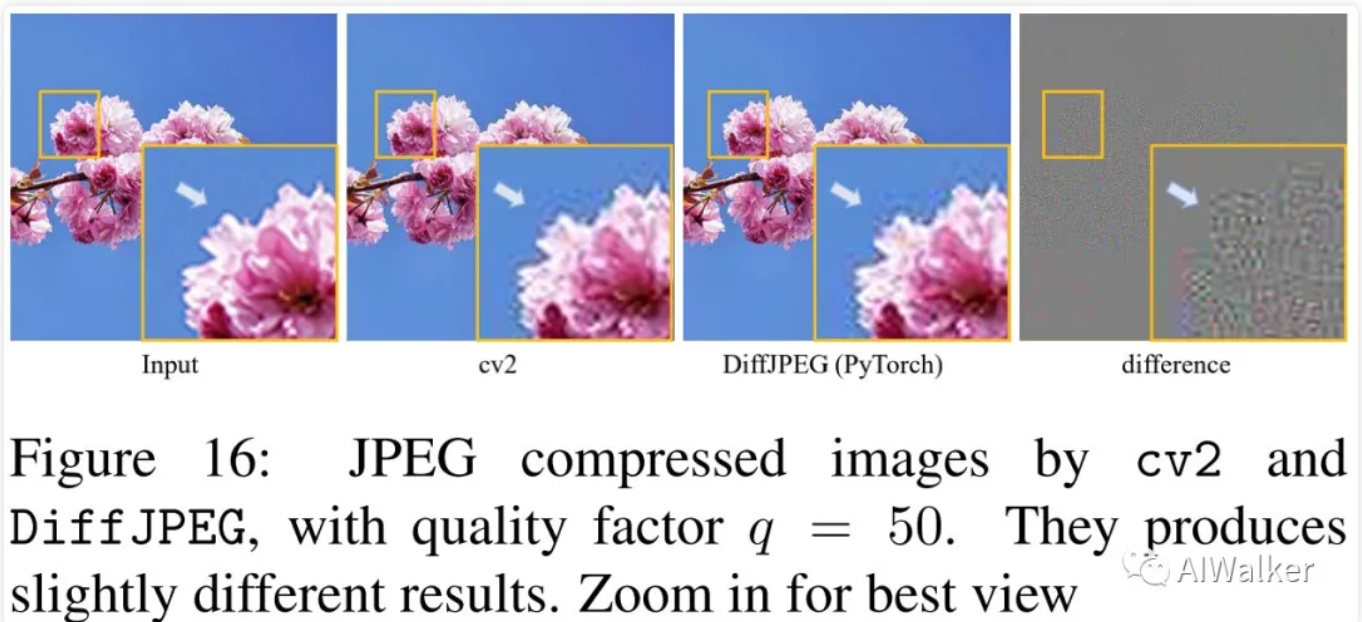

JPEG compression

JPEG压缩是一种常见的有损图像压缩技术,它会带来块状伪影问题。压缩图像的质量通过参数控制,越小意味着越高的压缩比越低的质量。下图对比了OpenCV与DiffJPEG的压缩效果对比,本文默认采用DiffJPEG压缩。

image-20210723211025173

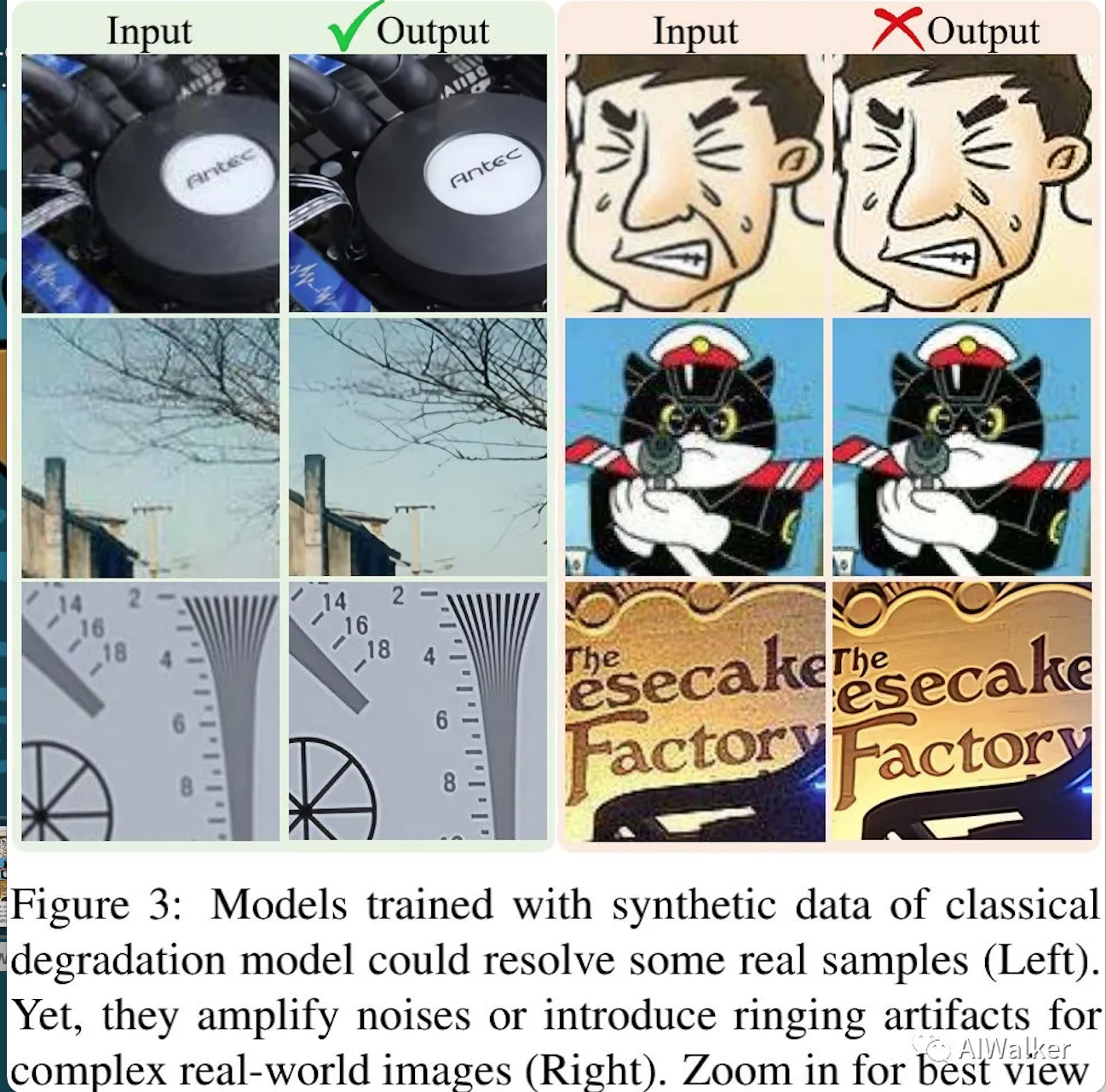

High-order Degradation Model

当采用上述经典退化模型合成训练数据对时,所训练的模型往往难以处理真实样例,可参见下图。这是因为合成数据与真实退化图像之间存在比较的差异。因此,我们需要扩展经典退化模型到高阶退化模型以处理更实际的退化问题。

经典的退化模型仅仅包含固定数量的基本退化,这种退化可以视作一阶退化。然而,实际生活中的退化过程非常多样性,通常包含不同的处理,比如成像系统、图像编辑、网络传输等等。当我们想要对网络下载的低分辨率图像进行重建时,难度可想而知。比如,原始图像可能由多年前的手机拍摄所得,包含严重的退化问题;当图像通过锐化软件编辑处理后又会引入overshoot以及模糊伪影等问题;当图像经过网络传输后又会进一步引入不可预料的压缩噪声等。上述种种操作均会使得退化变得过度复杂。

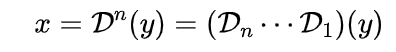

为缓解上述问题,我们提出了高阶锐化模型:它包含多个重复退化过程,其定义如下所述:

其中,每个阶段采用相同的退化处理但具有不同的退化超参。下图给出了2阶退化模型示意图。

需要注意到:上述所提高阶退化模型仍然不完美,无法覆盖真实世界的整个退化空间。相反,它通过修改数据合成过程对已有盲图像超分的退化边界进行扩展。

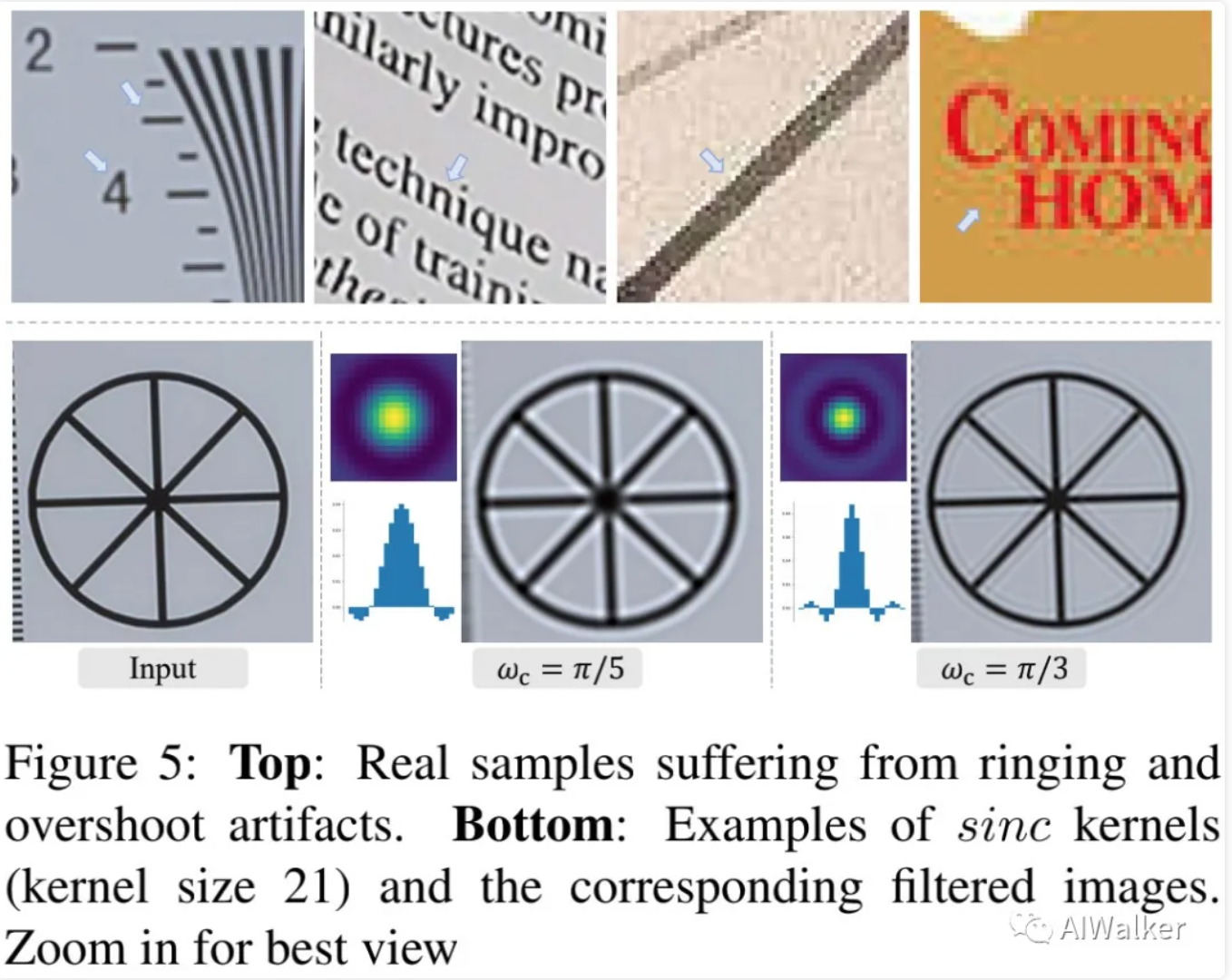

Ringing and overshoot artifacts

(Ringing artifacts)振铃伪影通常出现在图像的锐利边缘附近以伪边缘形式出现;(overshoot artifacts)过度锐利伪影通常伴随振铃伪影出现,表现为边缘过渡时的跳跃现象。产生这些伪影的主要原因:信号带宽限制,没有高频。当采用锐化算法、JPEG压缩等处理时通常会出现这些伪影问题,可参考下图。

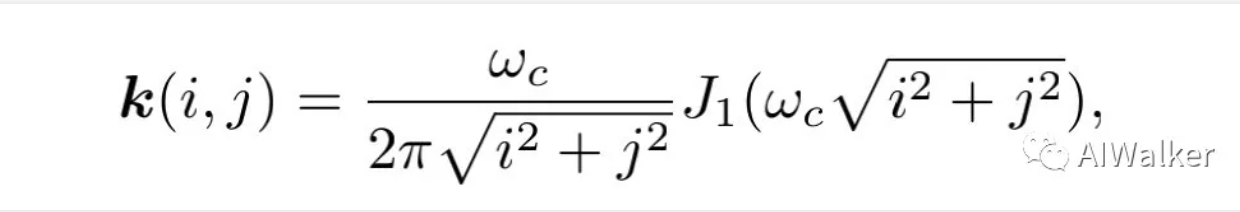

我们采用sinc滤波器模拟上述两种伪影,可参考上图bottom部分,该滤波器核可以表示如下:

我们在两个地方执行了该sinc滤波器处理:模糊处理以及最后的合成步骤。最后的sinc滤波器与JPEG压缩顺序随机交换以覆盖更大的退化空间。

Networks and Training

ESRGAN genrator 在生成器方面,我们采用了ESRGAN的生成器,即RRDBNet。我们同时还扩展了原始的x4 ESRGAN到x2与x1。由于ESRGAN是一个重度网络,我们首先采用piexl-unshuffle操作降低分辨率提升通道数。因此,计算量主要集中在小分辨率空间,同时降低了GPU与计算资源占用。

UNet discriminator with spectral normalization 由于Real-ESRGAN旨在解决比ESRGAN更大的退化空间,原始的判别器设计将不再稳定。也就是说,Real-ESRGAN需要更强悍的判别器;此外,判别器也需要生成关于局部纹理的精确梯度反馈。因此,我们将ESRGAN中的VGG风格判别器升级为UNet风格判别器以提供精确的像素级梯度反馈到生成器。

与此同时,UNet架构以及复杂的退化空间也带来的训练不稳定问题。因此,我们采用谱归一化正则稳定模型训练;此外,我们发现谱归一化有助于缓解过度锐化以及GAN导致的伪影问题。基于这些改进,我们可以比较容易的进行Real-ESRGAN训练并在局部细节增强与伪影抑制之间取得更好的均衡。

The training process 模型的训练分为两个阶段:(1) 采用损失训练PSNR导向的模型Real-ESRNet;(2) 采用L1、感知损失以及GAN损失训练Real-ESRGAN。

Experiments

训练细节就略过不表,这里对文中提到的Sharpen Groud-truth进行简单介绍:一种提升锐利度且不会引入视觉伪影的训练技巧。传统方法中常用的一种锐化图像的方法是Unsharp masking(即USM)。尽管该算法往往会带来过度锐化伪影,但是在训练过程中对GroundTruth进行USM后再进行模型训练可以在锐利度与伪影抑制方面取得更好的均衡。

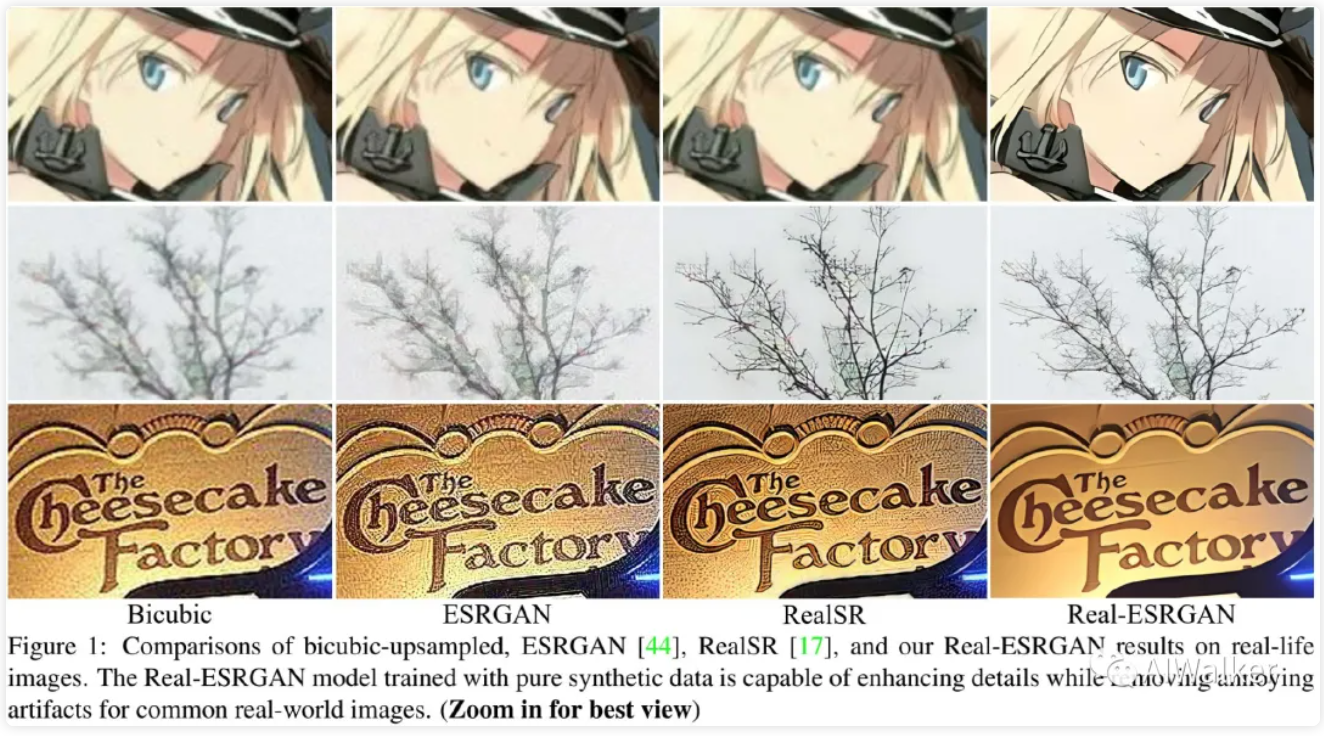

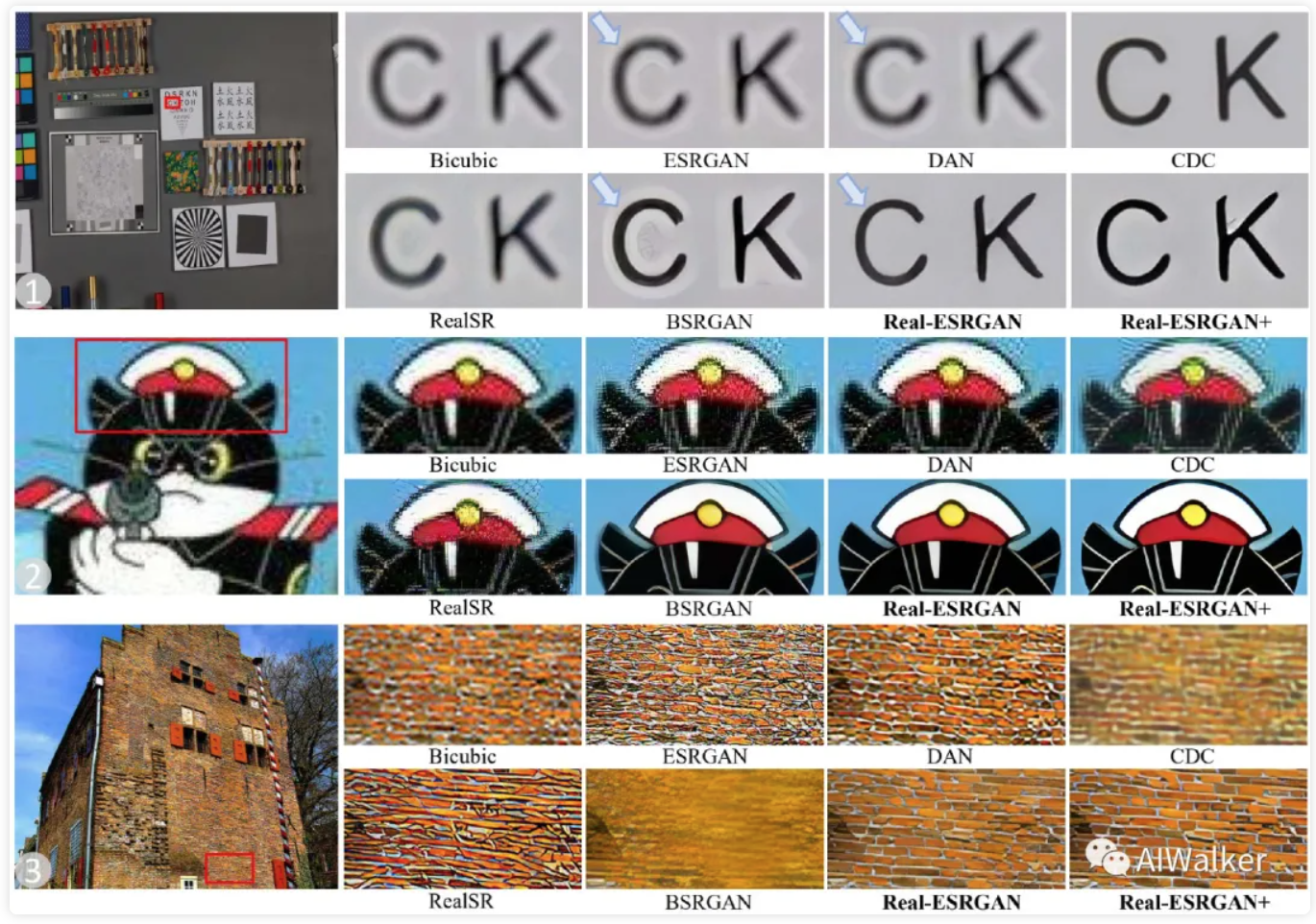

上图给出了不同超分方法在不同退化图像上的超分效果对比,从中可以看到:

- Real-ESRGAN在伪影移除与纹理细节复原方面取得了最佳的视觉效果,而Real-ESRGAN则进一步提升了视觉锐利度。

- 直接上采样会导致过度锐化伪影(即白边问题),而Real-ESRGAN将上述问题纳入考虑并通过sinc滤波器进行模拟,进而有效移除了这类伪影问题。

Ablation Study

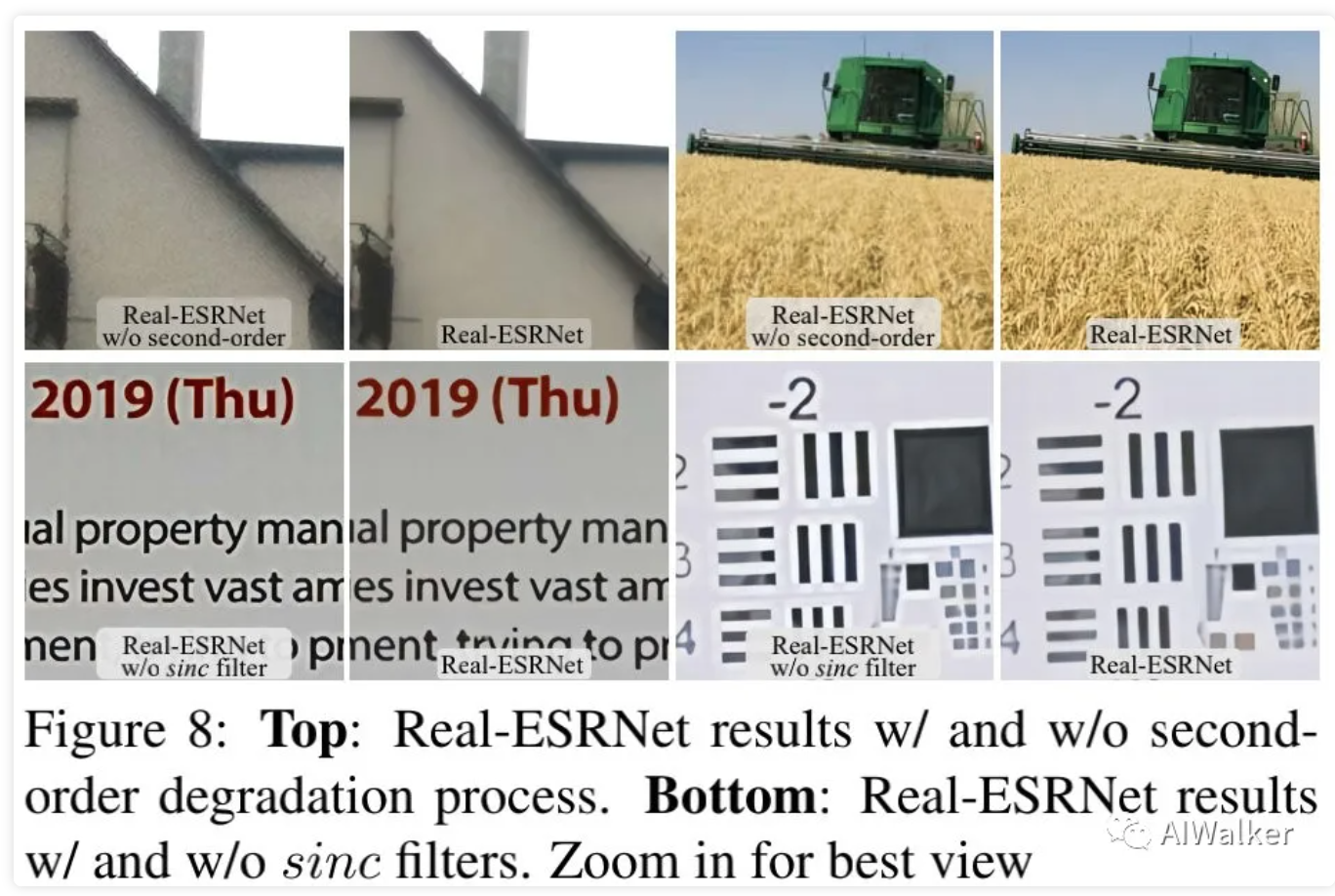

下图的Top对比了二阶退化模型的有效性,可以看到:当采用二阶退化模型后,模型的重建效果更佳;

上图的Bottom对比了sinc滤波器的作用,可以看到:退化模型引入sinc滤波器训练的模型可以有效移除伪影问题。

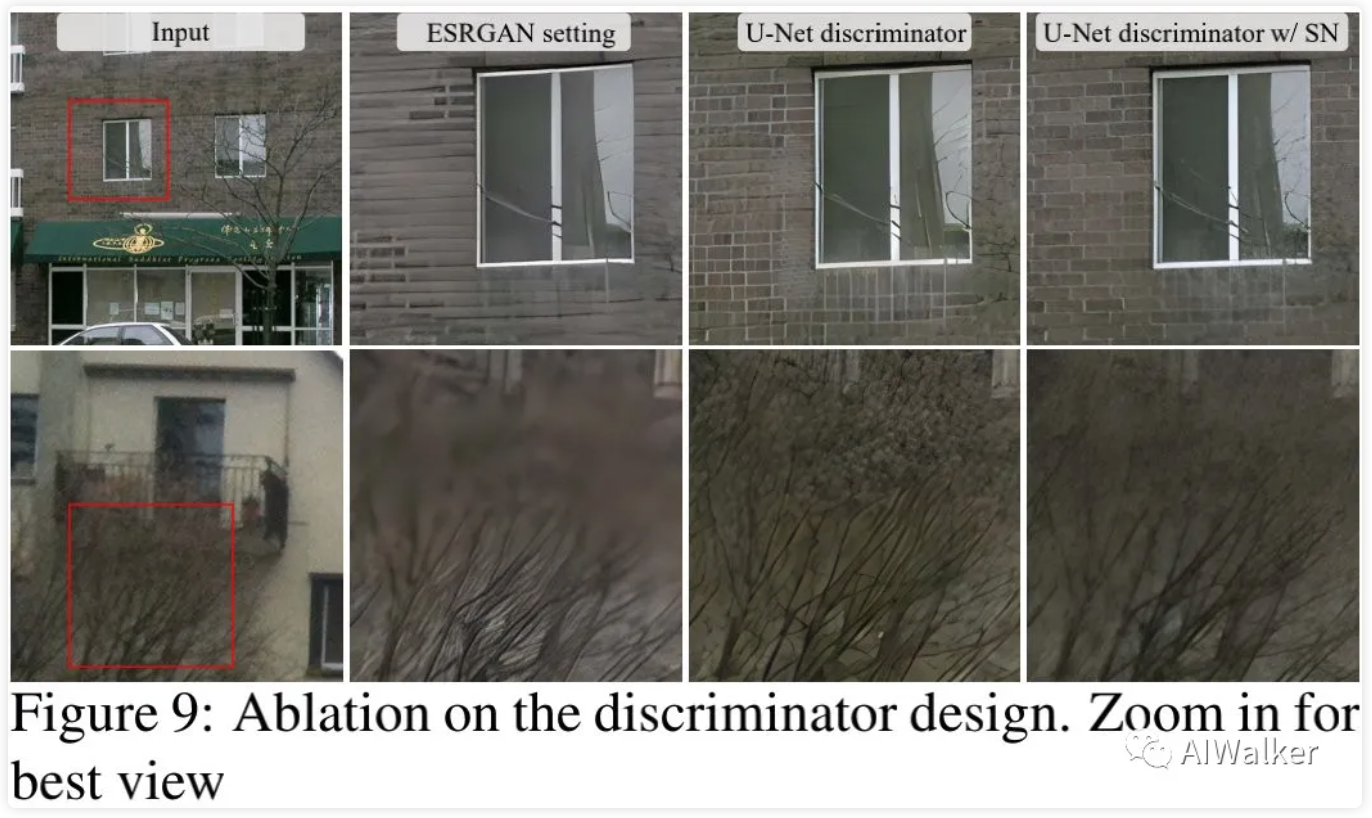

上图对比了不同判别器的作用,可以看到:SN+UNet的组合可以取得了最佳的视觉效果。

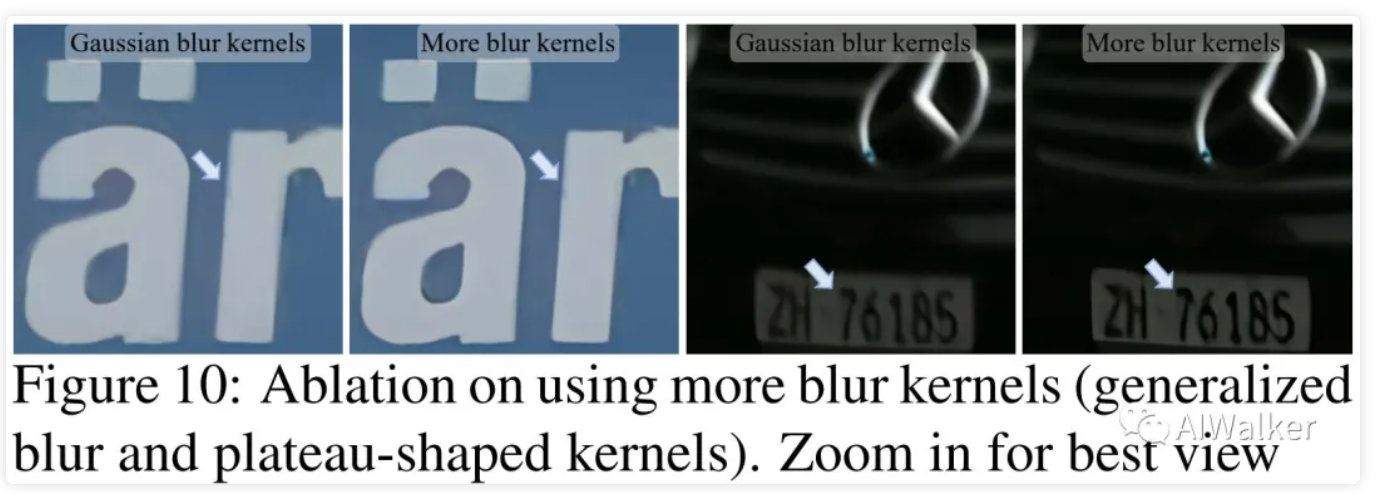

上图对比了退化模型空间大小的影响,可以看到:高阶退化过程+高斯模糊已经覆盖非常大的模糊空间,所得模型可以取得非常好的效果;当引入更多的模糊核,模型还可以进一步提升。

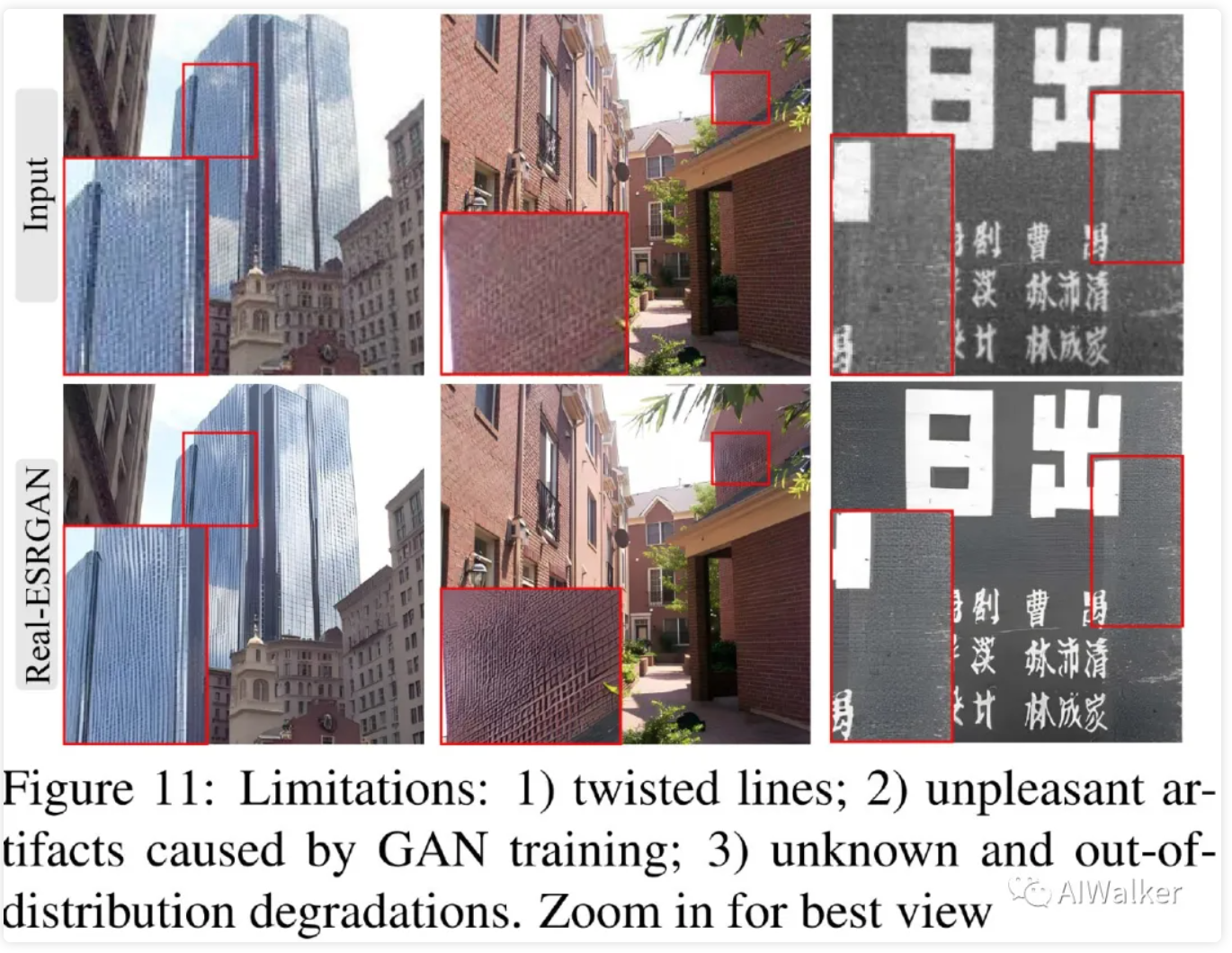

最后,作者还提供了三个表现不够好的场景,见上图。这些场景均为目前盲超分领域亟待改善的场景,比如第一种的过于细的线条场景;第二种则是GAN自身导致的伪影问题;第三种则是域外退化。

“瑕不掩瑜”,Real-ESRGAN的效果真的非常不错,尤其是在盲图像超分这个朝着实用出发的领域。合成数据的图像超分基本已经做到了极致,但盲图像超分仍处于初步探索阶段。之前的BSRGAN以及本文的Real-ESRGAN均为该领域提供了一个非常好的基线。

首发:AIWalker

作者:HappyAIWalker

推荐阅读

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏深度学习从入门到精通。