作者注:2016年9月23~24日,我应邀出席2016全球运维大会(GOPS)上海站,担任基础架构专场的出品人和讲师,在24日下午的专场第二个出场分享,题为《你以为你以为的超融合就是超融合?》,澄清对超融合架构的概念和组成等方面的误区,并展望了未来的演变方向。本文是演讲内容的速记整理配PPT截图,供大家参考。

接下来是我自己的分享,在(阿里巴巴基础资源事业部副总经理)闫昆之后讲压力挺大的,因为根据我参会经验来讲,排在BAT后面讲,要留住听众不容易。刚才第三位先生问到基础架构中IT的部分,我们说基础架构也好,基础设施也好,从硬件层面来看,大家可能也看到今天闫昆穿红色,我是黄色,是一个经典的组合——番茄炒蛋。

闫昆(左)讲机房,我(中)接着讲IT,正好形成“番茄炒蛋”组合。其实,闫昆穿的是GOPS上海站统一发给讲师的红色T恤(我23号穿了,没好意思连穿两天),而27号在北京举行的开放数据中心峰会,下午分会场的主持人和演讲嘉宾也有统一的黑色T恤(右)。这种“制式服装”也算是各种大会的一道风景吧……

其实基础设施一部分是机房另外一部分是网络、服务器、存储等IT设备,站在IT角度来说,机房又是他们的基础设施或者是基础架构。在差不多十年前,这两个部分彼此相对独立,但是在现在由于各种大的趋势,他们越来越密不可分,这部分不展开了。

本文内容根据2016全球运维大会上海站基础架构专场的演讲速记整理而成

我今天讲的是关于在IT设备的这部分,因为大家可能看到日程,发现一个比较有趣的现象,今天这一场主要是互联网公司来讲,只有我这一个不是互联网公司,讲的是面向传统的企业要用超融合的设备。所以也是挺有意思的,分别至少有一个百度一个阿里一个腾讯(BAT全齐)的负责基础架构的人问过我——“超融合”是什么意思?也还包括市场上遇到超融合有很多的误解、误读,所以我这个标题是“你以为你以为的超融合就是超融合?”,是高效运维的萧帮主点的题。看起来很霸气,主要是针对市场上的很多误解。所以我马上会讲超融合在技术构成上的方方面面,但是它的问世很重要一个原因是简化运维和部署。

简单介绍一下我自己:我们致力于新技术和新产品的市场教育,所以我们并不生产产品,我们主要是第三方的分析和研究的工作,这是我们的公众号,大家有兴趣可以扫描关注一下,里面有很多关于超融合分析的文章。我们这部分既然是分析超融合的市场和技术,所以会提到很多厂商和产品,但是不是广告的成分,完全是因为我们必须要拿一些代表性的厂商和产品来举例,这里我尽量隐掉他们的Logo出现。

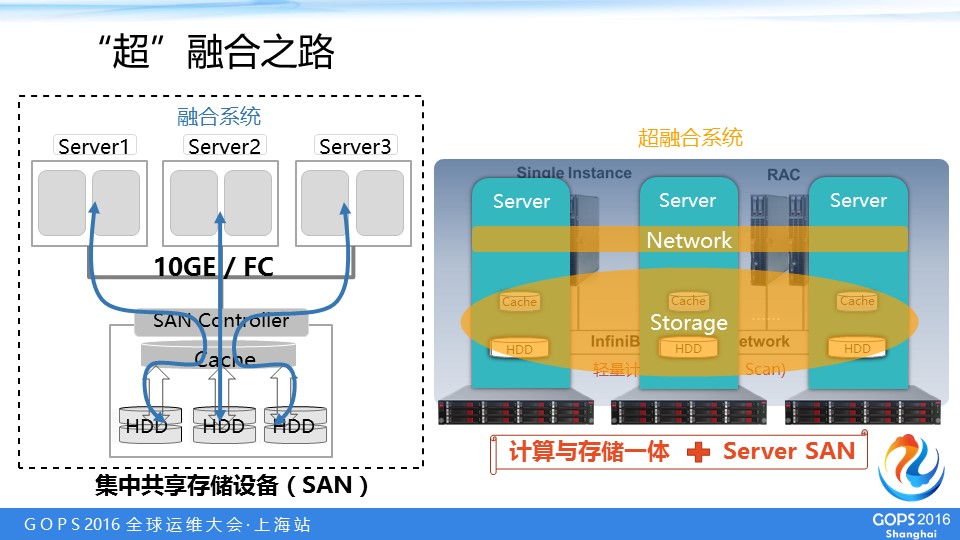

主要分5大部分。第一,什么是超融合。因为很多人问我超融合的事情,我首先都说,要知道什么叫超融合,首先要知道是“超”的什么融合?在这之前,融合是什么?我们知道,其实像IT设备包括服务器、网络这些东西一连就可以用了,对互联网公司就是这样的。但是对传统企业的IT,里面还有一个东西叫做“存储”,SAN(Storage Area Networking)或者说存储区域网。存储是一个单独的存储设备,用起来是很麻烦的。刚才在会议开始之前,我们在大屏幕上过PPT的时候有一位先生问我,说他家里存储的问题,他家里有15个硬盘了,好几十TB的数据,一说到存储,确实,新买一台电脑分分钟的事情,而要加一些硬盘怎么管理则是很麻烦的事情。

在传统企业里存储还有自己的网络——以前是光纤通道(Fibre Channel,FC),与服务器常用的以太网不一样,导致整个环境很复杂,部署和运维都很麻烦。十多年前Gartner曾经想鼓吹一个叫做“存储经理人”的概念,可是现在存储行业都快被颠覆了,这个概念也没有被炒起来,因为现在这个时代任何过于复杂的东西都会被淘汰。

简而言之,在一个企业里,除了采购服务器还要采购存储交换机和存储设备,采购流程很长,一般可能要几个月或者半年的时间,然后部署也很麻烦,而且懂得存储这套协议的运维人员相对也少,所以就出来一个融合系统。因为这些年流行的一个趋势是把项目变成产品,尽量把在用户现场的施工在工厂解决,与其说把这些设备分头采购,再集中到客户现场部署,不如厂商在出厂的时候就装在一起预配置好了,到用户现场“开箱即用”,但实际上也要设置几个小时,然后就可以用了……管理也有统一的界面,所以这是融合系统。

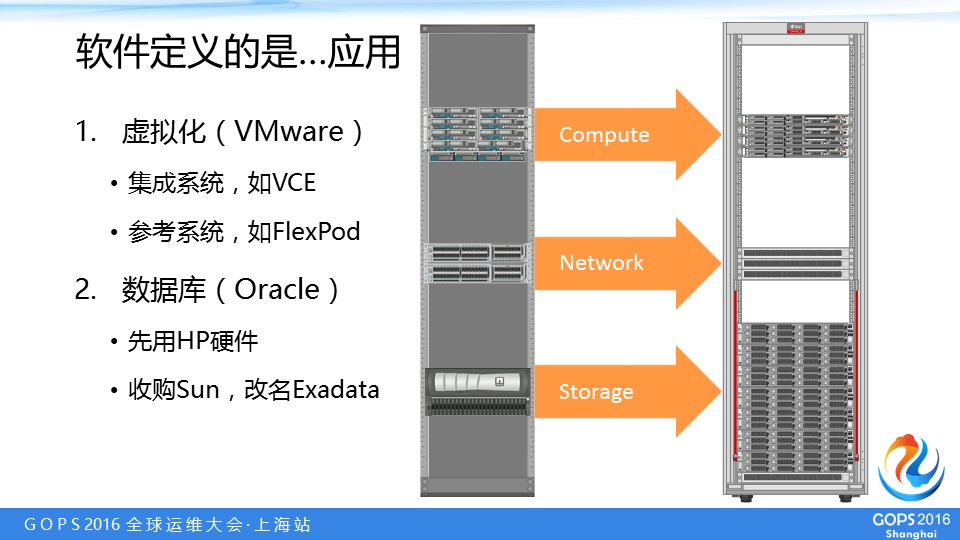

这个融合系统首先出现在两个主要的应用场所,主要是存储密集型的,不然要存储干什么,其实融合系统简单的说核心是解决存储问题。(两个场景中)第一个是虚拟化,是推动上一波存储向上发展的浪潮;另外一个是数据库,需要很高的I/O能力。

我们刚才提的融合系统,里面的服务器和存储都是硬件设备,那软件起什么作用?是上面的应用,它们不定义硬件的哪些行为(即不属于“软件定义”)。以虚拟化为例,上面是vSphere、Xen还是Hyper-V没太大区别。分类上,按照IDC官方的统计,由一个实体向外交付产品的叫做集成系统,最早的是2009年VMware、Cisco和EMC联合成立的VCE,取三家公司的字头,思科的服务器和网络、EMC的存储,VMware提供虚拟化软件;还有一种是涉及到两个或者多个厂商做的,叫参考架构,比如思科后来和NetApp做了一个东西叫做FlexPod,用的思科服务器和网络,虚拟化可以是微软等等。

上面是服务器,思科UCS跟网络有一部分是做在一起,中间是存储交换机下面是(NetApp)存储设备。另外一种是面向数据库的融合系统,也有叫集成系统,它开始比上面的虚拟化还早,2008年Oracle就跟惠普合作了,后来2009年Oracle把Sun收购了,x86服务器之间没有太本质的区别,就改用Sun的硬件,名字叫Exadata,这上面是数据库服务器,下面是存储服务器。它们两个有很大的区别,左边是用传统的SAN存储设备,右边是用x86所谓存储服务器做,中间也换成是InfiniBand(IB)交换机,这个后面会提到,然后向超融合方向演变。

那传统融合系统有一个很大的问题就在存储这里,上面服务器跑应用,这个水平的扩展没有问题,到时候往里加服务器就可以,但是存储是单一的设备,用光纤(通道)连过来,下面有很多的盘,但上面一定要经过一个集中的控制器,这个控制器会成为瓶颈,如果存储不够用,再加一个存储用了它自己的控制器,它们两个变成两个存储的孤岛,这个整合是很麻烦的事情,这是很典型的集成系统。

右边是Oracle的Exadata,向前进了一步,因为存储用的是x86服务器,有一定计算能力,虽然没有(上面的)数据库服务器配置高,但是可以进行一些简单的运算,比如一个很简单的查询,查询一个TB的数据,目标数据只有几百兆,那与其通过网络(把整个数据集)上传到数据库节点做查询,不如这么简单的查询就在各个存储节点做,只把结果数据返回过去就可以了,这是Oracle独有的技术叫Smart Scan,实际上已经把轻量级的计算任务在存储阶段完成了。虽然还是集成系统,虽然还有单独的存储角色,但是有一定的进步:第一不是传统的SAN存储设备,第二存储端可以运行一些计算。所以这个基础上,再往前走一步,就是所谓超融合系统,简单的说既是服务器又是存储,他们上面跑着计算的应用,同时还可以把自己本地的SSD和硬盘这些存储资源通过软件做成分布式存储,形成一个统一的资源池,这样就完全的消灭了独立的存储设备,这种软件定义存储其中一个很主要的分支是Server SAN,因为这是用服务器做到SAN的效果,上面还要跑计算的应用,所以什么叫超融合?就是计算和存储一体,用同样的(标准化)硬件上面通过Server SAN实现存储功能。

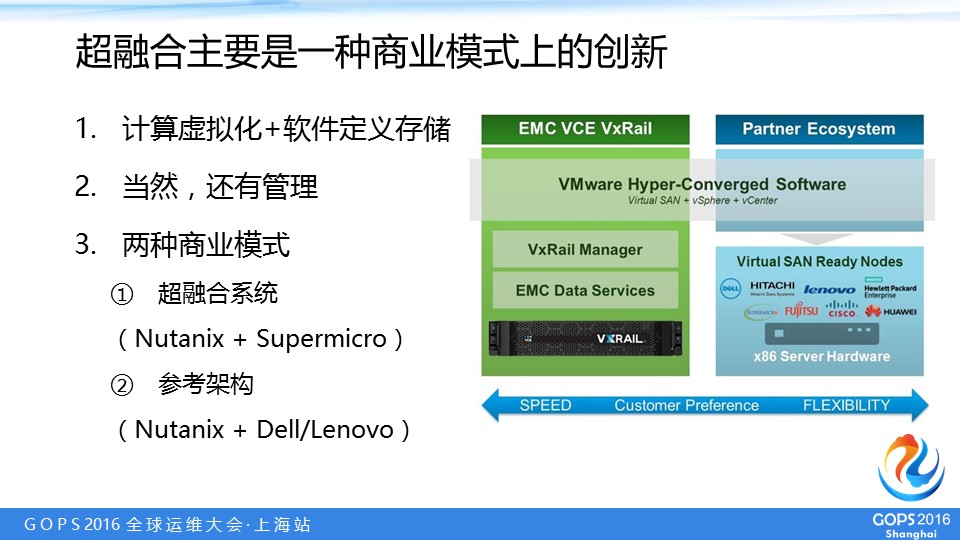

所以我们可以看到,所谓超融合(更多)是商业模式上的创新,只要有了软件定义存储(SDS),这个产品把它(和计算)放在一起,就可以做一个基本的超融合系统,核心的部分产生了,当然还要管理。因为Nutanix是超融合市场的开创者,这是他们产品的架构图,这下面灰色的部分大家不用关心,它的名字我也不用提了,就是计算和软件定义存储的部分。

另外一个是在Nutanix出来以后,因为这个本身主要是一个商业模式上的创新,其实技术上并不是很难,只要有这个软件定义存储的产品就可以做。所以在Nutanix公司出来以后,VMware开发自己的Virtual SAN(vSAN),就演化出两种模式,一种是通过VCE卖这个东西,还有这里一个叫VxRail Manager,可以做整个系统的硬件和软件统一管理,这个他自己卖。另外一部分就只有vSphere虚拟化和vSAN,因为VMware不能只做戴尔或EMC的生意,所有服务器厂商都是他的客户,允许所有服务器厂商可以用他的vSAN和计算虚拟化(vSphere)的产品做他们自己的超融合,只不过不提供管理这部分,管理这部分要(服务器厂商)自己去开发,这个项目叫vSAN ReadyNode。

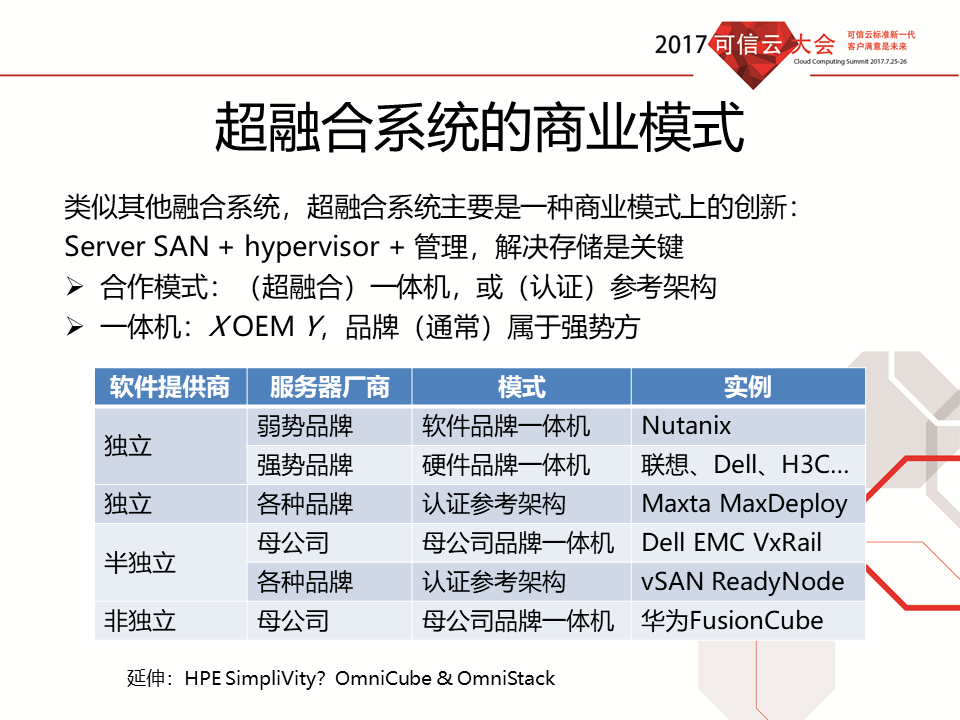

此处插入我在2017年可信云大会上分析的超融合系统商业模式,供参考

这里可以体现虽然管理不是超融合的基石,但也是其中不可缺少的一部分。其实这种情况下超融合有两种卖的方式,一种是左边的这种,一个完整的系统,一个整体方案交付。Nutanix最早就是这么做,用(在最终用户端)名声不是很大的Supermicro的服务器硬件,打(Nutanix)自己的品牌。但是Nutanix作为一个创业公司能直接覆盖的用户还不够多,所以先后跟戴尔和联想合作,以戴尔和联想的品牌卖,Nutanix提供软件,但是最后的交付方还是一个统一的完整的软硬件兼有的设备。所以这(上下)两种模式分别对应左右这两种模式,与融合系统时代的集成系统和参考架构之分颇有相似之处。这是前面是关于超融合系统的一个介绍。

推动超融合的“幕后黑手”

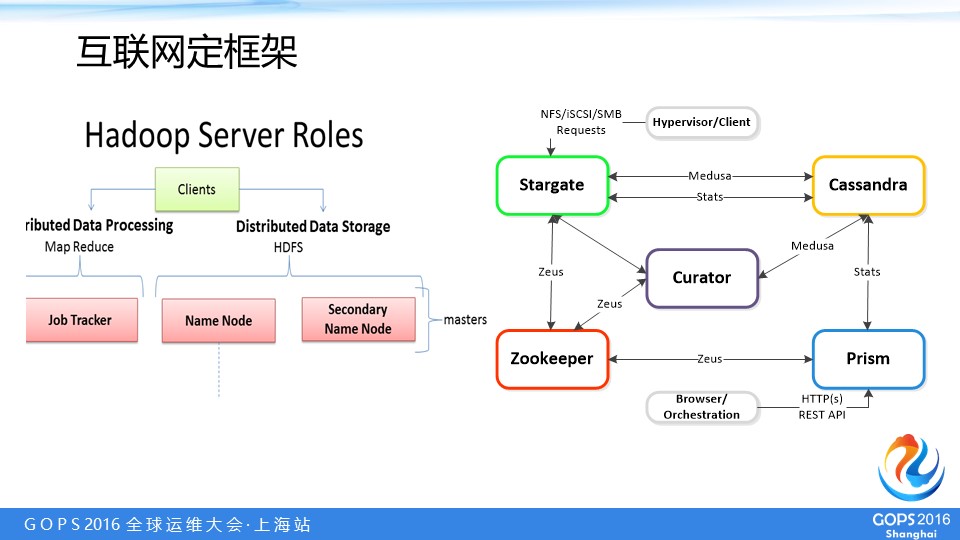

下面这部分是关于超融合的推动力,虽然“超融合”这个概念很多做互联网基础设施的专家都不了解,但是既然计算和存储一体,互联网公司很早就做了,谷歌是先行者,所以这可以算是超融合的一个开端,到现在有十年了。另外,不仅仅这种概念是传统企业市场向互联网学习的,在实际当中他们也用很多来源于Hadoop或上溯到谷歌的技术,右边图就是上一节说的Nutanix Prism管理,大家肯定可以看到左下方ZooKeeper是Hadoop里面的一个项目,包括还有右上方Cassandra也是历经几家著名的公司开源出来的,还有中间的Curator也是用于MapReduce集群的管理和清理,这些基本都是从谷歌或Hadoop学的分布式管理的框架,所以超融合系统确实是传统企业IT向互联网学习的一个产物。

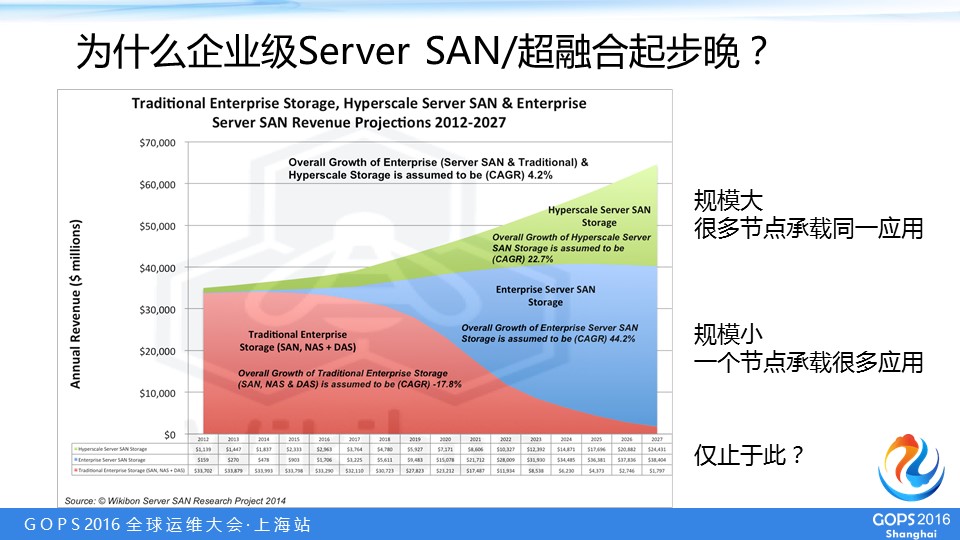

有一个分析公司Wikibon,是Server SAN积极的鼓吹者,因为超融合基本上是计算虚拟化加上Server SAN,所以我们可以拿Server SAN市场来看超融合的市场,这是他们对到2027年超融合市场的一个预估,当然这个预估有些激进。下面红色的是传统SAN(和NAS+DAS)存储,上面绿色的向上走是大型互联网公司用的(Hyperscale)Server SAN,中间这个蓝的部分是企业级的Server SAN。Hyperscale的规模很大,很多节点承载同一应用;传统企业市场往往在一个节点上有很多应用,但是他们的区别不仅仅在这里。像刚才说的,其实十年前就已经有(来自Hyperscale的)超融合的开源的方案,但是为什么这几年才开始在企业市场推出,很大程度上就因为硬盘,因为存储的性能,硬盘性能很差,所以像Hadoop——当然现在有些变化——以前是一个离线的应用,可以几个小时做一个分析的业务,其实对这种应用来说像硬盘这样的性能就可以了,但是如果做交易那是不够的。

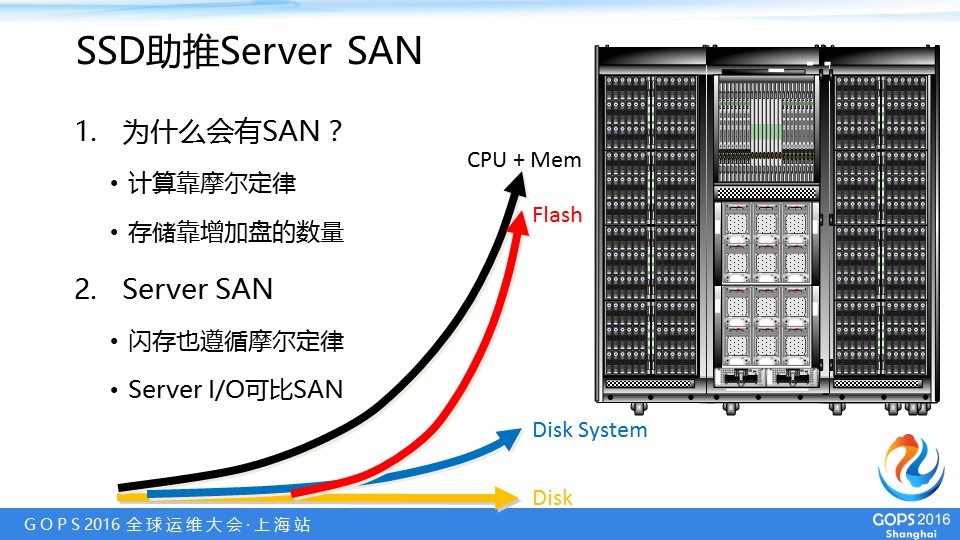

我们可以看到这是横轴是时间,CPU和内存是半导体,半导体可以遵循摩尔定律,性能随着时间推移是指数级的增长,但是硬盘是机械的设备,大家现在可能自己的电脑里放SSD,以前是硬盘,一直都很慢,这种情况下提升存储性能要靠增加(硬盘的)数量,比如十年前有一个存储系统是240个盘,过两年升级,最大的变化是增加到480个盘,性能可以提高一倍。比如右边这是一种高端存储系统(SAN)的低端型号,这是72个盘,中端型号盘数增加一倍,高端型号盘数再增加一倍,在堆盘的情况下用服务器堆是不划算的,因为服务器是很可能十几个盘就配几个CPU,实际上少数硬盘用不了这么高CPU的性能,所以盘堆上去有很多CPU就浪费了,所以这种情况下传统SAN存储是有优势的。

但是为什么这五六年Server SAN起来了,因为出现基于闪存的SSD(Solid State Drive,固态盘),它也是半导体,性能增长也是按照摩尔定律来的,而且还可以通过增加芯片数量获得更高的容量和性能,所以他的容量和性能往上提升反而能比CPU还快一些,在随机访问性能上一个SSD可以抵好几百个硬盘,那就没有必要堆好几百个硬盘了,一个服务器的存储性能潜力可以跟原来上千个盘的存储系统相比了,所以SSD的普及是超融合系统能够在企业存储市场崛起的一个很重要的因素。

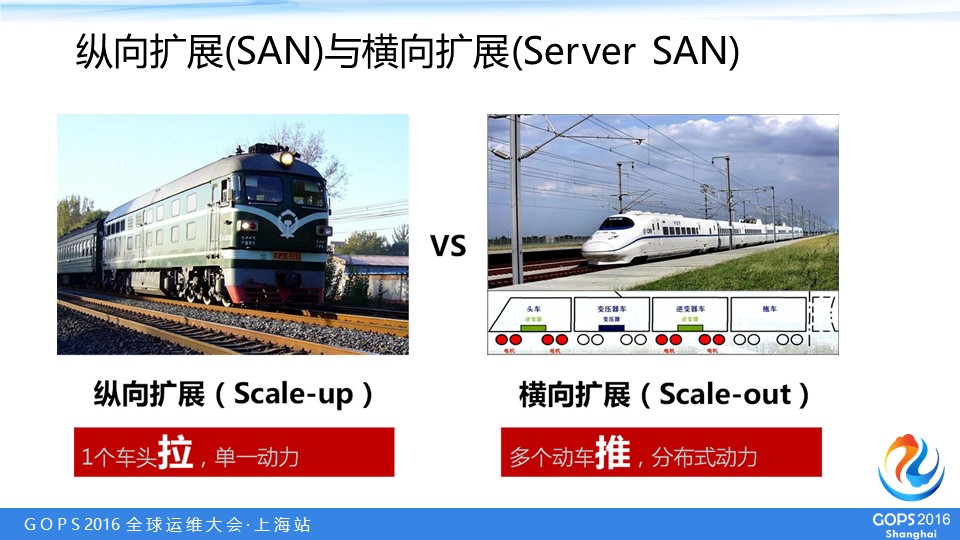

这两张图片涉及到前面说的纵向扩展(Scale-up)和横向扩展(Scale-out),传统绿皮车头就是Scale-up,跑的很慢,增加车厢数量只带来容量增长,速度(性能)不增长反而会下降。然后横向扩展是像高铁动车组,每个车箱都有动力,加车箱既可以放人又可以提高动力,所以加车箱并不会跑的更慢还可能跑的更快,但是这个比方我觉得有一个问题,因为时间因素这里不去剖析。

我更愿意从存储的角度,用瓶子的角度做比方,这个瓶子可以装很多水,把瓶子拉长可以装更多的水;但是上面有一个瓶颈,那要好几个人喝,喝水的速度不会加快,就是便于储存,不便于访问。杯子正相反,一个杯子装的水没有它多,但是加很多的杯子,每个人拿一个杯子喝,喝水的速度绝对快很多,所以杯子更多的这种方式更像横向扩展,更多是为被访问而优化。当然这也带来了一些问题,比如很多杯子要只是存这个东西,很多杯子比一个瓶子要贵的,也就是只做储存(如冷数据)的话不划算。

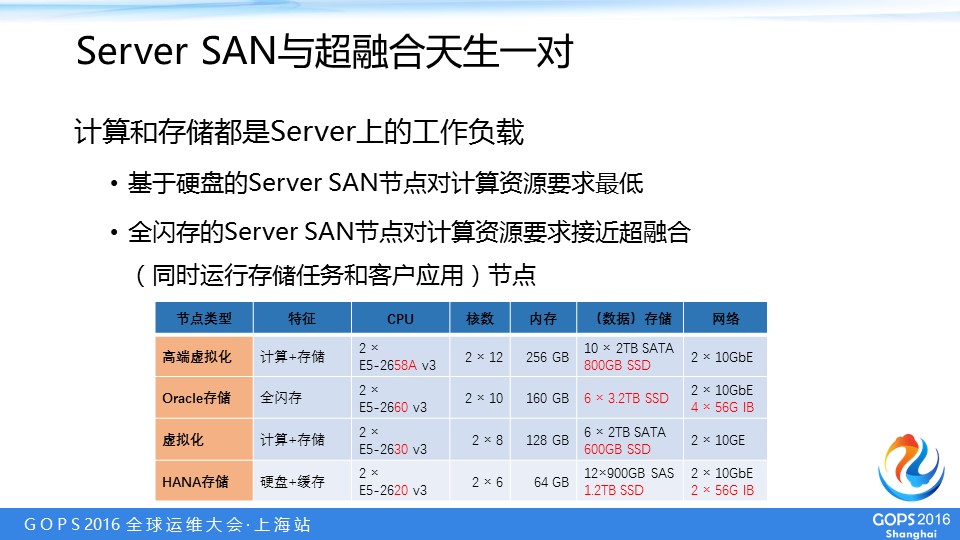

另外一个,我刚才说,为什么很多时候Server SAN和超融合我们会混淆着来说,因为计算和存储任务实际上都是运行在标准的x86服务器上的应用, Server SAN是软件用CPU实现存储的功能,这样的话,它跟用户的应用,也是一个计算任务,所以计算和存储都是Server上的负载。我们可以看到这是华为FusionCube超融合系统的几个典型的配置:

- 最底下因为前面已经说了,确实SSD助推Server SAN和超融合的发展,但是毕竟现阶段,尤其对企业用户而言,用全闪存方案不太现实,所以入门级的方案都拿SSD给硬盘做缓存——但也见不到连SSD都没有的企业级超融合,因为那个性能没有办法接受,所以里面每个节点至少有一个SSD,其实最低就是每节点用一个SSD给硬盘做缓存,用6核CPU就够了。

- 再往上这是一个能够运行虚拟化的超融合节点,它用CPU高一点是8核的,然后内存大些,100多GB,多出来给虚拟机用,存储也是硬盘加SSD缓存。

- 然后到全闪存的节点,就高性能的SSD,它的CPU是10核,内存容量更大。

- 最上面是一个高端虚拟化的节点,也就是它对计算性能要求更高,上面跑的VM比较多,所以用12核的CPU,内存200多GB,主要用来支持更多的虚机(VM)。

但是闪存的输出能力很高,也要配很多的计算资源给它。所以我们可以看到上面相邻的两项,全闪存Server SAN节点的计算资源配置很像超融合。一方面,I/O负载和虚机对计算资源的消耗一定程度上是等效的;另一方面,Server SAN(的节点)上面只要跑一个(用户)虚机就变成超融合了。所以,Server SAN和超融合真没有太大区别。

另外商业角度也积极推动超融合。因为这两年超融合很热,很多服务器厂商在积极宣传它,因为他们终于找到一个可以打败存储厂商的机会。十年前服务器厂商也有SAN产品,但是技术和商业等原因决定了他们的存储业务做不过纯粹的存储厂商,上面这个曲线就显示了从04年到11年的存储市场份额,HP、Dell、IBM三家服务器巨头加起来(红线)也不是EMC和NetApp(绿线)的对手,差距越拉越大。现在,超融合就是把SAN存储消灭了,所以他们(服务器厂商)推动这种趋势。

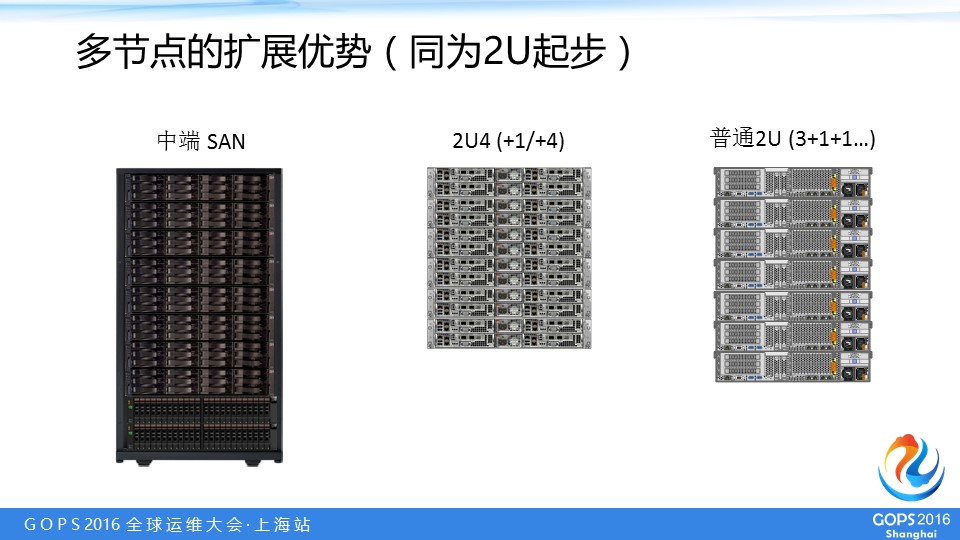

这种情况下也包括多节点服务器很受欢迎,因为Server SAN也好,超融合也好,存储都要用多副本的方式,包括管理方面和容错需求等各方面要求最小三个节点起步,所以2U4节点特别合适。这种服务器有很高密度,而且4个服务器节点共享两个电源模块和相对大尺寸的散热风扇,但在之前对国内传统企业用户没有很高的吸引力,高性能计算(HPC)和对密度要求比较高的领域会用到。但是从Nutanix基于Supermicro的2U4节点服务器推出超融合以后,2U4就成了超融合的标准硬件配置,所以很多模仿它的公司都用这种硬件,带动基本上每一家服务器厂商——以前只有较少的服务器厂商有这样的产品,现在几乎每家服务器厂商都有这种产品,主要就是为了满足超融合市场的需求。

我们看看多节点的优势在哪里,在左边是一个中端的SAN存储,一个最小配置是2U的节点是双控制器,前面带十几(3.5英寸)二十几(2.5英寸)个盘,(超融合方面)如果用普通的2U存储服务器要做一个起步的配置三个节点就是6个U,这比传统的存储起步还要高,而且起始交付要三个箱子(不包括交换机)很麻烦。要扩展的时候中端的SAN往下带盘柜,不管多少都只有上面的(那2U)控制器有处理能力,所以不能带太多,这款只能达到十个盘柜,但是超融合2U4扩展很容易,最少可以加一个节点变成2U4的节点,也可以每加2U就多4个节点的来扩展,而2U存储服务器每加2U才一个节点。

Hyper是几个意思?

第三部分来解释一下Hypervisor与超融合的关系。前面我说“超”(Hyper)是相对于之前的“融合”而言的,但也有人认为“Hyper”代表hypervisor,即基于hypervisor的虚拟化,用户应用跑在VM里。早期(如Nutanix)和现在主流的超融合系统确实是这样,但不代表超融合架构就必须这样。

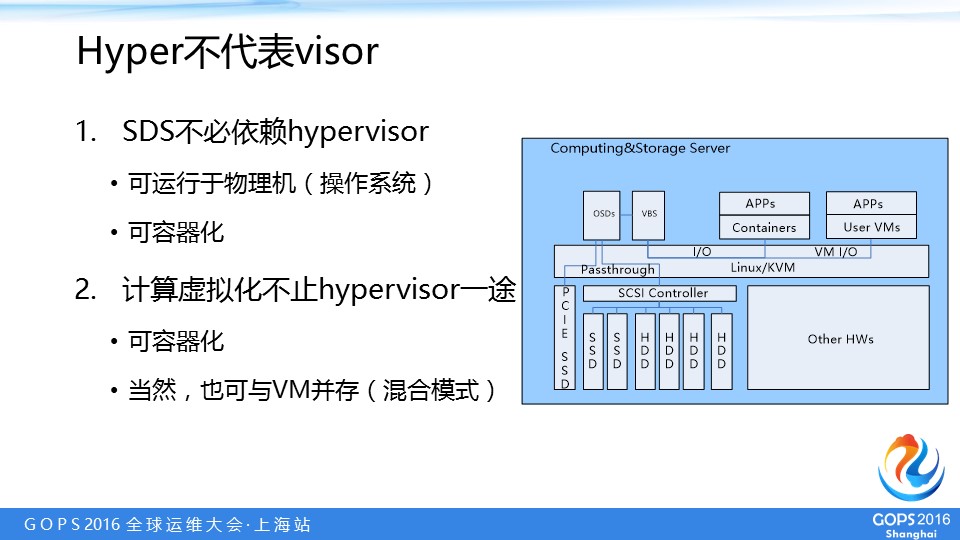

我们回顾一下最开始提到的超融合架构(HyperConverged Infrastructure,HCI)两大基石:软件定义存储(SDS)或者说Server SAN,并不一定依赖hypervisor——既可以直接运行于裸机,也可容器化;计算虚拟化呢,通过hypervisor也只是一种方式,我们还有容器呢。当然,有hypervisor支持的话,形成裸机、VM、容器并存的混合架构,也是可以的。

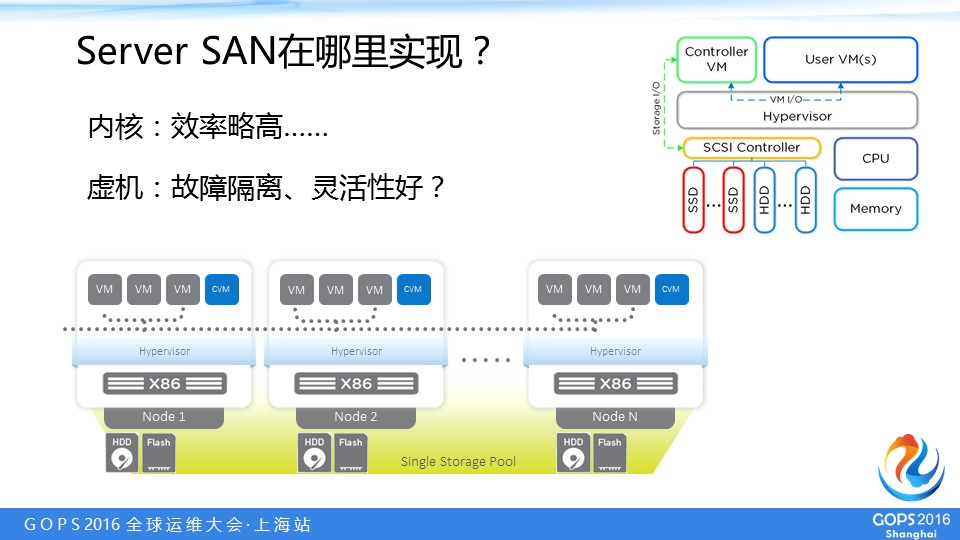

接下来就来看Server SAN与hypervisor的关系。Server SAN或者软件定义存储功能在哪实现是有一些区别的,比如可以在操作系统内核级实现,每个节点有它的自己的硬盘和闪存资源,用hypervisor——当然可以不是hypervisor,这里用来说明是内核级别——形成跨节点的统一存储池,Server SAN的功能就实现了,vSAN就是这么做的,其实在这种架构下是可以没有hypervisor(如果替换成普通的裸机操作系统)和VM的。

但是,也可以在上面单独装一个蓝色的控制虚机(Controller VM,CVM),右上角是Nutanix最早的架构图,用户虚机(User VM)的所有存储I/O都要通过这个控制虚机处理,这种架构显然离不开hypervisor和VM,因为首先不是用户应用(计算虚拟化)而是其自身存储功能(SDS/Server SAN)实现的需求。在内核层实现的效率略高,但是内核层也有它的问题,假设操作系统(OS/hypervisor)出问题了,如果纯存储节点只是存储不能用,但是如果上面这个节点跑用户虚机(超融合嘛),可能用户虚机也挂了,所以有一个单独的控制虚机实现,可能故障隔离和管理更灵活,比如下面hypervisor可以是微软,还可以是Xen……但是实际上,后面看情况是会变化的。

接下来是容器,我们知道现在国内有很多基于容器的初创公司,包括微服务化是一个发展方向,但是目前对传统企业市场还说来说还为时尚早,所以首先解决容器持久化的共享存储,这方面像Nutanix作为超融合市场上的概念和开创的厂商,也做了面向容器的服务,虽然现在它的架构还是离不开hypervisor和(C)VM,包括它首先做的是为容器提供存储。

现在容器管理很多公司在做,包括像联想做Nutanix的客户是这样,跟DaoCloud有一些合作去推动这些容器化,但是他们详细合作的细节我不太清楚。在应用容器化的情况下hypervisor可有可无,如果存储架构不依赖虚拟机,那当然可以在一个纯容器架构里,不需要再经过hypervisor,譬如把存储功能在宿主机的操作系统中实现。总的来说这不是技术问题,以现在的技术水平而言门槛不是太高,关键取决于传统企业对容器应用的接受程度,也就是市场需求。

网络也要超融合?

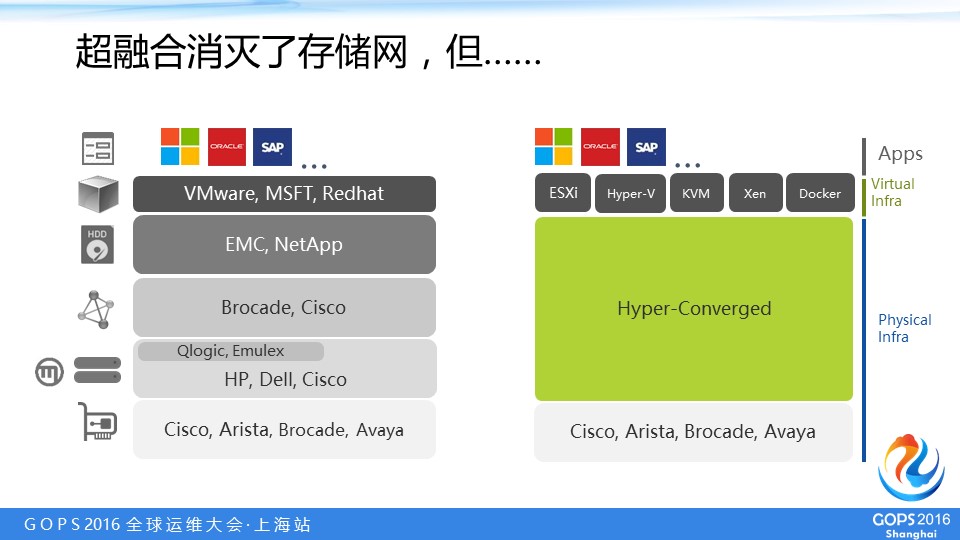

还有一个比较大的问题是网络是不是也是超融合的组成部分,但从目前的定义来说网络还不是。左边是传统融合系统或者传统企业IT不用超融合,最下面是以太网,然后上面是服务器和SAN存储,为了连SAN存储,服务器上必须增加对FC(光纤通道)的支持,得装FC的HBA,然后还要装光纤交换机,再往上是虚拟化和应用。

右边超融合的架构里,最下面以太网的交换机还有,去掉的是服务器上面的FC HBA、交换机和SAN存储,中间部分三合一了,就构成超融合,其实把存储自己特有的东西全融合到服务器里面,然后再往上面可以是hypervisor,也可以是容器,然后再上面再跑应用,这是从架构上来看。

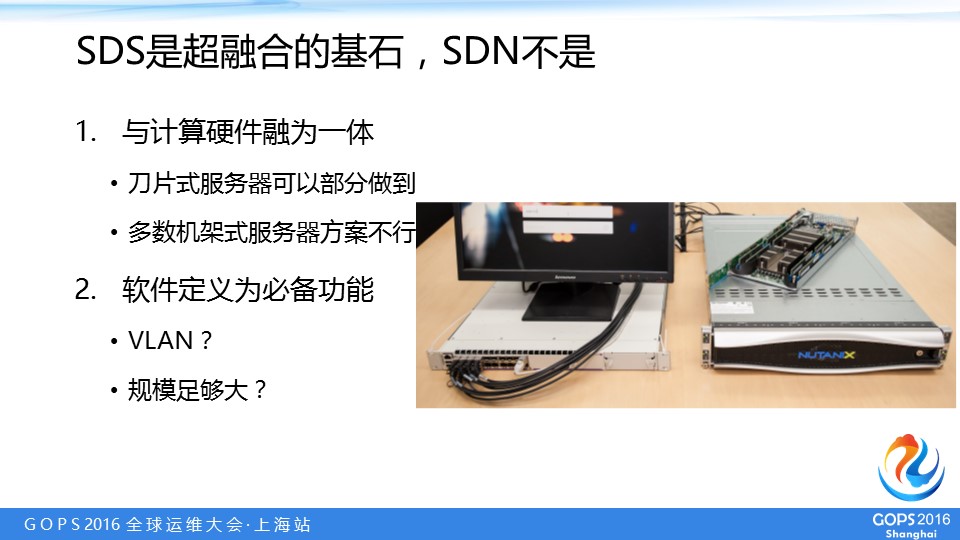

如果按照存储在超融合里做到的两点——与计算硬件融为一体、软件定义为必备功能——来要求,网络也还差得远。右边我们可以看到,Nutanix一个最小的演示环境,一个2U4节点配一台交换机。刀片式服务器可以集成网络交换机的部分,但是仍然有局限,这里就不展开说了(参见《如何“超”融合:超融合架构是与非》),而大多数机架式服务器的方案是不行的。

另外一个主要是因为很多时候SDN还是要到足够大的规模才用得到,比如几千几万个节点,这个时候SDN像hyperscale超融合,是很需要的,比如像阿里、百度他们都有自己SDN的技术,具体怎么应用我不太清楚,但是都是很大规模应用的。但是像一千个节点以内的超融合系统——很多传统企业IT都达不到这个规模——可能大多数用二层功能,或者用VLAN来划分对存储,对其中的软件定义存储就够用了。上面可能会有一些网络虚拟化功能(如VxLAN)但是跟着计算虚拟化层走的,并不是超融合基础架构层必须有的东西,有点儿和NFV一样偏应用层了。

我觉得可以换一个角度来说,因为从融合到超融合主要是消灭(传统)存储设备的问题,因为SAN存储太难用,所以大家想把它简化。网络不是超融合必不可少的部分,我们换一个角度来看,因为网络比较成熟的比较好用的,至少还没成为必须解决的问题。

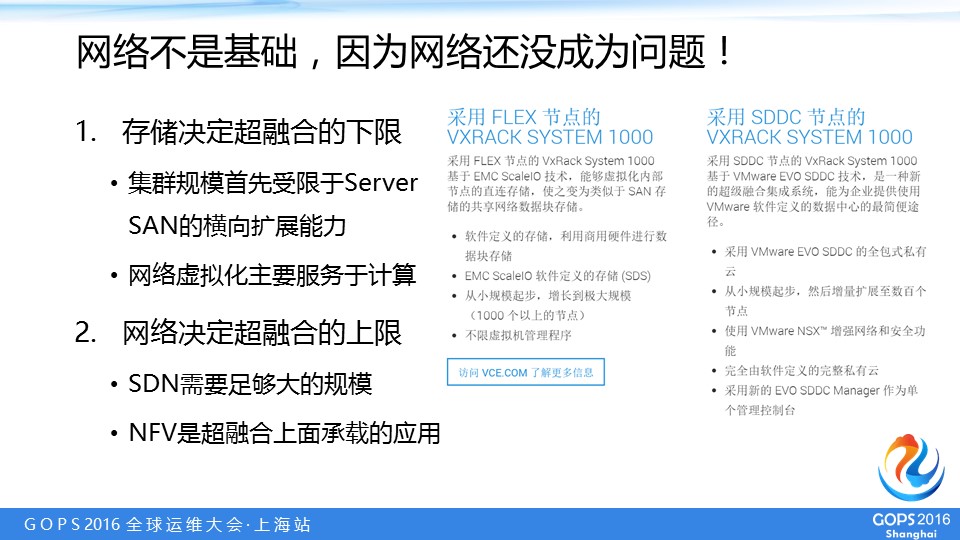

所以现在来说,存储是决定了超融合的下限,这个超融合系统能扩展到多少节点很大程度上都是由其软件定义存储(Server SAN)的扩展能力决定的,比如这里是(EMC旗下)VCE的两个机柜级超融合系统的方案:右边的方案是基于vSAN,它的扩展能力不好,所以宣称可以扩展几百个节点;左边是用ScaleIO,扩展能力比vSAN强,所以号称是一千个以上的节点。当然这些宣传有水分的,但是由同一家宣传的,所以还是有可比性的。所以我认为未来网络会决定超融合的上限,但是首先还是要达到足够大的规模。

超融合的进化or分化?

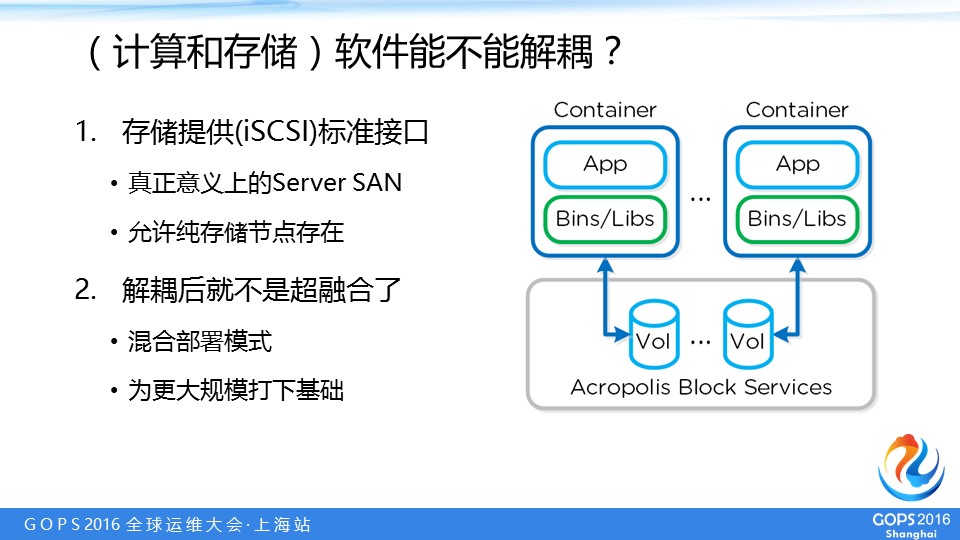

最后一部分是超融合的未来的发展,也关系到更大的规模。首先,计算和存储软件能不能解耦?是可以的,譬如Nutanix不想让自己的架构局限在虚拟化应用,也开始提供存储标准接口,让裸机能访问,理论上就可以适用于所有类型的应用。这个也不是技术问题,vSAN要想这么做也可以。

当然,解耦之后就不是超融合了。但是,混合部署模式,可以为更大规模打下基础,在这种情况下我们没有必要斤斤计较,非说有纯存储节点了就不是超融合,或者(一个集群里)超融合占多大比例。

这是软件方面,其实硬件方面也需要解耦,我们看到VMware有一个机柜级的超融合的方案,下面这些都是服务器,上面是交换机。其实这里面体现两点:一是即使到机柜级方案,网络仍然是没有与计算存储融合的(这样的整机柜还不能作为一台服务器来看待,所以交换机也不能算作服务器的一个组成部分),二是每个节点是既有计算又有存储的,它的物理配置是稳定的,这符合目前超融合的定义,但也意味着不够灵活。

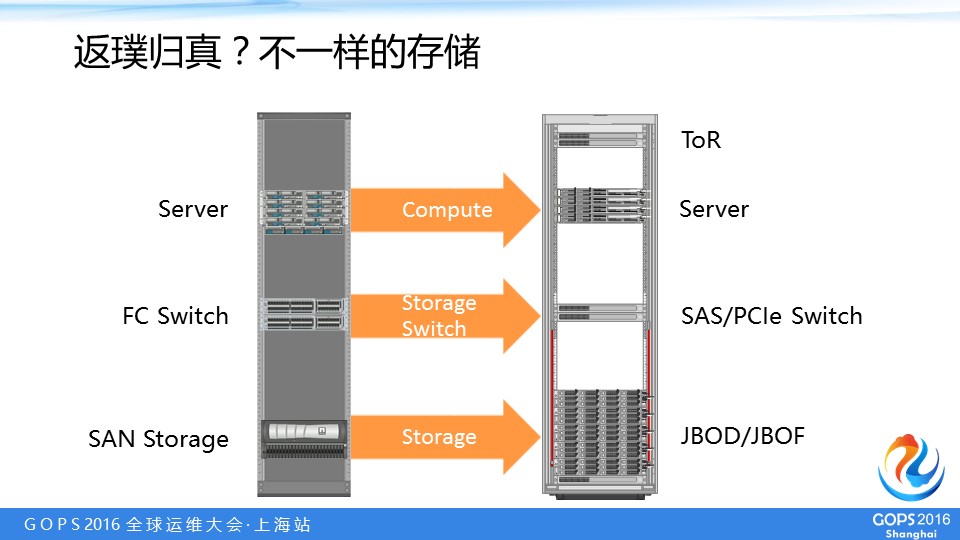

所以未来机柜级别的超融合,有可能在机柜内部还像原来融合系统一样有计算、网络和存储的角色之分,但是服务器、SAN存储和光纤交换机,它有可能演变成这种:服务器有计算能力,中间存储交换机变成SAS或PCIe,下面连的是JBOD或者JBOF(硬盘柜或闪存柜)。

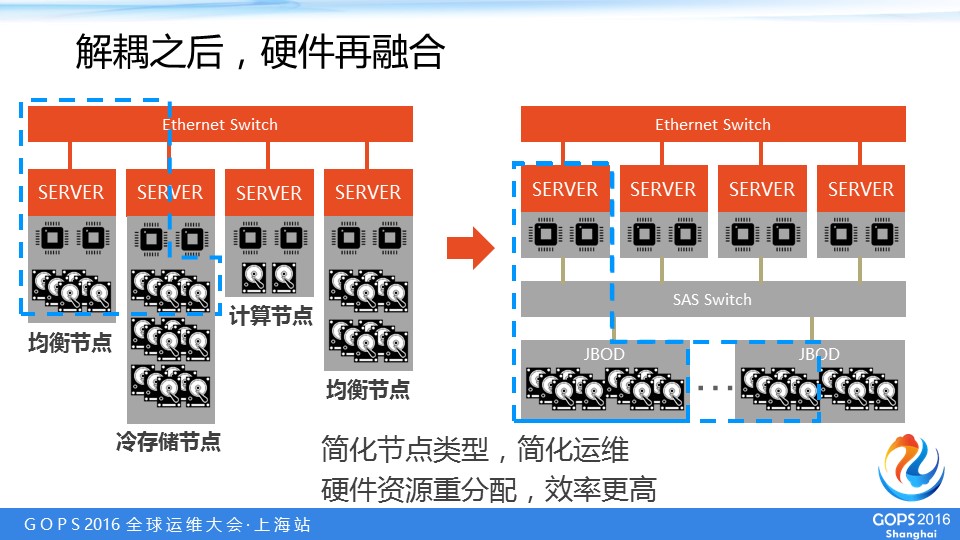

这两种方案的区别,比如这是现在的超融合架构:这个节点计算资源、存储资源比较均衡,这个是计算资源比较多、存储比较少。实际上因为我们知道现在产生很多热数据,过一段时间变冷了,一开始计算和存储的配置是可以的,但是随着时间推移,同样的计算资源可以带动更多的存储资源,那要跨节点分配资源需要网络调度,还要走软件定义存储的层面——要访问另外一个节点,这个节点要管理另外一个节点的存储还要通过它的CPU(计算资源)支持,所以各种损耗是很不划算的。

这种新的架构是刚才说到的架构,比如用SAS交换机分配存储资源,计算是计算,存储是存储,可能一开始配置是这边的JBOD,想扩硬盘的时候主要是SAS交换机多分配一些硬盘就可以,跟其他(计算)节点(Server)没有关系,但是这样存储又重新有了自己的网……这样有两个优点:第一简化节点类型,(最少)有一种计算节点一种存储节点就可以了,然后通过SAS交换机改变它的(计算和存储资源)配比,不用像现在这样有七八种机型;另外是在硬件层面实现资源重新分配,效率也是更高的。

实际上这个方向会(继续)向互联网如BAT超大规模的(整机柜)服务器学习,所以在这部分也是验证了我们在2013年年底写的一本行业技术分析报告《数据中心2013:硬件重构与软件定义》,提这里核心思想就是只讲软件定义不够,如果想获得更好的效果,一定还要有硬件层面的革新,要由它来配合的。在国内的几家服务器公司,有一家服务器公司已经不具出处的用这个“硬件重构+软件定义”的概念,做自己的宣传概念差不多两年了。我们一直在致力于写新版本,但是这个报告本身是一个非盈利项目,所以我们作为一个创业公司,首先要养活自己,不能把主要精力放在写书上面,但是确实很多朋友问我们以前的读者问这个新版什么时候出来,我们争取调配更多资源尽快兑现承诺。

最后总结:超融合是不断演进的架构,是一个商业模式,但是由于组成的技术在变化在进步,所以整体也在演化,在它的基础上可以衍生出很多商业模式。另外一个软件定义到硬件重构,超融合的现阶段还是靠软件定义做到的,但是将来要想扩展更大的规模,适用于更多的场景,因为超融合不是万能的药,想适应更多的应用场景就要突破纯靠软件分配资源的局限性。大家有什么问题下来我们再交流,谢谢大家!