5月13日,百度飞桨开源深度学习平台与瑞芯微Rockchip旗下AI芯片RK1808、RK1806正式完成适配,充分兼容飞桨轻量化推理引擎Paddle Lite。此次百度与瑞芯微的合作,旨在为AI行业赋能更多应用场景,加速AI产品落地进程。

在AI时代,深度学习框架和操作系统类似,起着承上启下的作用,连接芯片与应用。拥有强大算力的AI芯片加持,AI技术将得到更广泛普及。

NPU时代来临,软硬结合性能优化

飞桨产业级深度学习开源平台以百度多年的深度学习技术研究和产业应用为基础,集深度学习核心训练和预测框架、基础模型库、端到端开发套件、工具组件和服务平台于一体,2016年正式开源,是中国极具影响力的全面开源开放、技术领先、功能完备的产业级深度学习平台。Paddle Lite是飞桨推出的一套功能完善、易用性强且性能卓越的轻量化推理引擎,支持多种硬件、多种平台,具备轻量化部署、高性能实现等重要特性。

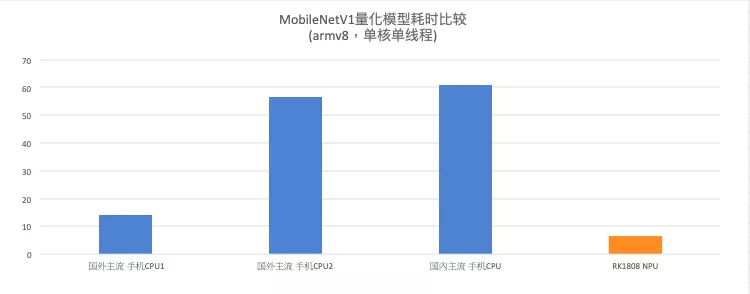

瑞芯微AI芯片RK1808及RK1806,内置独立NPU神经计算单元,INT8 算力高达3.0TOPs;采用22nm FD-SOI工艺,相同性能下的功耗相比主流28nm工艺产品降低约30%,在算力、性能、功耗等指标上均有优异的表现。经实测,瑞芯微AI芯片在Paddle Lite中运行MobileNet V1耗时仅为6.5 ms,帧率高达153.8 FPS,二者充分兼容并高效稳定运行。

如下图所示的实测結果可以看出,与手机等移动端常用的国内外主流CPU相比,RK18系列NPU在MobileNET_v1的耗时表现出色,由此证明在AI相关领域,如图像分类、目标检测、语音交互上,专用的AI芯片将带来更出色的效果。

通过适配飞桨开源深度学习平台,瑞芯微芯片将能更好地赋能国内用户的业务需求,为端侧AI提供强劲算力;二者的融合,将充分发挥软硬件结合的优势,加快开发部署速度,推动更多AI应用的落地。

国产芯合作升级,实操教程详解

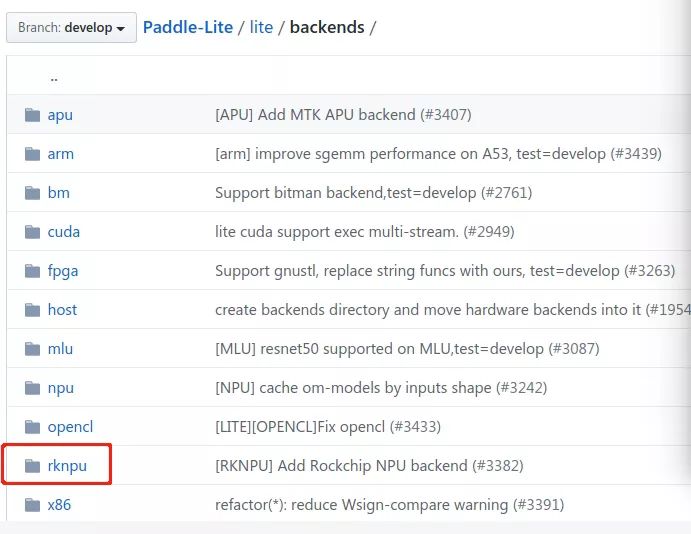

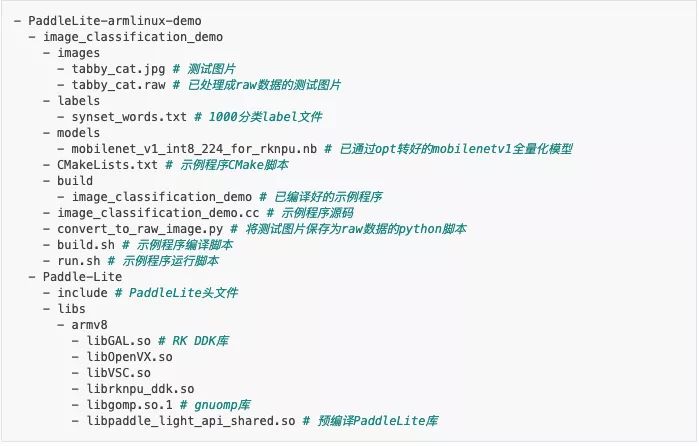

在飞桨上,瑞芯微AI芯片的详细操作方法可参考Paddle Lite文档,内容涵盖支持的芯片、设备列表、Paddle模型与算子及参考示例演示等等。

https://paddle-lite.readthedo...

此外,除RK1808及RK1806芯片解决方案外,瑞芯微旗下搭载NPU的AI系列芯片也将陆续升级适配百度飞桨,进一步深化双方合作关系,携手助力我国自主可控AI生态的构建。

关于飞桨

百度飞桨(PaddlePaddle)是国内自主研发、开源开放、功能最完备的产业级深度学习平台,集深度学习核心框架、基础模型库、端到端开发套件、工具组件和服务平台于一体。飞桨源于产业实践,致力于与产业深入融合,提供了领先的深度学习&机器学习任务开发、训练、部署能力,加速企业从算法研发到产业落地的过程。目前飞桨已广泛应用于工业、农业、服务业等,在百度大脑开放平台和飞桨平台上进行开发的开发者超过180万,与合作伙伴一起帮助越来越多的行业完成AI赋能。

关于瑞芯微

瑞芯微电子成立于2001年,总部位于中国福州,在上海、北京、深圳、杭州和香港均设有分公司或子公司,是中国极具创新精神和务实作风的集成电路设计公司。

瑞芯微电子近年已跃升成为全球排名前列的中国芯片厂商,并累计荣获十三届中国芯奖项。目前公司拥有一支以系统级芯片设计、算法研究为特长的研发团队,并获得多项国内外专利。专注于高端智能硬件、手机配件与人工智能等领域的芯片研发,为智能手机、平板电脑、流媒体电视盒、智能语音、智能视觉、新零售、物联网等应用提供具有竞争力的芯片解决方案。在万物互联的大趋势下,致力于加速融合智能感知技术和实现人工智能场景落地,同时为加快中国芯片产业本土化进程贡献力量。

如果您加入官方QQ群,您将遇上大批志同道合的深度学习同学。官方QQ群:703252161。

如果您想详细了解更多飞桨的相关内容,请参阅以下文档。

官网地址:https://www.paddlepaddle.org.cn

飞桨开源框架项目地址:

GitHub: https://github.com/PaddlePadd...