编者按:AICon 全球人工智能与机器学习大会(北京站)即将在 11 月 5 日和 6 日落地北京,我们邀请了微软技术总监公明博士来为大家分享《必应搜索问答系统及全球化过程中的挑战与方法》,为了让你对议题有所了解,公明老师以文稿的形式为你提前揭露一些内容,希望让你对议题内容有所了解,也欢迎你来会议现场听听各位专家的分享。

随着经济全球化和“互联网 +”的不断深化,海内外各大公司的国际化业务正在如火如荼地开展,产品国际化也成为必然趋势。作为产品国际化的基石,如何实现产品的跨语言扩展、将跨语言理解的核心人工智能技术在产品中落地应用尤为关键。

自 2018 年来基于预训练的 BERT 模型横空出世,自然语言处理突飞猛进,其中跨语言的预训练模型近几年更是成为学术界研究的热点,不仅仅是传统的机器翻译模型,还包括支持上百种语言的自然语言处理任务的模型。

此外,基于跨语言模型的跨语言理解技术在工业界的国际化产品中也进入了成熟落地时期,比如微软的所有产品都需要支持 200 多个地区的 100 多种语言。

产品国际化中语言扩展的挑战

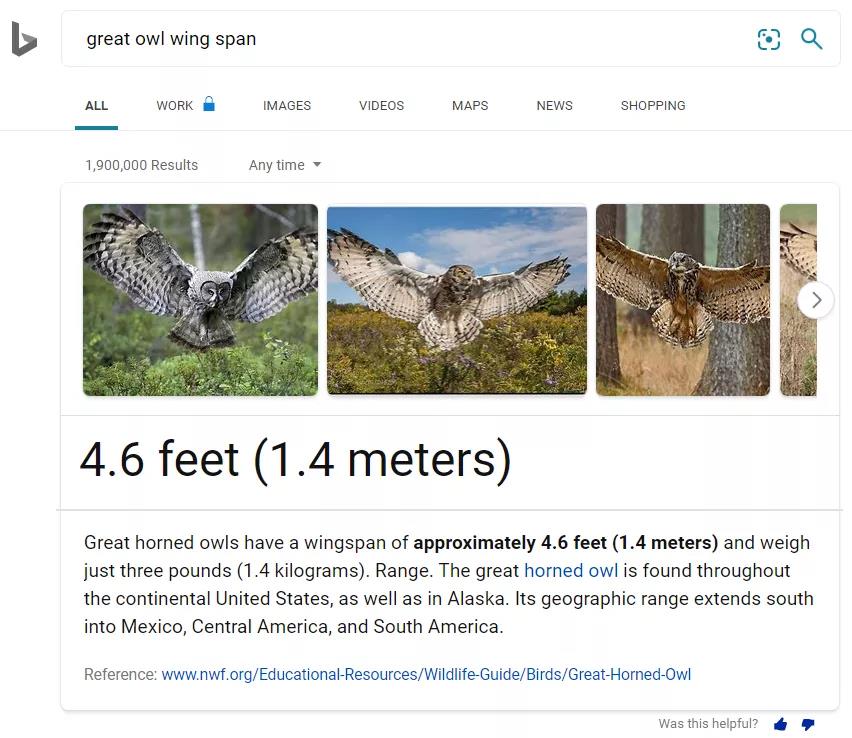

微软的搜索问答系统的研发可以追溯到 2015 年,最初主要专注在英文问答产品,为用户提供更智能的搜索体验。具体而言,希望为用户在搜索结果页的最上方提供直接、准确的答案,从而帮助用户节省信息检索的时间。该智能问答 feature 在上线后获得了用户的广泛好评,成为必应最具有影响力的智能搜索体验功能之一。

必应搜索作为全球化的信息搜索引擎,智能问答系统的全球化至关重要,如何有效且高效地实现系统中核心深度模型的跨语言扩展(language scaling)是其中最关键的问题。

具体而言,主要有以下三个挑战:

(1) 问答系统 / 模型的可维护性、快速更新。问答系统中有实现若干子任务的深度学习模型(假设为 N),如果我们为每种语言(假设共有 M 种语言)分别构建独立的问答系统,那么我们需要的模型数量就是 M*N。在实际产品中,N 一般大于 5,M 大于 100,这意味着我们需要训练至少 500+ 的深度模型,未来模型的维护和更新将成为一个很大的挑战。因此,从产品的可扩展、可维护性以及资源有效性的角度,我们希望可以构建多语言统一的问答模型(universal QnA model)。

(2) 缺少非英语训练数据,特别是低资源语言的训练数据。这是包括问答系统在内,几乎所有自然语言处理任务进行语言扩展过程中遇到的核心挑战之一。如何利用高资源语言的训练数据向低资源语言进行有效的迁移, 如何对低资源语言进行高质量的数据增强等,都是可以潜在可探索的方向。

(3) 如何实现模型线上高效的 inference。在实际产品中考虑资源利用的有效性,我们往往需要平衡模型效果与 inference 效率。如何在有限资源的情况下,通过模型压缩进行有效、高效的 inference 是模型最终可以上线的关键。对于多语言模型,如何研发更先进的压缩方法让模型同时保持在低资源和高资源语言的准确率对产品落地提出了更高的挑战。

跨语言理解技术在搜索问答系统中的应用

近年来,预训练 + 微调已经成为自然语言处理的新范式,大规模预训练模型在大量的 NLP 任务上都取得了 SOTA 的结果。预训练模型除了能够缓解跨任务中出现的低资源问题,还能够缓解跨语言中出现的低资源问题。

随着大规模多语言预训练模型的开发(比如 mBERT、Unicoder、XLM-Roberta 和图灵通用语言表示模型 InfoXLM),跨语言预训练能够利用高资源语言(比如英语)的任务相关标注数据,迁移到其他没有或者只有少量标注数据的语言,从而实现零样本或少样本的跨语言传输能力,这为我们训练多语言统一的问答模型(Universal QnA Model),解决系统 / 模型的可维护性、非英语训练数据缺乏等挑战提供了基础、有效的方法。

但是,当模型迁移到 100 种语言时,在低资源语言上的性能可能与资源丰富的语言(如英语)仍有很大差距,而全球化的产品对于各个语言、市场上线都有严格的准确度要求,这就需要进一步缩小低资源语言和高资源语言效果的差距。

为了进一步提升 Universal QnA model 在低资源语言的性能,我们开发了一系列跨语言技术,例如针对任务 / 领域的模型自适应,利用外部知识,基于用户反馈、机器翻译数据、目标语言非标注数据和生成数据的模型增强训练等。

同时,为了实现模型线上高效的 Inference,我们研发了更先进的知识蒸馏技术进行模型的压缩,如“多老师 - 学生”知识蒸馏、基于强化学习的知识蒸馏等。

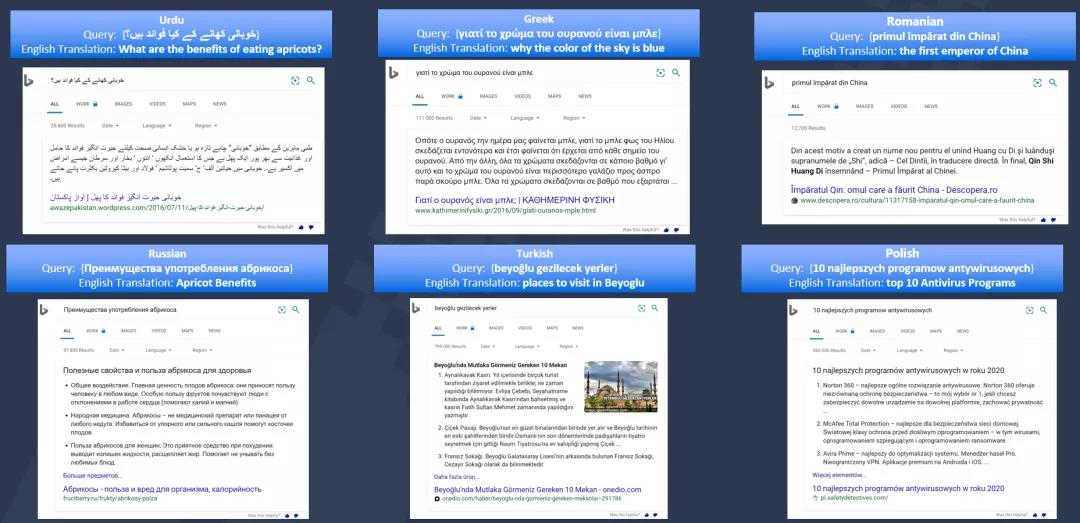

在这些 SOTA 跨语言理解技术的支持下,微软必应的问答系统成功上线到全球 100 多个语言和 200 多个区域国家。

除了搜索问答系统,团队在很多 NLP 领域的应用场景中都有丰富的跨语言扩展的实践经验,并且进行了系统的总结。感兴趣的朋友可以进一步参考团队在 KDD2021 和 WWW2021 的 Tutorial:

- WWW2021 Tutorial - Scaling out NLP Applications to 100+ Languages

- KDD2021 Tutorial - Language Scaling: Applications, Challenges and Approach

展望未来突破点

跨语言理解技术为我们的产品全球化带来前所未有的的机遇,但如何进一步提升语言扩展的效果和效率还面临着各种挑战, 同时也带来了新的探索方向:

- 利用语言学 (linguistic) 特征进一步增强大规模跨语言模型,比如语系特征,句法、语法特征等。

- 融合语言无关的特征和语言特有的特征,比如不同语种的知识信息等。

- 大规模跨语言模型的高效训练:(1)世界上有几千种语言,语言数量从 100 种扩张到几千种对于模型训练效率带来巨大的挑战 ; (2)当模型训练上千种语言的时候,如何避免灾难性遗忘 (catastrophic forgetting) 是一个具有挑战性的课题。

本文转自 公众号:AI前线 ,作者AI前线,点击阅读原文