【嘉勤点评】腾讯发明的应用于MOBA游戏的智能模型训练方案,不但能够有效的保证游戏模型的准确性、提升游戏模型的收敛速度,而且可以快速处理复杂游戏的游戏策略,并且对不同游戏环境的动作空间具有鲁棒性和泛化性。

集微网消息,近日,高通技术公司联合腾讯游戏宣布,双方正助力风靡全球的MOBA经典之作——《英雄联盟手游》在移动端还原端游的经典操作与竞技体验。

类似于英雄联盟、王者荣耀、QQ飞车这样的游戏统称为多人在线战术竞技游戏(MOBA),这种实时游戏一般都有复杂的游戏规则、多变的动态场景、行为达成不确定、信息不完全、决策时间短等特点。面对如此巨大的决策空间和决策的实时需求,如何制定、选择和执行策略是游戏智能系统面对的最主要问题。

由于在MOBA游戏中,玩家需要对抗和合作的游戏单元数量众多,丰富的游戏单元既使得游戏场景更加多元化,也增加了游戏AI策略模块的学习复杂度。因此,如何在瞬息万变的游戏对抗中确定准确的游戏策略是提升游戏AI能力的关键。

为此,腾讯在2021年2月2日申请了一项名为“游戏模型训练方法、装置、电子设备及存储介质”的发明专利(申请号:202110145344.1),申请人为腾讯科技(深圳)有限公司。

根据该专利目前公开的相关资料,让我们一起来看看这项技术方案吧。

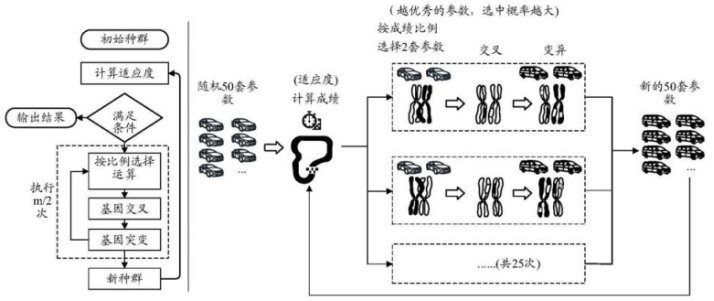

为了描述该专利中的方案与现有的传统技术之间的差别,该专利中以竞速类游戏的游戏策略产生为例,如上图,为传统技术(遗传算法)产生游戏策略的处理过程示意图。传统的方案是利用赛车运动和赛道来建立模型,通过利用经验的规则和动力学公式,将赛车控制与赛道的导航线建立联系。根据赛车的速度和朝向,以及前方赛道的宽度和曲率变化等因素,决策赛车的是否转向或者漂移。

但是,由于赛道的弯道都是形态各异的,所以赛车和赛道的建模需要足够的泛化才能适应不同的赛道,但是这一过程中,遗传算法的训练效率非常低,因为需要一代又一代的变异进化,往往需要10W次以上的迭代才能收敛得到期望结果。

同时,泛化带来了参数多而且相互耦合的缺陷,增加了训练所需要消耗的时间。此外,参数优化方案是基于已经建立好行为树的前提之下,这些行为树模型都是依据人类经验规则来建立人工调整参数很难获得符合游戏用户使用习惯的游戏模型,因此这样的方式缺乏鲁棒性和泛化能力。

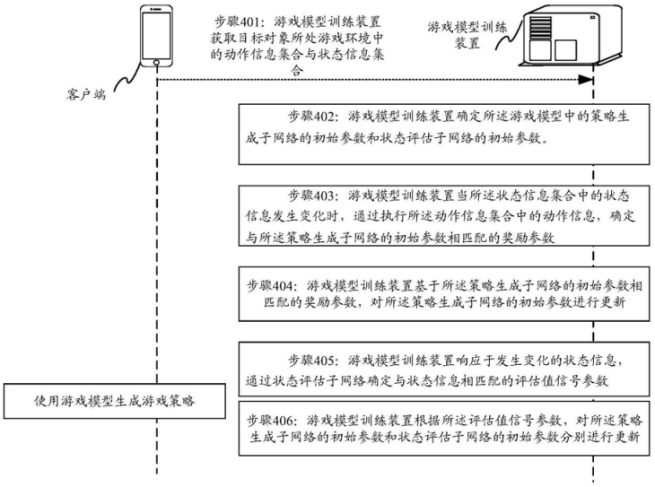

如上图,为该专利中发明的部署于服务器中的游戏模型的训练过程示意图,该方案主要基于人工智能技术,通过感知环境、获取知识等手段,使得游戏模型更加智能。

具体而言,首先,游戏模型训练装置需要获取目标对象所处游戏环境中的动作信息集合与状态信息集合,为了对这些原始数据中的噪声进行滤除,该方案还通过不同动态噪声阈值来适应不同类型的游戏的数据采集,从而更加有效筛选训练样本,使得所部署的经过训练的游戏模型所生成的游戏策略。

其次,游戏模型训练装置需要基于上述数据确定游戏模型中的策略生成子网络的初始参数和状态评估子网络的初始参数。游戏模型中的策略生成子网络用于生成AI模拟的游戏用户对游戏进程中虚拟对象的操作,并触发不同游戏策略对应的操作指令,状态评估子网络可以对执行游戏指令后虚拟对象的状态进行表示与评估,以反映游戏策略中不同游戏策略对应的操作指令对应的执行效果。

接着,当状态信息集合中的状态信息发生变化时,游戏模型训练装置会执行所动作信息集合中的动作信息,确定与策略生成子网络的初始参数相匹配的奖励参数,并对策略生成子网络的初始参数进行更新。

最后,游戏模型训练装置响应于发生变化的状态信息,通过状态评估子网络确定与状态信息相匹配的评估值信号参数,再由游戏模型训练装置根据评估值信号参数,就可以对策略生成子网络的初始参数和状态评估子网络的初始参数分别进行更新。

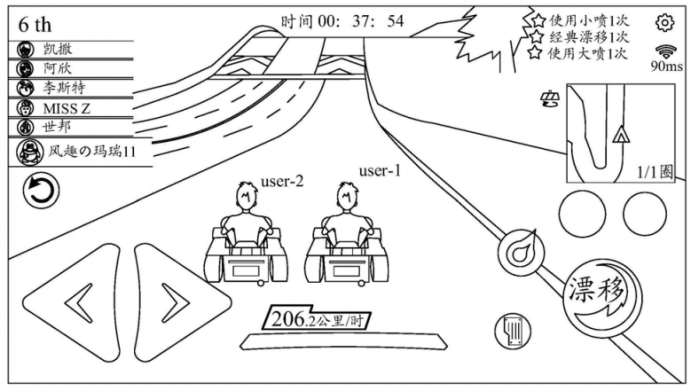

此外,在该专利中,还给出了一个以竞速游戏为示例的游戏模型构建的示意图,如上图所示,游戏服务器在检测到用户进行一局赛车游戏时,可为用户匹配一个由游戏模型所控制的虚拟对象(即陪玩AI),使得用户和陪玩AI可以同台竞技。

在上图中,“user‑1”为用户操纵的目标对象,“user‑2”为接入的由游戏模型所控制的陪玩AI,在实际游戏场景中,系统会为陪玩AI分配真实玩家的游戏ID(即游戏账号),以避免用户识别出陪玩AI,从而提升游戏用户的使用感受。

以上就是腾讯发明的应用于MOBA游戏的智能模型训练方案,该方案不但能够有效的保证游戏模型的准确性、提升游戏模型的收敛速度,而且可以快速处理复杂游戏的游戏策略,并且对不同游戏环境的动作空间具有鲁棒性和泛化性。

关于嘉勤

深圳市嘉勤知识产权代理有限公司由曾在华为等世界500强企业工作多年的知识产权专家、律师、专利代理人组成,熟悉中欧美知识产权法律理论和实务,在全球知识产权申请、布局、诉讼、许可谈判、交易、运营、标准专利协同创造、专利池建设、展会知识产权、跨境电商知识产权、知识产权海关保护等方面拥有丰富的经验。

(校对/holly)