从2020年GPT-3发布以来,国内外关于大模型的研究层出不群,各个大厂纷纷开始进行大模型的“军备竞赛”,致力于使模型更大、训练速度更快、覆盖领域更多和模型效果更好。但众所周知,大模型的研究投入是很大的,GPT-3训练一次的费用是460万美元,训练时间为355个GPU年,总成本据悉达到1200万美元,投入如此大的成本,大厂们肯定是希望能从大模型技术中获得回报的,但是,从目前大模型技术的发展来看,大模型的应用落地还面临着很多挑战。个人认为大模型在应用落地中面临的挑战可以归类为三个方面:场景、大模型调用方法和大模型迭代,下面以大规模语言模型为例逐一进行讨论。

一. 场景

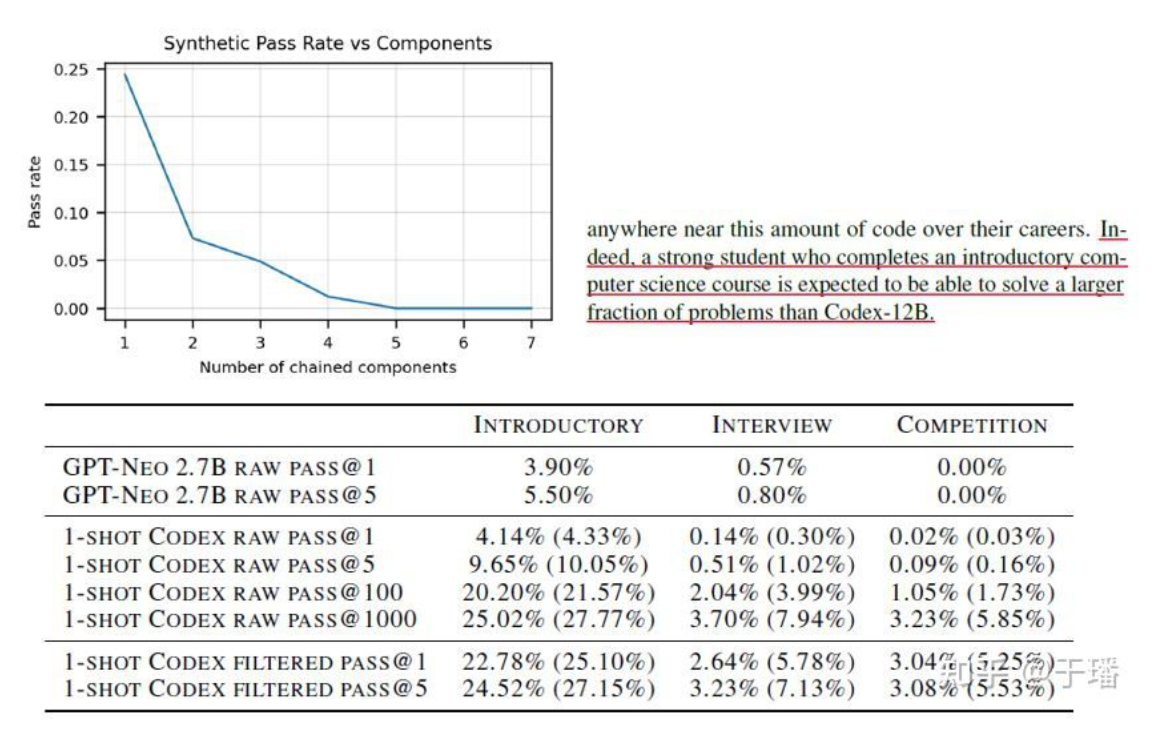

虽然大模型相比之前的模型展现出了令人惊艳的能力,但个人感觉,还没有达到“量变引起质变的程度”,大模型解决复杂问题的能力较弱或者相当不稳定,解决问题更多的是基于“记忆”而不是“思维”,这导致很难将大模型应用在容错率低的场景,即使引用了也需要人工干预,也就是说,目前的大模型很难开辟新的赛道和现金流业务。OpenAI在2021年联合github发布的Copilot,尝试在IDE领域为现有编程方式带来质变,但目前来看,还没有完全取得成功,如图1所示,Copilot解决复杂问题的能力也有限。

图1 Copilot解决复杂问题的能力有限

二.大模型调用方法

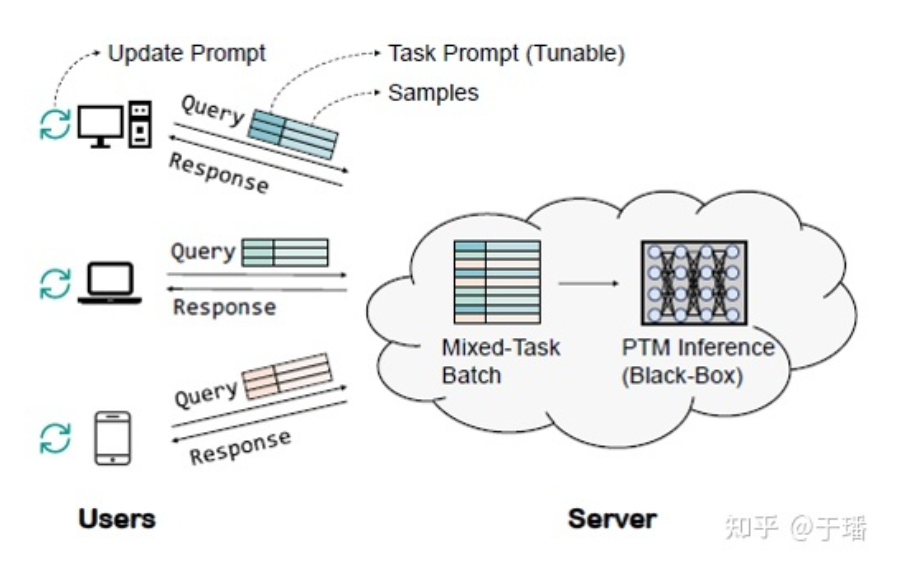

大模型由于太过庞大,导致微调成本很高,如果大模型厂商要给每个用户都提供微调服务的话,在用户数量很大的情况下,微调成本和模型维护成本会变得相当高,最理想的情况是,大模型厂商只维护一套参数,仅提供推理服务,这样,通过加速大模型推理过程,可以最大限度地降低成本。但是,如果仅提供推理服务,那就只能进行大模型的zero-shot,但目前大模型的zero-shot效果一般来说是要比小模型的微调效果差的,这就使得大模型的竞争力严重不足。关于这个问题,复旦邱锡鹏老师的团队提出了“黑箱优化”的方法,感兴趣的朋友可以了解一下。

图2 黑箱优化

三.大模型迭代

还有一个问题,就是大模型的迭代问题,如果想要解决预训练预料的时效性问题和提升大模型的能力,就要对大模型重新进行训练,如果迭代频率高的话,训练成本将变得不可接受,但迭代频率低的话,又将进一步降低大模型的竞争力,在这个问题上,课程学习/持续学习/Adapter等技术可能可以发挥一定的作用。

以上简单介绍了大模型应用中存在的一些挑战,在之后的文章中有机会的话再进一步和大家进行更深入的探讨。

原文链接:知乎

作者:于璠

推荐阅读

更多嵌入式AI技术相关内容请关注嵌入式AI专栏。