关于EBOF——SSD存储扩展机箱,我在下面几篇中曾有过一些讨论:

《NVMe-oF E-JBOF设计解析:WD RapidFlex网卡&OpenFlex Data24》

《NVMe-oF三种协议(FC、RDMA、TCP)对比:成败不只看性能》

《NVMe-oF以太网SSD:三星说第一家,东芝/Marvell两年前就有了?》

而当一位同行朋友与我展开讨论EBOF这个话题时,发现还有许多没搞清的东西。于是我又查阅了一些资料,并将收获整理在本文里分享给大家。

物以类聚:E-SSD/E-BoF

第一份资料来自SNIA SDC 2021会议上,三星分享的《Birds of Feather: E-SSD/E-BoF》(从 pdf 的水印上就可以看出来)。

图片点开后可放大,以下同

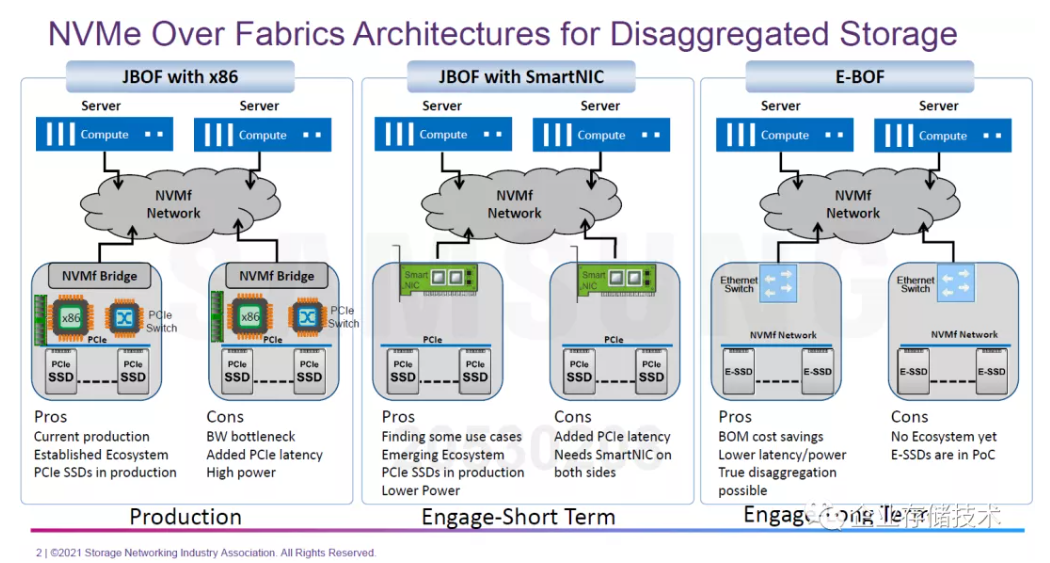

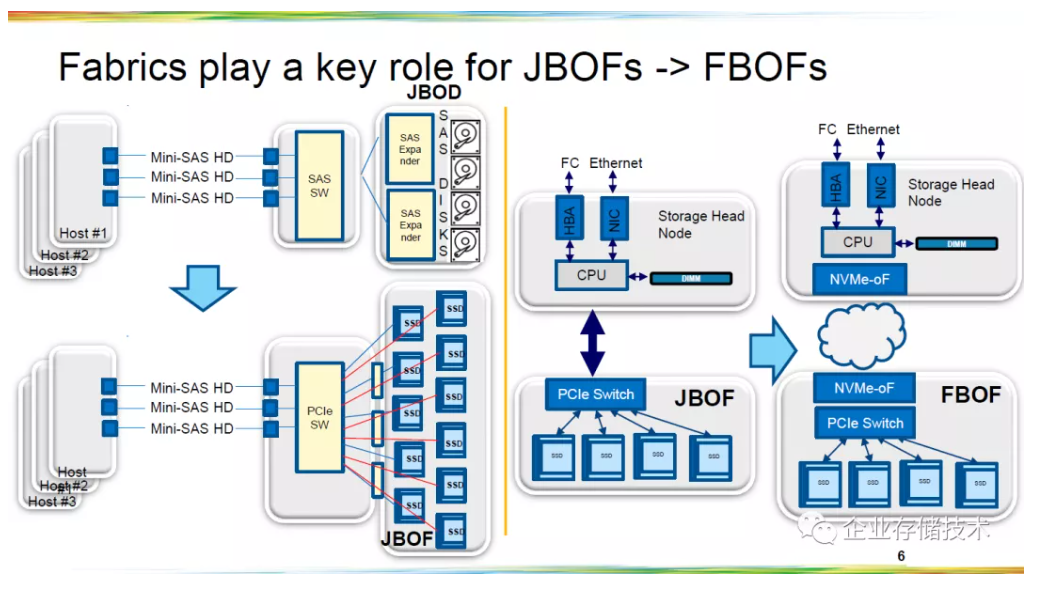

上图将NVMe-oF架构的分离式存储(扩展机箱)分为3类。左边的“JBOF with x86”,相比传统NVMe SSD存储阵列的扩展柜多出了服务器CPU模块。虽然软硬件生态都是现成的,但功耗上没有优势,带宽和延时方面也增加了瓶颈,如果在上面跑更多的存储软件功能倒是可以考虑。

中间的“JBOF with SmartNIC”分类,其实我之前写过的WD RapidFlex / OpenFlex就属于这种。严格说它可能还不算是纯EBOF,因为在智能网卡上还多跑着一层逻辑,位于NVMe-oF网络前端的计算节点并不是直接“看到”后端的SSD。如果说SmartNIC提供的带宽和网口有限,那么同时也能在上面实现更多的存储特性——稍后我会再展开聊这个方面。

右边的“E-BOF”则是架构层级上更简单的,底层的“E-SSD”无论是三星的原生提供以太网接口,还是东芝等加一块NVMe to Ethernet的转接板,每块盘都是各自通过以太网交换机,直接暴露给前端服务器。这样理论上延时和功耗都有降低,并且BOM成本上是节约的。至于普及速度我觉得要看应用需求,下文中我会给大家介绍EBOF领域的几家供应商。

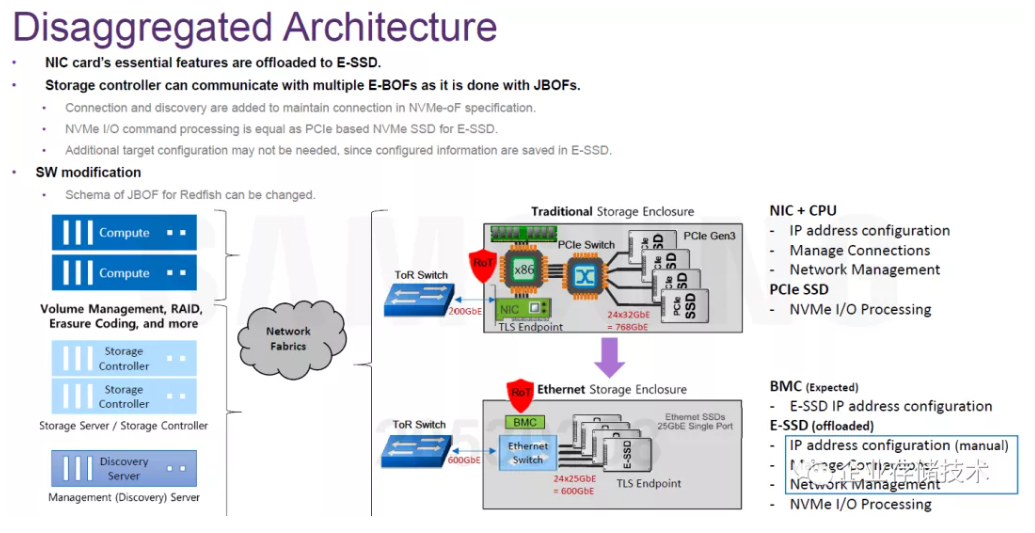

EBOF分离式架构的特点包括:

-网卡的必需功能被offload卸载到每个E-SSD上;

-存储机箱的BMC应该可以负责E-SSD的IP地址配置;

-上层存储控制功能完全放在前端服务器上实现,包括卷管理、RAID、EC纠删码等。

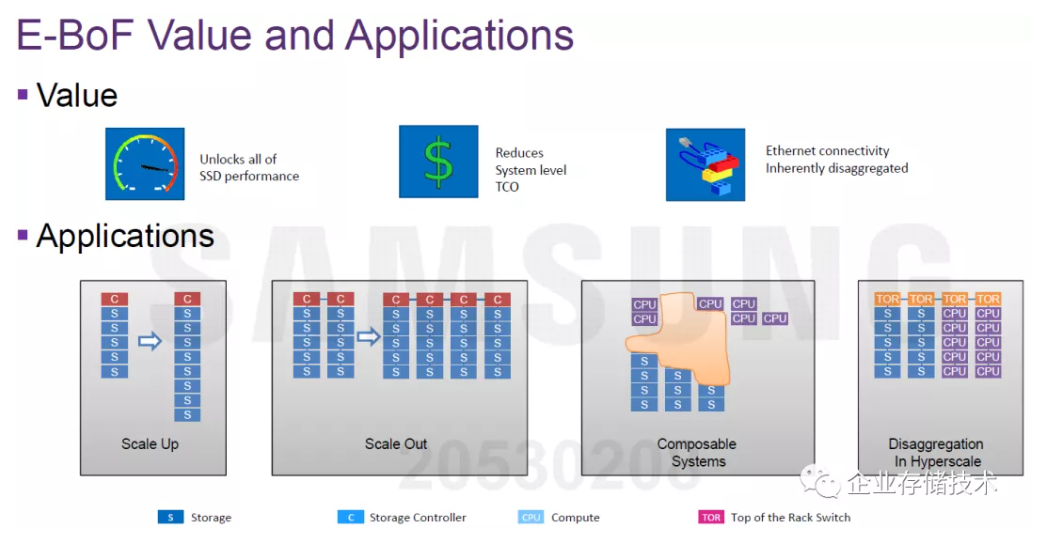

E-BoF(即EBOF)号称解锁了全部SSD性能,当前以太网SSD的双25GbE网口相对还好,不过随着将来PCIe 4.0、5.0 NVMe SSD的性能提升,E-SSD的网口不升级也会有瓶颈。

如果是用于接在存储阵列控制器后端的SSD扩展柜,据我了解Pure Storage等厂商用“EBOF”(注1)替代了JBOF,不过Pure只做了双控制器而没有Scale-Out多控。而EBOF更大的用途应该在Hyperscale,大型互联网、云服务提供商,在TOR交换机能连接到的范围内,EBOF中的SSD都可以灵活选择分配给每个服务器。

注1:在这里我可能有点概念上的混淆,因为Pure Storage的DirectFlash SHELF机箱出现较早,里面或许是用下文中将要提到的PCIe Switch + NVMe-oF网卡方案,而非严格意义上的EBOF。

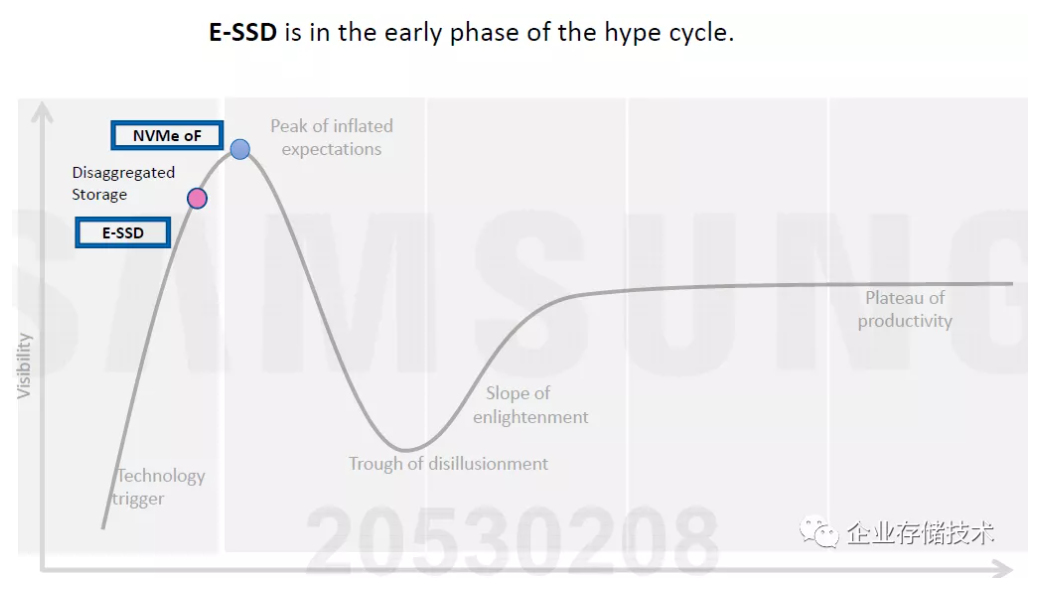

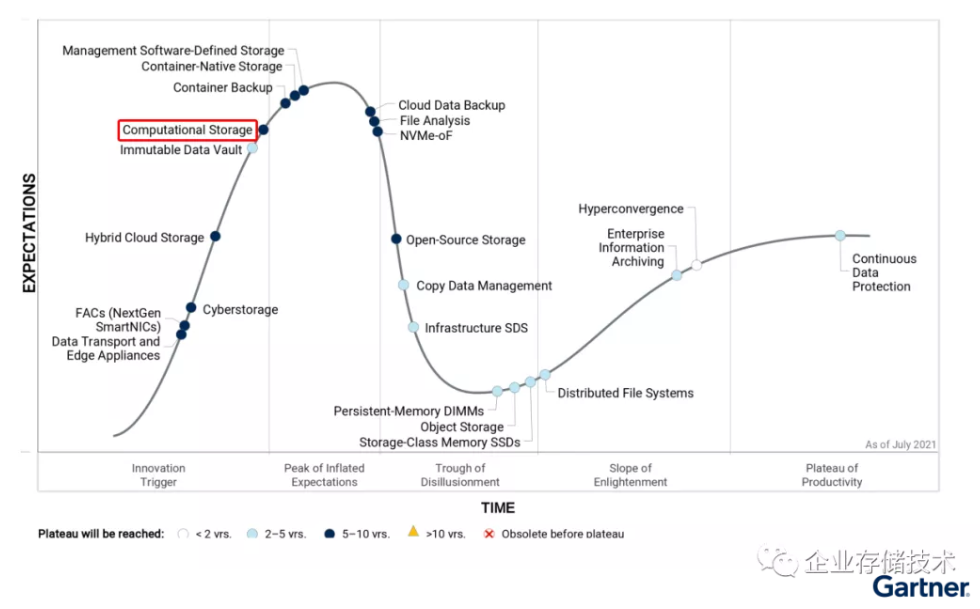

上图应该是三星模拟的一个“HypeCycle for Storage and Data Protection Technologies”曲线,为了说明E-SSD还处在比NVMe-oF更早的上升期。至于Gartner真正的《Hype Cycle for Storage and DataProtection Technologies, 2021》,我在《NVMe计算型存储:三星、WD和NGD的“SmartSSD”》一文中列出过,如下图:

以太网SSD还没有被做为一项单独的技术分类,而是应该被包含在“Computational Storage”里面,而NVMe-oF已经过了第一轮创新的顶峰。

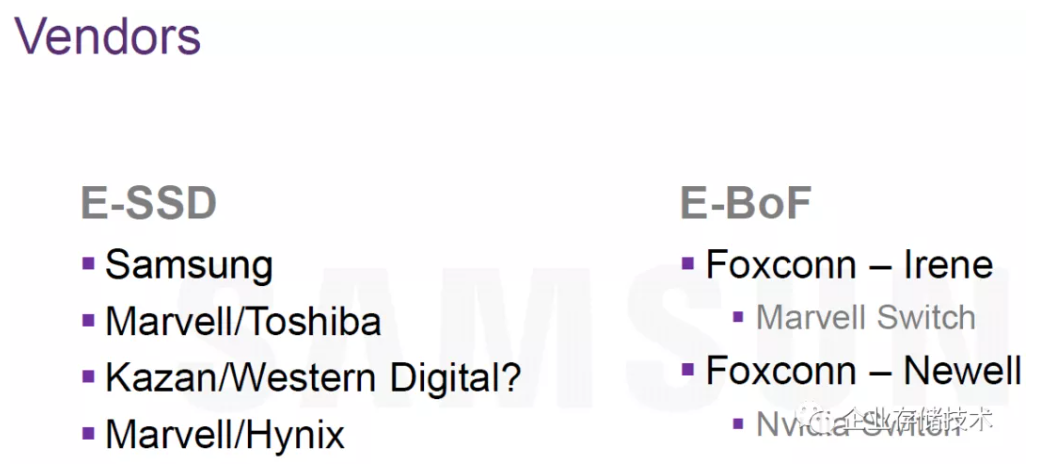

三星这份资料的最后介绍了该领域的玩家。E-SSD方面,Marvell应该是在同时与东芝和Hynix(并购了Intel SSD)合作,Micron不知为何在这里没提?另外,以前我也提到过WD收购Kazan之后的发展不太确定。

至于E-BoF,ODM大厂Foxcoon提供了Irene和Newell两种方案,分别内置Marvell和NVIDIA(Mellanox)的以太网交换机。这一块还漏掉了谁?

EBOF ODM供应商:Foxconn-Ingrasys和Accton

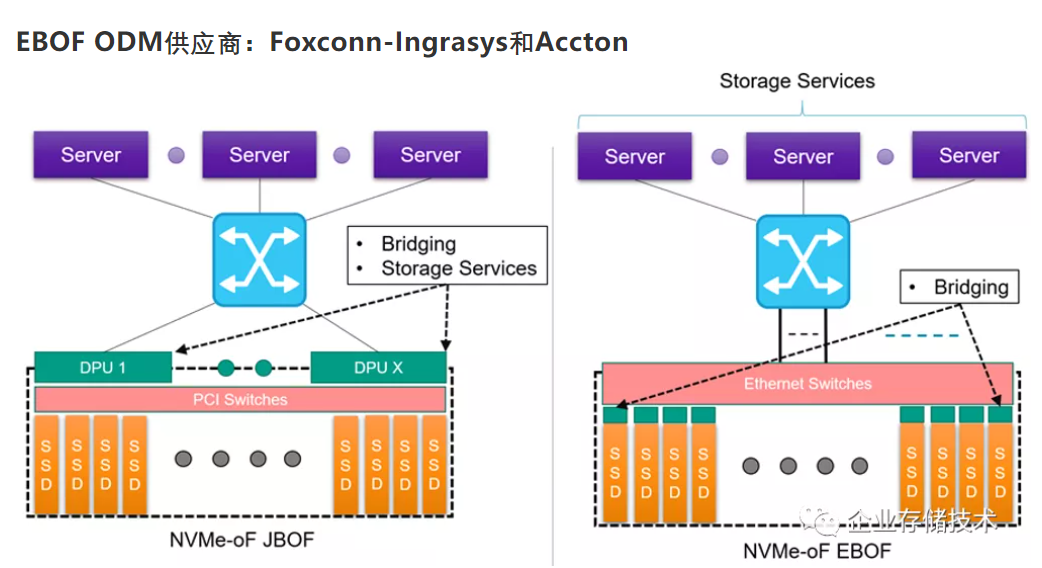

上面的资料来自Micron网站,在左边的NVMe-oF JBOF中,SmartNIC被写成了今天更时髦的词语“DPU”;而右边的EBOF里面,Bridging表示美光采用的也是NVMe SSD转接以太网方案。

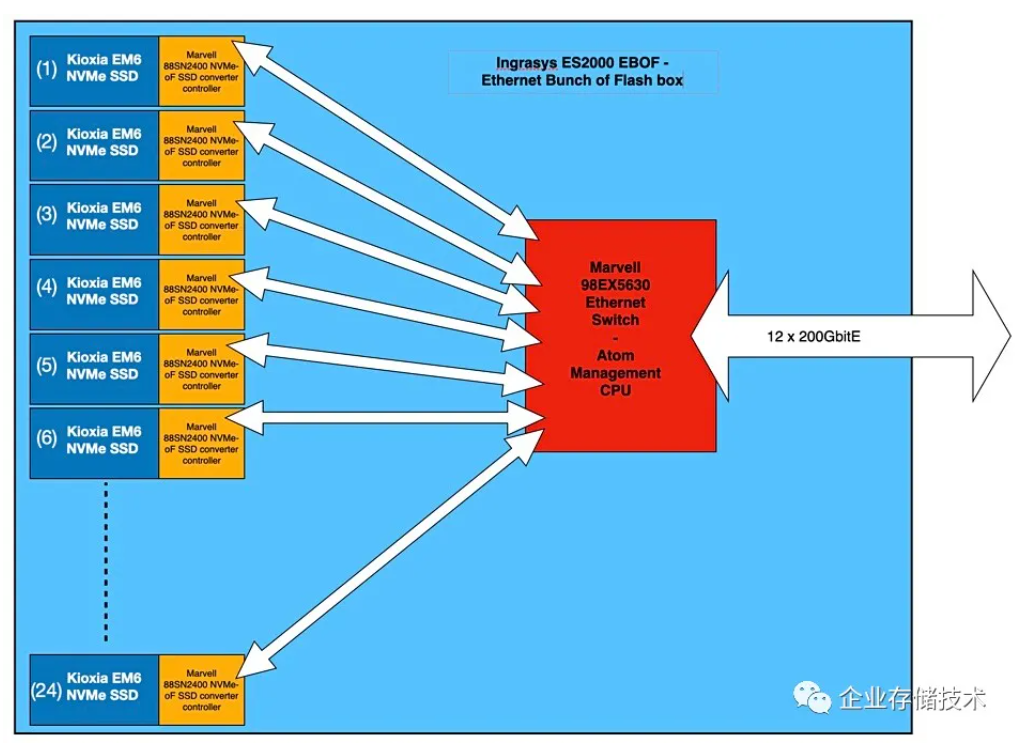

ES2000就是Foxconn-Ingrasys的EBOF型号,印象中blocksandfiles网站的知名作者Chris Mellor还为它画了下面这张结构图:

在东芝的EM6以太网SSD上,应该是集成了Marvell 88SN2400/88SN3400 NVMe-oF SSD转接控制器。ES2000 EBOF机箱里面除了Marvell 98EX5630以太网交换机之外,还有Atom CPU用于管理。

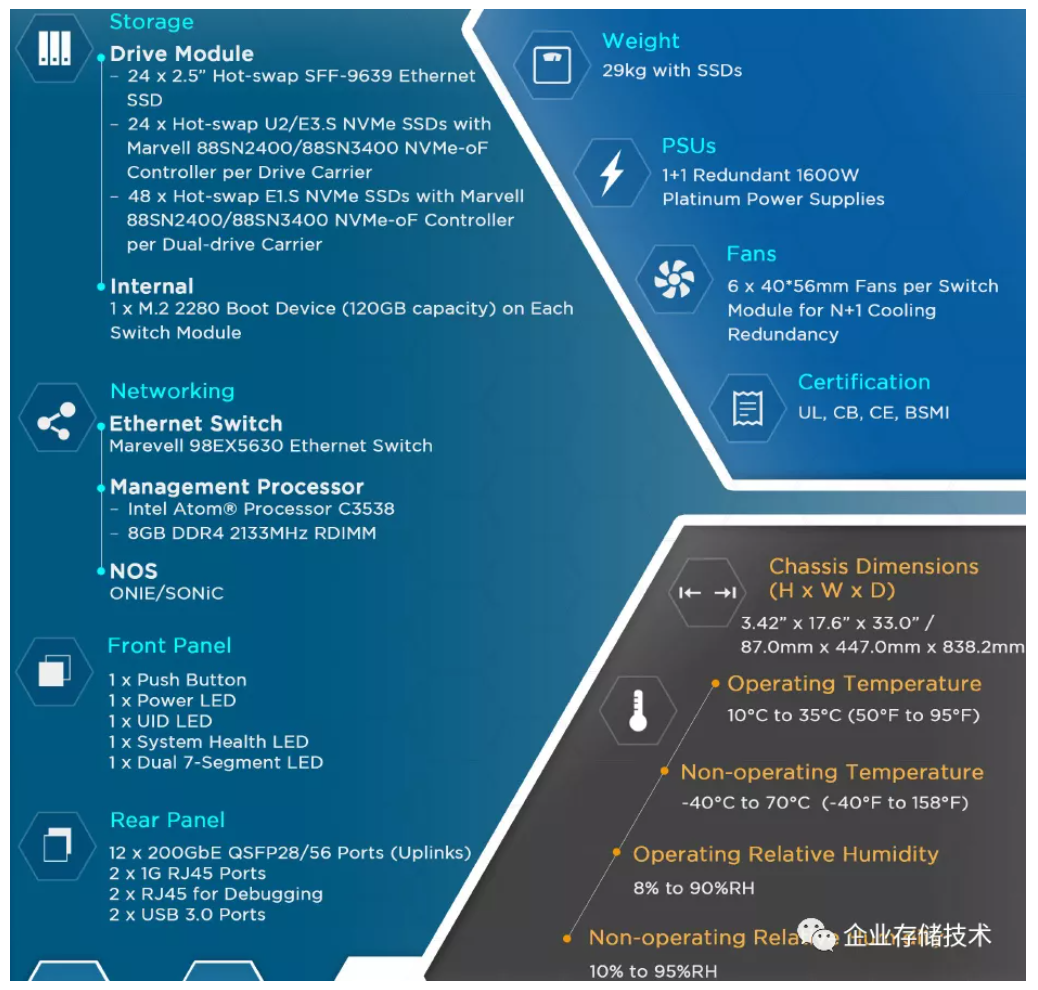

看看ES2000这款2U EBOF的规格表:

-方案1:支持24个2.5英寸热插拔SFF-9639以太网SSD;

-方案2:24个热插拔U.2/E3.S NVMe SSD,经过Drive Carrier上的Marvell芯片转接;

-方案3:48个热插拔E1.S NVMe SSD,同样经过双盘Carrier上Marvell芯片转接;

上行以太网主机接口是12个200GbE,像电源和风扇等规格我就不在这里赘述了。

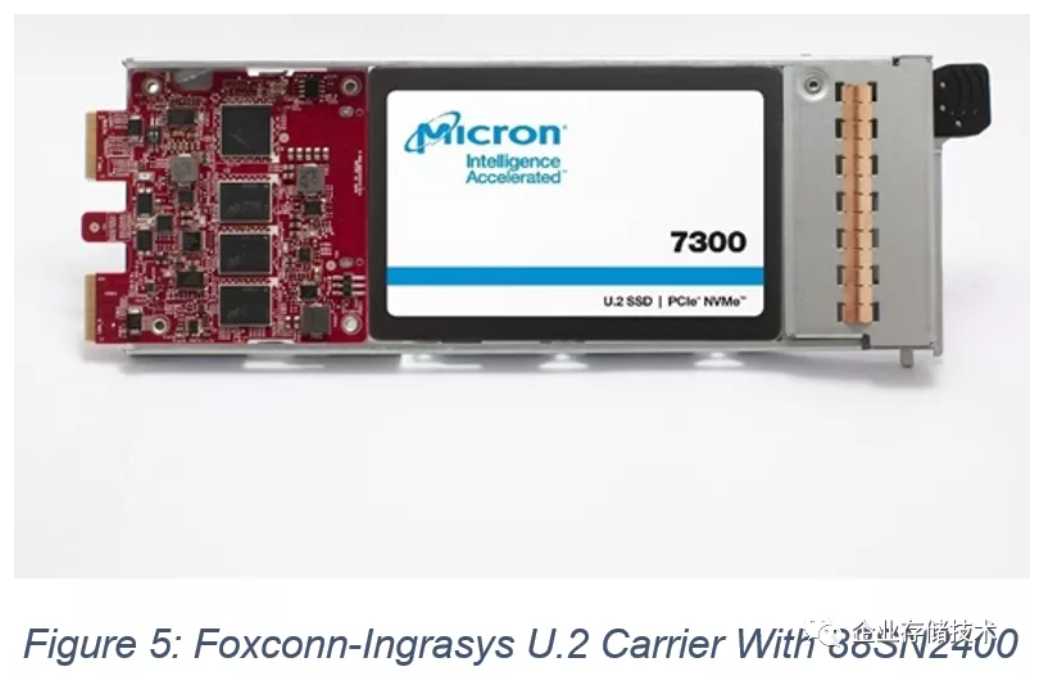

上图是Micron给出的,Foxconn-Ingrasys EBOF中的U.2转接Carrier + 7300 SSD的照片。

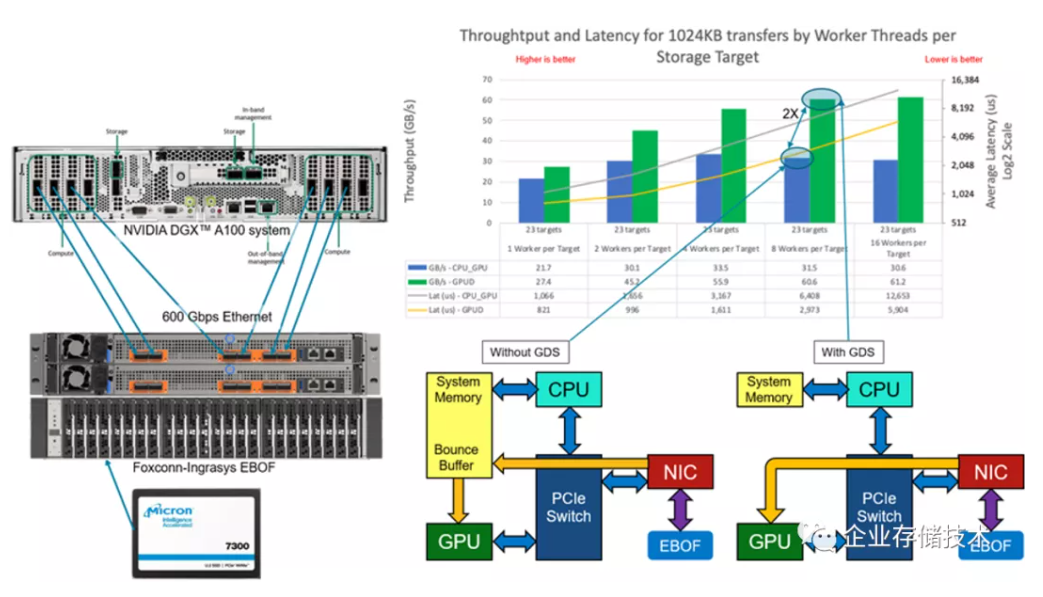

这里还可以看到ES2000 EBOF的背面——它也可以连接NVIDIA DGX A100 GPU系统,使用GPU Direct Storage访问之后,SSD块存储的访问性能有明显提高。

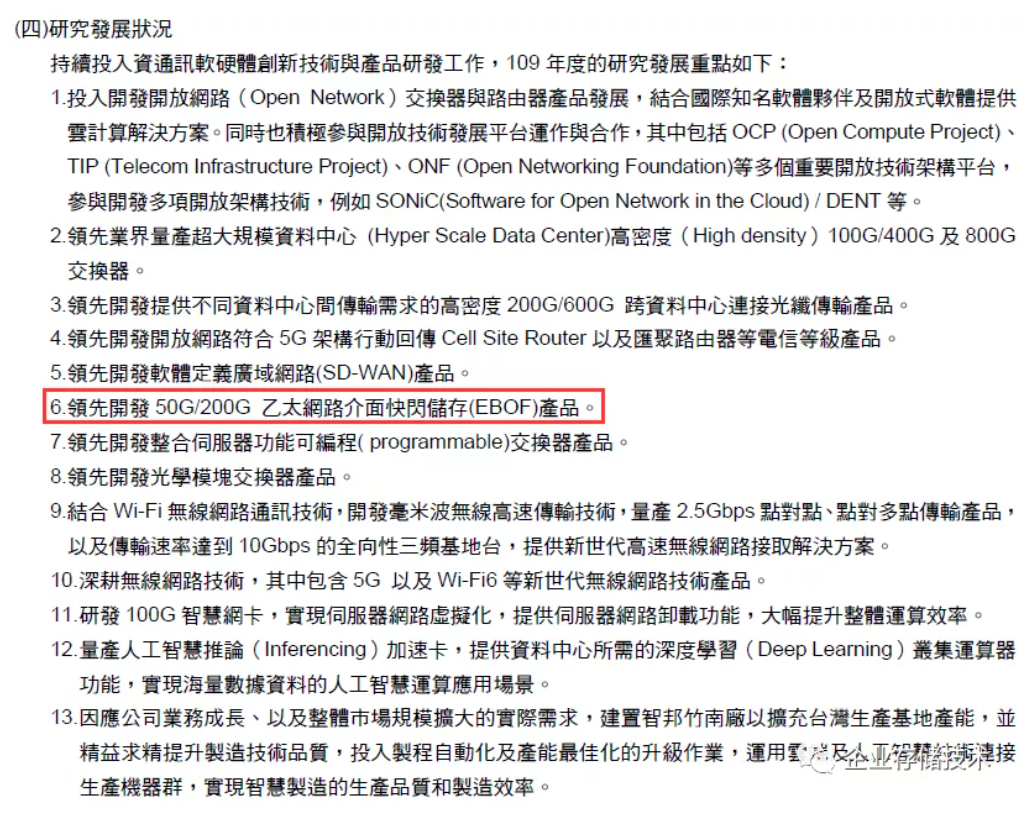

另一家EBOF ODM提供商Accton(智邦科技),除了在90年代用过他们的10/100Mb网卡之外,我对这家公司关注不多。

上图截自网上搜到的,智邦科技股份有限公司2020年财报,仅供参考。我觉得今天EBOF应该也能量产了吧?

FBOF前景:存储阵列之路能否走通?

前面把EBOF聊的差不多了,我们再来看看FBOF。

在nvmexpress.org标准组织的资料《NVMe-oF™ JBOFs 》中,将带有PCIe Switch和NVMe-oF网卡的“JBOFwith SmartNIC”称为FBOF(Fabrics attached just a Bunch ofFlash)。

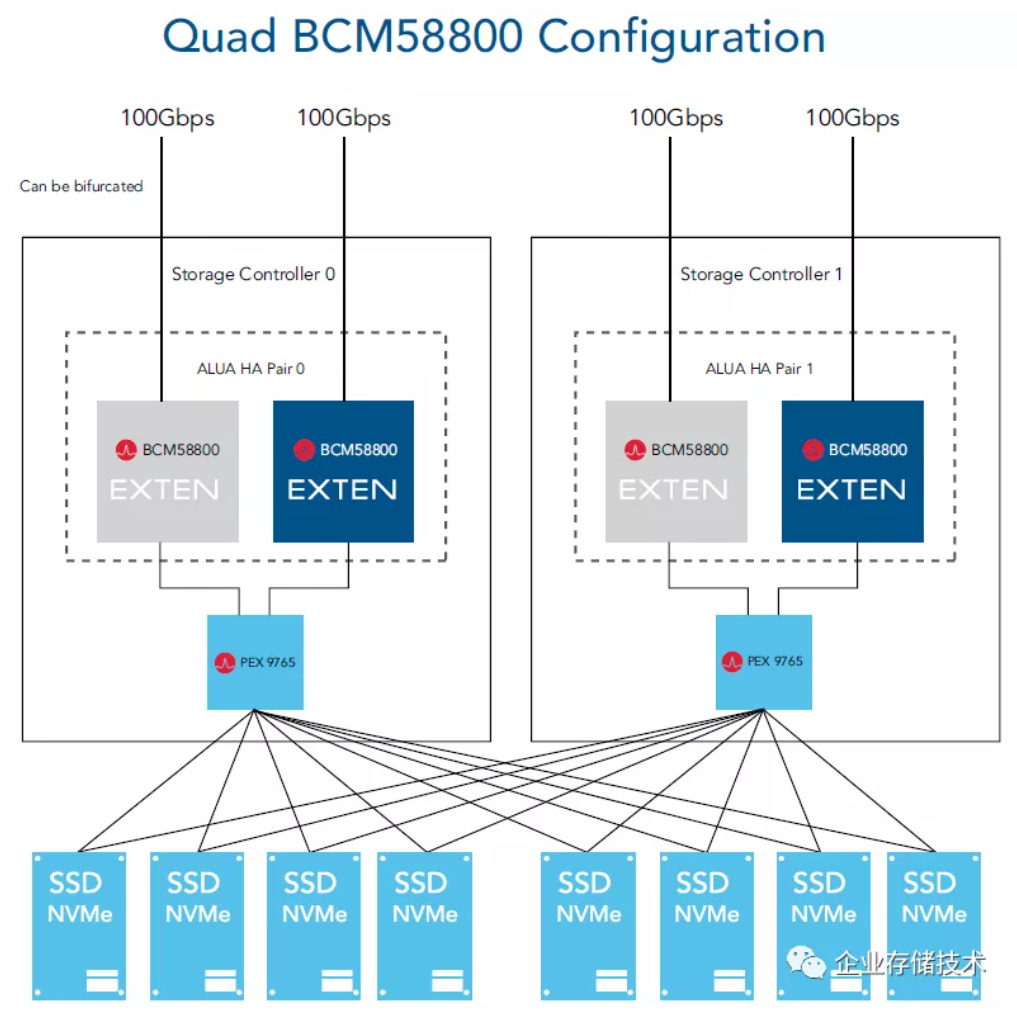

无论概念叫做FBOF还是F-JBOF,我觉得该类产品都不算太标准化的硬件。下面的结构图,来自我从Broadcom网站上找到的一份资料《AIC FBOF with EXTEN HyperDynamic Software Platform》。

我知道台湾AIC是做硬件盒子的,这款FBOF被称为2U 24-bay NVMe全闪存阵列,每个控制器里都有1颗PEX 9765 PCIe Switch芯片为,以及2颗BCM58800——就是早期出现的100GbE SmartNIC,Broadcom Stingray PS1100R板卡的主控芯片。

这里画的双控制器,从NVMe SSD一直到前端网口的链路都是冗余的,每个控制器内的2个BCM58800还组成了ALUAHA对。EXTEN 的HyperDynamic存储软件,在Braodcom SmartNIC上实现了NVMe-oF target、高级管理、分配和RAID保护(0-6),并兼容标准MPIO和Linux initiator驱动。

Broadcom Stingray板卡的图片我在以前的文章中出示过,上面带有双通道72bit ECC内存,这对RAID5/6比较重要。但AIC J2024-04 FBOF的2个控制器之间应该没有缓存镜像保护。

需要指出,我看到的AIC/EXTEN资料都是2019年的,相关FBOF产品的发展状况不太确定。接着再提下另一家我认为相对成功的。

Kalray也是做FBOF的——同样宣称为全闪存阵列。他们自己做了一块应该是自主ASIC的Smart Storage Adapter网卡。相比之下,WD/Kazan的FBOF在网卡上的功能简单了一些,只能做NVMe-oF而没有RAID等。这是否与他们被后来的(无网卡)EBOF淹没有关?

还有一家,推动NVMe over TCP的Lightbits也算活的还不错吧。Lightbits一开始是用FPGA卡搞了个FBOF阵列,听说有些企业存储系统厂商与他们合作,用硬件加速NVMe/TCP来降低延时。

尾声:EBOD与NVMe HDD硬盘

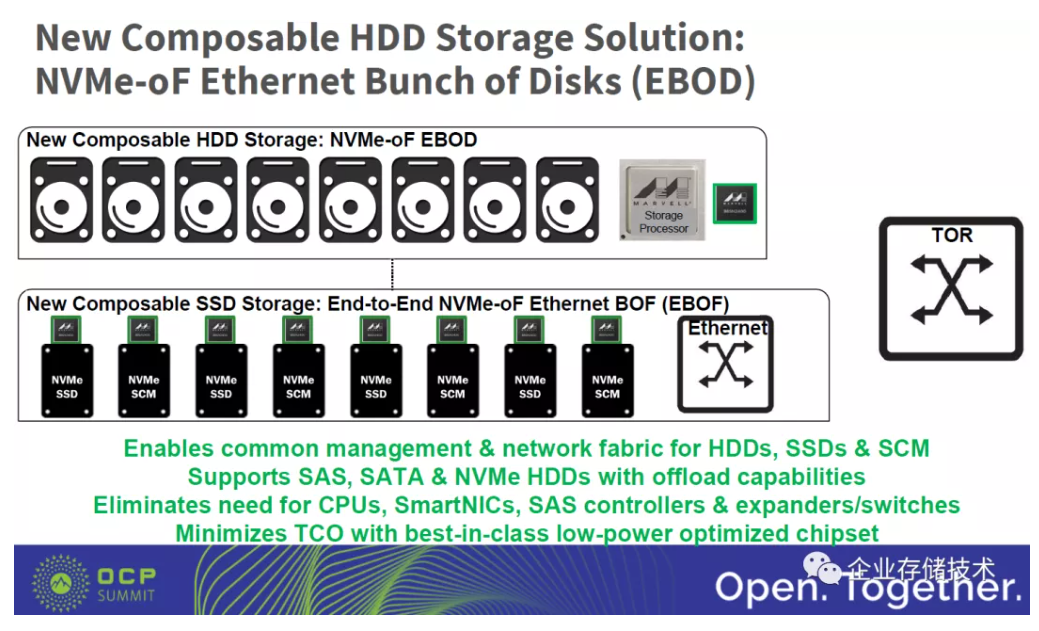

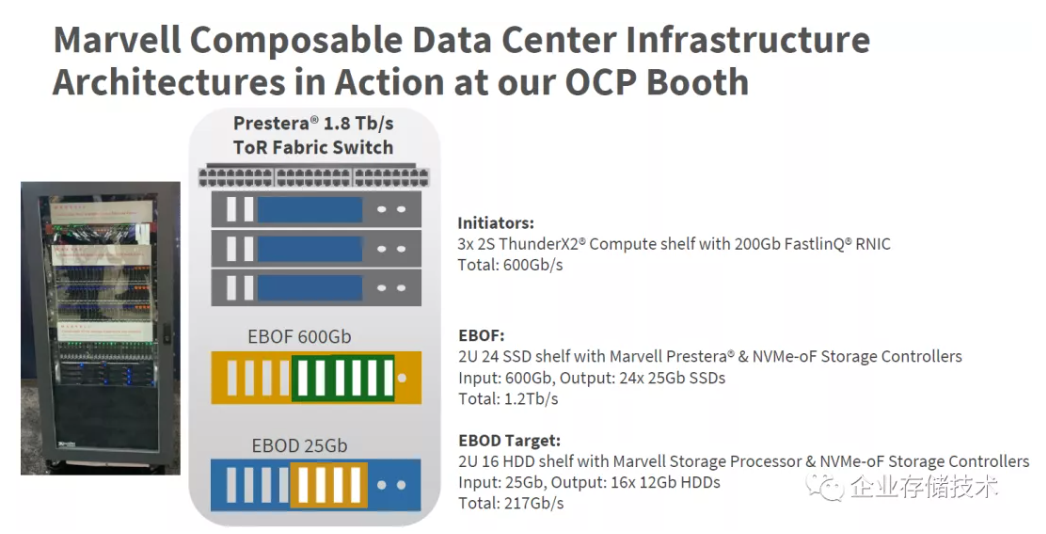

这份资料也是2019年的,来自Marvell在OCP大会上的演讲。

当年提出的NVMe-oF EBOD概念,相当于把JBOD的SAS上行换成了以太网。但毕竟机械硬盘没有SSD那样的PCIe/NVMe接口,所以中间要再加一颗Marvell的存储处理器(就像RAID卡/HBA用的磁盘控制器芯片)。

如上图,在这个EBOD 25Gb中用的是12Gb HDD,也就是SAS硬盘。如今该产品概念应该没有消失,而是因为下面这种产品技术的出现而进化了:

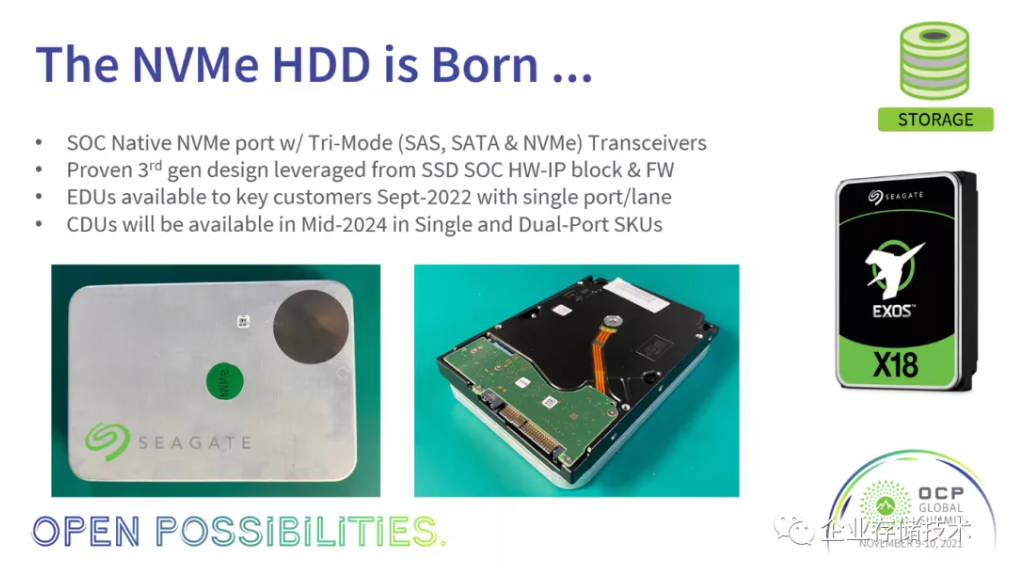

在2021年的OCP会议上,希捷提出要做原生NVMe接口HDD——确切地说是SAS/SATA/NVMe Tri-Mode三模SoC。

上图是NVMe HDD的POC JBOD,没有叫EBOD是因为它的IOM只是做了PCIe Switch转接而并未加以太网接口。那么,如果将来Marvell及其合作伙伴想继续搞EBOD,可以把那颗Storage Processor省掉了(顺便还可以消除一个单点故障,如果需要的话),只用88SN2400/88SN3400就好。

至于NVMe HDD和EBOD的前景,我不想在这里评价。只希望不要比SAS/SATA JBOD贵太多…

参考资料

链接:https://pan.baidu.com/s/1uMmsNKdYb1MgZJnSrUzGGw?pwd=8wid

提取码:8wid

作者:唐僧 huangliang

原文:企业存储技术

推荐阅读

欢迎关注企业存储技术极术专栏