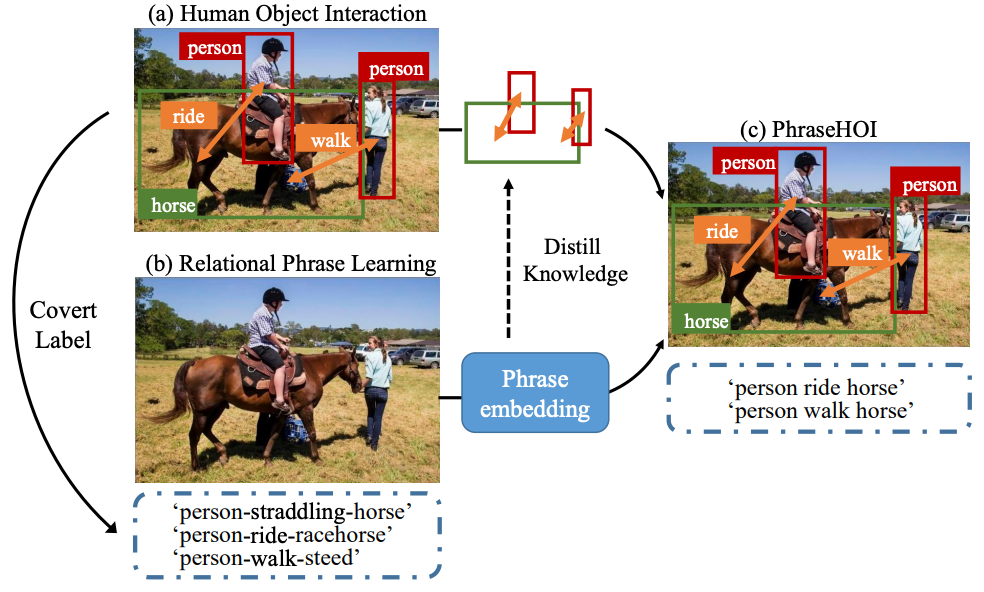

Figure 1 (a) HOI (b) Relational Phrase Learning (c) PhraseHOI

人-物交互关系检测(human-object interaction detection, HOI detection)是以人为中心的高维场景感知任务,该任务旨在定位图像中产生特定动作行为的人,以及与其产生交互关系的物体,如 Figure1(a)所示,HOI 任务即检测出图像中存在交互行为的 person,horse 以及交互行为 ride、walk,以组成对应的交互行为三元组<person ride horse>,<person walk horse>。

传统目标检测任务缺乏对场景的理解,通常会检测出图像中存在的所有目标。相比传统目标检测任务,HOI 任务提供了更为细粒度的感知,对以人为中心的高维场景感知任务十分重要。

然而,由于现实生活中人与物体存在丰富的交互关系,很难获取大量的标注数据,且标注成本高,导致现有数据集有效标注量少,影响交互关系建模性能。如何优美地引入多模态数据来提升交互关系检测的性能,成为目前研究的热点。

关系短语学习任务

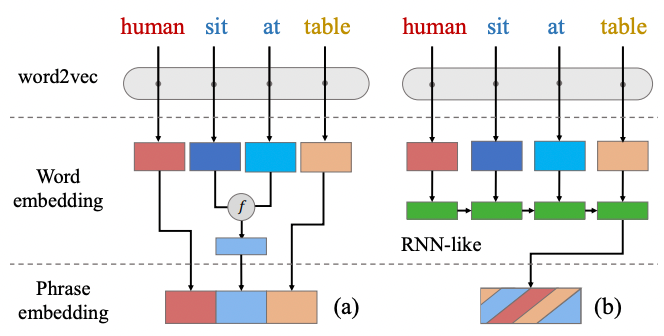

正是基于这样的研究背景,我们首先提出了一种新颖的关系短语学习任务,该任务衍生自 HOI 任务,如 Figure1(b) 所示。该任务输入一张图像,输出用于描述图像中人和物体间交互关系的短语。我们将这些短语称为“关系短语”,他们的真值通过原始的 HOI 标注自动转换而成,如 Figure2 所示。HOI 三元组标签(human, sit_at, table)可转换为'human sit_at table'短语。

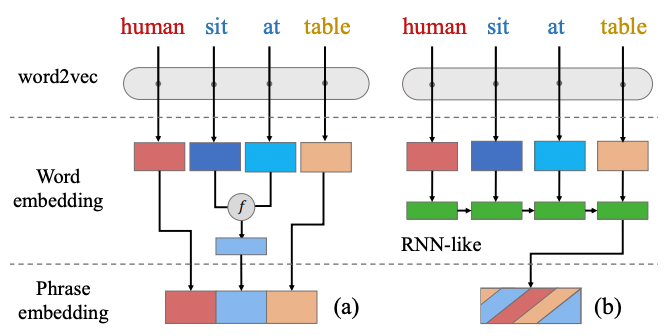

其中,每一个单词会被送入语言模型(如 word2vec[1])获得词向量。三个单词的词向量通过策略组合成短语向量,作为关系短语学习任务的学习目标。

推理时,以查表的形式,在预设的词组表中,获取预测短语的类别概率。实验证明,相比使用循环神经网络融合词向量,简单的向量拼接更有利于提高短语分支性能。

Figure 2 Illustration of two methods for phrase embedding generation.

(a) the concatenated method. (b) the language model encoded method.

标签创作模块

由于交互关系-物体对存在大量枚举空间,人-物体交互关系对的样本分布并不平衡,存在严重的长尾分布问题。为了更好识别稀有类,我们发现人类倾向于从相关或相似的已知实例中重构稀有目标与关系。

以稀有类“人-骑-长颈鹿”为例,人类具备对非稀有类“人-骑-马”和“人-看-长颈鹿”短语的先验知识,可以快速识别出“人-骑-长颈鹿”短语,并深刻记忆。受此启发,我们为每一个单词构建了语义邻居集合,并提出一个新颖的标签创作方法,以扩充标签空间。

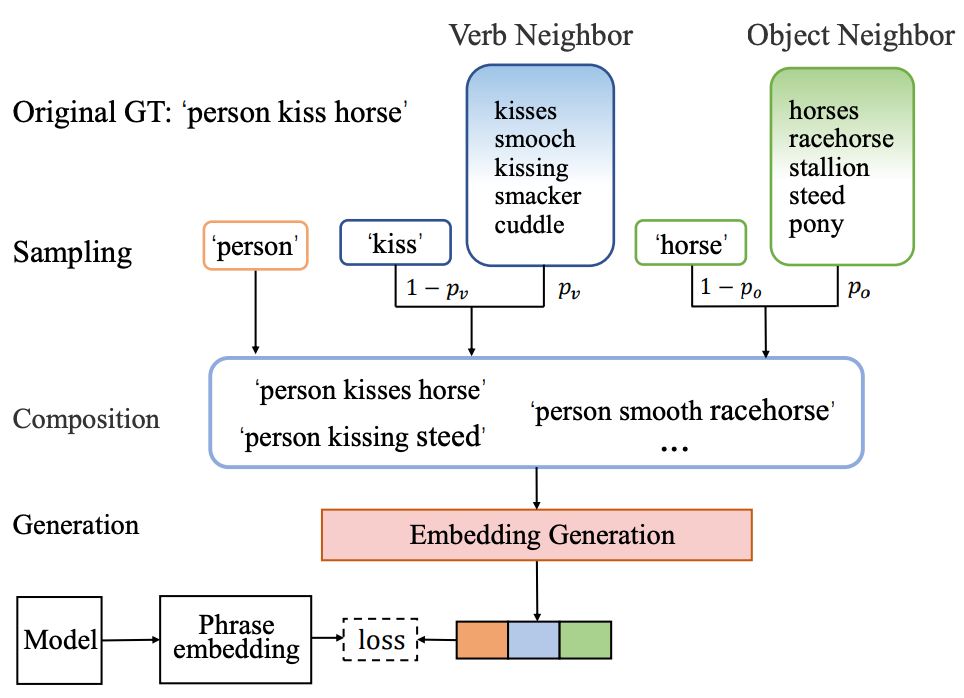

Figure 3: Illustration of the label composition method.

通过在语义邻居中概率抽样,来替换给定关系短语中的“交互关系”和“物体”单词,以构造新的标签样本,扩充标签空间,缓解因标注数据稀缺和长尾分布对性能的损失。相比于在特征空间上做特征增强,我们在标签空间做标签增强,作为一种元框架,可灵活适应于两阶段,一阶段和端到端算法框架。

以 HICO-DET 为例,对于每一个“关系”单词,我们在语言空间中寻找满足相似度阈值的 top K 个近邻组合成语义邻居集合。如 Figure3 所示,以给定查询单词‘kiss’为例,当阈值设置为 0.7 时,可获得集合为{('kisses', 0.81), ('smooch', 0.76), ('kissing', 0.71)},括号内浮点数为括号内单词与查询单词的相似度。对“物体”单词同理。

训练中,给定一个真值,例如'human kiss horse', 对于“关系”单词'kiss',我们以概率 pv 在{'kisses', 'smooch', 'kissing'}采样,概率 1-pv 不做增强,对“物体”单词同理。通过增强,原始的‘human kiss horse’被扩充成 20 个不同的样本。同时,单词通过语义近邻进行替换,只有最相似的单词会被纳入替换范围,合理提升标签空间的丰富度。

算法框架

人-物交互关系检测任务和关系短语学习任务均建模了人和物体间的交互关系,前者基于视觉模态,后者基于语言模态。我们认为这两种任务在知识空间中存在共享空间,可以联合优化使得知识从关系短语学习任务转移至人-物交互关系检测任务。由于关系短语学习任务通过大型语料库训练获得,丰富的语义知识可通过知识蒸馏有效提升 HOI 检测任务性能。

综上,我们提出了一个多任务学习框架 phraseHOI,联合优化 HOI 任务和关系短语学习任务,并显著提升 HOI 任务性能。网络框架包含一个 transformer backbone 和两个并行分支,如下图所示。训练时,原始的 HOI 三元组先转换成关系短语,接着送入标签创作模块,生成新的标签样本,最后通过语言模型(word2vec[1])生成短语向量,该短语向量作为当前输入的真值,来监督短语分支学习。HOI 分支使用了五元组损失,分别监督人-物体对的类别,位置,以及交互关系类别。

推理时,HOI 分支可直接预测人-物体交互三元组,短语分支也可预测短语向量,再通过查表获得短语类别。

Figure 4: Overall architecture

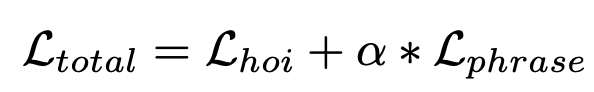

在 HOI transformer[2] 的基础上,我们设计了短语损失,联合优化算法框架。

前者为 HOI loss 作用于 HOI 分支,包含人-物体对的包围框回归损失于分类损失,交互关系分类损失。后者为 Phrase loss 作用于短语分支,由蒸馏损失和三元组损失组成。

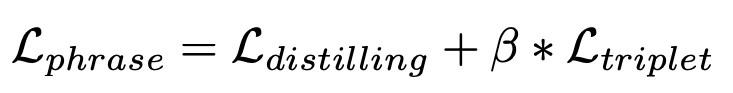

关系短语学习的过程是知识蒸馏的过程,我们提出蒸馏损失和三元组损失联合构成关系短语学习的损失函数。其中,蒸馏损失负责拉近短语分支预测的样本分布与真值之间的距离,即拉近类内距离,三元组损失在局部区域进行细微的调整,负责推远类间距离。

针对同一张输入图像,短语和 RGB 图像可看作'paired inputs',短语输入预训练的 word2vec 模型(教师模型),RGB 图像输入 PhraseHOI (学生模型),短语标签的词向量可以看做来自语言模态的 mid-level representations,监督短语分支学习。知识从通过大型语料库训练的语言模型蒸馏至 PhraseHOI 网络,提升 HOI 检测性能。

数据集

V-COCO 与 HICO-DET 数据集为人-物交互关系检测任务常见数据集。

V-COCO 数据集于 2015 年提出,作为 MS-COCO 的子集,包含 5400 张训练集,4946 张测试集。V-COCO 一共标注了 80 种物体类型,与 COCO 一致,标注了 29 种关系类型,其中包含 4 种无交互对象的动作类型。

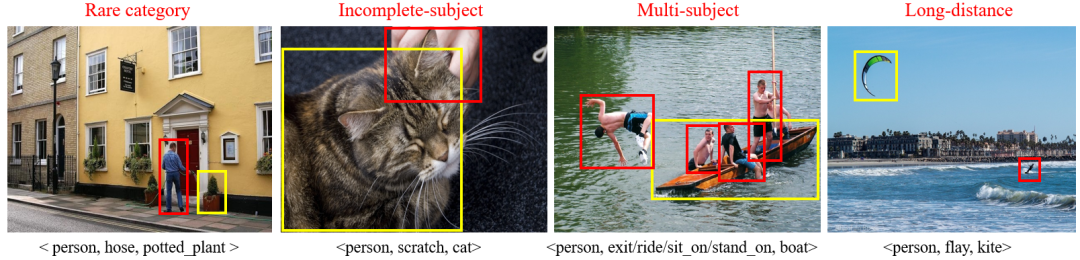

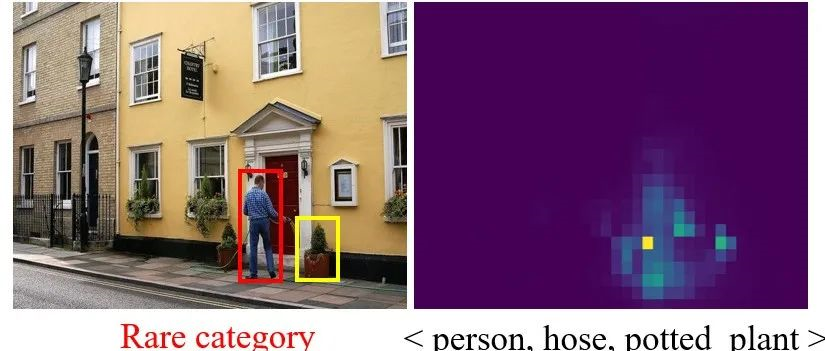

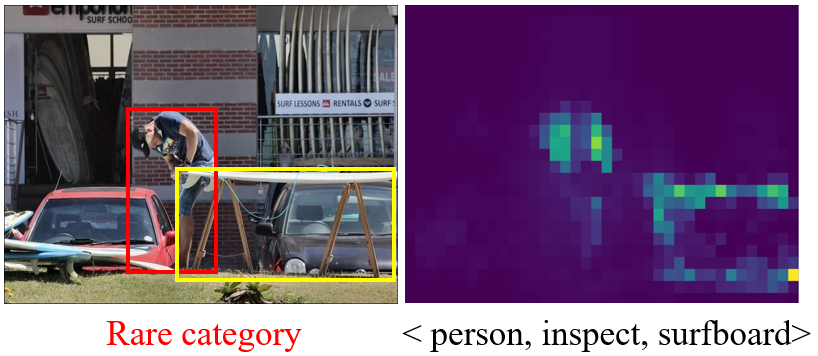

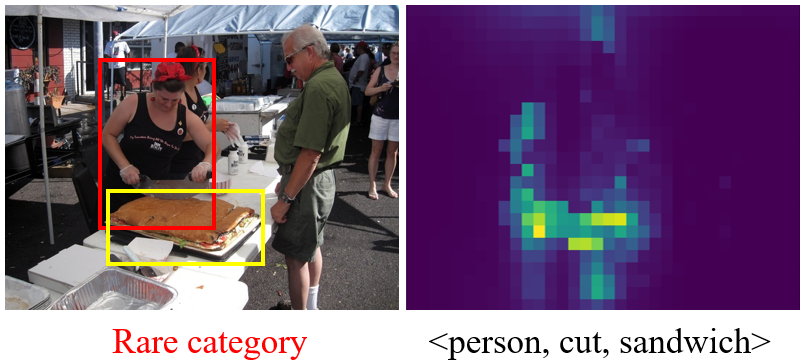

HICO-DET 数据集于 2018 年提出,包含训练集图像 38118 张,测试集图像 9658 张,部分样例如下图所示。HICO-DET 一共标注了 117 类动作,80 种物体类型,其中物体类型与 COCO 一致。117 类动作与 80 种物体构造了 600 种不同的人-物交互关系类型。根据在数据集中出现的频率,HICO-DET 将 600 类交互关系分类常见类 (Non-Rare)462 类和稀有类 (Rare)138 类。由于 HICO-DET 数据集存在明显的长尾分布,如何在稀有类别上取得更好的性能也成为了人-物交互检测领域的研究热点。

实验

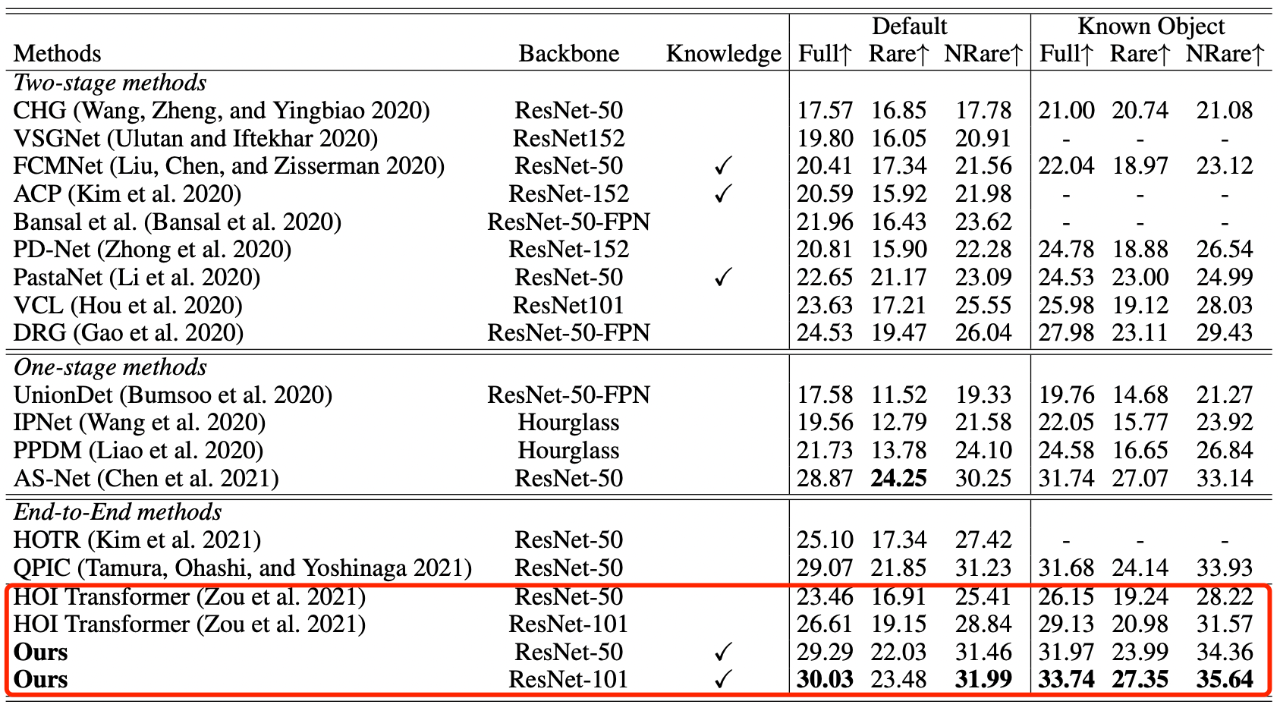

实验以 HOI transformer[2] 作为 baseline,实验表明,我们的方案对比基线网络获得了显著提升,相比近年来的算法取得了更优性能。

Tab. 1 Experiment on Hico-Det

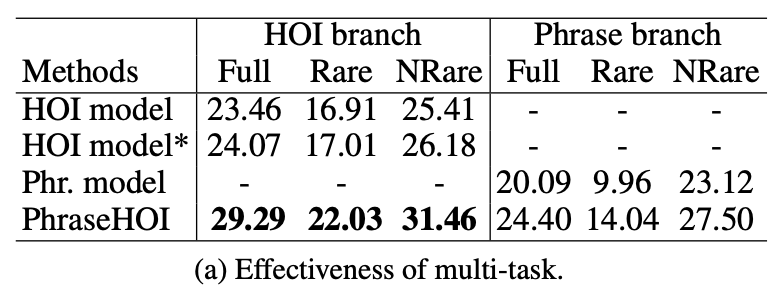

多任务学习有效性:

我们分别在三种模型上做了消融实验,如下表所示,HOI model 为我们复现的 HOI transformer 网络,Phr. model 为仅训练关系分支获得三元组类别,PhraseHOI 为 HOI branch和 Phrase branch 联合训练。

- Phr. model 在 full 指标上达到了 20.09%,超过了 tab. 1 中部分网络,证明了短语学习任务有能力建模交互关系。

- PhraseHOI 的 HOI branch 得到了 5.22% 的增益,证明了联合优化可以帮助语义知识从关系短语学习任务转移至 HOI 任务,大幅提升 HOI 模型性能。

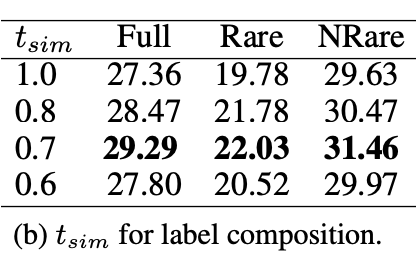

标签创作模块有效性:

我们对标签创作模块中的相似度阈值做了消融实验,如下表, 表示邻居集合只包含单词自身。由下表可看出,当相似度阈值由 1.0 降低至 0.7 时,逐渐扩充了邻居集合(标签空间),网络性能逐步上升。当设置为 0.6,由于相似度阈值变得更低,邻居集合引入了更多低质量的标签,损害了网络性能。

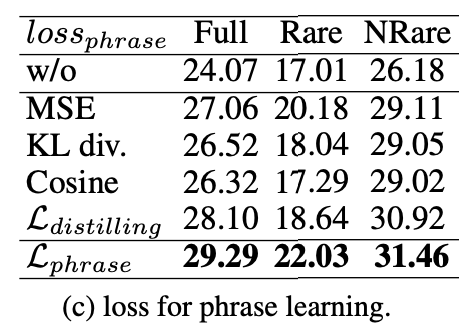

短语学习:

我们对比了 MSE,KL 散度,余弦相似性,蒸馏损失(MAE)和短语损失(MAE+triplet loss)。如下表所示,相比 baseline,蒸馏损失带来显著提升。然而,仅仅使用蒸馏损失是不够的,因为 MAE 仅仅考虑了预测结果与标签的分布(类内关系)。预测结果之间的关系也应被考虑在内(类间关系),尤其当标签分布非常接近的时候。

于是,我们将蒸馏损失与 triplet loss 结合组成短语损失,在短语损失监督下, 网络性能进一步提升。也就是说,蒸馏损失的目标在于拉进预测结果与标签的分布距离,同时,triplet loss 进一步细调类间距离,推开类间相似的样本,以达到模型最优结果。

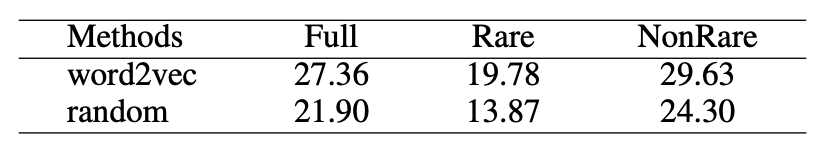

分析与展望:

为进一步探索关系短语对网络性能的提升,我们使用随机向量替换语言模型输出的单词向量,并关闭标签增强。由下表可看出,使用随机向量性能远低于使用语言模型输出的单词向量性能。这意味着网络学习中,由语言模型提供的语言先验知识更有利于 PhraseHOI 网络性能提升。

从 HOI 任务角度来看,网络推理过程中完全不需要短语分支,仅 HOI 分支即可获得性能提升。提出的 PhraseHOI 可以视为知识蒸馏或从语言先验知识迁移。

从 zero-shot 视角来看,当我们用短语分支推理时,将预设表更换为 open-set,提出的 PhraseHOI 有潜力完成 zero-shot 任务。

可视化效果

首发:旷视研究院

作者:R

专栏文章推荐

- 技术的真相 | 使用 OpenGL 实现线型动画的教程来啦!

- 聊聊旷厂黑科技 | 动作识别与检索带你体验视频时代“人工智能”新玩法

- 技术的真相 | 基于 K8S Framework 框架实现多种扩展调度策略

欢迎关注旷视研究院极术社区专栏,定期更新最新旷视研究院成果

加入旷视:career@megvii.com