paper: https://arxiv.org/abs/2202.13123

code: https://github.com/guanghaoyi...

注:本文系粉丝投稿,欢迎各位同仁投稿交流!

本文由浙江大学、字节跳动、华中科技大学和新加坡国立大学合作完成,该工作讨论了如何使用与待评估图像内容无关的高清图作为参考,实现对单张图片质量的评估(IQA)。文中提出的从全参考到内容无关参考的知识蒸馏方案,能够缓解内容无关参考性能的不稳定问题,其评价结果能够与人的主观感受具有高度一致性。本工作已入选 AAAI 2022 Oral。

1Abstract

将图片进行质量评价(IQA)在众多图像处理领域有广泛的实用性,可靠准确的图像质量评估方法对于图像压缩、图像重建等下游任务有重要的指导作用。在实际场景(如用户创作内容(UGC))中,可靠的图像质量评价方法有利于筛选过滤掉低质量图像数据,提高图像数据审核效率。

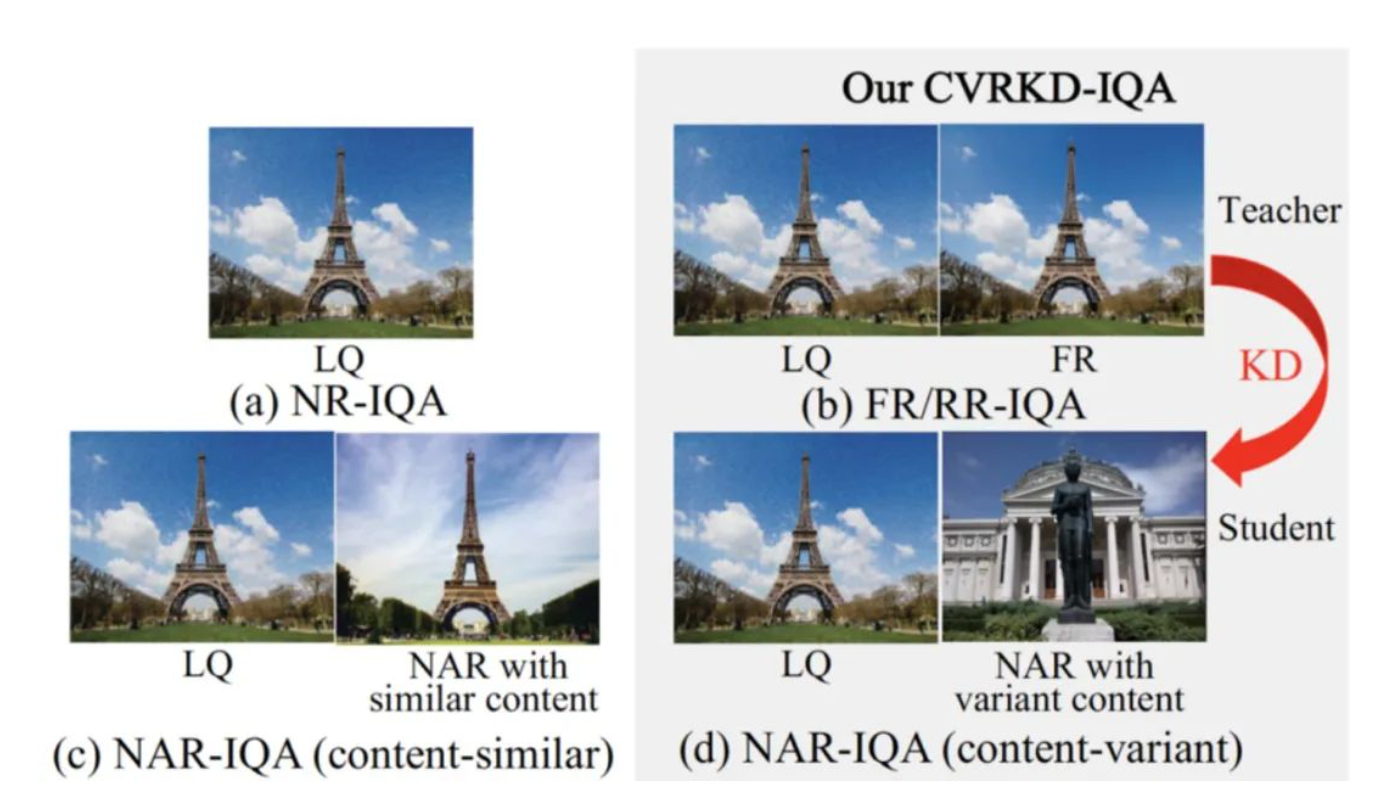

图像质量评估方法可分为三类:全参考(Full Reference-IQA)[1]、半参考(Reduced Reference-IQA)[2]和无参考(No Reference-IQA)[3]。虽然现阶段无论是全参考图像质量评价方法还是无参考方法都取得了长足发展,但这些方法距离人类对图像质量进行评估时的表现依然有极大的空间。人类对图像质量进行评估时,基于过往经验,在大脑中已经储存了大量高质量图像的信息。

全/半参考质量评价方法需要借助于待评估图像在像素级对齐的高清图像作为参考,限制了这类方法在UGC等没有高清全参考图像的现实场景下的使用。无参考图像质量评估方法往往只利用了待评估图像自身的信息,没有充分利用高质量图像的信息,在真实场景下评价性能有限。

为解决上述问题,本文首次提出了一种基于知识蒸馏的内容无关图像质量评估框架CVRKD-IQA(可参考上图),主要贡献如下:

- CVRKD-IQA利用日常可获取的任意内容高清图作为参考,解决已有全参考/半参考方法需要使用像素级对齐的参考图的限制,同时突破已有无参考方法无法利用高清图像分布信息导致的性能瓶颈,让评估模型更好地学习到各种内容无关高清图的图像分布信息,输出更好的图像质量分数。

- CVRKD-IQA首次引入知识蒸馏解决内容无关参考性能不稳定问题。选择结构完全相同的两组模型,将使用像素级对齐图像的全参考模型进行预训练之后作为teacher网络(FR-teacher),将使用内容无关参考图的模型作为student网络,使用知识蒸馏,在保证内容无关参考模型性能稳定的同时,向student网络引入更多的高清-低质差异先验信息,提高内容无关参考student网络(NAR-student)的鲁棒性和准确性。

2Method

CVRKD-IQA实现过程分为三个不同阶段:

- 第一阶段:选择设计好的随机参数初始化的网络作为模型,利用人工标记分数的全参考-待评估图像对,对FR- teacher网络进行有监督预训练;

- 第二阶段:固定训练好的FR- teacher网络参数,重新选择一个结构完全相同的模型作为NAR- student网络。将待评估图像分别输入到FR-teacher和NAR-student网络,将像素对齐的全参考图像和随机选择的内容无关参考图分别输入FR-teacher和NAR-student网络,使用人工标记的图像分数和来自FR-teacher的高清-低质差异特征蒸馏监督NAR-student训练;

- 第三阶段:将训练好的内容无关参考模型保存,使用过程中选择任意可获取到的高清图作为参考输入,同时输入待评估图像,模型进行前向传播后输出图像质量评估分数。

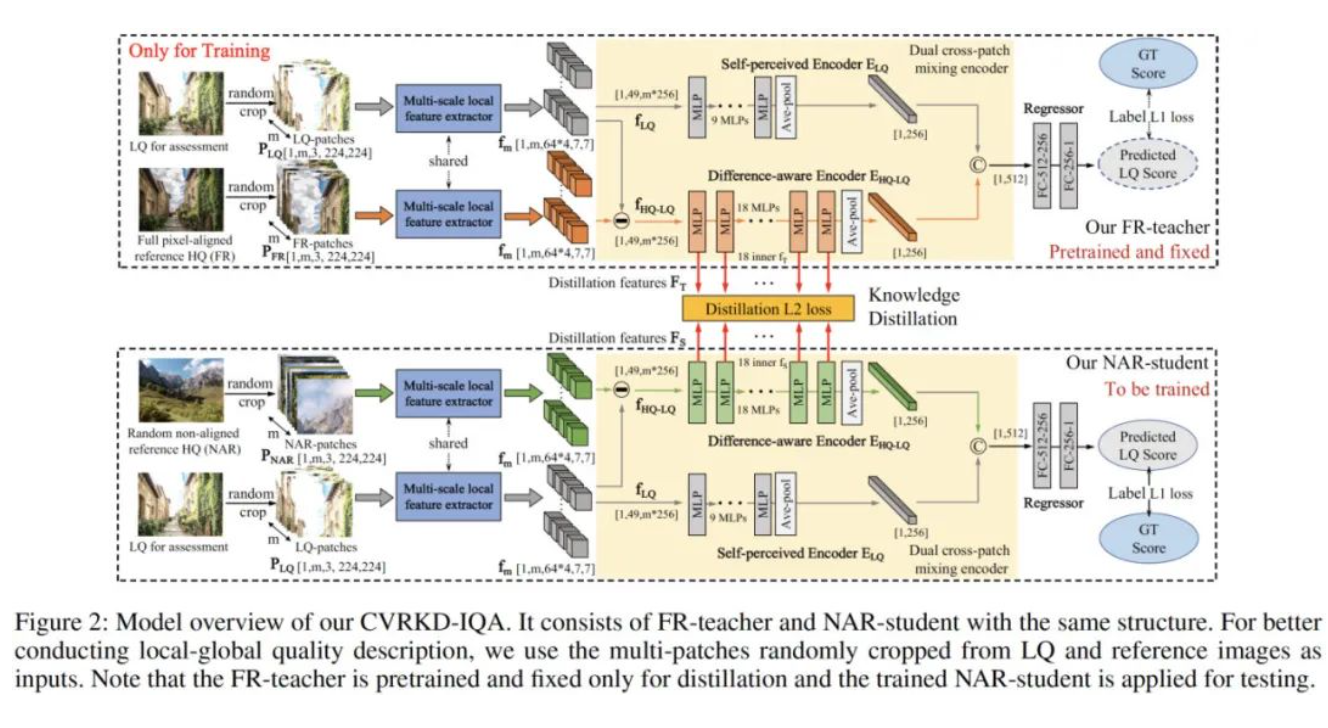

上图给出了本文所提CVRKD-IQA方案流程图,这里我们从输入端、网络结构以及蒸馏训练三个角度对该方案进行介绍:

- 输入端: 网络的输入包含参考图(全参考和任意内容无关参考图均可)和待评估图像两部分;

- 网络结构:首先将输入的参考图和评估图进行随机图像块裁剪,裁剪出的每一个图像块通过在ImageNet上预训练好的ResNet50特征提取器提取浅层图像特征;然后合并通道数、变换特征矩阵维度之后,分别将待评估图像特征,参考图-待评估图像差分特征输入到双流跨图像混合编码器的自编码分支和差异编码分支,其中自编码分支和差异编码分支分别由9个和18个多层感知器(MLP)串联组成;最后,将双流分支得到的两组特征合并,通过两个全连接层输出模型的预测结果。

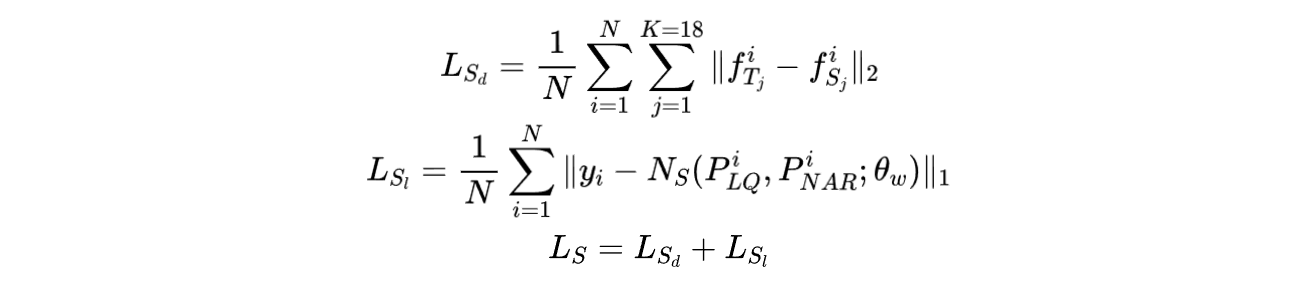

- 蒸馏训练:内容无关参考网络作为学生网络(NAR-student),蒸馏训练的过程中受到两个部分的监督,其中预测的分数与人工标记的分数之间计算L1损失,作为标签损失函数,这点与FR-teacher网络的损失一样;只依赖标签损失会导致NAR-student的训练受到参考图内容变化而波动,无法得到稳定的预测结果,因此在标签损失的基础上,本方法引入蒸馏损失,将FR-teacher和NAR-student在各自差异编码分支的18组中间特征计算L2损失约束NAR-student的差异编码过程,使得NAR-student更多地关注影响图像质量的分布,而减小图像内容变化带来的干扰,最后蒸馏训练由标签损失函数和蒸馏损失函数相加,作为NAR-student最终的损失函数。

在损失函数方面,本文所涉及的两个损失定义如下:

受益于知识蒸馏,本文所提的NAR-student可以更有效的学习HQ-LQ之间的差异性,同时保持不同参考图评价时的稳定性。在实际场景中,所得NAR-student可以直接采用非对齐HQ图像作为参考对待评估图像进行打分。

3Experiments

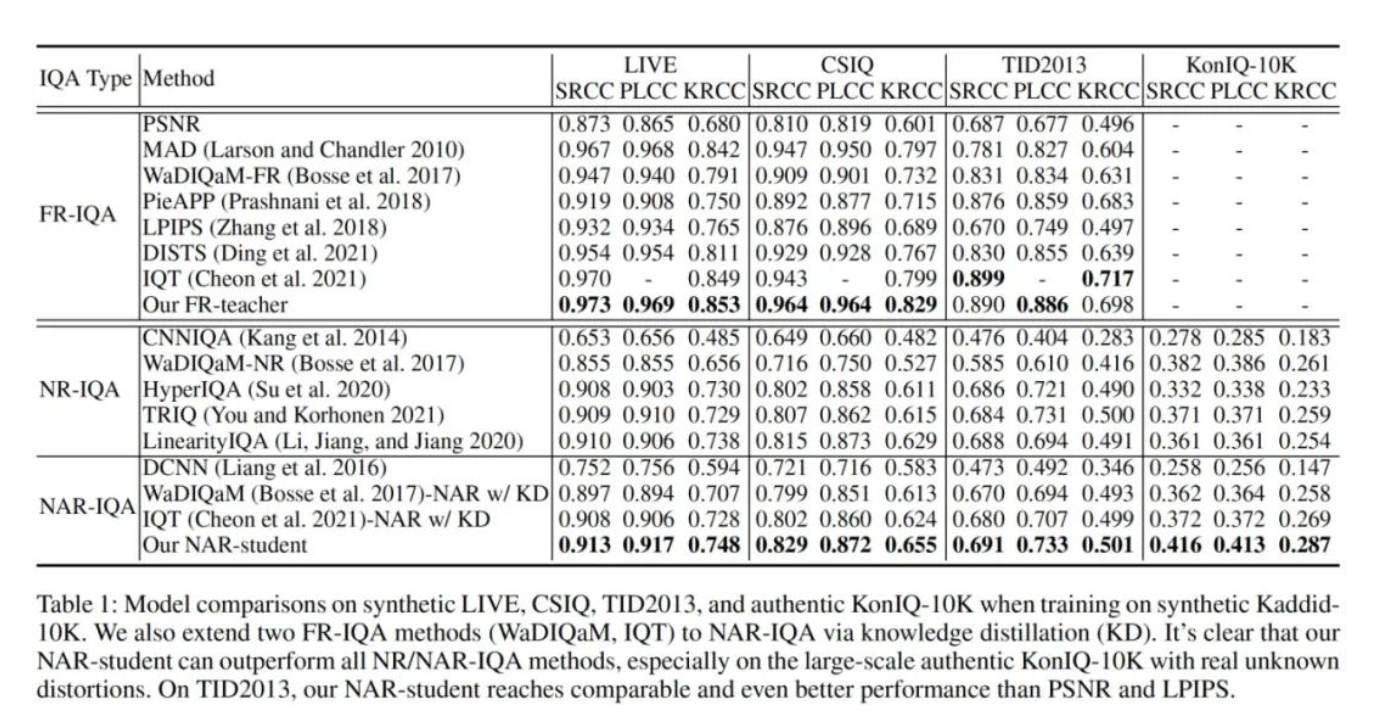

为了公平地比较全参考、无参考、任意图像参考的各类方法,本文将各类SOTA统一在合成数据集Kaddid-10K上进行训练,在合成数据集LIVE, CSIQ, TID2013和真实数据集上进行cross-dataset 比较。

上表给出了本文方案与其他IQA方案的性能对比,可以看到:

- 在全参考设置下,FR-teacher在LIVE,CSIQ数据集上达到SOTA性能,在TID2013数据集上相比更复杂的Transformer-based IQT方法[4]差距较小,证明了本文模型结构的优越性;

- 在无参考和任意图像参考设置下,经过蒸馏的NAR-teacher网络在四个测试集上均达到SOTA性能,且在合成测试集上与常用的全参考方法(例如PSNR,LPIPS)预测准确性能持平。

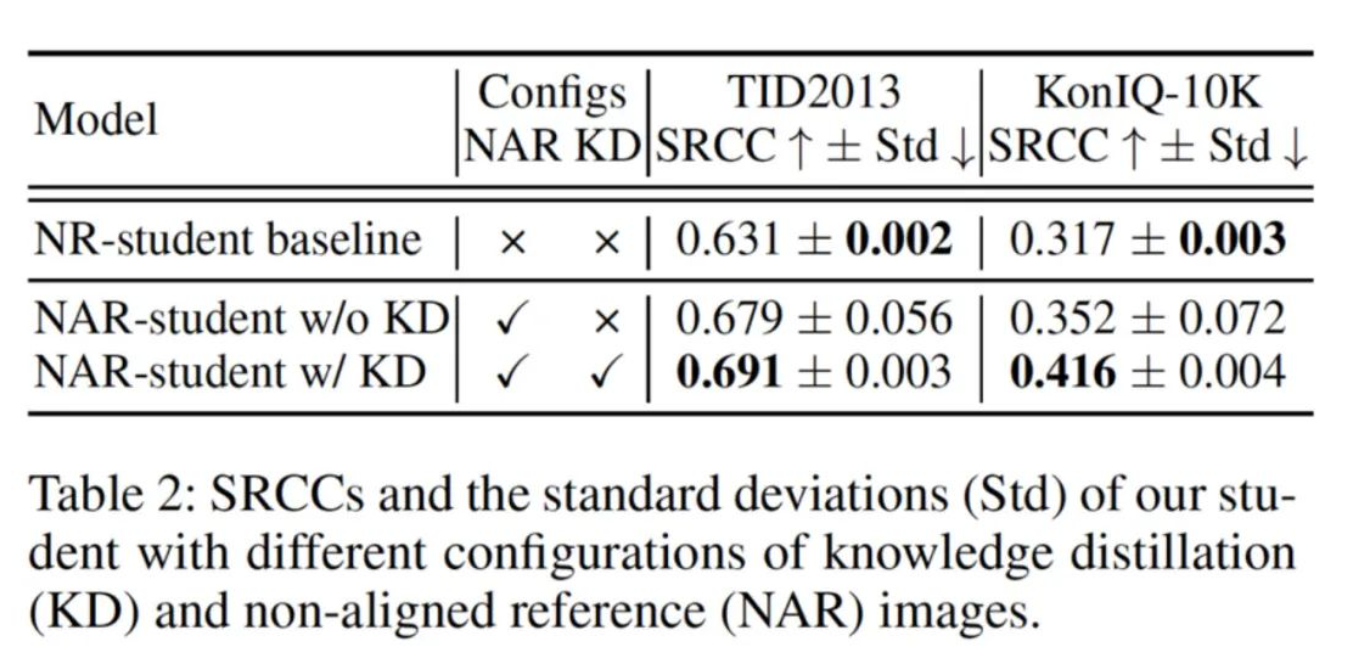

上表展示了有无参考图和知识蒸馏的消融实验结果,可以明显地观察到:

- 当使用参考图时,NAR- student相比与无参考baseline有明显提升,但参考图与待评估图像的内容差异也带来分数预测不稳定的严重问题(可以看到第二行的模型预测方差较大);

- 当使用FR-teacher对NAR- student进行蒸馏监督训练时,NAR- student的性能和稳定性得到明显提升。这说明知识蒸馏能够使NAR- student更多地关注影响图像质量的分布,而减小图像内容变化带来的干扰,提高IQA模型的性能和在不同参考图下的鲁棒性。

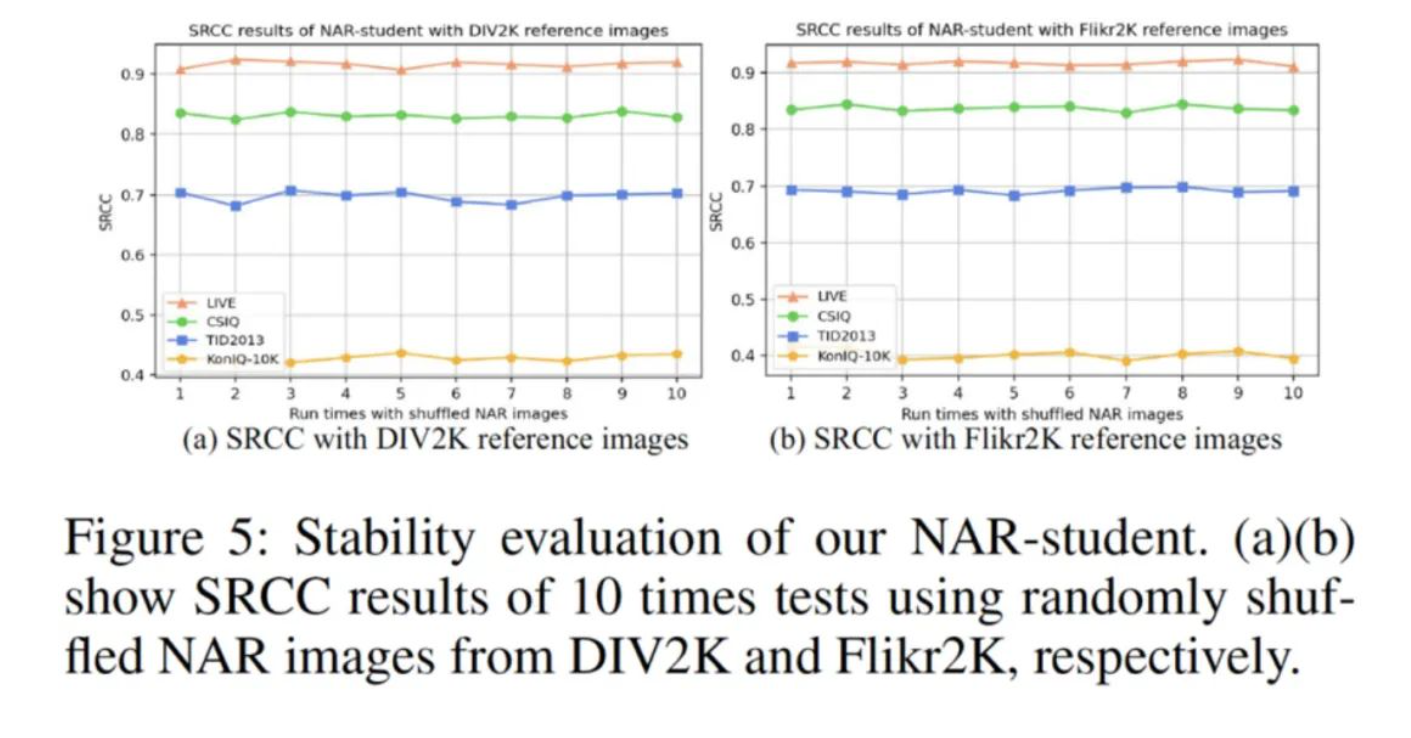

作者进一步验证了NAR- student在不同参考图下的稳定性,从上图可以看出:从不同的高清数据集(DIV2k和Flikr2K)随机选择参考图,NAR- student均得到了相对稳定的IQA预测结果,证明了方法在不同参考图下的稳定性。

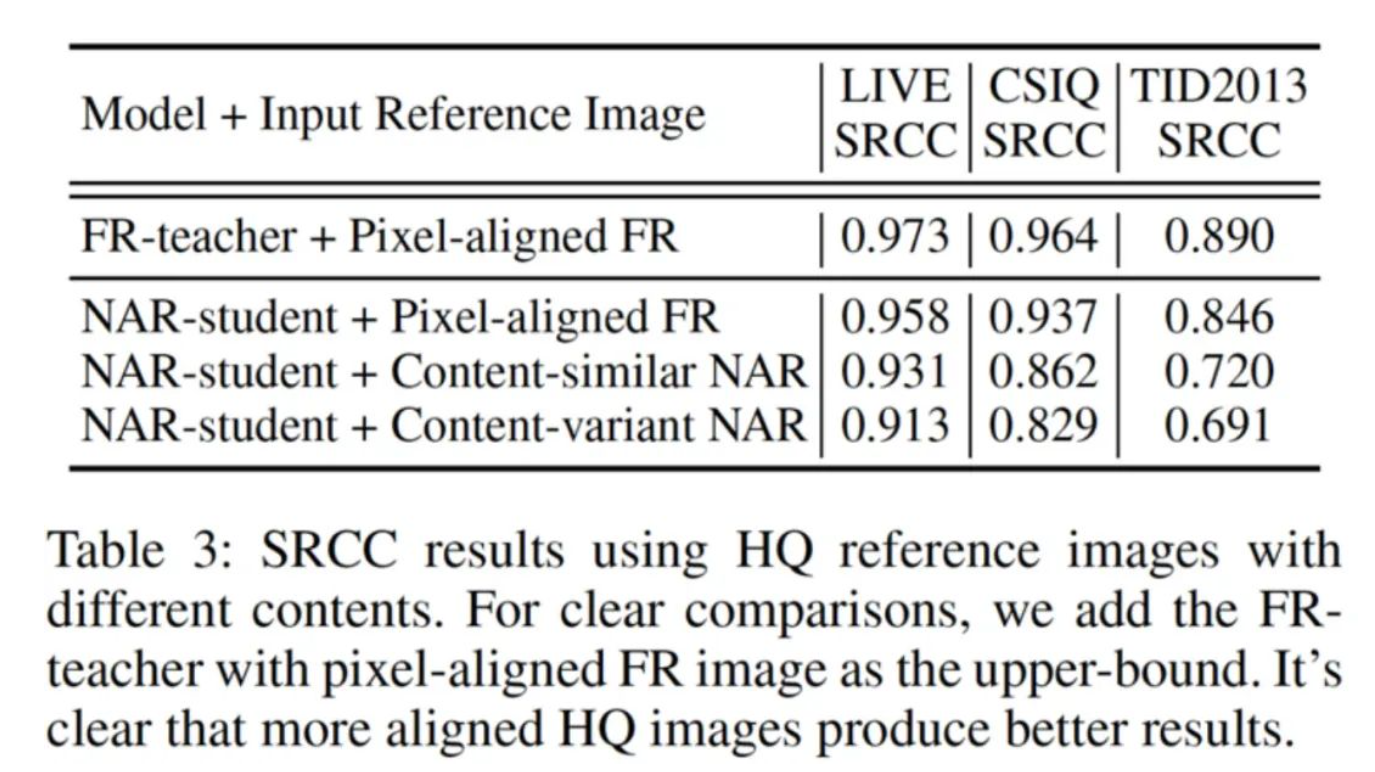

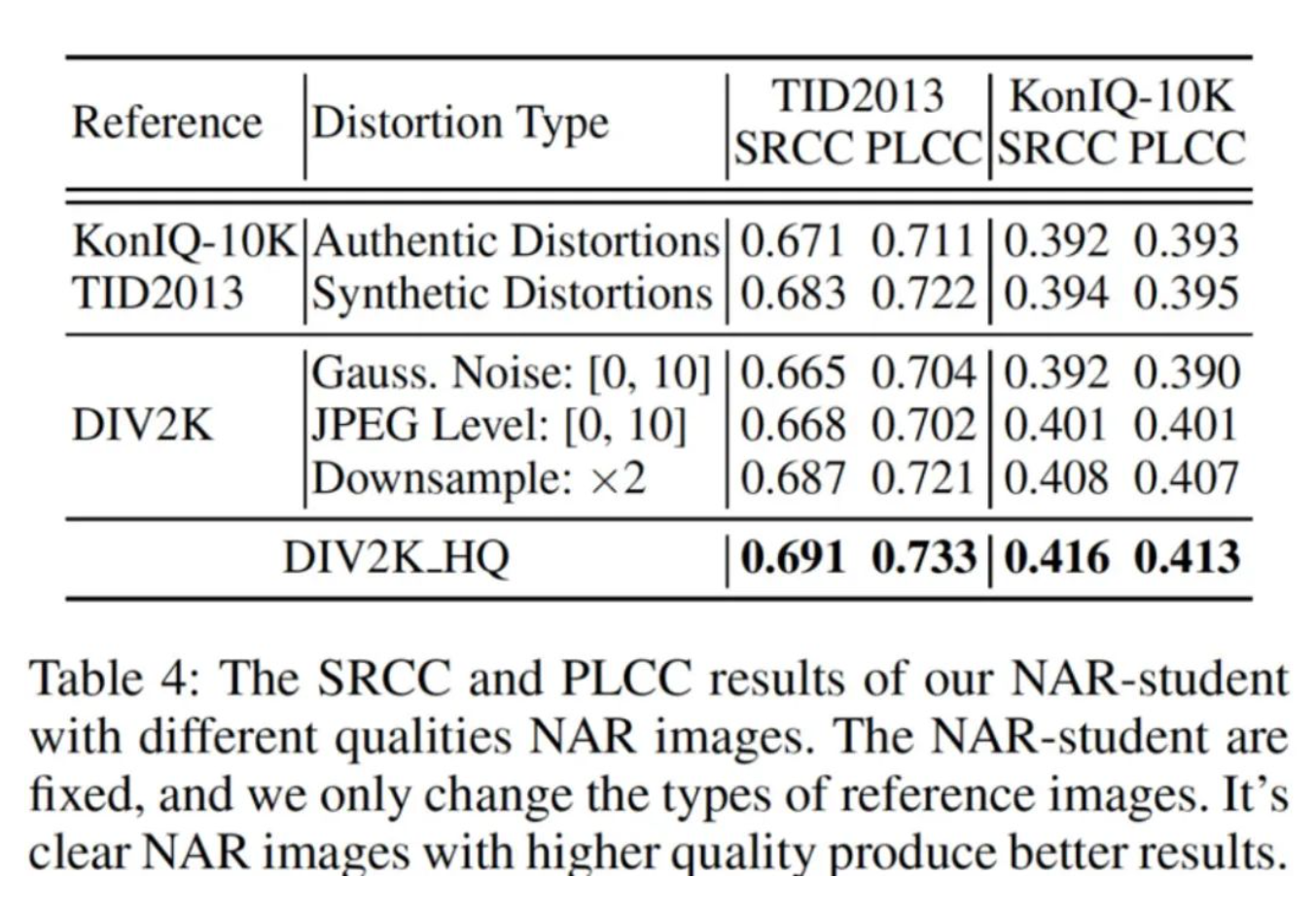

虽然CVRKD-IQA致力于使用任意的高清图作为参考,同时也对参考图选择进行了探讨(见上表):

- 当使用的参考图像质量越高,参考图像内容与待评价图像越接近时,CVRKD-IQA预测出来的图像质量分数越准确;

- 即使NAR-student没有显式输入像素对齐的全参考数据对进行训练,但NAR- student在全参考图像对的测试效果与FR-teacher较为接近。这就说明了NAR-student确实通过知识整理有效地学习到了FR- teacher的高清-低质图像差异分布信息。

对于参考图像质量来说,上表的结果说明:当参考图像质量越高时,NAR- student预测出的分数越准确。

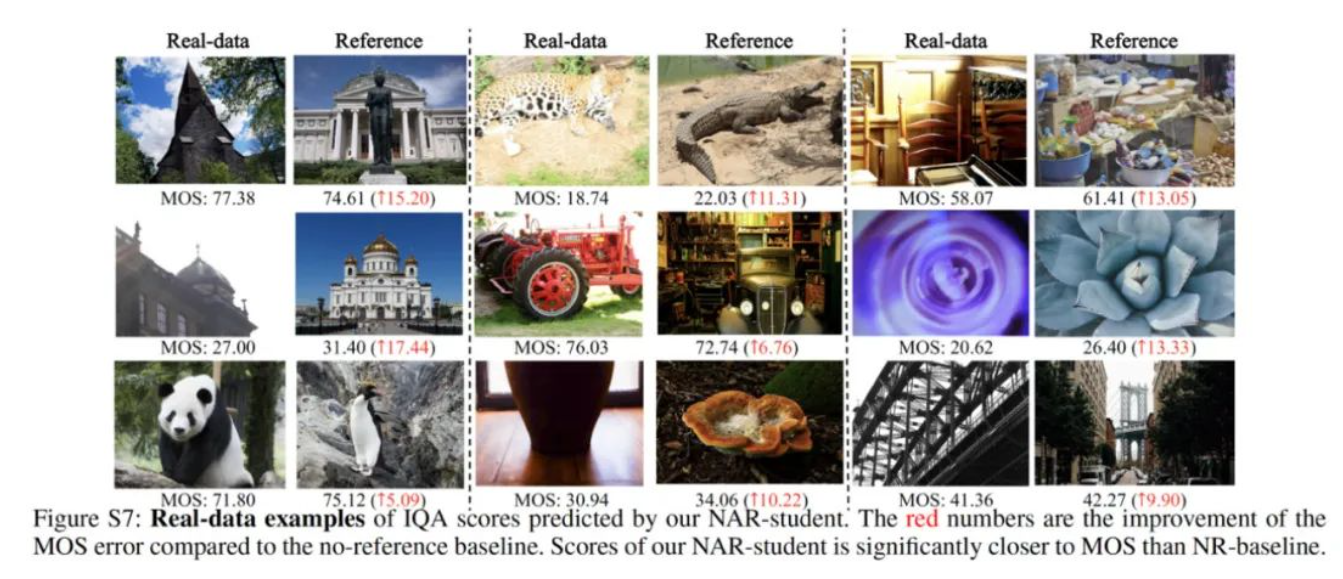

上图展示了更多真实图像上的预测结果,可以看出:CVRKD-IQA评价结果与人的主观感受具有高度一致性。总而言之,CVRKD-IQA兼具无参考图像质量评估方法不需要成对参考图像和全参考图像质量评估方法能有效利用高质量图像信息的优点,能利用不成对的高质量图像的分布信息,在有效的逼近全参考图像质量方法表现的同时,保持了实用性优势,并且能够推动图像质量评估方法的实际应用。

更多实现细节和实验结果,请参考论文原文及开源代码。

来源:AIWalker

作者:作者团队

推荐阅读

- 273.6FPS!百度开源超轻量实时语义分割方案PP-LiteSeg,兼具高性能与高推理速度

- 恺明团队新作ViTDet:探索ViT骨干在检测中的应用

- ABPN | 移动端实时超分详解

- DASR: 盲超分两大流派集成大者!

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏AIWalker。