paper: https://arxiv.org/abs/2204.02681

code: https://github.com/PaddlePadd...

本文提出一种轻量型实时语义分割方案PP-LiteSeg,它包含以下几个关键性模块改进:

- FLD(Flexible and Lightweight Decoder),它用于降低传统decoder模块的计算负载;

- UAFM(Unified Attention Fusion Module),它采用空域与通道注意力生成用于特征融合的权值;

- SPPM(Simple Pyramid Pooling Module),它以极低的计算消耗进行全局上下文信息聚合。

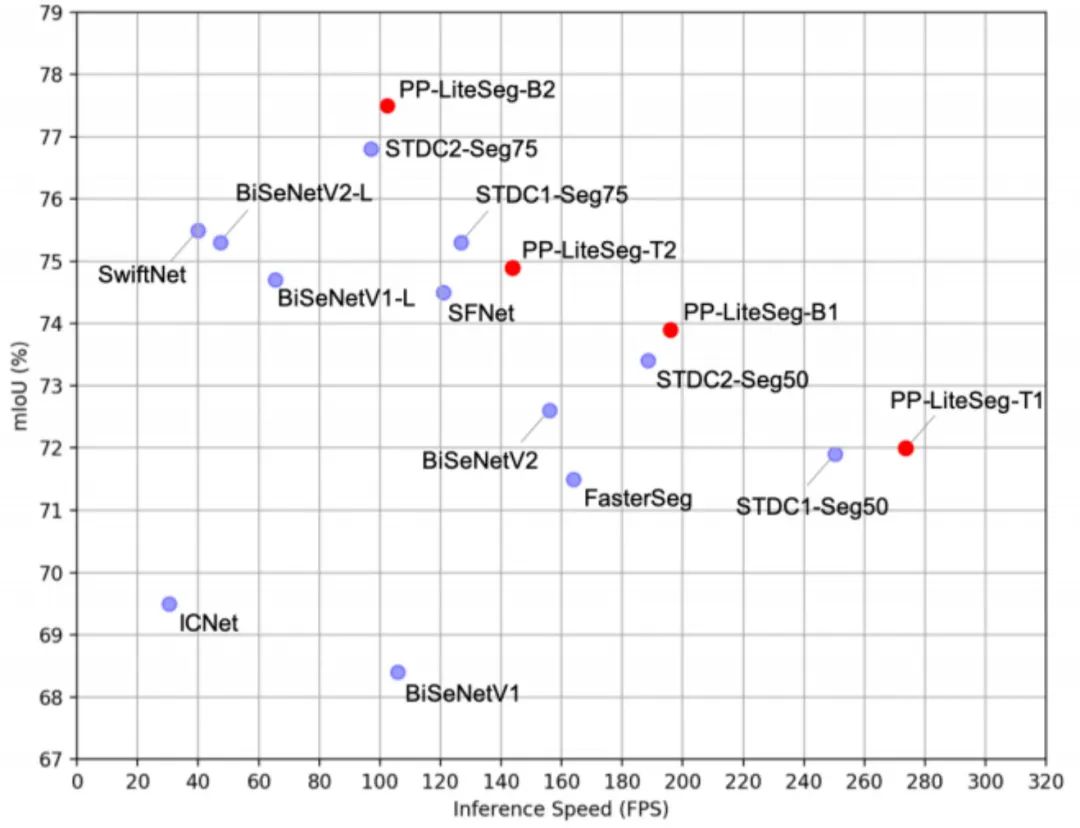

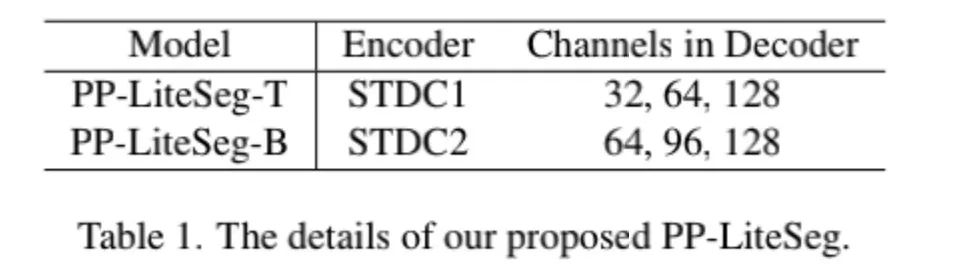

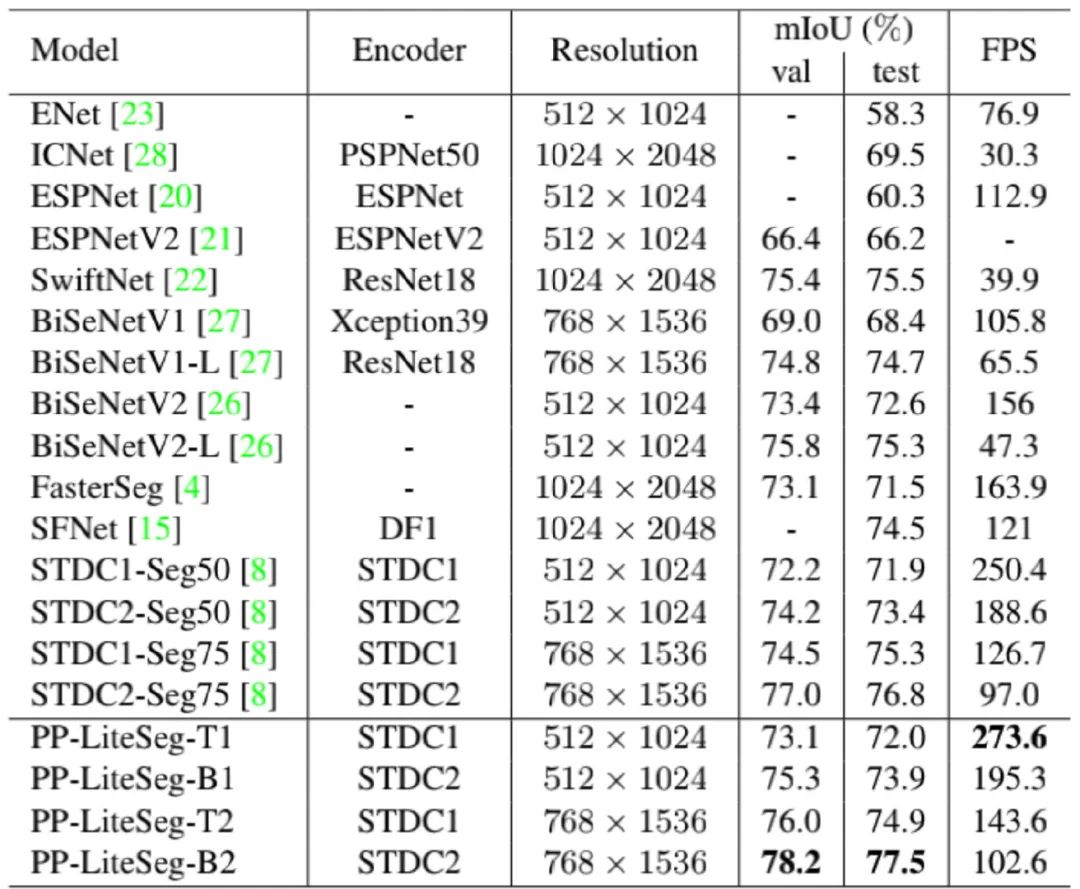

相比其他方案,所提PP-LiteSeg取得了更佳的精度-速度均衡(可参考下图)。在Cityscapes测试集上,PP-LiteSeg-S取得了72.0%mIoU,推理速度达273.6FPS;PP-LiteSeg-B取得了77.5%mIoU,推理速度达102.6FPS(注:硬件为NVIDIA GTX 1080Ti)。

1Method

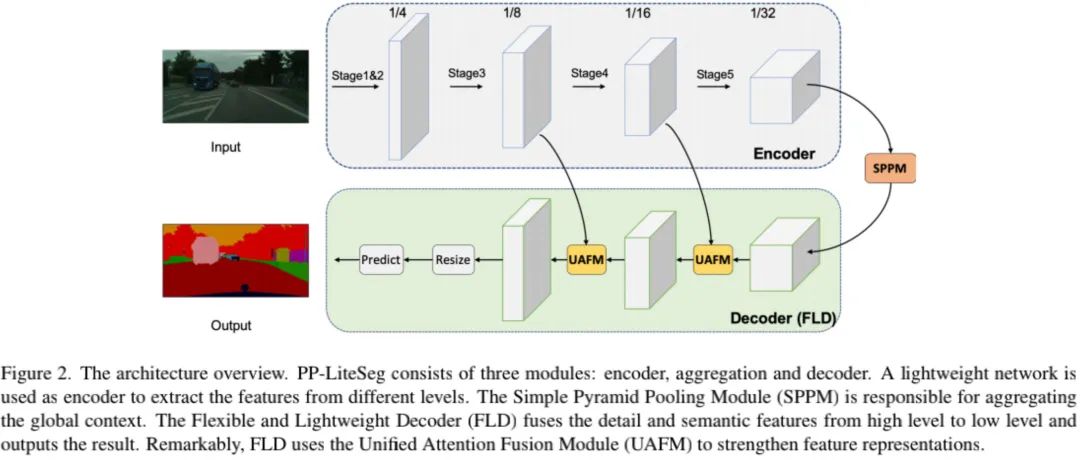

上图为本文所提PP-LiteSeg整体架构示意图,它包含三部分:

- Encoder:它采用了STDCNet一文中的轻量型骨干(注:骨干部分采用SSLD方案进行预训练);

- Aggregation:它采用SPPM进行长程关系建模,SPPM的输出包含全局上下文信息;

- Decoder:它采用渐进式方式融合多级特征并输出最终结果。具体来说,FLD包含两个UAFM与一个分割头。

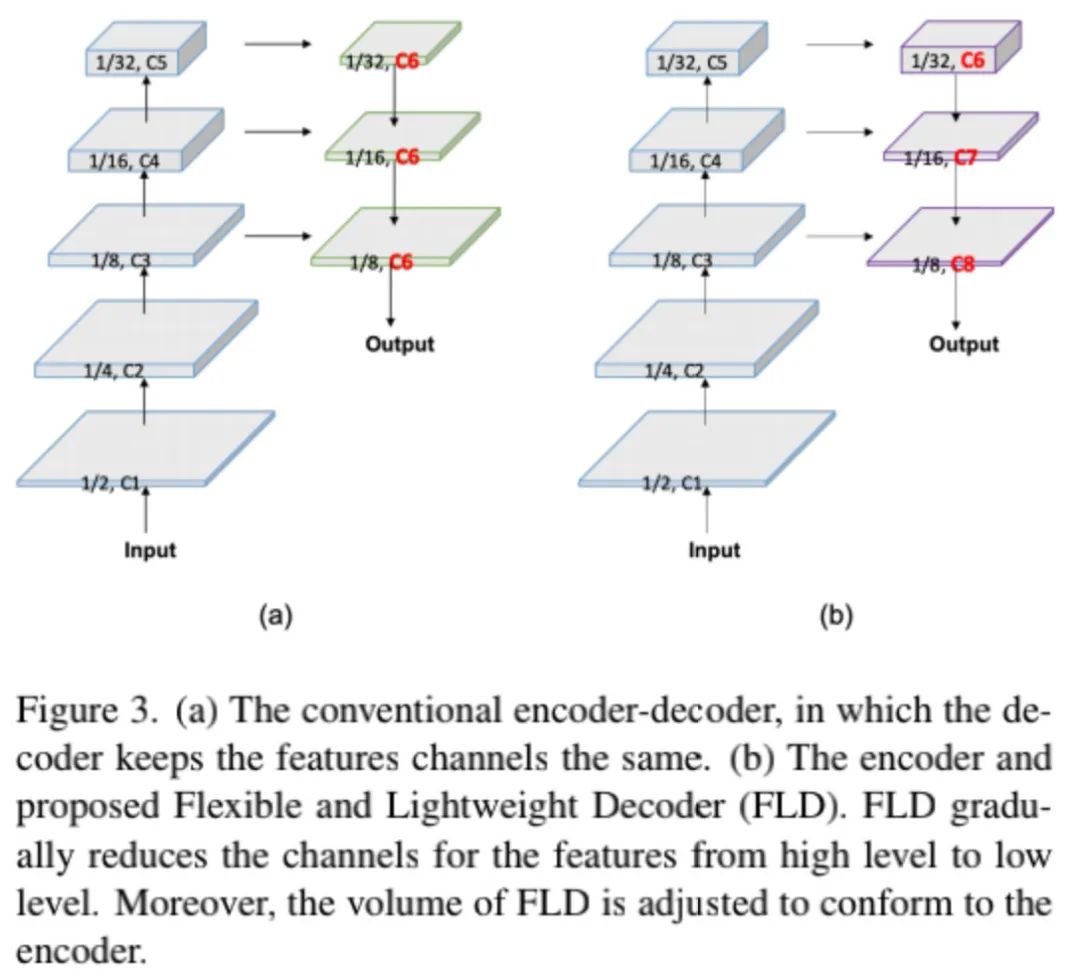

Flexible and Lightweight Decoder

上图给出了已有方案与本文方案在decoder方面的差异性对比,可以看到:已有方案(上图a)中decoder部分特征的分辨率在提升,同时通道数不变,这会导致浅层特征的计算量远大于深层特征,进而导致浅层特征的计算冗余。

为改善decoder的计算效率,本文提出了FLD,它伴随特征分辨率提升逐渐减少通道数。FLD可以更容易调节计算消耗以达成更好的平衡。

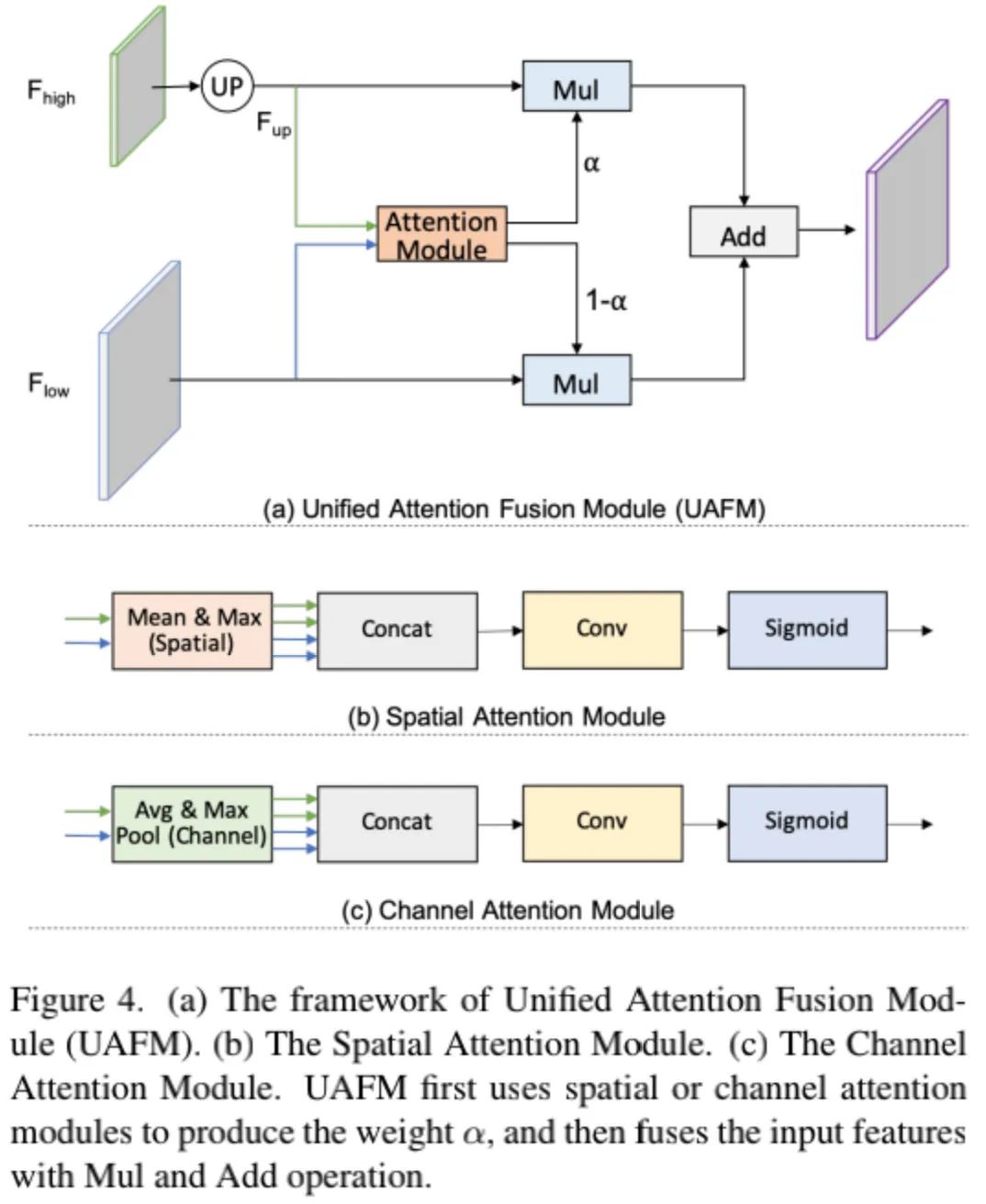

Unified Attention Fusion Module

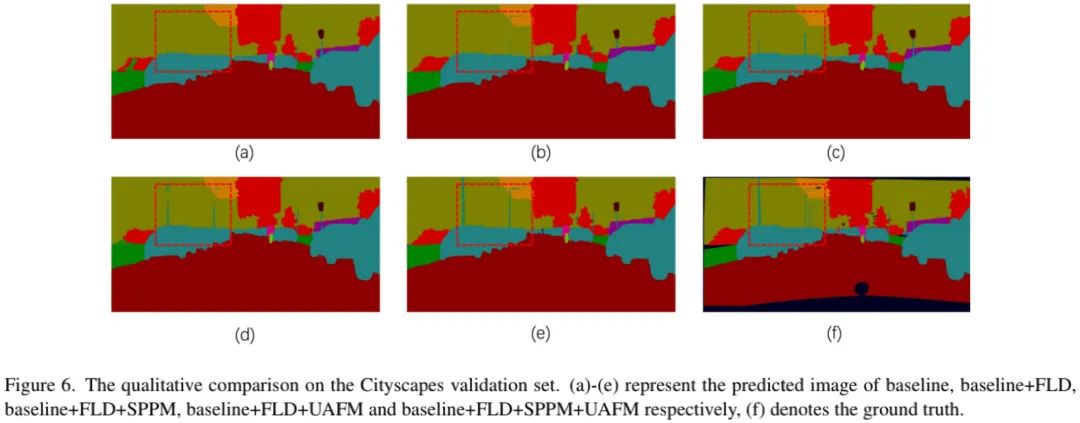

多级特征融合对于达成高分割精度非常重要。本文提出了UAFM,它采用通道与空域账户和毅力丰富融合特征的表达能力(见上图)。从图示可以看到:UAFM采用注意力模块生成权值α并用于进行特征融合。具体来说,UAFM首先采用双线性插值将

注意力的选择上其实就是BAM、CBAM中的计算方式,这里略过不计。不知各位有没有意识到:这里的UAFM跟SKNet一文的注意力的非常像。

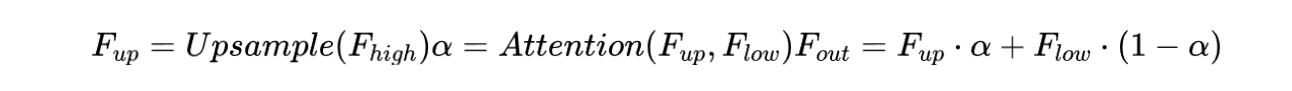

Simple Pyramid Pooling Module

上图为本文所设计SPPM模块示意图,其实就是PPM变种,这个看图就懂了,继续略过。

2Experiments

上表&图给出了不同实时语义分割方案的性能对比(Cityscapes),可以看到:

- PP-LiteSeg在精度-速度方面取得了SOTA均衡;

- PP-LiteSeg-T1取得了72.0%mIoU,推理速度273.6FPS;

- PP-LiteSeg-B2取得了77.5%mIoU,推理速度102.6FPS。

- 相比STDC-Seg,PP-LiteSeg精度更高、推理速度更快。

来源:AIWalker

作者:FastCV

推荐阅读

- 恺明团队新作ViTDet:探索ViT骨干在检测中的应用

- ABPN | 移动端实时超分详解

- DASR: 盲超分两大流派集成大者!

- CVPR2022 | DyRep让重参数化机制动态调整,涨点同时还减少训练耗时

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏AIWalker。