尽管Transformer已在图像超分领域取得了令人惊讶的性能,但从感受野角度来看:Transformer的潜力仍为得到充分挖掘。

基于此,本文提出了一种新颖Hybrid Attention Transformer(HAT)方案,它同时利用了通道注意力与自注意力机制。此外,更好的进行跨窗口信息聚合,本文提出一种Overlapping Cross-Attention模块以增强相邻窗口之间的信息交互。

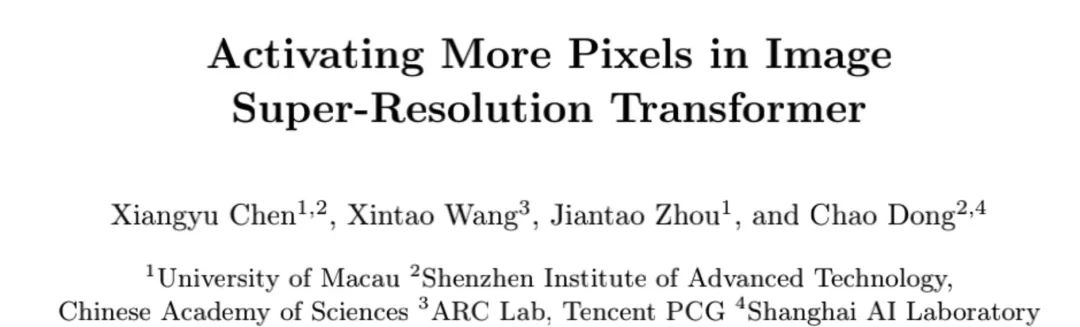

在训练阶段,本文还额外提出一种同任务预训练(Same-task Pre-training)策略进一步提升性能。实验结果表明:所提HAT大幅超越了其他图像超分方案,最高可达1dB。

1出发点

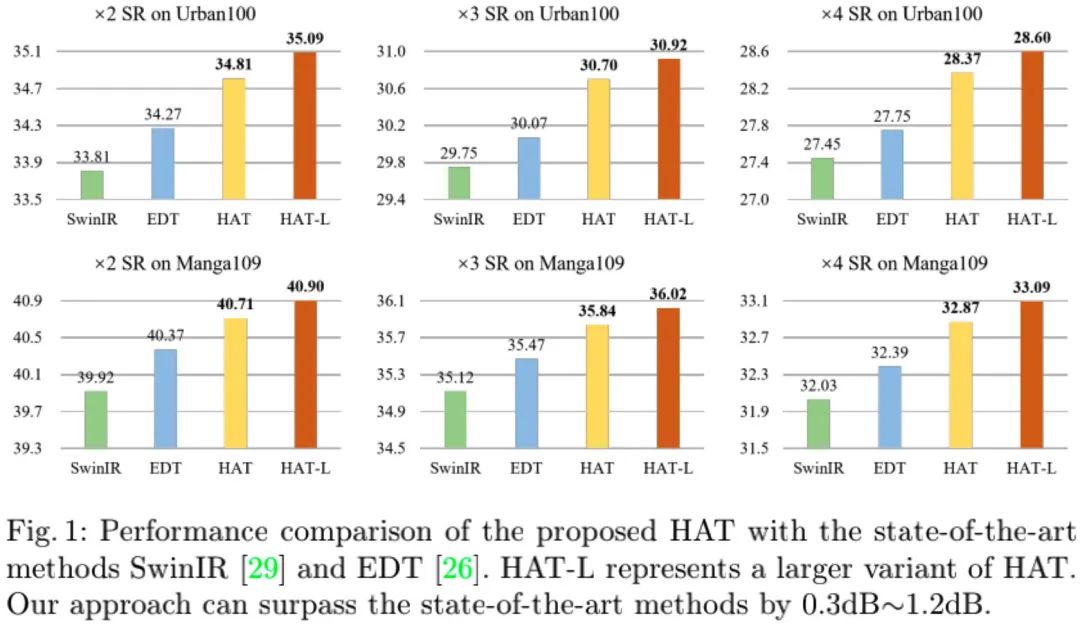

为什么SwinIR会比CNN方案具有更优的性能呢?为挖掘其工作机理,本文采用LAM进行了分析,LAM工具可以清晰的呈现哪些输入像素对所选区域产生了共享。

直观上来讲,越多的像素被利用模型的性能越好,CNN方案中的EDSR与RCAN符合该假设。但是,从上图可以看到:虽然SwinIR的性能更优,但SwinIR的感受野比RCAN更小。也就是说,Transformer方案有违前述直观感知。但同时也为我们提供农了额外的洞察:

- 相比CNN,SwinIR具有更强的建模能力:利用更少的信息达成更优的性能;

- 如果可以利用更多的输入像素,SwinIR还有进一步提升的空间。

此外,我们发现:SwinIR的中间特征存在明显的伪影问题。而这些伪影是由于窗口划分机制导致,这意味着:移位窗口对于构建跨窗口链接不够高效。

基于上述洞察,本文对通道注意力在Transformer方案中的应用进行了探索,同时还提出了一种OCAM用于更好的进行跨窗口信息聚合。

2本文方案

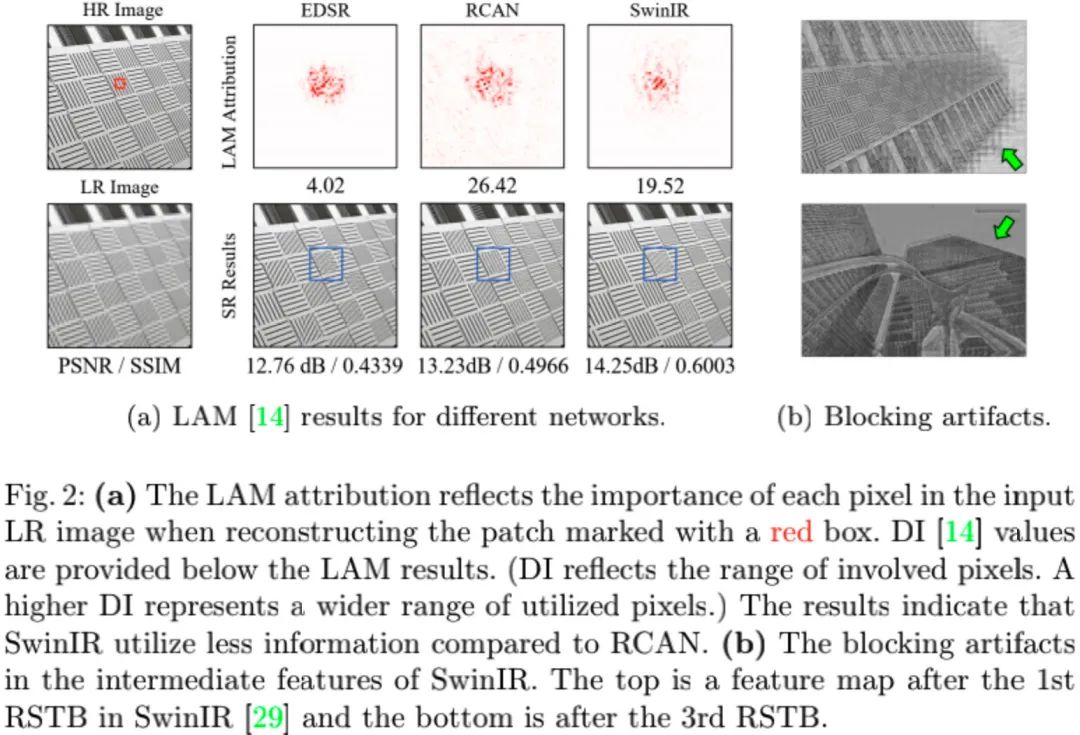

上图给出了本文所提HAT架构示意图,很明显,它是一种类RCAN架构。它与RCAN的关键区别在于RHAG与RCAG。因此,我们仅对RHAG进行介绍,而RHAG由HAB与OCAB两部分构成。

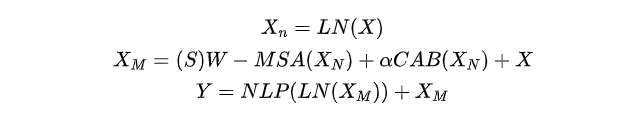

- HAB:该模块有CAB与(S)W-MSA组合得到,描述如下:

注:关于HAB中的(S)W-MSA模块部分可参见SwinIR一文,这里略过不计。

- OCAB :上图给出了OCAB模块的结构示意图。它与SwinIR中的自注意力的区别在于Key/Value采用了更大的块,进而达到了跨窗口信息聚合。为更好的控制窗口重叠程度,作者引入了超参,此时Key/Value的窗口尺寸定义为:。

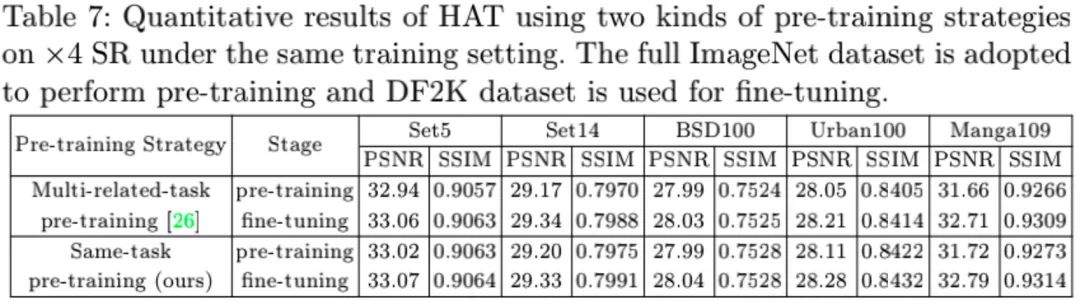

除了上述模块方面的改进外,本文还提出了一种同任务预训练策略:在相同任务下采用更大的数据集(如ImageNet)进行模型预训练,然后将预训练模型在目标数据集(如DF2K)上微调。

3Experiments

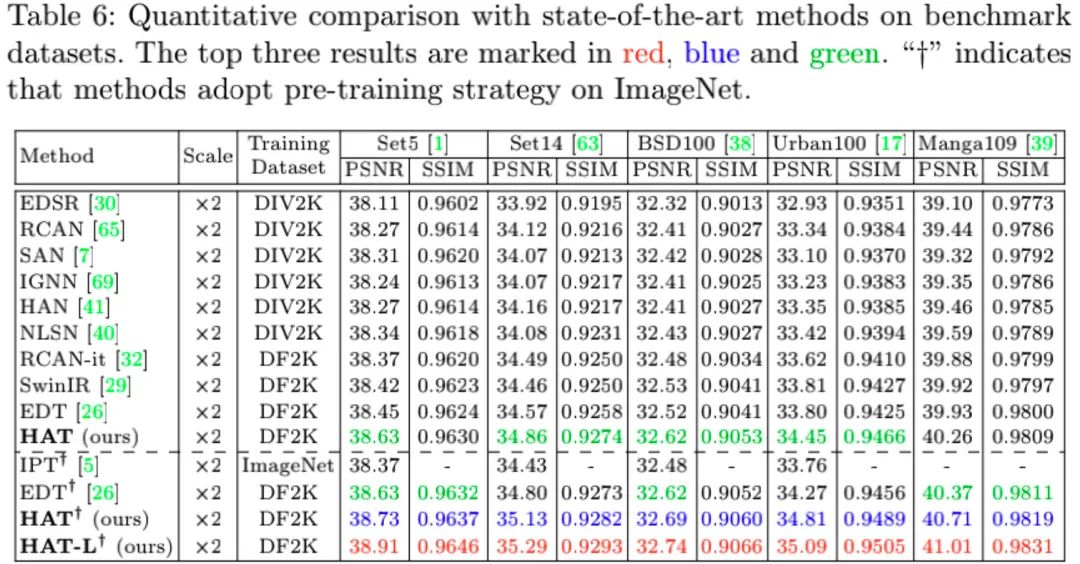

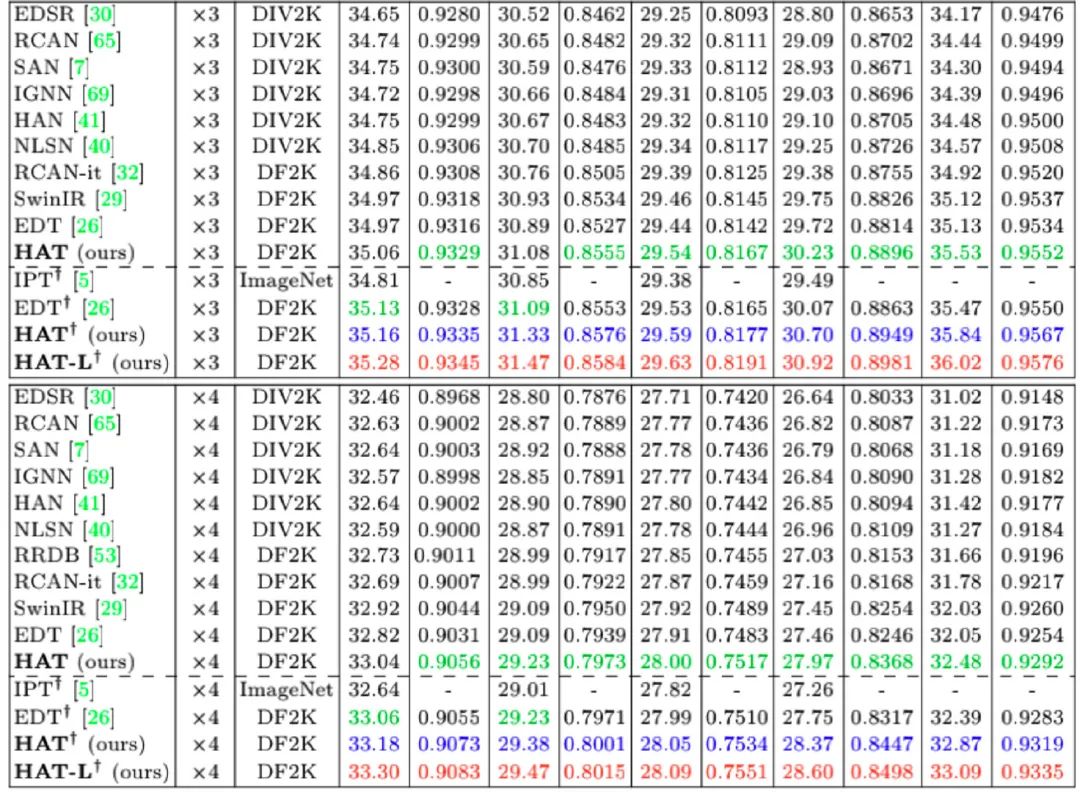

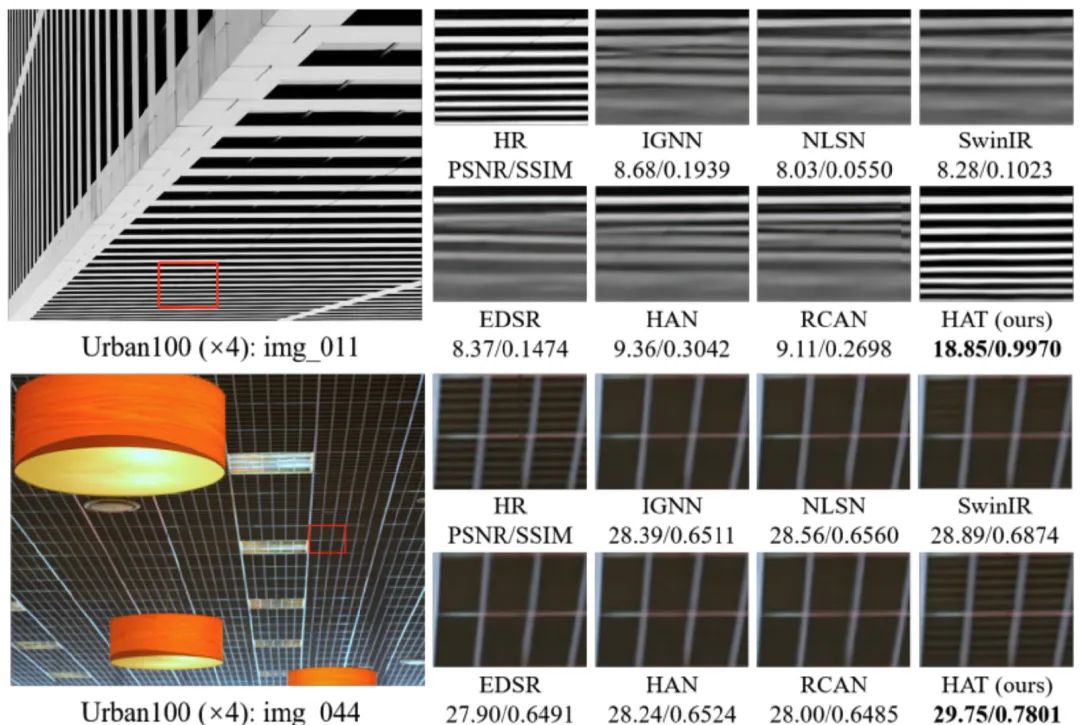

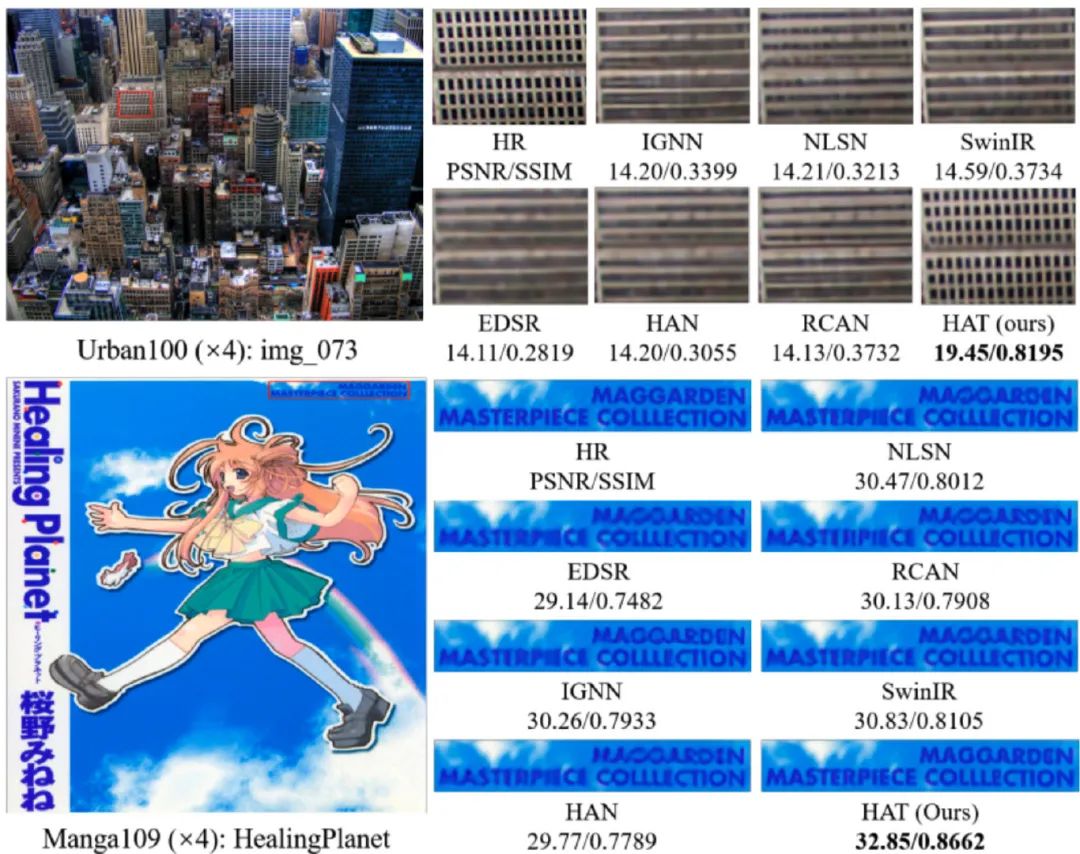

上面图&表对比了不同方案的性能与超分效果,可以看到:

- 在所有基准数据集上,HAT均大幅超越其他超分方案;

- 相比SwinIR,HAT的性能提升达0.48dB~0.64dB@Urban100,在Manga109数据集上的性能提升达0.34dB~0.45dB;

- 相比其他采用预训练的方案(如EDT),HAT的性能提升仍高达0.5dB@Urban100。

最后,我们再看一下同任务预训练策略的性能,见下表。

来源:AIWalker

作者:Happy

推荐阅读

- RepSR让BN重回SR怀抱,加速训练效率,同时消除伪影问题

- FMEN | NTIRE2021-ESR最低内存占用超分方案

- MIRNet重磅升级!MIRNetV2 更快、更强、更轻量

- CVPR2022 【盲图像超分】 LDL: 消除GAN伪影,打造更实用盲图像超分方案!

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏AIWalker。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。