1.多语言大模型落地的新范式

自OpenAI GPT-3、盘古α等超大规模预训练语言模型问世以来,大模型的强大语言表征能力在AI领域掀起了新一轮革命。在大模型不断刷新各类AI任务纪录的同时,如何将其高效部署到实际产品中逐渐成为核心课题。特别是在算力受限的终端应用中,往往无法直接部署性能卓越的大模型。这一问题在多语言大模型上尤为突出,因为其较单语言模型(如中文)需要更大参数量,用以学习更大规模的多语言语料。

另一方面,随着中国企业国际化进程的加速,AI模型的跨语言迁移成为一个关键问题。例如,当业务部门已经在中文上构建并部署了一套基于CNN或Transformer网络的对话NLU模型后,如何能快速地、低成本地将模型迁移到如英语、日语、泰语等多个语种上,为相应语言的用户提供服务。并且,由于原模型已经完成推理优化与部署,往往希望各语种上的模型仍然保持同样的架构,以便于进行统一的部署和管理。

针对这一实际需求,华为诺亚方舟实验室提出了一种全新的多语言大模型应用范式:【FreeTransfer-X】,旨在利用多语言大模型的能力快速将已部署的NLP模型无缝迁移到其他语种,并且无需任何标注数据,从而在每个语种上至少节省上万元的标注成本。具体地,该方法借助多语言预训练模型的跨语言迁移能力和知识蒸馏技术,在目标语言上性能媲美用实际标注数据训练的模型。

相关论文已发表在Findings of NAACL 2022:https://aclanthology.org/2022.findings-naacl.16.pdf(

代码开源在:https://github.com/huawei-noah/noah-research/tree/master/NLP/FreeTransfer-X

2.研究背景及任务设定

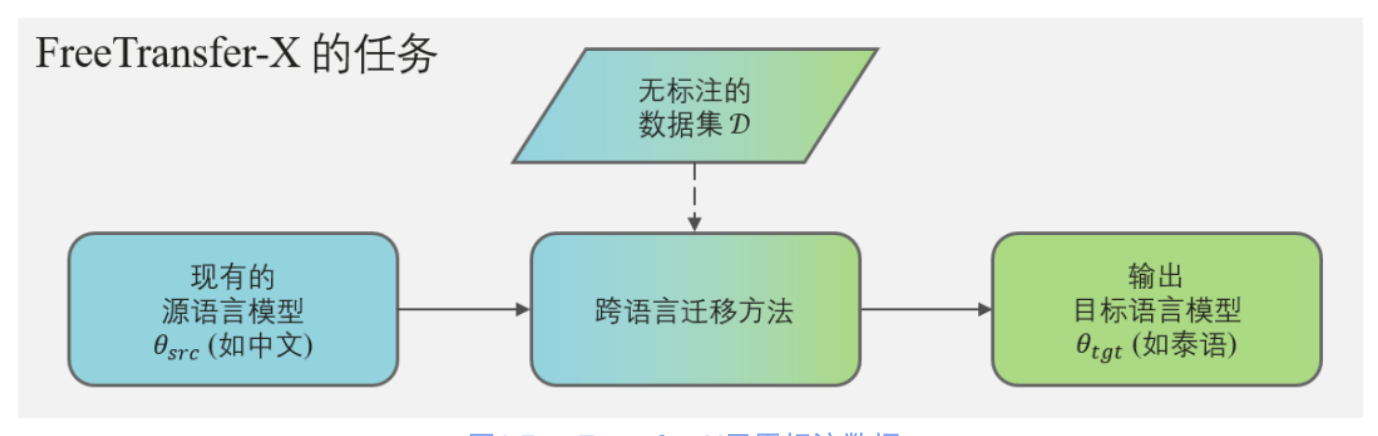

图1.FreeTransfer-X无需标注数据

传统的多语言大模型落地基于“精调+模型压缩”,它通常依赖昂贵的标注数据。而【FreeTransfer-X】如图1所示,仅基于【现有的源语言模型】及【无标注数据】,输出【目标语言的模型】。同时我们为了快速适配源语言已有部署环境,要求目标语言模型与源语言模型架构保持完全一致。【FreeTransfer-X】能安全、高效地利用已有的NLP模型及无标注数据。

3.【FreeTransfer-X】的解决方案

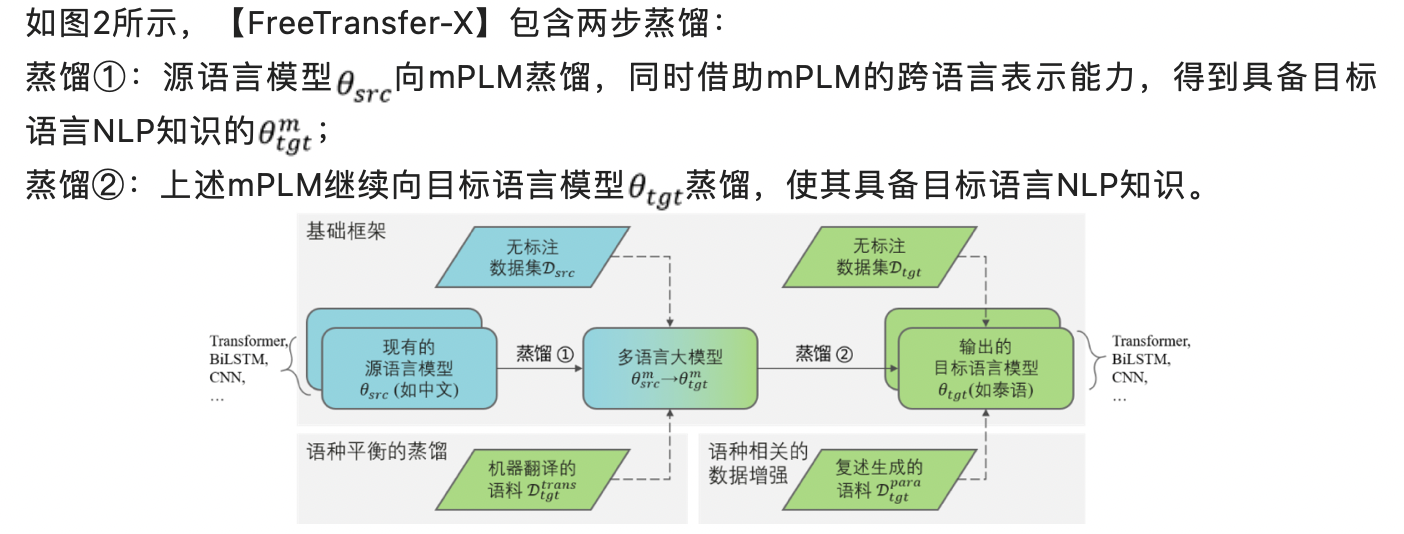

作为【FreeTransfer-X】的实现,本文提出了以【多语言预训练模型】(multilingual Pre-trained Language Model,mPLM)为“桥梁”的跨语言迁移框架,并通过知识蒸馏(Knowledge Distillation, KD [1])技术进行能力的迁移。此外,我们还引入了两种数据增强方法提升迁移性能。

1. 基于mPLM的跨语言知识蒸馏

图2. 总体框架:基于多语言预训练模型、知识蒸馏和数据增强的【FreeTransfer-X】

2. 基于数据增强的知识蒸馏

4.实验及收益

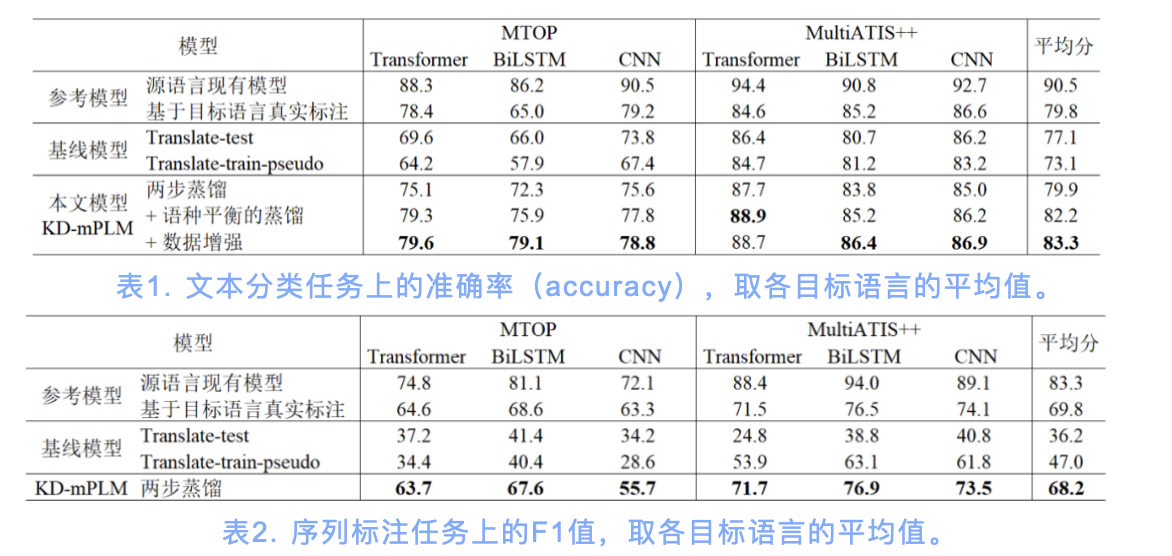

我们分别在MTOP和MultiATIS++数据集的【文本分类】和【序列标注】任务上进行实验,总共覆盖10种来自不同语族的语言。并采用同样无需标注数据的Translate-test [4]和Translate-train-pseudo作为基线。为便于实验和分析,源语言设定为英语(en)。

1.【FreeTransfer-X】性能媲美实际标注

如表1、表2所示,【FreeTransfer-X】在几乎所有数据集、任务、模型结构下均显著优于基线方法。在文本分类任务上(表1),平均优于最佳基线(Translate-test)2.8个百分点,且较Translate-test少一次推理,推理效率更高。在序列标注任务上(表2),平均优于最佳基线(Translate-train-pseudo)21.2个百分点。此外,数据增强进一步提升了【FreeTransfer-X】,使其目标语言性能媲美实际标注数据训练的模型。

2. 【FreeTransfer-X】未来的研究方向

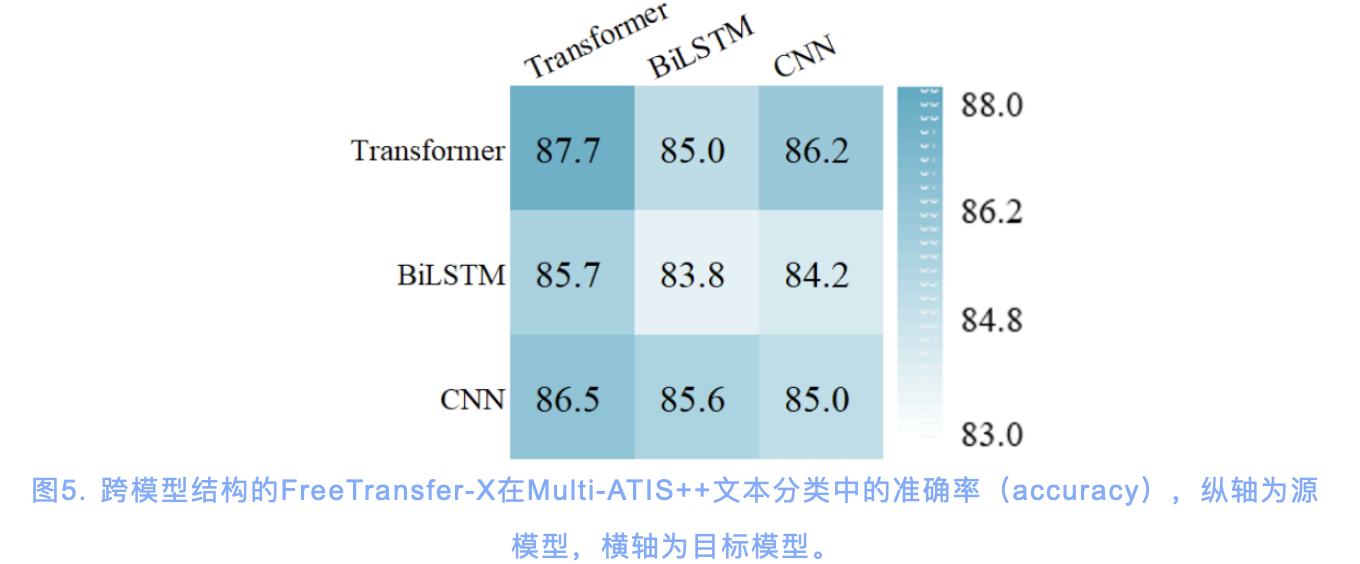

图5. 跨模型结构的FreeTransfer-X在Multi-ATIS++文本分类中的准确率(accuracy),纵轴为源模型,横轴为目标模型。

图5讨论了跨模型结构的【FreeTransfer-X】迁移学习。据图5可知,Transformer作为源模型、目标模型几乎都可达到最佳迁移性能,说明源模型、目标模型与【多语言大模型】具有相似网络有助于蒸馏。未来可以研究如何评价网络相似性,以及如何选取更优的【多语言大模型】作为“桥梁”模型。

3. 成本收益

以使用Amazon Mechanical Turk众包平台进行文本分类和NER两种任务人工标注为例,其标准定价分别为每个样本0.08 / 0.16 RMB(0.012 / 0.024 USD [5]),并有额外40%的平台收费。雇佣5名标注员,为多语言大模型通常覆盖的100种语言各标注1万个样本,则需要约【1,680,000 RMB】。此成本尚未考虑非标准供应商的标注价格可能高于标准定价,以及部分小语种难以寻找标注员、标注成本更高的情况。

若采用【FreeTransfer-X】框架,则可节省此标注成本。并且可以基于【多语言大模型】在不同的应用场景中持续发挥作用。

5.结语

为高效利用AI大模型,并适应新时期中国企业业务出海的迫切需求,本文提出了全新的【多语言大模型】落地范式【FreeTransfer-X】。【FreeTransfer-X】以【多语言大模型】为“桥梁”,无需标注数据,但性能媲美标注数据训练的模型,且能快速适配源语言的部署环境。开启了多语言大模型落地的新范式,较传统跨语言迁移大幅削减成本,极具有实用价值。此外,基于无标注数据和现有模型的跨语言迁移还有巨大研究潜力,我们将持续在此领域探索和突破。

参考文献

[1] Geoffrey Hinton, Oriol Vinyals, and Jeff Dean. 2015. Distilling the knowledge in a neural network.

[2] Alexis Conneau, Kartikay Khandelwal, Naman Goyal,Vishrav Chaudhary, Guillaume Wenzek, Francisco Guzmán, Edouard Grave, Myle Ott, Luke Zettle-moyer, and Veselin Stoyanov. 2020. Unsupervised cross-lingual representation learning at scale. In Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, pages 8440–8451, Online. Association for Computational Linguistics.

[3] Alexis Conneau, Ruty Rinott, Guillaume Lample, Adina Williams, Samuel Bowman, Holger Schwenk, and Veselin Stoyanov. 2018. XNLI: Evaluating crosslingual sentence representations. In Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, pages 2475–2485, Brussels, Belgium. Association for Computational Linguistics.

[4] Yinpeng Guo, Yi Liao, Xin Jiang, Qing Zhang, Yibo Zhang, and Qun Liu. 2019. Zero-shot paraphrase generation with multilingual language models. CoRR, abs/1911.03597.

[5] https://aws.amazon.com/sagema...

【免责声明】

华为在本公众号所载的材料和信息,包括但不限于文本、图片、数据、观点、建议、网页或链接,虽然华为力图在网站平台上提供准确的材料和信息,但华为并不保证这些材料和内容的准确、完整、充分和可靠性,并且明确声明不对这些材料和内容的错误或遗漏承担责任,也不对这些材料和内容作出任何明示或默示的、包括但不限于有关所有权担保、没有侵犯第三方权利、质量和没有计算机病毒的保证。

华为可以在没有任何通知或提示的情况下随时对网站上的内容进行修改,为了得到最新版本的信息,请您定时访问本网站。华为(含其关联公司)在本网站上所提及的非华为产品或服务仅仅是为了提供相关信息,并不构成对这些产品、服务的认可或推荐。华为并不就网址上提供的任何产品、服务或信息做出任何声明、保证或认可,所有销售的产品和服务应受华为的销售合同和条款的约束。

— 完 —

作者:诺亚方舟实验室

文章来源:诺亚实验室

推荐阅读

华为诺亚AI4EDA团队刷新EPFL逻辑综合榜单25/40个世界记录,连续两年排名最前列

【盘古Coder】:高性能函数级程序语言生成模型

三角迁移:助推以中文为中心的机器翻译

更多嵌入式AI相关技术干货请关注深度学习压缩模型论文专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。