液冷技术方面我算不上专业,因为最近在一篇博客中看到不错的资料,这里分享给大家顺便做点讨论。

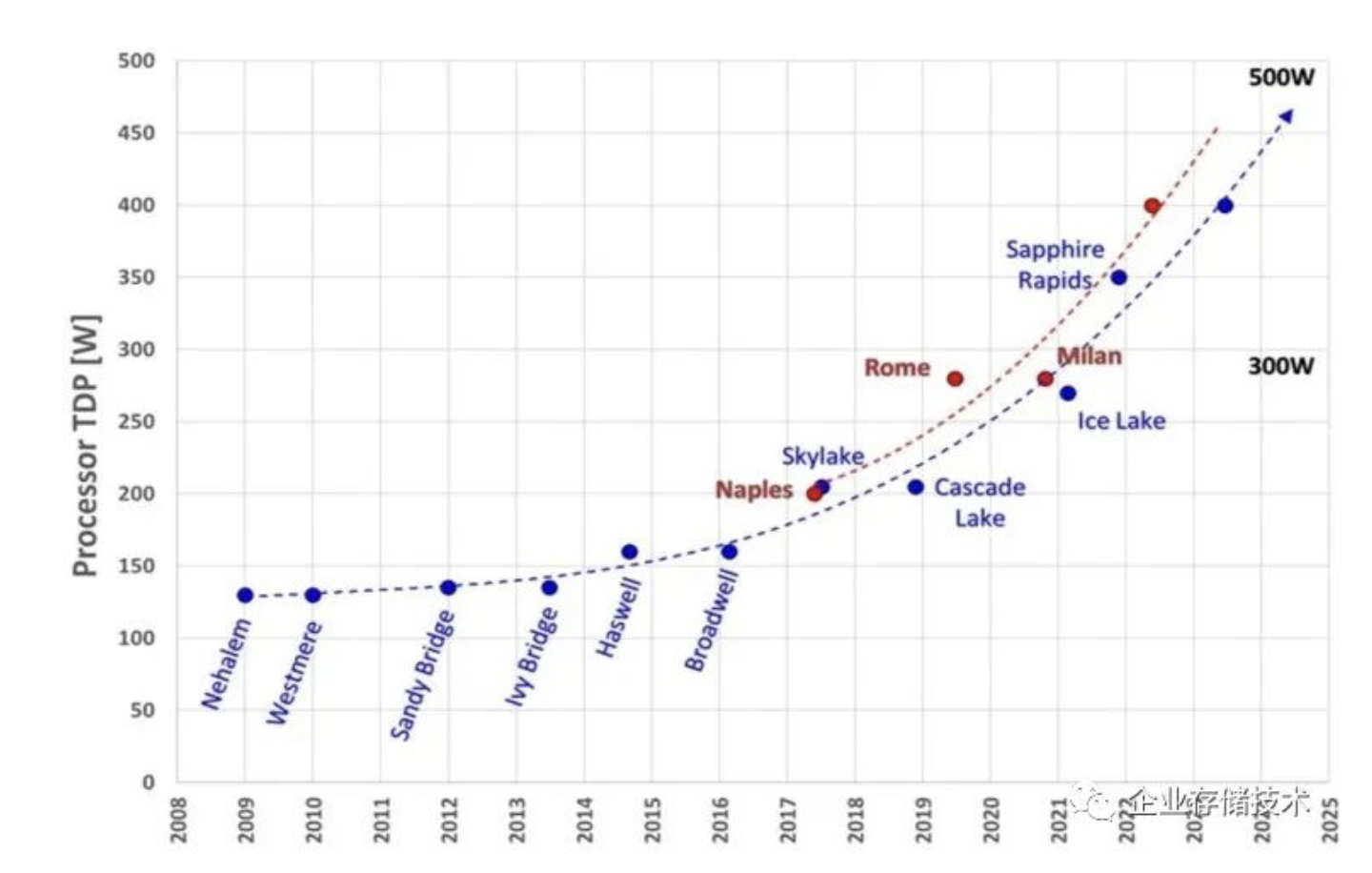

大家应该知道,Intel代号Sapphire Rapids的下一代Xeon处理器最高TDP将达到350W,AMD EPYC4功耗也是同级水平。上图中时间点应该是早些时候标的,众所周知Sapphire Rapids跳票了,所以AMD这一代应该会在前面正式上市。

从风冷350W到冷板式液冷的600W

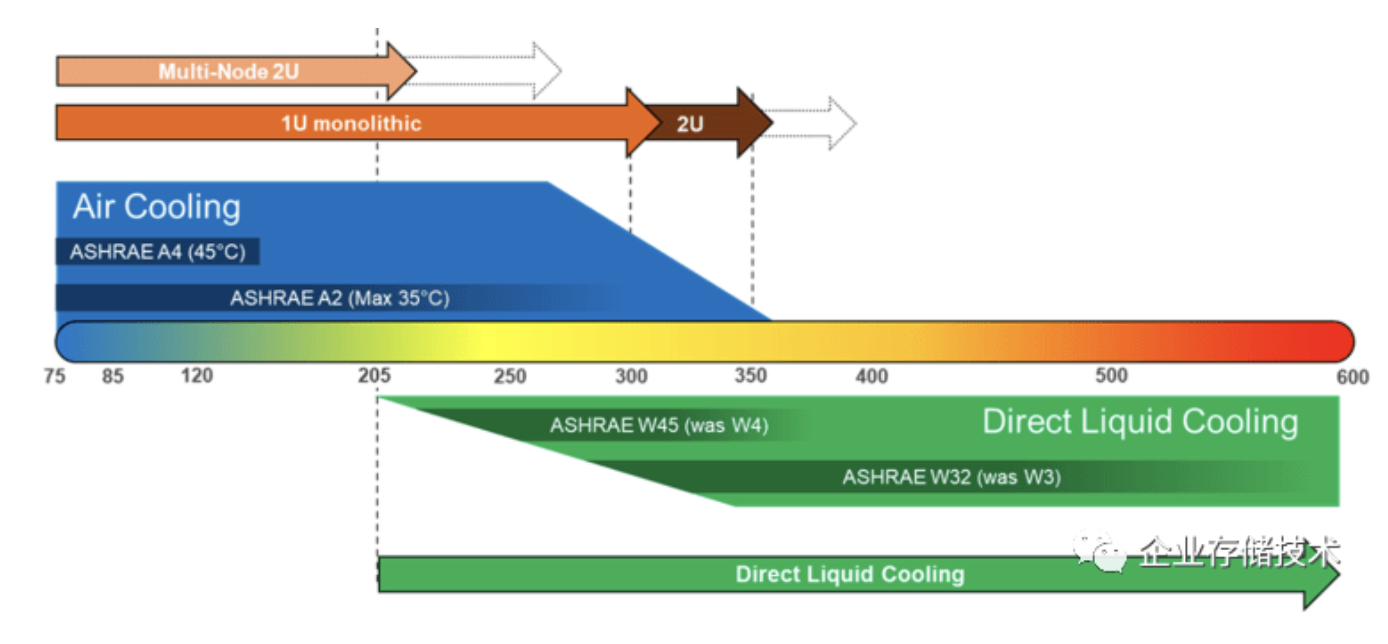

如上图,上半部分的蓝色梯形指的风冷。在ASHRAE A2(最高35℃进风温度)环境下,标准2U风冷服务器可以支持2颗350WTDP CPU,1U通用型服务器大约在300W左右,而定制化服务器甚至1U也能做到350W(因为可以根据客户自身需求做取舍)。如果环境温度放宽到ASHRAE A3(最高45℃进风),相应支持的散热功率也会降低。另外就是像2U 4节点这样的高密度机型,风冷的瓶颈会更明显,这也是HPC高性能计算用户更早青睐液冷的原因。

扩展阅读《1U双路风冷350W?点评方升服务器散热设计》

《冷板式液冷标准化:PowerEdge 15G服务器散热杂谈》

再看功耗轴下面的绿色部分,也就是冷板式液冷(Direct Liquid Cooling),支持600W以内的CPU应该问题不大。当然这里还有一个冷却液温度的区别,比如ASHRAE W32(应该指液体注入时的温度为32℃)的表现就要比ASHRAE W45更好,后者的散热能力看来还超不过400W。

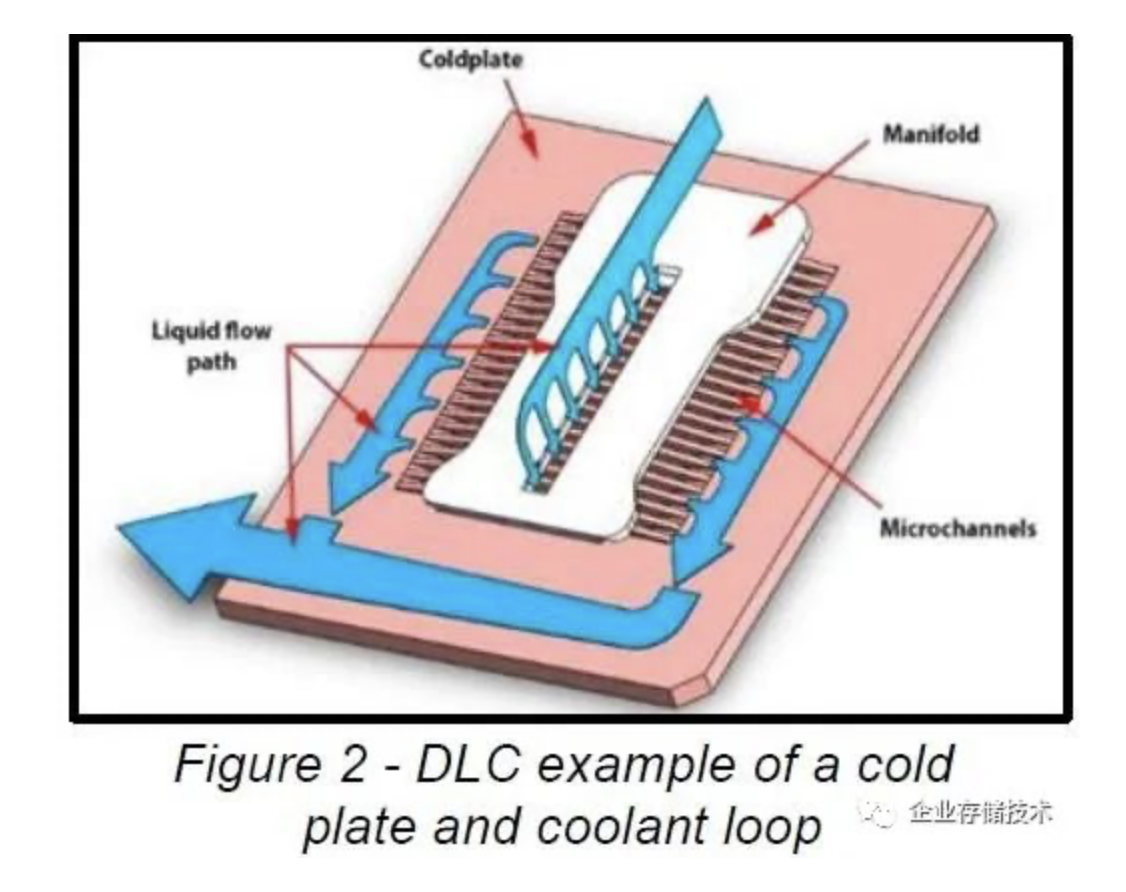

冷板式液冷的特点如上图,我就不在此展开了。

这是比较先进的DLC液冷结构示意图。包括冷板、微通道、冷却液流动的路径等。现在的冷板式液冷技术距离5-10年前应该有些改进,也包括漏液检测方面。

冷板和浸没式液冷,哪个支持功率密度更高?

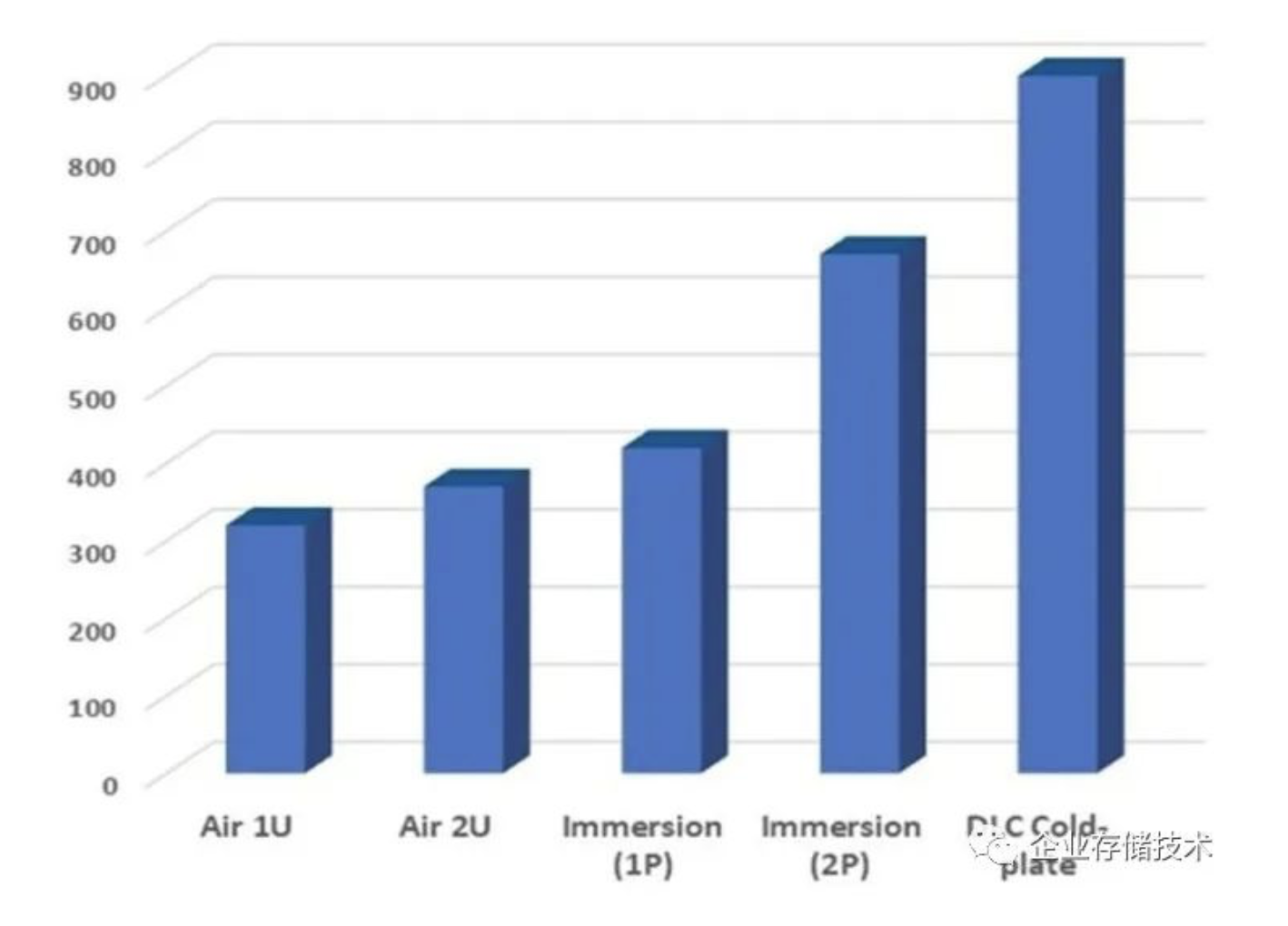

上图仅供参考。纵坐标是CPU/GPU等发热大户的功耗,Immersion 1P(单相浸没式液冷)可以支持到400W;2P(双相浸没式液冷)可达更高的650W;而DLC冷板能力最强——接近900W了。

根据我以前有限的认识,浸没式液冷可以实现更低的PUE,也就是用于散热产生的额外能耗较小,虽然成本较高、对数据中心设计改动更大,但密度支持上真的不如冷板式液冷吗?

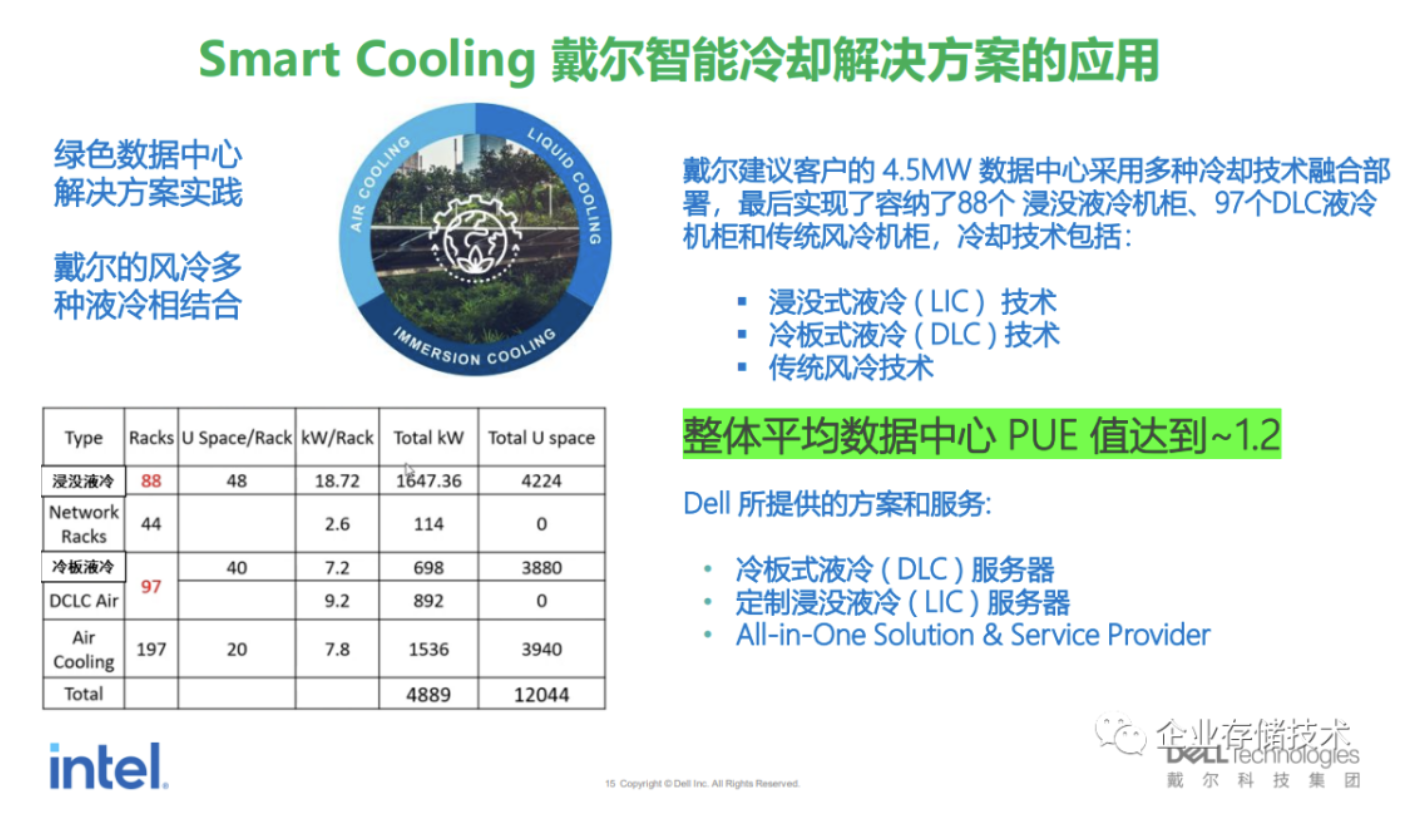

这张图来自网上找到的资料,在一套采用多种冷却技术的4.5MW数据中心融合部署中,冷板液冷的每机架利用密度为40U/Rack,浸没液冷应该是利用定制机柜达到48U。每机架的功率密度,冷板液冷的7.2kW并没有看出比风冷散热的明显优势?而浸没液冷则高达18.72kW/Rack。

但我们不能只看密度,因为如果只是在当前的风冷服务器上把CPU散热器更换为冷板式液冷,确实不见得能提高部署密度,而还有PUE的改善(因为风扇方面的耗电、成本减少)。如果要提高计算密度,一个是等CPU功耗上升,另一个就是设计高密度的系统。

OCP OAI SYSTEM液冷设计:支持8个1000W OAM模块

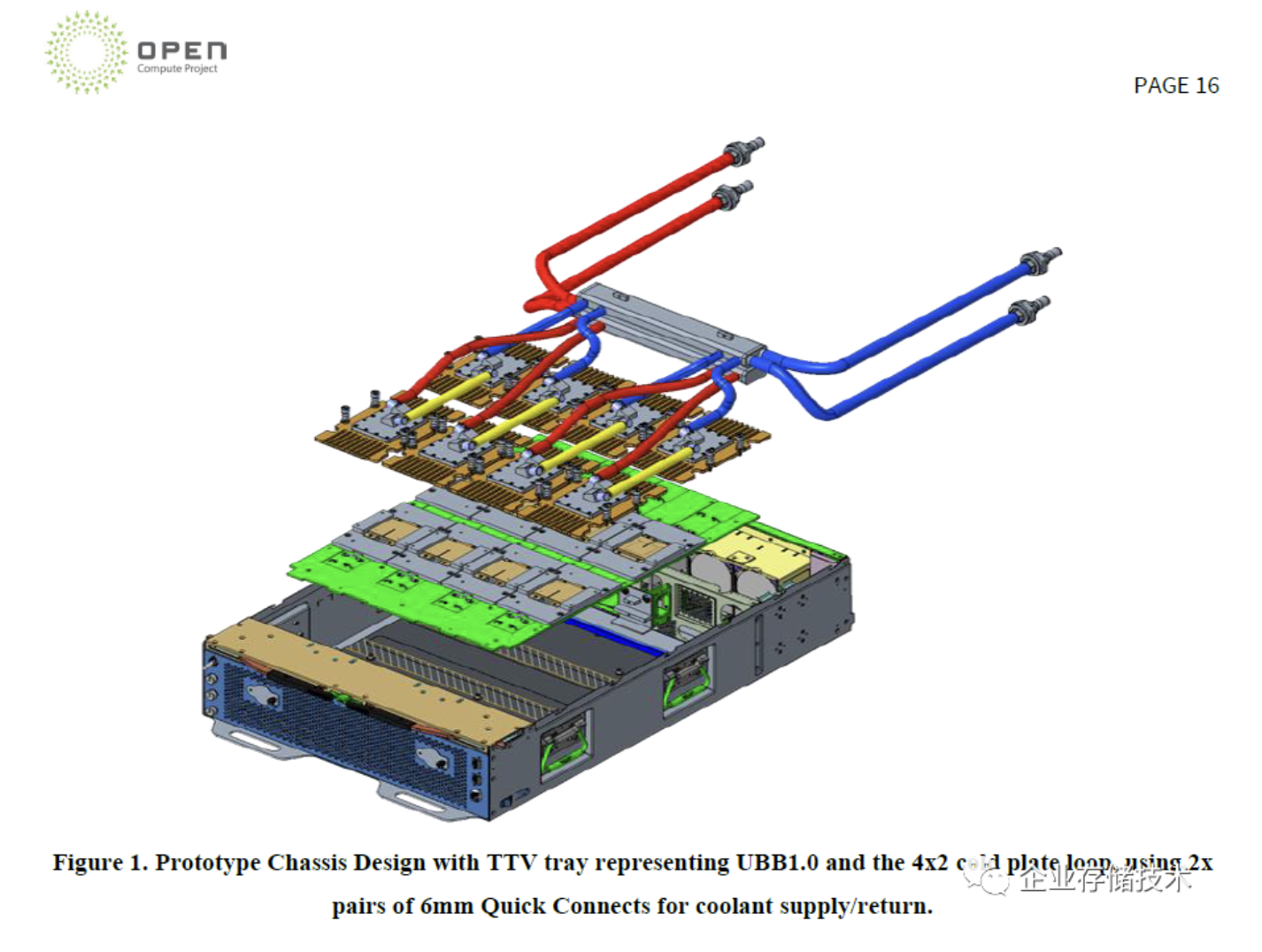

上图引用自《OCP OAI SYSTEM LIQUID COOLING GUIDELINES》,这个结构上接近2U 8xGPU的扩展机箱,从冷热水管不难看出,该原型机箱采用了冷板式液冷设计。

在3年前的《后IB时代的GPU服务器:48V和液冷哪个先行?》中,我曾经引用当时OCP OAM的资料,风冷最高支持440W的计算模块。有朋友可能会问:今天GeForce RTX 4090显卡不是已经用风冷散热器做到450W了吗?别忘了它那个散热器的尺寸,数据中心可是要高密度部署的。

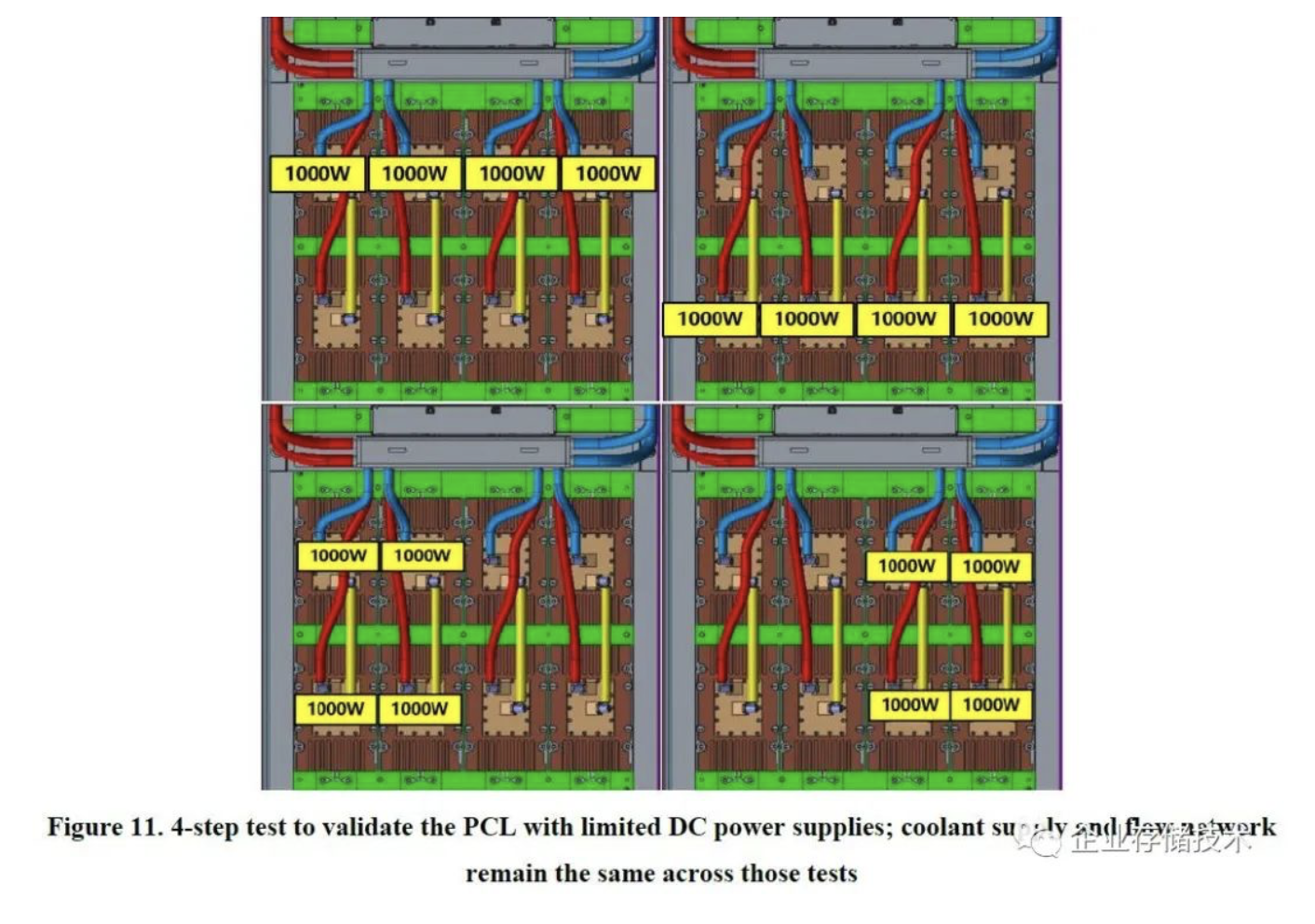

我们知道目前NVIDIAH100的功耗为700W(扩展阅读:《NVIDIA H100 GPU架构白皮书:2倍功耗SMX只比PCIe 5计算卡快25%》),如今OCP OAI系统设计的散热支持已经达到8个1000W SMX模块。下面我们看一下原型机的温度测试结果:

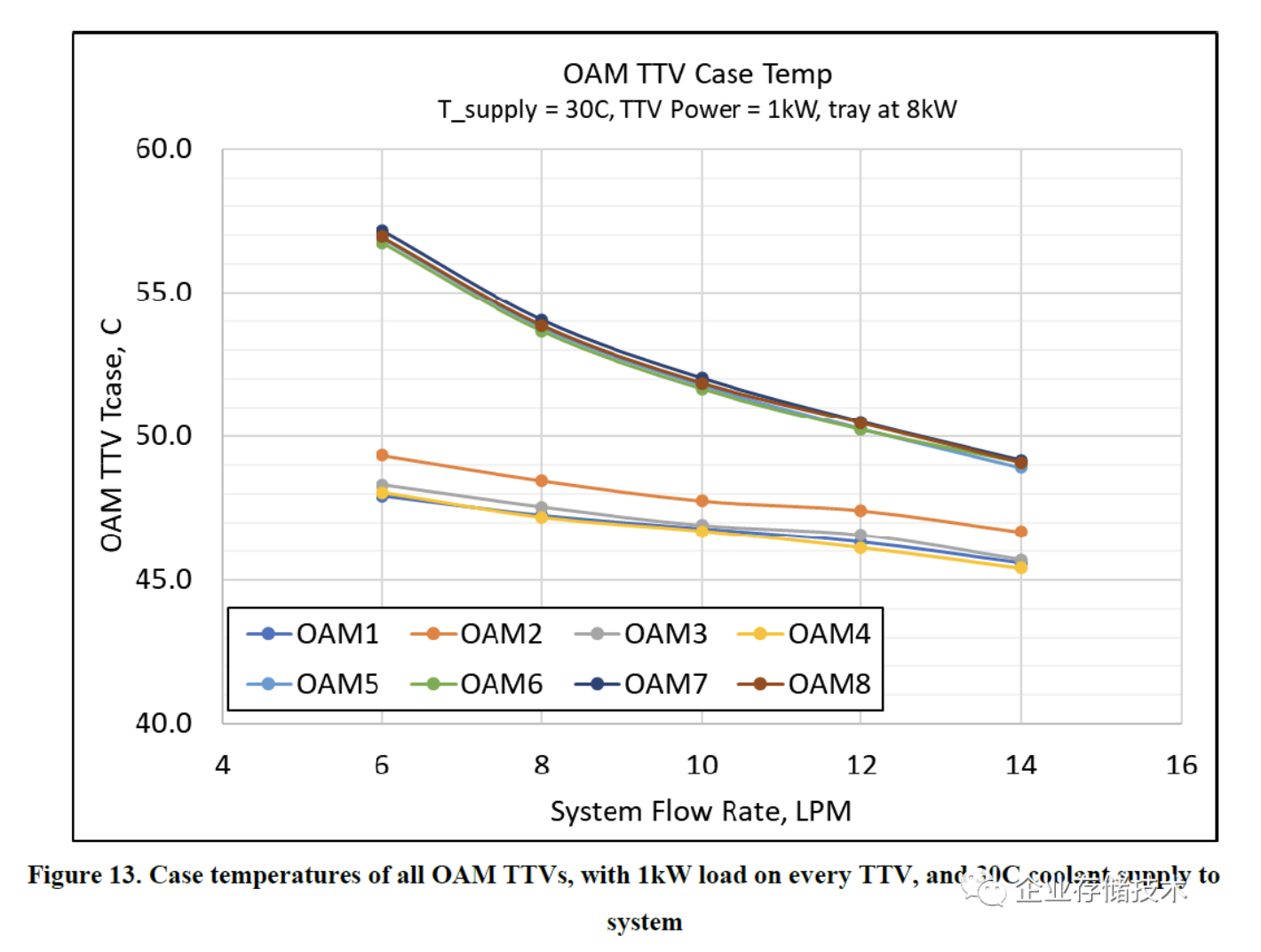

图表纵坐标是OAM(GPU等)的TTV Tcase温度,横坐标则是系统流速(冷却液的LPM)。当供应给系统的冷却液为30℃时,我们看到OAM 1-4的温度在45-50℃之间,而OAM 5-8在液体流速低时超过了55℃。如果有朋友还没理解,请看下图中的2种设计:

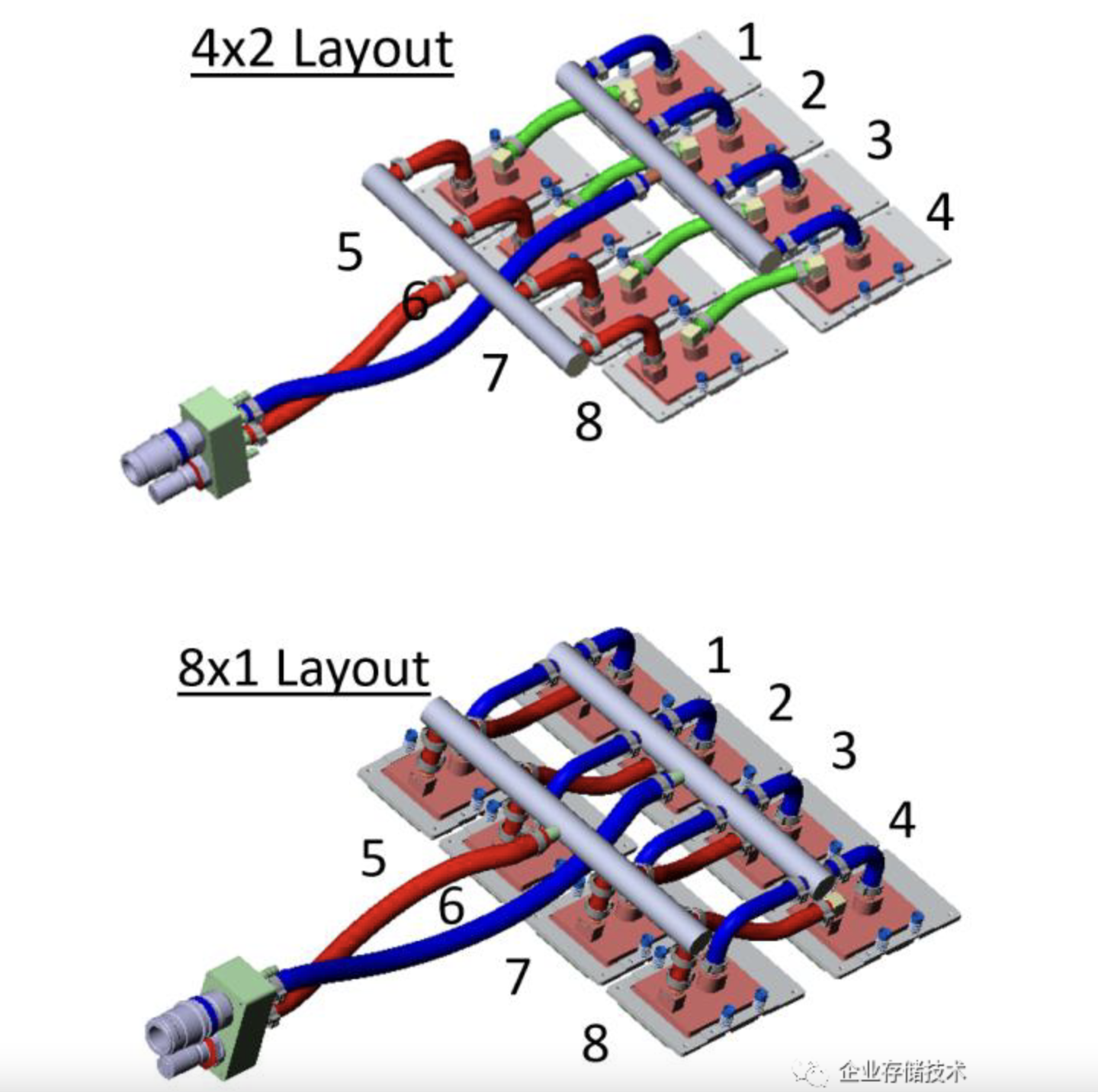

我们上面介绍的OAI系统采用了4x2冷板(即水管)回路,蓝色即低温液体先流入OAM 1-4上面的冷板,(吸热升温一些)然后再流经OAM 5-8的冷板。这就像风冷散热中一排气流先后经过2个CPU的散热片。

相比之下,8x1冷板回路Layout则将低温液体直接平均分配到8个OAM,这样不会有一半OAM温度偏高的问题,但包括水管在内的成本应该也会高一些。

看这个2U机箱8000W的设计,我想冷板式液冷短时间内应该不会遇到瓶颈。至于国内外对浸没式液冷的态度有些不同,听说有PUE政策方面的原因。技术上没有十全十美的,我个人短期内还是看好冷板的普及;浸没式是个双刃剑,具体的我不够权威,就不在这里讨论更多了…

作者: 唐僧 huangliang

原文:企业存储技术

推荐阅读

- RAID 5写带宽11.7GB/s:当SAS 24G阵列卡嵌入PCIe Switch

- 读IOPS 640万、写110万:24G SAS/NVMe RAID卡性能谜团

- FMS 2022闪存峰会演讲资料(完整版)

欢迎关注企业存储技术极术专栏, 欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。