本文全名Searching for Network Width with Bilaterally Coupled Network, 简称BCNetV2,目前已发表在人工智能领域顶刊 IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI),影响因子 24.3。其前序工作为 BCNet: Searching for Network Width with Bilaterally Coupled Network,简称BCNetV1,该论文已发表在人工智能顶会 CVPR 2021。目前BCNetV2 和BCNetV1 均已开源。

BCNetV2 文章:https://ieeexplore.ieee.org/document/9970301

BCNetV1 文章:

BCNetV2 和 BCNetV1的代码:https://github.com/xiusu/BCNetV2

导读

当今世界,人工智能领域迅速发展,AI在各应用领域中均迅速突破。然而,针对不同的应用领域和AI模型,如何从近乎无穷的可能性中,找出最适合任务需求的模型,是一个极其困难的问题。为了解决这个问题,BCNetV2 提供了一种极其有效的思路,以建模一个公平涵盖所有可能AI模型的超网络数学模型。为了促进所有AI结构在超网络中都能得到公平的训练和对比,本文通过概率期望数学模型来表征超网络中不同权重的训练状态,以及它们与整个搜索空间中模型的对应关系。同时为了更准确的搜索优质AI模型,我们提出网络结构搭建的最小模型准则,并依据该准则完善数学模型,使得无论是超网络中的AI模型权重抑或是所有可能的搜索模型都能得到公平的训练和对待。本文方法在拥有128万张图片的ImageNet数据集和CIFAR10数据集以及众多不同的模型架构基础上得到了广泛的验证,在这些方法中均取得了顶级效果。该项工作由悉尼大学和商汤研究团队共同完成。

动机和背景

为了从海量的结构中搜索到最合适的网络模型,我们往往需要借助神经网络结构搜索和超网络结构设计的知识。基于一个预设的超网络数学模型,我们可以以此评价所有可能的人工智能网络模型的优劣。然而,如何准确评价不同AI模型的相互关系,并借以单一超网络结构实现不同模型的性能排序,是一个极其复杂的问题。为了解决这个问题,我们提出了双向耦合公平的数学模型。以使得超网络中的每一个参数和超网络对应的每一个模型,都能获得公平的对待。从而使得所有AI模型之间形成正确的排序关系,借以挑选出适合任务需求的最佳AI模型结构。

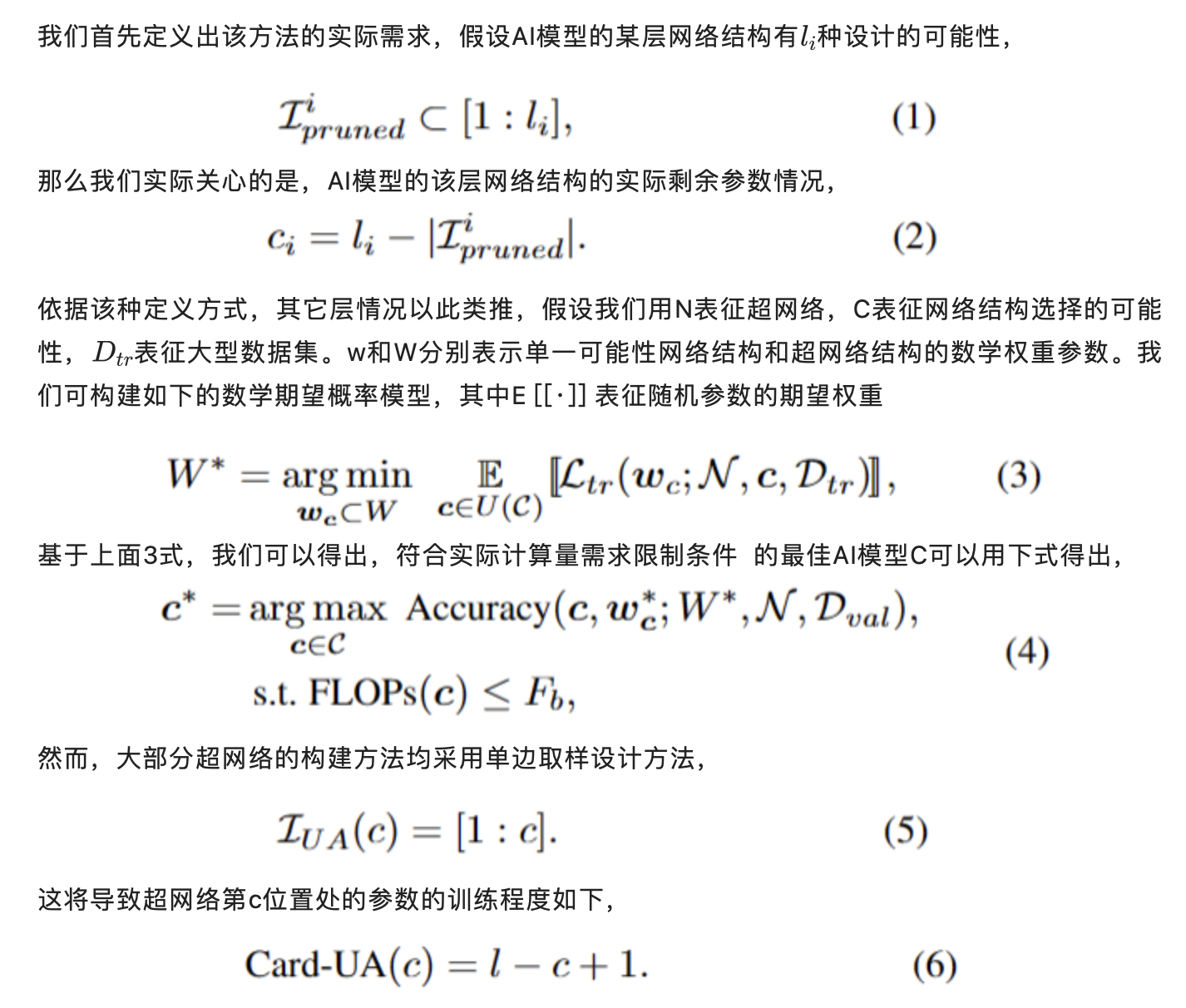

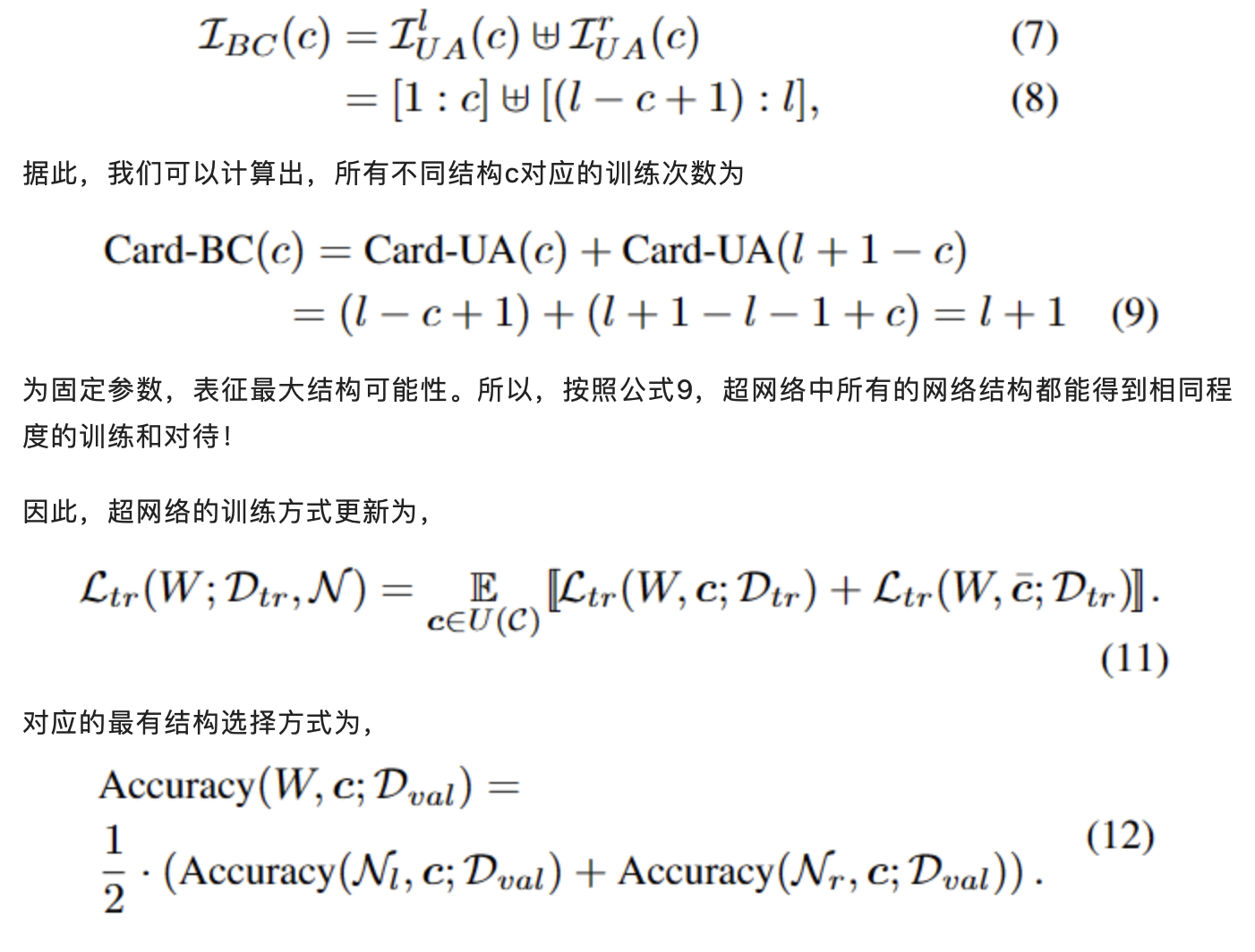

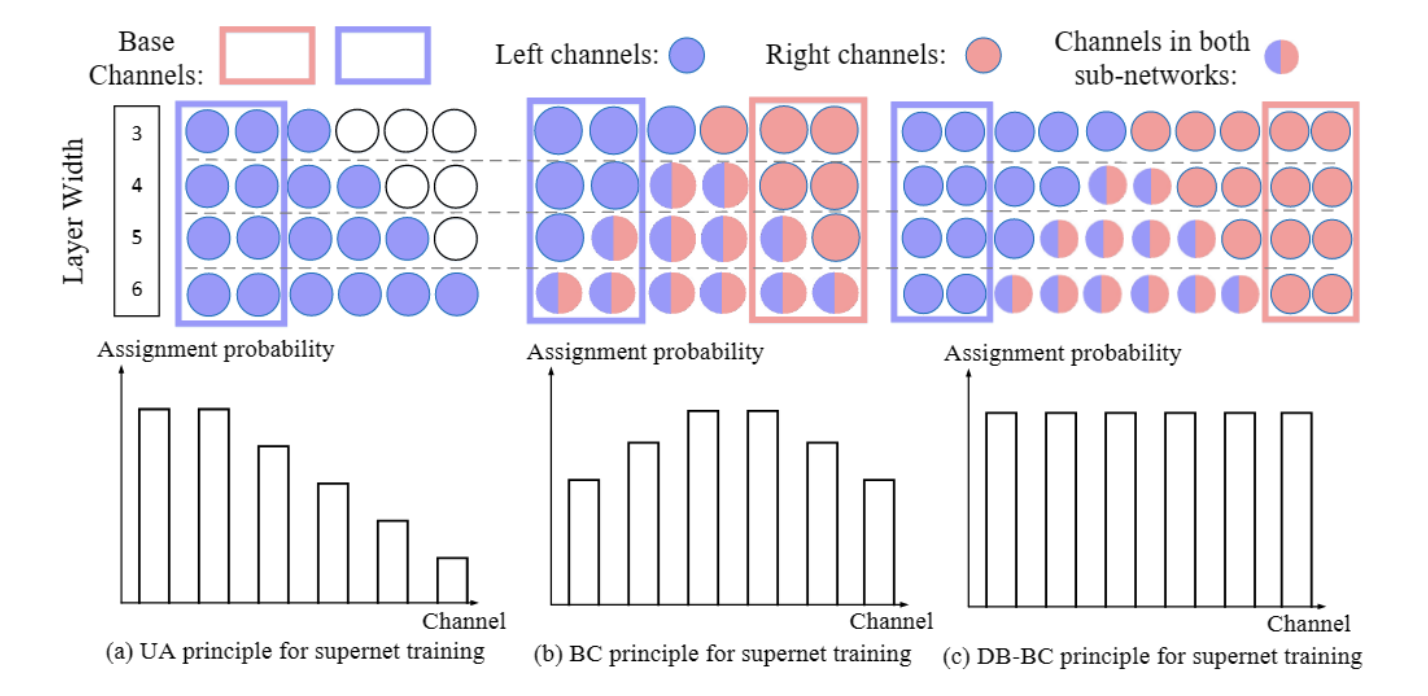

BCNet公平训练思路和数学模型:

因为 是可变变量,从而使得,超网络中各参数训练程度严重不同,无法公平衡量所有可能的网络结构!

为了解决这个问题,本文BCNetV2提出任一可能的网络结构,对应分别来自超网络左右两端的网络权重,通过合并超网络中的2个网络的损失函数,共同表征单一网络结构。由此可知,结构c在超网络中对应的权重为

优化遗传算法搜索途径:

为了能尽可能找到最佳AI网络模型,我们可选的网络模型结构数量往往超过个。浩瀚如繁星般的可能性,让我们无法通过设计出的超网络结构,一一验证所有模型的好坏。

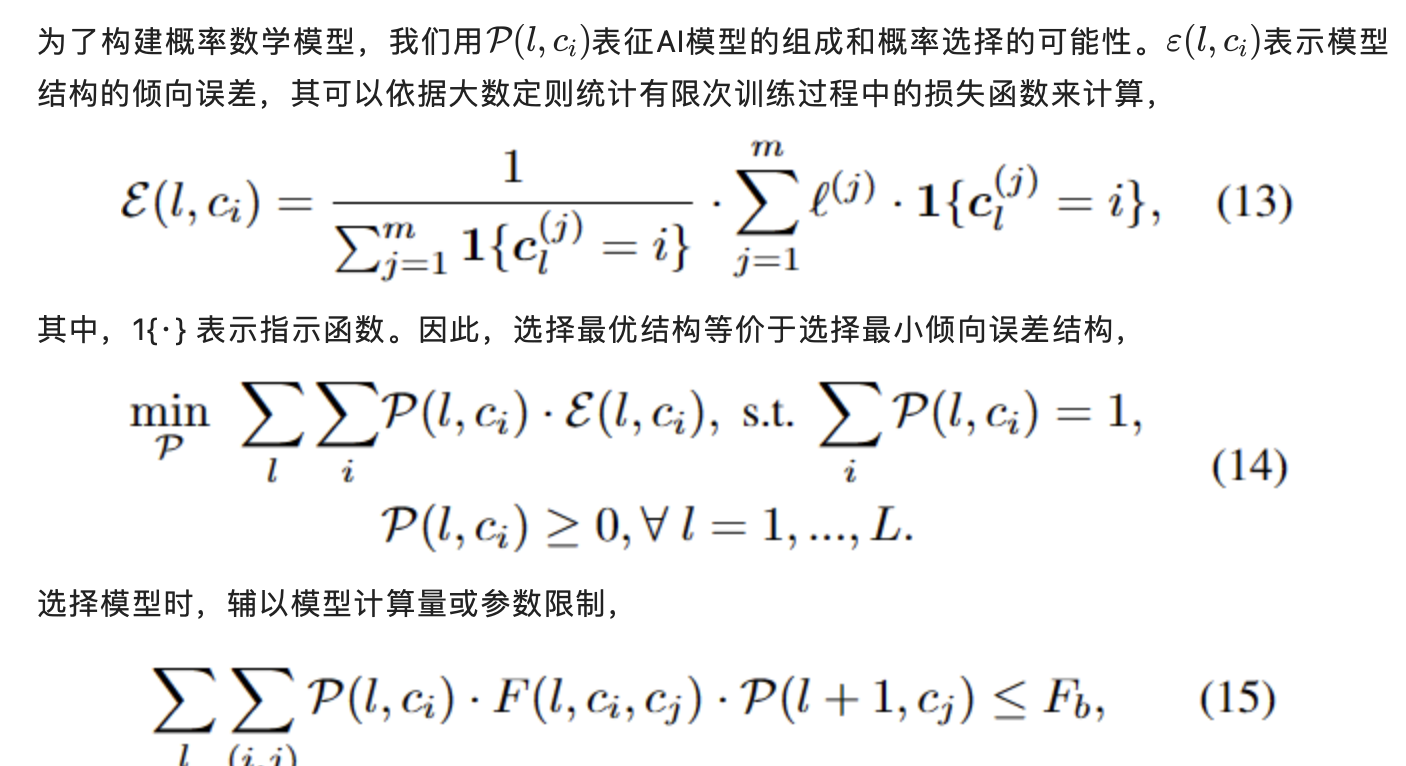

因此,本文提出通过遗传算法,选出相对任务需求最优的AI 模型。遗传算法十分依赖于初始解的选取,相比于传统方法随机构造初始解的思路。BCNetV2 采用了超网络训练过程中的损失函数作为评判网络结构性能的依据,显而易见的是,我们可以通过低网络损失的条件选择出优于随机组成的网络结构。

更进一步的,我们可以原子化网络结构,依据大数定则,在多数网络结构中表现较优的参数更可能组成有效的新AI网络结构。因此,我们可以通过训练过程中的有限次尝试,来揣测近乎无限的AI网络结构的可能性。

结合公式13, 14, 15。我们可以发现本问题变成典型的二次约束二次规划(QCQP)数学问题,可以简单通过众多数学工具求解。因此,我们通过上述数学过程,很容易的从有限尝试中推测出无限的结构可能性,并将其表征为QCQP问题。

BCNetV2 更进一步的超网络突破!

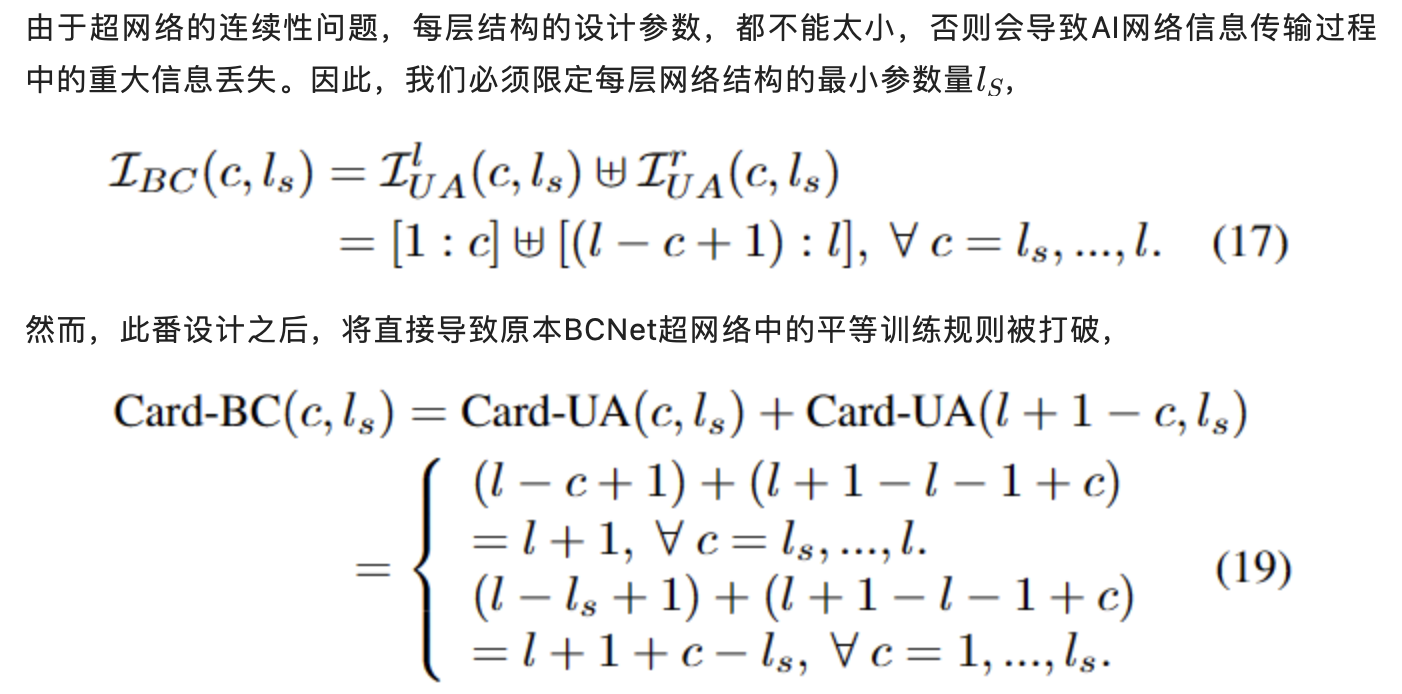

如公式19,超网络中不同参数训练程度将会出现差异。

为了解决这个问题,我们提出增广的BCNetV2 超网络模型,通过额外扩充一定程度不共有的双边网络参数,来解决上述问题,如下图 (c) 所示

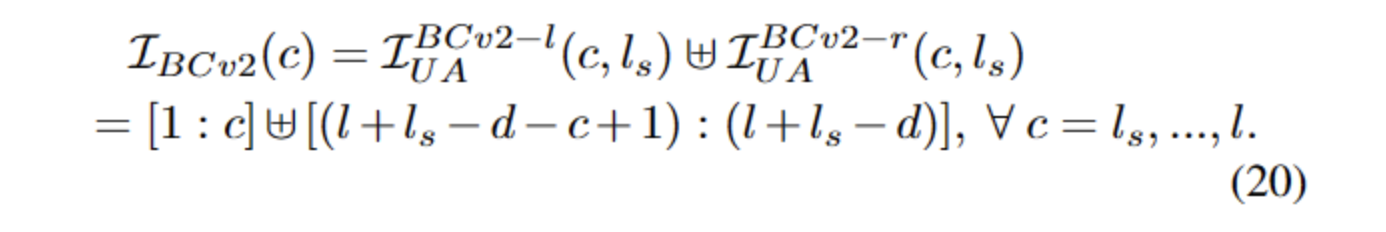

因此,超网络与可选网络结构的对应方式更新为下式所示,

在此情况下,不同参数的训练程度为,

从而,所有参数在有最小参数量限制的情况下,仍能得到公平训练,所有结构理论上得到相同的训练程度。

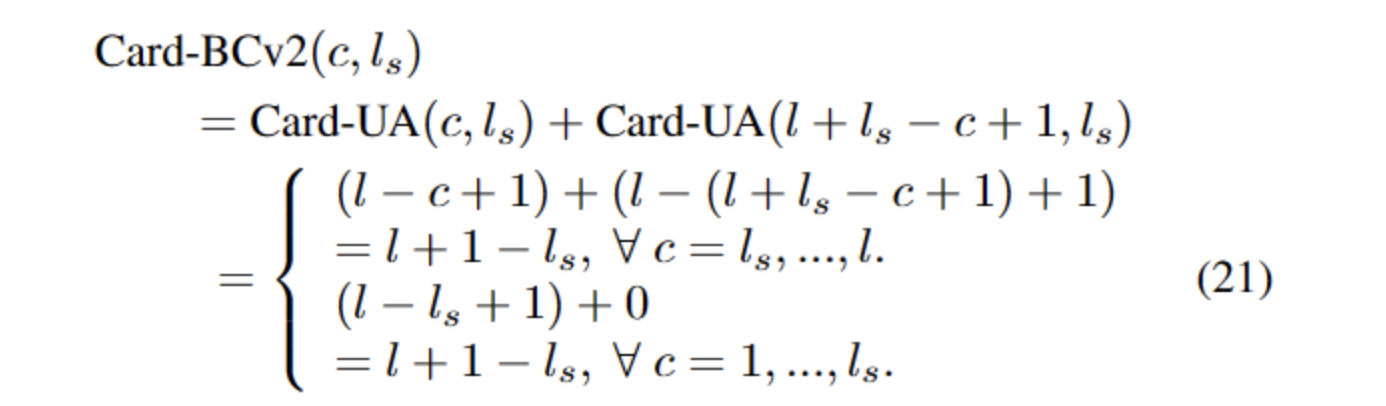

实验与验证

本文在多种不同数据集和模型设计的情况下,均验证了算法具有 state-of-the-art的效果,部分实验结果展示如下。ImageNet数据集:

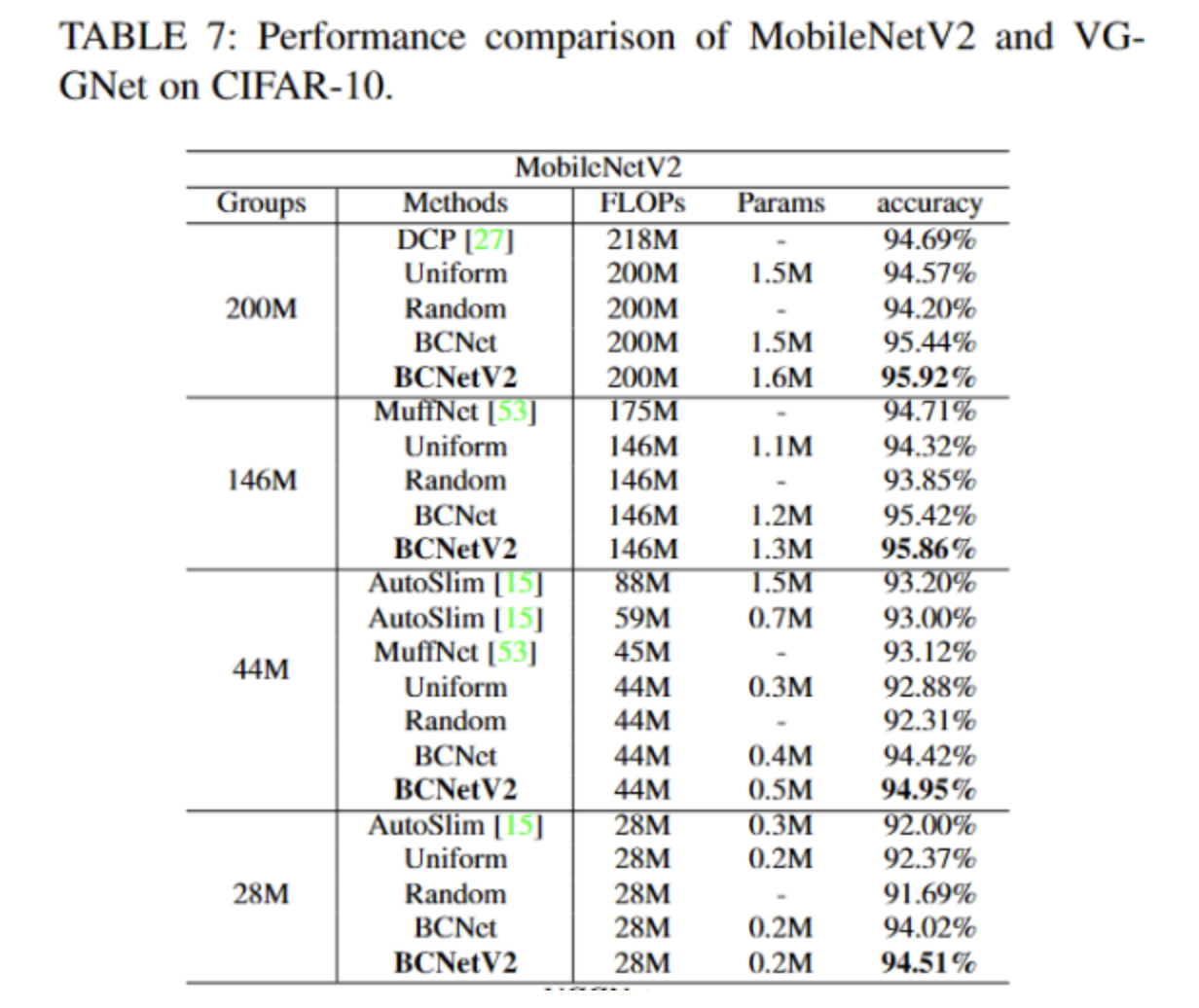

CIFAR-10数据集:

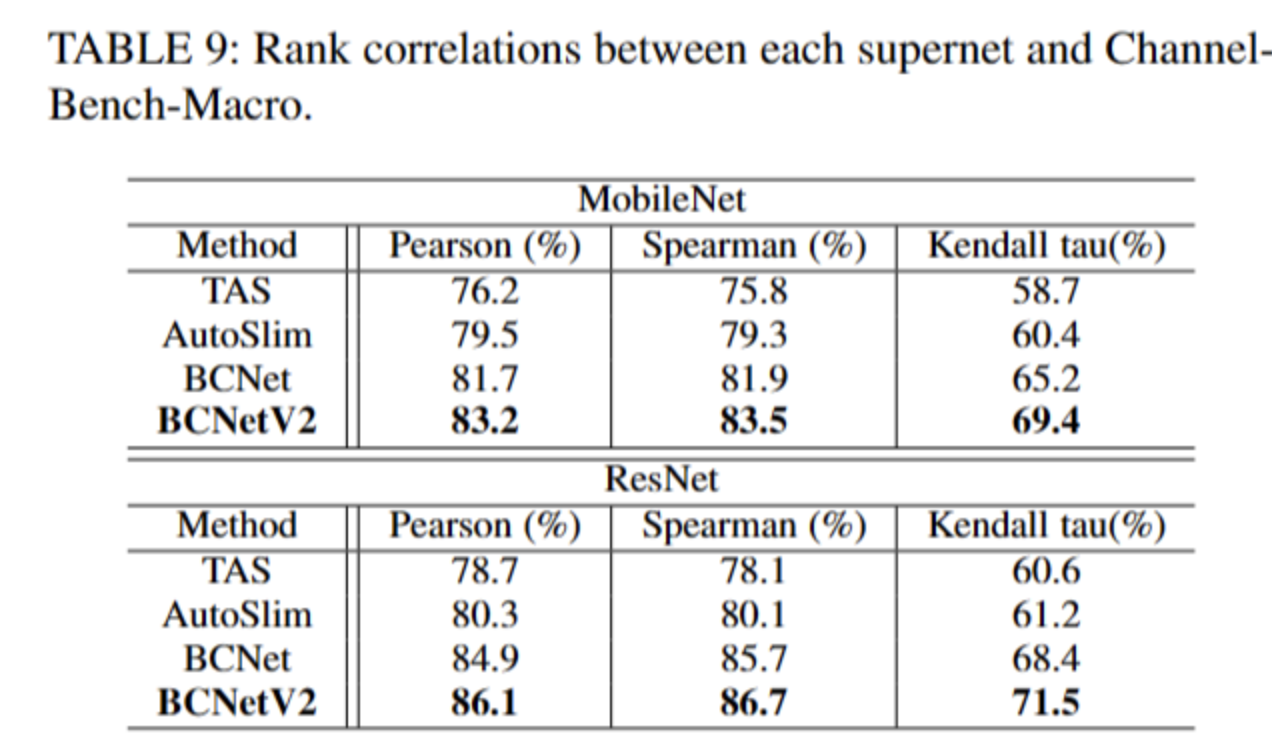

Channel-Bench-Marco:

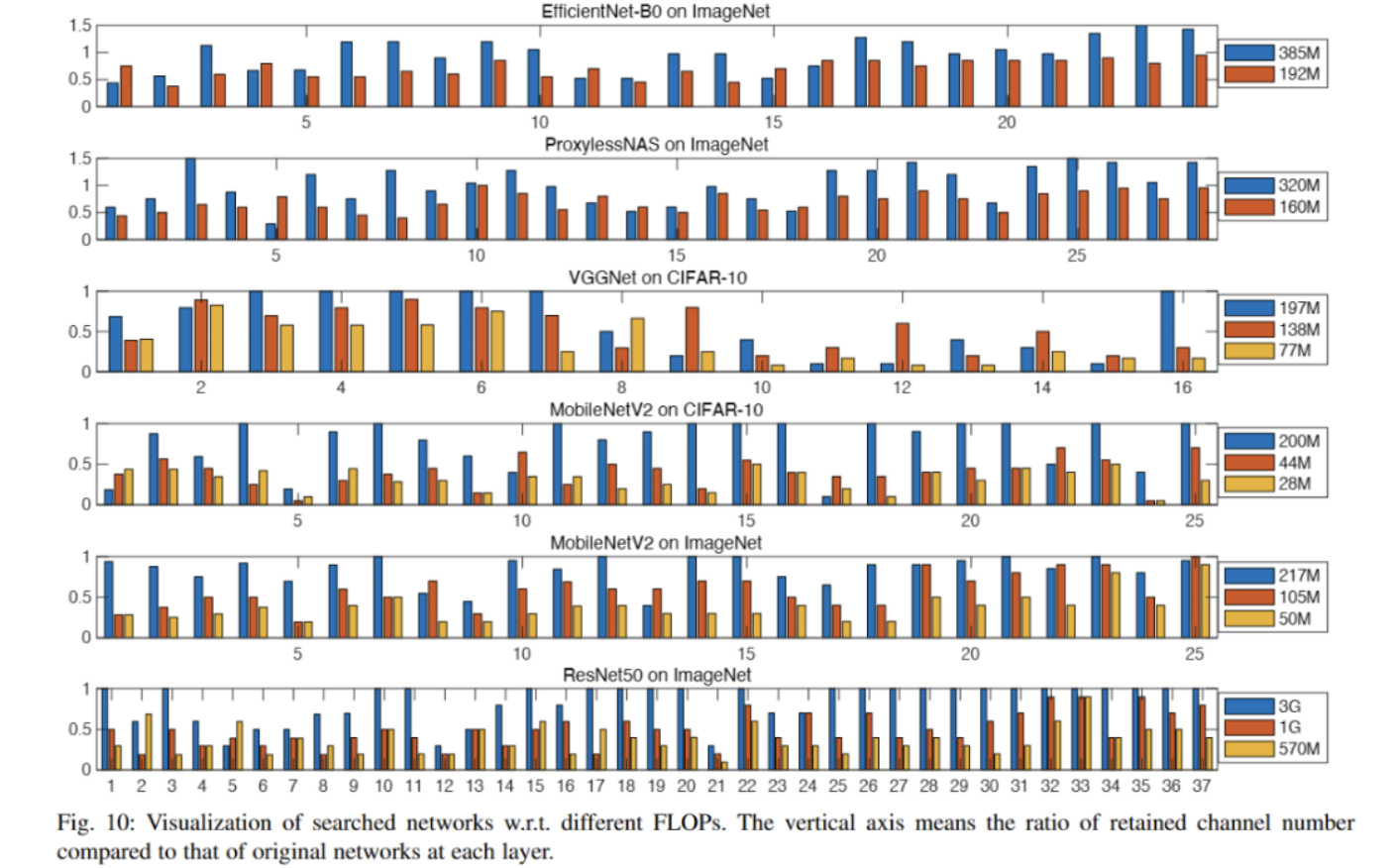

不同数据集和不同模型结构基础上,通过本文方法获得的最佳AI模型的可视化:

由于篇幅限制,更多实验,文章的思路和公式请查阅TPAMI BCNetV2原文,谢谢。

作者介绍

论文一作苏修,目前在悉尼大学攻读人工智能方向博士,主要从事AutoML领域中模型压缩和神经网络结构搜索,Transformer结构设计,Detection,小样本学习,模型鲁棒性设计等方向的研究,在TPAMI、CVPR、ECCV,NIPs,ICLR、ICML,KDD,AAAI等国际顶级期刊会议上发表十几篇paper。担任多个top-tier会议或期刊审稿人。主页:https://xiusu.github.io

论文二作游山,北京大学人工智能方向博士,现为商汤科技高级研究员,主要研究方向为自动化机器学习、模型轻量化、无监督半监督学习以及在计算机视觉中的应用与落地,目前发表20余篇包括NeurIPS、ICML、ICLR、CVPR、KDD、AAAI、IJCAI在内的国际顶会paper,担任多个top-tier会议或期刊审稿人。主页:http://shanyou92.github.io/

论文三作谢吉洋,北京邮电大学信息与通信工程专业博士,现为华为研究员,主要研究方向为深度学习、计算机视觉、贝叶斯学习等,在TPAMI、TIP、TNNLS、ECCV等国际会议期刊发表多篇论文,担任多个top-tier会议或期刊的审稿人。

来源:AIWalker

作者: 苏修

推荐阅读

- 强烈推荐:IQA在图像处理中应用

- HDRUNet | 深圳先进院董超团队提出带降噪与反量化功能的单帧HDR重建算法

- DAMO-YOLO | 超越所有YOLO,魔搭社区开源至强YOLO,5行代码即可体验!

- 超简Transformer风格ConvNet,比ConvNeXt还秀,媲美VAN

- 端侧高效骨干RepGhost | 重参数赋能GhostNet,达成端侧超高效骨干

本文章著作权归作者所有,任何形式的转载都请注明出处。更多动态滤波,图像质量,超分辨相关请关注我的专栏AIWalker。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。