出品人:Towhee 技术团队 张晨、顾梦佳

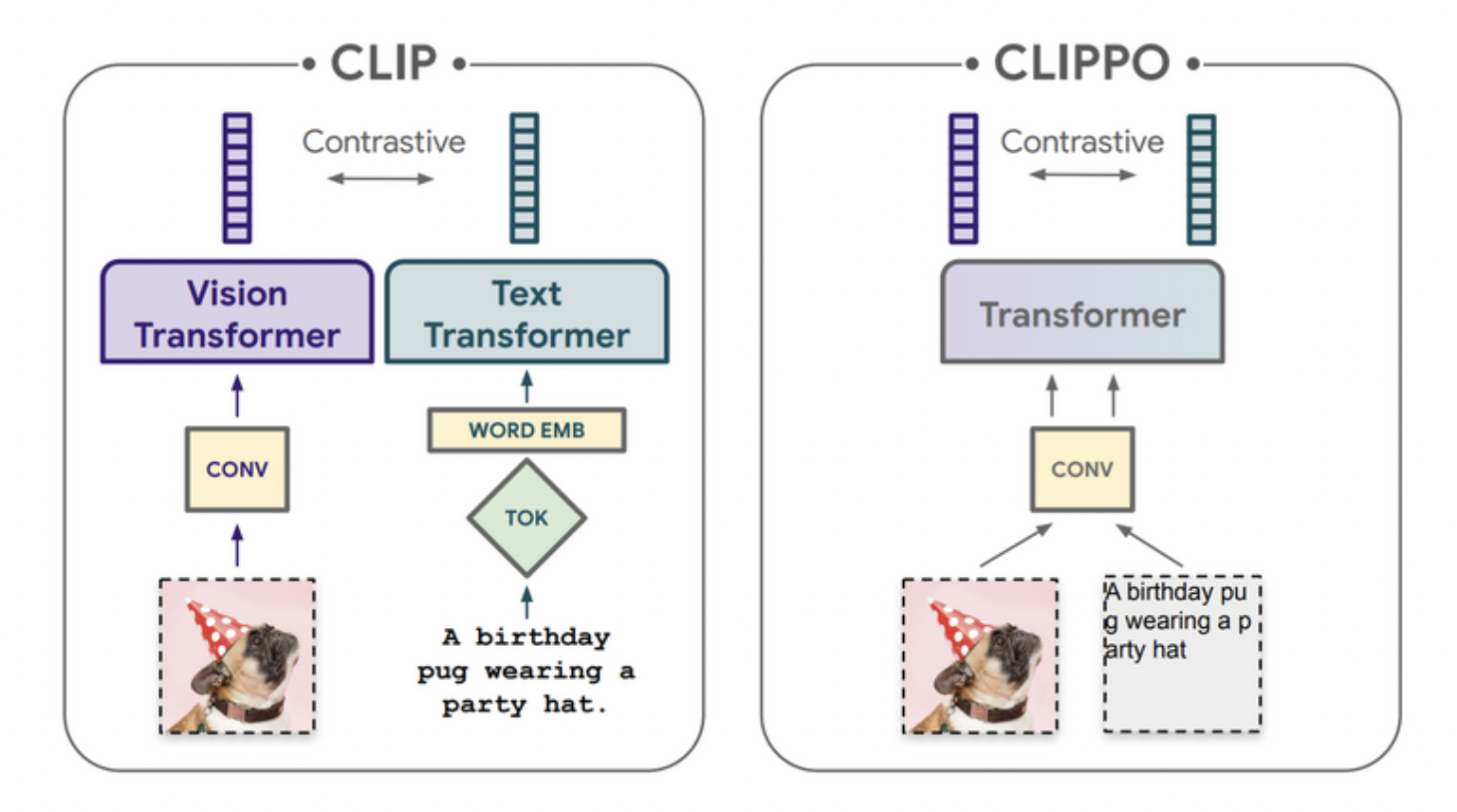

多模态模型变得越来越有效,部分原因在于统一的组件,例如 Transformer 架构。 然而,多模态模型仍然经常包含许多特定于任务和模态的部分和训练过程。 例如,CLIP 通过对比损失训练独立的文本和图像塔。 CLIPPO 选择使用对比损失进行训练,尝试使用纯像素模型来执行图像、文本和多模式任务。 CLIPPO 执行基于图像的任务,例如检索和 zero-shot图像分类,几乎与 CLIP 一样好,参数数量只有一半,并且没有文本特定的塔或嵌入。 当通过图像-文本对比学习和下一句对比学习联合训练时,CLIPPO 可以在自然语言理解任务上表现出色,没有任何词级损失(语言建模或掩码语言建模),优于基于像素的先前工作。 令人惊讶的是,CLIPPO 只需将问题和图像一起渲染,就可以在视觉问答中获得很好的准确性。 由于 CLIPPO 不需要tokenizer,它可以在不修改的情况下在多语言多模态检索上实现强大的性能。

CLIP vs. CLIPPOCLIP 在具有对比目标的图像/替代文本对上训练单独的图像和文本编码器,每个编码器都具有特定于模态的预处理和嵌入。 而 CLIPPO 使用单个编码器来处理常规图像和渲染为图像的文本。CLIPPO 通过将替代文本渲染为图像,使用共享视觉编码器(在两个独立的前向传递中)对生成的图像对进行编码,并应用与 CLIP 相同的训练目标,来训练具有同等能力的纯像素模型。

相关资料:

代码地址: https://github.com/google-research/big_vision

论文链接:Image-and-Language Understanding from Pixels Only