开源代码: https://github.com/megvii-research/OccDepth

论文链接:https://arxiv.org/abs/2302.13540

一、背景

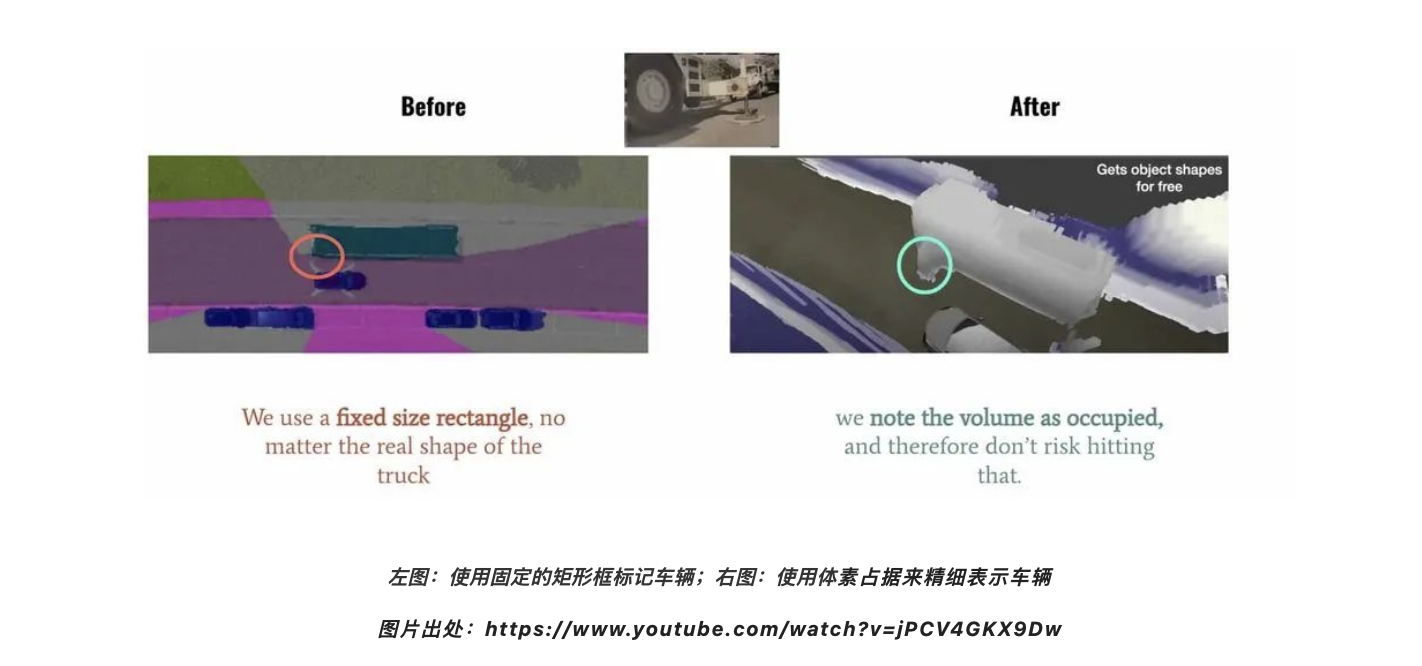

在 2022 年的 Tesla AI Day 上, Tesla 将 Bev(鸟瞰图) 感知进⼀步升级,提出了基于 Occupancy Network 的感知⽅法。这种基于 Occupancy Grid Mapping 的表示⽅法,⼜叫体素(Voxel)占据,在 3D 重建任务中已经是一个“老熟人”了。它将世界划分成为⼀系列 3D ⽹格单元,然后定义哪个单元被占⽤,哪个单元是空闲的,并且每个占据单元同时也包含分类信息,⽐如路⾯、⻋辆、建筑物、树⽊等。在⾃动驾驶感知中,相⽐普通的 3D 检测⽅法,这种基于体素的表示可以帮助预测更精细的异形物体。如下图 Tesla Demo 中所展示的那样,对于空间感知更精细。

在这种在线重建的⽅法中,⼀般使⽤ SSC ( Semantic Scene Completion)任务评判预测的准确性,即利⽤图像、点云或者其他 3D 数据作为输⼊,预测空间中的体素占据和类别信息,并与 GT 标注相⽐较。在权威的⾃动驾驶 Semantic-Kitti SSC 任务中,可以根据输⼊分成纯图像和基于 3D (点云、 TSDF、体素等)的两类不同的⽅法。使⽤纯图像⽅案恢复 3D 结构是⼀个⽐较困难的问题,旷视研究院提出了 OccDepth 的⽅法,将纯图像输⼊⽅法的精度⼤幅提升,获得了视觉⽅法的 SOTA,其中 SC IOU 从 34.2 增⻓为 45.1, mIOU 从 11.1 增⻓为15.9。同时可视化结果表明 OccDepth 可以更好地重建出近处和远处的⼏何结构。下⾯将带⼤家介绍 OccDepth 具体的⽅法。

二、任务困难和解决动机

仅从视觉图像估计场景中完整的⼏何结构和语义信息,这是⼀项具有挑战性的任务,其中准确的深度信息对于恢复 3D⼏何结构是⾄关重要的。之前的很多⼯作,都是利⽤点云、 RGBD 、TSDF[1]等其他 2.5D 、3D 形式[2-8]作为输⼊,来预测体素占据,这也需要较昂贵的设备来采集 3D 信息。基于纯图像的⽅案更便宜,同时也可以提供更为丰富且稠密场景表示, MonoScene[9]提出了纯视觉的 Baseline。但相较于上述的 3D ⽅法,在⼏何结构恢复⽅⾯,表现有⼀定的差距。

本项工作借鉴了“人类使用双眼能比单眼更好地感知3D世界中的深度信息”的思想,提出了名为 OccDepth 的语义场景补全⽅法。它分别显式和隐式地利⽤图像中含有的深度信息,以帮助恢复良好的 3D ⼏何结构。在 SemanticKITTI 和 NYUv2 等数据集上的⼤量实验表明,与当前基于纯视觉的 SSC ⽅法相⽐,我们提出的 OccDepth ⽅法均达到了 SOTA,在 SemanticKITTI 上整体实现了+4.82% mIoU 的提升,其中+2.49% mIoU 的提升来⾃隐式的深度优化,+2.33% mIoU 提升来⾃于显式的深度蒸馏。 在NYUv2 数据集上,与当前基于纯视觉的 SSC ⽅法相⽐, OccDepth 实现了+4.40% mIoU 的提升。 甚⾄相⽐于所有 2.5D 、3D 的⽅法, OccDepth 仍然实现了 +1.70% mIoU 的提升。

三、具体方法

上图是 OccDepth 的主要流程。3D 场景语义补全可以根据输⼊的双⽬图像所推理出来,其中连接了⼀个双⽬特征软融合(Stereo-SFA )模块⽤于隐式地将特征提升到 3D 空间,⼀个占⽤深度感知(OAD) 模块⽤于显式地增强深度预测,后续接上 3D U-Net ⽤于提取⼏何和语义信息。其中双⽬深度⽹络仅在训练的时候使⽤,⽤蒸馏的⽅法帮助 OAD 模块提升深度预测能⼒。

双目特征软融合模块

占用感知的深度蒸馏模块

为了在将 2D 图像特征转换为 3D 体素特征时引入空间占用的先验信息,本项工作提出了占用深度感知(OAD)模块,通过预测的深度信息显式地引入到空间占用先验信息。上图为占用感知深度模块的示意图,为了简单起见,图中仅展示了单图像VD 的处理流程。

残差设计

四、实验

指标对比

定性对比

在 SemanticTartanAir 和SemanticKITTI 上的可视化结果。最左侧是输入的图像,最右侧是语义体素真值,中间为各种方法的可视化结果。这里显示了 OccDepth 在两个数据集中有较好结果场景。

在室内场景 SemanticTartanAir 数据集上,虽然所有方法都正确获得了正确的场景表示,但 OccDepth 对物体边缘具有更好的还原效果,例如沙发(图(a)的第 1 行)和天花板灯(图(a)的第 2 行) 和地毯(图(a)的第 3 行)。而在室外场景的 SemanticKITTI 数据集上,与基础方法相比,OccDepth 的空间和语义预测结果明显更好。例如,通过 OccDepth 可以实现路标(图(b)的第 1 行)、树干(图(b)的第 2 行)、车辆(图(b)的第 2 行)和道路(图(b)的第 3 行)的准确识别。

消融实验

对提出的模块进行消融实验。(a) Stereo-SFA 模块的消融实验。(b) OAD 模块中深度蒸馏数据源的消融实验。(c)OAD 模块中深度蒸馏数据源的消融实验。“w/o Depth”表示不使用深度蒸馏,Lidar depth 是指激光雷达点云生成的深度图,Stereo Depth 是指 LEAStereo 模型生成的深度图。以上实验都在 SemanticKITTI 的 08 号轨迹上进行测试。(a),(b),(c)的消融实验结果证明了提出的每个模块的有效性。

五、总结

在这项工作中,我们提出了一种有效利用深度信息的 3D 语义场景补全方法,我们将其命名为 OccDepth 。我们在 SemanticKITTI(室外场景)和 NYUv2(室内场景)数据集等公共数据集上训练了 OccDepth, 实验结果表明,本工作提出的 OccDepth 在室内场景和室外场景上都可与某些以 2.5D/3D 数据作为输入的方法相媲美。特别地是,OccDepth 在所有场景体素类别分类上都优于当前基于纯视觉推理的方法。

来源:旷视研究院

作者:旷视研究院

专栏文章推荐

欢迎关注旷视研究院极术社区专栏,定期更新最新旷视研究院成果。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。

加入旷视:career@megvii.com