作者 | 程茜

编辑 | 漠影

生成式AI(又称AIGC)狂潮席卷,聊天机器人ChatGPT上线2月用户就突破1亿,成为消费级应用市场上冉冉升起的新星,海内外科技巨头纷纷开始争夺这场生成式AI盛宴的入场券。

资本市场闻风而动,国内服务器龙头玩家浪潮信息、“计算机视觉四小龙”之一云从科技、为算法模型开发提供专业数据集的AI训练数据服务商海天瑞声等众多ChatGPT概念股暴涨。

其中,算力层玩家已经悄然处于生成式AI产业发展的漩涡中心,AI训练芯片“一哥”英伟达股价开年至今上涨超60%。算力作为生成式AI产业的基础设施,一直在牵动全球科技企业的神经。

算力缺口问题一直存在,但随着生成式AI产业在消费级市场铺开,上亿级别的用户规模使得这一问题逐渐被放大。结合ChatGPT在训练和推理过程中对算力、网络等硬件的需求,市研机构中金研究院量化测算出在中性情景下,该应用有望推动约65亿美元(折合约446.51亿人民币)的增量市场空间。

在此背景下,国内AI芯片创企已经为大模型应用落地下激增的算力需求提出新解法,那就是以人脑为灵感的稀疏计算。

值此生成式AI爆发的关键节点,主攻稀疏计算的墨芯核心竞争力在哪里?巨头林立下,墨芯又将如何杀出重围抢夺市场蛋糕?这一波生成式AI浪潮对于以墨芯为代表的AI芯片创企又意味着什么?

带着这些问题,芯东西与墨芯创始人兼CEO王维进行了深入交流,从生成式AI产业带来的算力需求出发,探讨算力层玩家在其中的角色。

▲墨芯创始人兼CEO王维

一、算力激增,新Bing搜索基础设施砸40亿美元?

作为史上用户规模增长最快的消费级应用,ChatGPT的影响是爆炸性、裂变式的,其展示出来的生成式AI的交互能力已经大大超越了之前的小模型,智能性也产生了质的突破,随之而来的是对大算力的需求日益紧迫。

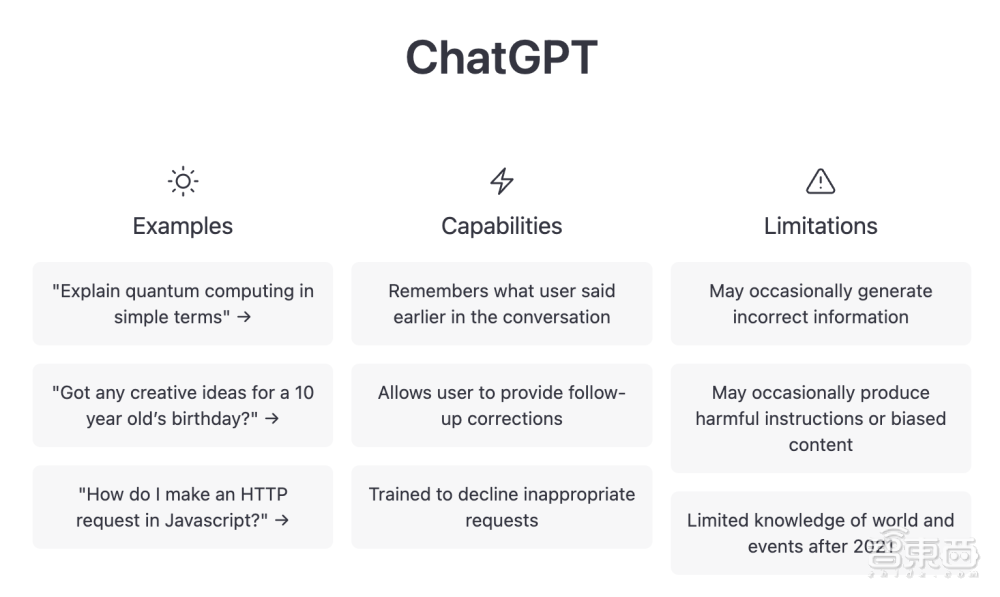

▲ChatGPT界面

因此这也一度让英伟达赚的盆满钵满。

产品面世之前,OpenAI可能就已经向算力层玩家狂砸千万、数十亿美元。据外媒报道,分析师称ChatGPT Beta版本使用了10000个英伟达GPU训练模型,新一代GPT-5大模型正在25000个英伟达GPU上训练。这背后就是数十亿的基础设施购买费用以及一次1200万美元的模型训练成本。

ChatGPT上线后,算力开销则只增不减。并且半导体产业分析机构SemiAnalysis的分析师称,当模型进入大规模部署阶段,将产生更高的算力成本。

摩根士丹利分析师称,ChatGPT的一次回复成本可能在2美分。国盛证券估算,假设以这样的稳定状态,且忽略集群配置的请求量冗余和服务质量冗余,那么,ChatGPT需要至少30382片英伟达A100 GPU芯片同时计算,才能支撑当前ChatGPT的访问量,对应初始投入成本约为7.59亿美元(折合约52亿人民币)。

集成到新Bing中的ChatGPT,则使得这一成本再次翻番。

研究机构New Street Research发现,集成ChatGPT的新Bing搜索引擎,可能需要8个GPU才能在不到一秒的时间内响应问题。按照这个速度,微软将需要超过20000台8-GPU服务器才能将Bing中的模型部署给每个人,这表明微软可能需要40亿美元的基础设施支出。

高昂的算力成本让“烧钱”成为了生成式AI产业应用落地的代名词。

如今,大模型规模持续增长已经是必然趋势,算力的需求仍然会不断激增,其结局只能是无止尽的砸钱吗?“并不是!”墨芯给了我们十分明确的答案。

就算不论成本,训练模型增大、计算量增加背后,被牺牲的训练时间和推理速度对消费级产品的扩展和规模落地影响都很大。因此,降本增效才是当前的关键。

二、单卡跑通GPT-3,企业成本降低3~5倍

这个答案的底气要先从墨芯布局的技术路线说起。

先来看一组数据,GPT-3模型是拥有1700多亿参数的大模型代表,如果放在GPU上去做推理的话,需要内存量是要几百G,也就是需要很多张80G的GPU,且会有明显时延;但通过稀疏化路径,用一张墨芯S30计算卡,就可以跑通GPT-3,并且计算速度还变快了很多。

稀疏计算的灵感就来自于人脑。我们在处理不同任务时,会激活大脑皮层的相应区域,无需调用整个神经网络。类比到芯片上,就是在不同的任务上进行稀疏激活。

随着通用人工智能时代的到来,稀疏计算与大模型的天然适配优势越来越明显。弱人工智能向通用人工智能的演进过程中,大算力爆炸时代稀疏特性越来越清晰、明显,相比于GPGPU的稠密计算,稀疏计算在算力能效比上有1~2个数量级的提升,并且墨芯的稀疏计算解决方案可以让企业成本降低3~5倍,王维谈道。

此外,墨芯S30加速卡通过软硬协同加速平台对大模型进行稀疏化,可单卡支持T5大模型推理,实现“1卡顶8卡”的算力效果。

从更宏观的角度来看,稀疏计算的发展也符合事物发展的第一性原理。他举了一个例子,相比于燃油车40%的热转换效率,电车的电能转化效率能达到90%,这也意味着燃油车时代向电车时代发展的必然性。

纵观当下生成式AI产业的发展,AI绘画工具、类ChatGPT产品等都正在将基于大模型的AI商业化应用落地推向高潮。

主打稀疏计算的墨芯正在突出重围,并彰显出无限的发展潜力。

成立4年墨芯首颗芯片Antoum一次流片成功、基于Antoum的AI计算卡S4仅5个月就实现量产,S30在全球权威AI测试MLPerf推理测试v2.1中的数据中心主流模型Resnet-50和Bert分获冠亚军,S4、S30快速拿到商业化订单……都在持续印证稀疏计算在AI发展历程中存在的合理性以及墨芯坚实的技术积累。

墨芯实测显示,运行在墨芯S30加速卡上的GPT开源模型,生成答案的速度能够较原来提升10倍。

此外,互联网、金融、运营商、制造、医疗等行业的头部用户也正在与墨芯接触,其产品已经可以应用于上述行业。这些计算密集型产业的应用已经让墨芯的产品得到市场验证。

王维说,生成式AI变革的当下对于墨芯和稀疏计算而言,是一个完美的时期。“两三年内,稀疏化计算应该会在大模型推理和训练中拥有一定的市占率。”

从短期来看,墨芯的战略布局将沿着稀疏化推理到稀疏化训练,再到训推一体。不过,一家企业的战略布局与方向必然不能着眼于当下,他补充道,墨芯的长期战略目标是搭载一个更先进的下一代计算平台,包含训练、推理的AI 2.0计算平台。

三、创新路径、顶尖人才、计算生态,成AI芯片黑马护城河

AI产业的爆炸性事件,让算力层玩家在技术发展和应用落地上宛如搭上了快车。王维说:“过去十年,GPU一直承载着AI产业的发展,现在是新的颠覆性技术最容易切入和最快速被市场接受和认可的节点。”

不过,外部环境虽然重要,打铁仍需自身硬。技术积累深厚、人才团队强大的“黑马”芯片企业的优势尤为显著。

1、底层“创新基因”,与大厂一较高下

王维多次谈到了“创新”,他认为这是生成式AI未来快速商业化的底层基因,也是墨芯的企业文化。

作为国内AI芯片创企的代表玩家,在AI爆炸性事件出现时,除了拥有技术积累去支撑其算力外,还应该肩负起更大的责任感和使命感。

大算力爆炸时代,从科技巨头到AI创企都在寻找解决算力难题,但现实是,依靠先进制程获得突破的道路对于国内芯片玩家而言过于艰难,而找到一条创新路径去支撑大模型的发展就尤为重要。

“这也是那些不缺资源、不缺人才的头部科技公司最看懂的东西。”王维说。

2、顶尖算法人才团队,量产、落地、创新一脉相承

人才济济的核心骨干成员是“创新基因”的载体。

创始人王维曾任美国高通和英特尔架构师,英特尔5-10代CPU处理器的核心成员,参与开发量产超50亿片芯片,拥有硅谷芯片公司创业经历;首席科学家严恩勖拥有40多篇AI顶会成果;工程VP芦勇曾任SK Hynix芯片设计总监和Marvell资深芯片设计经理;首席架构师肖志斌曾任达摩院核心架构师等等……

兼顾算法、架构、芯片设计的顶尖人才,使得后续墨芯在芯片量产、技术创新、应用落地上一脉相承,并迅速“迎接”大算力爆炸时代对于AI芯片创企更为严苛的考验。

3、拓展稀疏计算生态,加入主流生态龙蜥

不论是AI芯片产业化还是大模型应用落地,都需要完备的软硬一体生态才能让稀疏计算真正跑起来。

因此墨芯一直在布局稀疏计算生态拓展,目前该公司已经完成百度飞桨等AI框架、浪潮、新华三等主流服务器的适配,并加入龙蜥等国内主流生态。

王维谈到,生成式AI产业发展对于现有的生态而言是一个巨大的挑战,需要更聪明的方式去训练更大更稀疏的模型。未来,随着应用场景、应用数量的不断丰富与激增,生态构建将逐渐完备。

总的来看,生成式AI产业最终会落地到具体的应用场景中,而墨芯在其中扮演的角色更像是一个“装备库”,支撑着大模型背后庞大的算力需求,这也正是对AI芯片创企背后技术积累的突击检查。

结语:“狂飙”的ChatGPT背后,“创新基因”成AI芯片创企致胜关键

多年来,AI领域已经鲜少有像今天ChatGPT引发的热潮这样,让全球的人才、资本焦点都集中于此,也让多个产业站到了聚光灯下,AI芯片创企就是这样的存在。

虽然热潮爆发往往有一定的预兆,但想要快速切入风口、抓住机遇需要更快速的反应和行动力。在这样的巨大变革下,拥有强大技术团队和对技术路线有独到判断的墨芯更有底气。

尽管相比于科技巨头,AI芯片创企的体量、人才、资源都无法比拟,但正如王维所言,寻找创新路径是支撑未来大模型发展的关键。而这并不被大公司所独有。因此,大规模算力不断攀升的当下,也进一步加速了AI芯片创企的规模化落地布局。