导读

这几天看到一个非常有意思的工作——ChatSpot,这是由旷视基础模型小组最新研究的工作,目前还未正式推出,不过 Demo 已经放出,大家可以玩一玩。

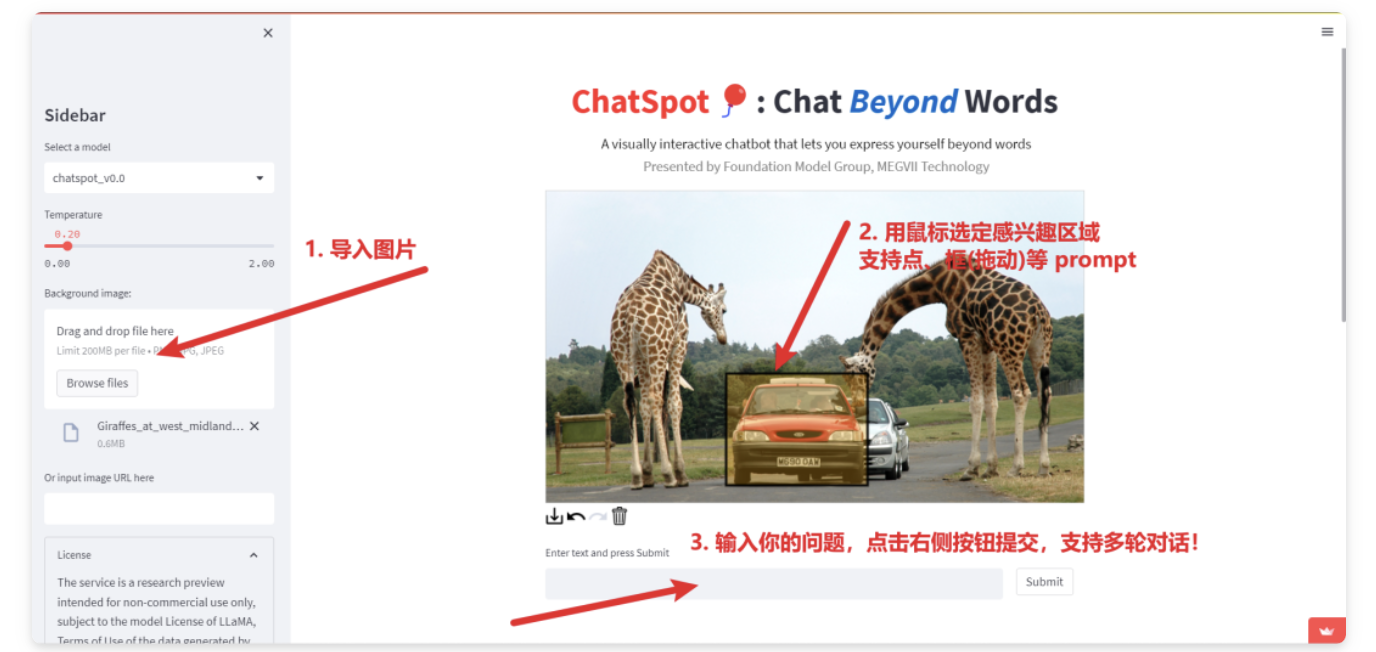

TL;DR: 据作者称,ChatSpot是一个提升多模态大语言模型“精确指代”(亦即交互)能力的探索工作,即非拼接的、能读懂用户“自然语言”以外的指令,如鼠标/手指的点击、拖拽等指代行为的交互式多模态 LLM。下面让我们一起跟随原著的脚步一起了解下,这项工作的“有趣之处”在哪里。

背景与动机

想象下面这个一个例子,如果你想知道图片中位于香蕉和苹果中间的外绿内白的水果是什么,你会如何提问?

一般而言,现有的 LLM 的模式必然是,你输入一张图片,然后直接提问:

Hei, Siri GPT,请告诉我图片中位于香蕉下面、苹果上面的外绿内白的水果是什么?在这句表达中可以看到在缺乏更直接的“指代”方式的情况下,用户不得不使用大量“定语”去提升指代内容的准确性。

当允许使用点、框和mask来表达用户的指代内容时,就好像用户和AI助手都在观察一张图像。用户可以使用手指或鼠标在图像上指向和绘制,以达到相同的目的。用户可能会拖动手指/鼠标选择感兴趣的区域(RoI),或者点击他们感兴趣的目标,如下所示:

然后,我们只需要简单提问:这是什么水果?

不难发现,有了更丰富的指代工具,沟通效率和便利程度会直线提升。我们把这类用于指代聊天目标或区域的用户输入统一称为Referring Prompt。

核心亮点

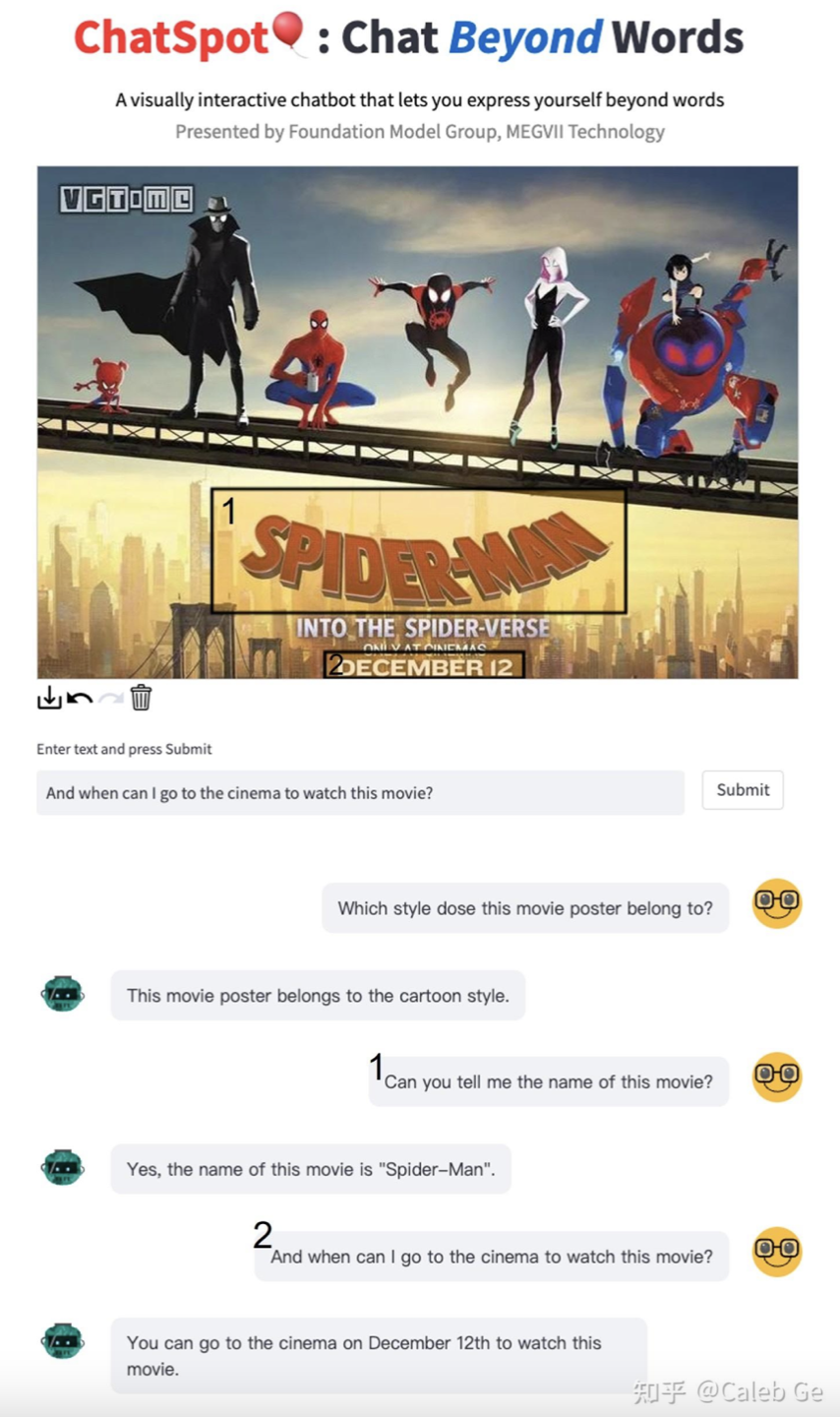

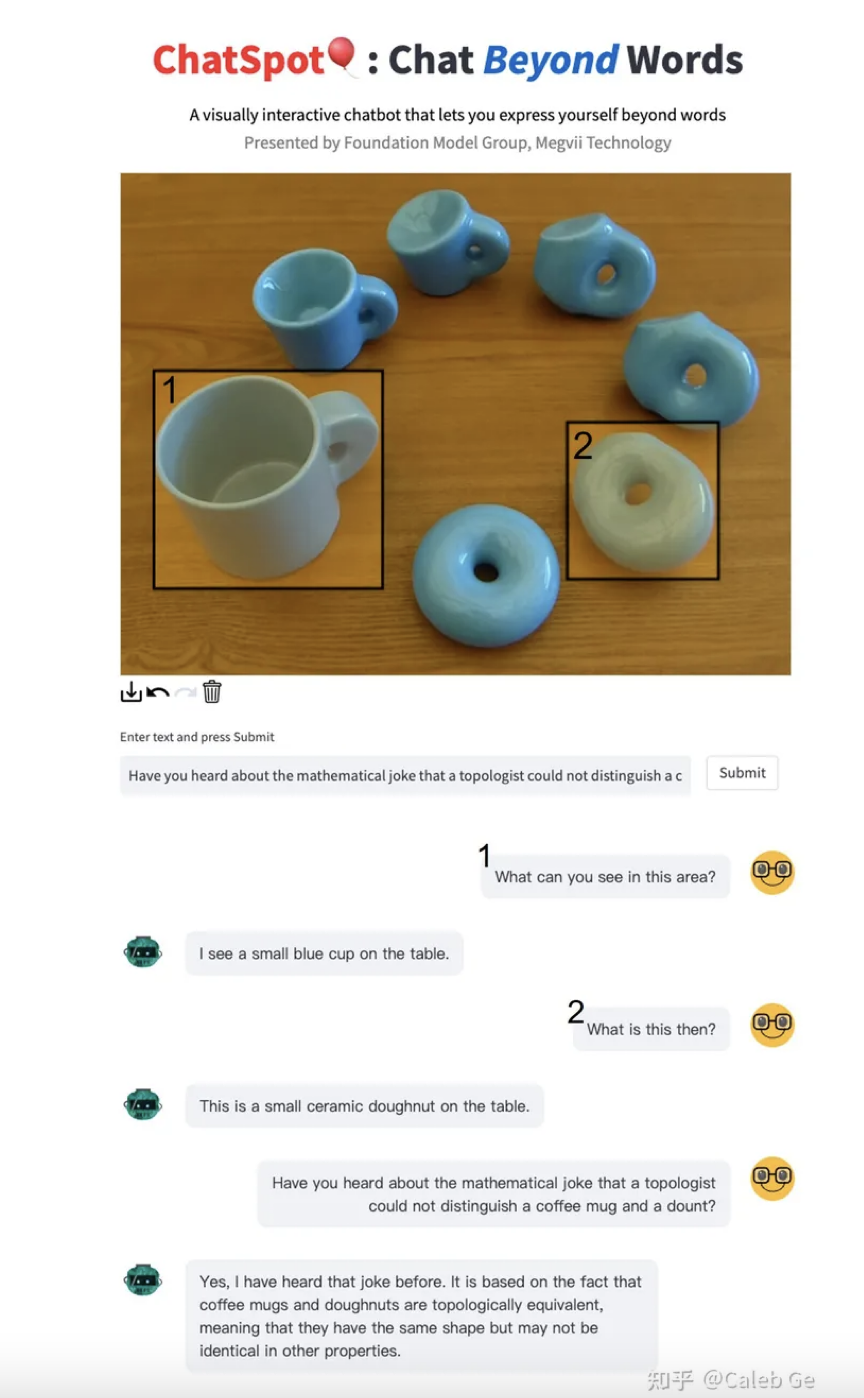

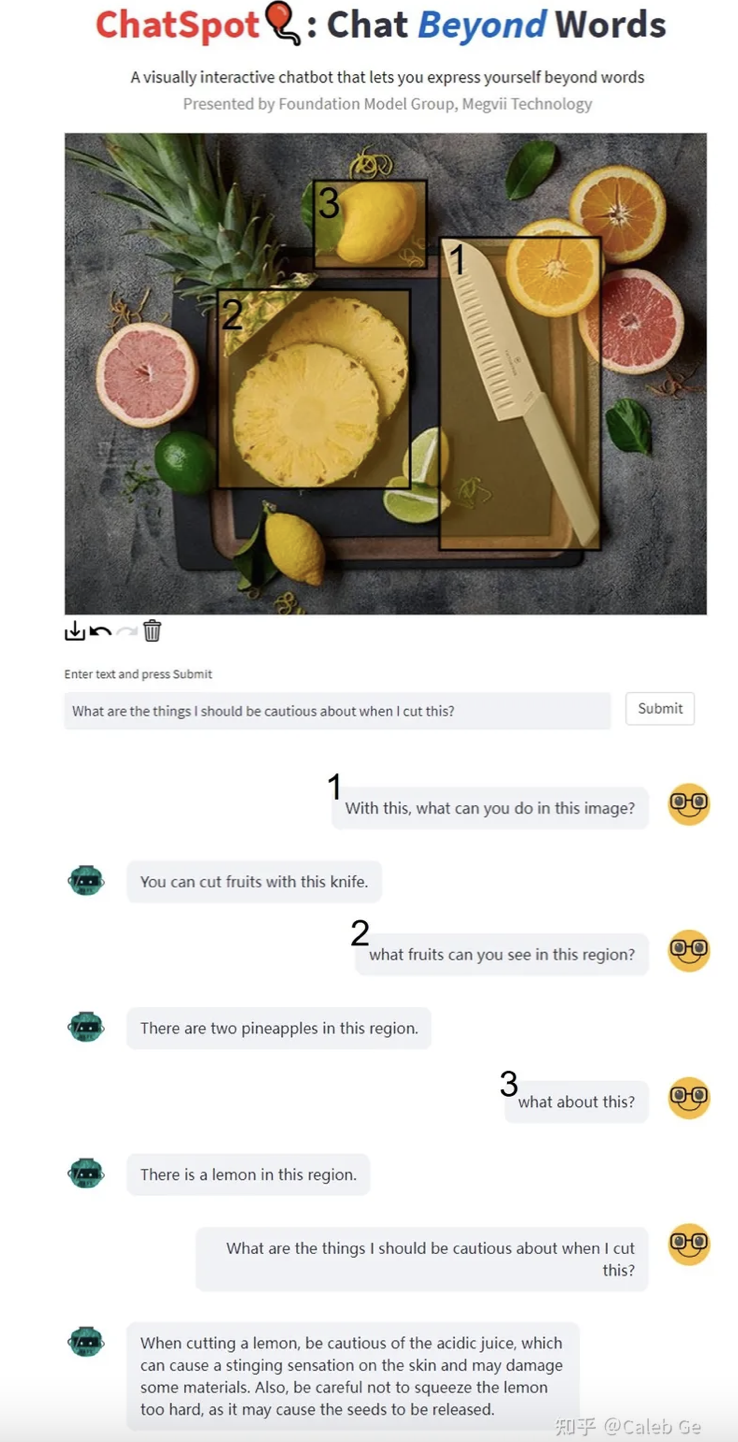

ChatSpot 是非拼接式的,将 Referring Prompt 编码为输入与 image、language 一同丢进LLM进行联合训练,故具有更大的Referring Prompt选择的灵活性,和更高的性能上限。下面是一些ChatSpot效果/能力展示:

1. 指代目标识别

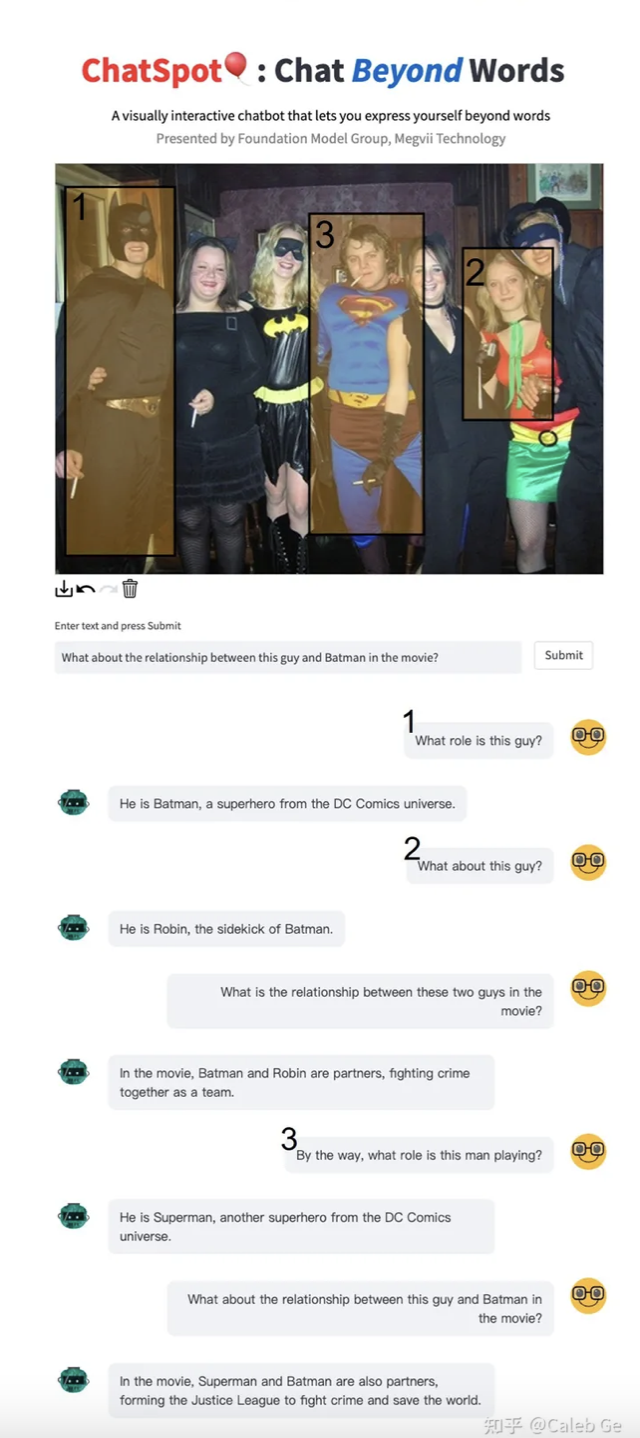

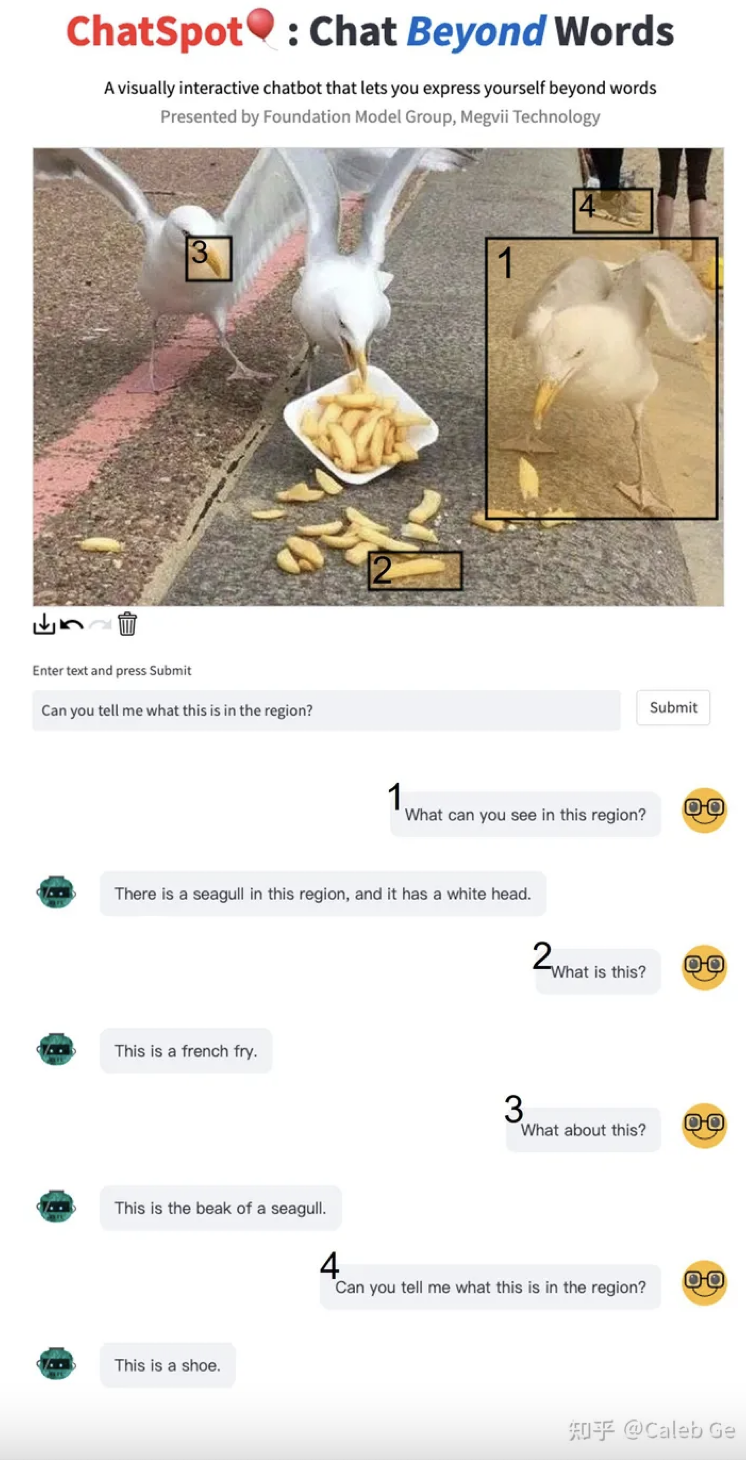

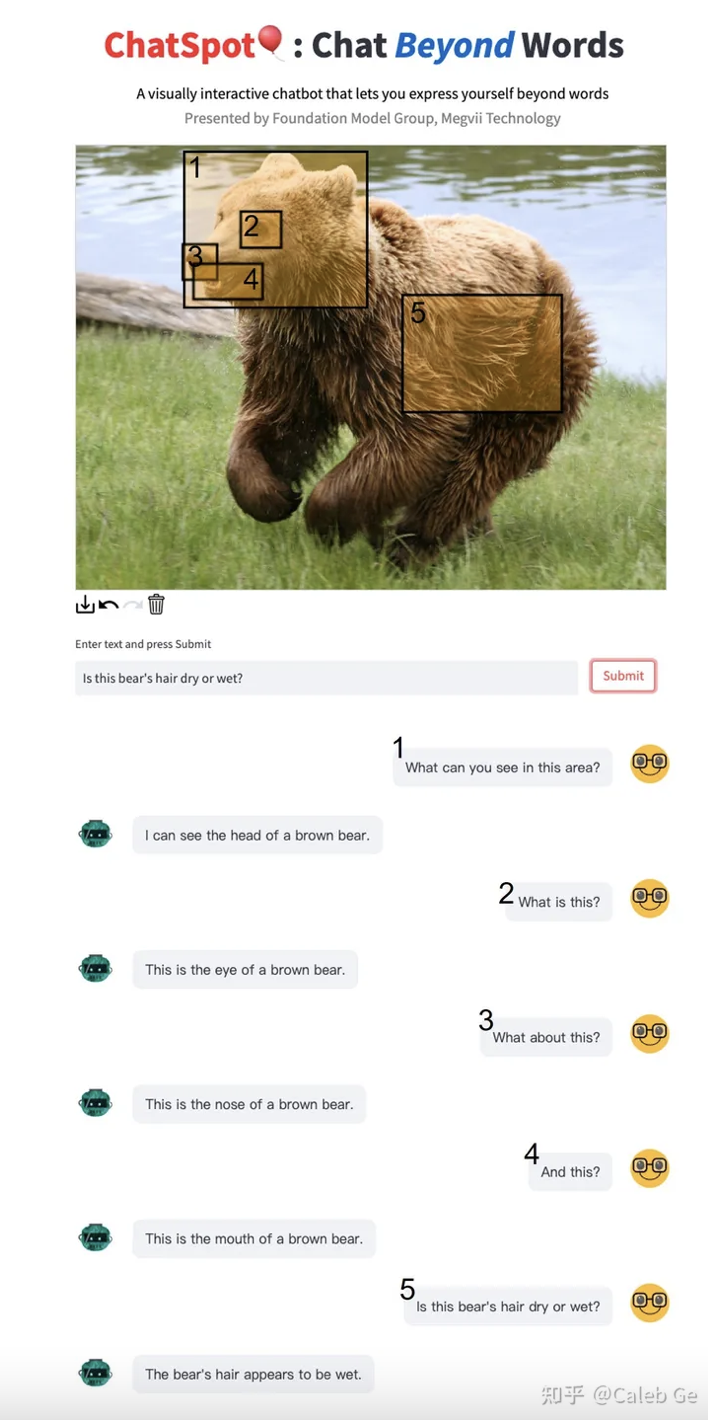

ChatSpot能精确感知用户定位的区域,以及精准感知区域内的物体,如下面三个示例:

本例中,ChatSpot认出了Batman,Robin(查了下,似乎是第四代罗宾,瑞思拜)、超人cosplay,对他们在DC宇宙中的关系也一清二楚。为了更清晰的展示,每个框附上了序号标签,表示输入的先后顺序。

ChatSpot精准感知到用户框取的感兴趣的区域,并识别了区域内的物体,如海鸥、薯条、海鸥的嘴、鞋。

这个例子中,ChatSpot 很好的区分了局部与整体,不仅识别了熊的脑袋,也识别了脑袋上的鼻子、嘴巴、眼睛等概念,有各层次细粒度的目标识别能力。此外也能感知到毛发潮湿这类细节特征。

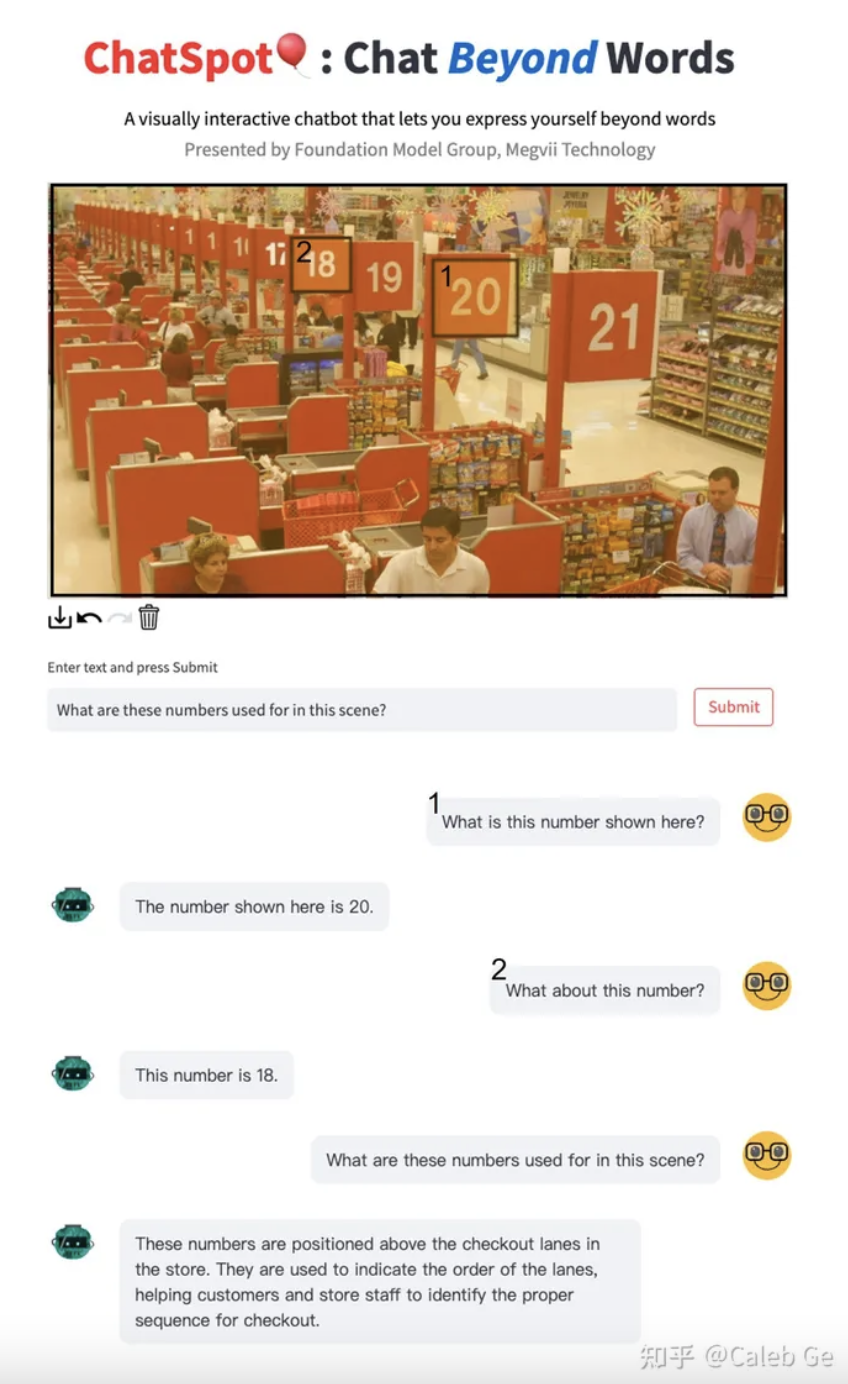

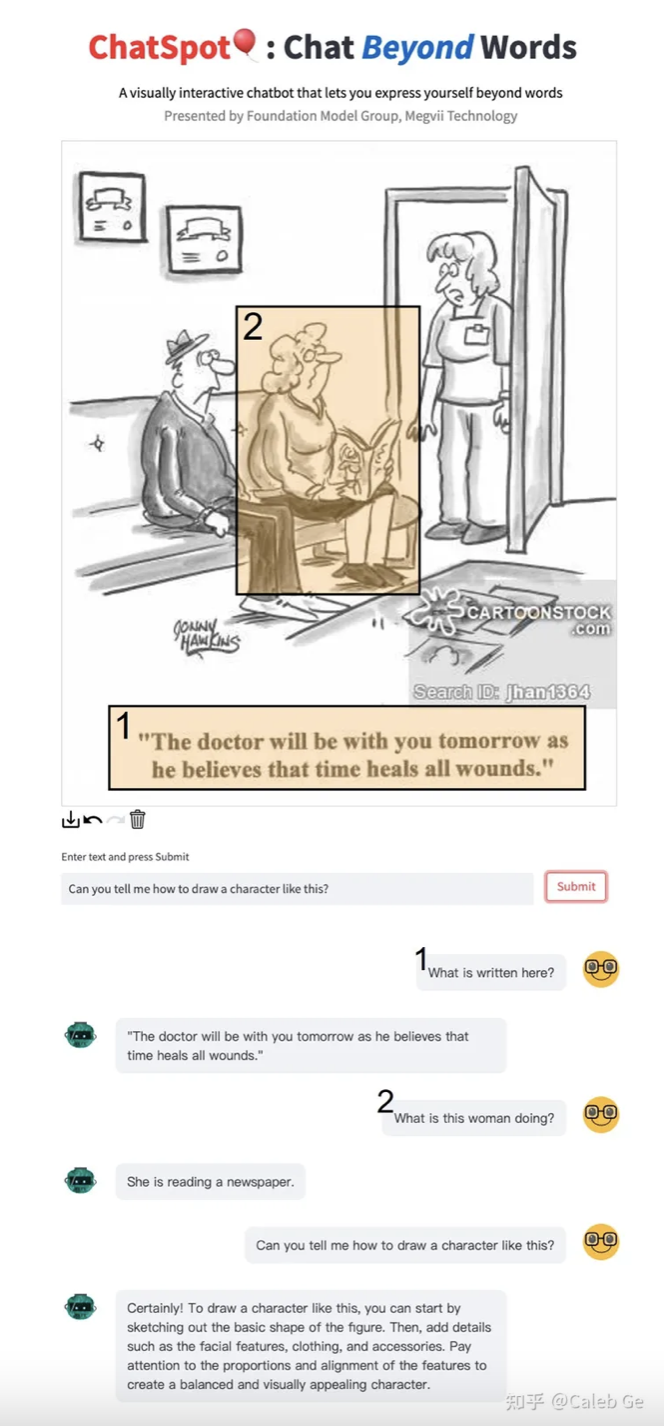

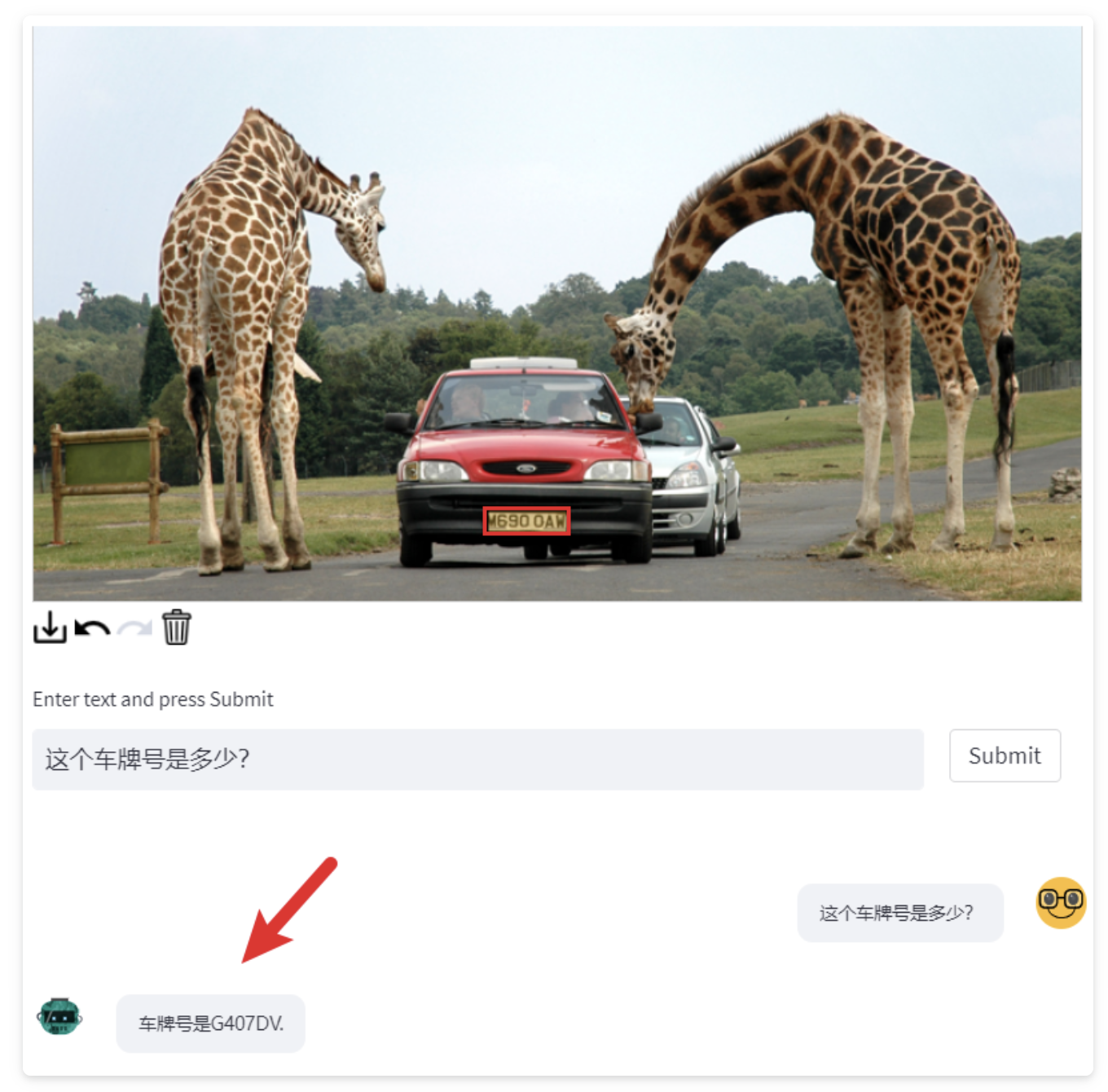

2. 指代文字识别

此外,下面还有一些例子,可以体现出ChatSpot与其他多模态大模型一样,具备基本的常识和reasoning能力。

延伸

ChatSpot不仅是一个聊天助手,在很多行业都具有潜在的应用价值,如机器人(Embodied AI)、智能头显(AR/VR/MR)、医疗等,期待大家积极解锁新的使用场景。当然作为初版模型,ChatSpot旨在做概念验证,其本身能力还远未达到product-level quality。

Referring Prompt的扩展,当下仅支持框、点、mask(Demo目前只开放基于框的交互),原理上它可以支持任意可编码的输入,如图像、声音等,未来我们也会积极探索更丰富的Referring Prompt形式,也希望更多的同行可以参与到这个方向来。

总结

今天我们为大家介绍的这款新模型,可以看出它的不同之处便是——“言简意赅”,大白话就是用户并不需要描述一堆“上下文”来表达自己的诉求,这就像赋予了多模态大语言模型“一双眼睛”一般,直接指哪说哪,非常的有趣!

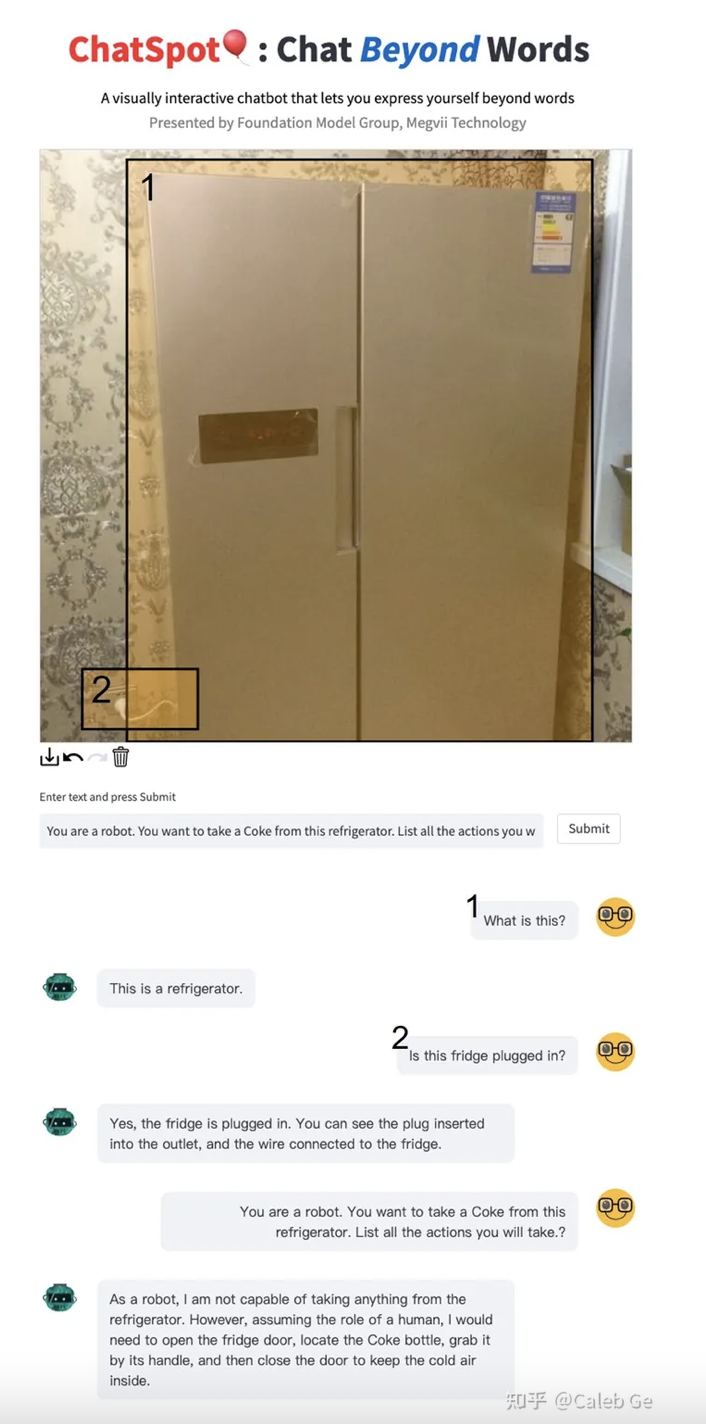

本着实事求是的探索精神,阿伟也为大家率先体验了一番:

以下是一些试验性的对话记录:

可以看出,模型确实是能够“理解”用户的意图并“准确”的回答出来。但本质上仍然还是会受到 LLM 普遍会犯的 “困惑” 窘境,即掉入用户错误的提示当中。当然,像ChatGPT这样的语言模型是通过机器学习训练得到的,其目标是生成合乎逻辑和相关性的回答,而不是确保回答的准确性。模型的训练数据包含了大量的人类生成的文本,因此它会学习到一些常见的观点、事实和推理,但并不保证每个回答都是绝对准确的。

当用户声称模型的回答是错误的时候,这可能是因为模型在某些情况下会产生一些不准确或有争议的答案。此外,语言模型也没有能力判断信息的真实性或准确性,它只能基于训练数据中的模式进行生成回答。

在与语言模型交互时,用户可以提供更多的上下文信息、相关证据或要求模型进一步解释其回答,以便获得更准确和详尽的回答。模型的目标是尽可能提供有帮助的信息,但用户仍然需要对模型的回答进行批判性思考,并结合其他可靠的信息来源进行判断。

另外,我们测试下它的文字识别能力:

可以看出模型性能整体还是有待提升。但总的来说,ChatSpot 确实是一项不错且有意思的工作,而且该工作的核心是解决“交互”的问题,单从这一点来看表现还是相当优异。至于未来多模态大语言模型会发展成什么样也没人能够准确预测,让我们保持初心,持续 follow!

作者: 派派星

文章来源:CVHub

推荐阅读

- thinktwice:用于端到端自动驾驶的可扩展解码器(已开源)

- CVPR 2023|小红书提出 OvarNet 模型:开集预测的新SOTA,“万物识别”有了新玩法

- 苏黎世理工 & 港科大震撼力作 | HQ-SAM:SAM新秀-高质量分割一切模型

- YOLOv8太卷啦 | YOLOv8官方仓库正式支持RT-DETR训练、测试以及推理

- 软硬协同优化 (1):高层综合编译技术

更多嵌入式AI干货请关注嵌入式AI专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。