时至今日,算力价值的重要性已经不言而喻。

日前,工业和信息化部、中央网信办联合国家六部门,联合印发《算力基础设施高质量发展行动计划》,从计算力、运载力、存储力以及应用赋能四个方面提出了到2025年发展量化指标,其中明确指出——到2025年,计算力方面,算力规模超过300EFLOPS,智能算力占比达到35%。

这也再次明确了算力应用的多样化。其实近些年来我们慢慢发现,随着智能计算的崛起,如今的算力就分为了传统算力和智能算力,而应用的创新也决定了评判标准的创新,我们也必须以新的眼光、新的标准来评判算力价值。

那么评判算力的工具有哪些呢?目前行业主流认识层面,对于传统算力依然是SPEC体系,而针对智能算力,近些年MLPerf成为了业界权威;至于更新的存力标准,则是SPC-1大展身手的领域。应该说,面向智能时代的标准已经多元化、多样化,但最终这些标准都反映出了应用场景下的性能、能效等核心数值表现,也将看不见摸不到的算力转变成了可以量化的指标。

从这个角度来说,SPEC、MLPerf、SPC-1将成为现在乃至未来一段时间我们对于数字化的重要评判依据,而谁能够在这些评测体系中名列前茅,谁才能够成为数字化时代的领头羊,才真正代表了未来数字时代的发展方向。下面,我们就将对这三大评测标准进行详细的介绍。

SPEC,传统算力应用的试金石

服务器是数据中心IT基础设施中最重要的设备之一,也是承载算力服务的硬件基础。一直以来,服务器性能都是行业关注的焦点,为此也产生了多种评判标准。这其中,SPEC测试因其权威、专业、覆盖面广成为行业标杆,几乎所有的服务器在出厂之前都要经过严格的SPEC测试,这也让SPEC成为了类似竞技体育中田径、游泳一类的“传统王牌项目”。

为什么SPEC会如此受欢迎呢?这还要从它的历史谈起。1988年,包括斯坦福大学、英特尔、IBM、Oracle、微软等全球数十所知名大学、研究机构、IT企业组成的第三方应用性能权威测试组织发起并成立了SPEC(Standard Performance Evaluation Corporation)标准性能评估组织,其目的就是确立、修改以及认定一系列服务器应用性能评估的标准。而多年来随着云计算、容器等应用场景的不断变化,SPEC的评定项目也从服务器硬件扩展到了云端,如今形成了覆盖性能、云环境、Java应用、能耗、虚拟化环境等5个维度的综合测试平台。

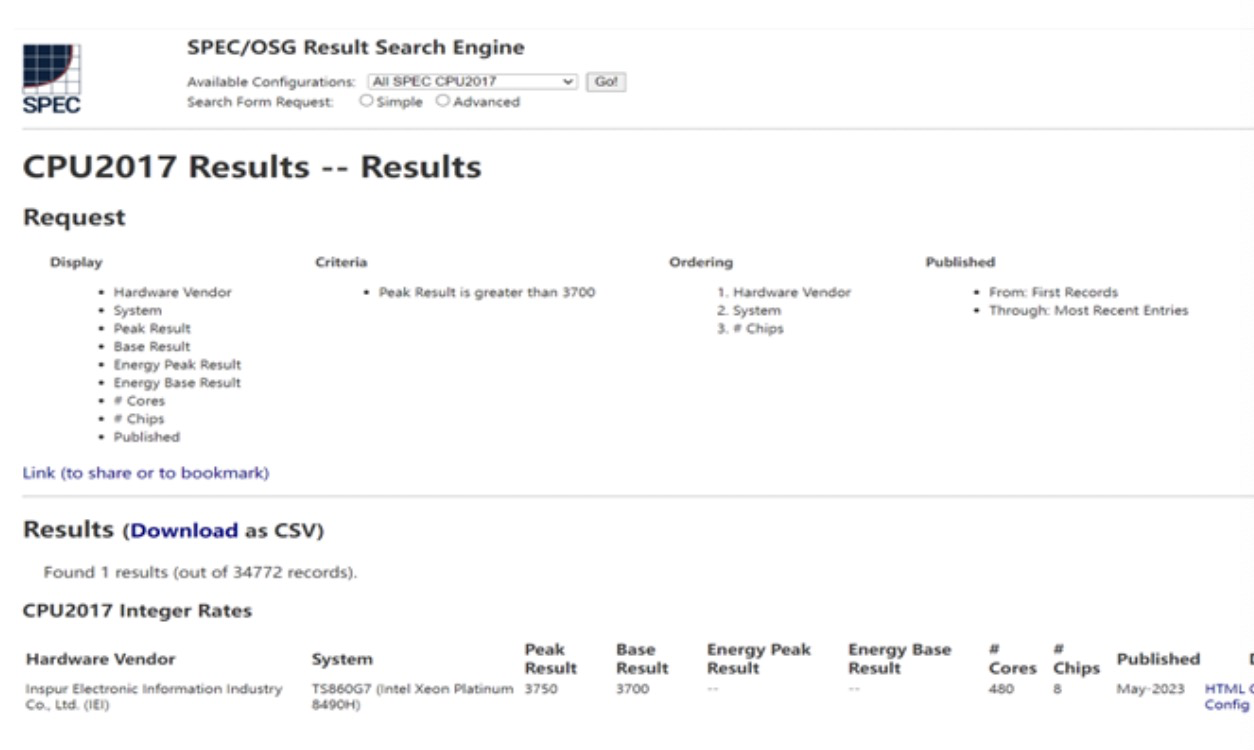

SPEC CPU是SPEC评估整机计算处理能力的测试工具,也是其“看家本领”,如今最新的版本为SPEC CPU 2017。虽然名字上是“2017”,但实际上它的测试项目却非常全面,测试项目覆盖了仿真分析、基于人工智能搜索引擎优化、视频压缩等10个典型应用场景,43个基准测试的业务负载,是反映服务器整体性能的重要参考指标,也是竞争最为激烈的赛道。

比如在上面这份榜单中我们就看到,来自浪潮信息的八路服务器TS860G7在Peak测试成绩达到了3750分,在入围榜单的34772份成绩中排名第一,从而也打破了单系统服务器性能世界纪录,定义了x86服务器的性能巅峰。

如果你觉得单机性能说服力不够的话,那么SPEC也提供了针对云平台性能测试的SPEC Cloud IaaS 2018和针对虚拟化性能测试的SPEC Virt。前者主要测试的是云平台的性能,即云平台上运行IO密集型和计算密集型负载,通过加压测试数据面性能、可扩展性以及控制面性能来评估云平台的性能;后者则是云数据中心虚拟化性能的标准测试工具,主要考察在保证服务质量(QoS)的前提下,一台服务器上能够部署多少台虚拟机,当然数量越多SPECvirt性能总得分就越高。

那么谁又是这两项测试的优胜者呢?这就不能不提到云海虚拟化平台。一方面,云海OS多次打破SPEC Cloud IaaS 2018测试纪录,可以高效完成I/O、计算等各类负载的调度,并且性能增长还具有领先的线性扩展能力,完全可以满足用户从传统业务到新型大数据、人工智能等创新应用的上云需求。而在虚拟化层面,云海虚拟化InCloud Sphere早在2021年就刷新了双路服务器平台榜单,以4679分打破了已尘封四年之久的世界纪录,成绩霸榜全球第一,较之前的测试最高分提升了39%。

可以说,SPEC奠定了服务器性能测试的基准,也是行业内广泛认可的测试方式,并被金融、电信、证券、能源等关键行业用户作为选择IT系统一项权威的选型指标。不过随着应用业务的发展,数字化业务已经不仅仅局限于单一服务器、单一集群或者单一数据中心,应用场景也从传统计算扩展到了智能计算,甚至诸如当下流行的大模型应用都需要有一套新的评价标准和体系。

MLPerf,智能时代的定海神针

如同竞技体育一样,田径游泳三大球的比赛固然精彩,但是年轻人却更喜欢滑板、霹雳舞、电子竞技等全新运动,整个大赛也需要这样的运动来赢得年轻人的关注。同样在数字化应用中,随着智能业务的无处不在,传统的算力评估平台已经不能满足场景化的需要,因此就有了名为MLPerf的全新测试,并迅速得到了全球行业用户的认可。

MLPerf由图灵奖得主大卫•帕特森(David Patterson)联合顶尖学术机构发起成立,但它的历史要比SPEC短得多。就在不久前的2020年,包括谷歌、英伟达、英特尔、哈佛大学、斯坦福大学等50余家全球AI领军企业及顶尖学术机构发起成立了非盈利性机器学习开放组织MLCommons,进而推出了MLPerf基准测试,以致力于推进机器学习和人工智能标准及衡量指标。

但是相比SPEC自行提交成绩,MLCommons选择了每年组织4次测试,包括2次AI训练能力测试和2次AI推理能力测试。其中,AI训练测试分为集群测试与单机测试两个场景,只考察完成AI任务训练的时间,时间越快则代表性能越强;而推理测试则提供了数据中心和边缘侧2大场景,每个场景也有不同的测试项目,精细度非常高。

AI训练是当下行业的热门,包括GPU在内的许多AI加速设备都是应用于该场景,尤其是在如今AIGC蓬勃发展的情况下,GPU可谓是“一卡难求”,也侧面证明了AI训练的火爆。而MLPerf测试这些年也在不断的迭代与演进中,从视觉、语言到智能推荐和强化学习都有对应的评判模型,并确保评测模型与业内的前沿成果同步更新,且每个模型设置多样化的考察标准,体现了测试的及时性、专业性与创新性。

浪潮信息同样是MLPerf的“常客”。自2020年伊始,浪潮信息就参与到MLPerf比赛中,通过智算架构和软硬协同的技术优势不断刷新AI计算的性能速度,连续两年夺得MLPerf的年度冠军榜首。

在不断斩获MLPerf冠军的同时,浪潮信息也毫不保留的将高效优化方法回馈至社区,推动AI技术的共同进步。在MLPerf Training v0.7中,浪潮信息开创性提出效率更高的ResNet收敛性优化方案:在ImageNet数据集上,仅使用85%的迭代步数就达到了75.9%的目标精度,该优化方案将训练性能提升了15%。目前,该方案已被社区成员采纳,并广泛应用到MLPerf Training V1.0测试中,让更多的用户因此受益。

这就好像一场比赛中,浪潮信息作为MLPerf测试中的“优等生”,不仅分享了成功经验,还优化了竞赛流程、提升了评审效率,以一己之力让MLPerf Training项目得到了跨越式发展,也帮助MLCommons完善了AI测试基准,形成了推动产业发展的良性循环。

SPC-1,多元化存储评估,让数据价值最大化

刚刚我们谈到了太多的算力因素,的确因为算力在如今的IT产业中占据了举足轻重的地位,也成为了AIGC角力的关键。但正如古语云:“不谋全局者,不足谋一域”,管理者不仅要看到眼前的需求,更需要考虑整体的、未来的长远需求。以AIGC为例,虽然目前行业对算力需求旺盛,但伴随着行业供货能力的不断提升,这股需求很快就会转移到后端的存储上来,毕竟再强大的算力和算法也要为业务服务,而数据本身就是业务直接表现。如此看来,存储也将成为继算力之后的又一个热门领域。

那么相比算力测试的SPEC和MLPerf,存储领域测试标杆又是什么呢?这就不能不提到全球存储性能委员会(SPC)。它是由世界级存储供应商联合组成的一个非盈利机构,是一个专注于存储行业供应商性能评测的中立机构。针对存储行业的需求和关注,SPC创建了全球第一个存储行业标准的性能标准——SPC-1基准测试,实现了从组件级评估到完整的存储系统测量,提供了严格的、经过审计的、可靠的和可重复验证的性能度量。

不过与算力测试不同,存储的评判标准要复杂得多。刚刚在介绍中我们提到,无论是SPEC还是MLPerf都有“成绩越高越好”、“耗时越短越好”、“跑得越快越好”等项目,评判的标准一目了然。但是对于存储来说,虽然性能也是关键性的因素,但是因为应用场景的特殊性,容量、稳定性、可靠性等标准同样非常重要。俗话说:“设备有价数据无价”,存储需要综合考量各方面的特性,而不能“唯性能论”。

为此,SPC-1基准测试也设计了多种场景,比如关键业务应用场景下的负载模型、比如覆盖结构化数据为主的数据库,再比如电子邮件等在线事务处理(OLTP)应用;在考察指标上也侧重用于读写响应时间敏感度、工作负载的多样性及动态变化、性能表现长时间稳定可靠等共计8种数据访问行为的模拟,这样就保障了测试的全面性和公正性,也因此受到了行业的一致认可。

比如可靠性和稳定性,这是存储设备的关键特性,甚至在某些特定行业中,保障数据的稳定、安全运行甚至比性能出色更为主要。为此,SPC-1在整个测试过程中的多个阶段都会检验数据的一致性,比如初始化阶段、SPC度量阶段、关电重启再校验数据的一致性等等,确保存储能够经受高可靠性的严格测试。而SPC-1长稳测试阶段则要求最大的可持续I/O请求至少需要8小时,浮动范围仅为5%,只有这样才能确保系统长期持续稳定的性能。

同样被重视的还有延时,这也是算力测试中容易被忽视的方面。SPC-1基准测试在延时方面有三个指标,分别是平均延时、延时带宽对比图和总体响应时间。就业务场景来说,这三个指标可以很好反应不同阶段的业务表现,特别是第一个平均延时更是行业通用的评判标准。我们看到,2021年8月浪潮高端全闪HF18000G5在测试中获得2300万IOPS,平均延时0.294毫秒(低于0.3ms),达到了行业领先的水平。而在响应时间与吞吐量对比方面,HF18000G5表现也非常不错,提供了不错的存储系统稳定性和应用潜力。

多元化的测试标准才能全面考察存储,那是不是意味着满足这些需求的“六边形战士”在成本上也会很高,甚至超过不少客户的承受能力呢?SPC-1也充分考虑到了这个问题,并提供了总性价比的评判标准——用系统总价格除以SPC-1 IOPS或者用总系统价格除以SPC-1 ASU的容量,这样就获得了每千IOPS或者每GB容量的性价比,帮助用户进行更好的评估。

比如刚刚我们提到的高端全闪HF18000G5,它的IOPS性能测试为2300万(精确值是23001502),这样算下来SPC-1性能方面的性价比为$375.56/SPC-1 KIOPS,远超过第二名;容量价格比为$10.58/GB,比许多人家里的电脑存储还要划算。

从算力扩张到存力爆炸,从电子时代到数字时代,正是不断的创新和变化推动了社会的发展。而面向数字化,我们需要一套针对算力、存力的评定方式,用量化的指标、前瞻性的思维让数字时代加速。无论是SPEC还是MLPerf亦或是SPC-1,正是为我们提供了一套系统、科学的评估方法,让我们能够发现什么是好的服务器、存储和云平台。而以浪潮信息为代表科技企业,在各个赛道中都有出色的成绩表现,让我们有理由相信,在未来的智算时代的生态体系中,我们将是至关重要的一环。