导读

大语言模型(LLM)可以从极少的示例中进行学习,而无需进行微调。这种学习方式被称为"上下文学习"(In-context Learning)。然而,我们是否可以期望常规大小的模型也具备类似的能力呢?尽管GPT4、Llama等大型模型在各个领域展现了卓越的性能,但由于资源限制或对实时性的要求较高,许多情况下无法使用这些大模型。为了深入研究小模型的上下文学习能力,来自字节跳动和华东师范大学的研究团队进行了一项专注于场景文本识别任务的探索性研究,用以揭示小模型在上下文学习方面的潜力,填补这个领域的研究空白。

场景文本识别旨在从图像中提取文本内容,但在实际应用中,它面临着多种挑战。这些挑战包括不同场景下的文本排版、形变、光照变化、字迹模糊和字体多样性等问题。因此,训练一个适用于所有场景的通用文本识别模型变得十分困难。一种直接的解决方法是收集相应场景的数据,并在特定场景下微调模型。然而,这个过程需要重新训练模型,并且随着场景的增加和任务的复杂化,训练、存储和维护所需的资源也会急剧增加。要解决上述问题,一个理想的方案是使文本识别模型具备上下文学习能力。这意味着在面对新场景时,只需少量标注数据作为提示,模型就能提高性能。这种方法可以有效解决问题。然而,由于场景文本识别是一项资源敏感型任务,将大模型用作文本识别器将消耗大量资源。通过初步实验,研究人员发现在场景文本识别任务上传统的训练大模型的方法并不适用。

为了应对这一挑战,来自字节跳动和华东师范大学的研究团队提出了一种名为ESTR(Ego-Evolving Scene Text Recognizer)的自进化文本识别器。与传统方法不同,ESTR是一个常规大小的文本识别器,但它具备上下文学习能力,能够快速适应不同的文本识别场景,而无需进行微调。该模型采用了上下文训练和上下文推理模式,不仅在常规数据集上取得了最先进水平,还能够使用单一模型提升在各种场景中的识别性能。引入ESTR后,文本识别器能够以快速且准确的方式适应新场景,甚至在识别性能方面超过经过微调的专用模型。这表明常规大小的模型已经足够有效地进行上下文学习。ESTR展现出了出色的适应性,可以在各种场景中实现卓越的性能,而无需进行微调,甚至超过了经过微调的专用识别模型。

论文地址:https://arxiv.org/pdf/2311.13120.pdf

方法

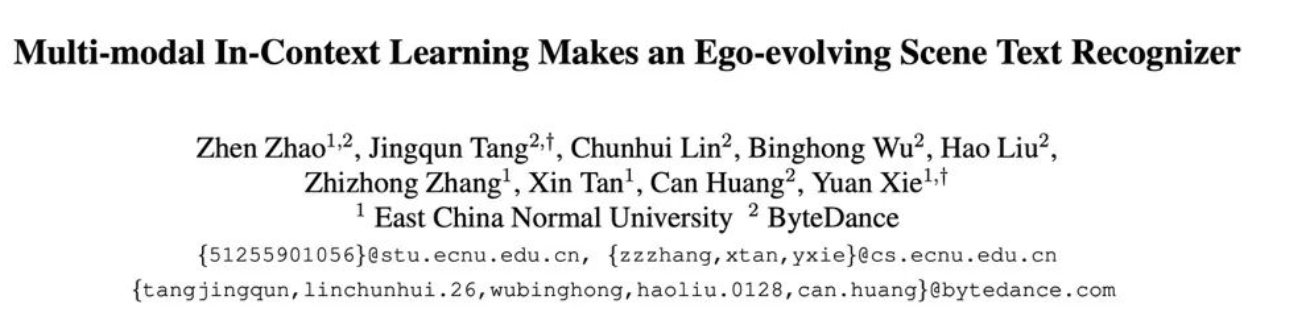

话不多说,下图展示了 的整个训练和推理流程:

1.基础文本识别训练

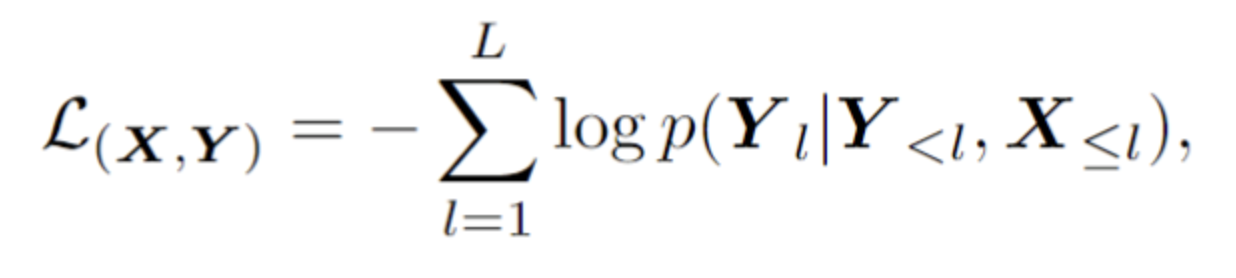

基础文本识别训练阶段采用自回归框架训练视觉编码器和语言解码器:

2.上下文训练

在上下文训练阶段,ESTR将根据文中提出的上下文训练范式进行深入训练。在这一阶段,ESTR将努力理解不同样本之间的关联,并从上下文提示中获得益处。通过这种训练方式,ESTR能够捕捉到文本识别任务中的上下文信息,并将其整合到模型的学习过程中。这种上下文训练的方法使得ESTR能够更好地理解文本出现的背景、语境和相关特征,从而提高在不同场景下的文本识别性能。

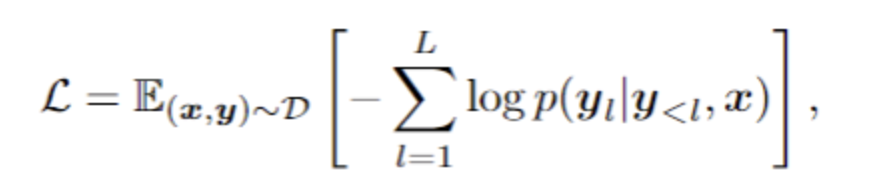

如图2所示,该论文提出了ST(Split and Transform)策略,通过对场景文本数据进行随机的分割和转换,生成一组"子样本"。这些子样本在视觉和语言方面都具有内在联系。为了获得上下文学习的能力,这些内在联系的样本被拼接成一个序列,模型通过自回归框架进行训练,从中学习上下文知识:

3.上下文推理

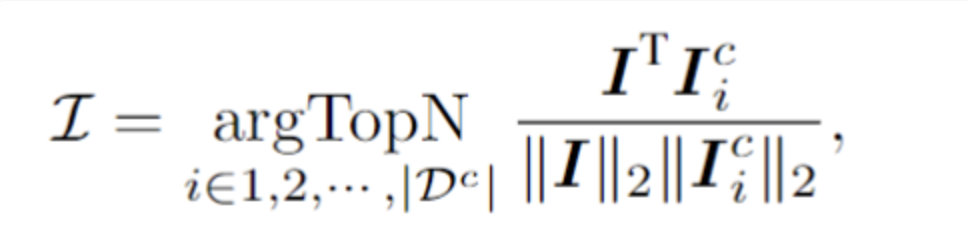

在测试样本上,该框架会从上下文提示池中选择N个样本,这些样本在视觉隐空间与测试样本具有最高的相似度。具体而言,该论文通过对视觉token序列进行平均池化,得到图像嵌入向量。然后,从上下文池中选取与的余弦相似度最高的前N个样本,形成上下文提示。通过这种方式,模型能够从视觉特征的角度选择与测试样本最相似的上下文样本,提供更丰富的上下文信息,以增强文本识别的性能。

将上下文提示和测试样本拼接后输入模型,ESTR以一种无需训练的方式从上下文提示中学习新知识,从而提升测试样本的识别准确率。需要注意的是,上下文提示池仅保留了视觉编码器输出的token,使得上下文提示的选择过程非常高效。此外,由于上下文池的规模较小,并且 能够直接进行推理而无需额外的训练,因此额外的计算消耗也被降到了最低限度。

实验

实验从三个角度进行:

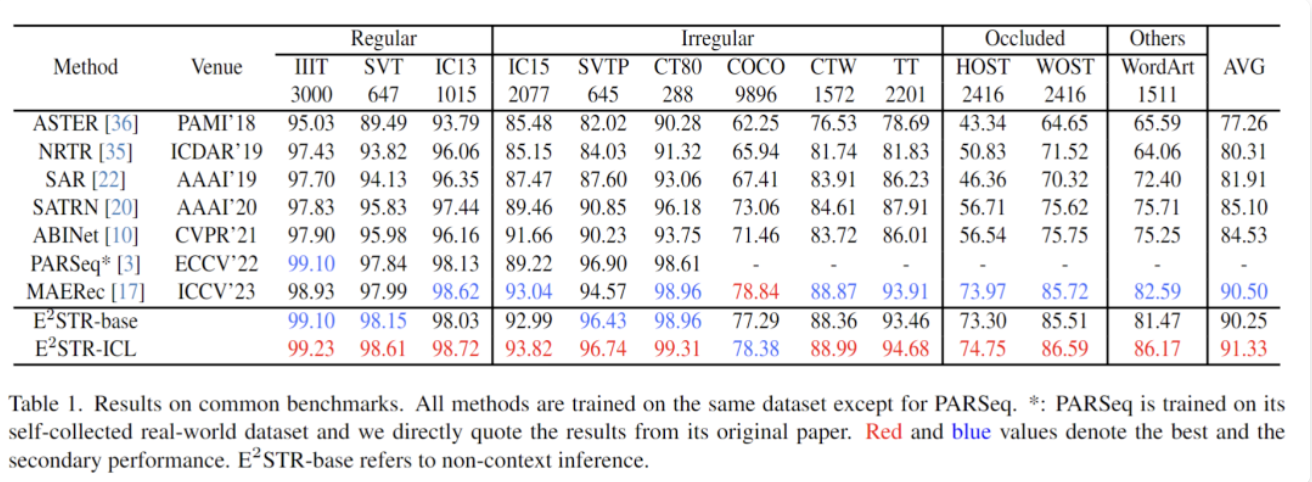

1.传统数据集

从训练集中随机抽取很少的样本(1000个,训练集 0.025% 的样本数量)组成上下文提示池,在12个常见的场景文本识别测试集中进行的测试,结果如下:

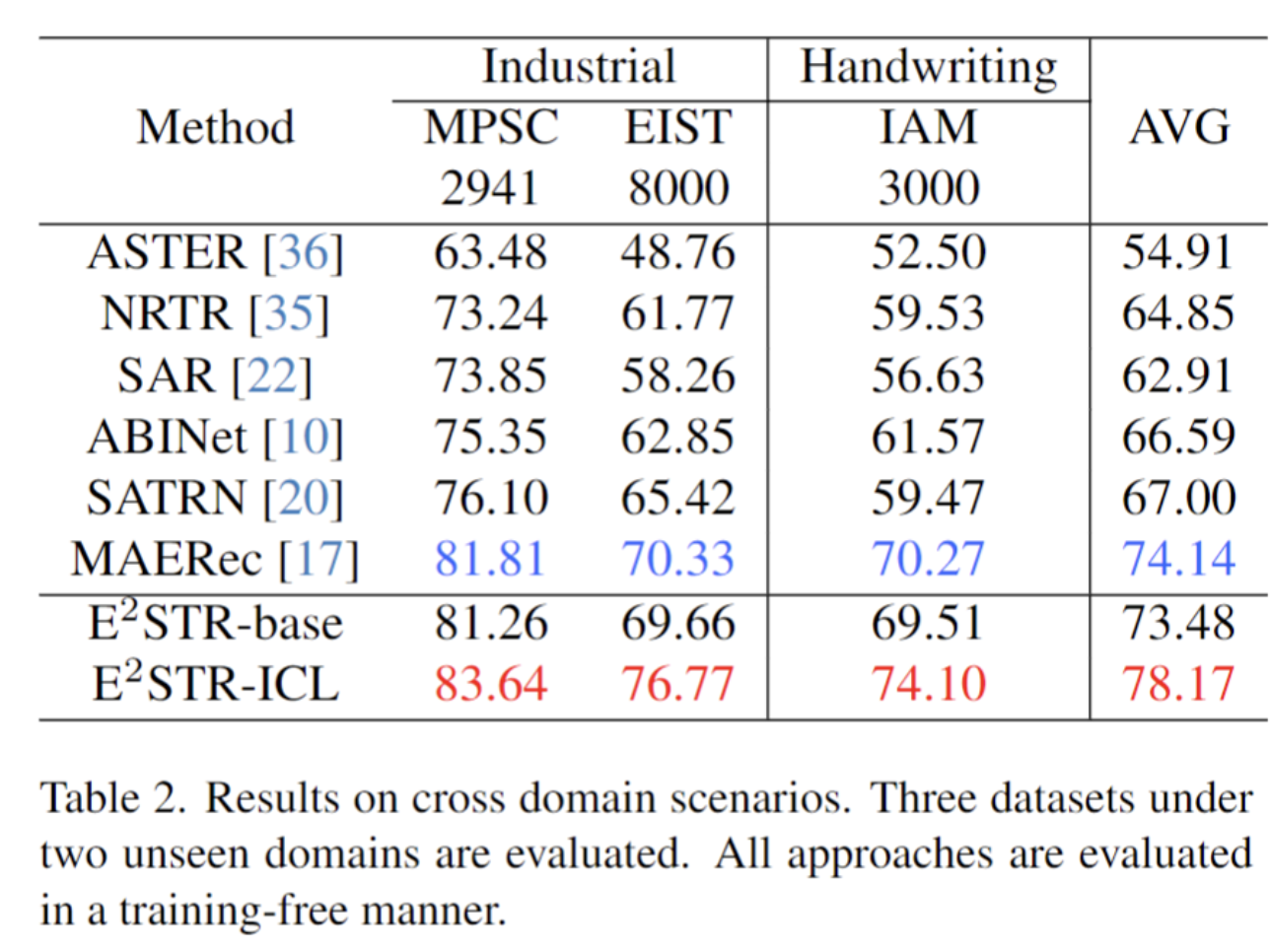

2.跨域场景

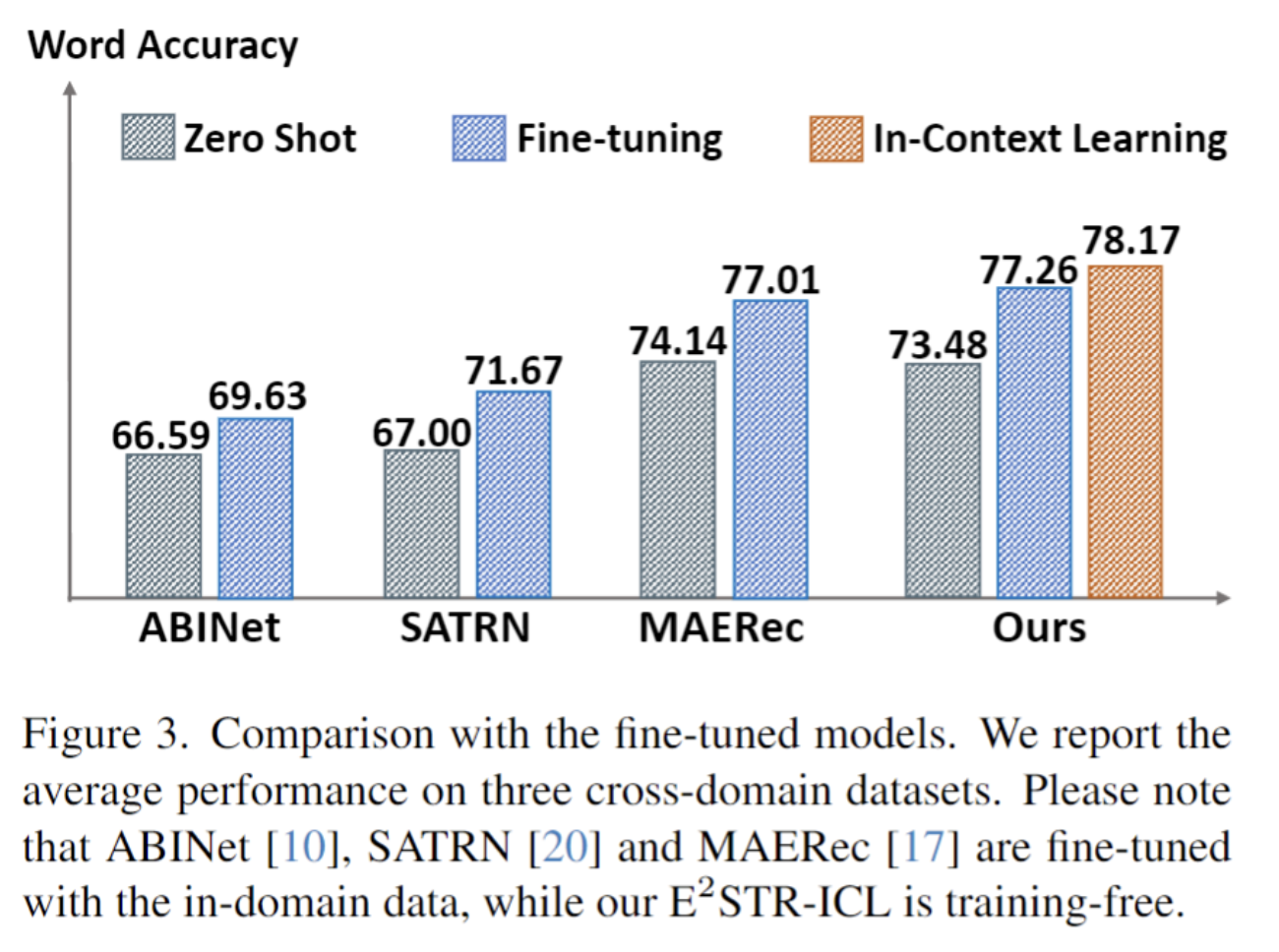

跨域场景下每个测试集仅提供100个域内训练样本,无训练和微调对比结果如下。 甚至超过了SOTA方法的微调结果。

3.困难样本修正

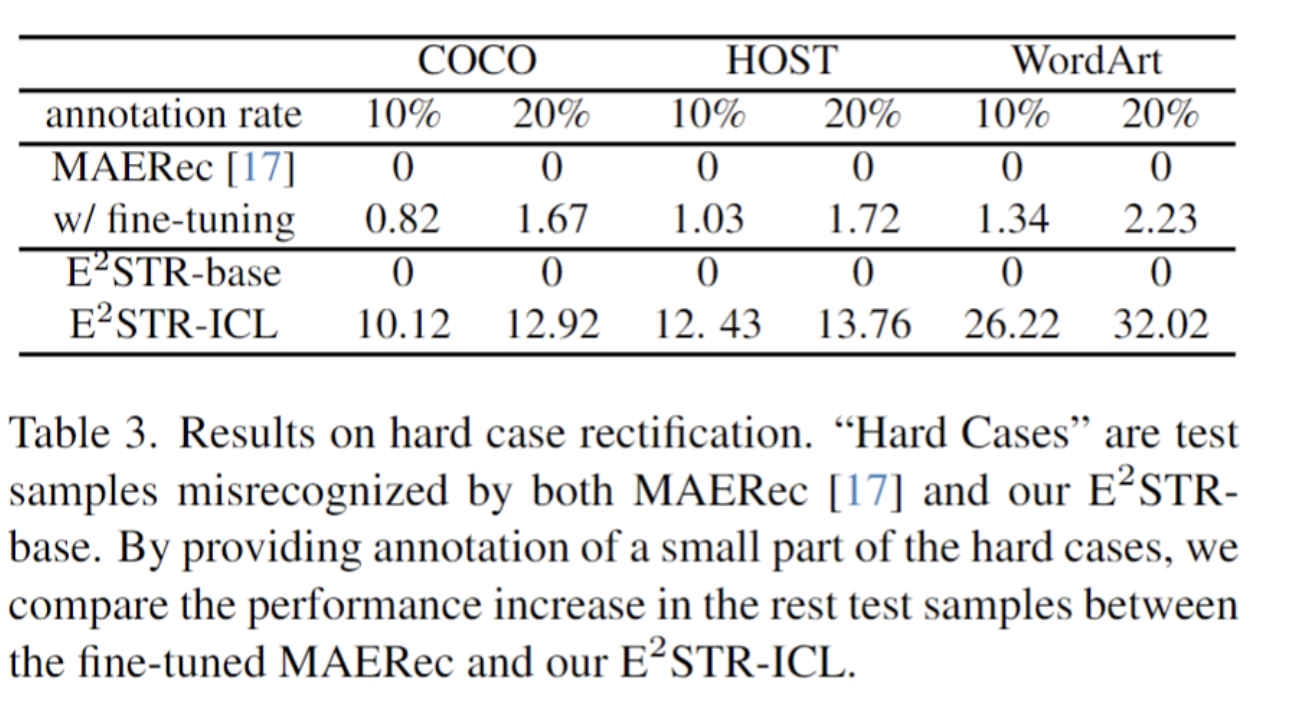

研究人员收集了一批困难样本,对这些样本提供了10%~20%的标注,对比ESTR的无训练学习方法和SOTA方法的微调学习方法,结果如下:

可以发现,大大降低了困难样本的错误率。

未来展望

ESTR的研究结果表明,通过适当的训练和推理策略,即使使用小模型,也能够获得类似于大语言模型(LLM)的上下文学习能力。这一发现对于一些实时性要求较高的任务而言具有重要意义,因为即使使用小模型,也能够快速适应新场景。更重要的是,这种使用单一模型实现对新场景快速适应的方法使得构建统一高效的小模型变得更加可行。这意味着我们可以利用小模型的优势,同时在不同场景下获得高效的性能,而无需为每个特定场景构建专用模型。

作者:派派星

文章来源:CVHub

推荐阅读

- 华为诺亚实验室+中科大提出TinySAM | 比SAM小10倍,但是依旧完成了精度的超车!

- 苹果发布开源多模态大语言模型Ferret

- 2D检测教3D检测做事情,YOLOv7让BEVFusion无痛涨6个点,长尾也解决了

- 你有多久没看过人脸识别的文章了?X2-SoftMax开源,ArcFace与MagFace都黯然失色了

更多嵌入式AI干货请关注嵌入式AI专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。