昨天,腾讯团队发表了一篇论文:AppAgent: Multimodal Agents as Smartphone Users,同时开源了代码。该框架设计的初衷,是让 AI 智能体去自己操作手机,完成特定的任务。

论文链接:https://arxiv.org/pdf/2312.13771.pdf

Github 仓库:https://github.com/mnotgod96/AppAgent

该框架使智能体能够通过简化的操作空间来操作智能手机应用程序,模仿人类的交互,如点击和滑动。这种新颖的方法绕过了对系统后端访问的需要,从而扩大了它在不同应用程序中的适用性。

大家可以看一下下图,下图是我把原图翻译成中文了,其中的“代理”,就是智能体,这是AI翻译错了。

这个智能体功能的核心是其创新的学习方法。智能体通过自主探索或观察人类演示来学习导航和使用新的应用程序。这个过程生成一个知识库,智能体在跨不同应用程序执行复杂任务时引用该知识库。

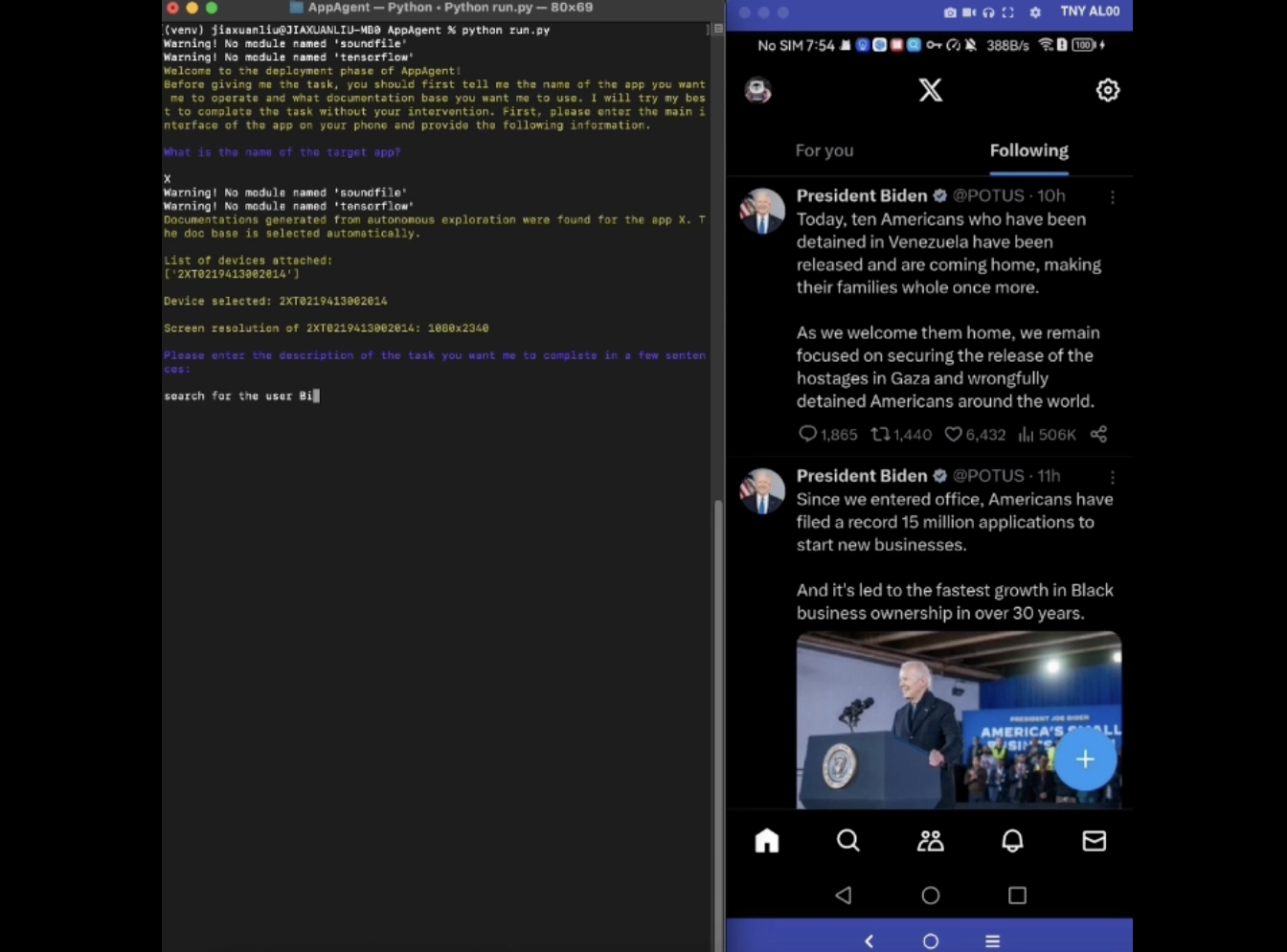

下面这个视频是 AppAgent 学会如何在推特上关注比尔盖茨。

我看了一下这个项目的介绍,这个智能体的核心是两个,先观察学习或者自主探索,然后就可以让它去执行你想要它干的任务了。

作者是使用的 GPT-4V 版本来作为智能体的。具体操作步骤大家可以去 Github 看一下,这里就不具体搬运了。

主要的就是配置手机连接电脑,配置 GPT-4V。

下面介绍一下核心的探索学习阶段。

探索阶段

这篇论文提出了一个新颖的解决方案,其中涉及两个阶段,即探索学习和部署阶段,将GPT-4V变成有能力的智能体,可以帮助用户在给出任务时自动操作其Android手机。探索阶段从您提供的任务开始,您可以选择让智能体自行探索该应用程序,或者从演示中学习。在这两种情况下,智能体都会生成一份交互文档,以在部署阶段使用。

选项1:自主探索

该方案是完全自主的探索,该探索使智能体可以通过尝试给定任务而无需任何人为干预,从而探索应用程序的使用。

首先,在根目录中运行Learn.py。请按照提示的说明选择自主探索作为操作模式,并提供应用程序名称和任务描述。然后,您的智能体将为您完成这项工作。在这种模式下,App Agent将反思其先前的操作,以确保其动作遵守给定的任务并为所探索的元素生成文档。

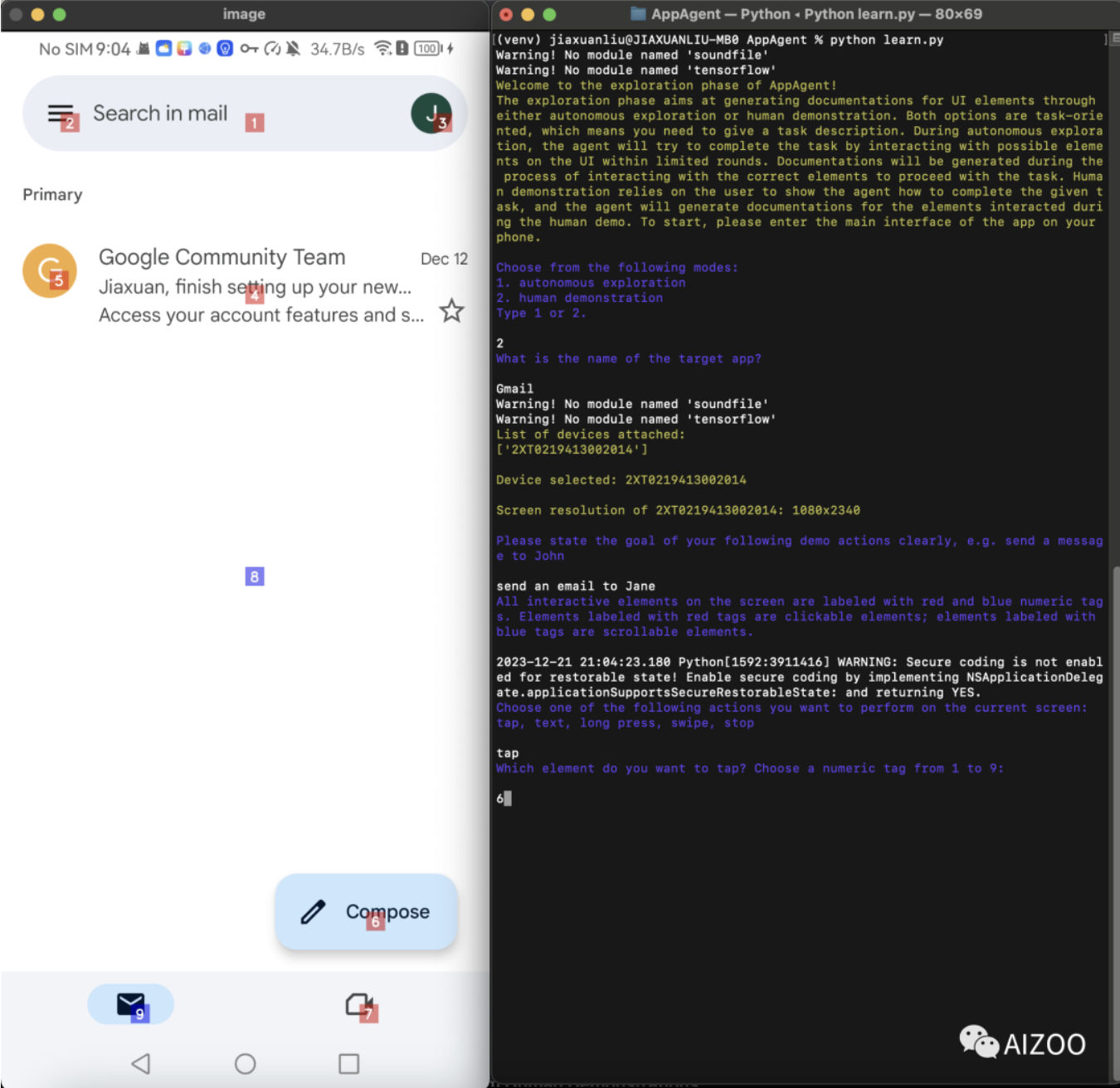

选项2:从人类示范中学习

该解决方案要求用户首先演示类似的任务。App Agent将从演示中学习,并为演示过程中看到的UI元素生成文档。

要开始人类演示,您应该在根目录中运行Learn.py。请按照提示的说明选择人类演示作为操作模式,并提供应用程序名称和任务描述。手机的屏幕截图将被捕获,屏幕上显示的所有交互式元素都将带有数字标签。您需要遵循提示,以确定您的下一个动作和动作的目标。当您相信演示完成时,请键入结束演示。

下图是人来教会它如何用 Gmail 来发邮件。主要就是 AI 问,人来回答,这样就把 AI 教会了。

AI 自己去执行任务

探索阶段完成后,你可以给出 APP 名字,并提出任务。然后,这个智能体将为你完成这项工作。智能体将自动检测到应用程序之前生成的文档基础;如果找不到文档,您也可以选择在没有任何文档的情况下运行智能体(但事不保证100%成功)。

大致看了一下这个论文,作者应该是让 AI 会自己操作手机来完成特定任务,虽然感觉有点扯,但是长远来看,AI 距离跟人一样玩手机,完成特定任务,的确更近了一步。

作者:元峰

文章来源:AIZOO

推荐阅读

- 【YOLOv8新玩法】姿态评估解锁找圆心位置

- TVM TensorIR与TE的Schedule介绍

- 中科院自动化所提出Drive-WM | 第一个端到端自动驾驶世界模型,带领ADAS走向未来

- 首创!BEV-CV:用鸟瞰视角变换实现跨视角地理定位

更多嵌入式AI干货请关注嵌入式AI专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。