天下武功,唯快不破。

作者|苏霍伊

编辑|赵健

本周,一匹 AI 芯片黑马 Groq 在业内走红。

Groq 推出了一款全新的 AI 芯片 LPU(Language Processing Unit),宣称做到了“地表最强推理”——在 Groq 上运行大模型的推理速度,较英伟达 GPU 提高 10 倍,而成本只有其十分之一。

在 Groq 发布的同期,英伟达的股价巧合地连续四个交易日下跌,一直到昨天财报发布。

Groq 上的大模型每秒能够输出大约 500 个 token,而 ChatGPT-3.5 的公开版本每秒只能生成大约 40 个 token。Groq 云服务的对外开放,让大家切身感受到了不卡顿的了对话机器人用起来有多爽。

Groq 在社交平台 X 信心爆棚地表示:“这不是进化,而是一场革命。”

随着 Sora 的火爆,多模态大模型对 AI 算力的消耗更高,英伟达的 GPU 芯片一卡难求,算力短缺成为很多 AI 公司面临的头等难题。“天下苦皮衣刀法久矣”,Groq 的横空出世,或为市场带来了一种全新的选择。

有 AI 开发者称赞 Groq 或为低延迟产品的“革命者”。ArtificialAnalysis.ai 联合创始人 Micah Hill-Smith 表示,Groq 代表了可用速度的进一步变化,为 LLM 提供了新的用例。更有用户则认为它有潜力“替代英伟 A100 和 H100 芯片的高性能硬件”。

Groq 真实水平到底如何?它的 LPU 能否实现替代英伟达 GPU ?

1.“地表最强”推理芯片

Groq 推理速度到底有多快?「甲子光年」对 Groq 和 GPT-4 提了一个相同且不需要复杂推理的问题:什么是中性粒细胞?

Groq 在 6 秒左右就给出了完整回答。而 GPT-4 几个字符地往外“蹦”答案的时间大约是 25 秒。

随后,我们又分别对 GPT-4 与 Groq 下达相同的指令—— 从 1 数到 100。 Groq 用时 5 秒左右,而 GPT-4 用时长达 32 秒。

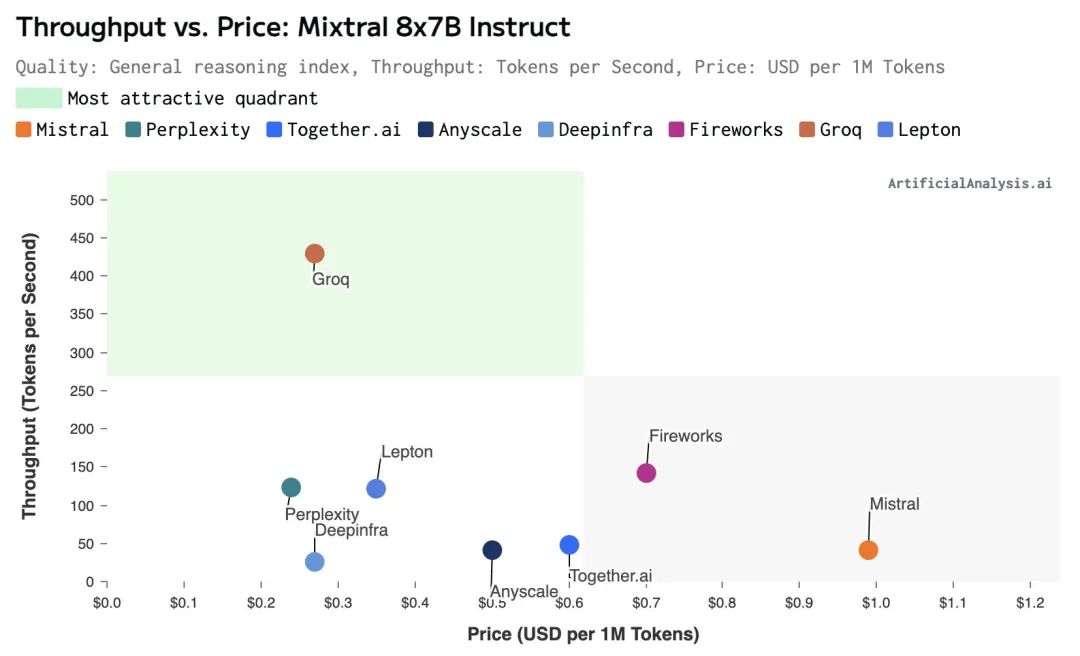

依据 ArtificialAnalysis.ai 数据显示,Groq 推出的 Mixtral 8x7B Instruct API,以每秒处理约 430 个 token 的速度,这刷新了业界吞吐量的历史记录。而且其每百万个 token 的价格仅为 0.27 美元,击败了 Mistral、Lepton 等。

同时,在最新的 LLM 基准测试中,Groq 每百万 token 价格最低,并在延迟与吞吐量等关键性能指标上击败了 Microsoft Azure、Perplexity 等。其处理吞吐量是其他推理服务的 4 倍,同时收费却低于 Mistral 自己的 1/3。

在令人眼花缭乱的 AI 产品中,Groq 为何能脱颖而出?主要在于其独具特色的技术路径。

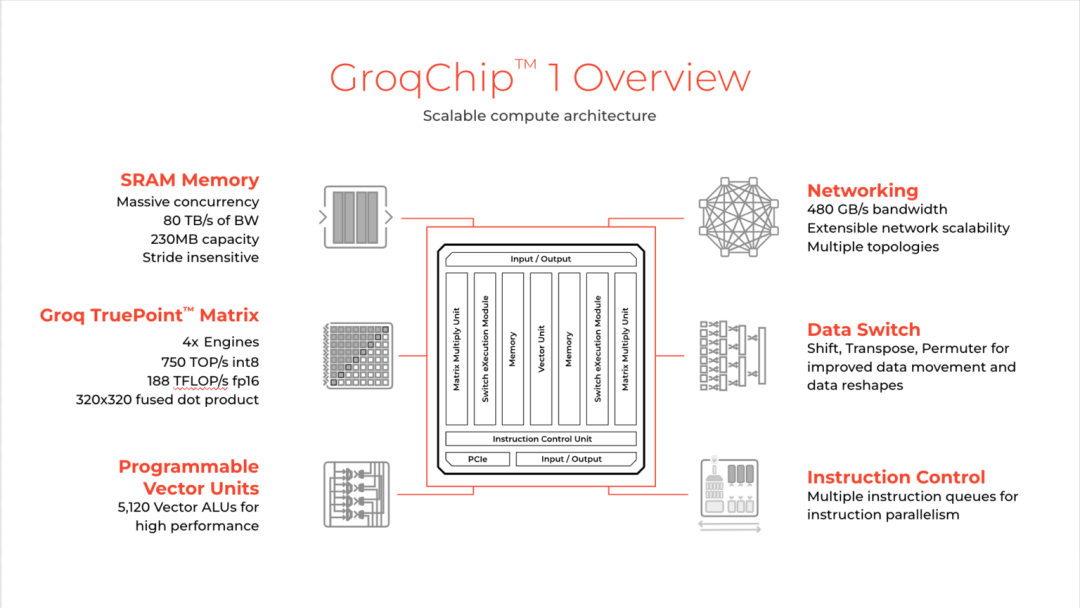

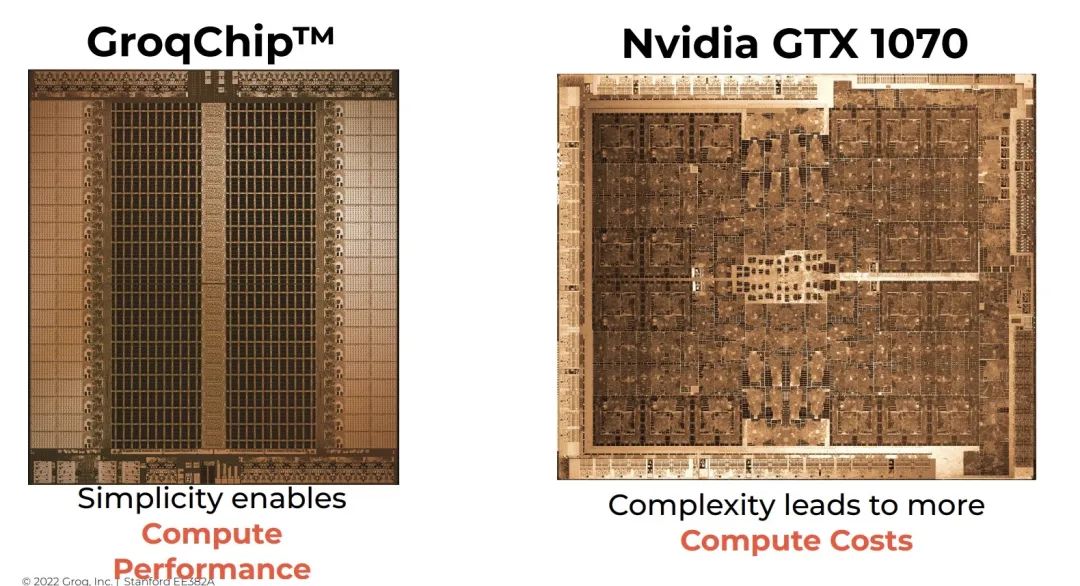

根据 Groq 的论文,他们从头设计了一个张量流处理器(Tensor Streaming Processor,TSP)微架构设计 。这个架构不是开发小型可编程内核并对其进行数百次复制,而是容纳一个具有数百个功能单元的单个处理器。

为了组织多个 TSP,Groq 设计了一个名为 Dragonfly 的网络,它采用多级层次化结构,通过几个层次的路由器连接不同的子组,提供高带宽容量和低通信延迟,这对于机器学习任务而言十分重要。

简单来说,Groq 的 TSP 技术就像是一个交通系统,通过软件控制红绿灯,让所有同一方向的车辆在一条路上快速前进,从而大大提高了效率和速度。

不同于传统的 CPU 和 GPU 架构,Groq 团队为其大语言模型量身定制了专用芯片,它能在速度上取胜的核心技术是首创的 LPU 技术,LPU 主要解决计算密度和内存带宽这两大瓶颈。

Groq 的芯片采用成熟的 14nm 制程,搭载了230MB 的 SRAM 来保证内存带宽,片上内存带宽达到了 80TB/s。在算力层面,Gorq 芯片的整型(8位)运算速度为 750TOPs,浮点(16位)运算速度则为 188TFLOPs。

需要注意的是,尽管 Groq 媒体称为“最快大模型”,但事实上 Groq 并没有研发新模型,它只是一个模型启动器,主页上运行的是开源模型 Mixtral 8x7B-32k 和 Llama 270B-4k 。

Groq 对此发文解释道:“我们不是大型语言模型。LPU 推理引擎是一种新型的端到端处理单元系统,可为具有顺序组件的计算密集型应用程序提供最快的推理,例如 AI 语言应用程序 。” 换言之,它只提供推理,不能用来训练大模型。

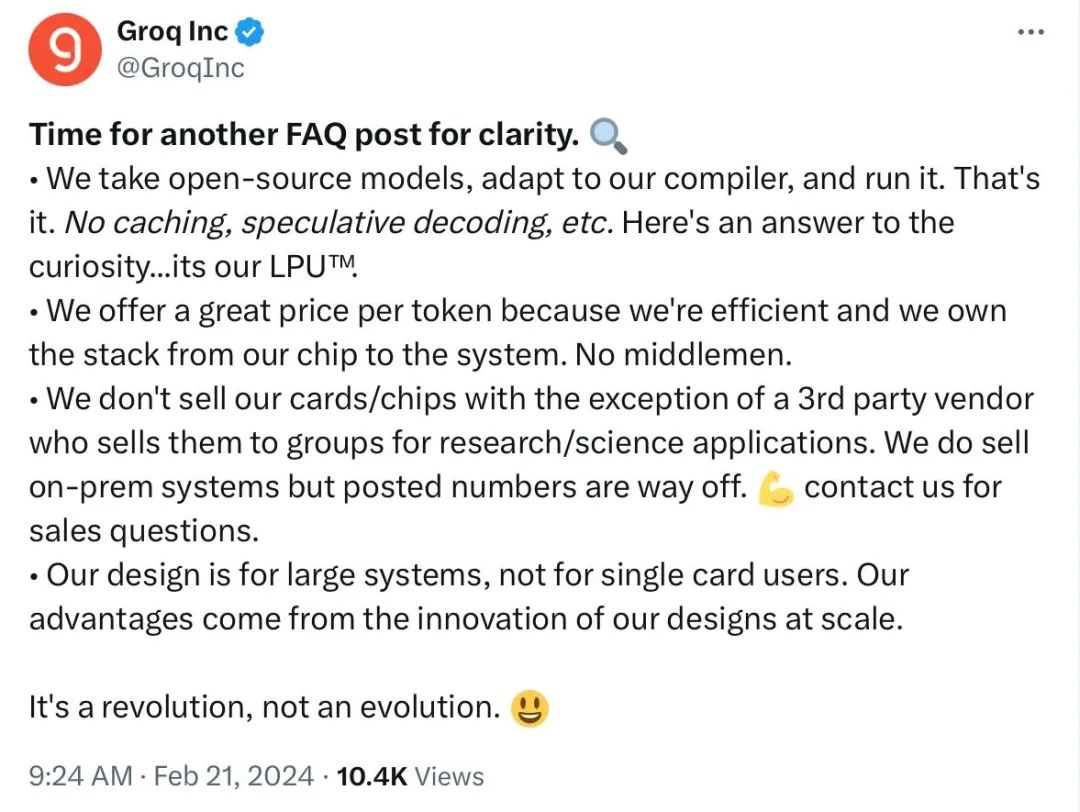

同时,Groq 还在社交平台上解答用户较为关心的问题:

LPU 能为每 token 提供良好的价格,因为效率高而且拥有从芯片到系统的堆栈,且没有中间商;

我们不卖卡/芯片,除非第三方供应商将其出售给研究/科学应用团体,但我们出售本地部署系统;

我们的设计适用于大型系统,而不是单卡用户,Groq 的优势来自大规模的设计创新。

2.为什么 Groq LPU 比 Nvidia GPU 速度更快?

与传统的 GPU 和 CPU 相比,LPU 提供了更高的计算能力,这使得在处理每个单词时所需的计算时间大大减少,进而能够更迅速地生成文本序列。

Groq 的 LPU 不需要像 Nvidia GPU 那样快速的数据传输。与利用高带宽内存(HBM)的 GPU 不同,Groq 的 LPU 利用 SRAM 进行数据处理,其速度比 GPU 所用的存储器快约20倍。

它使用时序指令集计算机(Temporal Instruction Set Computer)架构,因此不必像使用高带宽内存(HBM)的 GPU 那样频繁地从内存中重新加载数据。这有助于避免 HBM 短缺的问题和降低成本。

由于推理运行使用的数据比模型训练少得多,因此 Groq 的 LPU 更节能。它从外部存储器读取的数据更少,推理任务的耗电量也比 Nvidia GPU 低。Groq 芯片的独特架构与其时间指令集相结合,可实现自然语言和其他顺序数据的理想顺序处理。

不过,想要挑战英伟达 GPU 的霸主地位绝非易事,从成本等方面来看,Groq 芯片目前还无法与之分庭抗礼。

Grop 芯片部署起来并不便宜。

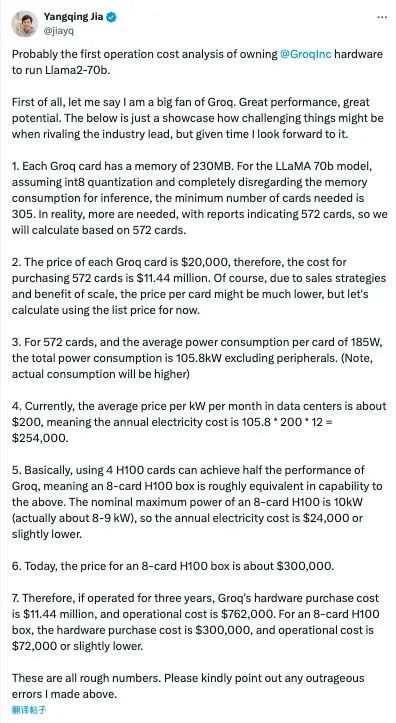

原 Meta 人工智能科学家、原阿里技术副总裁贾扬清做了一番估算,指出由于 Groq 的内存容量较小,在运行 LLaMa2 70B 模型时需要使用 305 张 Groq 卡,而使用 NVIDIA 的 H100 卡只需要 8 张。这相当于 Groq 的硬件成本大约是 H100 的 40 倍,而其能源成本则是 10 倍。

每张 Groq 卡的内存为 230 MB。考虑到 LLaMA 70B 模型,假设使用 int8 量化技术,并完全忽略推理过程中的内存消耗,则至少需要 305 张卡。实际上,有报告指出需要 572 张卡片,因此我们的计算将基于这个数字。

每张 Groq 卡的价格为 20000 美元,因此,购买 572 张卡片的成本为 1144 万美元。考虑销售策略和规模效应,每张卡的价格可能会低得多,但现在让我们先按照标价计算。(每张卡的 BOM 应该约为 1000 美元— 2000 美元。)

对于 572 张卡片,平均每张卡的功耗为 185W,总功耗达到 105.8kW,这还不包括附加的外围设备。(实际的能耗可能会更高)

目前,数据中心每千瓦每月的电费平均为 200 美元,这意味着每年的电费为 105.8 200 12 = 25.4 万美元。

基本使用 4 张 H100 卡可以实现 Groq 一半的性能,这意味着一个 8 卡 H100 盒子在能力上大致相当于上述配置。一个 8 卡 H100 的名义最大功率为 10kW(实际约为 8-9 kW),因此年电费为 24000 美元或略低。

目前,一个 8 卡 H100 盒子的价格约为 30 万美元。

因此,如果运营三年,Groq 硬件的购买成本是 114.4 万美元,运营成本为 76.2万。而对于一个 8 卡的 H100 盒子,硬件购买成本为 30 万美元,运营成本约为 7.2 万或稍低。

在这条 X 文字下,Groq 的CEO Jonathan Ross 回复到:“我们对当前的 token 即服务的定价感到非常满意。非常。其他人对 TaaS 的定价感到满意吗? ”

对此,贾扬清回复他:“坦白说,我们对目前的 Token 价格加上速度服务等级协议的组合并不满意。换句话说,我们对 Token 的价格是满意的,但如果有人大量并行调用 API,不保证速度。”

Groq 架构的特点是小内存和大算力,适合频繁数据搬运的场景,速度快但单卡吞吐能力有限,需要更多卡来保证同等吞吐量,速度既是优势也是劣势。

此外,由于 GPU 的生态极为发达,其中英伟达的 GPU 不仅性能强大,在性能卓越的同时,还聚集了大量用户和丰富的生态环境。

相比之下,Groq 目前仅能为少数大型模型提供服务,想要在低延迟领域建立持续优势,需要拓宽服务范围并进一步减少总体成本。

3.谷歌TPU发明者创立

虽然最近才火爆全网,但 Groq 公司并非初出茅庐的新创企业。

Groq 成立于2016年,是一家 AI 芯片公司由前谷歌员工 Jonathan Ross 创立。他曾发明了驱动谷歌机器学习软件的张量处理单元(TPU),这两项技术当时为 AlphaGo 提供了重要的技术支撑。

2016 年,谷歌 TPU 团队中有 8 名成员跟随 Jonathan 离开了谷歌。产品主管 John Barrus 曾在谷歌及亚马逊担任产品高管。高管内唯一一位华裔面孔、副总裁 Estelle Hong,在公司任职已有四年,此前曾供职于美国军队及英特尔。

虽然团队脱胎于谷歌 TPU,但 Groq 既没有选择 TPU 这条路,也没有看中 GPU、CPU 等路线。Groq 选择了一个全新的系统路线,也就是上文提到的 LPU。

2017 年,这家初创公司从风险投资家 Chamath Palihapitiya 那里获得了 1030 万美元的资金;2021 年 4 月,Groq 从 D1 Capital 、Tiger Global Fund 等机构融资 3 亿美元的。

2023 年8月,Groq 宣布,三星代工的 Taylor 工厂将生产它的 4 纳米 AI 加速器芯片。据悉,Groq 是 Taylor 工厂公开知名的首个客户。

2023 年 11 月,当马斯克准备发布人工智能模型 Grok 时,一度想用 Groq 命名,于是 Groq 公司的开发者们就发了一篇文章说马斯克撞名自己的公司,呼吁马斯克选择另外的名字,但这篇文章并未引起什么波澜。

Jonathan Ross 表明,Groq 的宗旨在于缩小社会贫富差异,并支持 AI 社区内每位成员的发展。他还强调,逻辑推理对于达成这个目标极为重要,因为速度是将开发人员的想法转化为业务解决方案和改变生活的应用程序的关键。

RAM对文章亦有贡献。