近日,通义实验室推出了手机端智能体Mobile-Agent。输入一句指令,AI可以作为智能中枢,根据指令在手机上自动规划和操作各种APP,操作场景包括但不限于导航、购物、组织电话会议、更改系统设置,其准确程度如同人类在操作手机一般,通过Mobile-Agent,用户将拥有一个手机端的超级智能助理,通过指令就可以使用手机端已授权app完成任务。

Github:

论文:

https://arxiv.org/abs/2401.16158

ModelScope Demo:

https://www.modelscope.cn/studios/wangjunyang/Mobile-Agent/summary

Hugging Face Demo:

https://huggingface.co/spaces/junyangwang0410/Mobile-Agent

即使是具有挑战性的多APP切换场景,Mobile-Agent也能得心应手。凭借智能体对操作历史的记忆,Mobile-Agent可以实现信息在APP之间的传递和加工。

技术亮点

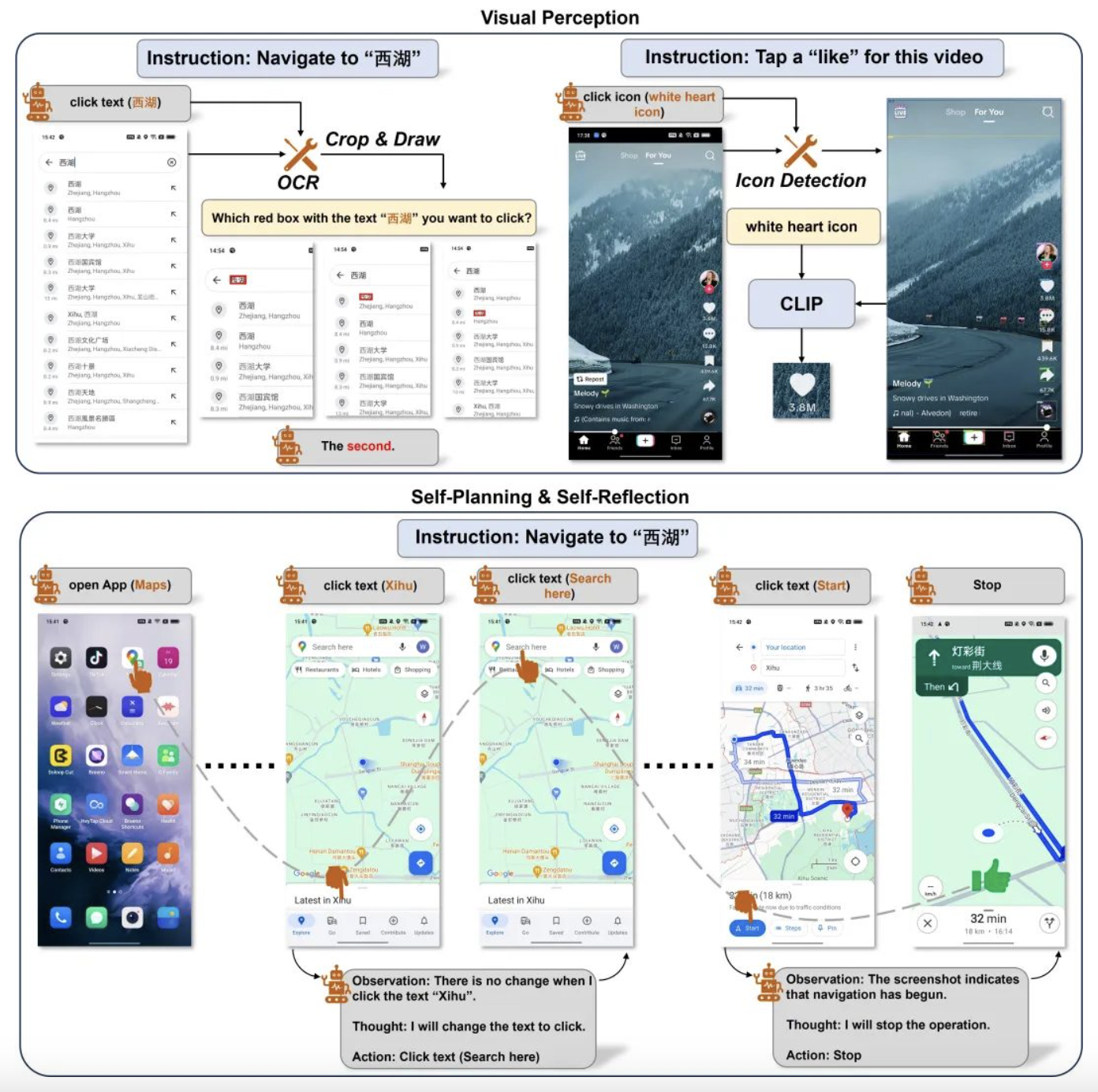

- 纯视觉解决方案:仅需感知截屏内容即可生成操作,不依赖APP的UI布局文件或系统底层代码

- 操作场景不受限:可以在手机桌面或APP内部进行操作,从而完成更复杂的操作内容

- 视觉感知工具定位:使用文字识别和图标识别模块用于定位需要操作的区域

- 即插即用:无需任何探索和训练过程

Agent架构

操作空间

我们定义了Mobile-Agent生成的操作范围:

- 打开App(App名字)

- 点击文本(文本内容)

- 点击图标(图标描述)

- 打字(文本内容)

- 上翻、下翻

- 返回上一页

- 退出App

- 停止

其中,点击文本和点击图标是两个需要操作定位的操作,因此Mobile-Agent在使用这两个操作时,必须输出括号内的参数,以实现定位。

操作定位

现有工作表明,即使是最先进的GPT-4V,也无法提供准确的操作坐标。Mobile-Agent利用MLLM产生的正确操作,通过额外的操作定位工具实现操作定位,这包括两种视觉感知工具,分别是文字识别模块和图标识别模块。

自我规划

Mobile-Agent以迭代方式完成每一步操作。在迭代开始之前,用户需要输入一个指令。我们根据指令生成整个流程的系统提示。在每次迭代开始时,Mobile-Agent会获取手机屏幕的截图,通过观察系统提示、操作历史和当前屏幕截图,输出下一步操作。

自我反思

Mobile-Agent会在两种情况下进行反思。第一种情况是生成了错误或无效的操作,导致进程卡住。当Mobile-Agent注意到某个操作后截图没有变化,或者截图显示了错误的页面时,它会尝试其他操作或修改当前操作的参数。第二种情况是忽略某些复杂指令的要求。当通过自我规划完成所有操作后,Mobile-Agent会分析操作、历史记录、当前截图和用户指令,以确定指令是否已完成。

能力评估

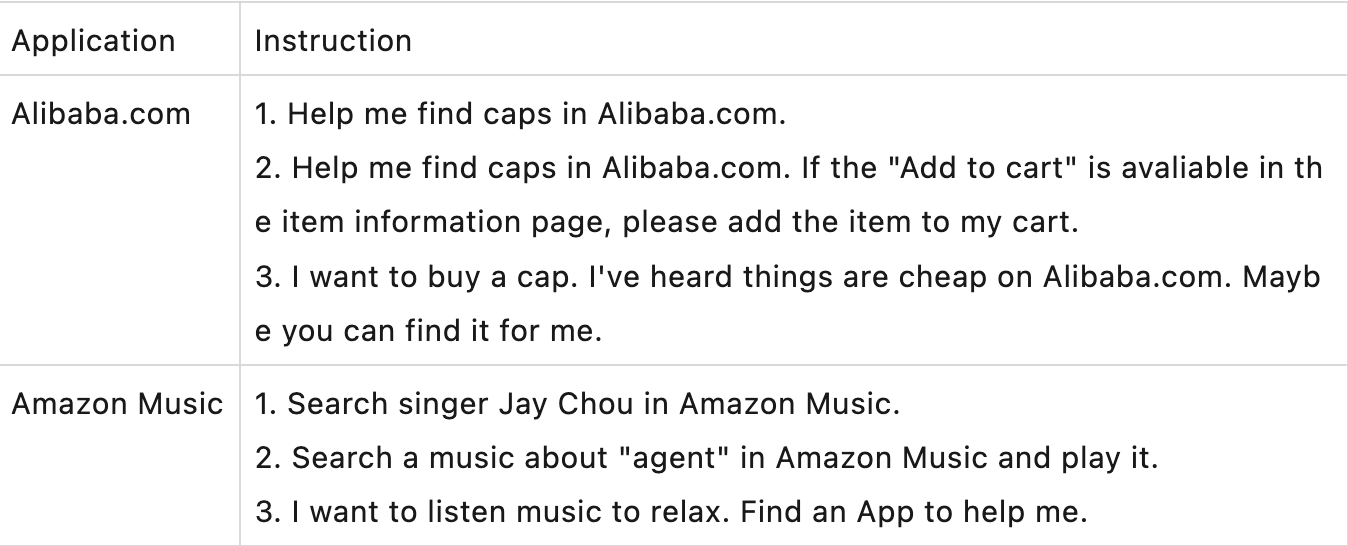

为了全面评估 Mobile-Agent 的能力,本工作引入了 Mobile-Eval,这是一个基于当前主流应用程序的benchmark。Mobile-Eval 共包含 10 个移动设备上常用的应用程序。为了评估多应用程序使用能力,Mobile-Eval还引入了需要同时使用两个应用程序的指令。Mobile-Eval为每个应用程序设计了三种指令。

第一条指令相对简单,只要求完成基本的应用程序操作。第二条指令在第一条指令的基础上增加了一些额外要求,使其更具挑战性。第三条指令涉及抽象的用户指令,即用户不明确指定使用哪个应用程序或执行什么操作,让agent自己做出判断。下面的表中展示了 Mobile-Eval 中的部分例子。

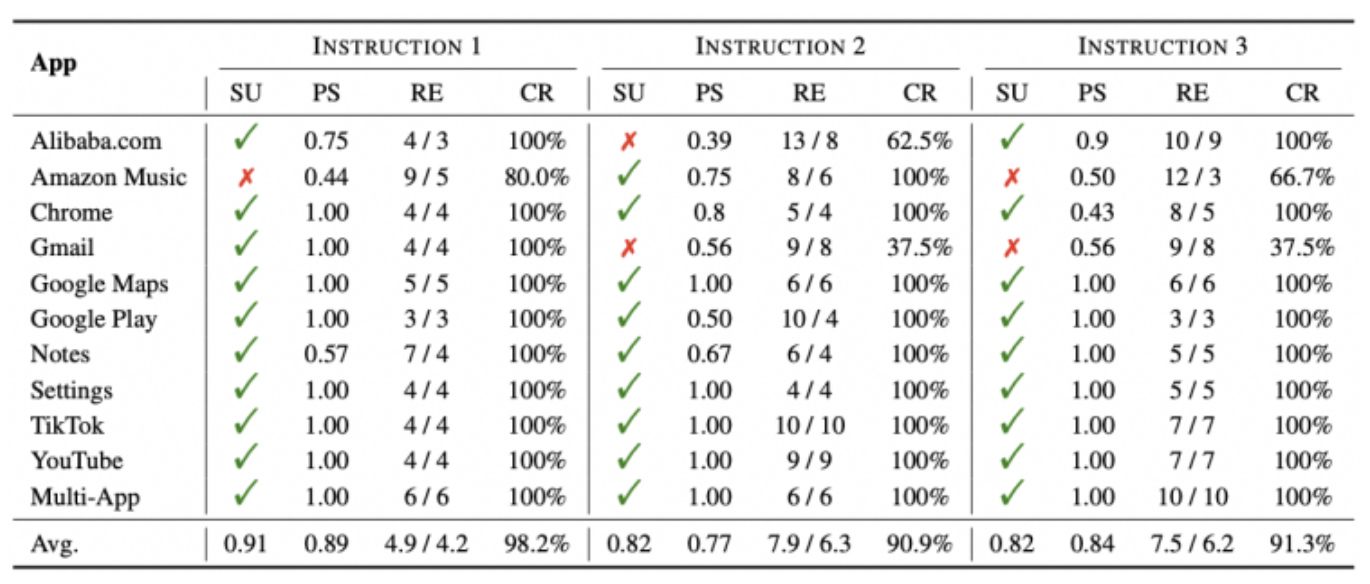

下表中展示了Mobile-Agent的评测结果。其中SU代表指令是否完成,PS代表正确操作占所有操作的比例,RE代表Mobile-Agent和人类完成指令时分别用了多少步,CR是Mobile-Agent能够完成的操作占人类操作的百分比。在3种指令上,分别达到了91%、82%和82%的成功率,在完成度上,3种指令都达到了90%以上,并且Mobile-Agent可以达到90%人类的效果。值得注意的是,虽然PS平均只有85%左右,但是在总共的33个任务上,Mobile-Agent能够完成28个,这也说明了自我反思的重要性,即使会出现错误操作,也能够及时发现并纠正,最终完成任务。

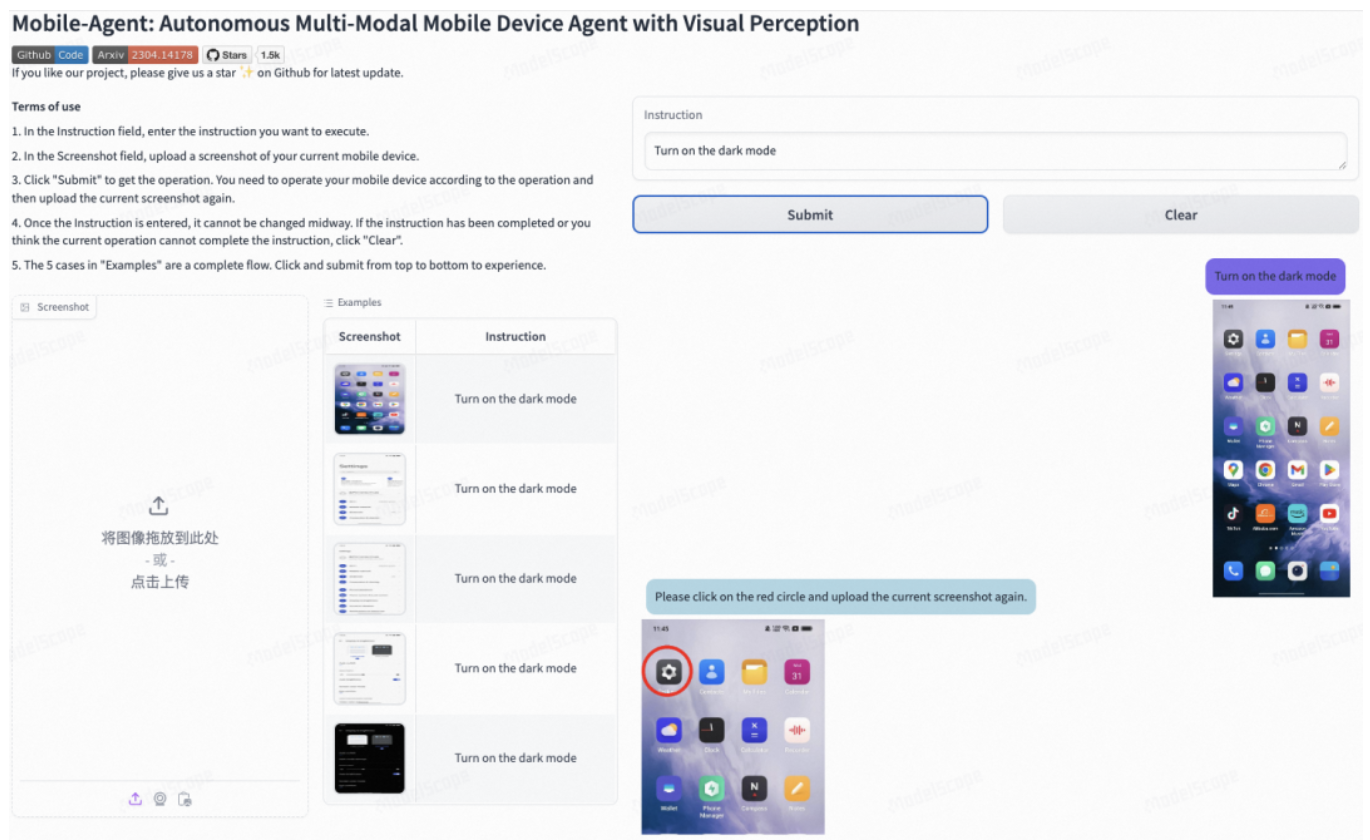

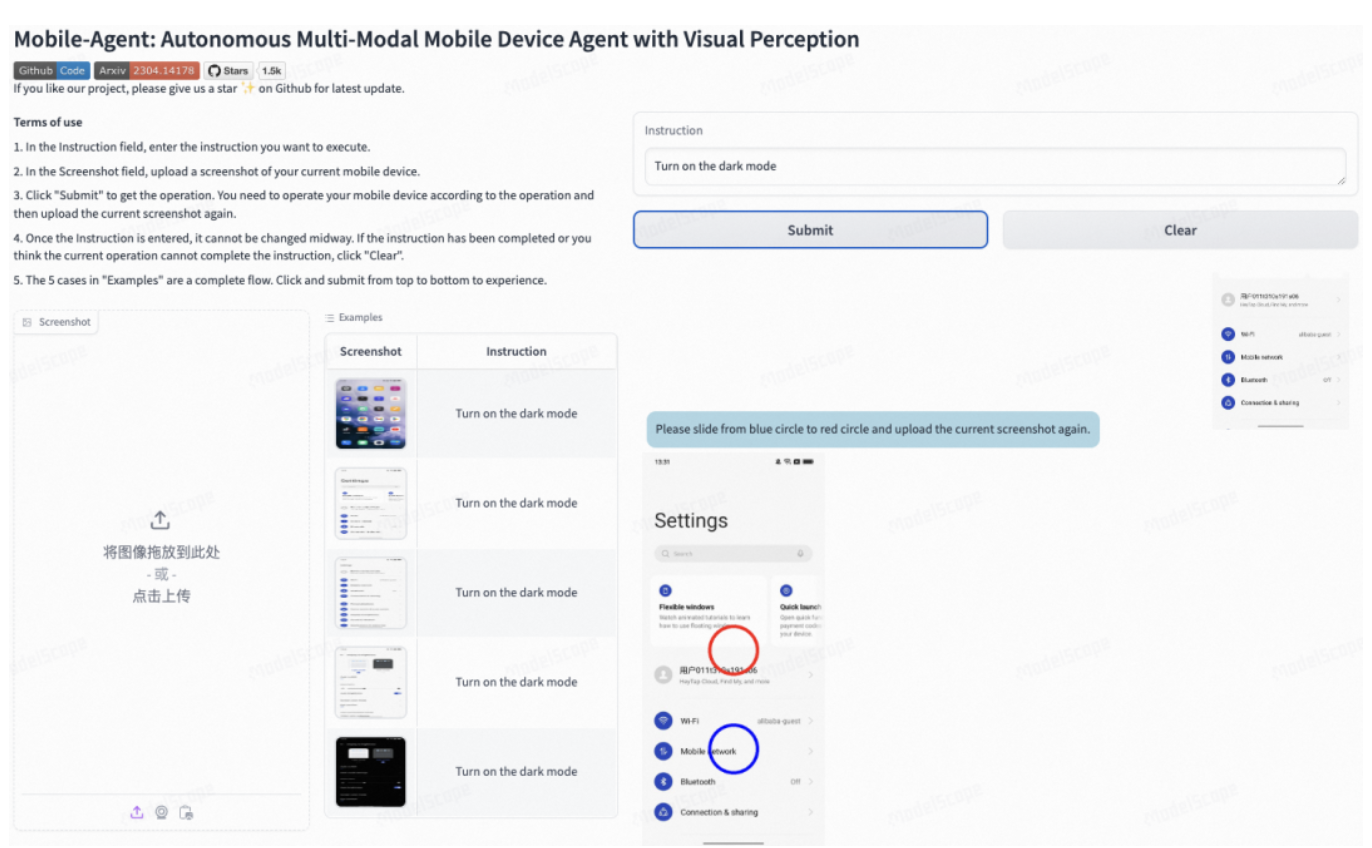

ModelScope实战

我们在魔搭ModelScope创空间上提供了可以上传手机截屏的Demo,Mobile-Agent将以对话的方式展现具体的操作。在创空间搜索“Mobile”,即可找到体验区。

地址:https://www.modelscope.cn/studios/wangjunyang/Mobile-Agent/summary

输入一张截屏和指令,就能得到Mobile-Agent想要执行的操作。

按照操作说明操作你的手机后,再将当前的手机截屏再次上传,得到下一步的操作。

未来展望&开源共建计划

MobileAgent目前仅可通过安卓开发工具在自己的授权手机上实践,想象一下,随着技术的推进,未来每个人都有一个手机/pad/VR/车载等任何移动端的超级助理,在你繁忙的家务时,让AI给小朋友生成并播放绘本故事,在你开车路上发现忘了重要纪念日的时候,及时的买上一束花,在你开会的时候,自动整理会议纪要,并形成日历里的日程安排。

下一步,我们将会:

- 优化中文场景的效果,解决中文场景下的幻觉问题

- 基于自研多模态大模型mPLUG,降低使用成本并提升响应速度

- 集成ModelScope Agent,提升开发者使用效率

欢迎star&加入!

Github:https://github.com/X-PLUG/MobileAgent

作者:王君阳

文章来源:魔搭ModelScope社区

推荐阅读

- 编译入门那些事儿(4):MLIR概述

- 编译入门那些事儿(3):不透明指针

- 安卓率先跑通多模态大模型,终端本地就能看图生成文本!高通:WiFi都会AI起来

- Safety-Adapted Loss | 让行人目标检测器也具有安全意识,行人不被漏检误检

更多嵌入式AI干货请关注嵌入式AI专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。