在浏览 Reddit 网站时,我遇到了有关在 Raspberry Pi 上运行 LLM 的讨论。

于是我很想验证这个“说法”,所以我决定在我的 Raspberry Pi 4 上使用 Ollama 本地运行大语言模型。

现在让我在这篇简短的文章中与各位分享自己的实践。

本文假设您对人工智能、大语言模型和其他相关工具和术语有基本的了解。

在 Raspberry Pi 操作系统(和其他 Linux)上安装 Ollama

Ollama 的安装过程可谓非常轻松。

如果我们要在 Linux 上安装,必须获得它的官方安装脚本并运行它。以下是其官方网站上描述的安装方法。

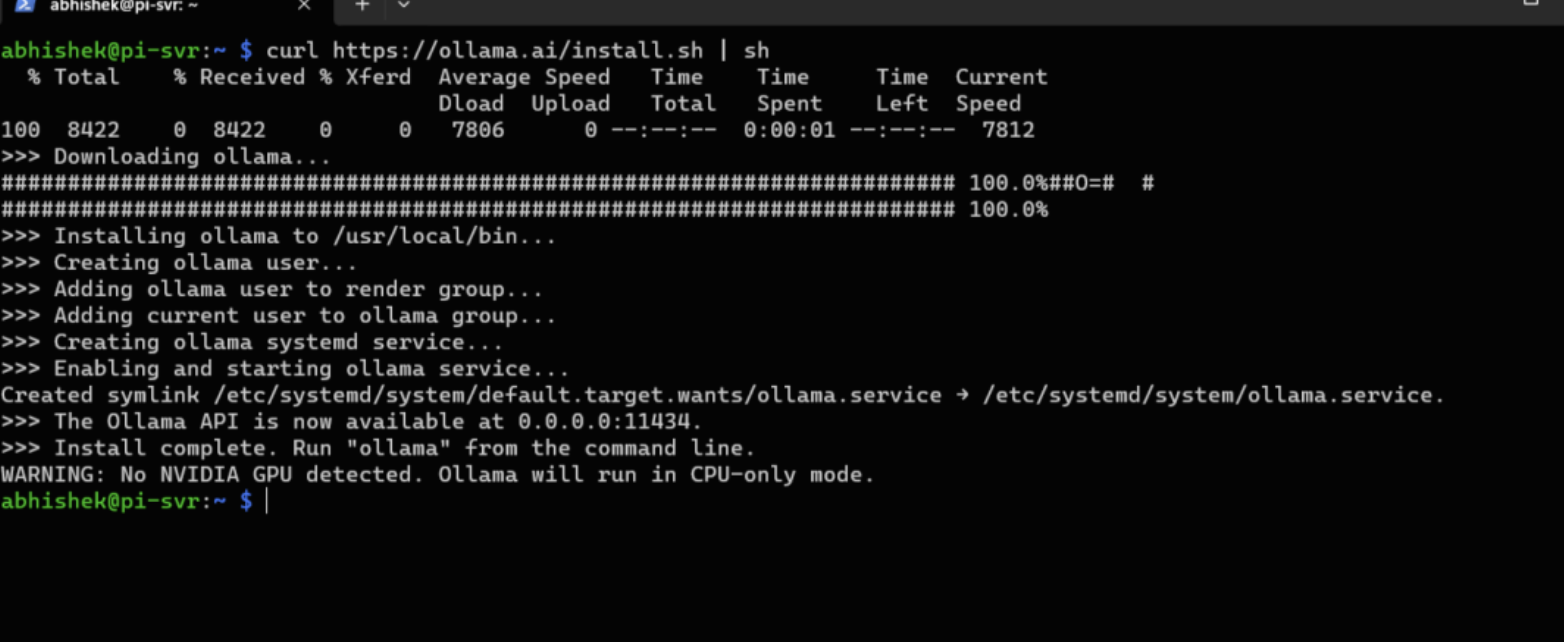

可以手动下载它并阅读它的作用。如果您像我一样懒惰,请将它们组合在一个命令中,如下所示:

curl https://ollama.ai/install.sh | sh探索不同的大语言模型

安装完成后,现在就可以在 Pi 上运行 LLM ,然后立即开始与 AI 聊天。

在我的实验中,我使用了tinyllama和phiLLM llava,您还可以尝试Ollama 库中提供的不同大型语言模型。

您应该至少有 8 GB 可用于运行 7B 模型,16 GB 可以运行 13B 模型,32 GB 可以运行 33B 模型。

TinyLlama

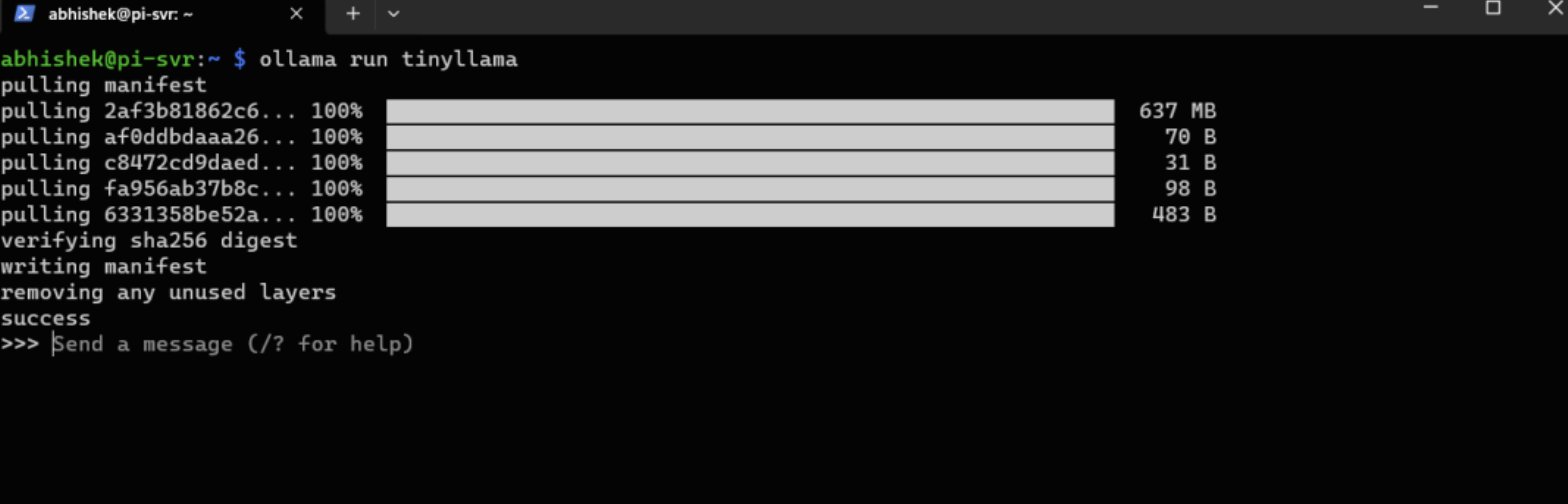

让我们从TinyLlama开始,它基于 11 亿个参数,是第一次尝试本地语言模型的完美候选者。

要下载并运行 TinyLlama,需要输入以下命令:

ollama run tinyllama下载语言模型需要几分钟的时间,下载完成后,您就可以开始与它聊天。

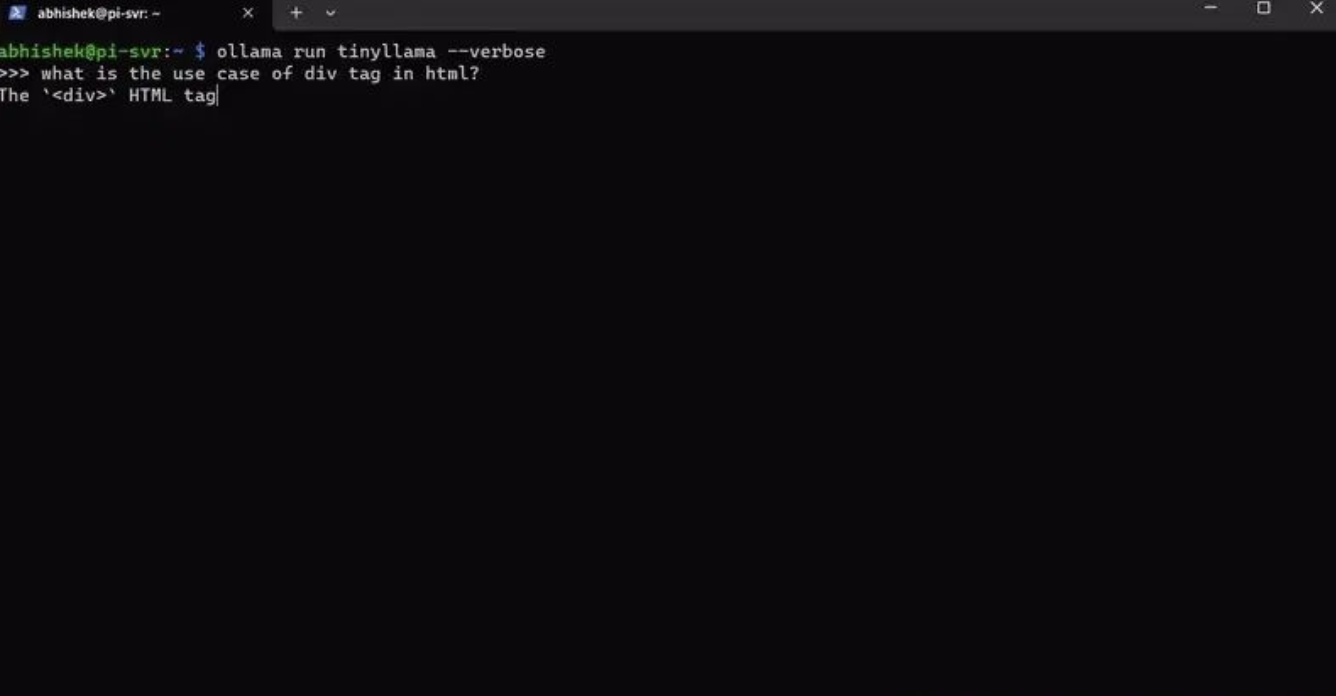

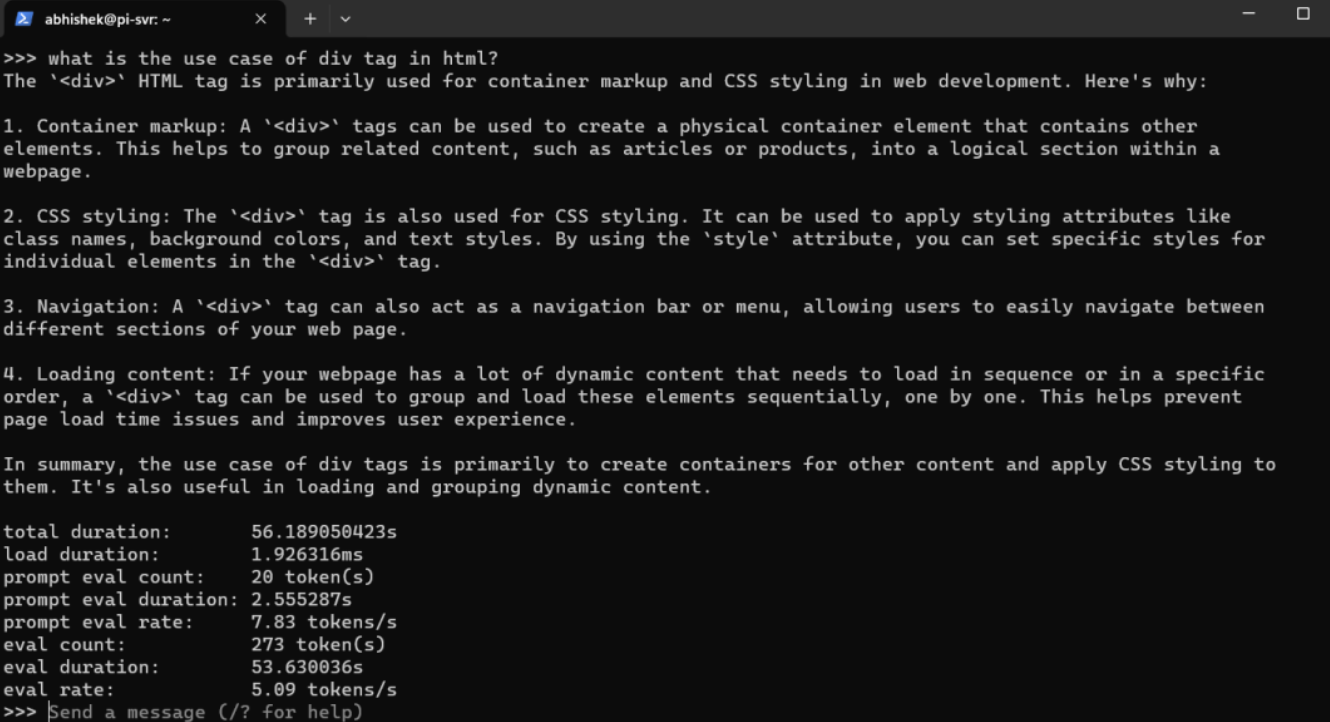

我向 AI 提出的问题是:

“div 标签在 html 中的用例是什么?”

下面是完整的答案以及完成它所需的时间:

真棒!谁会想到人工智能会在 Raspberry Pi 上运行得这么快?

phi

我们继续讨论一些更大的模型,例如phi,它是一个基于 2.7B 参数的语言模型。我认为 Raspberry Pi 也可以处理这个问题。

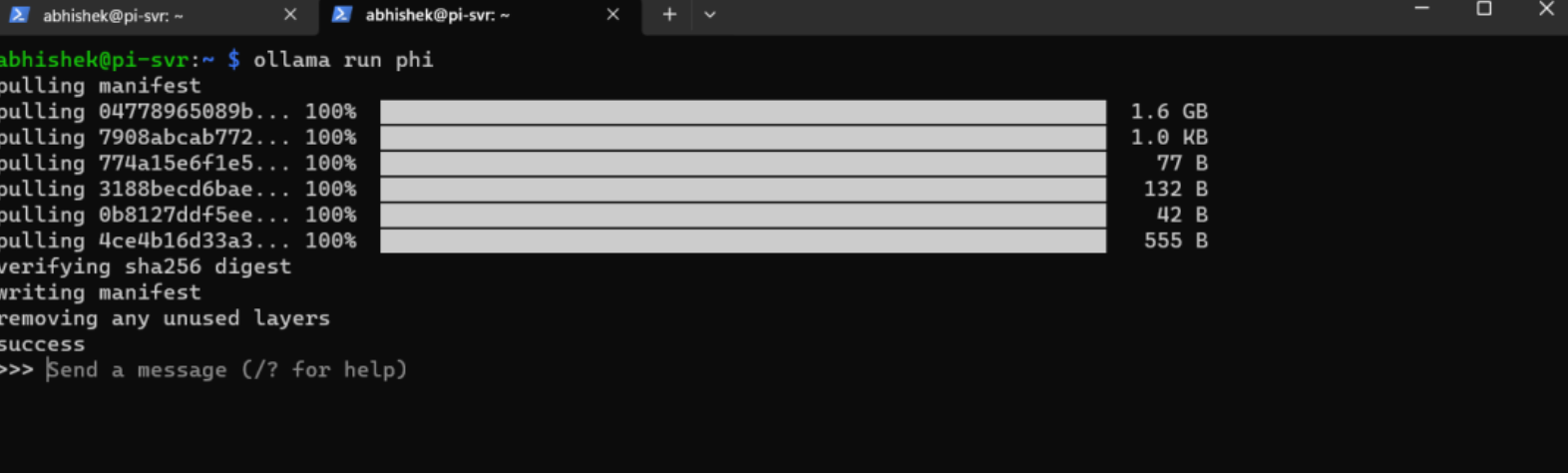

接下来安装并运行此模型,请键入以下命令:

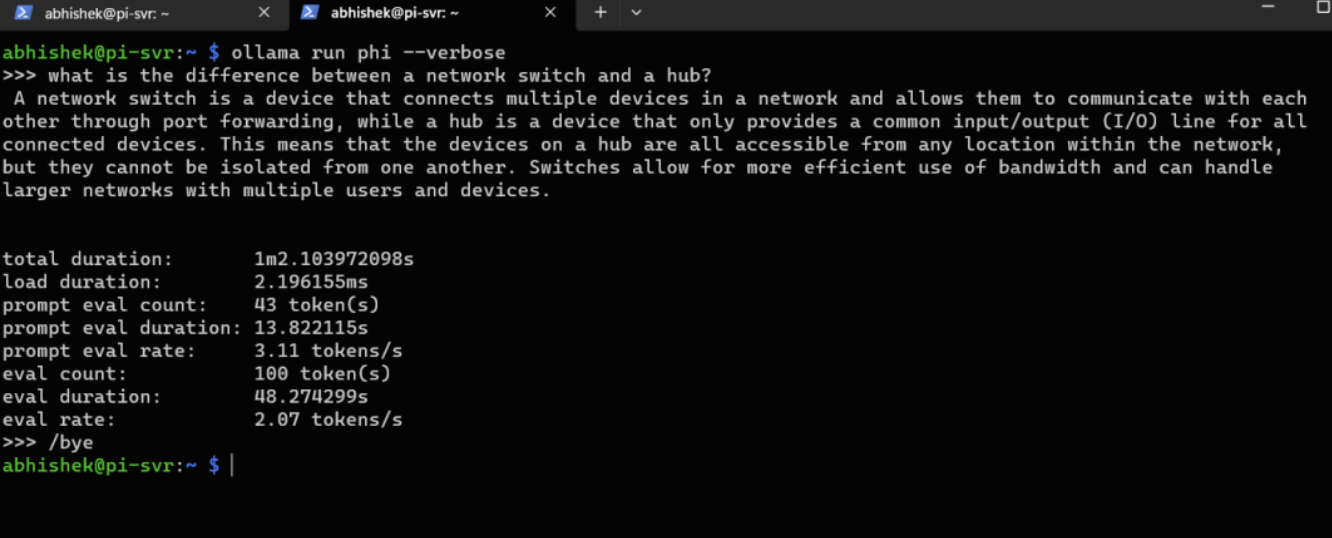

ollama run phi尝试问它一些问题。我提问道:“网络交换机和集线器有什么区别?”

下面是 phi 的完整答案以及其他详细信息:

llava

这是我测试过的最大的大语言模型,因为它自带有 7B 参数。我要求它描述图像而不是问简单的问题。

我使用的是 Raspberry Pi 4 的 4 GB 模型,我个人认为它不会像上面的语言模型那样工作得那么好。

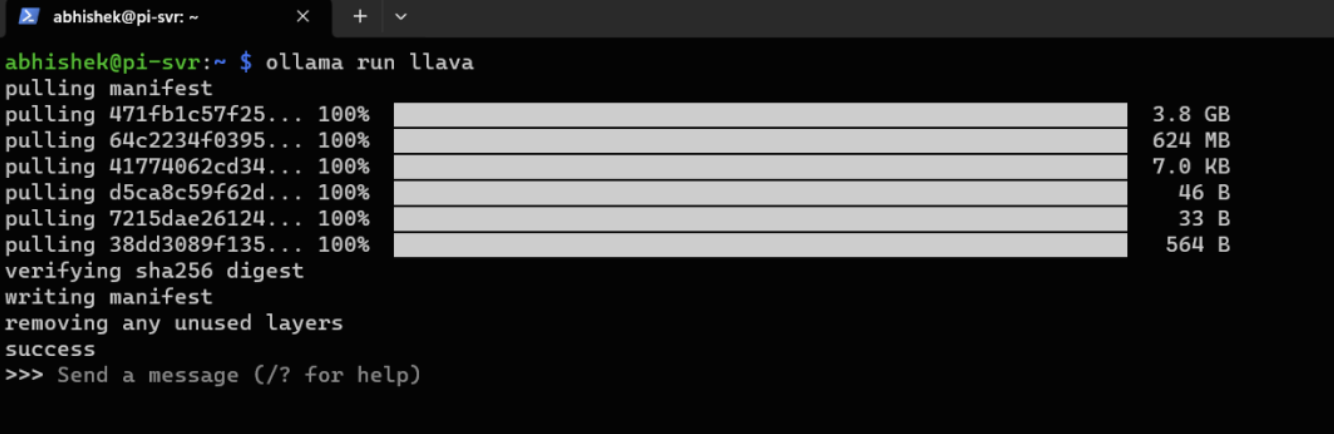

不过,我们还是测试一下。要安装 llava请使用以下命令:

ollama run llava下载这个模型需要一些时间,因为它的尺寸很大,接近 3.9 GB。

我将要求该模型描述存储在目录中的猫的图片:/media/hdd/shared/test.jpg。

但是我不得不中途终止该过程,因为回复时间太长(超过 30 分钟)。

但是,我们可以看到,响应非常准确,如果你有最新的 Raspberry Pi 5 和 8 GB RAM,你可以轻松运行 7B 参数语言模型。

结论

本文将 Raspberry Pi 5 的功能与 Ollama 相结合,为热衷于在本地运行开源语言模型的人奠定更坚实的基础。

无论您是努力突破紧凑计算界限的开发者,还是渴望探索语言处理领域的机关报爱好者,这种设置都提供了无限的机会。

欢迎在评论部分,发表您对 Ollama 的想法和实践经历。

作者:场长

文章来源:21cto.com

推荐阅读

更多芯擎AI开发板干货请关注芯擎AI开发板专栏。欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向。