35万张 H100 的算力平台将为大模型领域带来什么改变?

编译|艾伦

编辑|栗子

3月12日,Meta 推出 2 个 24K GPU 集群,为训练 Llama3 构建超强资源池。

在 Meta 工程网站,Meta 披露了有关万卡集群的硬件、网络、存储、设计、性能和软件的详细信息,并声称到 2024 年底将完成 350,000 个 NVIDIA H100 GPU 集群的构建。届时,其整个资源池计算能力将相当于近 600,000 个 H100。

Meta 构建大规模 AI 基础设施由来已久。

2022年10月,ChatGPT 发布前,Meta 就与全球领先的存储服务提供商共同推出了 RSC(Research SuperCluster)计算平台,并一度成为全球最快的 AI 超级计算机之一。

初代 RSC 配备有 16,000 个 NVIDIA A100 GPU,主要任务是为 Meta 元宇宙计划铺路。随着 ChatGPT 强势出圈,AGI 浪潮袭来。RSC 也从主要服务元宇宙转向服务于 GenAI 及其他 AI 领域的研发。2023年2月,Meta 在 RSC 支持下,发布了 Llama 并开源。RSC 逐渐为人熟知。

经过两年的发展,RSC 规模持续扩大,Meta 基于此成功打造出 Llama,Llama2 以及多种规格的AI大模型应用。同时更高水平的 AI 集群网络、计算及存储能力,将为 GenAI 下一阶段的发展铺平道路。

1.奠基 Llama3 的超大规模 GPU 集群

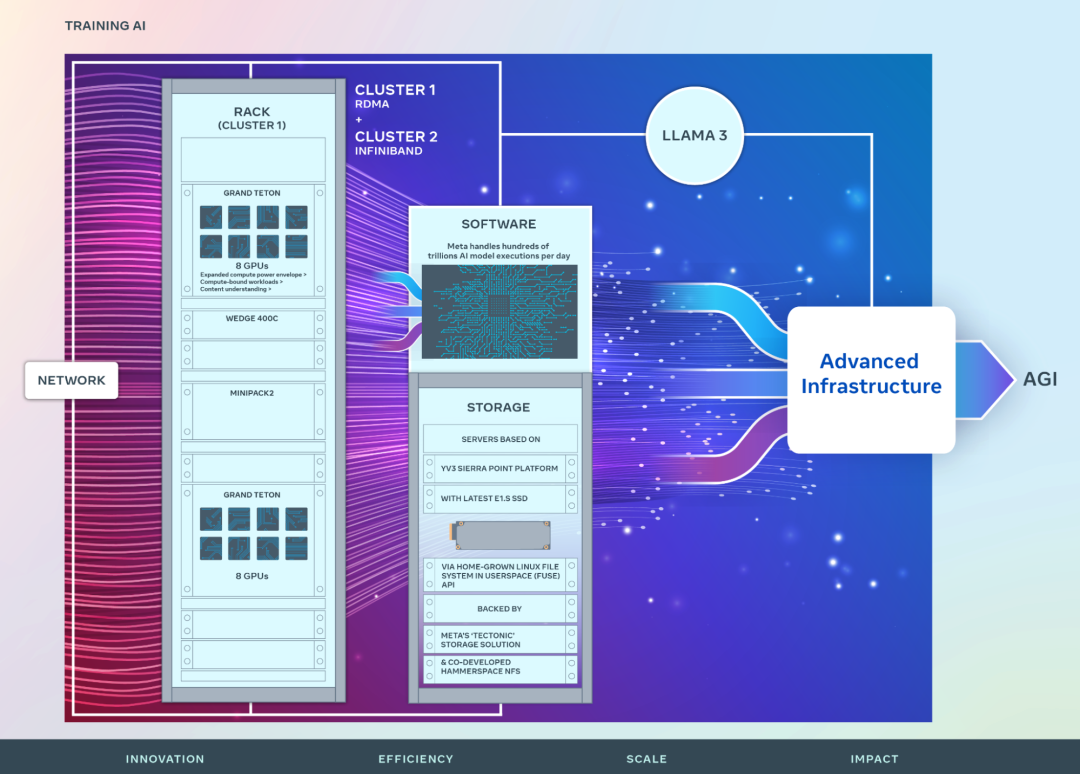

对于 GPU 集群来说,网络、计算、存储是三个极其重要的核心要素。而在这三方面,Meta 此次发布的 2 个 24K GPU集群都给出了领先的解决方案。

首先,从网络层面看,Meta 此次发布的两个集群均拥有24,576个NVIDIA Tensor Core H100 GPU。一个集群采用了具有融合以太网远程直接内存访问 (RDMA) (RoCE) 网络结构解决方案;另一个集群采用 NVIDIA Quantum2 InfiniBand 结构。

这两种解决方案都互连 400 Gbps 端点,可提供每天处理数百万亿个人工智能模型 API 调用的需求,并且没有任何网络瓶颈。

基于此,Meta 还具备了评估不同类型的互连对于大规模训练的适用性和可扩展性,成为了事实上的大模型训练行业标准。

其次,从计算层面看,此次Meta推出的两个万卡集群均基于 Grand Teton 构建,将电源、控制、计算和结构接口集成到单个机箱中,极简的设计提供了更强的灵活性和可扩展性。

事实上,Meta 从 2015 年开始就公开设计 GPU 硬件平台,至今已有近 10 年经验沉淀。在多代人工智能系统的构建基础上,未来基于 Meta 平台构建原生 AI 应用将更便宜、更便捷。

最后,从存储层面看,AGI 时代下的数据量与日俱增,尤其在Sora发布之后,多模态大模型离我们越来越近。而视频数据与文本数据的不是同一量级,尤其需要大规模数据训练大模型时,如何更有效地存储数据日益成为难题。

Meta 此次发布的万卡集群解决了以往的难点:数千个 GPU 能够以同步方式保存和加载检查点,同时还提供数据加载所需的灵活且高吞吐量的 EB 级存储。

除了更高的 SSD 容量之外,利用 OCP 服务器作为乐高积木,存储层能够灵活地扩展以满足集群以及未来更大的 AI 集群的未来需求。

文生图时代正式到来,当存储难题解决后,Llama3 的发布或许近在眼前。

2.超大规模集群的表现与未来

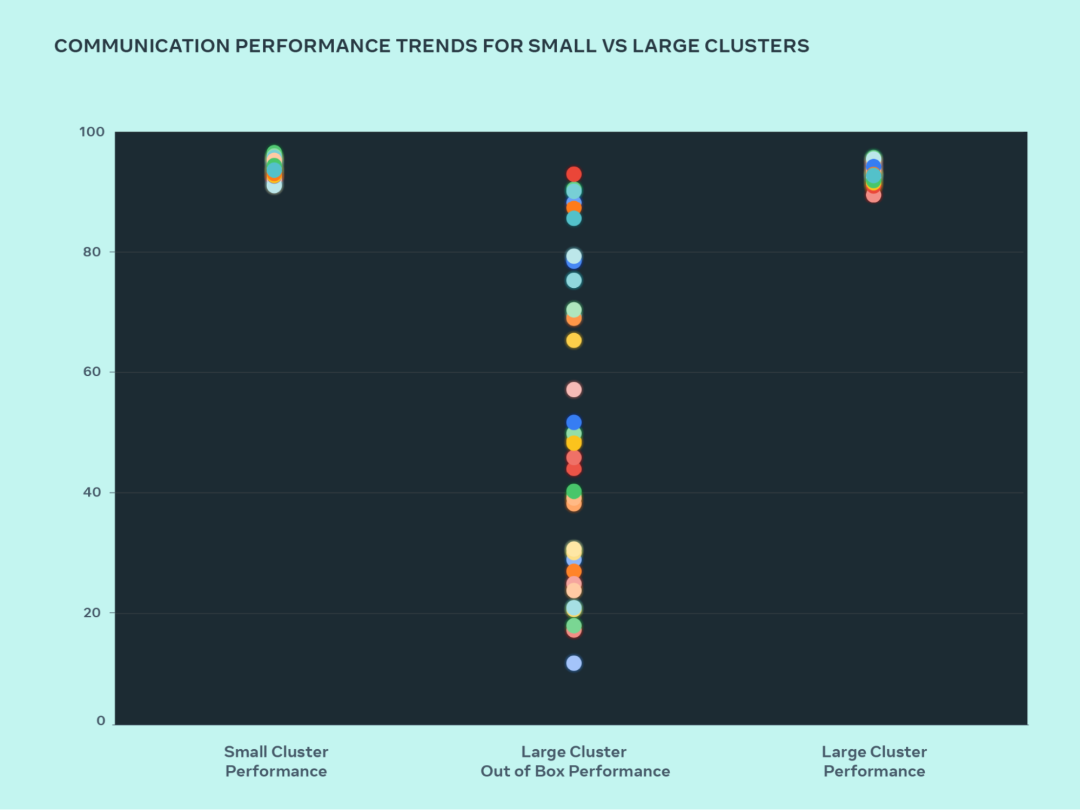

构建大规模人工智能集群的原则之一是同时最大限度地提高性能和易用性,这也是构建最优秀的人工智能模型不可或缺的衡量指标。然而,万卡集群的协调调度往往会有损性能。

为此,Meta 做了一个测试并改进了这一问题。

从图中可以看到,小型集群性能(整体通信带宽和利用率)开箱即达到 90%+,但未经优化的大型集群性能利用率非常低,从 10% 到 90% 不等。在优化整个系统(软件、网络等)后,大型集群性能恢复到理想的 90%+ 范围。

优化的小型集群性能相比,Meta 大型集群的开箱即用性能最初很差,并且不稳定。

随后,Meta更改了内部作业调度程序通过网络拓扑感知来调度作业的方式,将延迟优势扩大并最大限度地减少了流向网络上层的流量。同时结合 NVIDIA Collective Communications Library (NCCL) 更改优化了网络路由策略,实现了最佳的网络利用率。最终使得大型集群与小型集群一样实现出色的预期性能。

未来,Meta 将继续支持开放硬件创新,向 OCP 社区提供 Grand Teton 和 Open Rack 等设计。并继续对 PyTorch 的社区做贡献,为整个行业提供动力的人工智能软件框架。

到 2024 年底,Meta 将落地更大的基础设施建设,其中包括 350,000 台 NVIDIA H100,其计算能力将相当于近 600,000 台 H100。

昨天,OpenAI 开源了debug 工具,这被视为大模型开源的又一重大事件。随着 RSC 万卡集群落地并不断扩展,Llama3 的发布也近在眼前。可以预见的是,未来大模型开源领域将带来更多令人惊喜的发展。