AI Compass前沿速览:PixVerse V5、gpt-realtime、Grok Code Fast、HunyuanVideo、OmniHuman-1.5、字节WaverAI视频、MiniCPM 4.5等

AI-Compass 致力于构建最全面、最实用、最前沿的AI技术学习和实践生态,通过六大核心模块的系统化组织,为不同层次的学习者和开发者提供从完整学习路径。

- github地址:AI-Compass👈:https://github.com/tingaicompass/AI-Compass

- gitee地址:AI-Compass👈:https://gitee.com/tingaicompass/ai-compass

🌟 如果本项目对您有所帮助,请为我们点亮一颗星!🌟

1.每周大新闻

gpt-realtime – OpenAI语音模型

GPT-realtime 是OpenAI推出的一款先进的实时语音模型,旨在为实际应用提供高质量、自然的语音交互能力。该模型能够生成逼真的语音,支持多种语言和语音风格,并且能理解非语言线索和语境信息,以适应不同的应用场景需求。

核心功能

- 高质量语音生成: 能够生成自然、流畅且富有表现力的语音。

- 智能理解与推理: 具备对语音内容进行深度理解和综合推理的能力。

- 指令遵循: 能够准确理解并执行用户给出的复杂指令。

- 函数调用: 支持与外部工具或API进行集成,实现更广泛的功能扩展。

- 多模态输入: 除了语音,还支持图像等多种形式的输入,增强模型的感知能力。

- 支持多语言及非语言线索: 能够处理不同语言的语音,并理解语音中的情感、语调等非语言信息。

技术原理

GPT-realtime 的技术原理主要基于深度学习和神经网络模型。它可能采用了先进的文本到语音(Text-to-Speech, TTS)合成技术,结合大型语言模型(LLM)的强大语义理解能力,实现高度拟人化的语音输出和理解。其“实时”特性暗示了优化的模型架构和高效的推理算法,确保低延迟的语音处理。同时,对非语言线索的理解可能涉及到声学特征分析和情感识别等技术,而多模态输入则表明模型融合了语音识别与计算机视觉等技术。

PixVerse V5 – 爱诗AI视频生成模型

简介

PixVerse V5是爱诗科技(PixVerse)自主研发并全球同步上线的AI视频生成大模型。作为业界领先的AI视频生成平台,PixVerse旨在将用户的想象力转化为高质量的视频内容,支持从文本提示或上传图片生成视频。V5版本在动态效果、视觉质量、一致性保持和指令遵循等方面进行了全面升级,致力于生成更逼真、自然的视频。

核心功能

- 文本到视频生成 (Text-to-Video Generation):用户可以通过简单的文本描述生成具有特定风格和内容的视频。

- 图片到视频转换 (Image-to-Video Conversion):支持上传图片(如照片、自拍、肖像或合影)并将其转化为动态视频内容。

- 视频效果增强 (Video Effect Enhancement):提供多种内置效果和AI处理能力,将静态图片转化为引人入胜的动态视频。

- 多风格与场景创作 (Multi-Style and Scene Creation):模型支持生成动漫、写实等多种风格的视频,适应不同创作需求。

- 视频质量提升 (Video Quality Improvement):V5版本在动态效果、视觉质量、一致性及指令遵循上全面优化,确保生成视频的逼真度和自然度。

技术原理

PixVerse V5作为AI视频生成大模型,其核心技术原理基于深度学习和生成对抗网络(GANs)或扩散模型(Diffusion Models)等先进的AI架构。通过海量的视频和图像数据进行训练,模型学习如何理解文本描述和图像特征,并将其映射到视频的像素级生成。具体包括:

- 跨模态理解 (Cross-Modal Understanding):利用自然语言处理(NLP)技术解析文本提示,并结合计算机视觉(CV)技术分析图像输入,实现文本和视觉信息之间的有效关联。

- 时空一致性建模 (Spatio-Temporal Consistency Modeling):在视频生成过程中,确保帧与帧之间的内容在时间维度上保持平滑过渡和逻辑连贯性,同时保持空间上的视觉质量。

- 高级渲染与合成 (Advanced Rendering and Synthesis):通过复杂的神经网络层,将抽象的概念转化为具体的视觉元素,并进行高质量的图像渲染和视频合成,以达到逼真、自然的视觉效果。

- 指令遵循优化 (Instruction Following Optimization):通过强化学习或更精细的损失函数设计,提高模型对用户指令的精确理解和执行能力,确保生成内容与用户意图高度一致。

应用场景

- 内容创作 (Content Creation):个人创作者、社交媒体影响者快速生成短视频、动画片段或视觉故事。

- 数字营销与广告 (Digital Marketing and Advertising):企业和品牌利用AI快速制作产品宣传片、广告创意和社交媒体营销内容。

- 教育与培训 (Education and Training):制作教学视频、演示动画或互动式学习材料,提升学习体验。

- 影视娱乐 (Film and Entertainment):辅助电影制作人、动画师进行概念验证、预可视化或生成特定场景的视觉特效。

- 游戏开发 (Game Development):为游戏角色、场景或过场动画生成动态纹理和视频素材。

- 个人创意表达 (Personal Creative Expression):普通用户通过简单的操作将照片或想法转化为生动的视频,用于分享或纪念。

Grok Code Fast 1 – xAI推出的AI编程模型

Grok Code Fast 1 是 xAI 推出的一款先进的 AI 编程助手,旨在帮助开发者更快地编写、调试和学习代码。它被誉为 GitHub Copilot 和 ChatGPT 的增强版,专注于提供高速、经济且高质量的代码生成和调试能力,特别适用于智能体工作流和自动化开发任务。

核心功能

- 高速代码生成与调试: 能够快速生成高质量代码并协助调试,显著提高开发效率。

- 智能体编码任务: 擅长处理复杂的智能体编码工作流,包括函数编写、算法优化和系统集成。

- 深度代码理解: 能够理解复杂的代码库,并在长时间的开发会话中保持代码一致性。

- 可引导的推理轨迹: 提供清晰的推理过程,允许用户检查和调整模型的思考逻辑,以更有效地指导输出。

- 支持迭代与自动化开发: 专为迭代和自主开发而设计,能作为开发者的得力助手。

技术原理

Grok Code Fast 1 是一个基于 MoE (Mixture of Experts) 架构的推理模型,拥有 3140 亿参数和 256K 令牌的上下文窗口。它在技术上实现了显著的速度和成本优势,处理速度高达 92 令牌/秒,比同类领先的智能体模型快 4 倍,成本则降低 10 倍。该模型支持交错式工具调用 (interleaved tool-calling),并在流模式下通过 chunk.choices.delta.reasoning_content 暴露其思维轨迹,提供了可追溯的推理能力。

应用场景

- 软件开发与调试: 帮助初学者和专业开发者快速编写代码、解决错误,并加速开发进程。

- 自动化编程与智能体工作流: 在需要自主执行编码任务(如功能实现、算法优化)的场景中发挥重要作用。

- 教育与学习: 作为耐心导师和调试伙伴,辅助初学者学习编程。

- 集成开发环境 (IDE) 插件: 可集成到 Kilo Code、Fine、Cursor、Windsurf 和 Cline 等现有编码工具中,提供高效的辅助。

- 复杂项目管理: 协助开发者处理繁琐任务,使其能够专注于更高级的设计问题和项目整体架构。

Quick BI – 阿里AI商业分析Agent

Quick BI 是阿里云推出的一款智能商业分析工具,旨在通过集成AI能力,如SmartQ,加速企业的数据驱动决策过程。它提供全面的数据分析功能,帮助用户高效地进行数据洞察与管理。

核心功能

- 对话式报表与仪表板创建: 支持通过自然语言交互快速构建数据报表和可视化仪表板。

- 智能洞察与归因: 提供智能分析能力,自动发现数据中的潜在规律和业务驱动因素。

- 毫秒级查询响应: 内置Quick加速引擎,确保数据查询和分析的极速响应。

- 多端协同与集成: 提供PC端、H5移动端(如钉钉、Lark、企业微信)的无缝分析体验,并支持深度应用内集成,实现团队协作。

- 实时数据分析: 能够处理并展现实时数据流,支持即时业务监控和决策。

技术原理

Quick BI 的核心技术原理在于其AI与BI的深度融合。它通过自然语言处理 (NLP) 技术实现对话式查询和报表生成,降低用户门槛。预测性分析模型用于提供智能洞察和归因。此外,其Quick加速引擎采用高性能内存计算与分布式架构,优化数据查询性能,达到毫秒级响应速度。在数据合规性方面,通过多区域部署架构,确保数据主权和跨国合规性。

应用场景

- 企业级数据决策支持: 为企业高层及业务人员提供数据分析能力,辅助战略规划与运营决策。

- 实时业务监控与预警: 适用于需要对关键业务指标进行实时监控和异常预警的场景,如金融反欺诈中的eKYC检查。

- 跨部门数据协作: 促进不同团队之间的数据共享、分析和协同工作,提升整体运营效率。

- 移动化办公分析: 支持在移动设备上随时随地进行数据分析和报表查阅。

- 合规性数据管理: 面向具有国际业务的企业,帮助其在多司法管辖区内遵守数据主权和隐私法规。

2.每周项目推荐

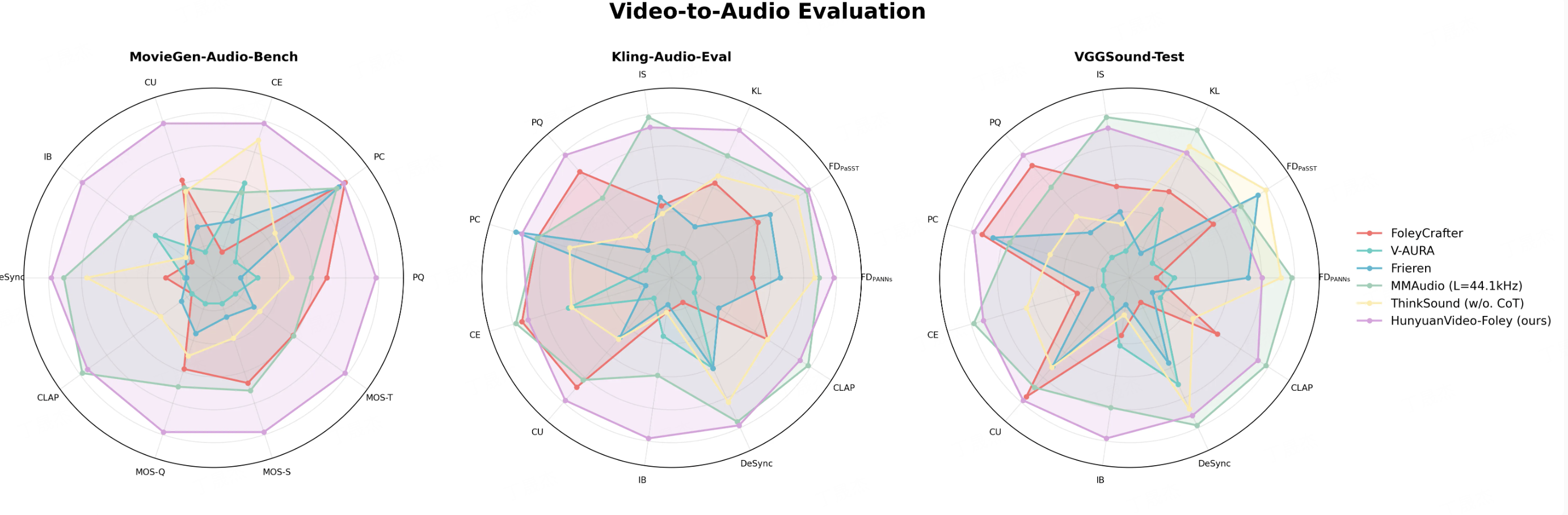

HunyuanVideo-Foley视频音效生成模型

HunyuanVideo-Foley是由腾讯混元团队开源的一款先进的文本-视频-音频(Text-Video-to-Audio, TV2A)生成系统。该系统旨在根据输入的视频内容和文字描述,自动生成高保真且与视频画面及语义高度匹配的音效,从而为无声视频赋予沉浸式的听觉体验,显著提升内容的吸引力和专业度。

核心功能

- 自动音效生成: 能够基于输入的视频画面和附加的文本描述,智能地为视频生成精确、自然的音效。

- 多模态语义均衡响应: 具备理解视频画面并同时结合文字描述的能力,实现多模态信息的平衡处理,生成更具层次感和复合性的音效,避免单模态信息导致的偏差。

- 高保真音效输出: 生成的音效达到专业级音频保真度,能够精准还原声音的细节和质感,满足专业制作对音质的高要求。

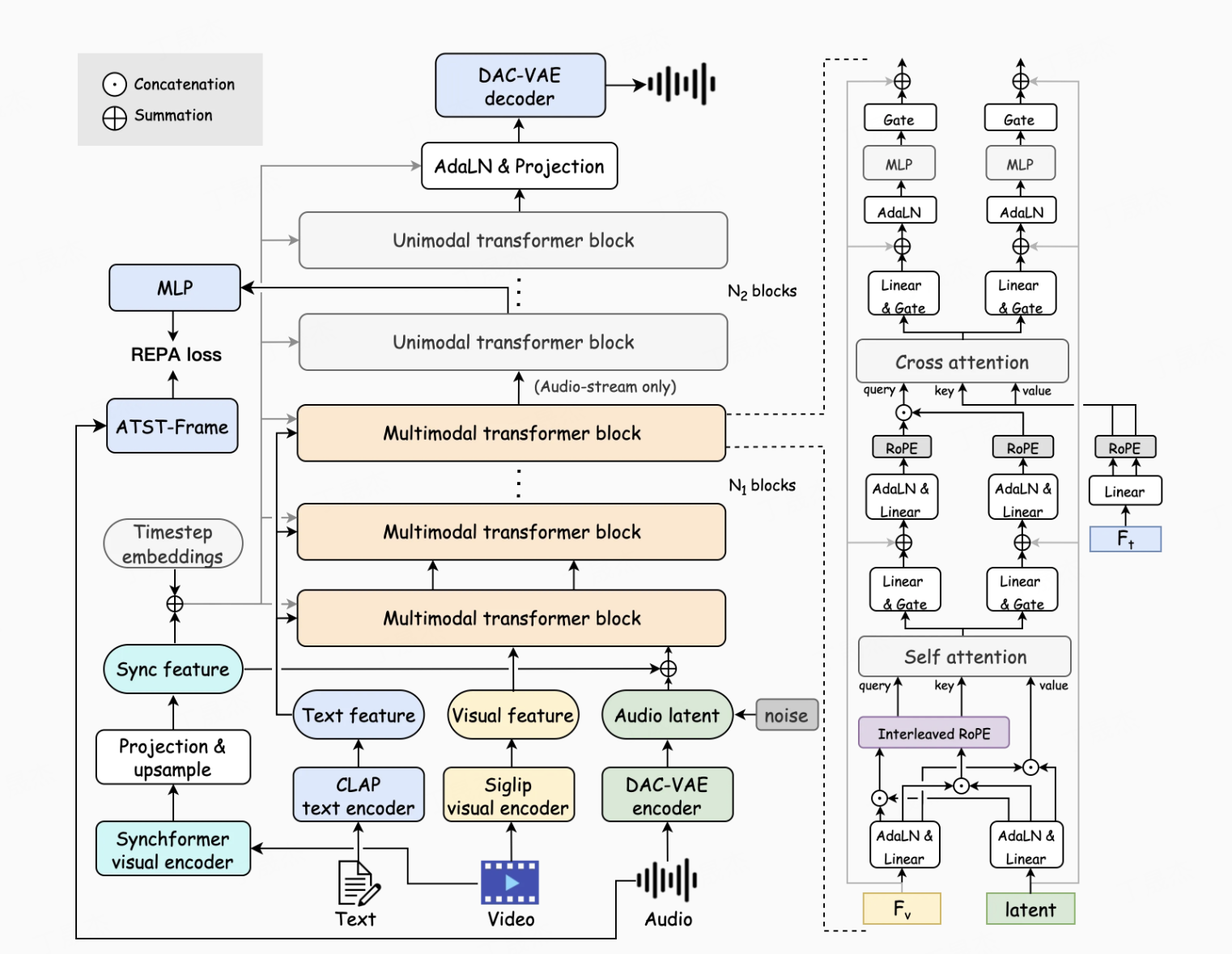

技术原理

HunyuanVideo-Foley的核心技术基于以下几个方面:

- 大规模TV2A数据集构建: 模型训练依赖于一个约10万小时级的高质量文本-视频-音频(TV2A)数据集,通过自动化标注和过滤方式构建,为模型的泛化能力提供了坚实基础。

- 多模态扩散变换器(MMDiT)架构: 采用双流MMDiT架构,通过联合自注意力机制对视频和音频的帧级别对齐关系进行建模,并通过交叉注意力机制有效地注入文本信息,解决了多模态数据融合中的模态竞争问题,实现了视频、音频和文本间的精准对齐。

- 表征对齐(REPA)损失函数: 引入预训练音频特征作为建模过程的语义与声学指导,通过最大化预训练表示与内部表示之间的余弦相似度,显著提升了生成音频的质量和稳定性,并有效抑制了背景噪音和不一致的音效瑕疵。

应用场景

- 短视频创作: 为短视频内容创作者提供高效的音效生成方案,快速提升视频的感官体验。

- 电影与广告制作: 在电影、电视剧和广告片的后期制作中,用于自动生成或辅助制作场景化音效,提高制作效率和视听效果。

- 游戏开发: 为游戏中的角色动作、环境变化和事件触发等提供自动化音效匹配与生成,增强游戏沉浸感。

- 多媒体内容生产: 广泛应用于各类多媒体内容的制作,如教育、新闻、纪录片等,快速为无声或音效不足的视频添加高质量声音。

- 项目官网:https://szczesnys.github.io/h...

- GitHub仓库:https://github.com/Tencent-Hu...

- HuggingFace模型库:https://huggingface.co/tencen...

- arXiv技术论文:https://arxiv.org/pdf/2508.16930

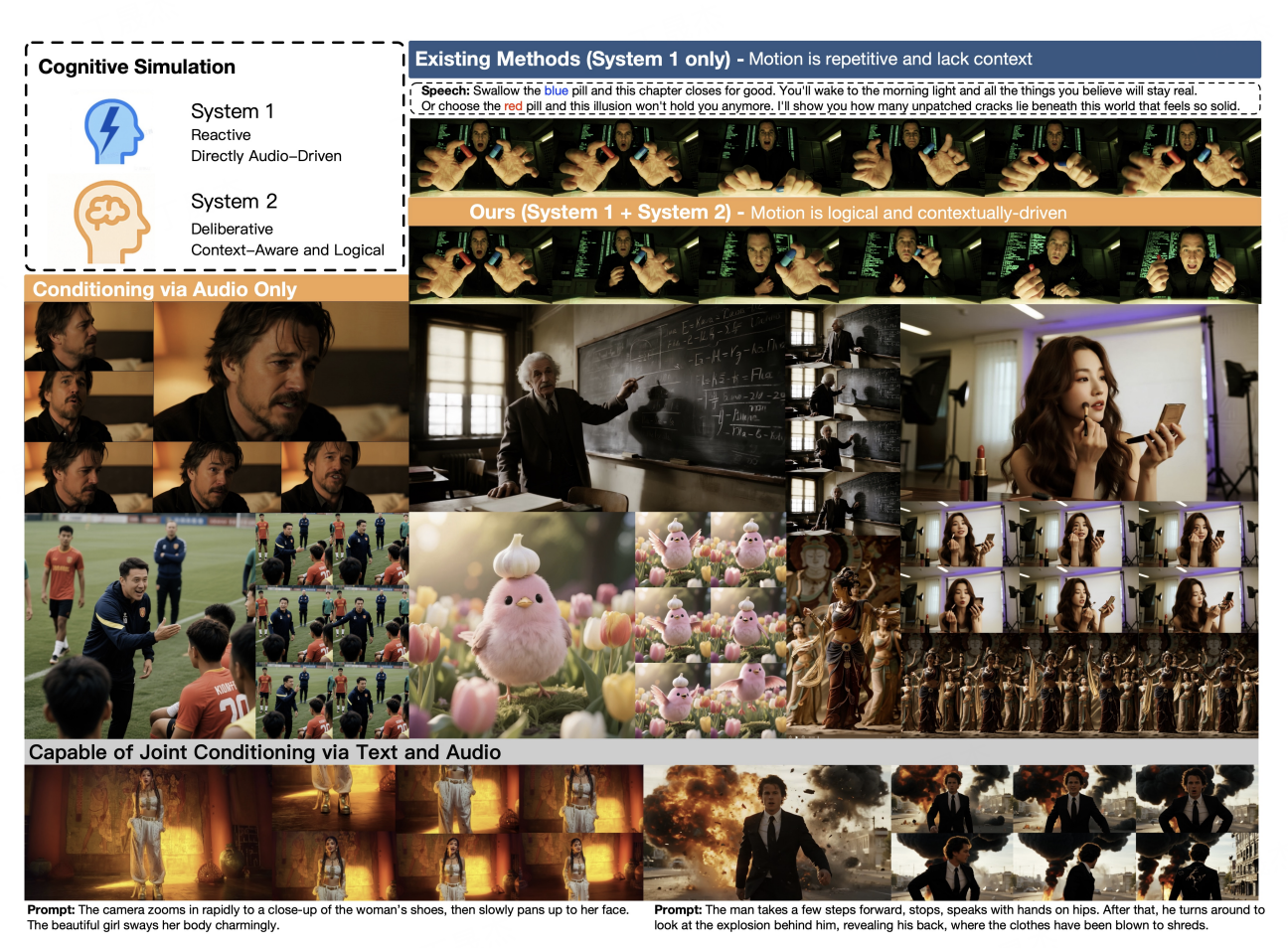

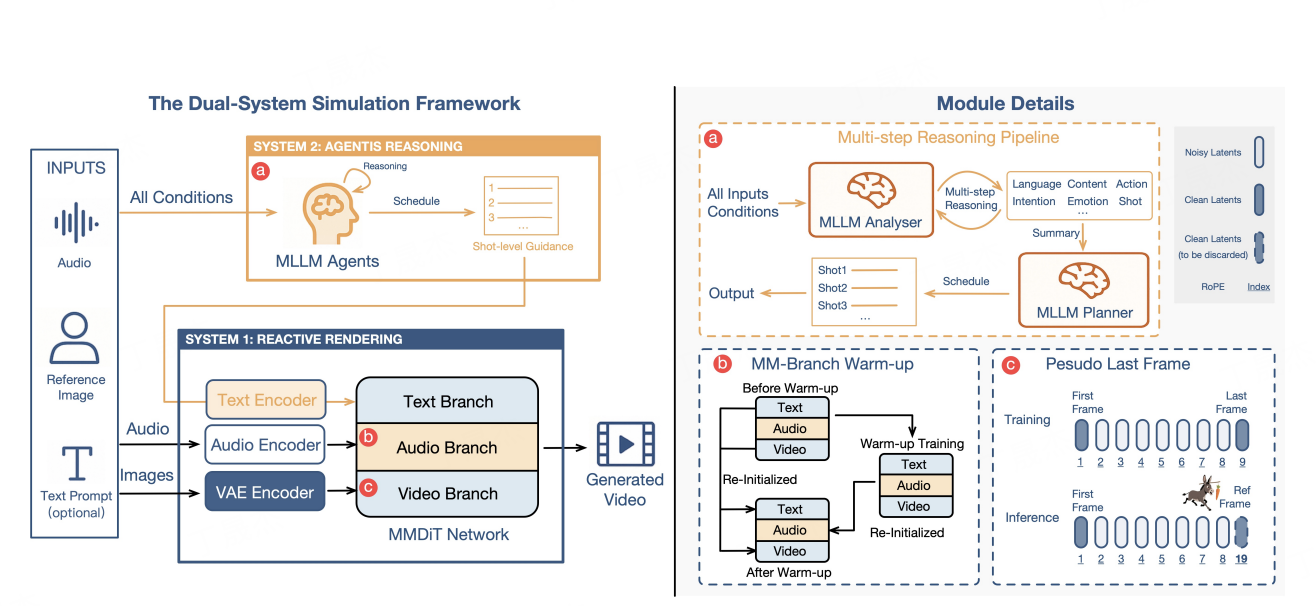

OmniHuman-1.5 – 字节数字人动画生成模型

OmniHuman-1.5是字节跳动推出的一款先进的AI模型,旨在从单张图片和语音轨道生成富有表现力、上下文连贯且情绪化的数字人动画。该模型模拟人类的“系统1和系统2”双重认知理论,结合了多模态大语言模型(MLLM)和扩散变换器(Diffusion Transformer),实现了从审慎规划到直觉反应的模拟,极大地提升了数字内容创作的效率和表现力。

核心功能

- 动画生成: 能够从单一图像和语音轨道生成高质量的数字人动画。

- 多角色互动: 支持生成多角色动画,并能实现角色间的复杂互动。

- 情感表现: 生成的数字人动画具有丰富的情感表现力,能根据语音和文本提示做出相应的情感反应。

- 文本细化与动态调整: 支持通过文本提示对动画进行进一步的细化和调整,提升动画的准确性和表现力。

- 动态场景: 能够生成动态背景和场景,使动画更加生动和真实。

技术原理

- 双重系统认知理论(Dual System Cognitive Theory): 模型设计灵感来源于人类的认知过程,模拟了“系统1”(快速、直觉反应)和“系统2”(慢速、深思熟虑)的认知模式,使其能同时处理复杂的逻辑和直观的情感反应。

- 多模态大语言模型(Multimodal Large Language Models, MLLM): 用于处理文本和语音输入,提供高层次的语义指导,理解上下文和情感,从而生成与语音节奏、语调和语义内容一致的动画。

- 扩散变换器(Diffusion Transformer, DiT)架构: 负责生成高质量的动画帧,确保动画的流畅性和视觉效果。它能有效融合多种模态输入,并缓解模态间的冲突。OmniHuman-1.5在MMDiT(Masked Multimodal Diffusion Transformer)架构基础上进行了显著增强。

- 多模态融合: 将图像、语音、文本等多种模态的信息进行深度融合,以生成更丰富、更真实的动画。

- 伪参考帧机制: 通过在最后一帧位置放置用户参考图像,并调整其位置编码,引导模型保持对参考身份的忠诚度,同时避免训练伪影。

应用场景

- 动画制作: 快速生成高质量角色动画,显著降低制作成本并提升创作效率。

- 游戏开发: 为游戏角色生成自然、生动的动画,增强游戏的沉浸感和玩家互动体验。

- 虚拟现实(VR)和增强现实(AR): 创建逼真的虚拟角色和交互式内容,提升用户在VR/AR环境中的体验和趣味性。

- 社交媒体和内容创作: 快速生成动画内容,适用于短视频和直播平台,提升内容的互动性和吸引力。

- 数字人及虚拟主播: 用于创建具有情感和认知能力的数字人,应用于客服、教育、娱乐等领域。

- 项目官网:https://omnihuman-lab.github....

- arXiv技术论文:https://arxiv.org/pdf/2508.19209

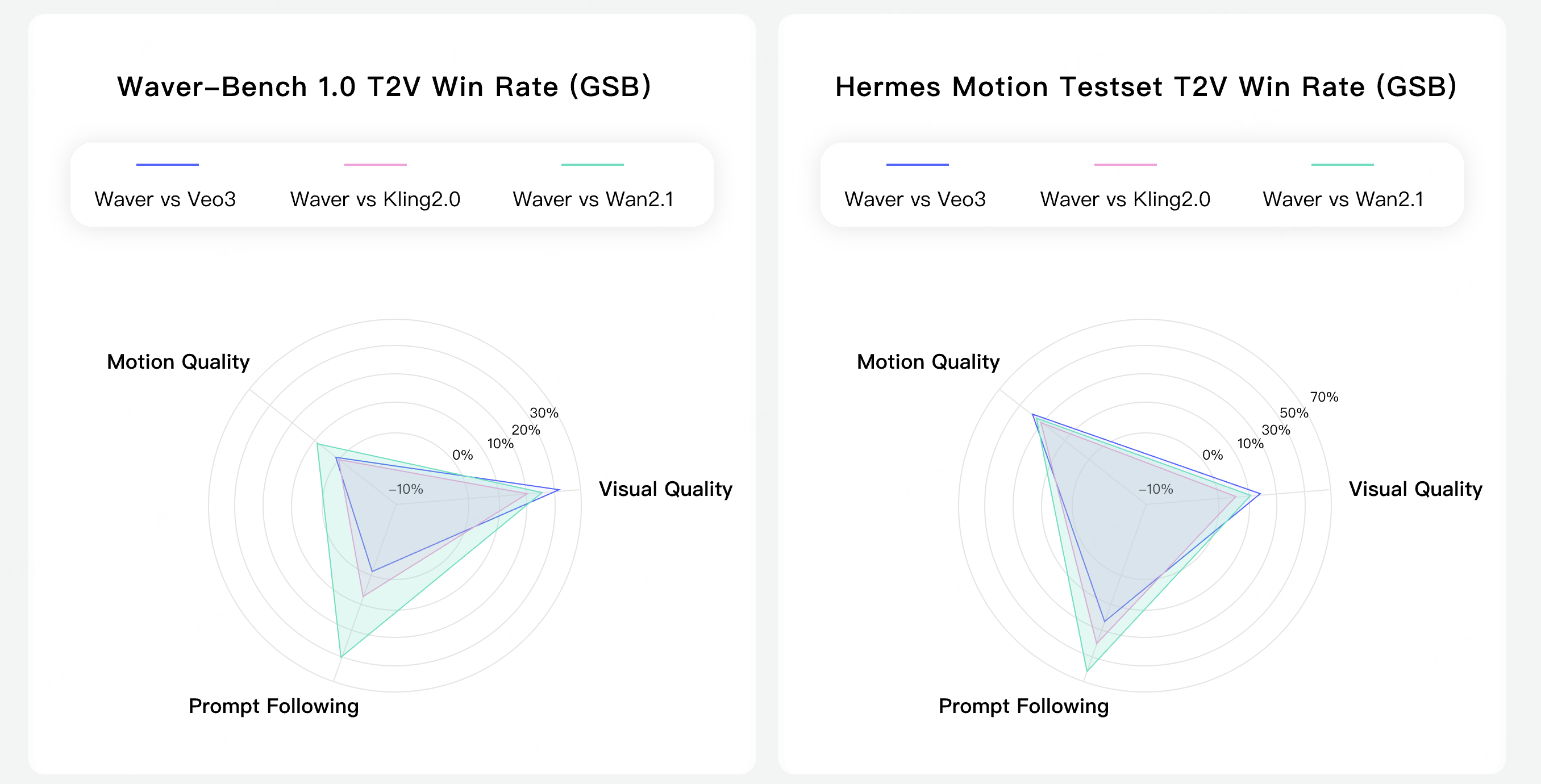

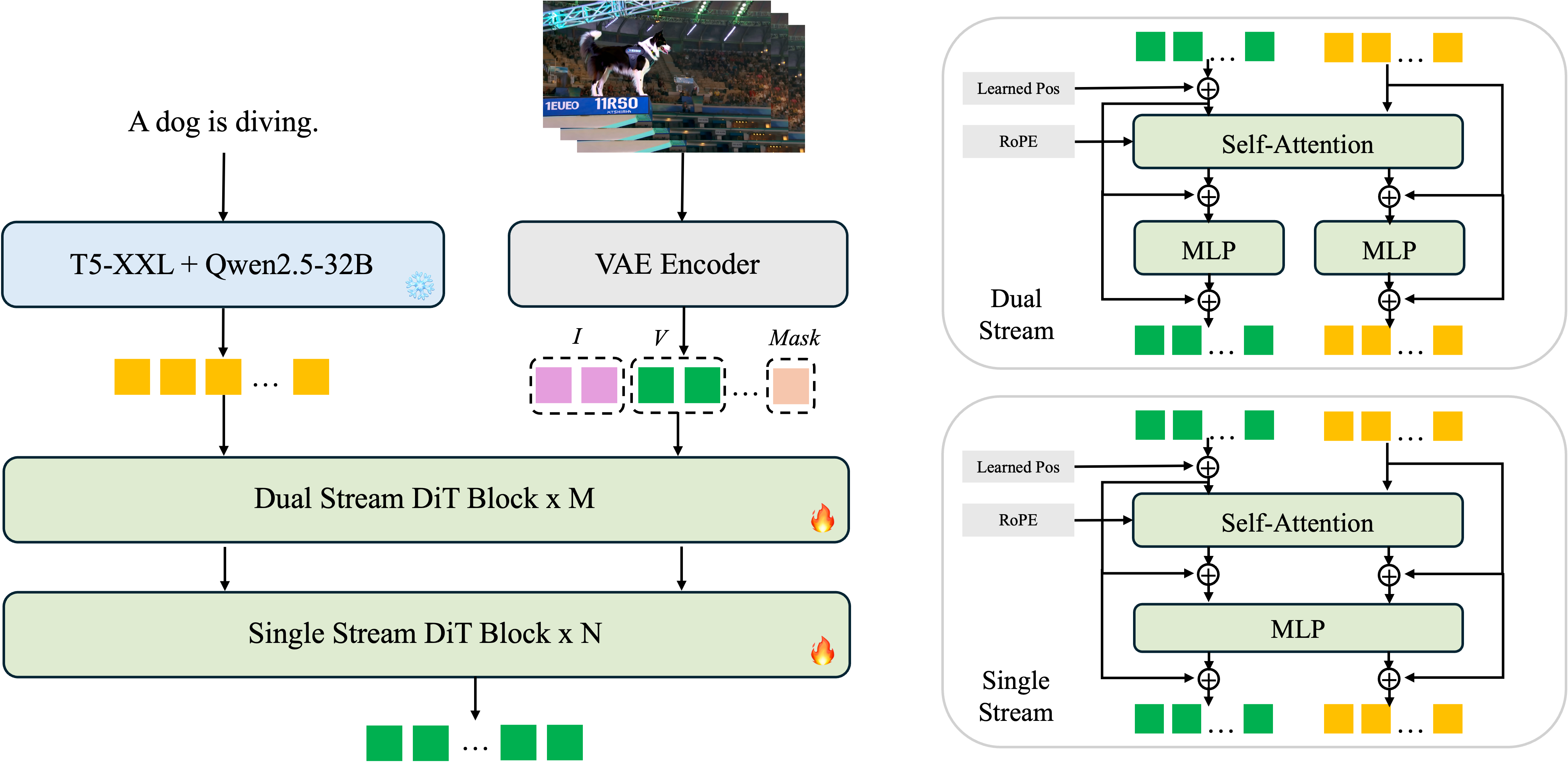

Waver 1.0 –字节AI视频生成模型

Waver 1.0是一个下一代的人工智能视频工具,也是一个通用的基础模型,专为统一的图像和视频生成而设计。它利用先进的AI技术,将静态的文字和图像无缝转换为动态的视频内容,旨在提供高质量、高速度和高创造性的AI生成视频解决方案。

核心功能

- 多模态生成: 支持文本到视频 (T2V)、图像到视频 (I2V) 以及文本到图像 (T2I) 的内容生成。

- 视频生成能力: 可直接生成时长5到10秒的720p视频,并可升级至1080p分辨率。

- 灵活性与控制性: 提供灵活的分辨率和宽高比,支持任意视频长度,并易于扩展以实现可控的视频生成。

- 性能优化: 具备更快的渲染时间、增强的视频质量以及更深度的自定义选项。

技术原理

Waver模型基于整流流Transformer架构构建,旨在实现工业级性能。其核心包含两个主要模块:

- 任务统一的DiT (Diffusion Transformer): 负责生成720p分辨率、5到10秒时长的视频。

- 级联精炼器 (Cascade Refiner): 用于将生成的视频从720p分辨率提升至1080p。

模型的训练过程注重从低分辨率视频(如192p)学习运动,随后逐步提高分辨率至480p和720p,并采用类似于SD3的流匹配训练设置。在文本到图像生成方面,它利用了lognorm(0.5, 1)概率密度函数。

应用场景

- 社交媒体内容创作: 快速生成引人注目的短视频,满足社交平台的需求。

- 专业内容制作: 适用于需要高质量AI生成视频的创作者和企业,例如营销、教育、媒体等领域。

- 静态媒体动态化: 将现有文字内容或图片素材转化为视觉吸引力强的视频,提升表达效果。

- 项目官网:http://www.waver.video/

- Github仓库:https://github.com/Foundation...

- arXiv技术论文:https://arxiv.org/pdf/2508.15761

MAI-Voice-1 – 微软极速语音生成模型

MAI-Voice-1是微软人工智能团队推出的首个内部开发的、具有高度表现力和自然度的语音生成模型。它代表了微软在语音AI领域自主研发的重要进展,旨在提供高效、逼真的语音合成能力。

核心功能

- 高表现力语音生成: 能够生成听起来高度自然且富有表现力的语音。

- 高效音频合成: 可以在单个GPU上不到一秒钟内生成一分钟的音频,显示出极高的运算效率。

- 多场景集成: 已集成到微软的Copilot Daily和播客等产品中。

技术原理

MAI-Voice-1的开发得益于微软对下一代GB200 GPU集群的利用,该集群是专门为训练大型生成模型而优化的定制基础设施。这表明其技术原理可能涉及先进的深度学习架构,如基于Transformer或扩散模型的生成网络,并通过大规模并行计算和优化算法实现了高效的语音合成,从而在保证高质量输出的同时,显著提升了生成速度。

应用场景

- 智能助手: 用于提升Copilot等智能助手的语音交互体验,使其声音更自然、富有情感。

- 播客与内容创作: 为播客、有声读物或其他多媒体内容提供高质量的自动语音生成服务。

- 辅助功能: 为视力受损用户提供更自然、易于理解的文字转语音服务。

- 开发者工具与实验室: 通过Copilot Labs等平台提供给开发者和研究人员进行探索和创新。

- 企业应用: 可集成到客服、培训、广播通知等企业级应用中,实现高效的语音信息传递。

- https://microsoft.ai/news/two...

FramePackLoop – AI视频生成

FramePackLoop 是一个基于lllyasviel的FramePack项目开发的视频工具,专门用于生成无限循环的视频。它通过智能组合主视频和连接视频片段,实现视频内容的无缝循环播放。

核心功能

FramePackLoop 的核心功能是创建循环视频。它能够将用户提供的视频素材进行处理,通过技术手段使其首尾连接,形成一个平滑且连续的无限循环视频流。

技术原理

FramePackLoop 的技术原理基于扩散模型 (Diffusion Model) 和视频处理技术。它继承了FramePack项目在视频帧处理和生成方面的能力,并在此基础上进行了优化,实现了视频内容的无缝衔接,确保循环播放时的视觉流畅性,避免跳帧或中断感。其目标是让循环视频的扩散生成变得实用。

应用场景

FramePackLoop 的应用场景广泛,尤其适用于需要重复播放视频内容的场合,包括但不限于:

- 视频背景: 为网站、应用程序或演示文稿提供动态、不间断的背景。

- 图标动画: 制作带有循环动画效果的图标。

- 短视频内容: 创作引人注目的短视频,使其可以无限循环播放,增加观看时长和趣味性。

- 数字艺术: 艺术家可以利用其制作循环播放的视觉艺术作品。

- GitHub仓库:https://github.com/red-polo/F...

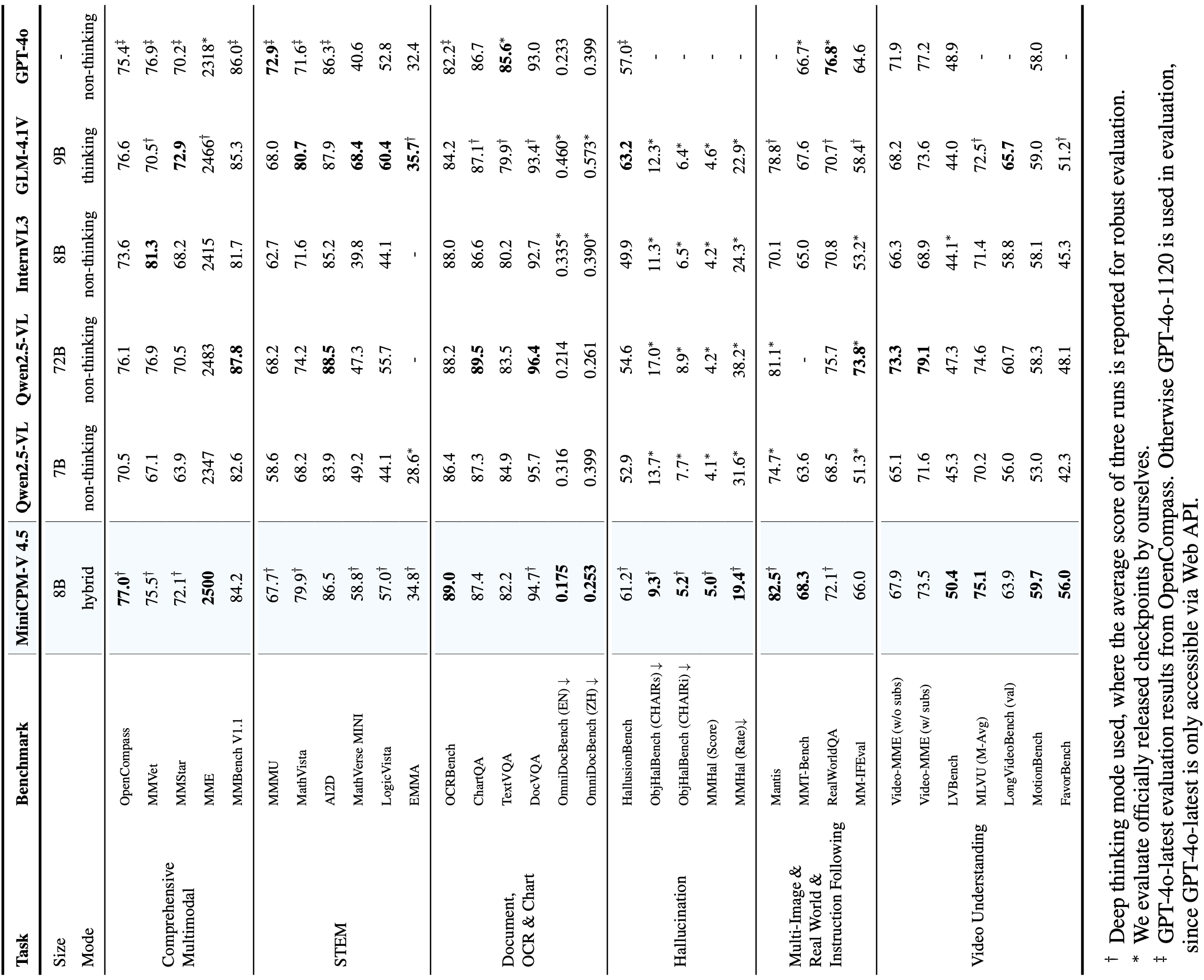

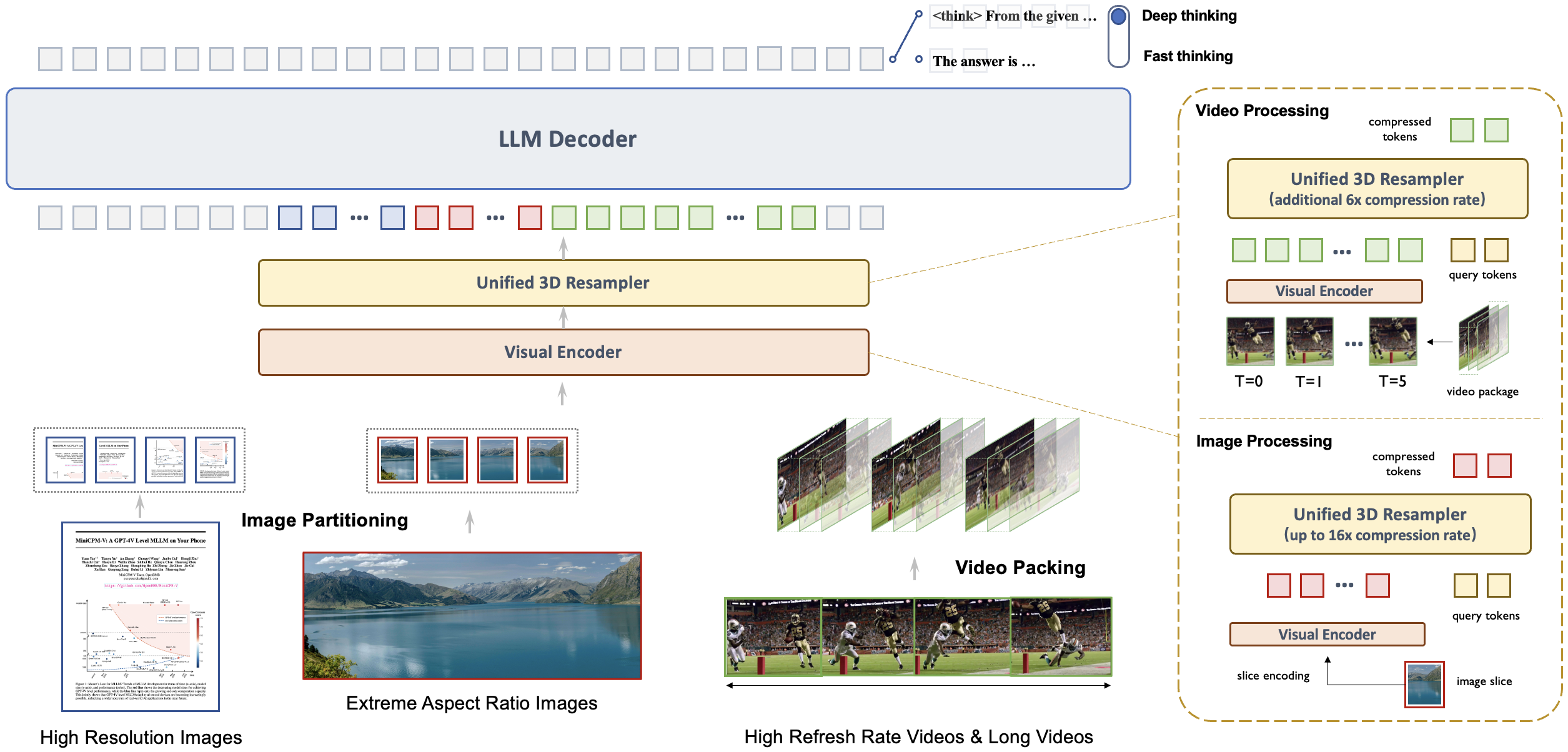

MiniCPM-V 4.5 – 面壁端侧多模态模型

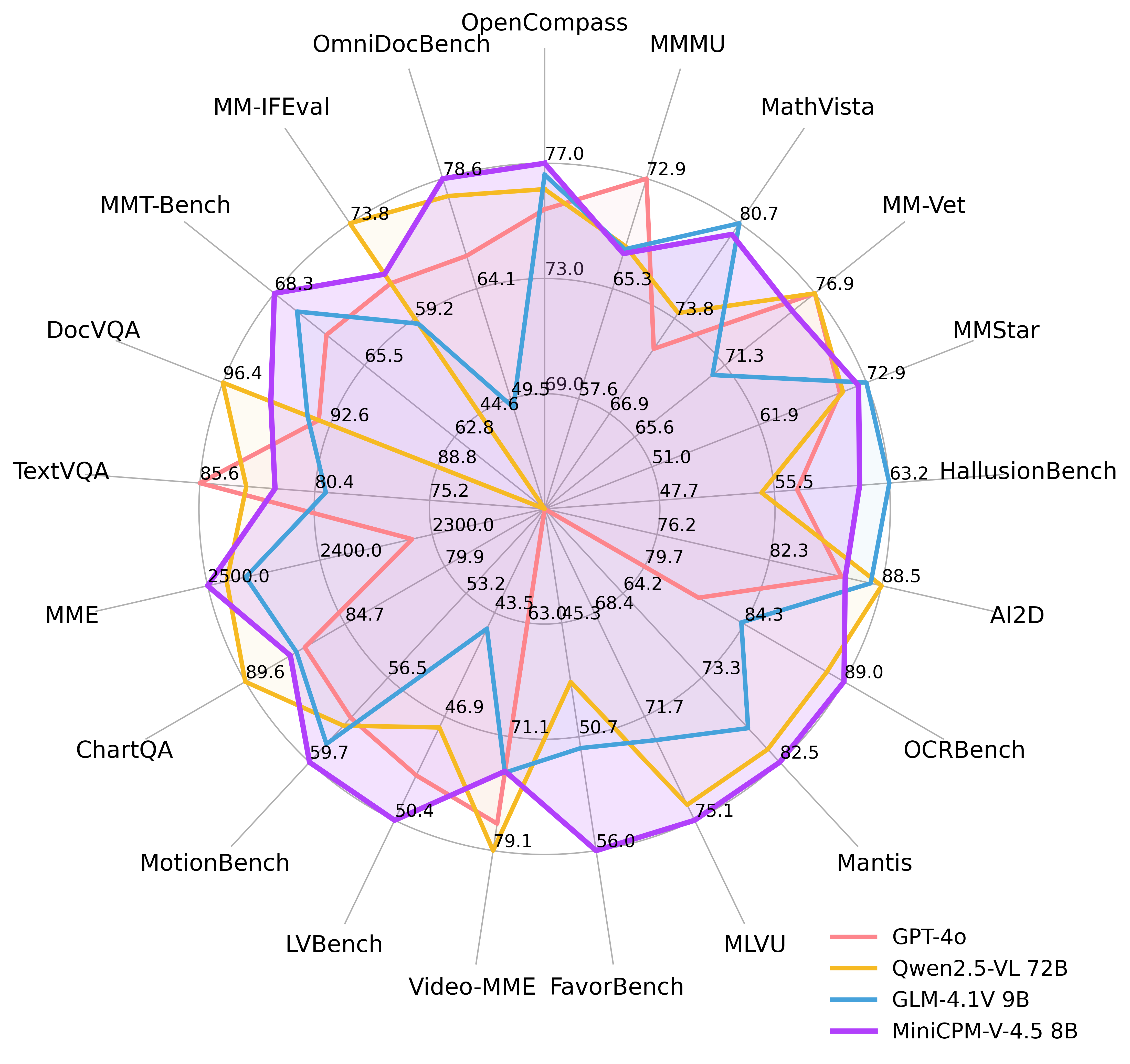

MiniCPM-V 4.5是MiniCPM-V系列中最新、功能最强大的模型,总参数量为80亿,由Qwen3-8B和SigLIP2-400M构建。它在视觉-语言能力方面表现卓越,超越了GPT-4o-latest、Gemini 2.0 Pro等专有模型以及Qwen2.5-VL 72B等开源模型,成为30亿参数以下性能最佳的端侧多模态模型。该版本显著提升了性能并引入了高效高刷新率长视频理解、可控的混合快/深度思维等新功能。

核心功能

- 多模态理解能力: 接受图像、视频和文本作为输入,并输出高质量文本,MiniCPM-o版本还支持音频输入和高质量语音输出。

- 高分辨率图像处理: 基于LLaVA-UHD架构,能处理任意宽高比、高达180万像素(如1344x1344)的高分辨率图像,且视觉token使用量比大多数多模态大语言模型(MLLMs)少4倍。

- 混合快/深度思维模式: 提供“快思考”和“深度思考”两种可切换模式,通过混合强化学习方法优化,平衡了日常使用效率和复杂任务处理能力。

- 高效视频理解: 支持高效的高刷新率和长视频理解,视频token压缩率高达96倍。

- 文档解析与OCR: 在OCRBench和OmniDocBench上表现出色,具有领先的OCR识别和PDF文档解析能力。

技术原理

MiniCPM-V 4.5模型基于Qwen3-8B语言模型和SigLIP2-400M视觉模型进行构建。其核心技术原理包括:

- LLaVA-UHD架构: 用于高效处理高分辨率图像,通过减少视觉token数量来优化性能。

- 混合强化学习(Hybrid Fast/Deep Thinking with Multimodal RL): 结合RLPR和RLAIF-V技术,共同优化模型的快思考和深度思考模式,以泛化鲁棒的推理技能。

- RLAIF-V和VisCPM技术: 这些技术被用于进一步提升模型的视觉-语言对齐和推理能力。

- 参数优化: 采用80亿参数的紧凑设计,实现在端侧设备上的高性能部署。

- 高效视频编码: 通过高压缩率(96x)处理视频tokens,实现高效长视频理解。

应用场景

- 移动端设备与边缘计算: 作为性能最佳的端侧多模态模型,适用于手机、平板等资源受限设备上的AI应用。

- 智能助理与对话系统: 可用于开发能理解图像、视频和文本输入,并进行智能问答和交互的智能助理。

- 文档自动化与处理: 凭借其强大的OCR和PDF文档解析能力,可应用于自动化文档录入、信息提取和报告生成等领域。

- 视频内容分析: 适用于视频监控、短视频内容理解、视频摘要生成等需要高效处理视频流的场景。

- 多媒体内容创作与理解: 为内容创作者提供基于图像和视频的智能辅助,如图像描述、视频字幕生成等。

- GitHub仓库:https://github.com/OpenBMB/Mi...

- HuggingFace模型库:https://huggingface.co/openbm...

- 在线体验Demo:http://101.126.42.235:30910/

Meeseeks – 美团开源指令遵循能力评测集.

Meeseeks是美团M17团队开源的一个大模型评测集,专注于评估大型语言模型(LLMs)的指令遵循能力。该评测集基于真实业务数据构建,旨在全面衡量模型是否能够严格按照用户指令进行响应,并引入了迭代反馈机制,以促进模型的自我修正和能力提升。

核心功能

- 指令遵循能力评估: Meeseeks的核心功能是全面评测大模型在复杂指令下的遵循能力。

- 三级评测框架: 通过宏观到微观的三级评测框架,对模型的指令执行情况进行多维度细致的衡量。

- 基于真实业务数据: 评测数据集来源于实际业务场景,确保评估结果的实用性和准确性。

- 迭代反馈与自我修正: 支持模型接收结构化反馈并迭代优化响应,提升模型在多轮对话中的表现。

技术原理

Meeseeks 的技术原理主要围绕其独特的评估机制和数据构造:

- 多层次评估体系: 采用三级评测框架,从不同粒度(例如,宏观意图理解、中间步骤执行、微观细节实现)评估模型的指令遵循度,确保评估的全面性。

- 行为导向评测: 区别于传统基于文本相似度的评测,Meeseeks更注重模型实际执行指令后所产生的行为或结果是否符合预期,即“只关注模型行为”。

- 真实业务数据驱动: 评测集的数据集完全基于美团的真实业务数据构建,通过对海量用户与业务交互数据的清洗、标注和筛选,确保评测数据的多样性和代表性,从而更真实地反映模型在实际应用中的表现。

- 自校正循环机制(Self-correction Loop): 在评估过程中,模型可以接收到结构化的反馈,并利用这些反馈信息来调整和优化其后续响应,从而实现类似于强化学习中的自我迭代和能力提升。

应用场景

- 大模型研发与优化: 作为衡量和改进大模型指令遵循能力的关键基准,帮助研究人员和开发者发现模型在理解和执行指令方面的弱点,从而进行针对性优化。

- 模型选型与部署: 为企业在选择和部署适合特定业务场景的大模型时提供客观的评估依据。

- 学术研究: 为LLM指令遵循、行为评估等领域提供标准化的评测工具和数据集,促进相关研究的深入。

- 个性化AI助手: 通过评估和提升模型对用户个性化指令的理解和执行能力,从而改进智能客服、智能助手等产品的用户体验。

- GitHub仓库:https://github.com/ADoublLEN/...

- HuggingFace模型库:https://huggingface.co/datase...

美团 LongCat-Flash-Chat

美团正式发布并开源 LongCat - Flash - Chat。该模型采用创新性混合专家模型架构,实现计算效率与性能双重优化,推理速度快,适合复杂智能体应用。在多领域基准测试中表现优异,还提供两种高效部署方案,已在 Github、Hugging Face 平台开源。

核心功能

- 计算效率与性能优化:创新性架构使计算效率和性能双提升,少量激活参数时性能比肩主流模型。

- 快速推理:推理速度快,适合耗时较长的复杂智能体应用。

- 多领域表现良好:在通用领域知识、智能体工具使用、编程、指令遵循等方面表现出色。

- 高效部署:提供基于 SGLang 和 vLLM 的两种高效部署方案。

技术原理

- 架构层面:采用混合专家模型(Mixture - of - Experts, MoE)架构,引入“零计算专家(Zero - Computation Experts) ”机制,实现算力按需分配和高效利用。

- 训练优化:训练过程采用 PID 控制器实时微调专家偏置,稳定单 token 平均激活量;层间铺设跨层通道,使通信和计算并行;对常用大模型组件和训练方式改进,使用超参迁移和模型层叠加方式训练。

- 底层优化:定制化底层优化,实现高效训练和高推理速度。

应用场景

- 复杂智能体应用:因其推理速度快,适合耗时较长的复杂智能体任务。

- 通用知识问答:在通用领域知识基准测试表现好,可用于知识问答场景。

- 编程辅助:在编程相关基准测试有竞争力,可辅助编程工作。

- 指令遵循任务:在指令遵循方面优势显著,适用于需遵循复杂指令的任务。

- Hugging Face:https://huggingface.co/meitua...

- Github:https://github.com/meituan-lo...

阶跃发布端到端语音大模型Step-Audio 2 mini

阶跃星辰发布端到端语音大模型 Step - Audio 2 mini,在多个国际基准测试集获 SOTA 成绩。它将语音理解、音频推理与生成统一建模,支持语音原生的 Tool Calling 能力,已上线 GitHub、Hugging Face 等平台。

核心功能

- 多任务处理:在音频理解、语音识别、跨语种翻译、情感与副语言解析、语音对话等任务中表现出色。

- Tool Calling 能力:率先支持语音原生的 Tool Calling,可实现联网搜索等操作。

- 精细理解与回应:能对情绪、语调等副语言和非语音信号精细理解、推理并自然回应。

- 逻辑推理:可将抽象哲学问题转化为具体方法论,引导用户解决问题。

技术原理

- 真端到端多模态架构:突破传统 ASR + LLM + TTS 三级结构,实现原始音频输入到语音响应输出的直接转换。

- CoT 推理结合强化学习:在端到端语音模型中首次引入链式思维推理与强化学习联合优化。

- 音频知识增强:支持包括 web 检索等外部工具,解决幻觉问题,赋予多场景扩展能力。

- GitHub:https://github.com/stepfun-ai...

- Hugging Face:https://huggingface.co/stepfu...

- ModelScope:https://www.modelscope.cn/mod...

3. AI-Compass

AI-Compass 致力于构建最全面、最实用、最前沿的AI技术学习和实践生态,通过六大核心模块的系统化组织,为不同层次的学习者和开发者提供从完整学习路径。

- github地址:AI-Compass👈:https://github.com/tingaicompass/AI-Compass

- gitee地址:AI-Compass👈:https://gitee.com/tingaicompass/ai-compass

🌟 如果本项目对您有所帮助,请为我们点亮一颗星!🌟

📋 核心模块架构:

- 🧠 基础知识模块:涵盖AI导航工具、Prompt工程、LLM测评、语言模型、多模态模型等核心理论基础

- ⚙️ 技术框架模块:包含Embedding模型、训练框架、推理部署、评估框架、RLHF等技术栈

- 🚀 应用实践模块:聚焦RAG+workflow、Agent、GraphRAG、MCP+A2A等前沿应用架构

- 🛠️ 产品与工具模块:整合AI应用、AI产品、竞赛资源等实战内容

- 🏢 企业开源模块:汇集华为、腾讯、阿里、百度飞桨、Datawhale等企业级开源资源

- 🌐 社区与平台模块:提供学习平台、技术文章、社区论坛等生态资源

📚 适用人群:

- AI初学者:提供系统化的学习路径和基础知识体系,快速建立AI技术认知框架

- 技术开发者:深度技术资源和工程实践指南,提升AI项目开发和部署能力

- 产品经理:AI产品设计方法论和市场案例分析,掌握AI产品化策略

- 研究人员:前沿技术趋势和学术资源,拓展AI应用研究边界

- 企业团队:完整的AI技术选型和落地方案,加速企业AI转型进程

- 求职者:全面的面试准备资源和项目实战经验,提升AI领域竞争力