Tengine是一款开放AIoT应用开发平台,助力AIoT全行业的快速赋能及应用落地。Tengine平台可以高效的适配于绝大部分搭载了Arm架构的芯片设备,并兼容TensorFlow、Caffe,mxnet,onnx等主流深度学习开源框架的模型。开发者可以使用Tengine一键部署主流框架模型到嵌入式操作系统,还能异构调度平台里的各类硬件,充分利用硬件算力。

此外,Tengine还提供了常见的AI应用算法,包括图像检测,人脸识别,语音识别等。不懂AI没关系,用Tengine上手就能跑AI应用。

一、增加3大新功能

1.GPU backend support with ACL 19.02

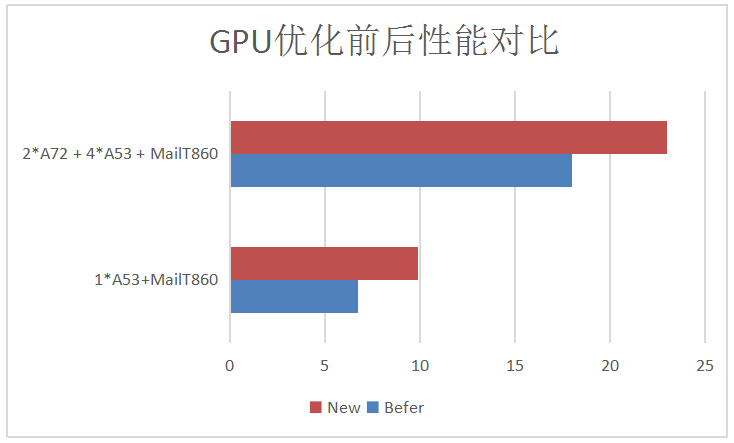

最新版本Tengine1.7.1对Mail GPU的支持,无论是在性能还是在硬件支持平台上,均有了质的提升,我们当前支持ACL 19.02版本,对GPU的支持面覆盖到ACL可支持的硬件平台,并且在Tengine本身的异构框架下做到了进一步的性能提升。

基于RK3399的Mail T860 GPU和CPU异构的性能对比(MobilenetSSD)

2.Static tool for convert other models to Tengine

我们提供了基于最新版本的模型转换工具,只需要在x86的Linux环境下既可以进行模型转换,参数简单,操作方便,不依赖任何其他三方库和文件 ,相比之前还需要依赖库有了更方便的操作体验。

模型转换工具支持:caffe,TensorFlow,mxnet,onnx,tf_lite等模型格式的直接转tengine,具体的算子支持情况,请移步Tengine开发者网站:http://www.tengine.org.cn/jis...

3.Tengine graph use origin layout to execute

Tengine支持使用模型原始的layout去执行,不会在执行时转换模型的维度,避免模型格式转换时遇到的一些问题 ,当前Tengine支持两种layout格式NCHW和NHWC 。

二、性能进一步优化

在功能丰富的前提下我们同步对性能又做了进一步的优化,当前的性能提升主要有三点:

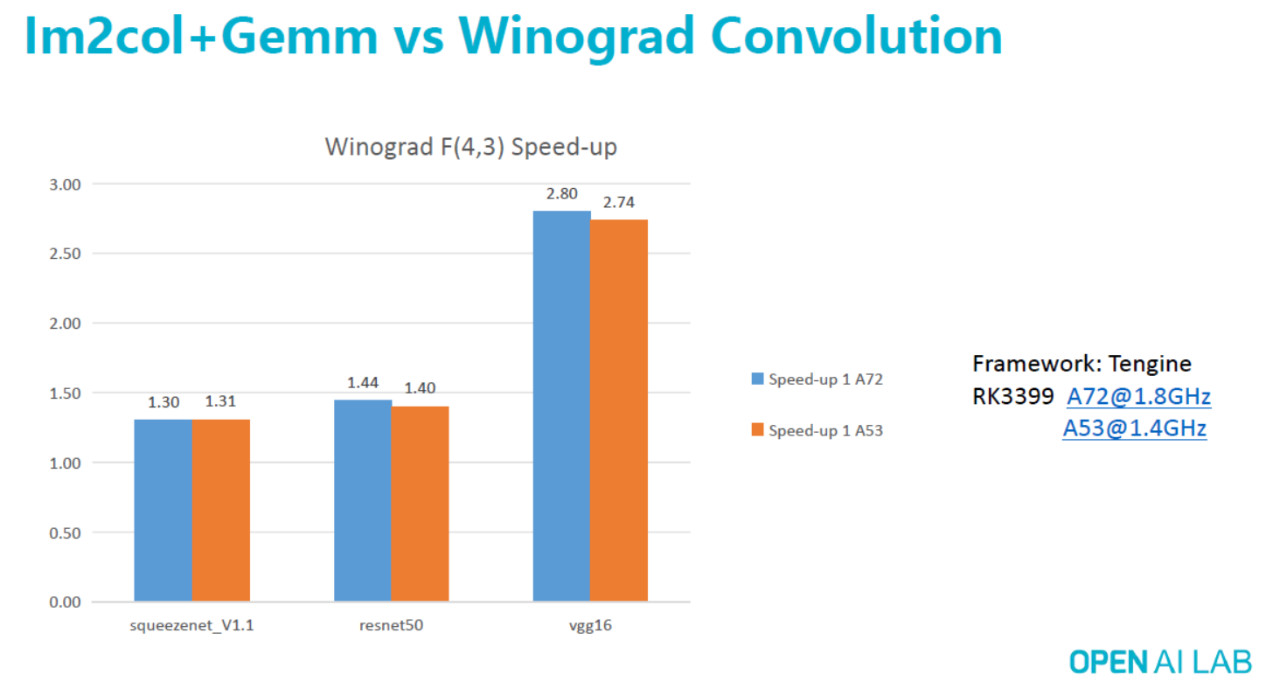

1、添加了对Winograd快速卷积方法的支持

该卷积方法对卷积运算有了进一步的调优,比原始的卷积计算方法减少了大量的乘法运算,提升了运算性能,针对几个开源网络我们实测了下性能提升的对比倍数,如下是不同硬件和不同网络下winograd相对于gemm性能提升的倍数关系图。

exp:vgg16在1*A72@1.8G 环境下Winograd的性能是Gemm的2.8倍

2、 支持LSTM算子的汇编优化实现

3、 支持GRU算子的汇编优化实现

三、Tengine 1.7.1 版本下载

本次开放下载,我们提供了市面上大多数的硬件平台的开发者版本,用户不需要申请即可免费下载 ,如下为我们本次开放下载的版本列表:

Tengine1.7.1 下载页面链接:http://www.tengine.org.cn/info.php?class_id=105105

四、送福利

Tengine推理引擎在助力AI落地上起到了举足轻重的作用,为了让广大开发者更方便的使用Tengine,也为了更加的完善我们的Tengine产品,现开放以下福利给广大的开发者 :

在使用Tengine过程中,如果发现Tengine有NN的算子不支持的,并能提供对应资料,有如下奖励:

▶ 个人用户奖励150元现金红包;

▶ 企业用户提供免费1年的技术支持服务,和OPEN AI LAB签署生态合作协议,并奖励提出者300元现金红包。

1,资料包括:包含所提交的不支持算子的模型,以及用Tengine推理运行的异常日志;

2,NN算子限于Mxnet ,Caffe,TensorFlow,onnx框架平台支持的标准算子;

3,每个不支持的算子只奖励第一个提出者;

4,提交相关信息到Developer@openailab.com邮箱;

5,奖励上限为1000份;

6,活动会每周定期公布提交的人的邮箱和相关信息;

7,本活动OPEN AI LAB拥有最终解释权。

Tengine1.7.1 下载页面链接:http://www.tengine.org.cn/info.php?class_id=105105