近年,基于分割的方法在场景文字检测领域很流行,即把分割方法产生的概率图转化为边界框和/文字区域;并且,二值化的后处理对这些方法而言很关键。本论文提出一种可微分二值化(DB)的方法,可在分割网络中进行二值化。有了它,分割网络可以自适应地设定二值化阈值,这不仅可以简化后处理,还可以提升文字检测性能。通过一个简单的分割网络,旷视研究院在 5 个基准数据集上的实验,取得了速度和精度的双重当前最佳,验证了这一新方法的性能提升。本工作由旷视研究院联合华中科技大学完成,将作为口头报告出现在AAAI-2020会议中。

论文名称:Real-time Scene Text Detection with Differentiable Binarization

论文链接:https://arxiv.org/abs/1911.08947

开源代码:https://github.com/MhLiao/DB

导语

近年,由于场景文字阅读有着广泛的实际应用价值,比如图像/视频理解,视频搜索,自动驾驶,盲文辅助等,这一研究领域越发活跃起来。

作为场景文字阅读的一个核心组件,场景文字检测(scene text detection)旨在定位每一个文字实例的边界框和区域,但这并非易事,文字常常有着不同的大小和形状,比如水平,多方向和弯曲。

得益于像素级别的预测结果,基于分割的场景文字检测方法可以描述不同形状的文字,因而最近流行开来。但是,大多数基于分割的方法需要复杂的后处理,把像素级别的预测结果分类为已检测的文字实例,导致推理的时间成本相当高。

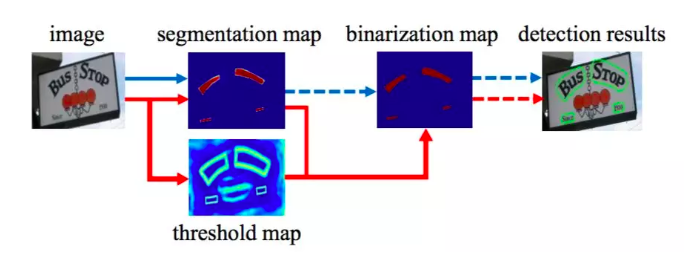

图 2:传统pipeline(蓝箭头)和本文pipelie(红箭头)

同时,大多数现有的检测方法的后处理是相似的,如图 2 所示(蓝箭头):

- 一个固定的阈值被设定,以把分割网络产生的概率图转化为二值图;

- 通过一些启发式技巧比如像素聚类,把像素分类为文字实例。

简介

有鉴于此,旷视研究院新方法的 pipeline(红箭头)通过把二值化操作嵌入到分割网络以进行联合优化。

借助这一方式,图像上每个点的阈值皆可获得相应的预测,从而把前景与背景的像素完全区分开。然而,这一标准的二值化函数并不是可微分的,取而代之,旷视研究院给出了一个二值化的近似函数,称之为可微分二值化(DB),当进行分割网络训练时,它是完全可微分的。

这一方法的主要贡献是可微分模块 DB 的提出,它使得 CNN 的二值化处理的端到端训练成为现实。通过在一个简单的分割网络中加入 DB 模块,旷视研究院给出了一个鲁棒而快速的场景文字检测器。基于来自 DB 模块的性能评估,本文发现,相较于当前最优的基于分割的方法,该检测器有以下明显优势:

- 本文方法连续在水平、多方向和弯曲文字在内的 5 个基准数据集上获得更加性能;

- 本文方法比先前的领先方法速度更快;

- 在使用轻量级 backbone 时,DB 表现相当好;

- 由于可在没有任何性能损失的情况下,把 DB 从推理阶段移除,也就没有测试方法的额外内存/时间成本。

方法

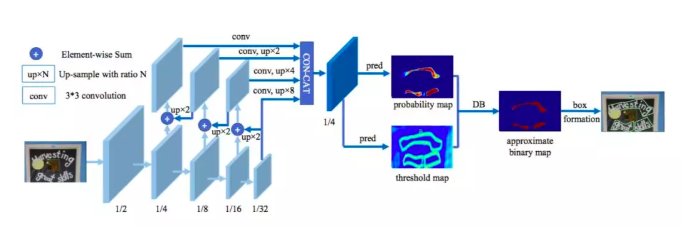

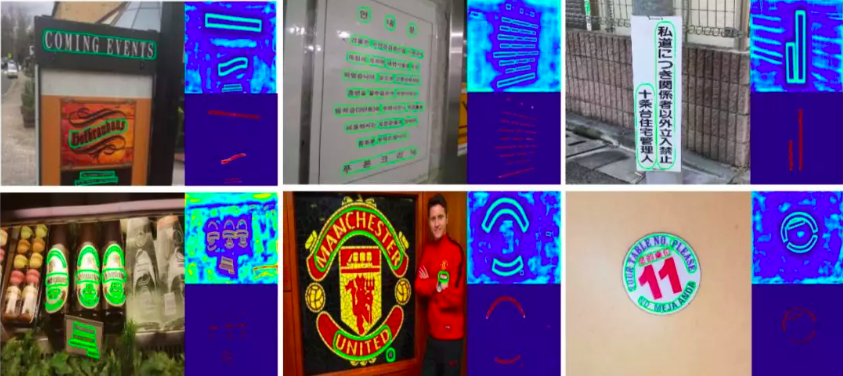

本文方法的架构如图 3 所示。

图 3:本文方法架构图

首先,输入图像被馈送至一个金字塔特征的 backbone;其次,金字塔特征被上采样为同一大小,并被级联以生产特征 F;接着,通过特征 F 同时预测概率图(P)和阈值图(T);最后,通过 P 和 F 计算近似的二值

在训练阶段,监督被应用在阈值图、概率图和近似的二值图上,其中后两者共享同一个监督;在推理阶段,则可以从后两者轻松获取边界框。

可微分二值化

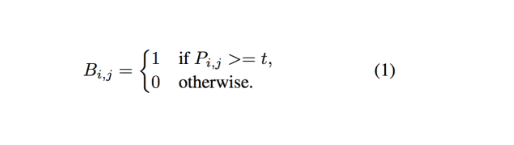

等式 1 中的标准二值化是不可微分的。因此它在训练阶段无法随着分割网络被优化。

为解决这一问题,旷视研究院提出执行带有近似步函数的二值化:

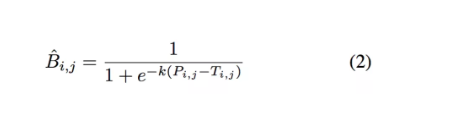

这一近似二值化函数虽与标准的二值化函数类似,但是可微分的,因此训练时可随着分割网络一起优化。带有自适应阈值的可微分二值化不仅有助于把文字区域与背景区分开,而且还能把相近的实例分离开来。一些实例如图 7 所示。

图 7:不同形状文字实例的可视化结果

自适应阈值

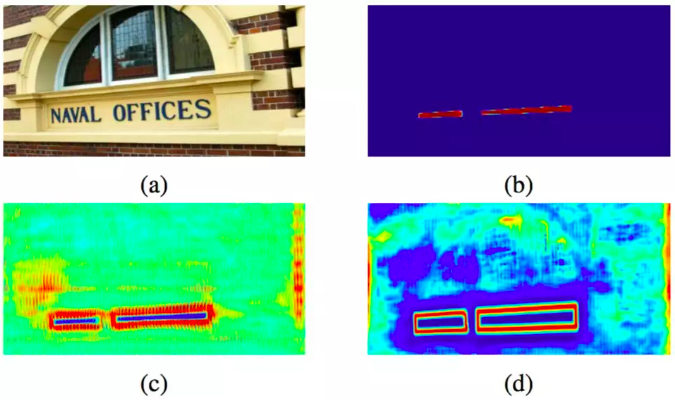

从表面上看,图 1 中的阈值图与论文(Xue, Lu, and Zhan 2018) 中的文字边界图相似。然而,阈值图的动机和使用方法却与文字边界图不一致。带有/不带有监督的阈值图如图 6 所示。

图 6:带有/不带有监督的阈值图

即使没有监督,阈值图也会强调文字的边界区域,这表明像边界一样的阈值图有助于最终结果。因此,本文把像边界一样的监督应用于阈值图,以获得更好的指导。

标签生成

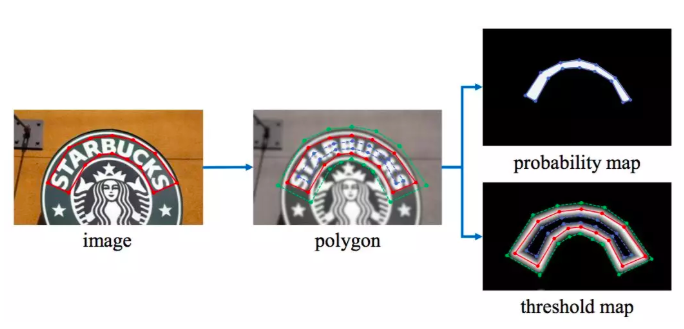

图 5:标签生成

概率图的标签生成收到了 PSENet 的启发。给定一张文字图像,其文本区域的每个多边形由一组线段描述:

接着,通过 Vatti clipping 算法 (Vati 1992)缩小多边形,从而生成正区域:

通过相似的操作,即可为阈值图生成标签。

实验

本文把旷视研究院的方法与现有方法在 5 个标准基准上做了对比,包括 2 个弯曲文字基准,一个多方向文字基准,以及 2 个长文字线条的多语言基准,一些定量结果如图 7 所示。

弯曲文字检测

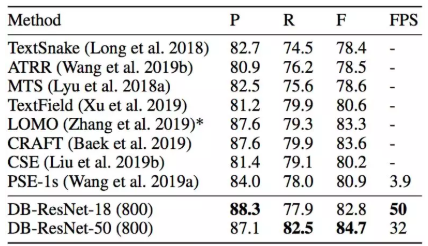

旷视研究院在两个弯曲文字基准 Total-Text 和 CTW1500 上证明了本文方法明显的鲁棒性。如表 3 和表 4 所示,该方法同时在精度和速度上获得了当前最佳性能。

具体而言,在 Total- Text 和 CTW1500 数据集上,DB-ResNet-50 分别超出先前最佳方法 1.1 个点和 1.2 个点。DB-ResNet-50 快于先前所有方法,且通过 ResNet-18 backbone,速度可进一步提升。相较于当前基于分割的检测器 (Wang et al. 2019a)(在 Total- Text 上速度为 3.9 fps),DB-ResNet-50 (800)的速度要快上 8.2x;DB- ResNet-18 (800)的速度是 12.8x。

表 3:Total-Text 数据集上的检测结果

表 4:CTW1500 数据集上的检测结果

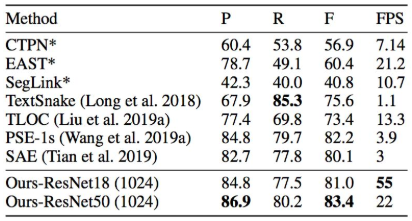

多方向文字检测

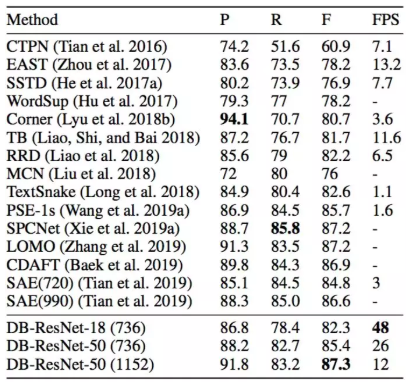

如表 5 所示,在 ICDAR 2015 数据集上,DB-ResNet-50 (1152) 获得了当前最佳的精度;相较于先前的最快方法(Zhou et al. 2017),DB-ResNet-50 (736) 精度上超出 7.2 个百分点,并且速度是 2 倍。当 ResNet-18 作为 backbone 时,DB- ResNet-18 (736) 速度高达 48 fps,同时 f-measure 为 82.3。

表 5:ICDAR 2015 数据集上的检测结果

多语言文字检测

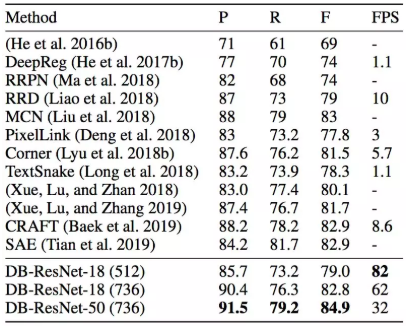

本文方法在多语言文字检测上同样鲁棒。如表 6 和表 7 所示,DB-ResNet-50 在精度和速度上优于先前方法。

速度方面,在 MSRA-TD500 数据集上,DB-ResNet-50 快于先前最快方法 (Liao et al. 2018) 3.2x。在 MSRA-TD500 数据集上,借助一个轻量级 backbone,DB- ResNet-18 (736) 相较于先前最佳方法 (Liu et al. 2018) (82.8 vs 83.0) 取得了一个有竞争力的精度,且速度为 62 fps,是先前最快方法 (Liao et al. 2018) 的 6.2x;如果减小输入大小,该速度可进一步提升至 82 fps。

表 6:MSRA-TD500 数据集上的检测结果

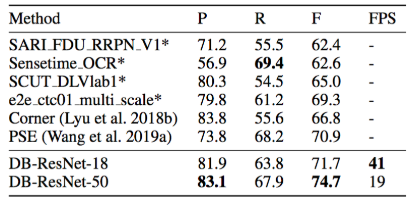

表 7:MLT-2017 数据集上的检测结果

结论

本文中,旷视研究院给出了一个检测任意形状的场景文字的全新框架,其分割网络中包含了本文提出的可微分二值化(DB)操作。

实验证明,就速度和精度而言,本文方法(ResNet-50 backbone)已在 5 个标准的场景文字基准上连续超越当前最佳方法。

特别是,仅使用一个轻量级 backbone,本文方法也可在所有测试数据集上以实时的推理速度取得有竞争力的表现。未来,将会进一步把该方法扩展至端到端的文字识别。

参考文献

[1] Baek, Y.; Lee, B.; Han, D.; Yun, S.; and Lee, H. 2019. Character region awareness for text detection. In Proc. CVPR, 9365–9374.

[2] Deng, D.; Liu, H.; Li, X.; and Cai, D. 2018. Pixellink: Detecting scene text via instance segmentation. In Proc. AAAI.

[3] Vati, B. R. 1992. A generic solution to polygon clipping. Communications of the ACM 35(7):56–64.

[4] Wang, X.; Jiang, Y.; Luo, Z.; Liu, C.-L.; Choi, H.; and Kim, S. 2019b. Arbitrary shape scene text detection with adaptive text region representation. In Proc. CVPR, 6449–6458.

[5] Yao, C.; Bai, X.; and Liu, W. 2014. A unified framework for multioriented text detection and recognition. IEEE Trans. Image Processing 23(11):4737–4749.

[6] Liao, M.; Shi, B.; and Bai, X. 2018. Textboxes++: A singleshot oriented scene text detector. IEEE Trans. Image Processing 27(8):3676–3690.

[7] Liu, Y., and Jin, L. 2017. Deep matching prior network: Toward tighter multi-oriented text detection. In Proc. CVPR.

[8] Liu, W.; Anguelov, D.; Erhan, D.; Szegedy, C.; and Reed, S. E. 2016. SSD: single shot multibox detector. In Proc. ECCV.

专栏文章推荐

- AAAI20 | 旷视研究院提出TextScanner:确保字符阅读顺序,实现文字识别新突破

- R TALK | 旷视危夷晨:不确定性学习在视觉识别中的应用

- R TALK | 旷视孙剑:如何打造云、端、芯上的视觉计算

欢迎关注旷视研究院极术社区专栏,定期更新最新旷视研究院成果

加入旷视:career@megvii.com