今天是第三部分,介绍如何推理新的句子。

作者:CreateMoMo

编译:ronghuaiyang

首发:AI公园公众号

2.6 为新的句子推理标签

在前面的章节中,我们学习了BiLSTM-CRF模型的结构和CRF损失函数的细节。你可以通过各种开源框架(Keras、Chainer、TensorFlow等)实现自己的BiLSTM-CRF模型。最重要的事情之一是模型的反向传播是在这些框架上自动计算的,因此你不需要自己实现反向传播来训练你的模型(即计算梯度和更新参数)。此外,一些框架已经实现了CRF层,因此将CRF层与你自己的模型结合起来非常容易,只需添加一行代码即可。

在本节中,我们将探索如何在模型准备好时在测试期间推断句子的标签。

步骤1:BiLSTM-CRF模型的Emission和transition得分

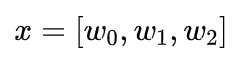

假设,我们有一个包含三个单词的句子:

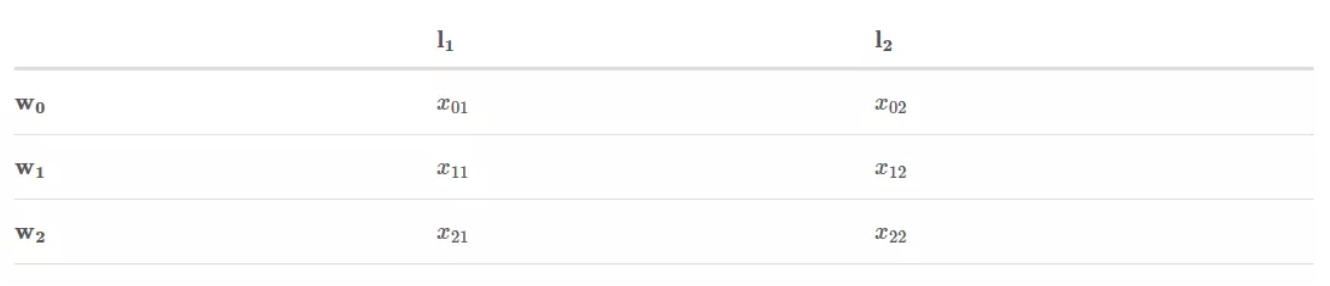

此外,我们已经从BiLSTM模型得到了Emission分数,从下面的CRF层得到了transition分数:

表示被标记为的得分。

是从标签i转换成标签j的得分。

步骤2:开始推理

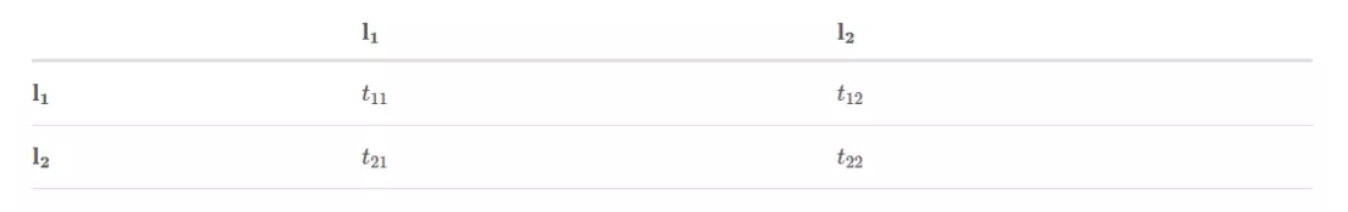

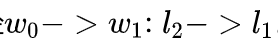

如果你熟悉Viterbi算法,那么这一部分对你来说很容易。但如果你不熟悉,请不要担心。与前一节类似,我将逐步解释该算法。我们将从句子的左到右进行推理算法,如下图所示:

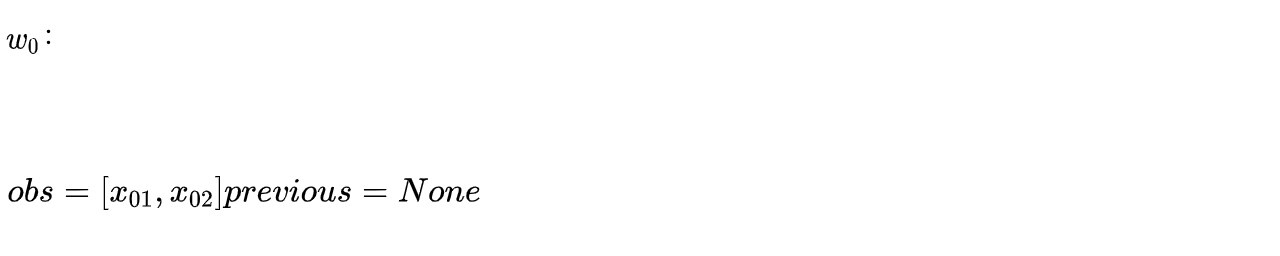

你会看到两个变量:obs和previous。previous存储前面步骤的最终结果。obs表示当前单词的信息。

现在,我们观察到第一个单词,现在,对于是很明显的。

比如,如果

因为只有一个单词,而且没有标签直接的转换,transition的得分没有用到。

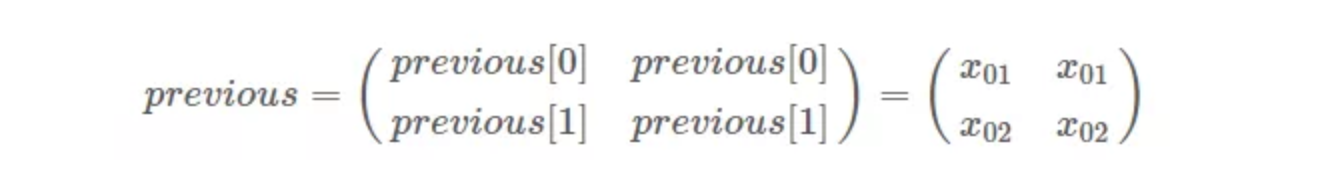

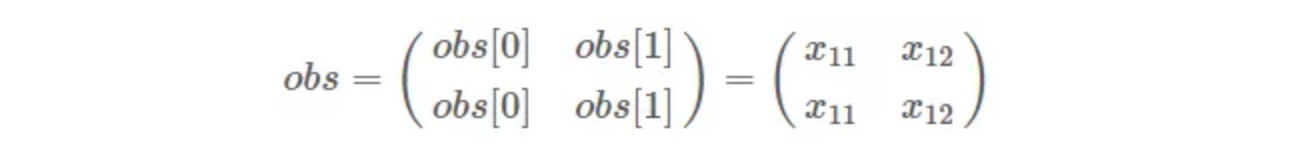

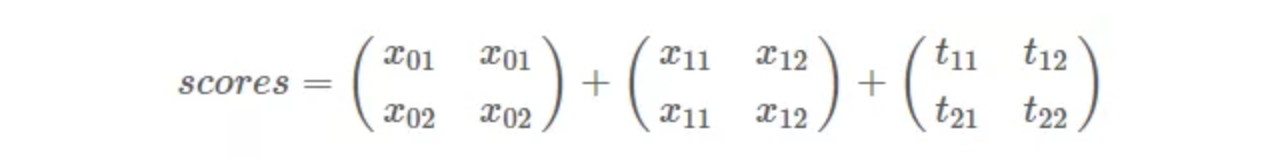

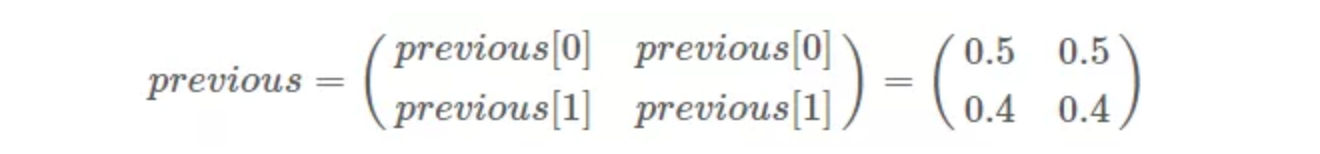

- 把previous扩展成:

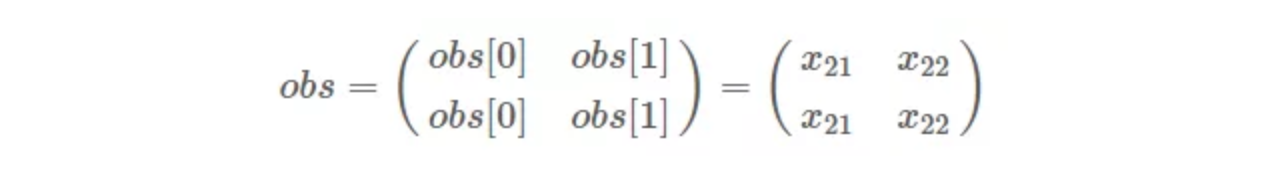

- 把obs扩展成:

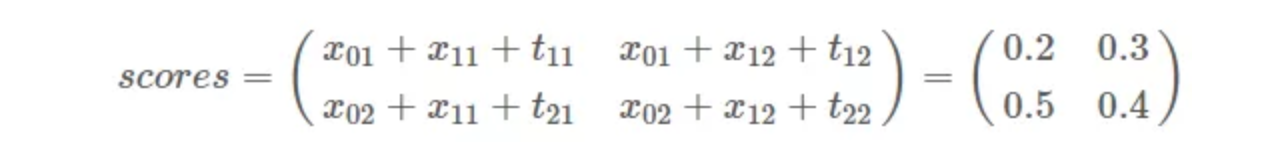

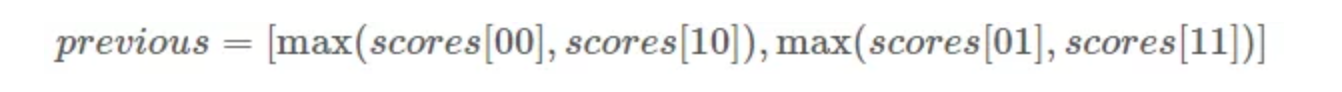

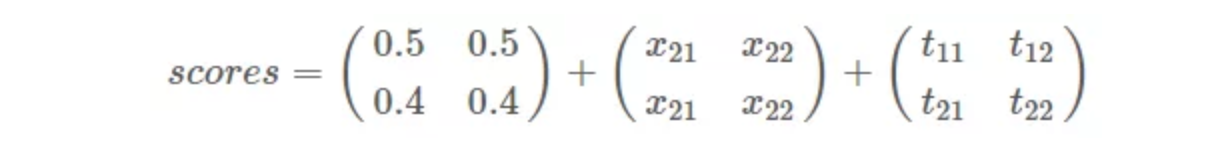

- 把previous, obs和transition分数都加起来:

然后:

你可能想知道,当我们计算所有路径的总分时,与上一节没有什么不同。请耐心和细心,你很快就会看到区别。

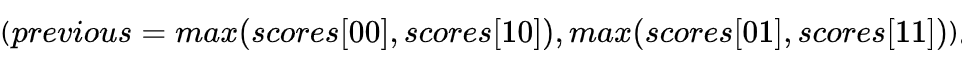

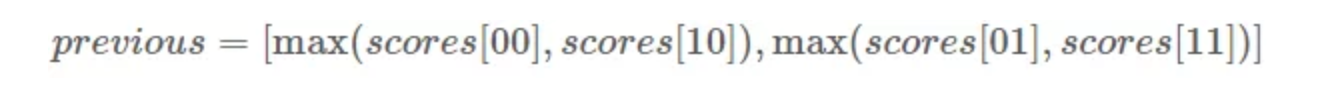

为下一次迭代更改previous的值:

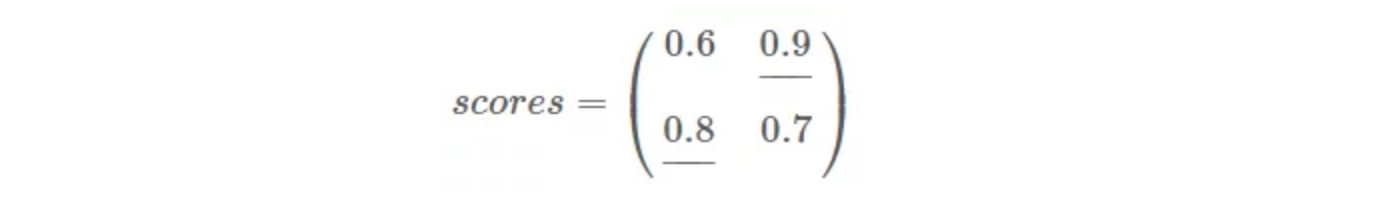

比如,如果我们的得分是:

我们的下个迭代的previous是:

previous有什么含义吗? previous列表存储了每个当前的单词的标签的最大的得分。

[Example Start]

举个例子:

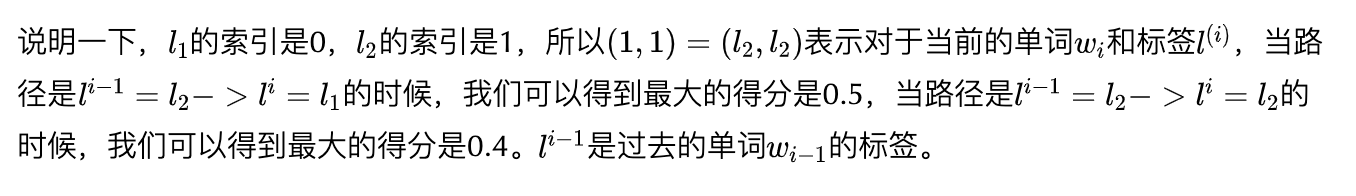

我们知道在我们的语料中,我们总共只有2个标签

这两个标签的索引是0和1。

previous[0]是以第0个标签为结尾的路径的最大得分,类似的previous[1]是以第1个标签为结尾的路径的最大得分。在每个迭代中,变量previous存储了以每个标签为结尾的路径的最大得分。换句话说,在每个迭代中,我们只保留了每个标签的最佳路径的信息

具有小得分的路径信息会被丢掉。

[Example End]

回到我们的主任务:

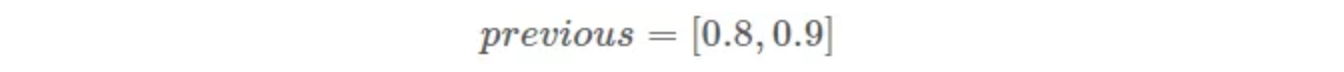

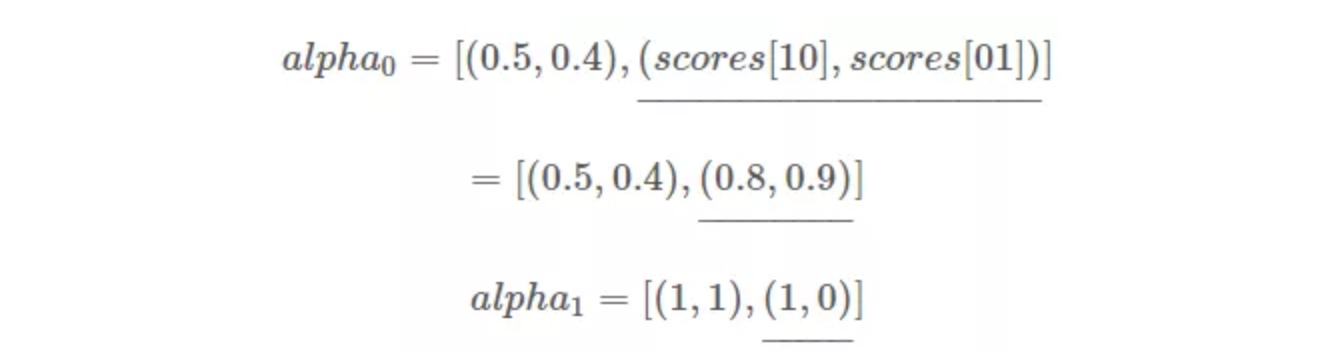

同时,我们还有两个变量用来存储历史信息(得分和索引),

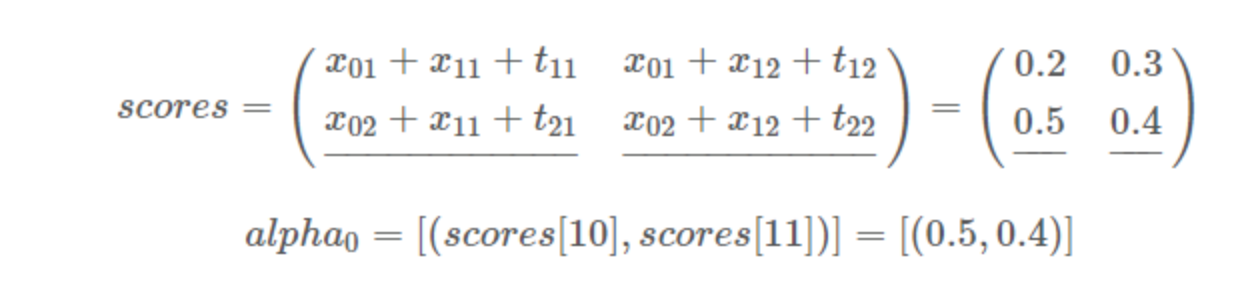

在这个迭代中,我们把最佳得分加上,为了方便,每个标签的最大得分会加上下划线。

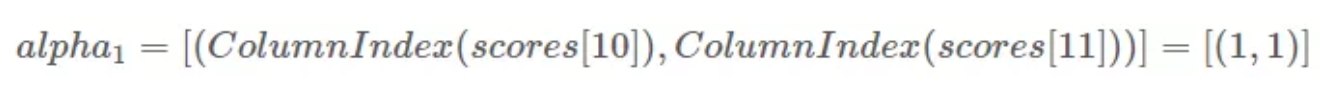

另外,对应的列的索引存在里。

- 把previous扩展成:

- 把obs扩展成:

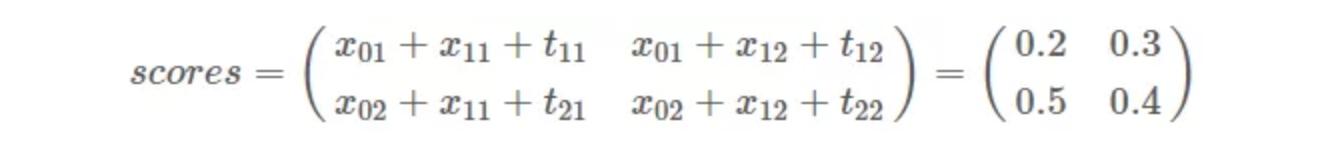

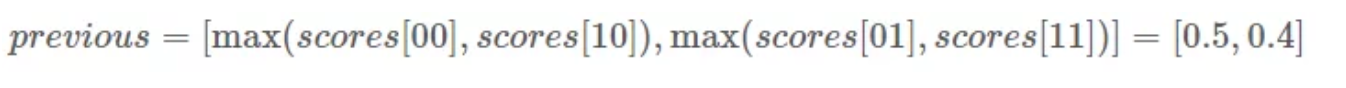

- 把previous, obs和transition 分数都加起来:

然后:

为下一次迭代更改previous的值:

这次迭代我们得到的分数是:

我们得到最新的previous:

实际上,previous[0]和previous[1]中最大的那个就是预测的最佳路径。

同时,每个标签和索引的最大得分会加到

步骤3:找到具有最高得分的最佳路径

这是最后一步!你就快完成了!在此步骤中,将使用

首先,检查

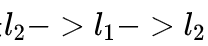

其次,我们继续向后移动并得到

恭喜!我们这个例子中的最佳路径是

—END—

英文原文:https://createmomo.github.io/2017/11/24/CRF-Layer-on-the-Top-of-BiLSTM-6/

推荐阅读

关注图像处理,自然语言处理,机器学习等人工智能领域,请点击关注AI公园专栏。

欢迎关注微信公众号