两年一度的国际计算机视觉大会 ICCV 2019 ( IEEE International Conference on Computer Vision) 将于当地时间 10 月 27 至 11 月 2 日在韩国首尔举办。旷视研究院共有 11 篇接收论文,涵盖通用物体检测及数据集、文字检测与识别、半监督学习、分割算法、视频分析、影像处理、行人/车辆再识别、AutoML、度量学习、强化学习、元学习等众多领域。在此之前,旷视研究院将每周介绍一篇 ICCV 2019 接收论文,助力计算机视觉技术的交流与落地。本文是第 7 篇,旷视研究院提出了一个基于行人重识别的定位修正框架,它能够修正行人检测的结果,使其更加有利于行人搜索任务。实验结果显示,该方法性能优于现有最领先方法。

论文名称:Re-ID Driven Localization Refinement for Person Search

论文地址:https://shimo.im/docs/8gHWHGjr98GPXDjQ

目录

- 导语

- 简介

- 方法

- ROI变换层

- 定位优化

- Proxy Triplet Loss

- 实验

- 结论

- 参考文献

- 往期解读

导语

行人搜索(Person Search)的目标是让系统从一系列未经裁剪的画面中对行人进行定位与识别。与行人重识别(Re-ID)任务不同,行人搜索的性能也与行人检测器的定位精度有关。当前最佳方法是单独训练检测模型和重识别模型,但问题在于因此输出的检测框可能并非接下来行人重识别任务所需的最优区域。为此,旷视研究院提出了一个基于行人重识别的定位修正框架,它能够修正行人检测给出的检测框,使其更加有利于重识别任务。实验结果显示,该方法性能优于现有最佳方法。

简介

虽然行人重识别任务的性能已取得重要成果,但在实践过程中,往往需要和行人检测这一环相配合,即行人搜索任务:该任务的目标是在原始图像中同时定位与识别出特定的人。相较于让系统仅仅去匹配经手工裁剪或行人预检测后的图像,行人搜索任务结合了行人检测与行人重识别。

当前最优的方法是分别训练检测器与重识别模型,这将行人搜索任务拆分为了两个独立的阶段,且检测阶段无法为后面的重识别阶段提供最优的检测信息结果,因此存在一定缺陷。如图 1(b) 所示,它可能忽视某些重要特征,比如背包,或者混入了干扰特征,比如周围的人。

图 1:行人搜索的检测结果

如图 1 所示,(a)代表 ground truth,(b)由通用检测器检测,(c)是由本文方法修正过的结果。可以发现,独立训练的通用检测器无法很好地给出后面重识别所需的输入图像。它包含了很多噪声信息并且漏掉了部分重要细节。作为对比,本文方法可通过去掉多余的背景、增加有用的特征来修正定位的结果,给出对于后面行人搜索任务来说更具判别力的嵌入信息。

为了应对这个问题,旷视研究院提出了一个基于重识别定位优化的网络,它将行人检测与行人重识别结合到了一个端到端框架中。这样做的原因是为了让检测器在重识别损失的监督下进行优化,以便给出更好的检测框。

方法

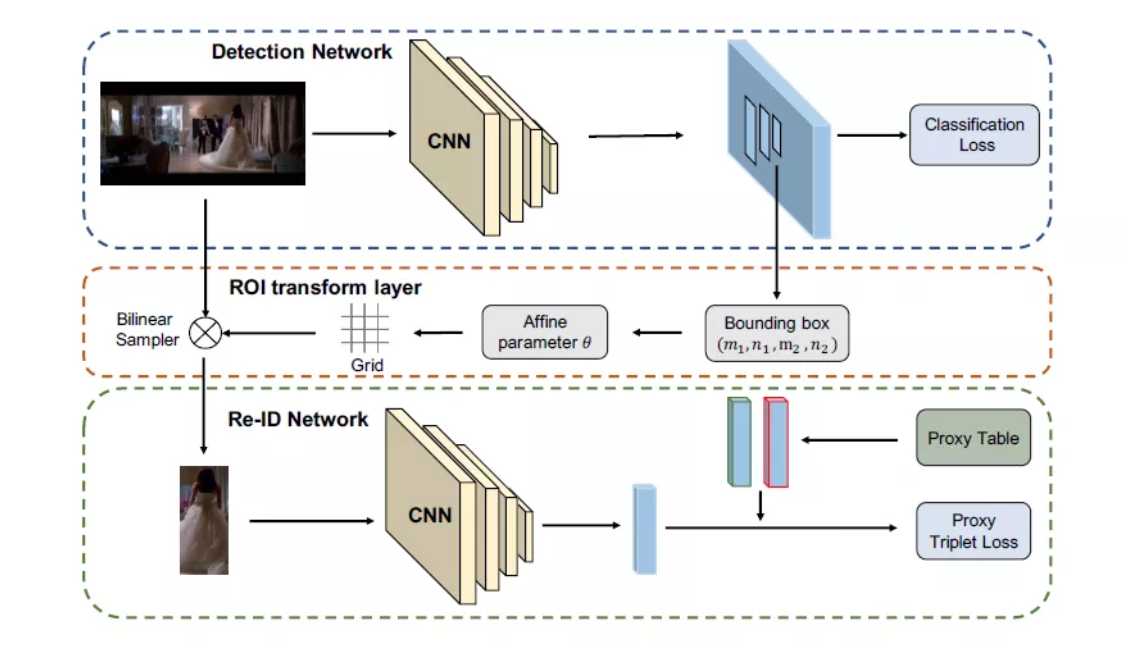

本文方法总体结构如图 2 所示。传统的分类网络一般由两个损失来监督。分类损失用于区分物体类别或背景信息、回归损失用来调整检测框。然而从图 1 可以发现,对于行人搜索任务而言,回归损失无法保证生成后一阶段对行人重识别最合适的检测框,因此旷视研究院在本文行人搜索框架中重新设计了检测器的监督部分。

图 2:本文方法框架

具体而言,团队开发了一个可微的 ROI 变换层,它能够将检测框图像从原始图像中裁剪出来。然后被剪裁的图像被送入一个固定的使用 proxy triplet loss 和 soft-max loss 的重识别模型。由于整个过程是关于检测框坐标可微的,所以检测网络可在端到端网络中用重识别损失来优化,得到经修正的检测框,更好地服务行人搜索任务。

ROI 变换层

在检测网络结构后面,研究员设计了可微的 ROI 变换层,实现检测框图像的裁剪功能。该步骤意在使框架端到端可训练。裁剪检测框的图像有两个原因:首先,尽管检测框的相关特征在一般的检测网络中也可用,但这会导致检测与重识别两个任务共享一个特征嵌入,产生冲突;另外,由于特征图中的感受野足够大,所以裁剪操作会引入冗余的语义,有损重识别性能。因此,裁剪检测框图像就更好。

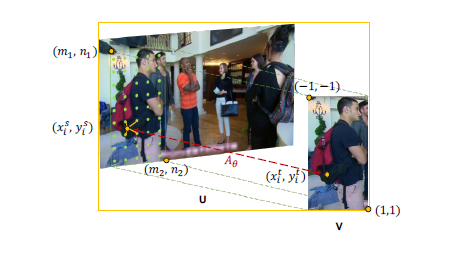

图 3:从原图 U 到目标图像 V 的采样过程

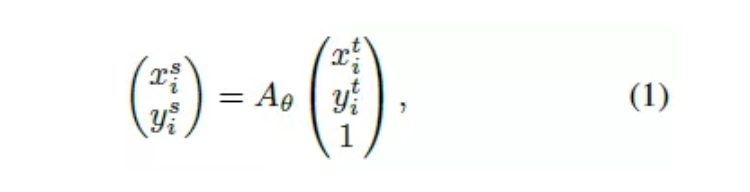

假设检测框的左上、右下坐标在原图中为(m\_1,n\_1,m\_2,n\_2),那么为了从原图中对检测框进行变换,如图 3,研究员就需要首先计算从原图坐标到目标坐标的仿射变换

定位优化

由于分离的检测器的优化目标与行人搜索任务不同,所以旷视研究院在端到端框架中,用重识别损失的监督来优化检测器。在本文的方法中,研究员用重识别损失(包括 proxy triplet loss 和 soft-max loss)替换了回归损失。基于 ROI 变换层,检测框的图像可以由原始图像变换而来。因此前后两个任务便连接了起来,让梯度能够从重识别损失反传到检测框坐标,从而修正了检测器的定位,与行人搜索保持一致。

具体而言,本方法中的检测器与重识别模型均在训练集上经过了预训练。检测网络将原始图像作为输入,生成检测框(这些检测框是 ROI 变换层用于裁剪操作的输入),然后得到对应的图像。此步骤之后接着的是一个参数固定的重识别模型,正因为如此,检测框才能够在重识别损失下进行修正。

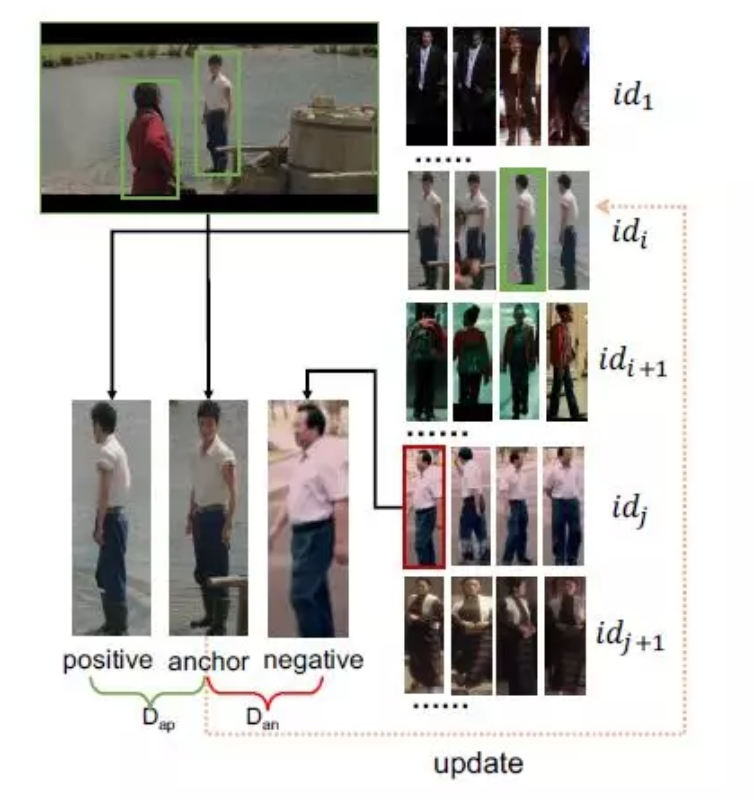

Proxy Triplet Loss

为保证本文方法的可扩展性,研究员也在其他数据集上对重识别模型进行了预训练。因此 softmax 就不可用了,研究员需要开发一个新的标准损失来解决这个问题。Triplet Hard Loss 是在行人重识别中被广泛应用的损失函数,但在行人搜索任务中,由于输入图像较大,导致 batch 的大小受到显存的限制,因此旷视研究院提出了 proxy triplet loss,它通过建立proxy table 来存储由锚点(anchor)样本、正样本、负样本组成的 triplets。

图 4:Proxy Triplet Loss 示意图

实验

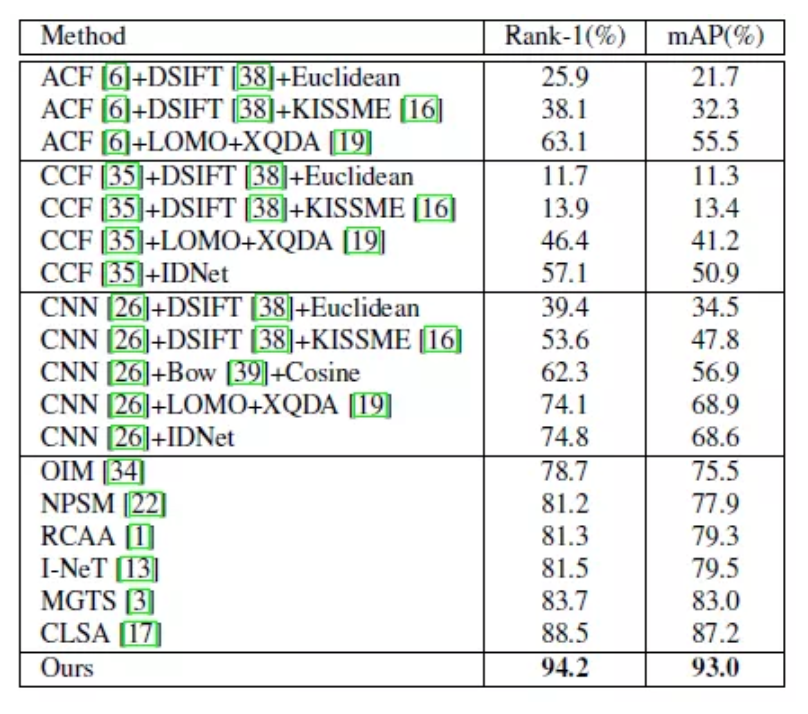

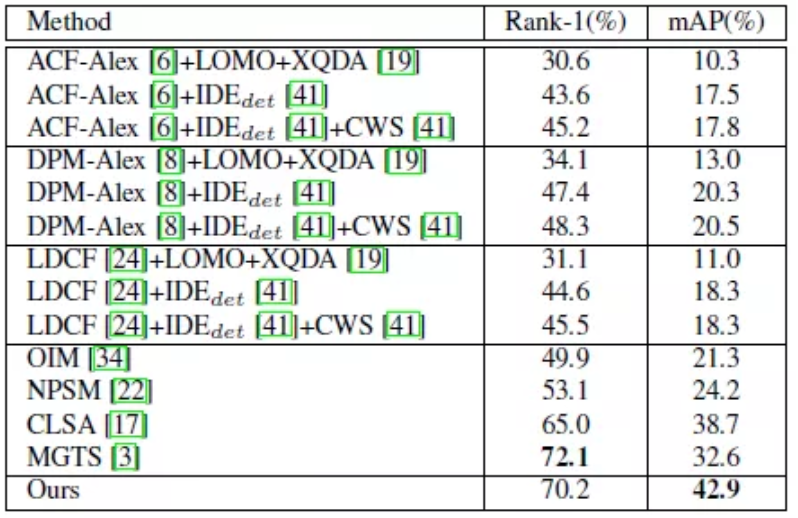

在实验部分,旷视研究院分别在两个大型数据集(CUHK-SYSU 和 PRW)上对本文方法与当前已有的领先方法以及一些联合了不同行人检测器、行人描述器、距离标准的方法进行了性能对比,见表 2、3。

表 2:本文方法在 CUHK-SYSU 数据集上与当前最领先模型的性能对比

表 2 展示了本文方法在 CUHK-SYSU 数据集上与同类方法的性能对比,其中“CNN”、“IDNEet”分别代表基于 ResNet-50 的 Faster R-CNN 以及重识别网络。当候选行人库(gallery)数目设置为 100 时,可以发现本文方法显著超越当前无论是端到端还是分离式处理的方法。与当前最佳性能模型 CLSA 的比较可以发现,本文方法在 Rank-1、mAP 两个指标上分别提升了 5.8%、5.7%。

为了观察模型的扩展性能,研究团队还在不同 gallery size 条件下进行了对比,如图 5 所示,证明本文模型具备扩展性,能够在大规模行人搜索场景下依然保持优势。

在数据集 PRW 上的性能对比,见表 3, 依然得出了类似结果,说明本文方法在行人搜索任务上是具备领先性的。

表 3:本文方法在 PRW 数据集上与当前最领先模型的性能对比

结论

在本文中,旷视研究团队提出了一个可以修正检测框定位的网络,它是一个结合了行人检测与行人重识别任务于一体的端到端框架。为了解决因独立训练的检测器会导致生成非最佳的重识别检测框的问题,研究团队用重识别损失作为监督来优化检测器,生成用于行人搜索的可信的检测框。

具体而言,团队开发了一个可微的 ROI 变换层来执行对检测框图像的裁剪工作;然后裁剪的图像被送入以重识别损失为监督的重识别模型。由于整个过程是关于检测框可微的,所以检测网络可以在端到端框架中重识别损失优化。

此外,为了解决标准 teriple hard loss 无法在行人搜索任务中使用的问题,团队还提出了 proxy triplet loss。在两个大型行人搜索数据集上的对比实验结果显示本文方法实现了当前最佳性能。

参考文献

- Xiaojun Chang, Po-Yao Huang, Yi-Dong Shen, Xiaodan Liang, Yi Yang, and Alexander G Hauptmann. Rcaa: Relational context-aware agents for person search. In European Conference on Computer Vision, 2018.

- Dapeng Chen, Dan Xu, Hongsheng Li, Nicu Sebe, and Xiaogang Wang. Group consistent similarity learning via deep crf for person re-identification. In IEEE Conference on ComputerVision and Pattern Recognition, 2018.

- Di Chen, Shanshan Zhang, Wanli Ouyang, Jian Yang, and Ying Tai. Person search via a mask-guided two-stream cnn model. In European Conference on Computer Vision, 2018.

- Weihua Chen, Xiaotang Chen, Jianguo Zhang, and Kaiqi Huang. Beyond triplet loss: a deep quadruplet network for person re-identification. In IEEE Conference on Computer Vision and Pattern Recognition, 2017.

- Jifeng Dai, Yi Li, Kaiming He, and Jian Sun. R-fcn: Object detection via region-based fully convolutional networks. In Advances in Neural Information Processing Systems, 2016.

专栏文章推荐

欢迎关注旷视研究院极术社区专栏,定期更新最新旷视研究院成果

加入旷视:career@megvii.com