首发:https://zhuanlan.zhihu.com/p/83603416

作者:张新栋

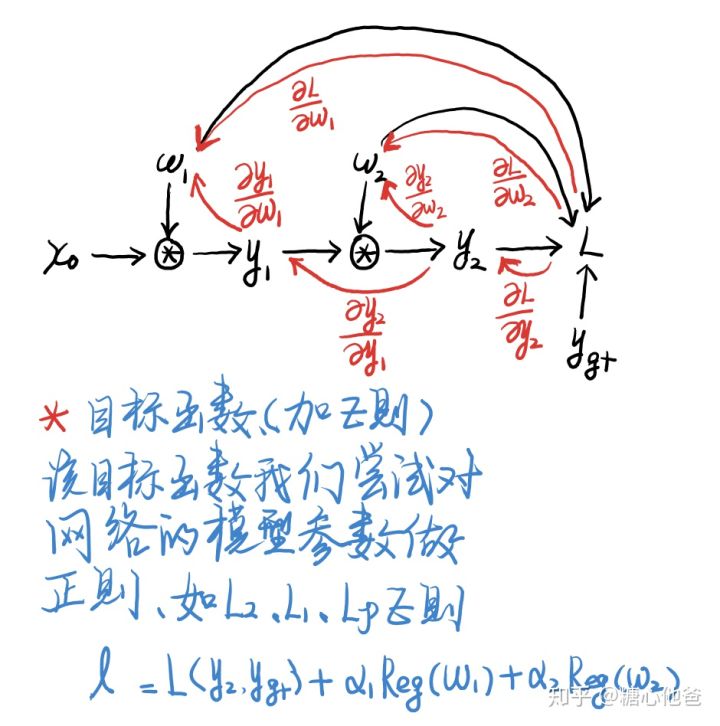

前面的一篇原理简述的文章中,给大家简单介绍了神经网络前(后)传播的有向图、反向传播的计算和更新。这篇文章跟大家简单讨论一下神经网络的参数正则,加了参数正则以后,网络的前(后)传播的有向图会有何改变呢?大家可以餐卡一下如下简单的图例,

- 参数正则

参数正则实例

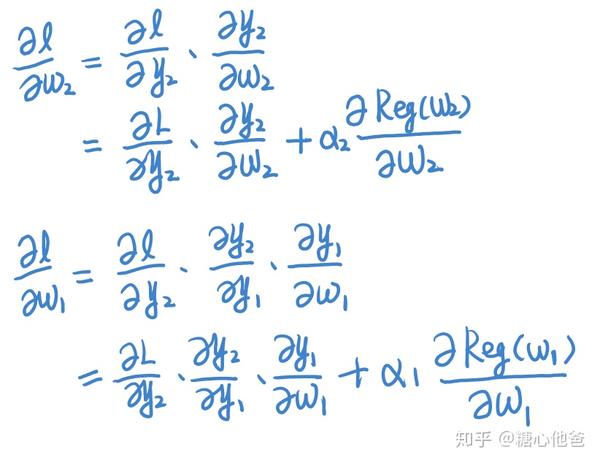

上面图例中,我们对神经网络的w1和w2参数分别作了参数正则,大家也可以对比上面的有向图跟前一篇文章中的有向图,看看有什么区别?上面图例中,我们也写出了加入参数正则以后的损失函数。参数正则的选取有很多,常见的有L2正则(高斯分布约束,平滑)、L1正则(Laplacian分布约束)、Lp约束(p属于(0,1),稀疏约束)等等。下面我们来看看加了参数正则以后的反向传播,较之前没加参数正则的有何不同。

- 反向传播

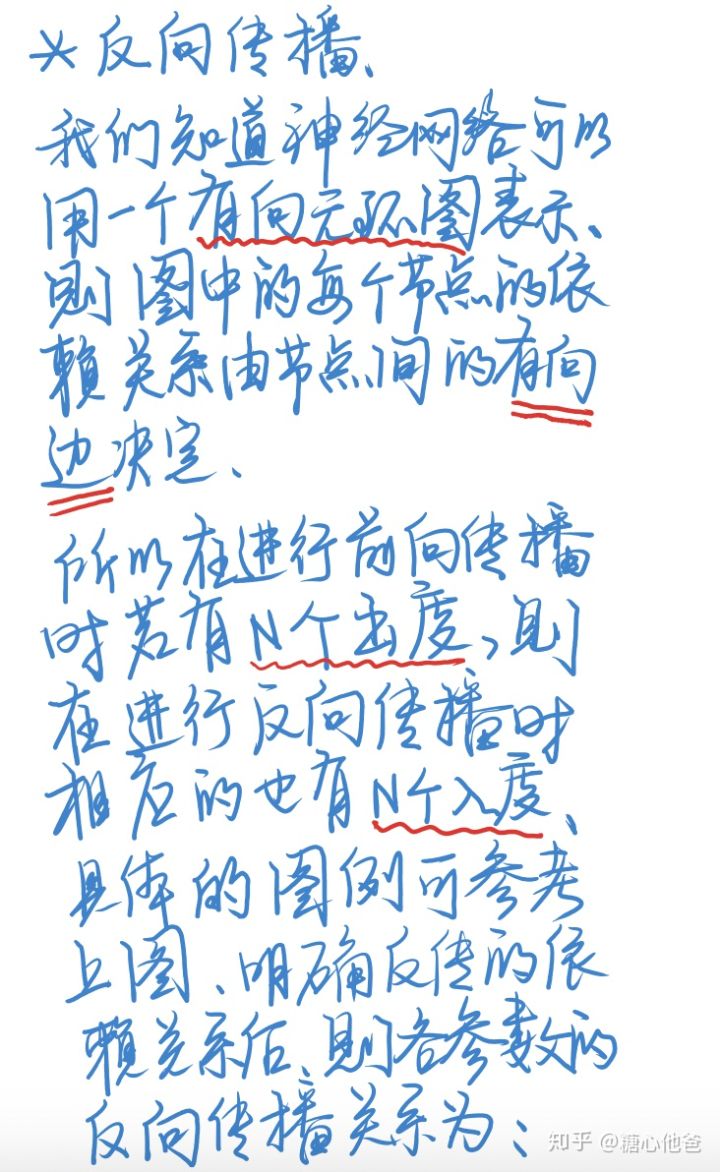

反传的公式更新可以参考上图,需要注意的一点是我们在考虑反向传播的时候,该节点有多少的Out-degree,其相应的在进行反向传播的时候就会有多少的Out-degree。相应的例子,可以看图一种的前后传有向图的示例。

- 最后

这篇文章跟大家简单讨论了神经网络中加参数正则后的一些常见问题,如前后传播的有向图、反向传播的参数更新。欢迎大家留言、关注专栏,谢谢大家!

推荐阅读

专注嵌入式端的AI算法实现,欢迎关注作者微信公众号和知乎嵌入式AI算法实现专栏。

更多嵌入式AI相关的技术文章请关注极术嵌入式AI专栏