IEEE国际计算机视觉与模式识别会议 CVPR 2020 (IEEE Conference on Computer Vision and Pattern Recognition) 大会官方论文结果公布,旷视研究院 16 篇论文被收录(其中含 6篇 Oral 论文),研究领域涵盖物体检测与行人再识别(尤其是遮挡场景),人脸识别,文字检测与识别,实时视频感知与推理,小样本学习,迁移学习,3D感知,GAN与图像生成,计算机图形学,语境分割,细粒度图像,对抗样本攻击等众多领域,取得多项领先的技术研究成果,这与已开放/开源的旷视AI生产力平台Brain++密不可分。本文是旷视CVPR2020论文系列解读第13篇,本文建立了一个分析框架,以深入研究场景文字识别的「词汇依赖」问题,并给出了独到的新见解,这有利于场景文字识别的进一步研究;本文还给出一个简单而有效的互学习策略,允许上述两种模型协同学习。这一纠正方法缓解了词汇依赖的问题,提升了场景文字识别的整体性能。

论文名称:On Vocabulary Reliance in Scene Text Recognition

论文链接:https://arxiv.org/abs/2005.03959

目录

- 导语

- 简介

- 分析框架

- 测试数据

- 训练数据

- 模块组合

- 评价指标

- 对比分析

- 训练数据的影响

- 预测层的对比

- 语境模块的对比

- 推荐组合

- 互学习

- 优化

- 实验

- 结论

- 参考文献

- 往期解读

导语

===============

近年,虽然自然场景文字识别不断取得新成绩,但一个重要问题长期被忽视:图像上的词出现在训练词汇表之内,当前主流方法可以很好识别;而对于单词不在训练词汇表之内的图像,主流方法表现差强人意。

如图1所示,一个当前学界广泛使用的文字识别器,可以良好处理图像质量的挑战(左),但在质量较好的图像上却可能发生错误(右)。究其原因在于词汇:当前最佳方法倾向于记住训练时见过的字词,这一现象称之为「词汇依赖」。

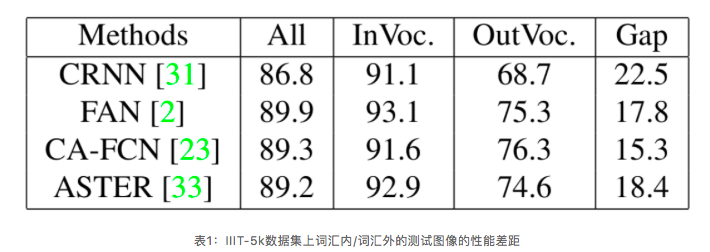

为进一步验证「词汇依赖」在自然场景文字识别中的普遍性,本文复现了大量经典方法,比如CRNN、FAN、CA-FAN、ASTER。如表1所示,复现方法的词汇内/词汇外的测试图像的性能差距非常大,这表明词汇依赖普遍存在。

简介

==========

本文对「词汇依赖」问题做了系统调研,并建立一套评估框架,它使用了专门的数据集以对词汇表进行变量控制,同时还专门设计了评估指标评价和对比不同模块的组合性能。

进一步,为了缓解现有方法中的词汇依赖问题,文章提出一个全新的互学习策略,让带有不同预测层(PRED)——基于注意力的解码器和基于分割的解码器——的模型在训练中实现互补。实验结果证明,本文方法可以有效提升基于注意力和分割的解码器的准确率和泛化能力。

分析框架

============

测试数据

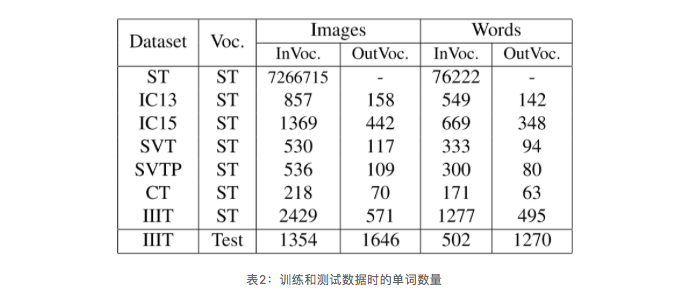

如图1所示,对于视觉上不清晰的文字图像,系统识别时往往依赖相应的词汇信息。本文把5个公开的真实图像数据集作为数据集Ω,其ground truth标签则用作合成数据训练的语料库。因此,Ω及其补集Ω^c分别代表属于词汇依赖和不属于依赖的部分。此外,本文还准备了一个单独使用的数据集IIIT,见表2。

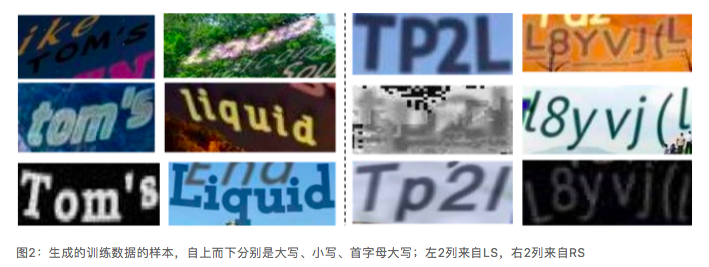

训练数据

在训练数据方面,基于合成数据集SynthText(ST)的合成引擎和前面测试集的语料库,本文生成了专门用于分析词汇依赖问题的3个数据集LexiconSynth(LS)、RandomSynth(RS)、MixedSynth(MS),样例见图2;其中,LS的语料库通过均匀采样测试集语料库获到;而RS的语料库则通过字母随机生成;MS则是对RS和LS按一定比例进行采样的结果。

模块组合

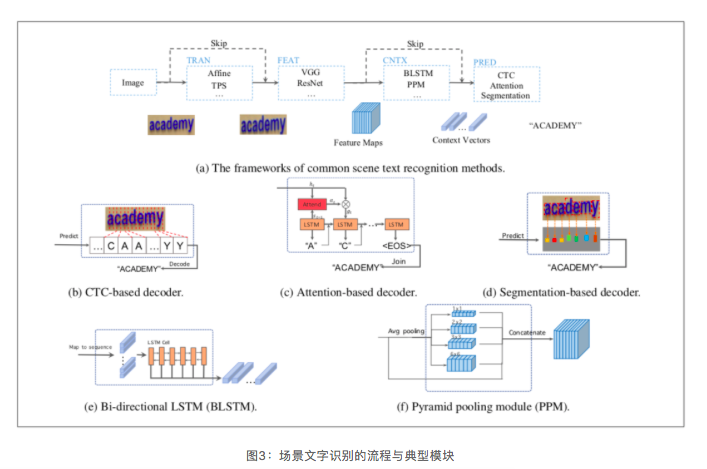

场景文字识别一般分为4个步骤,1)变换(TRAN);2)特征抽取(FEAT);3)语境建模(CNTX);4)预测(PRED);其中CNTX阶段类似于序列建模。图3可视化了整个流程以及一些重点模块。

实验中,本文着重关注CNTX和PRED这两个与词汇依赖问题紧密相关的阶段。并引入了3种PRED层,以及2CNTX的选项。3种PRED层分别是CTC、基于注意力的解码器、基于实例分割的MaskTextSpotter;3个CNTX选项分别是BLSTM、PPM或者跳过这一阶段。

表3给出了对比的原始结果,模块组合的名字用画圈数字表示。

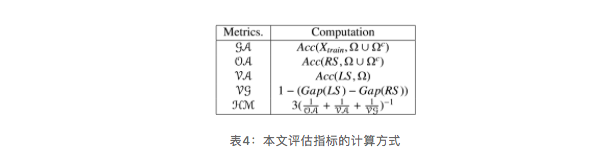

评价指标

本文还基于现有评估指标专门定义了5个指标,具体如下:

- General Accuracy(GA): 模型在本文前述所有测试集上的识别准确率;

- Observation Ability(OA): 在训练集没有任何词汇依赖的前提下,算法的单词识别准确率;

- Vocabulary Learning Ability(VA): 模型在受控词汇数据上训练后的识别准确率;

- Vocabulary Generalization(VG): 在LS上训练的模型,在词汇库之外的单词识别准确率;

- Harmonic Mean(HM): 评价性能的总体指标,是OA、VA、VG的调和平均值。

对比与分析

=============

训练数据的影响

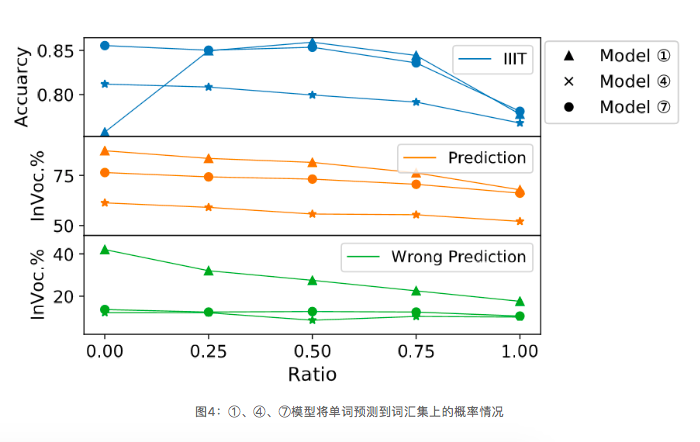

为验证本文数据集效果,研究词汇依赖与训练数据的关系,本文对3个模型①、④、⑦的性能做了对比,如表3所示。另外,除了观察在IIIT上的识别准确率,本文还观察了模型将单词预测到词汇集上的概率情况,如图4所示。

可见,随着r值增大(大约到0.5),即RS数据以更大比例与LS结合,成为训练数据,模型在IIIT上的识别准确率逐渐改善;当r超过0.5时总体准确率开始下降。

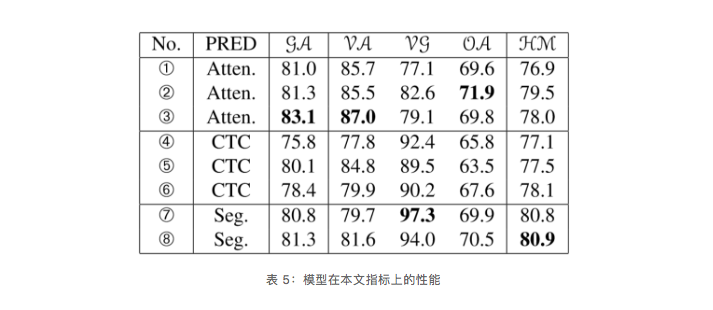

预测层的对比

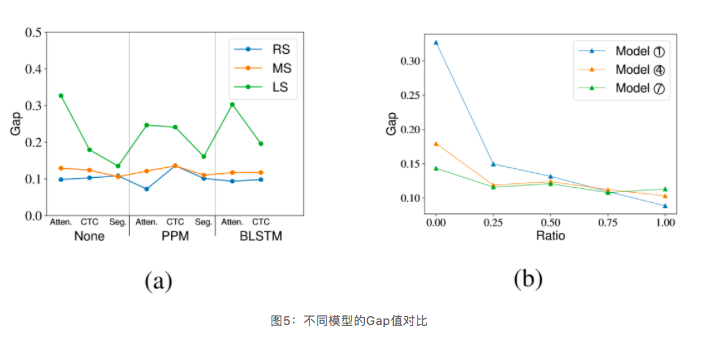

图5(a)展示了在RS、MS、LS三个数据集上训练模型的Gap值对比情况。可知,所有组合都会遇到词汇依赖问题,只是程度不同。

图5(b)展示的是模型①、④、⑦在IIIT上的Gap性能对比,横轴表示训练数据MS的r值变化情况。

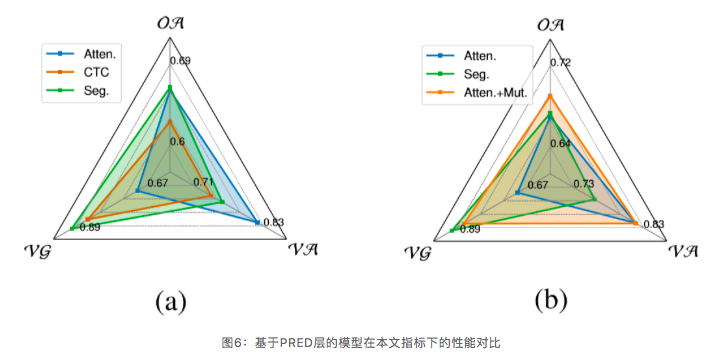

在图6中,本文还展示了基于PRED层的模型(所有参与比较的模型均未使用CNTX模块)在本文提出的指标下的性能对比情况。可以发现CTC的性能总体上不及另外两者,而基于注意力和基于分割的解码器分别在VA和VG上表现突出。另外,从二者在OA上类似的表现可以判断,它们在完全基于视觉特征的识别任务上具有相似的性能。

语境模块的对比

从图8 VA 指标可见,引入CNTX模块之后,可以较好缓解模型的词汇依赖问题,而且通过图8的(a)、(b)可知,CNTX模块的效果会随着搭配的预测层发生显著变化。

具体而言,基于注意力的解码器学习训练数据的词汇更加强大,再加上语境模块之后,其VA和VG指标变化不大;但是语境模块可提取语境信息,从而促进基于注意力和基于分割的解码器的视觉观察能力。

相比之下,CTC系列模型通过添加PPM和BLSTM模块,显著改善了VA上性能,但降低了VG性能,这是因为其自身缺乏一定的语境建模能力。

因此,预测层与语境建模层的不同搭配对于改善模型词汇依赖性十分重要,因为这本质上是VA与VG之间的权衡问题。

推荐组合

基于表 5与上文分析,本文推荐了两种模块搭配,以应对不同场景的文字识别任务。

模型 ③在VA指标上取得最佳性能,同时凭借在词汇学习上的优点,也取得了GA最高得分,因此模型 ③ 在词汇限定的场景下表现良好。相应地,对于在泛化性上要求较高的场景,可用模型 ⑦ 。

互学习

===========

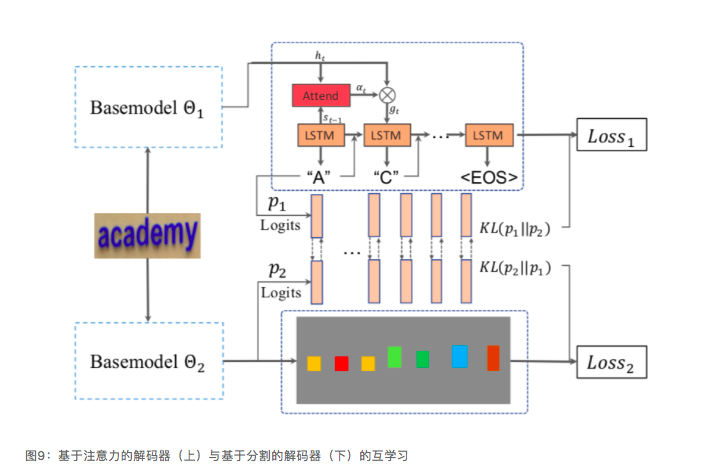

本文给出一个简单却有效的训练策略,可以整合模型中基于注意力和基于分割的解码器各自的优势。这一想法受启发于知识蒸馏和深度互学习。

由于其各自优势,本文选择把基于分割的和基于注意力的解码器集合成基础模型,并假设基于分割的解码器监督基于注意力的解码器以学习缓解词汇依赖问题,并且后者反过来提升前者。

优化

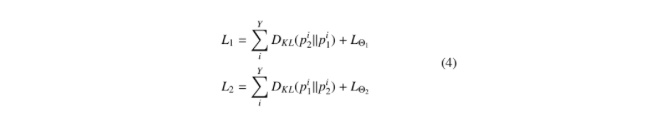

除了原始损失之外,计算KL散度作为补充损失函数,所以注意力解码器和分割解码器的最终损失函数为:

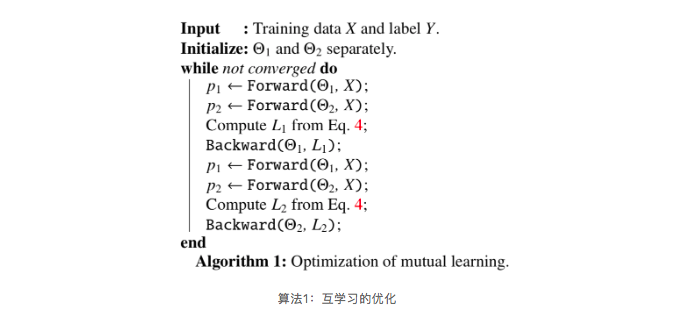

通过等式4,可以互监督地优化网络,如算法1所示:

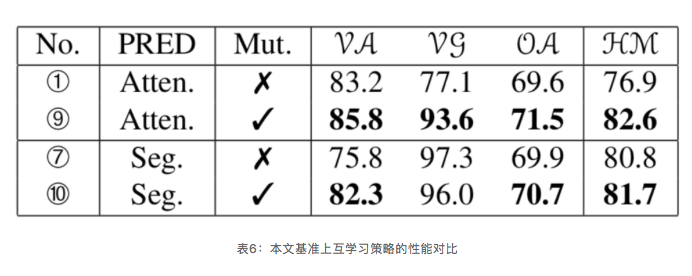

实验

本文通过现有框架评估了互学习策略,并分别给出了原始的精度和性能,如表3和表6所示。实验结果表明证明了有互学习支持的基础模型的重大性能提升。

并且,注意力解码器的词汇依赖性被分割解码器所中和。互学习的定性对比如图6b所示,基准上的显著提升证明了其有效性,并验证了整合不同预测层各自优势的合理性。

结论

==========

本文研究了一个重要但长期被忽视的问题——自然场景文字识别中的词汇依赖性。本文通过构建整体框架,对比和分析单独的文字识别模块及其组合。基于这一框架,获得了一系列关键的观察和发现,以及有价值的建议,进一步推动自然场景文字识别研究进展。

进而,本文还分析了当前的语境和预测模块,并提出一种互学习策略,提升其词汇学习能力,或者词汇之外的泛化能力。

参考文献

- Jeonghun Baek, Geewook Kim, Junyeop Lee, Sungrae Park, Dongyoon Han, Sangdoo Yun, Seong Joon Oh, and Hwalsuk Lee. What is wrong with scene text recognition model comparisons? dataset and model analysis. 2019 IEEE International Conference on Computer Vision, 2019.

- Ankush Gupta, Andrea Vedaldi, and Andrew Zisserman. Synthetic data for text localisation in natural images. In CVPR, pages 2315–2324, 2016.

- Max Jaderberg, Karen Simonyan, Andrea Vedaldi, and Andrew Zisserman. Synthetic data and artificial neural networks for natural scene text recognition. NIPS Deep Learning Workshop, 2014.

- Baoguang Shi, Mingkun Yang, Xinggang Wang, Pengyuan Lyu, Cong Yao, and Xiang Bai. Aster: An and attentional scene and text recognizer and with flexible and rectification. In PAMI, pages 1–1. IEEE, 2018.

- Minghui Liao, Pengyuan Lyu, Minghang He, Cong Yao, Wenhao Wu, and Xiang Bai. Mask textspotter: An end-toend trainable neural network for spotting text with arbitrary shapes. IEEE transactions on pattern analysis and machine intelligence, 2019.

- Zhaoyi Wan, Mingling He, Haoran Chen, Xiang Bai, and Cong Yao. Textscanner: Reading characters in order for robust scene text recognition. ArXiv, abs/1912.12422, 2019.

- Anand Mishra, Karteek Alahari, and CV Jawahar. Scene text recognition using higher order language priors. In BMVCBritish Machine Vision Conference. BMVA, 2012.

专栏文章推荐

- CVPR 2020 Oral | 旷视研究院提出密集场景检测新方法:一个候选框,多个预测结果

- CVPR 2020 | 旷视研究院提出数据不确定性算法 DUL,优化人脸识别性能

- CVPR 2020 | 旷视研究院提出UnrealText,从3D虚拟世界合成逼真的文字图像

欢迎关注旷视研究院极术社区专栏,定期更新最新旷视研究院成果

加入旷视:career@megvii.com